De eerste keer dat ik probeerde een volledige lijst van alle pagina's op een website te verzamelen, dacht ik dat het simpel zou zijn: gewoon door het menu klikken, elke link noteren en klaar. Maar al snel kwam ik erachter dat er steeds weer nieuwe pagina’s opdoken: verborgen productpagina’s, oude campagnes, blogposts die diep verstopt zaten achter eindeloos scrollen. Het voelde alsof ik een plattegrond van een stad probeerde te tekenen door alleen de hoofdwegen te volgen, om er vervolgens achter te komen dat er een heel metronetwerk onder de grond lag.

Als je ooit hebt geprobeerd om alle pagina's van een website te verzamelen voor een content-audit, SEO-traject of concurrentieanalyse, weet je dat het een stuk lastiger is dan het lijkt. Sterker nog, —wat betekent dat het grootste deel van de content op een site onzichtbaar blijft voor zowel bezoekers als zoekmachines. Dat zijn gemiste kansen én digitale spinnenwebben. Maar hoe krijg je nu wél een compleet overzicht van alle websitepagina’s? En waarom is dat zo belangrijk voor je contentstrategie? Laten we erin duiken.

Waarom een Volledige Website Linkslijst Onmisbaar is voor Contentplanning

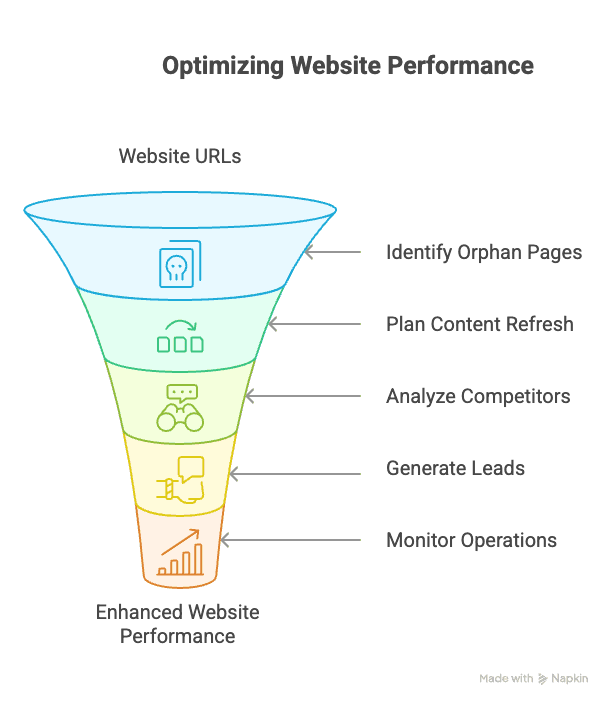

Voordat we het over het ‘hoe’ hebben, eerst het ‘waarom’. Een volledige website linkslijst maken is niet alleen iets voor SEO-nerds (al vind ik het persoonlijk best leuk). Het is een strategisch hulpmiddel voor elk bedrijf dat serieus met content, leads of online prestaties bezig is.

Waarom zou elk team hier aandacht aan moeten besteden?

- Content- & SEO-audits: Met een overzicht van alle URL’s kun je verouderde, dunne of verweesde pagina’s opsporen. Vooral verweesde pagina’s—die zonder interne links—zijn verraderlijk. Ze kunnen en de autoriteit van je site schaden.

- Contentplanning & Updates: Met een volledige inventaris zie je welke content er is, wat vernieuwing nodig heeft en waar de gaten zitten. Veel bedrijven ontdekken tijdens audits tientallen vergeten pagina’s—soms ideaal om te updaten.

- Concurrentieanalyse: Wil je alle landingspagina’s, productcategorieën of verborgen resources van je concurrent zien? Dan heb je hun volledige sitemap nodig, niet alleen het hoofdmenu.

- Sales & Leadgeneratie: Door alle pagina’s met contactgegevens of winkeladressen te verzamelen, mis je geen enkele lead.

- Operations & Monitoring: E-commerce teams kunnen elke productpagina volgen op prijswijzigingen of voorraadstatus—ook die niet in de hoofdmenu’s staan.

Per team ziet dat er zo uit:

| Team / Rol | Toepassing van Volledige Paginalijst | Voordeel |

|---|---|---|

| SEO / Webbeheer | Volledige content-audit—verweesde pagina's, kapotte links, dubbele of dunne pagina's opsporen. | Verbeter de sitestructuur, los SEO-problemen op en vergroot de indexatie (verweesde pagina's verzwakken autoriteit). |

| Contentmarketing | Alle blogposts, landingspagina's, enz. inventariseren voor contentplanning. | Oude content updaten of hergebruiken; consistente boodschap waarborgen en contentgaten ontdekken. |

| Sales / Leadgeneratie | Alle pagina's met contactinfo, winkels of testimonials vinden. | Gerichte leadlijsten opbouwen, zodat geen enkele kans wordt gemist. |

| Concurrentieanalyse | De hele site van de concurrent crawlen (productpagina's, blog, support). | Inzicht krijgen in het aanbod, prijsstructuur en contentstrategie van de concurrent (zie hoe sitemaps verborgen URL's onthullen). |

| E-commerce Operations | Alle productpagina's (ook die niet in het menu staan) in kaart brengen voor prijs- of voorraadmonitoring. | Prijswijzigingen of voorraadstatus bijhouden over het hele assortiment; geen producten missen die niet in categorieën staan. |

| IT / Compliance | Alle URL's ontdekken (ook oude, verborgen of testpagina's die nog live staan). | Verouderde of niet-conforme pagina's verwijderen; zorgen voor een veilige, actuele website. |

Kortom: als je alleen het topje van de ijsberg ziet, mis je waardevolle inzichten, leads en kansen.

Wat Betekent 'Alle Pagina's van een Website Vinden' Nu Echt?

Laten we een misverstand uit de wereld helpen: ‘alle pagina’s van een website vinden’ is niet simpelweg eindeloos op ‘volgende pagina’ klikken. Websites zijn slim. Ze gebruiken oneindig scrollen, ‘laad meer’-knoppen, links die pas verschijnen na interactie, URL-parameters en soms hele secties die niet in het menu staan. Sommige pagina’s zijn alleen te vinden als je de directe URL weet.

Dus als ik het heb over een website linkslijst maken, bedoel ik:

- Oneindige scrollfeeds doorzoeken (denk aan Twitter, nieuwssites)

- ‘Laad meer’-knoppen aanklikken die verborgen content tonen

- Pagina’s vinden die ontstaan door URL-parameters (zoals filters)

- Verweesde pagina’s zonder interne links opsporen

- Privé- of niet-gelinkte secties ontdekken (zoals oude campagnes)

Het is minder als bladeren door een boek, en meer als een huis met geheime kamers en verborgen deuren verkennen. Je hebt meer nodig dan alleen een zaklamp—je hebt een plattegrond én wat digitale speurzin nodig.

Traditionele Manieren om Alle Websitepagina's te Vinden

Voordat AI-tools als bestonden, gebruikten de meeste mensen een mix van handmatige trucs en gespecialiseerde software om een website linkslijst te maken. Deze methodes werken nog steeds, maar hebben hun beperkingen.

Google Search en Site-Operators Gebruiken

De klassieker: typ site:voorbeeld.nl in Google. Zo zie je alle pagina’s die Google heeft geïndexeerd voor dat domein. Je kunt het verfijnen met site:voorbeeld.nl/blog voor specifieke secties.

Voordelen:

- Supersimpel

- Snel een grove inschatting

Nadelen:

- Toont alleen wat Google heeft geïndexeerd (vaak slechts een fractie)

- Laat geen privé, verweesde of geblokkeerde pagina’s zien

Sitemaps en Robots.txt Controleren

De meeste zakelijke sites hebben een sitemap.xml—een bestand met alle URL’s voor zoekmachines. Vaak vind je die op voorbeeld.nl/sitemap.xml of via een link in robots.txt.

Voordelen:

- Handig om pagina’s te vinden die niet in het menu staan

- Kan oude of verborgen pagina’s bevatten

Nadelen:

- Niet altijd actueel of volledig

- Kan pagina’s tonen die voor bots geblokkeerd zijn (je ziet ze, maar kunt ze niet bezoeken)

- Sommige pagina’s zijn wel geïndexeerd maar staan niet in de sitemap ()

Crawlen met SEO Spider Tools

Tools als Screaming Frog of WebSite Auditor crawlen een site door links te volgen en zo een kaart van alle bereikbare pagina’s te maken.

Voordelen:

- Vindt diep gelinkte pagina’s

- Kan kapotte links en sitestructuur controleren

Nadelen:

- Heeft moeite met dynamische content (oneindig scrollen, JavaScript-links)

- Vereist technische kennis en configuratie

- Gratis versies hebben limieten (Screaming Frog stopt bijvoorbeeld bij 500 URL’s)

- Vindt geen verweesde pagina’s (geen links = niet gevonden)

De Beperkingen van Traditionele Methoden

Hier wordt het lastig. Zelfs na al deze stappen mis je vaak nog:

- Verweesde pagina’s: Geen interne links, niet in de sitemap, niet geïndexeerd—digitale kluizenaars.

- Dynamische content: Oneindig scrollen, ‘laad meer’-knoppen, of content die via JavaScript/AJAX wordt geladen.

- Pagina’s achter formulieren of scripts: Sommige pagina’s verschijnen pas na een gebruikersactie (zoals een zoekopdracht).

- Dubbele of geparametriseerde URL’s: Meerdere paden naar dezelfde content, of unieke content die alleen via URL-parameters bereikbaar is.

Kortom, traditionele methoden zijn als vissen met een net vol gaten. Je vangt veel, maar mist ook veel.

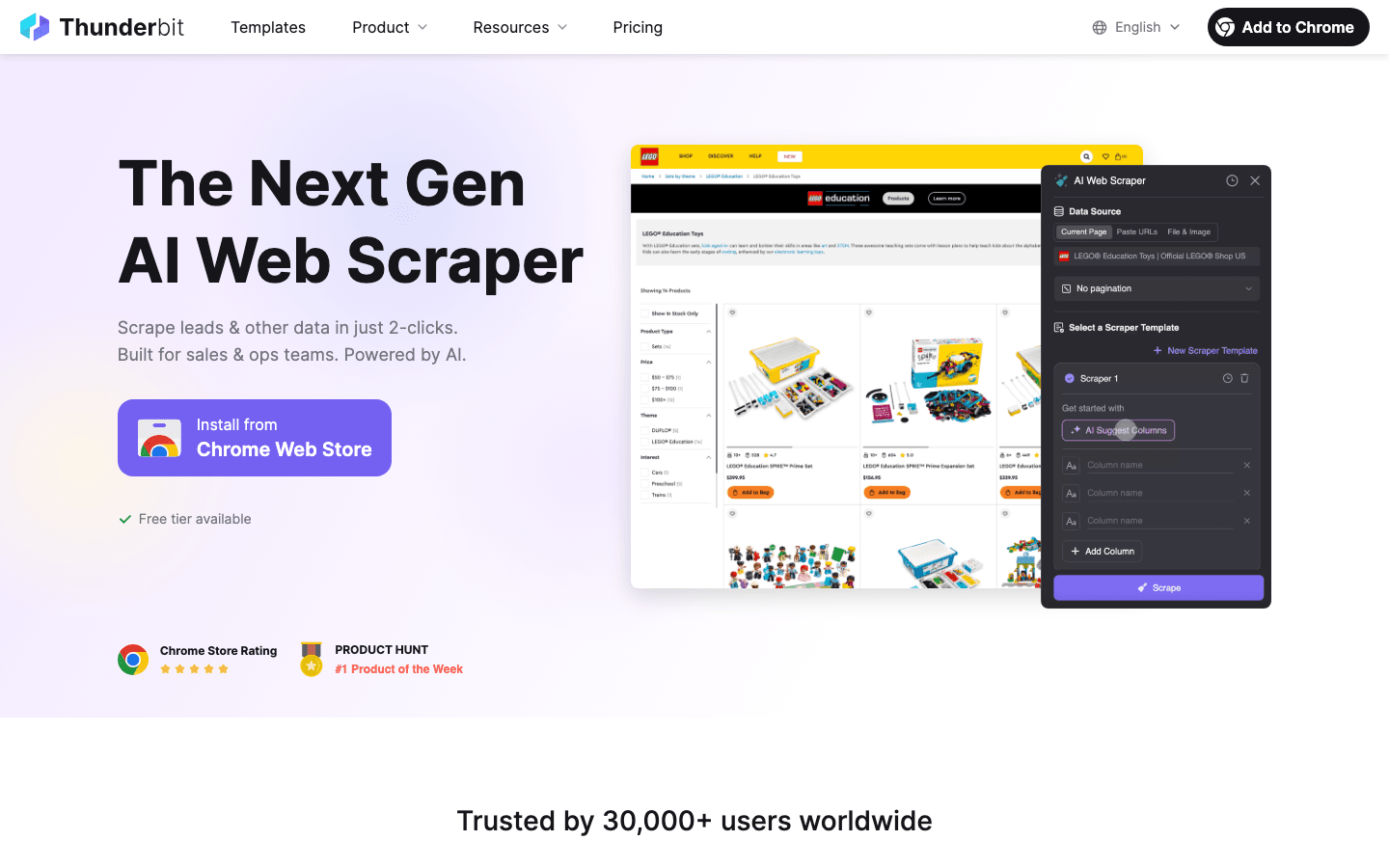

Thunderbit’s AI-aanpak: Slimmer Alle Websitepagina's Vinden

Hier komt de om de hoek kijken—en ik ben oprecht enthousiast over wat we hebben gebouwd.

Thunderbit crawlt niet alleen links, maar ‘leest’ de pagina als een mens en zet de inhoud om naar een Markdown-achtige structuur voordat de data wordt opgehaald. Hierdoor begrijpt de AI de context, herkent lijsten, tabellen, koppen en zelfs navigatielogica. Het is alsof je de AI een leesbril en markeerstift geeft.

Waarom is dit belangrijk?

- Semantisch Begrip: Door pagina’s vooraf om te zetten naar Markdown, krijgt Thunderbit’s AI een semantische kaart van de site. Zo ziet het verschil tussen een zijmenu en een productlijst, of herkent een ‘laad meer’-knop die geen gewone link is.

- Kan Dynamische Content Aan: Thunderbit kan scrollen, klikken en interactie aangaan—net als een gebruiker. Oneindig scrollen? Geen probleem. JavaScript-links? Worden meegenomen.

- AI-gestuurde Linkdetectie: De AI herkent navigatie-elementen die geen standaard links zijn (zoals knoppen of kaarten) en volgt ze naar subpagina’s.

- Natuurlijke Taal Prompts: Je kunt letterlijk tegen Thunderbit zeggen: “Vind alle productpagina’s en geef titels en prijzen weer,” en de AI regelt het.

Kortom, Thunderbit overbrugt de kloof tussen hoe mensen browsen en hoe machines data verzamelen. Het is krachtig, flexibel en—durf ik te zeggen—best leuk om te gebruiken.

Omgaan met Paginering: Van Oneindig Scrollen tot 'Laad Meer'-Knoppen

Een veelvoorkomend scenario: je zit op een blog of productoverzicht, en na de eerste 10 items moet je eindeloos scrollen of steeds op ‘Laad meer’ klikken. Traditionele crawlers stoppen bij wat er direct zichtbaar is. Thunderbit’s AI weet echter hoe hij moet doorgaan.

Hoe Thunderbit Verschillende Paginering Herkent

| Type paginering | Traditionele tool | Thunderbit AI |

|---|---|---|

| Genummerde pagina's of 'Volgende'-links | Volgt als ingesteld | Detecteert en klikt automatisch door |

| 'Laad meer'-knop | Vereist aangepaste script om te blijven klikken | AI vindt en klikt tot alles geladen is |

| Oneindig scrollen (auto-load) | Ziet alleen eerste batch; scripting nodig | AI scrollt en laadt alles in |

| Verborgen of JS-navigatie | Wordt vaak gemist | AI interpreteert en navigeert waar nodig |

Met Thunderbit klik je gewoon op ‘AI Suggest Fields’ en daarna op ‘Scrape’. De AI herkent automatisch de pagineringslogica—of het nu een knop, scroll of URL-parameter is—en gaat door tot alles binnen is. Geen gedoe meer met crawl-diepte of scripts schrijven.

Meer weten over paginering? Bekijk de .

Subpagina's Scrapen: Verder dan Alleen de Hoofdlijst

Een klassieke beginnersfout: je haalt een lijst met producten of artikelen op, maar vergeet de detailpagina’s te bezoeken voor de echte details (zoals prijs, reviews of contactinfo). Daar komt subpagina-scraping om de hoek kijken.

Met Thunderbit’s Subpagina’s Scrapen-functie kun je:

- Automatisch elke detailpagina bezoeken die vanuit je hoofdlijst gelinkt is

- Extra velden ophalen (zoals productspecificaties, auteursbio’s of contactgegevens)

- Alles samenvoegen in één overzichtelijke tabel

Stel je voor: je scrapt een vastgoedsite, haalt alle listings op, en Thunderbit bezoekt automatisch elke woningpagina om aantal kamers, prijs en makelaar te verzamelen. Alles in één keer, zonder handmatig URL’s te kopiëren of een tweede crawl te starten.

Bekijk de voor een visuele uitleg.

Kiezen tussen AI-scraping en Websitesjablonen

Niet elke site heeft de volledige AI-aanpak nodig. Voor standaardplatforms als Amazon, Shopify of Zillow biedt Thunderbit kant-en-klare sjablonen. Dit zijn voorgeconfigureerde webscrapers die precies weten waar de data staat—zodat je met één klik kunt exporteren.

Wanneer AI-modus gebruiken:

- Onbekende of maatwerk websites

- Complexe lay-outs of unieke datavelden

- Als je data direct wilt transformeren of categoriseren

Wanneer een sjabloon gebruiken:

- Bekende, gestandaardiseerde sites (Amazon, LinkedIn, Instagram, enz.)

- Je wilt snelheid en gegarandeerde nauwkeurigheid

Thunderbit geeft zelf aan als er een sjabloon beschikbaar is voor de site die je bezoekt. Anders schakel je gewoon over naar AI-modus en laat je het zware werk aan de AI over.

Websitepagina's Vinden Afstemmen op Je Bedrijfsdoelen

Een gewaagde stelling: ‘alle websitepagina’s vinden’ is niet altijd het juiste doel. Wat je écht wilt, is alle relevante pagina’s vinden voor jouw businessdoel.

- Sales-teams zijn vooral geïnteresseerd in pagina’s met contactinfo.

- Marketingteams willen alle blogposts, landingspagina’s of campagne-URL’s.

- Operations focust op product- of compliancepagina’s.

Met Thunderbit kun je je doel gewoon in gewone taal omschrijven—“Haal alle pagina’s met e-mailadressen op” of “Geef elke productpagina met prijs en SKU weer”. De AI past het scrapingbereik daarop aan, zodat je geen tijd (of credits) verspilt aan irrelevante pagina’s.

Tips voor het formuleren van scrapingdoelen:

- Wees specifiek in veldnamen en instructies

- Gebruik domeinkennis (“scrape alle /resources/ pagina’s”)

- Pas je prompts aan als je te veel of te weinig data krijgt

Deze aanpak bespaart tijd, voorkomt dat je overspoeld wordt met data en zorgt dat je linkslijst direct bruikbaar is.

Stappenplan: Met Thunderbit Alle Pagina's van een Website Ophalen

Zelf aan de slag? Zo gebruik ik Thunderbit om een volledige website linkslijst te maken—zonder code.

- Installeer de : Snel geïnstalleerd, gratis versie beschikbaar.

- Navigeer naar de gewenste website: Begin op de homepage of een specifieke sectie.

- Open Thunderbit en kies je gegevensbron: Standaard is dit ‘Huidige pagina’.

- Klik op ‘AI Suggest Fields’: Thunderbit analyseert de pagina en stelt kolommen voor (zoals ‘Paginatitel’, ‘URL’, enz.).

- Controleer en pas velden aan: Hernoem, voeg toe of verwijder velden naar wens. Stel gegevenstypen in voor duidelijkheid.

- Schakel subpagina-scraping in (indien nodig): Voor detailpagina’s zet je ‘Subpagina’s scrapen’ aan en kies je het juiste veld.

- Klik op ‘Scrape’: Thunderbit regelt automatisch paginering, infinite scroll en subpagina’s.

- Volg de voortgang: Zie de tabel zich vullen. Controleer steekproefsgewijs op juistheid.

- Exporteer je linkslijst: Download als CSV, of exporteer direct naar Excel, Google Sheets, Notion of Airtable.

- Fijnslijpen en herhalen: Mis je een sectie? Start een nieuwe scrape of pas je prompt aan.

Meer weten? De bieden een handige quickstart.

Samenvatting: Een Complete Website Linkslijst Bouwen met Thunderbit

De belangrijkste lessen op een rij:

- Traditionele methoden (Google, sitemaps, crawlers) zijn nuttig, maar missen vaak verborgen, dynamische of verweesde pagina’s.

- Thunderbit’s AI-webscraper biedt semantisch begrip, verwerkt complexe navigatie, infinite scroll en subpagina’s zonder ingewikkelde instellingen.

- Stem je scraping af op je bedrijfsdoelen—haal niet zomaar elke pagina op, maar juist de pagina’s die je nodig hebt.

- Uniek voordeel van Thunderbit: Door pagina’s eerst naar Markdown om te zetten, krijgt de AI diepgaand inzicht in de sitestructuur—zelfs bij sites die vaak van lay-out of content veranderen.

- Gebruiksvriendelijk voor niet-technische gebruikers: Geen code, geen scripts, gewoon aangeven wat je wilt en Thunderbit doet de rest.

- Direct bruikbare resultaten: Exporteer gestructureerde data naar je favoriete tools en ga direct aan de slag—of het nu voor een content-audit, SEO-project of leadgeneratie is.

Heb je AI-gestuurde websitepagina-ontdekking nog niet geprobeerd? Geef een kans. Je zult versteld staan van wat er op je eigen site verborgen zit—of wat je concurrenten allemaal achter de schermen hebben.

Veelgestelde Vragen

1. Waarom is een volledige lijst van websitepagina’s belangrijk voor contentplanning?

Een complete paginalijst helpt je om verouderde of verweesde content te vinden, contentaudits te stroomlijnen, SEO-problemen op te sporen en kansen te ontdekken voor updates of hergebruik. Het ondersteunt ook leadgeneratie, concurrentieanalyse en operationele monitoring.

2. Wat zijn de beperkingen van traditionele methoden om alle websitepagina’s te vinden?

Traditionele tools zoals Google-operators, sitemaps en SEO-crawlers missen vaak dynamische content, verweesde pagina’s of content die achter scripts en interacties verborgen zit. Door complexe navigatie en rendering worden lang niet alle pagina’s gevonden.

3. Hoe verschilt Thunderbit’s AI-webscraper van traditionele webcrawlers?

Thunderbit gebruikt AI om de semantische structuur van een webpagina te begrijpen door deze eerst naar Markdown om te zetten. Het kan omgaan met infinite scroll, JavaScript-links en ‘laad meer’-knoppen, en bootst zo het gedrag van een echte gebruiker na.

4. Welke teams profiteren van een volledige website linkslijst, en hoe?

Teams als SEO, contentmarketing, sales, e-commerce en compliance halen er voordeel uit. SEO-teams vinden en herstellen verweesde pagina’s, sales kan contactpagina’s verzamelen, en operations kan productpagina’s monitoren die niet makkelijk vindbaar zijn.

5. Wanneer kies je voor Thunderbit’s AI-modus en wanneer voor een sjabloon?

Gebruik AI-modus voor onbekende, maatwerk of complexe websites met dynamische interacties of unieke datastructuren. Gebruik een sjabloon voor bekende platforms als Shopify of Amazon, waar voorgeconfigureerde webscrapers snel en accuraat data ophalen.

Meer weten: