Vroeger leek alle links op een website crawlen iets voor hardcore techneuten of een overijverige stagiair, maar die tijd is echt voorbij. Tegenwoordig is het niet alleen Google die een compleet overzicht van een site wil hebben. Of je nu in sales werkt en op zoek bent naar verse leads, als marketeer concurrenten wilt analyseren, of als operations medewerker productcatalogi moet checken: de kracht om ‘alle links op een website te crawlen’ is een stille gamechanger voor iedereen die met webdata werkt. Uit mijn eigen ervaring in SaaS en automatisering weet ik: met de juiste tools wordt een tijdrovende, technische klus ineens kinderspel.

Laten we eerlijk zijn: het web is gigantisch en alles gaat razendsnel. Volgens recente cijfers , en . Het probleem? De meeste klassieke crawlers zijn gemaakt voor developers, niet voor zakelijke gebruikers die snel en zonder code resultaat willen. Daarom laat ik je zien hoe moderne AI-tools (zoals ) het mogelijk maken om zonder technische kennis alle links op een website te crawlen, de data te structureren en direct te gebruiken—geen Python of SEO-jargon nodig.

Wat betekent "alle links op een website crawlen"?

Even de jargon ontrafelen. Alle links op een website crawlen betekent dat je een site systematisch doorloopt en elke vindbare URL verzamelt—je krijgt dus een compleet overzicht van alle pagina’s, niet alleen de homepage. Zie het als een robot die bij de voordeur begint, elke gang doorloopt, elke deur opent en elk kamernummer noteert. Dat is precies wat een webscraper (ook wel spider genoemd) doet: hij start op een pagina, volgt alle links, en herhaalt dat tot elke hoek van de site is ontdekt ().

Verwar crawlen niet met scrapen of indexeren. Crawlen draait om het ontdekken van alle URLs. Scrapen betekent specifieke data uit die URLs halen (zoals prijzen of e-mailadressen). Indexeren is het organiseren en opslaan van die data voor zoekopdrachten of analyses (). Als we het hebben over ‘alle links op een website crawlen’, bedoelen we die eerste stap: met een tool automatisch de site doorlopen en elke vindbare URL verzamelen—ook die verborgen pagina’s die niet in het hoofdmenu staan.

Waarom alle links crawlen belangrijk is voor sales, marketing en operations

Misschien vraag je je af: “Waarom zou ik als zakelijke gebruiker alle links willen crawlen?” Het antwoord: gestructureerde linkdata is de basis voor slimmere, snellere workflows. Verschillende teams halen er hun voordeel uit:

| Team | Voorbeeldtoepassing | Voordelen |

|---|---|---|

| Marketing | Crawl de volledige website van een concurrent om alle landingspagina’s en blogs te vinden | Inzicht in contentstrategie, hiaten ontdekken, inspiratie voor campagnes |

| Sales | Crawl een branchevereniging om alle ledenprofielen te verzamelen | Direct een gerichte leadlijst bouwen, daarna contactinfo extraheren met tools zoals Thunderbit’s E-mail-extractor |

| Operations | Crawl alle productpagina’s van een leverancier of concurrent | Voorraad, prijzen of beschikbaarheid monitoren; catalogi automatisch controleren |

| Vastgoed | Crawl woningplatforms en bezoek elke detailpagina | Gegevens, prijzen en contactinfo verzamelen voor marktanalyse of leadgeneratie |

Het resultaat is duidelijk: bedrijven die webcrawling inzetten, rapporteren . Zo verhoogde retailer John Lewis de omzet met 4% door concurrentieprijzen te scrapen, en verdubbelde ASOS de internationale verkoop door regio-specifieke content te crawlen voor hun campagnes.

Maar het belangrijkste: gestructureerde linkdata maakt van websites bruikbare databases. In plaats van handmatig door een concurrentensite te klikken, crawl je alles en heb je direct een spreadsheet met alle URLs—klaar om te filteren, analyseren of verrijken.

Traditionele methoden om alle links te crawlen: voor- en nadelen

Eerlijk is eerlijk: vóór AI-tools was alle links crawlen óf een monnikenwerk, óf een technisch obstakel. Dit zijn de klassieke methoden:

| Methode | Vaardigheid nodig | Voordelen | Nadelen |

|---|---|---|---|

| Handmatig klikken / Google zoeken | Geen | Iedereen kan het bij kleine sites | Traag, foutgevoelig, mist verborgen pagina’s, niet schaalbaar |

| Sitemap/robots.txt | Laag (XML lezen) | Snel als beschikbaar | Niet elke site heeft een sitemap; vaak onvolledig of verouderd |

| SEO-crawlers (zoals Screaming Frog) | Gemiddeld | Grondig, vindt de meeste links | Gratis versie beperkt tot 500 URLs; technische interface; leercurve voor niet-SEO’s |

| Eigen scripts (Python, etc.) | Hoog (programmeren) | Maximale controle, aanpasbaar | Programmeerkennis vereist, breekt bij sitewijzigingen, veel onderhoud |

| No-code scrapers (pre-AI) | Laag-gemiddeld | Makkelijker dan coderen, soms templates | Nog steeds instellen, kan slecht overweg met dynamische sites, vaak betaalmuur voor belangrijke functies |

Voor niet-technische gebruikers waren deze opties vaak te traag, te ingewikkeld of te beperkt. Ik heb meer dan eens een marketeer zien afhaken bij een SEO-crawler als Screaming Frog, en salescollega’s die handmatig een leadlijst probeerden te maken, kwamen zelden ver.

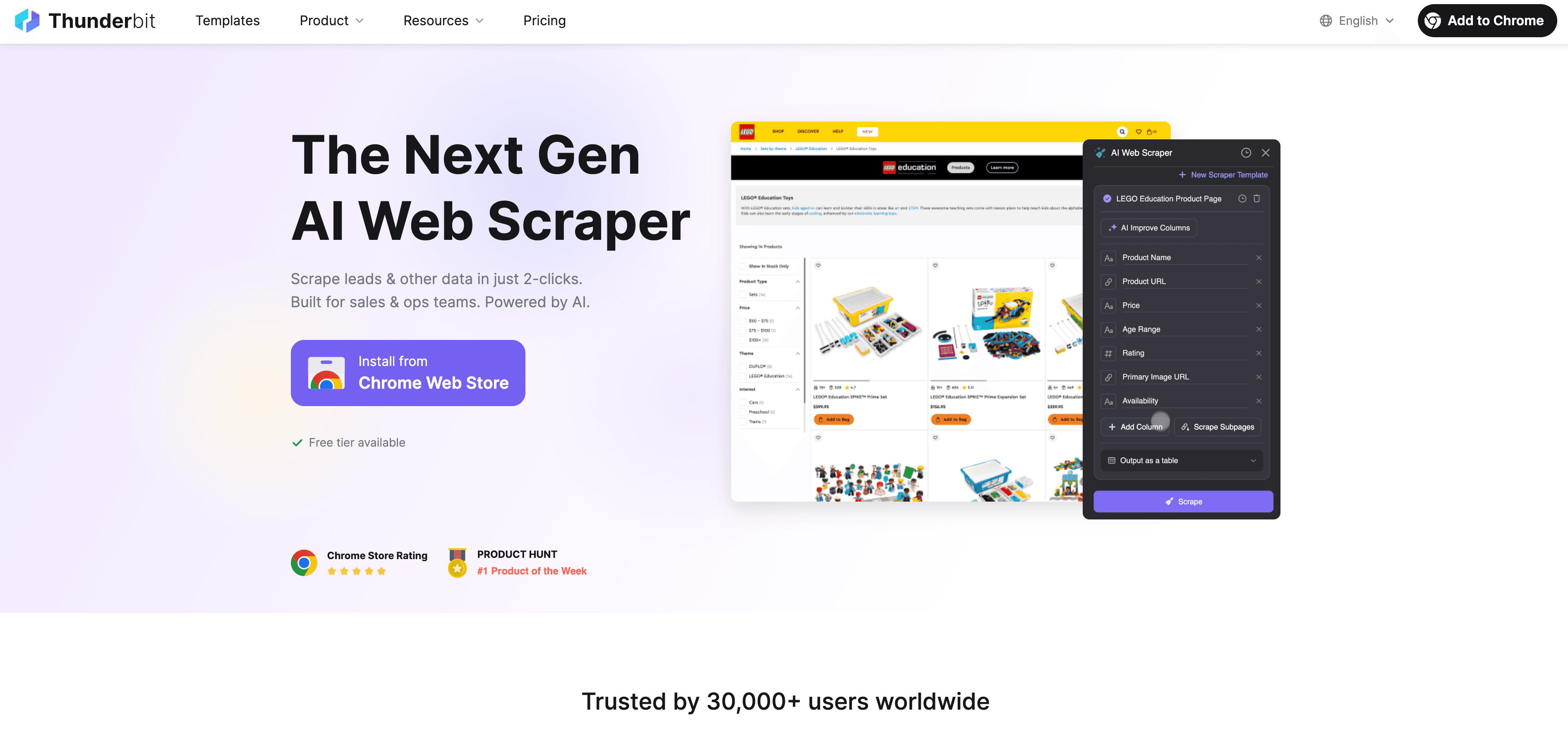

Thunderbit: De snelste manier om alle links te crawlen (zonder code)

Hier komt om de hoek kijken. Thunderbit is een AI-gedreven Chrome-extensie, speciaal voor zakelijke gebruikers die snel resultaat willen. Ons doel? ‘Alle links op een website crawlen’ zo simpel maken als twee klikken—geen code, geen gedoe, geen technische termen.

Hoe Thunderbit’s AI Suggest Fields link crawling eenvoudig maakt

Zo werkt het:

- Open de gewenste website in Chrome.

- Klik op het Thunderbit-extensie-icoon.

- Druk op “AI Suggest Fields.” Thunderbit’s AI scant de pagina, herkent de structuur en stelt automatisch de juiste velden voor—zoals “Linktekst”, “URL” en zelfs “Categorie” als er verschillende paginatypes zijn.

- Pas de voorgestelde kolommen aan indien nodig (hernoemen, toevoegen of verwijderen).

- Klik op “Scrapen.” Thunderbit crawlt de pagina, volgt de links en bouwt een gestructureerde tabel van alle gevonden URLs.

Geen recepten, geen selectors schrijven, geen leercurve. Gewoon aanwijzen, klikken en de AI doet de rest. Meer weten? Bekijk de .

Gestructureerde linkdata exporteren naar Excel, Google Sheets en meer

Na het crawlen kun je de data direct exporteren naar . De export is netjes, gestructureerd en direct klaar voor gebruik—of het nu gaat om outreach, analyse of import in je CRM. En in tegenstelling tot sommige tools zijn exports bij Thunderbit .

Verder dan de homepage: Subpagina’s crawlen voor diepgaandere linkdetectie

Hier blinkt Thunderbit echt uit. Veel websites verstoppen belangrijke pagina’s diep in de site—denk aan productdetails, ledenprofielen of downloads. Met de functie Subpagina’s scrapen kun je automatisch alle subpagina’s bezoeken en daar links of data uithalen.

Voorbeelden:

- E-commerce: Crawl de productcatalogus en laat Thunderbit elke productpagina bezoeken om prijzen, voorraad en afbeeldingen te verzamelen.

- Vastgoed: Crawl het overzicht van woningen en haal oppervlakte, prijs en makelaarsgegevens uit elke detailpagina.

Met Subpagina’s scrapen krijg je niet alleen een lijst met URLs, maar bouw je een rijk, gelaagd databestand dat de echte structuur van de site weerspiegelt.

Linkdata categoriseren en structureren: meer dan alleen een URL-lijst

Alle links crawlen is meer dan een lijstje URLs dumpen. Thunderbit kan links automatisch categoriseren (bijvoorbeeld productpagina’s, blogs, downloads, contactformulieren) en labelen tijdens het scrapen. Dat is een gamechanger voor zakelijke gebruikers:

- Marketing: Filter direct op alle landingspagina’s of blogs voor campagne-analyses.

- Sales: Zie in één oogopslag welke links bedrijfsprofielen, contactformulieren of downloads zijn.

- Operations: Scheid productpagina’s van supportdocumentatie of FAQ’s voor gerichte controles.

Met Thunderbit’s kun je zelfs bepalen hoe links gelabeld of verrijkt worden—zonder handmatig opruimen.

Praktijkvoorbeelden: Zo gebruiken teams “alle links crawlen”

Tijd voor de praktijk. Dit zijn scenario’s die ik bij Thunderbit-gebruikers heb gezien:

Marketing: Alle landingspagina’s van een concurrent verzamelen

Een SaaS-marketingteam wilde de advertentie-aanpak van een concurrent analyseren. Met Thunderbit crawlden ze de hele site, filterden op URLs met “/landing” en exporteerden zo 25+ landingspagina’s. Daarna haalden ze meta-beschrijvingen en koppen op om de boodschap te vergelijken en ontdekten snel hiaten in hun eigen content. Het resultaat? Betere advertentieprestaties en hogere conversie—zonder te programmeren.

Sales: Een hoogwaardige B2B-leadlijst bouwen

Een B2B-sales team richtte zich op het ledenoverzicht van een branchevereniging. Met Thunderbit crawlden ze alle ledenprofielen, en met de ingebouwde haalden ze contactmails van elke pagina. Wat voorheen weken handmatig werk was, was nu in minuten klaar—en de leads stonden direct in Google Sheets voor opvolging.

Stappenplan: Zo crawl je alle links op een website met Thunderbit

Zelf proberen? Zo crawl je alle links op een website met Thunderbit—zonder technische kennis.

Stap 1: Installeer de Thunderbit Chrome-extensie

- Ga naar de .

- Klik op “Toevoegen aan Chrome.”

- Log in of maak gratis een account aan. Thunderbit werkt op Chrome, Edge en andere Chromium-browsers, en ondersteunt 34 talen.

Stap 2: Open de gewenste website en start Thunderbit

- Navigeer naar de website die je wilt crawlen.

- Klik op het Thunderbit-icoon in je browser om de zijbalk te openen.

Stap 3: Gebruik AI Suggest Fields om alle links te detecteren

- Klik op “AI Suggest Fields.”

- Thunderbit’s AI scant de pagina en stelt kolommen voor zoals “Linktekst”, “URL” en “Categorie.”

- Controleer en pas de velden aan indien nodig (hernoemen, toevoegen of verwijderen).

Stap 4: Start met crawlen en exporteer de resultaten

- Klik op “Scrapen.”

- Thunderbit crawlt de pagina, volgt links en bouwt een gestructureerde tabel met alle URLs.

- Klaar? Klik op “Exporteren” om de data naar Excel, Google Sheets, Airtable, Notion of als CSV/JSON te sturen.

Stap 5: (Optioneel) Subpagina’s crawlen voor volledige dekking

- Selecteer in de resultaatentabel de kolom met URLs.

- Klik op “Subpagina’s scrapen” om Thunderbit elke link te laten bezoeken en extra data te verzamelen (zoals prijzen, contactinfo of beschrijvingen).

- Exporteer de verrijkte dataset voor diepere analyse.

Thunderbit versus andere link-crawling oplossingen

Zo verhoudt Thunderbit zich tot de traditionele methoden:

| Methode | Vaardigheid nodig | Complexiteit | Exportmogelijkheden | Subpagina’s scrapen | Gratis limieten | Pluspunten |

|---|---|---|---|---|---|---|

| Handmatig browsen | Geen | Hoog | Handmatig kopiëren | Nee | N.v.t. | Geen tools nodig |

| Sitemap/robots.txt | Laag | Laag | XML importeren | Nee | N.v.t. | Snel als beschikbaar |

| SEO-crawler (Screaming Frog) | Gemiddeld | Gemiddeld | CSV, Excel | Nee | 500 URLs (gratis) | Grondig, technische SEO-functies |

| Eigen script (Python) | Hoog | Hoog | Maatwerk | Ja (indien geprogrammeerd) | Onbeperkt (als je codeert) | Flexibel, aanpasbaar |

| No-code scraper (pre-AI) | Laag-gemiddeld | Gemiddeld | CSV, Excel, beperkt | Soms | Vaak betaalmuur | Makkelijker dan code, maar instellen vereist |

| Thunderbit | Geen | Zeer laag | Excel, Sheets, Notion | Ja | 6–10 pagina’s (gratis), schaalbaar | AI-gedreven, 2-kliks, onbeperkt exporteren |

Het voordeel van Thunderbit? Geen code, geen recepten, direct resultaat, subpagina’s crawlen en automatische categorisatie. Voor zakelijke gebruikers is het verschil tussen “ik kijk er later wel naar” en “het is al geregeld voor de lunchpauze.”

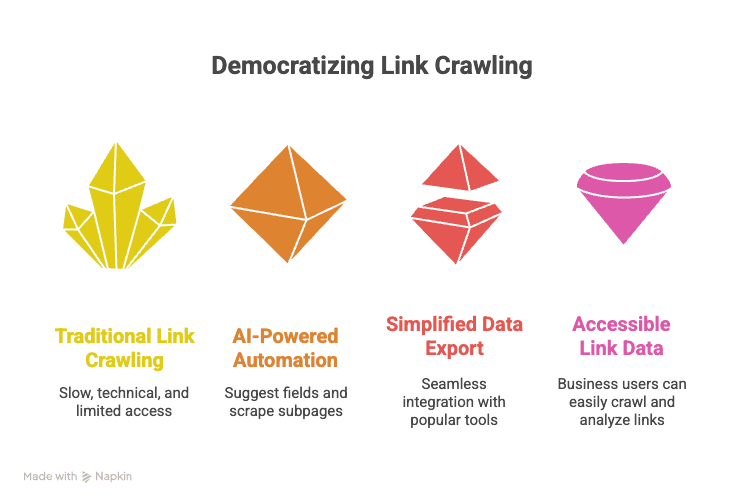

Samenvatting: Link crawling toegankelijk voor iedereen

- Alle links op een website crawlen is nu een zakelijke superkracht—niet alleen voor developers of SEO-specialisten.

- Gestructureerde linkdata versnelt sales, marketing en operations—van leadgeneratie tot concurrentieanalyse en cataloguscontroles.

- Traditionele tools zijn traag, technisch of beperkt—Thunderbit maakt het snel, eenvoudig en voor iedereen toegankelijk.

- AI Suggest Fields + Subpagina’s scrapen = productiviteit in twee klikken—nooit meer handmatig kopiëren of worstelen met scripts.

- Exporteer in seconden naar Excel, Sheets, Notion of Airtable—je data is direct bruikbaar, niet opgesloten in een tool.

Zelf ervaren hoe makkelijk ‘alle links op een website crawlen’ kan zijn? , probeer het op een site die je interessant vindt en ontdek hoeveel tijd (en frustratie) je bespaart. Meer tips, tutorials en praktijkvoorbeelden vind je op de .

Veelgestelde vragen

1. Wat is het verschil tussen crawlen, scrapen en indexeren?

Crawlen draait om het ontdekken van alle URLs op een website. Scrapen is het extraheren van specifieke data uit die URLs (zoals productinformatie of contactgegevens). Indexeren is het organiseren en opslaan van die data voor zoekopdrachten of analyses.

2. Waarom zou een zakelijke gebruiker alle links op een website willen crawlen?

Gestructureerde linkdata helpt sales bij het bouwen van leadlijsten, marketeers bij concurrentieanalyse en operations bij cataloguscontroles of het monitoren van wijzigingen. Het maakt van websites bruikbare databases voor outreach, analyse en automatisering.

3. Hoe verschilt Thunderbit van traditionele crawling tools?

Thunderbit gebruikt AI om velden voor te stellen en het crawlen te automatiseren—zonder code of ingewikkelde instellingen. Het verwerkt subpagina’s, categoriseert links en exporteert gestructureerde data direct naar Excel, Google Sheets, Notion of Airtable.

4. Kan Thunderbit omgaan met dynamische sites of pagina’s achter een login?

Ja! Thunderbit ondersteunt zowel browser- als cloudgebaseerd crawlen. Voor sites met login gebruik je de browsermodus; voor openbare sites is cloudmodus sneller en kun je tot 50 pagina’s tegelijk crawlen.

5. Is er een gratis versie van Thunderbit?

Zeker. Met het gratis plan van Thunderbit kun je tot 6 pagina’s crawlen (of 10 met een gratis proefboost), met onbeperkt exporteren. Betaalde plannen starten vanaf $15/maand voor grotere projecten.

Meer weten: