Laten we eerlijk zijn: in 2025 voelt het internet als één gigantische, constant veranderende spreadsheet—maar dan zonder die magische 'Exporteer naar Excel'-knop. (Was het maar zo simpel!) Als iemand die jarenlang SaaS- en automatiseringstools heeft gebouwd, zie ik dagelijks hoe sales-, marketing- en operationele teams smachten naar actuele, betrouwbare webdata—of het nu gaat om leads, prijsvergelijkingen of vastgoedtrends. De vraag naar webscraping is groter dan ooit, maar de manier waarop we het aanpakken verandert razendsnel.

Java is al jarenlang de go-to voor grootschalige, serieuze webscraping. Maar laten we eerlijk zijn: tenzij je een developer bent die in accolades denkt, voelt het opzetten van een Java-webscraper soms als het bouwen van een IKEA-kast zonder handleiding—en altijd blijven er schroeven over. Daarom ben ik zo enthousiast over de nieuwe generatie AI-webscrapers, zoals , die ik samen met mijn team heb ontwikkeld om data extraheren net zo makkelijk te maken als twee keer klikken—zonder code of HTML-kennis. In deze gids neem ik je mee in beide werelden: waarom Java nog steeds relevant is, wat er komt kijken bij het bouwen van een scraper, en hoe AI-tools webscraping voor iedereen toegankelijk maken.

Waarom webscraping met Java in 2025 nog steeds een slimme keuze is

Ondanks de opkomst van no-code en AI-gedreven tools, blijft Java de motor achter veel van de grootste webscrapingprojecten wereldwijd. Dat is niet voor niets: Java staat bekend om zijn prestaties, betrouwbaarheid en de mate van controle die je nodig hebt voor dataverzameling op enterprise-niveau.

Waar Java echt in uitblinkt

- Leadgeneratie & Sales: Dankzij Java’s kracht in gelijktijdige processen kun je miljoenen profielen van bijvoorbeeld bedrijvengidsen of LinkedIn in één nacht scrapen. Zo vul je je salesfunnel met verse leads terwijl je slaapt—zonder dat je aan de energiedrankjes hoeft.

- Concurrentieprijsmonitoring: E-commerce teams gebruiken Java-webscrapers om duizenden producten bij concurrenten te volgen en prijzen direct aan te passen. Zo zag Target bijvoorbeeld een ) na het inzetten van datagedreven prijsstrategieën.

- Vastgoeddataverzameling: Makelaars en investeerders gebruiken Java om woningaanbod, historische prijzen en demografische gegevens uit verschillende bronnen te combineren, waardoor investeringskansen sneller zichtbaar worden ().

- Financieel marktonderzoek: Investeringsmaatschappijen vertrouwen op Java’s stabiliteit voor het 24/7 scrapen van beurskoersen, nieuws en sentiment—want in de financiële wereld kan een paar seconden vertraging flink in de papieren lopen.

De afweging: flexibiliteit versus toegankelijkheid

Met Java heb je maximale controle: je kunt elk detail van je scraper tweaken, uitzonderingen afhandelen en direct integreren met je backend. Maar daar staat tegenover dat je echt programmeerkennis nodig hebt. Voor niet-developers is de leercurve steil en het onderhoud intensief. Daarom kiezen steeds meer zakelijke gebruikers voor AI-gedreven, no-code oplossingen voor dagelijkse scrapingbehoeften ().

De basis: wat is webscraping met Java?

Even simpel uitgelegd—zonder moeilijke termen.

Webscraping met Java betekent dat je een programma schrijft dat zich gedraagt als een robotbrowser: het bezoekt een webpagina, leest de inhoud en haalt de data op die jij nodig hebt. Zie het als een digitale stagiair die razendsnel informatie voor je kopieert—en nooit om een koffiepauze vraagt.

Hoe werkt het?

- Verzoek versturen: Je Java-programma haalt de ruwe HTML van een webpagina op, net als je browser.

- HTML parseren: Het programma leest de structuur van de pagina (al die

<div>,<span>en<table>tags). - Data extraheren: Je geeft aan wat je wilt verzamelen (bijvoorbeeld: “pak alle prijzen in

<span class='price'>”). - Exporteren: De data wordt opgeslagen in een CSV, Excel-bestand of database.

Voor statische sites is dit vrij eenvoudig. Voor dynamische sites (waar content via JavaScript wordt geladen) heb je extra tools nodig om een echte browser na te bootsen. Daarover straks meer.

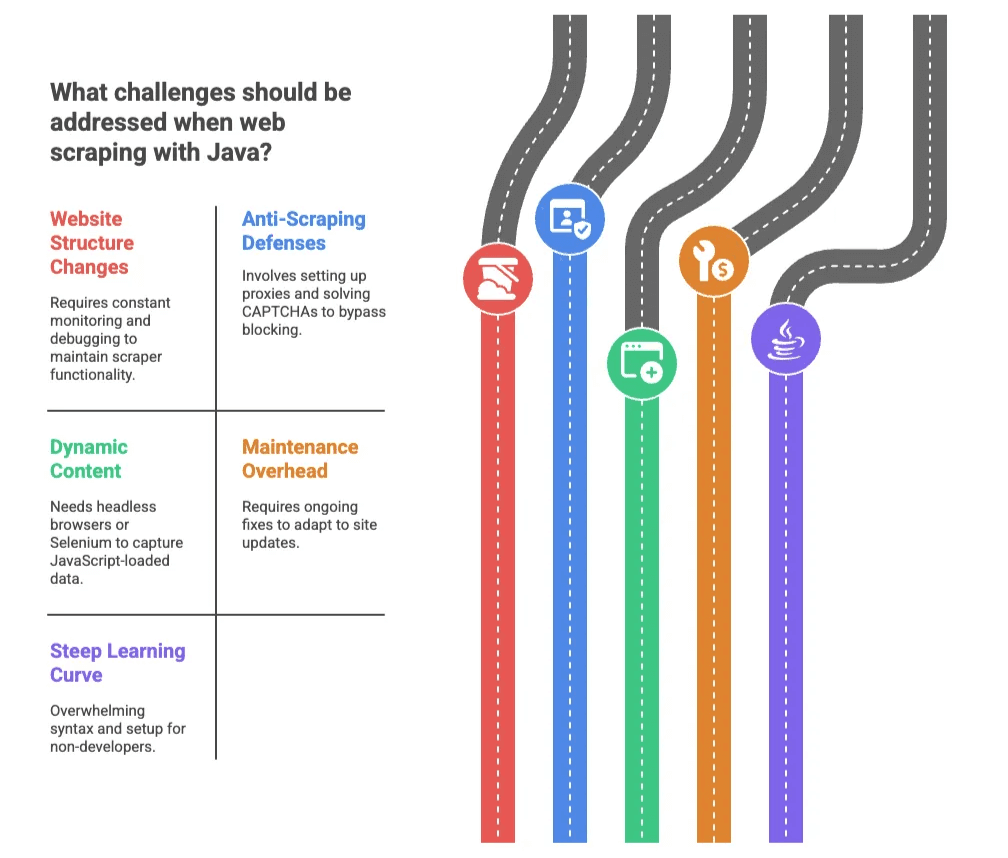

Belangrijkste uitdagingen bij webscraping met Java

Java is krachtig, maar het is niet altijd een wandeling door het park—tenzij jouw park vol zit met CAPTCHAs, IP-blokkades en HTML die wekelijks verandert. Dit zijn de grootste obstakels:

1. Veranderende websitestructuur

Websites veranderen hun opmaak vaak precies als je scraper eindelijk werkt. Zelfs een kleine aanpassing—zoals het hernoemen van een CSS-klasse—kan je code breken. Plotseling haalt je scraper alleen nog maar lucht binnen en zit jij ’s nachts te debuggen ().

2. Anti-scrapingmaatregelen

Websites weren scrapers met CAPTCHAs, IP-blokkades en limieten op het aantal verzoeken. Uit een recent onderzoek gaf aan dat blokkades hun grootste frustratie zijn. In Java betekent dit: proxies instellen, CAPTCHAs oplossen en je soms in een eindeloos kat-en-muisspel begeven.

3. Dynamische content

Veel moderne websites laden data pas na het openen van de pagina via JavaScript. Simpele Java-scrapers zien deze content niet. Je hebt dan headless browsers of tools als Selenium nodig—wat het proces ingewikkelder en trager maakt.

4. Onderhoudsintensief

Zelfs als je scraper werkt, moet je hem blijven bijhouden. Elke site-update kan je code breken, en jij (of je developer) moet dan direct aan de slag om het te repareren.

5. Steile leercurve

Voor niet-developers kan Java’s syntax en installatie overweldigend zijn. Zelfs kleine foutjes leiden tot onbegrijpelijke foutmeldingen. Het is alsof je leert schakelen—maar dan staat de auto in brand en is de weg van HTML gemaakt.

Traditionele Java-webscraping: wat komt erbij kijken?

Wil je toch zelf aan de slag met code? Dit is hoe het proces er meestal uitziet:

| Stap | Java-codemethode | AI/No-code tool |

|---|---|---|

| Omgeving opzetten | Installeer JDK, IDE, voeg libraries toe (uren werk voor beginners) | Installeer browserextensie of maak een account aan (enkele minuten) |

| Data identificeren | HTML inspecteren, selectors schrijven (kennis van HTML/CSS vereist) | AI detecteert velden automatisch, of selecteer met aanwijzen en klikken |

| Dynamische content | Selenium of HtmlUnit implementeren (complex, traag) | Automatisch geregeld door de tool |

| Debuggen & fixes | Foutmeldingen lezen, code aanpassen, testen | Tool lost meeste problemen op; gebruiker past velden aan indien nodig |

| Data exporteren | Code schrijven voor CSV/DB, handmatige integratie | Eén klik export naar Excel, Google Sheets, Airtable, Notion |

| Onderhoud | Sitewijzigingen monitoren, code bijwerken (doorlopend werk) | AI past zich aan, minimale inspanning gebruiker |

Populaire Java-webscraping libraries

- Jsoup: Ideaal voor statische HTML. Makkelijk in gebruik, maar kan geen JavaScript-content verwerken ().

- HtmlUnit: Simuleert een browser en kan JavaScript uitvoeren. Trager en soms moeite met moderne webtechnieken.

- Selenium: Stuurt een echte browser aan (Chrome, Firefox), perfect voor dynamische sites. Krachtig, maar zwaar en complex voor niet-programmeurs.

Kortom: Deze libraries zijn top voor developers, maar voor zakelijke gebruikers voelt het alsof je een raket moet bouwen om een pizza te bezorgen.

AI-webscraper oplossingen: webscraping voor iedereen

Hier wordt het pas echt interessant. AI-gedreven webscrapers zoals veranderen het spel door webscraping toegankelijk te maken voor iedereen—zelfs als je geen regel code kent.

Hoe werkt Thunderbit?

- AI stelt velden voor: Klik op een knop en de AI leest de pagina, stelt kolommen en gegevenstypen voor. Geen HTML-inspectie nodig.

- 2-kliks workflow: Gewoon “AI stelt velden voor” en “Scrapen”—de AI doet de rest.

- Subpagina’s scrapen: Meer details nodig? Thunderbit bezoekt automatisch subpagina’s (zoals product- of profielpagina’s) en vult je tabel aan.

- Overal exporteren: Stuur je data direct naar Excel, Google Sheets, Airtable of Notion met één klik.

- Cloud- of browserscraping: Kies cloud voor snelheid (tot 50 pagina’s tegelijk) of browsermodus voor sites waar je moet inloggen.

En ja, het is echt zo simpel. Ik heb niet-technische gebruikers in minder dan 10 minuten 500 concurrentproducten zien scrapen—zonder enige voorkennis.

Thunderbit versus traditionele Java-scraping: een snelle vergelijking

| Functie | Traditionele Java | Thunderbit AI-webscraper |

|---|---|---|

| Installatietijd | Uren tot dagen | Minuten (Chrome-extensie installeren) |

| Vereiste kennis | Java, HTML, CSS, debuggen | Geen (basis webnavigatie) |

| Onderhoud | Handmatig, doorlopend | AI past zich automatisch aan |

| Data exporteren | Handmatig coderen | 1-klik naar Excel, Sheets, Airtable, Notion |

| Dynamische content | Complex (Selenium/HtmlUnit) | Automatisch geregeld |

| Subpagina’s scrapen | Eigen crawlerlogica schrijven | Ingebouwd, met één klik |

| Schaalbaarheid | Multithreading, proxies coderen | Cloudscraping, parallel |

| Kosten | Ontwikkeltijd, infrastructuur | Betaalbare abonnementen, gratis versie beschikbaar |

Voor de meeste zakelijke gebruikers voelt Thunderbit als een verademing. Het is alsof je je handgeschakelde auto inruilt voor een zelfrijdende wagen.

Stappenplan: zo begin je met webscraping in Java

Wil je toch zelf Java proberen? Hier een kort, helder stappenplan:

-

Installeer je omgeving: Zet de Java Development Kit (JDK) en een IDE zoals IntelliJ of Eclipse op. Voeg een library als Jsoup toe voor HTML-parsing ().

-

Kies je doelwit: Open de website in je browser, inspecteer de HTML en zoek de elementen die je wilt (bijvoorbeeld productnamen, prijzen).

-

Schrijf de code: Gebruik Jsoup om de pagina op te halen en de gewenste data te selecteren. Bijvoorbeeld:

1Document doc = Jsoup.connect("http://example.com/page").get(); 2Elements prices = doc.select("span.price"); 3for (Element price : prices) { 4 System.out.println(price.text()); 5} -

Omgaan met paginering: Doorloop meerdere pagina’s door de URL aan te passen of “Volgende” links te volgen.

-

Data exporteren: Schrijf de resultaten naar een CSV-bestand zodat je ze in Excel of Google Sheets kunt openen.

-

Testen en verfijnen: Draai je scraper, los fouten op en pas selectors aan waar nodig.

Tips voor het onderhouden van je Java-webscraper

- Controleer je output: Kijk regelmatig of je data compleet is.

- Centraliseer selectors: Houd al je HTML-selectors op één plek voor makkelijk onderhoud.

- Omzeil blokkades: Gebruik proxies en wissel user agents als je geblokkeerd wordt.

- Documenteer alles: Voorzie je code van commentaar en houd bij wat elk deel doet.

- Blijf binnen de regels: Controleer altijd de gebruiksvoorwaarden en robots.txt van een site voordat je gaat scrapen.

Klinkt dit als veel werk? Dat is het ook. Daarom stappen steeds meer teams over op AI-tools.

Wanneer kies je voor AI-webscraper tools zoals Thunderbit?

Welke route past bij jou? Mijn advies na jaren in het veld:

Kies voor Java als:

- Je zeer specifieke logica, diepe integratie of scraping op grote schaal nodig hebt.

- Je organisatie strenge eisen stelt aan beveiliging of compliance.

- Je developers en tijd hebt om de code te onderhouden.

Kies voor Thunderbit (of een andere AI-webscraper) als:

- Je niet wilt of kunt programmeren.

- Je snel data nodig hebt, met minimale setup.

- De websitestructuur vaak verandert, of je veel verschillende sites wilt scrapen.

- Je direct wilt exporteren naar Excel, Google Sheets, Airtable of Notion.

- Je waarde hecht aan je gemoedsrust.

Thunderbit is vooral ideaal voor sales-, e-commerce- en vastgoedteams die repetitieve dataverzameling willen automatiseren zonder afhankelijk te zijn van IT. Ook voor ad-hoc projecten, snelle leadgeneratie of concurrentiemonitoring is het perfect—kortom, in elke situatie waar snelheid en eenvoud belangrijk zijn.

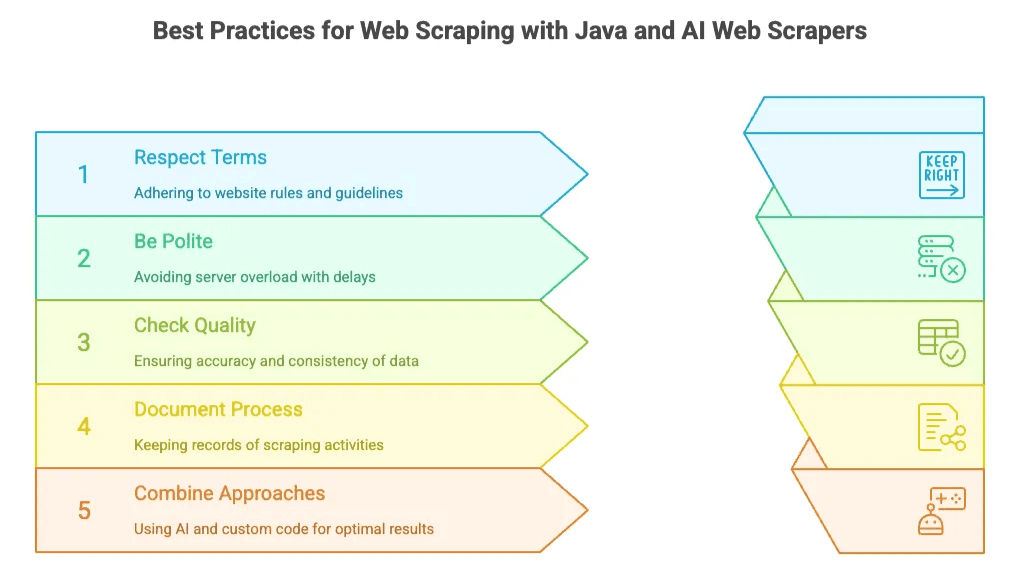

Best practices voor webscraping met Java en AI-webscrapers

Welke aanpak je ook kiest, een paar gouden regels gelden altijd:

- Respecteer de regels van websites: Check altijd robots.txt en de gebruiksvoorwaarden. Scrape geen privé- of gevoelige data.

- Wees beleefd: Overbelast servers niet—voeg vertragingen toe tussen verzoeken als je codeert, of gebruik de ingebouwde limieten van AI-tools.

- Controleer datakwaliteit: Bekijk je resultaten op juistheid en volledigheid. Thunderbit’s “Field AI Prompt” helpt je data direct te structureren en opschonen.

- Documenteer je proces: Houd bij wat je scrapt, waarvandaan en hoe vaak.

- Combineer methodes: Soms is het slim om snel te starten met een AI-tool en daarna over te stappen op maatwerkcode voor geavanceerde wensen.

Conclusie: de toekomst van webscraping voor zakelijke gebruikers

Webscraping in 2025 draait om keuzevrijheid. Java blijft de krachtpatser voor grootschalige, maatwerkprojecten. Maar voor de meeste zakelijke gebruikers—sales, marketing, operations—betekent de opkomst van AI-webscrapers zoals dat je geen developer meer hoeft te zijn om de kracht van webdata te benutten.

De markt groeit hard: de wereldwijde markt voor webscrapingsoftware zal naar verwachting , en gebruikt in 2028 geautomatiseerde analysetools. De boodschap is duidelijk: datagedreven werken is de toekomst, en de tools worden alleen maar slimmer.

Twijfel je nog? Probeer dan eens de . Je kunt gratis aan de slag en zult versteld staan hoeveel je met een paar klikken voor elkaar krijgt. (En ben je een developer die van Java houdt? Geen zorgen—voor de grote, complexe scrapingklussen blijft jouw expertise onmisbaar.)

Meer weten? Check onze voor diepgaande artikelen, tutorials en best practices—zoals en .

Veel succes met scrapen—en moge je data altijd actueel, compleet en binnen handbereik zijn. Was alles in het leven maar zo makkelijk, toch?

Veelgestelde vragen

1. Waarom zou je in 2025 nog Java gebruiken voor webscraping?

Java blijft een topkeuze voor grootschalige, professionele scraping vanwege de snelheid, betrouwbaarheid en flexibiliteit. Het is ideaal voor toepassingen als financiële monitoring, prijsvergelijkingen en het scrapen van grote lead-databases—vooral als je veel controle of backend-integratie nodig hebt.

2. Wat zijn de nadelen van webscraping met Java?

Hoewel krachtig, brengt Java-scraping uitdagingen met zich mee: een steile leercurve, veel onderhoud, frequente storingen door HTML-wijzigingen, lastig bij JavaScript-rijke sites en een complexe setup met proxies, CAPTCHAs en paginering.

3. Hoe maken AI-tools zoals Thunderbit scrapen makkelijker?

Thunderbit automatiseert het hele scrapingproces: het detecteert velden met AI, verwerkt dynamische content, navigeert subpagina’s en exporteert data direct naar tools als Excel of Notion. Je hebt geen code, HTML of installatie nodig—dus ook niet-technische gebruikers kunnen ermee aan de slag.

4. Wanneer kies ik voor Thunderbit in plaats van Java?

Thunderbit is ideaal voor zakelijke gebruikers die snel en betrouwbaar data willen zonder te programmeren. Perfect voor sales, e-commerce en ad-hoc onderzoek waar snelheid en eenvoud belangrijker zijn dan maatwerklogica.

5. Kan ik Java en AI-scrapingtools combineren?

Zeker. Veel teams starten met AI-tools zoals Thunderbit voor snelle resultaten en stappen daarna over op Java voor geavanceerde of grootschalige taken. Zo combineer je gebruiksgemak met de kracht van maatwerk.

Meer weten: