Ik weet het nog goed: de allereerste keer dat ik probeerde een website te scrapen om een lijst met sales leads te verzamelen. Ik dacht bij mezelf: “Ik kan JavaScript, hoe lastig kan het zijn?” Een paar uur later zat ik tot over mijn oren in lastige selectors, verdwijnende dynamische content en kreeg ik steeds meer respect voor anti-botmaatregelen. Blijkbaar ben ik niet de enige— geeft aan dat data steeds belangrijker wordt, en webscraping staat daarbij centraal. Maar naarmate websites slimmer worden, is webscraping met JavaScript zowel een krachtig wapen als een flinke uitdaging.

In deze gids deel ik alles wat ik heb geleerd over webscraping met JavaScript—van de basics tot de valkuilen, en hoe moderne AI-tools zoals je kunnen redden van selector-frustraties. Of je nu productlijsten verzamelt voor je webshop of leads zoekt voor sales, laten we samen de wereld van webscraping met JavaScript (en een beetje AI) induiken.

Webscraping met JavaScript: De Basis en Beperkingen

Laten we bij het begin beginnen: webscraping met JavaScript betekent dat je met scripts automatisch data van websites haalt, ofwel direct in de browser of via Node.js op de achtergrond. JavaScript is dé taal van het web, dus het voelt logisch om het hiervoor te gebruiken—zeker met handige libraries als Cheerio (voor statische HTML), Puppeteer en Playwright (voor headless browser-automatisering).

Waarom is JavaScript zo populair voor scraping?

- Directe toegang tot de DOM: In de browser kun je de DOM benaderen zoals een gebruiker dat zou doen.

- Uitgebreid ecosysteem: Met Node.js heb je toegang tot krachtige libraries voor HTTP-verzoeken, parsing en automatisering.

- Flexibiliteit: Je kunt logins, klikken, scrollen en meer automatiseren—alles wat je in Chrome doet, kun je scripten.

Maar er zit een keerzijde aan: moderne websites veranderen continu. Ze laden content dynamisch in met JavaScript, herschikken DOM-elementen en gebruiken anti-botmaatregelen. Daardoor werkt je script vandaag, maar morgen misschien niet meer. Je bent constant selectors aan het aanpassen, pop-ups aan het wegklikken en data aan het najagen die asynchroon wordt geladen. Het lijkt soms op een potje whack-a-mole, maar dan met meer accolades.

Waarom Moderne Webpagina’s Moeilijker te Scrapen Zijn met JavaScript

Vroeger was scrapen simpel: HTML ophalen en de data eruit vissen. Maar tegenwoordig zijn sites als Facebook Marketplace, Amazon of zelfs lokale woningplatforms gebouwd met JavaScript-frameworks die content live renderen, data verstoppen achter eindeloos scrollen en informatie diep in de DOM verstoppen.

Gewoon HTML parsen is vaak niet meer genoeg. Bijvoorbeeld: productreviews of geneste reacties ophalen draait niet alleen om de juiste <div> vinden, maar ook om de relaties tussen elementen, de context van elk veld en soms zelfs de betekenis van de data.

Hier komt slimme pre-processing om de hoek kijken. In plaats van alleen ruwe HTML te pakken, heb je een manier nodig om de pagina semantisch te begrijpen: wat is een productnaam, wat is een prijs, wat is een gebruikersreview? Dat is lastig met standaard JavaScript—maar precies waar AI-tools het verschil maken.

Traditionele JavaScript Webscraping Tools

Laten we het over tools hebben. De klassieke JavaScript scraping stack bestaat meestal uit één (of meer) van deze opties:

- Cheerio: Ideaal voor het parsen van statische HTML. Zie het als jQuery voor de server.

- Puppeteer/Playwright: Headless browser-automatisering. Hiermee start je een echte browser, voer je JavaScript uit en kun je de pagina bedienen alsof je een gebruiker bent (of een hyperactieve robot).

Een standaard workflow ziet er zo uit:

- Vraag de pagina op (met of zonder headless browser).

- Wacht tot de content geladen is (soms met

waitForSelectorof iets vergelijkbaars). - Parse de DOM om de gewenste data te vinden.

- Haal de data eruit en structureer het.

Klinkt eenvoudig, toch? Maar hier zit het probleem: elke keer dat de website zijn layout aanpast, werken je selectors niet meer. Komt er een nieuwe pop-up bij, dan loopt je script vast. Wordt de volgorde van velden aangepast, dan raakt je data in de war. Onderhoud wordt zo een eindeloze klus.

Vergelijking van Populaire JavaScript Scraping Libraries

| Functie | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| Beste voor | Statische HTML | Dynamische pagina's | Dynamische pagina's |

| Browserautomatisering | Nee | Ja | Ja |

| Kan JS-content aan | Nee | Ja | Ja |

| Snelheid | Snel | Langzamer | Langzamer |

| API-gemak | Eenvoudig | Gemiddeld | Gemiddeld |

| Anti-bot omzeiling | Beperkt | Gemiddeld | Gemiddeld |

| Cross-browser | Nee | Alleen Chrome | Chrome, Firefox, WebKit |

| Toepassingen | Simpele sites, API's | Interactieve sites | Interactieve sites |

Cheerio is supersnel voor statische pagina’s of API’s die HTML teruggeven, maar kan geen JavaScript uitvoeren. Puppeteer en Playwright zijn ideaal voor dynamische sites, maar zijn zwaarder en vragen meer configuratie. Ze kunnen logins, klikken en scrollen automatiseren, maar je moet nog steeds zelf de logica schrijven voor elke verandering op de site.

Maak kennis met Thunderbit: AI-webscraper voor JavaScript Workflows

Nu wordt het interessant. Bij Thunderbit zagen we dat scrapen niet alleen draait om HTML ophalen—het gaat om het begrijpen van de pagina zoals een mens dat doet. Daarom hebben we ontwikkeld, een AI-webscraper Chrome-extensie die webscraping een semantische laag geeft.

Hoe werkt het?

- Thunderbit zet de webpagina om naar een Markdown-weergave—een schonere, gestructureerde versie van de pagina.

- Vervolgens analyseert onze AI de Markdown om velden, relaties en context te herkennen—zo weet het wat een prijs is, wat een review is en wat alleen een decoratieve emoji is.

- Het resultaat? Je krijgt gestructureerde, gelabelde data die bestand is tegen layout-wijzigingen, dynamische content en veranderende DOM-structuren.

Voor zakelijke gebruikers betekent dit minder handmatig opschonen, minder kapotte scripts en meer tijd voor echte inzichten. En voor ontwikkelaars: je kunt je richten op het automatiseren van het browsen (logins, klikken, scrollen) en Thunderbit laat het lastige extractiewerk voor je doen.

Stapsgewijs: Webscraping met JavaScript (Traditioneel en met Thunderbit)

Tijd om praktisch te worden. We gaan een voorbeeld uitwerken: productlijsten scrapen van een fictieve webshop. Eerst doen we het op de traditionele manier met Puppeteer. Daarna laat ik zien hoe je met Thunderbit je workflow versnelt.

Stap 1: Je JavaScript Scraping-omgeving opzetten

Eerst heb je nodig. Daarna kun je Puppeteer installeren:

1npm install puppeteerLiever Playwright (voor meer browseropties)? Gebruik dan:

1npm install playwrightGeen zorgen als je niet technisch bent: je kunt de code gewoon kopiëren en plakken, ik leg uit wat elk deel doet.

Stap 2: Navigeren en Interactie met Dynamische Pagina’s

Moderne sites verstoppen data vaak achter logins, pop-ups en eindeloos scrollen. Zo kun je die stappen automatiseren met Puppeteer:

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // Ga naar de loginpagina

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'your_username');

8 await page.type('#password', 'your_password');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // Ga naar de productpagina

12 await page.goto('https://example.com/products');

13 // Scroll om meer items te laden

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // Wacht tot producten geladen zijn

21 await page.waitForSelector('.product-card');

22 // ... (data extractie volgt in de volgende stap)

23})();Dit script logt in, navigeert naar de productenpagina en scrollt om meer items te laden. Het is belangrijk om te wachten tot elementen zichtbaar zijn—anders scrape je lucht.

Stap 3: Data Extractie met JavaScript

Nu gaan we de data ophalen. Stel dat elk product in een .product-card div staat:

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);Veelvoorkomende valkuilen:

- Selectors zijn kwetsbaar. Als de site

.product-titleverandert in.title, werkt je script niet meer. - Verborgen data. Prijzen of reviews worden soms pas na het laden via AJAX opgehaald.

- Anti-botmaatregelen. Te veel verzoeken? Dan kun je geblokkeerd worden.

Stap 4: Extractie Versnellen met Thunderbit AI

Hier komt Thunderbit om de hoek kijken. In plaats van te worstelen met selectors en breekbare logica, kun je de gerenderde HTML (of zelfs een screenshot) aan Thunderbit geven voor AI-gedreven extractie.

Hoe werkt dat in de praktijk?

- Gebruik Puppeteer of Playwright om het browsen, inloggen en navigeren te automatiseren.

- Zodra je op de juiste pagina bent, haal je de HTML op:

1const pageContent = await page.content();- Stuur deze HTML naar Thunderbit (via de ) voor AI-extractie.

Thunderbit zal:

- De pagina omzetten naar Markdown voor eenvoudige semantische analyse.

- AI inzetten om velden, relaties en context te herkennen.

- Gestructureerde data opleveren die je direct kunt exporteren naar Excel, Google Sheets, Airtable of Notion.

Nooit meer achter selectors aanjagen of rommelige data opschonen.

Omgaan met Dynamische Content en Asynchroon Laden

Dynamische content is de nachtmerrie van elke webscraper. Sites laden data vaak pas na het eerste renderen—denk aan eindeloos scrollen, “Laad meer”-knoppen of AJAX-reviews.

Traditionele aanpak:

- Gebruik

waitForSelectorom te wachten tot elementen zichtbaar zijn. - Wacht tot het netwerk stil is (geen verzoeken meer) voor je gaat scrapen.

- Scroll of klik handmatig om meer data te laden.

Maar deze methodes zijn kwetsbaar. Verandert de site zijn laadmethode, dan werkt je script niet meer.

Thunderbit’s aanpak: Door de pagina om te zetten naar Markdown en AI de structuur te laten analyseren, is Thunderbit minder afhankelijk van specifieke DOM-structuren of IDs. Zelfs als de layout verandert, kan Thunderbit’s AI de content meestal nog vinden en extraheren. Dat betekent minder onderhoud en betrouwbaardere data.

Een Duurzame Datapijplijn Bouwen: Van Script tot Zakelijk Inzicht

Scrapen is geen eenmalige klus—het is het begin van een datastroom. Zo pak ik het aan:

- Automatiseer het browsen en extractie met JavaScript (Puppeteer/Playwright).

- Laat Thunderbit het werk doen voor AI-gedreven structurering en labeling.

- Exporteer de resultaten naar je favoriete tool: Excel, Google Sheets, Airtable, Notion.

- Plan terugkerende taken met Thunderbit’s —beschrijf je interval (“elke maandag om 9:00”), vul je URLs in en Thunderbit regelt de rest.

- Sluit de cirkel door gestructureerde data in je bedrijfsprocessen te gebruiken—of dat nu sales, prijsmonitoring of marktonderzoek is.

Deze combinatie—JavaScript voor automatisering, Thunderbit voor AI-extractie—maakt het mogelijk om herhaalbare, onderhoudsarme datastromen te bouwen die je bedrijf voorzien van actuele, betrouwbare data.

Conclusie: Kies de Juiste Webscraping-aanpak voor Jouw Doel

Wat is nu de beste manier om het web te scrapen met JavaScript? Mijn advies:

- Traditioneel scrapen met JavaScript (Cheerio, Puppeteer, Playwright) werkt prima voor simpele, statische sites of als je volledige controle wilt over browserautomatisering. Maar het vraagt veel onderhoud—selectors breken, layouts veranderen en anti-botmaatregelen worden steeds strenger.

- AI-extractie met Thunderbit voegt een semantische laag toe. Het is robuuster tegen veranderingen, vraagt minder handmatig opschonen en laat je focussen op inzichten in plaats van debuggen.

Wanneer kies je wat?

- Voor snelle, eenmalige scrapes van simpele pagina’s: gebruik Cheerio of Puppeteer.

- Voor complexe, dynamische sites—of als je je workflow toekomstbestendig wilt maken—combineer je JavaScript-scripts met Thunderbit’s AI-extractie.

- Voor zakelijke gebruikers die geen code willen schrijven, is de Thunderbit Chrome-extensie de snelste manier om van webpagina naar spreadsheet te gaan.

Meer voorbeelden zien? Bekijk voor diepgaande artikelen over , en meer.

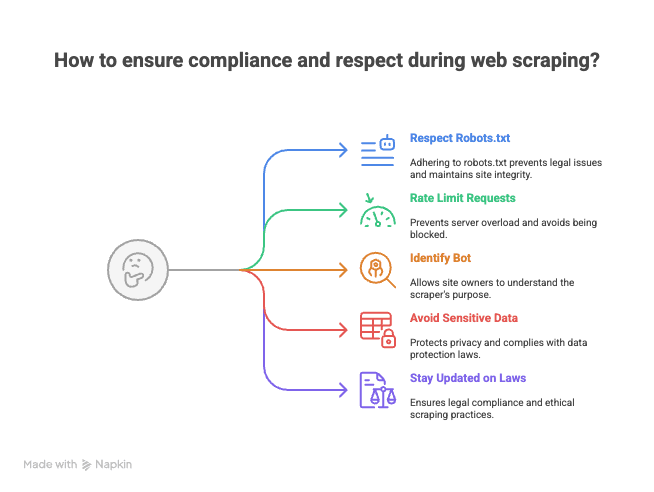

Bonus: Tips om Eerlijk en Wettelijk te Scrapen

Voordat je je scraping scripts loslaat op het web, een paar tips (van iemand die al eens een “vriendelijke” mail van een websitebeheerder kreeg):

- Respecteer robots.txt en de gebruiksvoorwaarden. Niet elke site wil gescrapet worden.

- Beperk je verzoeken. Stuur niet te veel verzoeken tegelijk—anders word je geblokkeerd (of erger, op een zwarte lijst gezet).

- Identificeer je bot. Gebruik een eigen User-Agent zodat site-eigenaren weten wie je bent.

- Vermijd het scrapen van gevoelige of persoonlijke data. Blijf bij openbare informatie en respecteer privacy.

- Blijf op de hoogte van wetgeving en best practices. Webscraping zit in sommige landen in een juridische grijze zone.

Onthoud: met grote scraping-kracht komt grote verantwoordelijkheid (en soms een pittige e-mail van een jurist).

Webscraping met JavaScript is zowel een kunst als een wetenschap. Met de juiste tools—en een beetje AI—maak je van het web je eigen gestructureerde databron. En als je vastloopt, weet je me te vinden (ik zit waarschijnlijk selectors te debuggen met een kop koffie en een Thunderbit-tab open).

Succes met scrapen!

Veelgestelde Vragen

1. Wat is webscraping met JavaScript en waarom is het zo populair?

Webscraping met JavaScript betekent dat je met scripts automatisch data van websites haalt, in de browser of via Node.js. Het is populair omdat JavaScript directe toegang tot de DOM biedt, een rijk ecosysteem aan libraries heeft voor HTTP-verzoeken en automatisering, en veel flexibiliteit geeft om interacties zoals logins, klikken en scrollen te automatiseren.

2. Wat zijn de grootste uitdagingen bij het scrapen van moderne, dynamische websites?

Moderne websites gebruiken vaak JavaScript-frameworks om content dynamisch te laden, data te verstoppen achter eindeloos scrollen of pop-ups, en hun layout regelmatig te veranderen. Daardoor zijn traditionele scraping-methodes kwetsbaar: scripts breken snel als selectors veranderen of data asynchroon wordt geladen.

3. Hoe verhouden traditionele JavaScript scraping tools als Cheerio, Puppeteer en Playwright zich tot elkaar?

- Cheerio is ideaal voor statische HTML en werkt snel, maar kan geen JavaScript-rendered content of browserautomatisering aan.

- Puppeteer en Playwright zijn gemaakt voor dynamische pagina’s, ondersteunen browserautomatisering en kunnen JavaScript-content aan, maar zijn trager en vragen meer setup. Playwright ondersteunt meerdere browsers, Puppeteer vooral Chrome.

4. Welke voordelen biedt Thunderbit ten opzichte van traditionele scraping-methodes?

Thunderbit gebruikt AI om webpagina’s semantisch te begrijpen door ze om te zetten naar een gestructureerd Markdown-formaat en daaruit gelabelde data te halen. Deze aanpak is robuuster tegen layout-wijzigingen, vermindert handmatig opschonen en vraagt minder onderhoud dan traditionele selector-gebaseerde scraping.

5. Wat zijn best practices om eerlijk en wettelijk te scrapen?

- Controleer en respecteer altijd de robots.txt en gebruiksvoorwaarden van een website.

- Beperk je verzoeken om servers niet te overbelasten.

- Identificeer je bot met een eigen User-Agent.

- Vermijd het scrapen van gevoelige of persoonlijke data en blijf bij openbare informatie.

- Blijf op de hoogte van de wetgeving en best practices in jouw regio.

Meer weten: