Eerlijk is eerlijk: de eerste keer dat ik probeerde om alle URL’s van een grote website te verzamelen, dacht ik: “Hoe moeilijk kan dat nou zijn?” Een paar uur later zat ik nog steeds als een malle te klikken, links te kopiëren en te plakken in een spreadsheet, en vroeg ik me serieus af waar ik aan begonnen was. Als je ooit hebt geprobeerd om alle pagina’s van een website te vinden—voor een content-audit, een lijst met leads of concurrentieonderzoek—dan weet je precies hoe frustrerend het is. Het is saai, je maakt snel fouten en het is gewoon zonde van je tijd en energie.

Gelukkig hoeft het tegenwoordig niet meer zo omslachtig. Dankzij AI-tools zoals kun je nu alle URL’s van een domein binnen een paar minuten verzamelen, in plaats van dagen. Bedrijven die AI-gestuurde webscraping inzetten, besparen op dataverzameling, en sommigen zien zelfs vergeleken met handmatig werk. Dat zijn geen loze cijfers—dat zijn uren (of zelfs dagen) die je gewoon terugkrijgt.

Laten we dus eens kijken waarom alle pagina’s van een website vinden zo’n gedoe is, waarom algemene AI-modellen zoals GPT of Claude hier niet in uitblinken, en hoe gespecialiseerde AI-agents—zoals Thunderbit—dit klusje juist supermakkelijk maken. En ja, ik laat je stap voor stap zien hoe je elke URL kunt verzamelen, zelfs als je geen techneut bent.

Waarom Alle URL’s op een Domein Vinden Zo Lastig Is

Websites zijn niet gemaakt om je een lekker overzichtelijk lijstje van alle pagina’s te geven. Ze zijn bedoeld voor bezoekers, niet voor mensen die in één keer alle pagina’s willen vinden. Dat maakt het zo lastig:

- Handmatig Kopiëren en Plakken: Door elk menu, lijstje en directory klikken en URL’s één voor één kopiëren is een recept voor muisarm (en je mist sowieso pagina’s).

- Paginering en Oneindig Scrollen: Veel sites verdelen content over meerdere pagina’s of laden meer resultaten als je scrolt. Mis je een “Volgende”-knop of scroll je niet ver genoeg, dan mis je hele secties.

- Verschillende Pagina-indelingen: Sommige pagina’s tonen links op hun eigen manier, andere weer anders. Het overzicht houden is een ramp.

- Verborgen of Weespagina’s: Niet elke pagina is via het hoofdmenu te vinden. Sommige zijn diep verstopt, alleen bereikbaar via een sitemap of interne zoekfunctie.

- Menselijke Fouten: Hoe meer je handmatig kopieert, hoe groter de kans op fouten—dubbele URL’s, typefouten of gewoon iets vergeten.

Werk je met een site van honderden of duizenden pagina’s? Dan kun je handmatig verzamelen wel vergeten. Zoals een datateam het mooi zei: bij alles wat niet simpel is, .

Wat Bedoelen We Eigenlijk met “Alle Pagina’s op een Website Vinden”?

Voordat we naar de oplossingen gaan, eerst even duidelijk wat we precies zoeken:

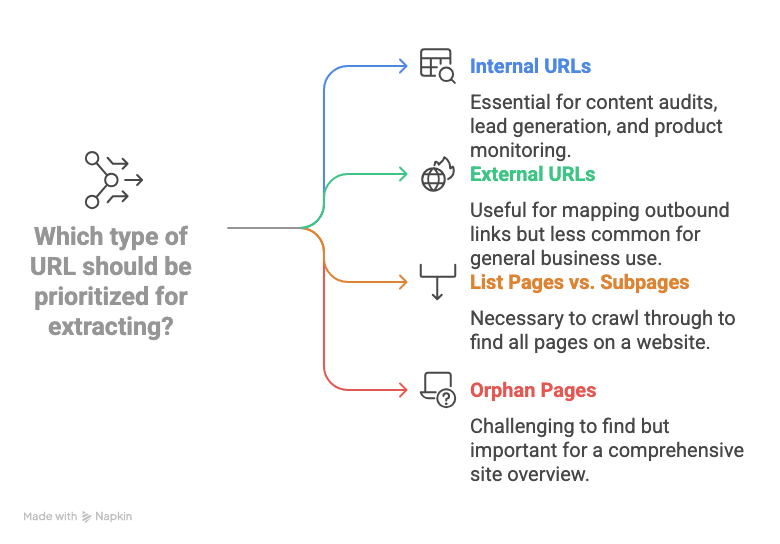

- Interne URL’s: Links die verwijzen naar pagina’s op hetzelfde domein (zoals /over-ons of /producten/widget-123). Voor de meeste zakelijke toepassingen—content-audits, leadgeneratie, productmonitoring—zijn dit de belangrijkste.

- Externe URL’s: Links naar andere websites. Meestal heb je deze niet nodig, tenzij je uitgaande links wilt analyseren.

- Lijstpagina’s vs. Subpagina’s: Veel sites hebben “hub”- of “lijst”-pagina’s (denk aan categorieën, blogoverzichten, directories) die weer doorverwijzen naar detailpagina’s (zoals producten of profielen). Om echt alle pagina’s te vinden, moet je deze lijsten doorlopen en alle subpagina’s meenemen.

- Weespagina’s: Pagina’s die nergens duidelijk gelinkt zijn. Soms vind je ze via een sitemap of interne zoekfunctie, maar ze zijn makkelijk te missen.

Kortom: met alle URL’s op een domein vinden bedoelen we: elke interne pagina-URL verzamelen, van de homepage tot de diepste product- of artikelpagina, liefst in een handig formaat (zoals een spreadsheet).

Traditionele Manieren om Alle URL’s op een Domein te Vinden

Er zijn een paar klassieke methodes, maar die hebben allemaal hun nadelen:

Handmatig Kopiëren en Browsertools

Dit is de “old school” aanpak: elke link aanklikken, URL kopiëren, plakken in een spreadsheet, en hopen dat je niks mist. Sommige mensen gebruiken browserextensies om alle links van de huidige pagina te pakken, maar je moet dit alsnog voor elke pagina herhalen, en paginering of verborgen secties moet je zelf uitzoeken. Prima voor een minisite, maar niet voor grotere projecten.

Site Search en Sitemaps Gebruiken

- Google’s site: Zoekopdracht: Typ site:jouwdomein.nl in Google en je ziet een lijst met geïndexeerde pagina’s. Maar Google toont alleen wat het heeft geïndexeerd (vaak maximaal 1.000 resultaten), dus je mist nieuwe, verborgen of minderwaardige pagina’s. geeft toe dat dit geen volledige oplossing is.

- XML Sitemaps: Veel sites hebben een /sitemap.xml met belangrijke URL’s. Handig—mits de sitemap actueel is en alles bevat. Niet elke site heeft er een, sommige splitsen de sitemap op in meerdere bestanden. Weespagina’s ontbreken vaak.

Technische Crawlers en Scripts

- SEO Tools (zoals Screaming Frog): Deze crawlen een site als een zoekmachine en geven een lijst met URL’s. Krachtig, maar je moet het instellen, configureren en soms een licentie aanschaffen voor grote sites.

- Python Scripts (zoals Scrapy): Ontwikkelaars kunnen scripts schrijven om URL’s te verzamelen. Maar als je niet technisch bent, is dit geen optie. Bovendien breken scripts als de site-indeling verandert, dus je bent altijd aan het bijwerken.

Kortom: Traditionele methodes zijn te handmatig, te onvolledig of te technisch voor de meeste zakelijke gebruikers. Niet gek dat veel mensen halverwege afhaken.

Waarom Algemene AI-Modellen URL-Extractie Niet Volledig Kunnen Automatiseren

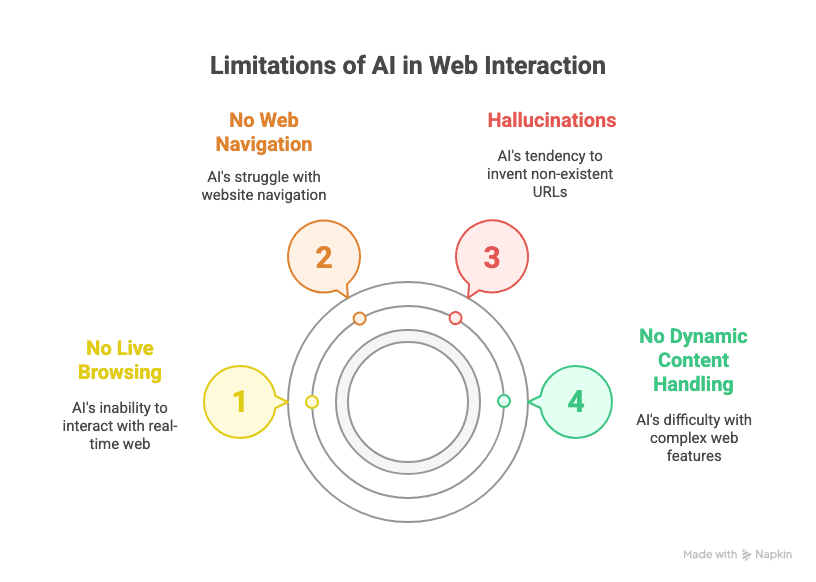

Misschien denk je: “Kan ik ChatGPT of Claude niet gewoon vragen om alle pagina’s van een website te vinden?” Was het maar zo makkelijk. De realiteit:

- Geen Live Browsen: Algemene AI-modellen zoals GPT of Claude kunnen niet live op het web surfen. Ze zien de actuele website niet—ze werken alleen met hun trainingsdata of wat je erin plakt.

- Geen Webnavigatie: Zelfs met plugins of browse-mogelijkheden weten LLM’s niet hoe ze op “Volgende” moeten klikken, oneindig moeten scrollen of systematisch alle links moeten volgen.

- Fantasielinks: Vraag een generieke AI om alle URL’s van een domein, en hij verzint vaak links die logisch klinken maar niet bestaan. (Ik heb ze /over-ons-pagina’s zien verzinnen die nooit hebben bestaan.)

- Geen Dynamische Content: Sites die content laden met JavaScript, inloggen vereisen of complexe navigatie hebben, zijn niet te doen voor algemene LLM’s.

Zoals het zegt: “Wil je honderden of duizenden pagina’s scrapen… dan schiet ChatGPT tekort.” Je hebt een tool nodig die hiervoor is gemaakt.

Verticale AI-Agents Zijn de Toekomst (En Waarom Dat Belangrijk Is)

Hier komt mijn ervaring met SaaS en automatisering om de hoek kijken: verticale AI-agents—AI-tools die zijn gebouwd voor een specifiek domein, zoals webdata-extractie—zijn de enige manier om betrouwbare, schaalbare resultaten te krijgen voor zakelijke taken. Waarom?

- Algemene LLM’s zijn prima voor tekst of zoeken, maar ze verzinnen dingen en kunnen geen stabiele, herhaalbare workflows aan zoals bedrijven nodig hebben.

- Zakelijke SaaS-tools moeten veel repetitieve, gestructureerde taken automatiseren. Daar blinken verticale AI-agents in uit—ze zijn gebouwd om één ding te doen, en dat goed, met minimale fouten.

- Voorbeelden zijn er genoeg: Thunderbit voor webdata, Devin AI voor softwareontwikkeling, Alta voor salesautomatisering, Infinity Learn’s IL VISTA voor onderwijs, Rippling voor HR, Harvey voor juridisch… enzovoort.

Kortom: als je alle pagina’s van een website betrouwbaar wilt vinden, heb je een verticale AI-agent nodig die hiervoor is gebouwd—geen algemene chatbot.

Maak Kennis met Thunderbit: AI-gestuurde URL-Extractie voor Iedereen

Hier komt om de hoek kijken. Als AI-webscraper Chrome-extensie is Thunderbit gemaakt voor zakelijke gebruikers—geen code, geen technische installatie, gewoon resultaat. Wat maakt het uniek?

- Natuurlijke Taalinterface: Beschrijf simpelweg wat je wilt (“Geef alle pagina-URL’s van deze site”), en Thunderbit’s AI regelt de rest.

- AI Suggest Fields: Thunderbit scant de pagina en stelt automatisch kolomnamen voor (zoals “Pagina-URL”)—je hoeft niet te rommelen met CSS-selectors of XPath.

- Kan Paginering en Oneindig Scrollen Aan: Thunderbit klikt automatisch op “Volgende” of scrolt door, zodat je geen pagina’s mist.

- Subpagina-navigatie: Dieper nodig? Thunderbit volgt links naar subpagina’s en haalt daar ook data op.

- Gestructureerde Export: Exporteer direct naar Google Sheets, Excel, Notion, Airtable of CSV—gratis en met één klik.

- Geen Code Nodig: Als je een website kunt bezoeken, kun je Thunderbit gebruiken. Zo simpel is het.

Omdat Thunderbit een verticale AI-agent is, is het stabiel en betrouwbaar—ideaal voor zakelijke gebruikers die steeds dezelfde taken willen automatiseren.

Stapsgewijs: Zo Vind Je Alle URL’s op een Domein met Thunderbit

Benieuwd hoe het werkt? Hier een niet-technische uitleg om elke URL te verzamelen die je nodig hebt.

1. Installeer de Thunderbit Chrome-extensie

Begin met . Werkt op Chrome, Edge, Brave en andere Chromium-browsers. Zet hem vast in je werkbalk voor snelle toegang.

2. Open Je Doelpagina of Directory

Ga naar de website waarvan je de URL’s wilt verzamelen. Dit kan de homepage zijn, een sitemap, een directory of een lijstpagina met links naar de gewenste pagina’s.

3. Start Thunderbit en Stel Je Velden In

Klik op het Thunderbit-icoon om de extensie te openen. Start een nieuwe scraper-template. Hier gebeurt het:

- Klik op “AI Suggest Fields”. Thunderbit’s AI scant de pagina en stelt kolommen voor—zoek naar “Pagina-URL”, “Link” of iets vergelijkbaars.

- Zie je niet direct het juiste veld? Voeg dan zelf een kolom toe met de naam “Pagina-URL” (of wat logisch is). Thunderbit’s AI herkent deze termen en koppelt ze aan de juiste data.

4. Zet Paginering of Scrollen Aan (Indien Nodig)

Heeft je doelpagina meerdere pagina’s (zoals “Pagina 1, 2, 3…” of een “Meer laden”-knop), zet dan paginering aan in Thunderbit:

- Kies “Klik op paginering” voor sites met “Volgende”-knoppen, of “Oneindig scrollen” voor sites die meer laden tijdens het scrollen.

- Thunderbit vraagt je om de “Volgende”-knop of het scrollgebied aan te wijzen—klik erop, en de AI doet de rest.

5. Start de Scrape en Bekijk Je Resultaten

Klik op “Scrapen”. Thunderbit doorzoekt alle pagina’s en verzamelt elke gevonden URL. Je ziet de resultaten direct in een tabel in de extensie. Bij grote sites kan dit een paar minuten duren, maar het is nog steeds veel sneller dan handmatig.

6. Exporteer Je URL-lijst

Is de scrape klaar? Klik op Exporteren. Je kunt je data direct sturen naar:

- Google Sheets

- Excel/CSV

- Notion

- Airtable

Exporteren is gratis en behoudt je opmaak. Nooit meer kopiëren en plakken.

Thunderbit Vergeleken met Andere URL-Extractie Oplossingen

| Methode | Gebruiksgemak | Nauwkeurigheid & Dekking | Schaalbaarheid | Exportopties |

|---|---|---|---|---|

| Handmatig kopiëren | Pijnlijk | Laag (veel missen) | Geen | Handmatig (Excel, etc.) |

| Browser Link Extractors | Oké voor 1 pagina | Gemiddeld | Slecht | Handmatig |

Google site: Search | Makkelijk | Gemiddeld (niet compleet) | Max. ~1.000 | Handmatig |

| XML Sitemap | Makkelijk (indien aanwezig) | Goed (indien actueel) | Goed | Handmatig/Script |

| SEO Tools (Screaming Frog) | Technisch | Hoog | Hoog (betaald) | CSV, Excel |

| Python Scripts (Scrapy, etc.) | Zeer technisch | Hoog | Hoog | Custom |

| Thunderbit | Zeer makkelijk | Zeer hoog | Hoog | Google Sheets, CSV, etc. |

Thunderbit biedt je de nauwkeurigheid en schaal van een professionele crawler met het gebruiksgemak van een browserextensie. Geen code, geen gedoe, gewoon resultaat.

Extra: Meer Dan Alleen URL’s Extracten met Thunderbit

Hier wordt het pas echt interessant. Thunderbit is niet alleen voor URL’s—je kunt ook het volgende verzamelen:

- Titels

- E-mailadressen

- Telefoonnummers

- Afbeeldingen

- Elke gestructureerde data op de pagina

Stel, je bouwt een leadlijst: Thunderbit kan de profiel-URL, naam, e-mail en telefoonnummer van elke directoryregel verzamelen—alles in één keer. Doe je een productaudit? Haal de product-URL, naam, prijs en voorraadstatus op. Thunderbit ondersteunt zelfs , dus het kan doorklikken naar elke link en daar details ophalen.

En ja, de e-mail- en telefoonextractors van Thunderbit zijn helemaal gratis. Dat is goud waard voor sales- en marketingteams.

Samenvatting: Zo Vind Je Alle Pagina’s van een Website met AI

Nog even kort op een rijtje:

- Alle URL’s van een domein verzamelen is lastig met handmatige of standaardtools.

- Algemene AI-modellen zoals GPT kunnen niet navigeren, pagineren of dynamische content aan.

- Verticale AI-agents zoals Thunderbit zijn speciaal gebouwd voor webdata—stabiel, herhaalbaar en makkelijk voor zakelijke gebruikers.

- Thunderbit maakt het simpel: installeer de extensie, gebruik AI om velden te suggereren, zet paginering aan, scrape en exporteer. Geen code, geen gedoe.

- Je kunt meer dan alleen URL’s verzamelen: titels, e-mails, telefoonnummers en meer—ideaal voor leadgeneratie, audits of onderzoek.

Ben je klaar met links kopiëren of worstelen met technische crawlers? . Er is een gratis versie, zodat je zelf kunt ervaren hoeveel tijd (en frustratie) je bespaart.

Nieuwsgierig naar wat Thunderbit nog meer kan—zoals , , of ? Check de voor meer tips en uitleg.

Klaar om tijd te besparen op handmatige dataverzameling? De toekomst van webdata-extractie ligt bij verticale AI-agents—en Thunderbit loopt voorop. Probeer het uit en maak van je volgende audit, leadlijst of onderzoek je makkelijkste project ooit.

Meer Lezen

P.S. Mocht je ooit in de verleiding komen om 1.000 URL’s met de hand te kopiëren, onthoud dan: daar is nu AI voor. Je polsen (en je baas) zullen je dankbaar zijn.