De wereld draait steeds meer om data, en de strijd om die data slim te benutten wordt alleen maar intenser. Elke dag worden miljarden webpagina’s gescrapet voor inzichten, prijsvergelijkingen, leads en onderzoek—de drijvende kracht achter alles van e-commerce tot de nieuwste AI-innovaties (). De wereldwijde webscraping-markt stevent af op een waarde van meer dan 9 miljard dollar eind 2025, dus als je nog geen gebruik maakt van een efficiënte webscraper, laat je waarschijnlijk kansen liggen ().

Na jaren in SaaS en automatisering heb ik zelf ervaren hoe het juiste webscraping-gereedschap het verschil kan maken. De laatste tijd ben ik vooral onder de indruk van wat Rust te bieden heeft. In deze gids laat ik je zien waarom Rust zo krachtig is voor het bouwen van een webscraper, hoe je stap voor stap aan de slag gaat, en hoe je Rust slim kunt combineren met AI-tools zoals voor het beste van twee werelden: snelheid, veiligheid en minder frustratie.

Waarom kiezen voor Rust bij het bouwen van een webscraper?

Waarom zou je voor Rust gaan? Die vraag krijg ik vaak, vooral van mensen die gewend zijn aan Python of Node.js voor scraping. Dit zijn de grootste voordelen van Rust:

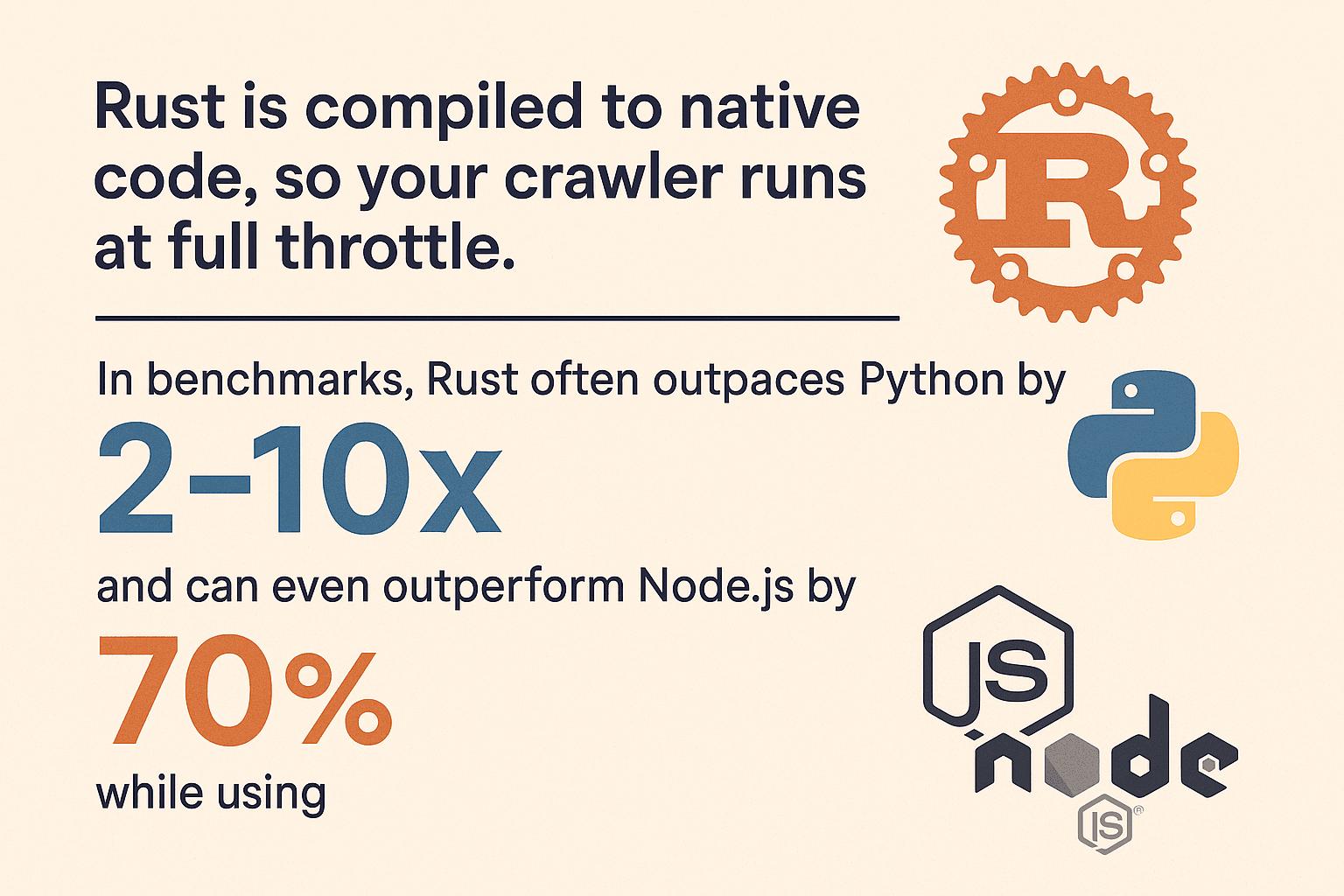

- Supersnelle prestaties: Rust wordt gecompileerd naar native code, waardoor je webscraper razendsnel draait. In benchmarks is Rust vaak 2–10× sneller dan Python bij zware taken, en zelfs 70% sneller dan Node.js met 90% minder geheugenverbruik (, ).

- Geheugenveiligheid: Dankzij Rust’s ownership-model zijn mysterieuze crashes en geheugenlekken verleden tijd. De compiler pikt fouten op voordat ze problemen veroorzaken.

- Veilige multithreading: Rust is gemaakt voor gelijktijdigheid. Wil je 100 pagina’s tegelijk ophalen? Geen probleem—Rust zorgt dat je threads veilig blijven en voorkomt datadiefstal.

- Betrouwbaarheid: Rust dwingt je om na te denken over fouten dankzij het gebruik van

ResultenOption. Je webscraper crasht niet zomaar bij een foutieve aanvraag. - Beveiliging: Geen buffer overflows of null pointer fouten. De veiligheidsmechanismen van Rust maken je webscraper minder kwetsbaar voor kwaadaardige of foutieve webinhoud.

Vergeleken met Python (makkelijk, maar traag en geheugenvretend) of Node.js (snelle I/O, maar single-threaded en zwaar op geheugen), biedt Rust uitstekende prestaties en stabiliteit—vooral als je scraping op grote schaal wilt aanpakken ().

Je Rust webscraper-omgeving opzetten

Klaar om te starten? Zo zet je je Rust-omgeving op:

1. Installeer Rust en Cargo

Rust wordt geleverd via , waarmee je eenvoudig Rust en de cargo build tool beheert. Download de installer voor jouw besturingssysteem en volg de instructies. Op Windows kan het zijn dat je Visual C++ Build Tools moet installeren.

Check je installatie:

1rustc --version

2cargo --versionZie je versienummers? Dan zit je goed.

2. Start een nieuw project

Open je terminal en voer uit:

1cargo new rust_web_crawler

2cd rust_web_crawlerNu heb je een nieuw project met een Cargo.toml en een src/main.rs.

3. Voeg de benodigde dependencies toe

Voor webscraping heb je nodig:

- (HTTP-client)

- (HTML parser met CSS-selectors)

- (async runtime, voor asynchrone scraping)

- (voor data-export)

Voeg ze toe met:

1cargo add reqwest scraper csv tokio --features fullOf pas je Cargo.toml aan:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. Kies je IDE en tools

Zelf werk ik graag met VS Code en de extensie. Hiermee krijg je code-aanvulling, inline documentatie en handige linting. Voor grotere projecten zijn JetBrains CLion of IntelliJ met de Rust-plugin ook prima keuzes.

5. Veelvoorkomende problemen oplossen

- Wordt

cargoniet gevonden? Check of Rust’s.cargo/binin je PATH staat. - Op Windows: installeer ontbrekende C++ build tools als daarom wordt gevraagd.

- Dependency-fouten? Probeer

cargo updateof check op typefouten inCargo.toml.

Stap voor stap: je eerste Rust webscraper bouwen

We gaan een simpele webscraper maken die een pagina ophaalt, productdata uitleest en deze naar CSV exporteert. Je kunt dit later uitbreiden.

Webpagina’s ophalen met Rust

Begin met het importeren van reqwest:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}In productie kun je beter foutafhandeling toevoegen in plaats van overal unwrap() te gebruiken:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};Data parsen en extraheren

Gebruik nu scraper om de HTML te parsen en productinformatie te verzamelen.

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}Deze aanpak is geïnspireerd op en werkt goed voor e-commerce of directory-achtige pagina’s.

URL’s beheren en dubbele pagina’s vermijden

Voor een echte crawler wil je links volgen en niet twee keer dezelfde pagina bezoeken. Dit patroon wordt vaak gebruikt:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // Gebruik de `url` crate!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}Vergeet niet om URL’s te normaliseren (met de crate) zodat je relatieve paden, slashes en fragmenten goed verwerkt.

Concurrency implementeren voor snellere scraping

Hier blinkt Rust echt uit. Pagina’s één voor één ophalen is traag—dus laten we het parallel doen.

Optie 1: Multithreading

Start meerdere threads die samen de queue afwerken. Gebruik Arc<Mutex<>> voor gedeelde data. Voor kleine crawls is dit prima.

Optie 2: Async/Await met Tokio

Wil je echt snelheid? Gebruik async. Met tokio en asynchrone reqwest kun je honderden verzoeken tegelijk doen zonder je geheugen te overbelasten.

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;Async Rust is niet alleen snel, maar ook veilig. Geen dataraces of vreemde bugs—gewoon maximale doorvoer ().

Data exporteren en opslaan

Als je data hebt verzameld, wil je die waarschijnlijk exporteren. Met de crate is dat zo geregeld:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();Je kunt ook direct structs serialiseren met , of exporteren naar JSON voor complexere data.

Thunderbit gebruiken voor snelle en eenvoudige webdata-extractie

Laten we het nu hebben over . Hoe leuk het ook is om zelf te coderen, soms wil je gewoon snel de data binnenhalen. Thunderbit is een AI-webscraper Chrome-extensie waarmee je met een paar klikken data van websites haalt—zonder code.

Thunderbit is een AI-webscraper Chrome-extensie die zakelijke gebruikers helpt om met behulp van AI data van websites te halen. Het is een productiviteitstool die tijd bespaart en repetitieve webtaken automatiseert.

Wat maakt Thunderbit uniek?

- AI-veldherkenning: Thunderbit scant de pagina en stelt automatisch kolommen voor om te extraheren—namen, e-mails, prijzen, noem maar op ().

- Scrapen met één klik: Klik op “Scrape” en Thunderbit zet de data direct in een gestructureerde tabel.

- Subpagina’s scrapen: Informatie nodig van detailpagina’s? Thunderbit bezoekt automatisch elke link en verrijkt je tabel ().

- Paginering & oneindig scrollen: Thunderbit herkent en verwerkt automatisch pagina’s met paginering of infinite scroll.

- Gratis data-export: Exporteer naar Excel, Google Sheets, Notion, Airtable of CSV—zonder gedoe.

- AI-autovullen: Automatiseer het invullen van formulieren of inloggen met AI, zodat je ook achter een login data kunt scrapen.

Thunderbit is een uitkomst voor zowel zakelijke gebruikers als ontwikkelaars—vooral bij lastige, dynamische of JavaScript-rijke websites.

Wanneer kies je voor Thunderbit of Rust?

- Thunderbit: Ideaal voor snelle prototypes, eenmalige scrapes of als je niet-technische collega’s wilt laten scrapen.

- Rust: Perfect voor grootschalige, maatwerk of diep geïntegreerde webscrapers waar maximale prestaties en controle nodig zijn.

De echte kracht zit in de combinatie van beide.

Rust webscraper-prestaties vergeleken met andere technologieën

Even technisch: hoe presteert Rust ten opzichte van andere talen?

| Taal/Framework | Snelheid | Geheugenverbruik | Concurrency | Stabiliteit | Ecosysteem |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 Laag | 🟢 Uitstekend | 🟢 Hoog | Gemiddeld |

| Python (Scrapy) | 🚀 | 🔴 Hoog | 🟡 Beperkt | 🟡 Gemiddeld | 🟢 Groot |

| Node.js | 🚀🚀 | 🔴 Hoog | 🟢 Goed | 🟡 Gemiddeld | 🟢 Groot |

| Go | 🚀🚀 | 🟢 Laag | 🟢 Uitstekend | 🟢 Hoog | Gemiddeld |

- Rust is vaak 2–10× sneller dan Python en gebruikt minder dan 10% van het geheugen (, ).

- Node.js is sterk in I/O, maar single-threaded voor JS en kan traag worden bij zware parsing.

- Go is een sterke concurrent, maar Rust’s geheugenveiligheid en zero-cost abstractions geven het een voorsprong bij langdurige, intensieve scrapes.

Wil je grootschalig scrapen of maximale prestaties? Dan is Rust moeilijk te verslaan.

Thunderbit en Rust combineren voor maximale efficiëntie

Mijn favoriete workflow: gebruik Thunderbit en Rust samen.

- Snel prototypen: Gebruik Thunderbit om snel een site te verkennen en voorbeelddata te verzamelen. Zo begrijp je de structuur voordat je code schrijft.

- Slim verdelen: Laat Thunderbit de lastige, dynamische of beveiligde pagina’s doen (met AI-autovullen en subpagina-scraping), terwijl je Rust-webscraper de bulk van de statische of API-pagina’s verwerkt.

- Geplande scraping: Stel geplande scrapes in met Thunderbit voor regelmatige dataverzameling, en laat je Rust-backend de resultaten verwerken of samenvoegen.

- Niet-ontwikkelaars helpen: Laat je marketing- of operationele team Thunderbit gebruiken voor ad-hoc data, zodat je ontwikkelaars zich op complexere taken kunnen richten.

- Veerkracht: Als je Rust-webscraper breekt door een layoutwijziging, kan Thunderbit’s AI vaak direct aanpassen—zonder code.

Deze hybride aanpak geeft je het beste van beide: snelheid en flexibiliteit met Thunderbit, kracht en controle met Rust.

Problemen oplossen en best practices voor Rust webscrapers

Een robuuste webscraper bouwen draait niet alleen om code, maar ook om omgaan met de grillen van het web.

Veelvoorkomende uitdagingen

- Anti-botmaatregelen: Gebruik realistische User-Agents, respecteer

robots.txt, vertraag je verzoeken en overweeg proxies bij intensief scrapen (). - CAPTCHAs en logins: Voor sites met CAPTCHAs of complexe logins kun je Thunderbit’s AI-autovullen gebruiken of een headless browser inzetten (zoals of )—maar alleen als het echt nodig is.

- JavaScript-rijke sites: Wordt data via AJAX geladen? Zoek naar de onderliggende API-calls. Moet je toch JS renderen, gebruik dan Thunderbit of een headless browser.

- Foutafhandeling: Gebruik altijd goede foutafhandeling (

Result,Option), stel timeouts in en log fouten voor debugging. - Concurrency-valkuilen: Gebruik thread-safe structuren (

Arc<Mutex<>>ofDashMap) en voorkom knelpunten bij gedeelde data. - Geheugenbeheer: Schrijf data direct naar schijf als je miljoenen pagina’s crawlt—hou niet alles in het geheugen.

- Ethiek en regelgeving: Respecteer de regels van websites, overbelast servers niet en houd rekening met privacywetgeving.

Best practices

- Modulaire code: Splits ophalen, parsen en opslaan voor beter onderhoud.

- Instelbare parameters: Gebruik config-bestanden of CLI-argumenten voor URLs, concurrency, vertragingen, enzovoort.

- Logging: Gebruik de

logcrate voor gestructureerde logging. - Testen: Schrijf unittests voor je parsing met voorbeeld-HTML.

- Monitoring: Houd het geheugen- en CPU-gebruik, fouten en status van je webscraper bij—zeker bij langdurige jobs.

Meer tips? Bekijk de gids van en de Rust scraping tutorial van .

Conclusie & belangrijkste inzichten

Een webscraper bouwen in Rust is niet alleen technisch uitdagend, maar geeft je ook een voorsprong in de datagedreven wereld van nu. Dit zijn de belangrijkste punten:

- Rust is een krachtpatser voor webscraping: snel, veilig en gemaakt voor gelijktijdigheid.

- Stapsgewijs werkt het best: Zet je omgeving op, haal en parse pagina’s, beheer URLs, voeg concurrency toe en exporteer je data.

- Thunderbit is je geheime wapen voor snelle, no-code scraping—vooral bij complexe of dynamische sites.

- Combineer beide voor maximale efficiëntie: Gebruik Thunderbit voor prototyping en lastige pagina’s, Rust voor schaal en maatwerk.

- Blijf pragmatisch: Soms is een paar klikken effectiever dan honderden regels code.

Wil je je webscraping-skills naar een hoger niveau tillen? Probeer Rust—en laat het zware werk doen als dat nodig is. Meer scraping-tips en automatiseringstrucs? Bekijk de .

Veel succes met scrapen—en moge je data altijd snel, schoon en slim zijn.

Veelgestelde vragen

1. Waarom zou ik Rust gebruiken voor een webscraper in plaats van Python of Node.js?

Rust biedt veel betere prestaties, geheugenveiligheid en ondersteuning voor gelijktijdigheid. Python en Node.js zijn handig voor snelle scripts, maar Rust is ideaal voor grootschalige, langdurige of kritieke webscrapers waar snelheid en betrouwbaarheid tellen ().

2. Welke libraries heb ik nodig voor een Rust webscraper?

Gebruik reqwest voor HTTP-verzoeken, scraper voor HTML-parsing, tokio voor asynchrone scraping en csv voor data-export. De url crate is handig voor URL-normalisatie.

3. Hoe ga ik om met JavaScript-rijke of beveiligde websites in Rust?

Voor JS-rijke sites kun je zoeken naar onderliggende API-calls of een headless browser gebruiken met crates als fantoccini. Voor beveiligde pagina’s kun je cookies beheren met reqwest of Thunderbit’s AI-autovullen inzetten voor automatische logins.

4. Wat is het voordeel van Thunderbit combineren met Rust?

Thunderbit versnelt data-extractie met AI-gestuurde, no-code scraping—ideaal voor prototyping, dynamische pagina’s of niet-ontwikkelaars. Rust is het beste voor maatwerk en hoge prestaties. Samen kun je snel schakelen én opschalen.

5. Hoe voorkom ik dat ik geblokkeerd word tijdens het scrapen?

Respecteer robots.txt, gebruik realistische headers, vertraag je verzoeken en overweeg proxies bij grootschalig scrapen. Scrape altijd ethisch en volgens de regels van de site en privacywetgeving ().

Thunderbit zelf proberen? en begin vandaag nog slimmer te scrapen. Meer weten over webautomatisering? Bekijk de .

Meer weten