Heb je je ooit afgevraagd hoe Google werkelijk alles op het internet lijkt te weten—zelfs dat vergeten blogje uit 2012? Je bent zeker niet de enige. Het geheim is geen magie of een leger stagiairs die dag en nacht websites doorspitten. Het zijn crawlers: digitale speurders die non-stop het web afstruinen, alles ordenen en indexeren. Na jaren werken met automatisering en AI-tools (en ja, soms per ongeluk een site platgelegd), weet ik hoe bepalend deze bots zijn voor wat wij online te zien krijgen. Heb je een website? Dan is snappen hoe crawlers werken geen nerdy detail, maar het verschil tussen gevonden worden of compleet onzichtbaar zijn.

Laten we samen induiken in wat crawlers precies zijn, hoe ze jouw website ‘bekijken’, waarom ze onmisbaar zijn voor SEO en wat je kunt doen om te zorgen dat jouw content niet verdwijnt in de digitale jungle. En omdat ik gek ben op slimme automatisering, laat ik je zien hoe nieuwe AI-tools zoals het speelveld veranderen voor website-eigenaren en datagedreven teams.

Crawlers Website Basics: Wat zijn het en hoe werken ze?

Zie een crawler als een digitale bibliothecaris—of een spin met een master in ordenen—die het web afstruint, link voor link. In technische termen is een crawler (ook wel spider of bot genoemd) een softwareprogramma dat systematisch websites bezoekt, pagina’s ophaalt, links volgt en informatie verzamelt. Zo bouwen zoekmachines als Google en Bing hun gigantische indexen van online content.

Zo werkt het in grote lijnen:

- Starten met een lijst van bekende URL’s (zoals je homepage of een paar ‘seed’-sites).

- De HTML-inhoud van elke pagina ophalen.

- Hyperlinks verzamelen en toevoegen aan de lijst met te bezoeken pagina’s.

- Het proces herhalen: van link naar link gaan, nieuwe pagina’s catalogiseren en de zoekmachine-index bijwerken.

Stel je een bibliothecaris voor die razendsnel door oneindige boekenkasten rent en alles noteert—maar dan op internetschaal. Zonder crawlers zou het grootste deel van het web onzichtbaar zijn voor zoekmachines en dus voor gebruikers.

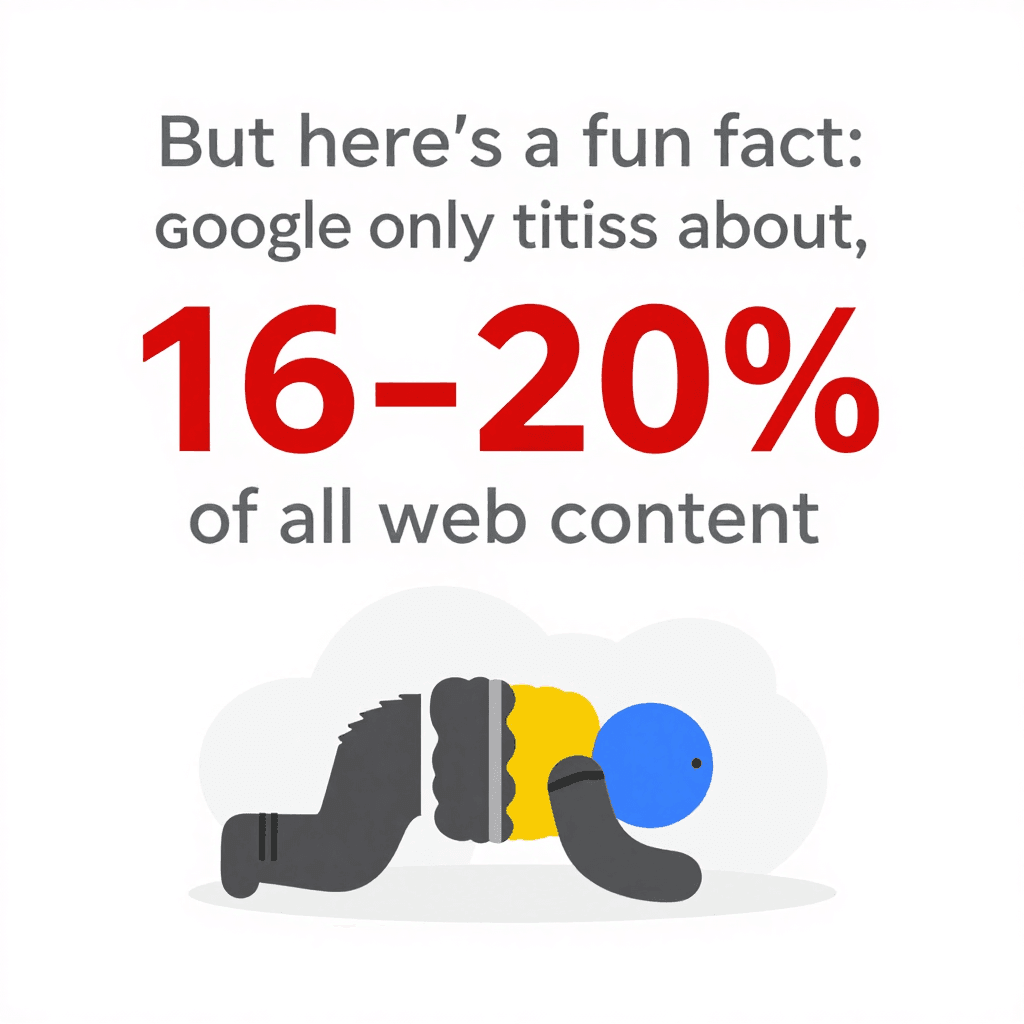

Leuk feitje: ondanks al die crawl-power indexeert Google slechts . De rest blijft verstopt in het ‘deep web’, buiten bereik van de meeste bots. Hoe je je site opbouwt—en hoe toegankelijk die is voor crawlers—maakt dus echt verschil.

Leuk feitje: ondanks al die crawl-power indexeert Google slechts . De rest blijft verstopt in het ‘deep web’, buiten bereik van de meeste bots. Hoe je je site opbouwt—en hoe toegankelijk die is voor crawlers—maakt dus echt verschil.

Hoe crawlers jouw website bekijken en begrijpen

Crawlers zien je website totaal anders dan mensen. Ze geven niks om mooie lettertypes, toffe afbeeldingen of die coole parallax die je uren hebt gebouwd. Ze laden de ruwe HTML, scannen de tekst, lezen de tags en volgen de links. Het is alsof je de bouwtekening van een huis leest in plaats van erdoorheen te lopen.

Hier letten crawlers vooral op:

- HTML-structuur: Ze zoeken naar koppen, alinea’s, lijsten en links.

- Interne links: Dit zijn de routes die crawlers naar verschillende delen van je site leiden. Staat een pagina nergens gelinkt? Dan is die voor een crawler onzichtbaar.

- Navigatie en sitemaps: Goed georganiseerde menu’s en actuele sitemaps werken als een GPS en zorgen dat crawlers je belangrijkste content vinden.

- Metadata en gestructureerde data: Tags als

<title>,<meta description>en Schema.org-markup helpen crawlers te snappen waar een pagina over gaat—ook als dat niet direct uit de tekst blijkt.

Zie je website als een stad. Crawlers zijn de bezorgers, en je interne links en sitemaps zijn de straatnaamborden en plattegronden die hen overal naartoe leiden.

De rol van sitemaps en robots.txt in het gedrag van crawlers

Twee bestanden zijn bepalend voor hoe crawlers met je site omgaan:

-

XML Sitemap: Dit is een machineleesbare lijst van de belangrijkste pagina’s van je site. Het is alsof je de bibliothecaris een overzicht geeft van al je boeken en waar ze staan. Een goede sitemap zorgt dat crawlers geen belangrijke content missen—zelfs als je interne links niet perfect zijn. Zeker bij grote of complexe sites kan een uitgebreide sitemap .

-

robots.txt: Dit simpele tekstbestand in de root van je site vertelt crawlers waar ze wel en niet mogen komen. Wil je bots uit je admin-omgeving houden of dubbele pagina’s blokkeren? Dan regel je dat hier. Let op: een typefout (zoals

Disallow: /) kan per ongeluk je hele site blokkeren voor zoekmachines—een klassieke SEO-blunder. Gebruik robots.txt om .

Pro tip: Verwijs in robots.txt altijd naar je sitemap. Zo wijs je crawlers direct de weg.

Waarom crawlers belangrijk zijn voor jouw website: SEO en bezoekers

Kort gezegd: als een crawler een pagina niet kan bereiken, bestaat die voor Google niet. Geen crawl = geen index = geen zoekverkeer. Al je werk aan content, design en branding? Zonde als Googlebot het niet kan vinden.

Waarom is dit zo belangrijk? Omdat en . Is je site niet crawler-vriendelijk, dan mis je de grootste bron van bezoekers.

Een goed gecrawlde site betekent:

Een goed gecrawlde site betekent:

- Meer pagina’s geïndexeerd: Meer kansen om in zoekresultaten te verschijnen.

- Hogere posities: Zoekmachines kunnen de relevantie van je content beter beoordelen.

- Snellere updates: Nieuwe content wordt sneller gevonden en gerankt.

- Betere gebruikerservaring: Bezoekers vinden sneller wat ze zoeken, wat je geloofwaardigheid en verkeer vergroot.

Er zijn talloze voorbeelden van websites die hun verkeer zagen exploderen door crawlproblemen op te lossen—zoals kapotte links of per ongeluk geplaatste noindex-tags. Vaak zijn het de ‘verborgen in het zicht’-problemen.

De invloed van crawlers op je zoekresultaten

Zoekmachines gebruiken crawl-data om te bepalen welke pagina’s het meest relevant zijn voor een zoekopdracht. Ze letten op:

- Kwaliteit van de content en zoekwoorden

- Interne en externe links

- Hoe actueel de pagina is en hoe vaak deze wordt bijgewerkt

- Mobielvriendelijkheid (Google indexeert nu mobiel als eerste)

Voor grote sites geldt ook het crawlbudget—het aantal pagina’s dat een zoekmachine in een bepaalde periode bezoekt. Heeft je site 100.000 pagina’s, maar crawlt Googlebot er maar 5.000 per dag, dan kan het weken duren voor alles is geïndexeerd. Daarom is een (waar de meeste pagina’s met een paar klikken bereikbaar zijn) zo krachtig: crawlers kunnen je content sneller en efficiënter vinden.

De grenzen van traditionele crawlers: uitdagingen met moderne websites

Hier wordt het lastig. De moderne webwereld zit vol JavaScript, dynamische content en inlogschermen. Traditionele crawlers—vooral de simpele—raken snel de weg kwijt of geven het op.

Veelvoorkomende problemen zijn:

- Dynamische content en JavaScript: Veel crawlers zien alleen de eerste HTML. Laadt je content via JavaScript (zoals oneindig scrollen of ‘laad meer’-knoppen), dan ziet een simpele bot… niets. Zelfs Google’s crawler, die JavaScript kan uitvoeren, indexeert JS-rijke sites soms maar deels, zeker als content traag of pas na interactie verschijnt ().

- Content achter een login: Vereist een pagina een login, dan komen de meeste crawlers er niet in. Vaak is dat bewust, maar soms zit belangrijke publieke content per ongeluk achter een loginmuur.

- Fout ingestelde robots.txt of meta-tags: Eén foutje kan crawlers uit hele delen van je site weren.

- Anti-botmaatregelen: CAPTCHAs, strenge limieten of onbekende user agents kunnen crawlers blokkeren.

Met , moeten crawlers steeds slimmer worden. Toch blijft veel content onzichtbaar.

Wanneer crawlers tekortschieten: dynamische content en JavaScript

Stel, je hebt een webshop waar producten pas laden als je scrolt. Een traditionele crawler ziet dan alleen de eerste 20 producten en mist de rest. Of je reviews verschijnen pas na het klikken op een tabblad—ook die blijven voor de meeste bots verborgen.

Het gevolg? Waardevolle content wordt niet geïndexeerd en je loopt zoekverkeer mis. De oplossing: bied alternatieve routes (zoals paginatie of server-side HTML) en test hoe crawlers je site zien met tools als Google Search Console’s URL-inspectie.

Slimmere crawlers: zo pakt Thunderbit complexe pagina’s aan

Hier word ik enthousiast van—want precies dit probleem losten we op met . Thunderbit is niet zomaar een crawler; het is een AI-webscraper die websites ‘leest’ als een mens, gestructureerde data ophaalt en moeiteloos omgaat met alle moderne webtechnieken.

Wat maakt Thunderbit anders?

- AI Suggest Fields: Je hoeft niet zelf in de HTML te duiken of te coderen. Thunderbit’s AI scant de pagina en stelt direct de beste kolommen voor—zoals ‘Productnaam’, ‘Prijs’ of ‘Contact e-mail’. Je kunt de suggesties aanpassen, maar het zware werk is al gedaan.

- Subpagina’s scrapen: Meer details nodig? Thunderbit bezoekt automatisch elke subpagina (zoals productdetails of profielen), haalt extra info op en verrijkt je dataset. Geen handmatig klikken of kopiëren meer.

- Kan overweg met JavaScript en logins: Omdat Thunderbit als Chrome-extensie draait (of in een echte browser in de cloud), kan het JavaScript uitvoeren, wachten op dynamische content en zelfs pagina’s scrapen waar je bent ingelogd.

- Past zich aan sitewijzigingen aan: Traditionele scrapers breken als een website verandert. Thunderbit’s AI leest de pagina elke keer opnieuw, dus kleine aanpassingen zijn geen probleem.

- Geplande scraping: Prijzen monitoren of elke ochtend een leadlijst updaten? Stel gewoon een schema in (“elke maandag om 9 uur”) en Thunderbit regelt de rest.

Thunderbit is gemaakt voor zakelijke gebruikers—sales, marketing, e-commerce, vastgoed—die data willen, geen gedoe. En ja, exporteren naar Google Sheets, Notion of Airtable is één klik (en helemaal gratis).

Thunderbit’s AI-functies voor optimale crawlbaarheid

De echte kracht van Thunderbit zit in de natuurlijke taalverwerking. Het haalt niet alleen tekst op, maar begrijpt de context. Zo herkent het het verschil tussen een telefoonnummer, e-mailadres of productprijs, en kan het data direct labelen, structureren en zelfs vertalen.

Gebruikers zijn enthousiast. Eén reviewer zei: “Thunderbit is mijn vaste tool voor het verzamelen van influencer-contactgegevens. Ik betaalde eerst voor databases, nu bouw ik ze zelf in een paar minuten.” Dat is het soort workflow-verbetering waar ik blij van word.

En als je ooit een site hebt geprobeerd te scrapen die elke week van layout verandert (ik kijk naar jullie, e-commerce platforms), dan waardeer je Thunderbit’s ‘onderhoudsvrije’ aanpak. De AI past zich aan, zodat jij niet steeds scripts hoeft te repareren.

Je website optimaliseren voor crawlers: structuur, strategie en slimme tools

Wat kun je doen om je website aantrekkelijk te maken voor crawlers? Hier een aantal bewezen tips:

- Ontwerp een logische sitestructuur: Houd belangrijke pagina’s binnen een paar klikken van de homepage. Een (brede navigatie, weinig diepte) zorgt voor efficiënter crawlen en betere indexatie.

- Gebruik sterke interne links: Verbind gerelateerde pagina’s met contextuele links. Controleer regelmatig op kapotte links en herstel ze.

- Houd je XML-sitemap actueel: Zet alle belangrijke URL’s erin en dien hem in bij Google Search Console en Bing Webmaster Tools.

- Optimaliseer je robots.txt: Geef toegang tot belangrijke content, blokkeer alleen wat echt nodig is en controleer op onbedoelde blokkades.

- Snelheid telt: Snel ladende, foutloze pagina’s worden beter gecrawld. Optimaliseer afbeeldingen, gebruik een CDN en los serverfouten op.

- Voorkom dubbele content: Gebruik canonical tags en verspil geen crawlbudget aan (bijna) identieke pagina’s.

- Maak gebruik van gestructureerde data en metadata: Implementeer Schema.org-markup voor producten, artikelen, evenementen, enzovoort, en beheer je meta-tags slim.

- Monitor crawl-activiteit: Gebruik Google Search Console’s Index Coverage en Crawl Stats om problemen snel te signaleren.

- Test met slimme tools: Gebruik Thunderbit of vergelijkbare tools om te zien hoe crawlers je site ervaren en om je eigen datastromen soepel te houden.

Je website-architectuur afstemmen op crawlers

Een doordachte sitestructuur is niet alleen goed voor bots, maar ook voor je bezoekers. Regelmatige audits (met tools als Screaming Frog of Sitebulb) helpen je crawlproblemen, kapotte links en verweesde pagina’s op te sporen voordat ze je ranking schaden.

En vergeet mobiel niet: met Google’s mobile-first indexing moet je mobiele site alle belangrijke content en links bevatten die je desktopsite ook heeft. Anders loop je het risico dat waardevolle pagina’s niet worden geïndexeerd ().

Thunderbit versus traditionele crawlers: een snelle vergelijking

Even op een rij:

| Aspect | Thunderbit (AI-webscraper) | Traditionele crawler/scraper |

|---|---|---|

| Gebruiksgemak | Geen code nodig, AI stelt velden voor, zakelijke gebruikers starten in 2 klikken. | Technische installatie, vaak coderen of handmatig selectoren instellen. |

| Aanpasbaarheid | AI past zich aan layout-wijzigingen aan, nauwelijks onderhoud. | Breekt bij wijzigingen in de site, vereist handmatige updates. |

| Dynamische content | Kan standaard overweg met JavaScript, logins en interactieve elementen. | Beperkt tot statische HTML, moeite met JS of content achter login. |

| Subpagina’s crawlen | Ingebouwde subpagina- en paginatie-crawling, data wordt automatisch samengevoegd. | Handmatig instellen voor diepte, recursief crawlen kost extra werk. |

| Data structureren | AI levert direct bruikbare tabellen met betekenisvolle kolommen, ondersteunt rijke datatypes (tekst, getallen, e-mails, afbeeldingen, PDF’s, enz.). | Ruwe output, gebruiker moet structuur zelf bepalen, beperkt tot HTML tenzij maatwerk. |

| Integratie | Exporteren naar Google Sheets, Notion, Airtable, CSV, enz. met één klik. | Meestal handmatig exporteren/importeren, weinig directe integraties. |

| Bot-obstakels | Gaat automatisch om met proxies, user agents, retries; waterfall-aanpak voor maximaal succes. | Gebruiker moet zelf IP-blokkades, CAPTCHAs, enz. oplossen—vaak complex en duur. |

| Doelgroep | Niet-technische zakelijke gebruikers: sales, marketing, operations, e-commerce, vastgoed. | Developers, IT, data engineers. |

| Prijs | Krediet-gebaseerd, gratis versie beschikbaar, je betaalt alleen wat je gebruikt. | Abonnement, per gebruiker of serverkosten; vaak verborgen kosten voor proxies of onderhoud. |

Kortom: Thunderbit maakt geavanceerd crawlen toegankelijk voor iedereen, niet alleen voor developers. Het is snel, accuraat en past zich aan de veranderende webwereld aan.

Samenvatting: zo haal je het meeste uit crawlers voor jouw website

- Crawlers bepalen je online zichtbaarheid. Is je site niet crawler-vriendelijk, dan mis je zoekverkeer en nieuwe bezoekers.

- Structuur en strategie zijn essentieel. Logische navigatie, interne links, sitemaps en robots.txt zijn je beste vrienden.

- Moderne websites vragen om slimme crawlers. JavaScript, dynamische content en logins zijn lastig voor simpele bots—maar AI-tools zoals kunnen het aan.

- Blijf monitoren. Gebruik Search Console, crawl-audits en slimme scrapingtools om je site gezond en zichtbaar te houden.

- Upgrade je toolkit. Of je nu voor SEO optimaliseert of je eigen datastromen bouwt, slimme crawlers besparen tijd, verhogen de nauwkeurigheid en ondersteunen betere zakelijke beslissingen.

Benieuwd hoe Thunderbit je kan helpen om zelfs de lastigste websites te crawlen, indexeren en data te extraheren? en probeer het zelf. Meer tips over webscraping, SEO en automatisering vind je op de .

Veelgestelde vragen

1. Wat is een crawler en waarom is het belangrijk voor mijn website?

Een crawler is een softwarebot die systematisch websites bezoekt en indexeert voor zoekmachines. Is je site niet toegankelijk voor crawlers, dan verschijnen je pagina’s niet in de zoekresultaten en ben je moeilijk vindbaar.

2. Hoe beïnvloeden sitemaps en robots.txt crawlers?

Sitemaps wijzen crawlers de weg naar je belangrijkste pagina’s, terwijl robots.txt aangeeft waar ze wel en niet mogen komen. Beide zijn essentieel voor efficiënt crawlen en indexeren.

3. Welke problemen hebben traditionele crawlers met moderne websites?

Traditionele crawlers hebben moeite met JavaScript-rijke content, dynamische elementen, pagina’s achter een login en anti-botmaatregelen. Daardoor missen ze soms belangrijke content of indexeren ze die maar deels.

4. Hoe pakt Thunderbit complexe websites anders aan?

Thunderbit gebruikt AI om pagina’s te ‘lezen’ als een mens, kan overweg met JavaScript en logins, en haalt gestructureerde data op—ook van subpagina’s en dynamische content. Het past zich aan sitewijzigingen aan en vereist geen code.

5. Wat zijn de beste tips om mijn website crawler-vriendelijk te maken?

Zorg voor een logische sitestructuur, gebruik interne links, houd je sitemap en robots.txt actueel, optimaliseer voor snelheid en monitor crawl-activiteit. Gebruik slimme tools zoals Thunderbit om je site te testen en te verbeteren.

Meer weten? Lees meer gidsen op de of abonneer je op ons voor de nieuwste tips over webautomatisering en AI-scraping.

Meer weten