Webdata is tegenwoordig echt het nieuwe goud, en in 2025 draait alles erom: van slimmere sales tot diepgaand marktonderzoek. Ik zie dagelijks hoe teams – of ze nu in e-commerce, vastgoed of SaaS werken – razendsnel rommelige webpagina’s omtoveren tot overzichtelijke, bruikbare spreadsheets. En als je dit leest, wil jij daar vast ook van meeprofiteren. Het mooie is: Python is dé tool voor webscraping en toegankelijker dan ooit – zelfs als je geen hardcore programmeur bent.

In deze gids neem ik je stap voor stap mee in de wereld van webscraping met Python: van je allereerste script tot het opschalen met frameworks zoals Scrapy. Ook ontdek je hoe AI-tools zoals het verzamelen van data voor bedrijven supersnel en simpel maken. Of je nu een nieuwsgierige beginner bent of een ervaren gebruiker die zijn skills wil uitbreiden, je vindt hier praktische stappen, codevoorbeelden en tips uit de praktijk om direct aan de slag te gaan.

Wat is Webscraping met Python? Een Korte Intro

Webscraping is het automatisch verzamelen van info van websites – je leert je computer supersnel en op grote schaal data kopiëren en plakken. In Python betekent dit dat je scripts schrijft die webpagina’s ophalen, de HTML analyseren en precies die gegevens eruit vissen die jij nodig hebt: denk aan productprijzen, contactgegevens, reviews, noem maar op.

Voor bedrijven is webscraping echt een goudmijn. Sales-teams bouwen er leadlijsten mee, e-commerce houdt concurrentieprijzen in de gaten en analisten volgen markttrends – allemaal door ongestructureerde webinhoud om te zetten naar gestructureerde data. Python is hiervoor favoriet omdat het krachtig én gebruiksvriendelijk is, waardoor het de standaardtaal is voor zowel kleine als grote scraping-projecten ().

Waarom Python de Favoriet is voor Webscraping

Waarom kiest iedereen voor Python bij webscraping? Simpel: het is makkelijk te leren, heeft een enorme bibliotheek aan tools en een actieve community die altijd klaarstaat.

- Lekker leesbare code: Python is makkelijk te schrijven én te snappen. Je hoeft geen software engineer te zijn om te starten.

- Sterke bibliotheken: Tools als BeautifulSoup, Scrapy en Requests maken het verzamelen, analyseren en doorzoeken van webpagina’s super eenvoudig.

- Veelzijdig: Python is niet alleen geschikt voor scraping, maar ook voor data-analyse en automatisering. Je kunt dus van ruwe data direct naar inzichten, zonder van taal te wisselen.

- Community support: Loop je vast op een lastige HTML-structuur? Grote kans dat iemand op Stack Overflow het al heeft opgelost.

Hoe verhoudt Python zich tot andere talen?

| Taal | Voordelen | Nadelen | Ideaal voor |

|---|---|---|---|

| Python | Makkelijk te leren, veel libraries, community | Minder snel dan C++/Java | Alle scraping, klein tot groot |

| JavaScript | Werkt goed met JS-rijke sites | HTML-parsing minder volwassen, async issues | Single-page apps, dynamische sites |

| R | Sterk in data-analyse | Minder scraping-frameworks | Kleine, statistische projecten |

| Java/C# | Snel, enterprise-kwaliteit | Veel code, omslachtig | Grote, geïntegreerde systemen |

Python staat steevast in de top van programmeertalen voor webscraping en was in 2023 zelfs populairder dan SQL ().

Onmisbare Tools & Bibliotheken voor Webscraping met Python

Dit heb je nodig om te starten met webscraping in Python:

- Requests: Dé library om HTTP-verzoeken te doen. Haalt webpagina’s op alsof je ze in je browser opent.

- BeautifulSoup: De alleskunner voor het analyseren van HTML en XML. Hiermee kun je data zoeken, filteren en extraheren.

- Scrapy: Een compleet framework voor grootschalig, geautomatiseerd scrapen en crawlen.

- Selenium: Automatiseert browsers om dynamische, JavaScript-rijke sites te scrapen.

- Overige:

lxmlvoor snelle parsing,pandasvoor dataverwerking, enPlaywrightvoor moderne browserautomatisering.

Wanneer gebruik je wat?

- Requests + BeautifulSoup: Ideaal voor statische pagina’s en kleine projecten.

- Scrapy: Perfect voor het crawlen van veel pagina’s, paginering en grootschalige data-export.

- Selenium/Playwright: Nodig als je met JavaScript of gebruikersacties moet werken.

Aan de Slag: Je Python Webscraping-omgeving Inrichten

Laten we je omgeving klaarmaken. Zelfs als je nieuw bent met Python, is dit zo gepiept.

-

Installeer Python: Download Python 3.x via . Zorg dat het in je systeem-PATH staat.

-

Maak een virtuele omgeving aan: Zo houd je je project afhankelijkheden overzichtelijk.

1python3 -m venv venv 2# Activeren: 3# Op Windows: 4venv\Scripts\activate 5# Op Mac/Linux: 6source venv/bin/activate -

Installeer de benodigde libraries:

1pip install requests beautifulsoup4 scrapy selenium -

Projectstructuur: Voor kleine scripts volstaat één

.py-bestand. Voor Scrapy gebruik jescrapy startproject mijnprojectom een volledige projectstructuur te maken. -

Test je installatie:

1import requests, bs4, scrapy, selenium 2print("Alle libraries succesvol geïmporteerd!") -

Stel een User-Agent in (aanrader): Sommige sites blokkeren standaard “Python-requests”. Doe je voor als browser:

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

Top, je bent klaar om te scrapen!

HTML Analyseren met BeautifulSoup: Je Eerste Python Webscraper

Laten we samen een simpele scraper bouwen. We halen quotes en auteurs op van – een oefensite.

Stap 1: De Website Structuur Bekijken

- Open de site in Chrome.

- Klik met rechts op een quote en kies “Inspecteren”.

- Je ziet dat elke quote in een

<div class="quote">staat, met de tekst in<span class="text">en de auteur in<small class="author">.

Stap 2: Je Scraper Schrijven en Uitvoeren

Hier een basisvoorbeeld:

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"Request mislukt: {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")Veelvoorkomende valkuilen:

- Als een element ontbreekt, check dan op

Nonevoordat je.get_text()gebruikt. - Controleer altijd je selectors in de browser.

Opschalen: Python Webscraping Optimaliseren met Scrapy

Wil je niet alleen één pagina, maar een hele site en alle subpagina’s scrapen? Dan is Scrapy jouw beste vriend.

- Architectuur: Scrapy werkt met “spiders” (klassen die bepalen hoe je crawlt en data verzamelt), pipelines (voor dataverwerking) en asynchrone requests voor snelheid.

- Waarom Scrapy? Het is gemaakt voor schaal – duizenden pagina’s ophalen, foutafhandeling en data exporteren naar CSV/JSON zonder gedoe.

Wanneer Scrapy Beter is dan BeautifulSoup

- Je wilt automatisch veel pagina’s crawlen of links volgen.

- Je hebt ingebouwde ondersteuning nodig voor retries, throttling en dataverwerking.

- Je bouwt een scraper die je regelmatig draait of met een team deelt.

Scrapy in de Praktijk: Voorbeeldproject

Hier een spider die alle quotes van alle pagina’s verzamelt:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)Uitvoeren met:

1scrapy crawl quotes -O quotes.jsonEn je hebt een JSON-bestand met alle data – geen handmatige loops meer nodig.

Als je scraping-project groeit, zijn de structuur en snelheid van Scrapy ideaal voor grootschalige dataverzameling.

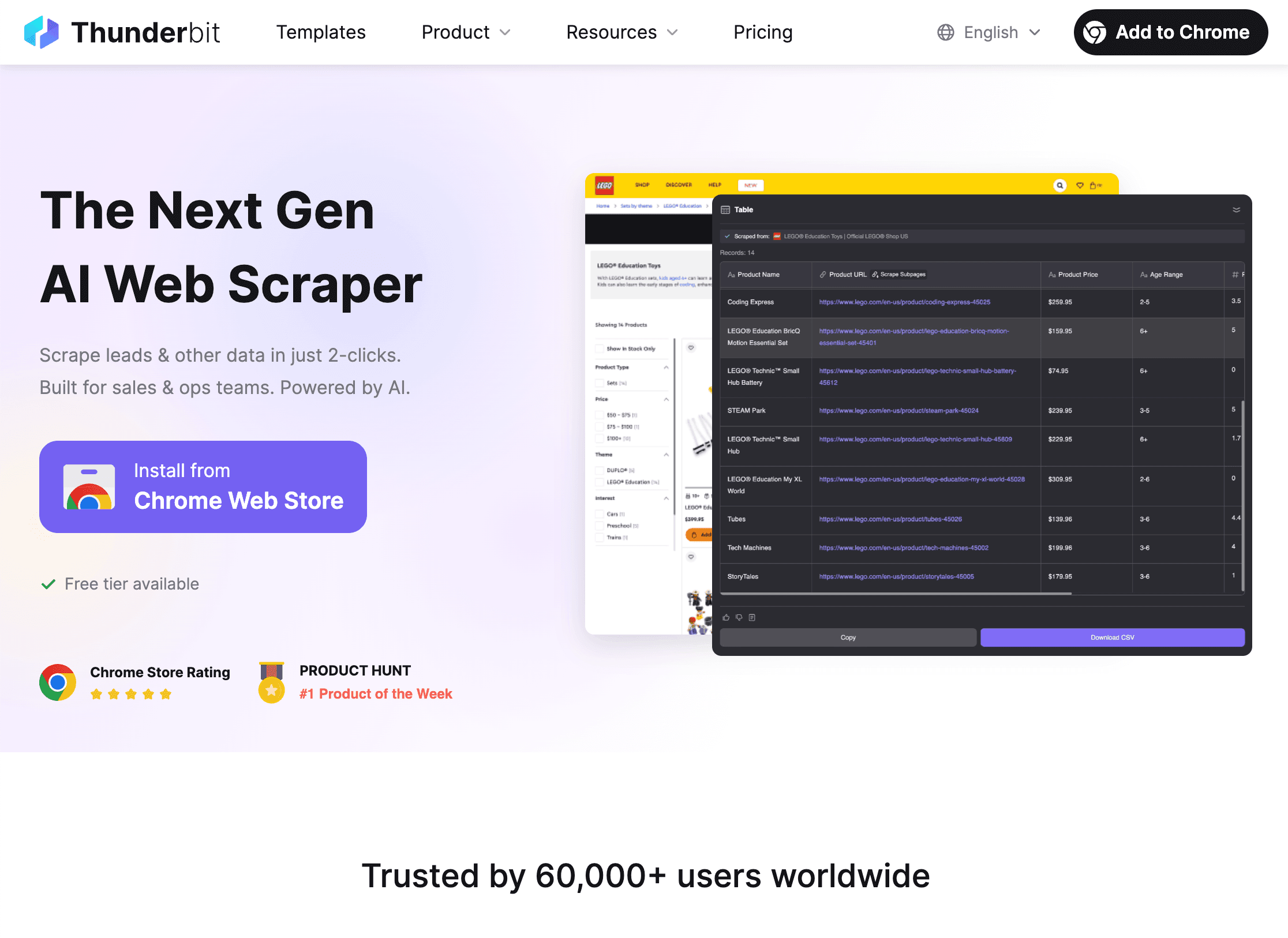

Thunderbit: AI-tools die Python Webscraping een Boost Geven

Eerlijk is eerlijk: zelfs met Python kan scrapen lastig zijn – zeker bij dynamische sites, subpagina’s of veranderende layouts. Daar komt om de hoek kijken.

Thunderbit is een AI-webscraper voor Chrome waarmee je in twee klikken websites kunt scrapen:

- AI stelt velden voor: De AI leest de pagina en doet suggesties voor kolommen (zoals “Productnaam”, “Prijs”, enz.).

- Scrapen: Klik nogmaals en Thunderbit verzamelt alle data – inclusief paginering, subpagina’s en zelfs oneindig scrollen.

Waarom ik fan ben van Thunderbit:

- Geen code nodig: Ideaal voor zakelijke gebruikers en analisten.

- Kan complexe sites aan: Dynamische content, subpagina’s en layout-wijzigingen? De AI past zich aan.

- Direct exporteren: Stuur data direct naar Excel, Google Sheets, Airtable of Notion.

- Subpagina’s scrapen: Details van elk product of profiel? Thunderbit bezoekt automatisch elke subpagina en verrijkt je tabel.

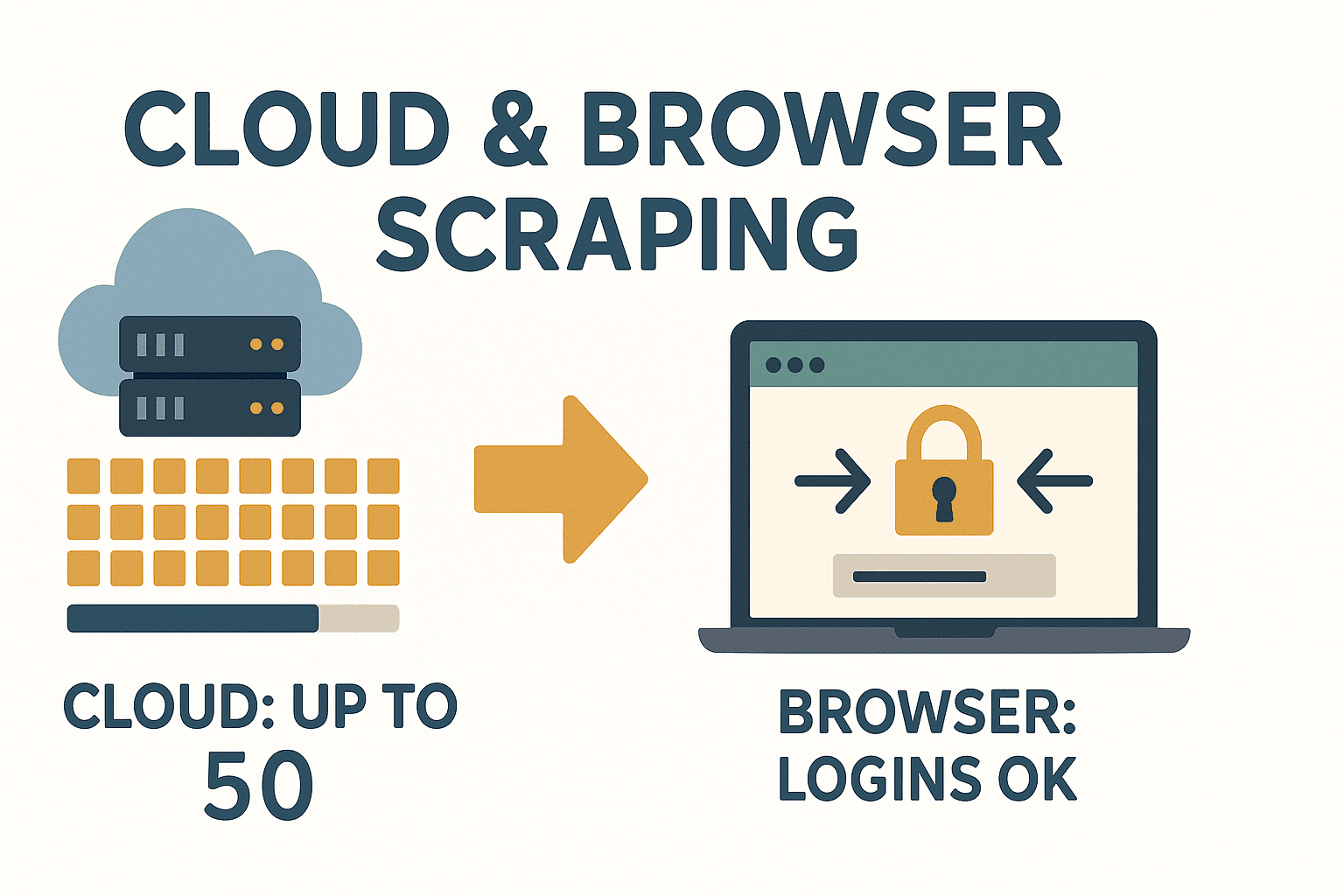

- Cloud- of browsermodus: Scrape tot 50 pagina’s tegelijk in de cloud, of gebruik je browser voor sites waar je moet inloggen.

Thunderbit is echt een gamechanger voor iedereen die snel data nodig heeft en niet telkens code wil aanpassen als een site verandert.

Thunderbit is echt een gamechanger voor iedereen die snel data nodig heeft en niet telkens code wil aanpassen als een site verandert.

Wanneer AI-tools zoals Thunderbit Gebruiken

- Je hebt direct data nodig en wilt niet wachten op IT of zelf code schrijven.

- De site is complex, dynamisch of verandert vaak.

- Je wilt niet-technische collega’s zelf data laten verzamelen.

- Je wilt data direct verrijken (vertalen, categoriseren, enz.) tijdens het scrapen.

Thunderbit werkt perfect samen met Python-workflows – gebruik het voor snelle prototypes, lastige sites of als je geen zin hebt in onderhoud. Meer weten? Lees de .

Omgaan met Dynamische Content en Paginering bij Python Webscraping

Moderne websites gebruiken veel JavaScript, wat scrapen soms lastig maakt. Zo pak je dat aan:

- Dynamische content: Wordt data pas zichtbaar na het laden van JS? Gebruik Selenium of Playwright om een browser te automatiseren, wacht tot de content geladen is en haal dan de data op.

- Paginering: Loop door “Volgende”-links of verhoog het paginanummer in de URL. Scrapy regelt dit elegant met zijn request-volgmechanisme.

Voorbeeld: Paginering met BeautifulSoup

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...quotes extraheren...

12 page += 1Voor infinite scroll of “Load More”-knoppen: Gebruik Selenium om te scrollen of te klikken, of kijk in het netwerk-tabblad voor API-calls die je met Requests kunt nadoen.

Data Opslaan: Je Gescrapete Data Gebruiken in de Praktijk

Als je de data hebt, wil je die natuurlijk handig opslaan.

- CSV: Universeel en makkelijk te openen in Excel of Google Sheets.

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel: Gebruik pandas voor snelle export.

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - Database: Voor grote of doorlopende projecten, gebruik SQLite of PostgreSQL.

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...tabel aanmaken, data invoegen... 4conn.close()

Kies het formaat dat bij jouw workflow past. Voor delen met niet-technische collega’s zijn Excel of Google Sheets meestal het handigst.

Juridische en Ethische Aspecten van Webscraping met Python

Scrapen is krachtig, maar brengt ook verantwoordelijkheid met zich mee. Zo blijf je binnen de regels:

- Scrape alleen openbare data: Heb je een login nodig of zit het achter een betaalmuur? Denk dan goed na.

- Check de gebruiksvoorwaarden: Sommige sites verbieden scraping expliciet. Negeer je dit, dan kun je geblokkeerd worden of erger ().

- Respecteer robots.txt: Niet wettelijk bindend, maar wel netjes.

- Vermijd persoonsgegevens: Door GDPR en CCPA kan het verzamelen van namen, e-mails of telefoonnummers problemen opleveren.

- Overbelast servers niet: Voeg vertragingen toe, beperk het aantal verzoeken en scrape bij voorkeur buiten piekuren.

Snelle compliance-checklist:

- Lees de ToS en robots.txt van de site.

- Vermijd het scrapen van persoonlijke of gevoelige data.

- Vermeld je databronnen.

- Wees beleefd: overbelast de server niet.

Meer weten over de juridische kant? Zie .

Problemen Oplossen & Best Practices voor Betrouwbare Python Webscraping

Webscraping verloopt niet altijd vlekkeloos. Zo los je veelvoorkomende problemen op:

- HTTP-fouten (403, 404, 429): Gebruik een realistische User-Agent, vertraag je verzoeken en vang fouten netjes af.

- Geblokkeerde IP’s: Gebruik proxies of roteer je IP bij grootschalig scrapen – maar vraag je altijd af of je ethisch bezig bent.

- CAPTCHAs: Kom je een CAPTCHA tegen, overweeg dan of je door wilt gaan. Er zijn diensten die ze oplossen, maar het is een grijs gebied.

- Wijzigingen in site-structuur: Gebruik robuuste selectors, controleer op

Noneen gebruik try/except-blokken. - Encoding-problemen: Werk altijd met UTF-8 en test je output in Excel of Sheets.

Best practices:

- Log elke stap – zo weet je waar het misgaat.

- Herhaal mislukte verzoeken met backoff.

- Test je scraper eerst op een paar pagina’s voordat je opschaalt.

- Houd het resultaat van je scraper in de gaten – daalt het aantal items, dan is er waarschijnlijk iets veranderd.

En ben je het zat om telkens je scraper te repareren als een site verandert? gebruikt AI om zich automatisch aan te passen aan nieuwe layouts.

Dankzij de AI-aanpak van Thunderbit kun jij je focussen op inzichten, niet op onderhoud.

Samenvatting & Belangrijkste Leerpunten

Webscraping met Python is een superkracht voor bedrijven – je verandert de chaos van het web in gestructureerde, bruikbare data. Dit hebben we behandeld:

- Python is de beste keuze voor webscraping dankzij de leesbare code en krachtige libraries.

- Requests + BeautifulSoup zijn ideaal voor kleine, statische klussen; Scrapy is perfect voor grootschalig, geautomatiseerd crawlen.

- Thunderbit brengt AI in het spel, waardoor scrapen voor iedereen toegankelijk wordt – geen code, geen gedoe, gewoon data.

- Dynamische content en paginering pak je aan met Selenium of de ingebouwde features van Scrapy.

- Sla je data op in CSV, Excel of databases – wat het beste bij jouw bedrijf past.

- Blijf legaal en ethisch: Scrape alleen openbare data, respecteer de regels van de site en vermijd persoonsgegevens.

- Bouw robuuste scrapers: Log, herhaal en monitor veranderingen. Of laat Thunderbit’s AI het zware werk doen.

Klaar om te beginnen? Bouw je eerste Python-webscraper – of, als je geen zin hebt in code, en ontdek hoe makkelijk webdata verzamelen kan zijn. Meer tips en verdieping vind je op de .

Veelgestelde Vragen

1. Is webscraping met Python legaal?

Webscraping is toegestaan als je alleen openbare data verzamelt en je aan de gebruiksvoorwaarden, robots.txt en privacywetgeving zoals de AVG houdt. Vermijd het verzamelen van persoonlijke of gevoelige informatie en check altijd de regels voordat je begint ().

2. Wat is het verschil tussen BeautifulSoup en Scrapy?

BeautifulSoup is een lichte HTML-parser – ideaal voor kleine taken of het scrapen van één pagina. Scrapy is een compleet framework voor het crawlen van veel pagina’s, paginering en grootschalige data-export. Gebruik BeautifulSoup voor snelle scripts, Scrapy voor grote projecten ().

3. Hoe ga ik om met JavaScript-rijke websites in Python?

Gebruik Selenium of Playwright om een browser te automatiseren, wacht tot JavaScript geladen is en haal dan de data op. Of kijk in het netwerk-tabblad voor API-calls die je met Requests kunt nadoen.

4. Wat maakt Thunderbit anders dan Python scraping-libraries?

Thunderbit gebruikt AI om velden voor te stellen, subpagina’s te verwerken en zich aan te passen aan veranderende layouts – zonder code. Ideaal voor zakelijke gebruikers en teams die snel data willen, zonder het onderhoud van traditionele scrapers ().

5. Hoe kan ik gescrapete data delen met mijn team?

Exporteer je data naar CSV of Excel voor eenvoudig delen, of gebruik pandas om op te slaan in databases voor grotere projecten. Met Thunderbit kun je direct exporteren naar Google Sheets, Airtable, Notion of gratis downloaden als CSV/Excel.

Veel succes met scrapen – en moge je data altijd gestructureerd, schoon en klaar voor gebruik zijn.