Het internet groeit als kool, en als je in de zakenwereld zit, in tech werkt of gewoon een echte dataverzamelaar bent zoals ik, heb je het vast al door: de echte kracht zit in de data die je kunt binnenhalen—niet alleen in wat je op het scherm ziet. Steeds meer bedrijven zetten vol in op het automatiseren van webdataverzameling, en de wereldwijde webscraping-markt wordt naar verwachting waard. Leuk feitje: meer dan gebruikt inmiddels webcrawlers of webscrapers om hun AI, analyses en bedrijfsvoering te voeden.

Hoe kun jij hiervan profiteren? Voor de meeste mensen is Python hét antwoord. Het is dé programmeertaal om webscrapers te bouwen—lekker simpel, krachtig en vol handige libraries die het leven makkelijker maken. In deze gids leg ik uit wat een websitecrawler precies is, waarom Python zo’n hit is, hoe je zelf stap voor stap een crawler bouwt, en hoe tools als het allemaal nóg simpeler maken (voor als je liever klikt dan codeert). Of je nu developer bent, marketeer die op data stuurt, of gewoon saaie klusjes wilt automatiseren—hier vind je alles om je webdataverzameling naar een hoger plan te tillen.

Wat is een Website Crawler? (En Waarom Is Het Belangrijk?)

Heel simpel gezegd: een website crawler is een programma dat automatisch het web afstruint, pagina’s bezoekt, links volgt en (optioneel) onderweg data binnenhaalt. Zie het als een superwebsurfer—één die nooit moe wordt, nooit pauze neemt en nooit per ongeluk het verkeerde tabblad sluit. Crawlers zijn de motor achter zoekmachines (zoals Googlebot), maar bedrijven gebruiken ze ook voor bijvoorbeeld prijsmonitoring en marktonderzoek.

Maar wat is nu het verschil tussen crawlen en scrapen? Crawlen draait om het vinden en navigeren van pagina’s (alsof je een plattegrond van een stad tekent), terwijl scrapen gaat om het uithalen van specifieke data uit die pagina’s (zoals alle menukaarten van restaurants verzamelen). In de praktijk doe je vaak allebei: eerst crawlen om pagina’s te vinden, daarna scrapen om de data te pakken ().

Praktische toepassingen van crawlers voor bedrijven:

- Leadgeneratie: Automatisch contactgegevens verzamelen uit bedrijvengidsen of social media.

- Prijsmonitoring: Concurrentieprijzen en voorraad bijhouden over duizenden producten.

- Contentmonitoring: Alerts krijgen als je merk genoemd wordt in nieuws, blogs of fora.

- SEO-audits: Je eigen site scannen op kapotte links of ontbrekende metadata.

- Marktonderzoek: Vastgoedaanbod, vacatures of productreviews verzamelen voor analyse.

Heb je ooit gewenst dat je jezelf kon klonen om al dat webonderzoek bij te houden? Een crawler is het beste alternatief.

Waarom Website Crawlers Onmisbaar Zijn voor Automatisering

Laten we het praktisch maken. Waarom investeren bedrijven in crawlers en webscrapers? Omdat het bakken met tijd en geld scheelt. Hier zie je hoe verschillende teams crawlers inzetten en wat het oplevert:

| Use Case | Key Benefit | Who Uses It |

|---|---|---|

| Lead Generation | Automatisch prospects verzamelen, uren werk besparen | Sales, Recruitment |

| Price Tracking | Direct inzicht in concurrentie, dynamische prijsstelling | E-commerce, Productteams |

| Content Monitoring | Merkbescherming, trends signaleren | Marketing, PR |

| SEO Site Audit | Betere sitegezondheid, hogere rankings | SEO, Webmasters |

| Market Research | Actuele, grote datasets voor analyse | Analisten, Onderzoeksteams |

Uit de praktijk blijkt dat het automatiseren van een wekelijkse dataverzameltaak (scrapen van 5-7 websites) één medewerker meer dan 50 uur per jaar bespaart—reken maar uit wat dat doet voor een heel team. Geen wonder dat als ze eenmaal crawlers gebruiken.

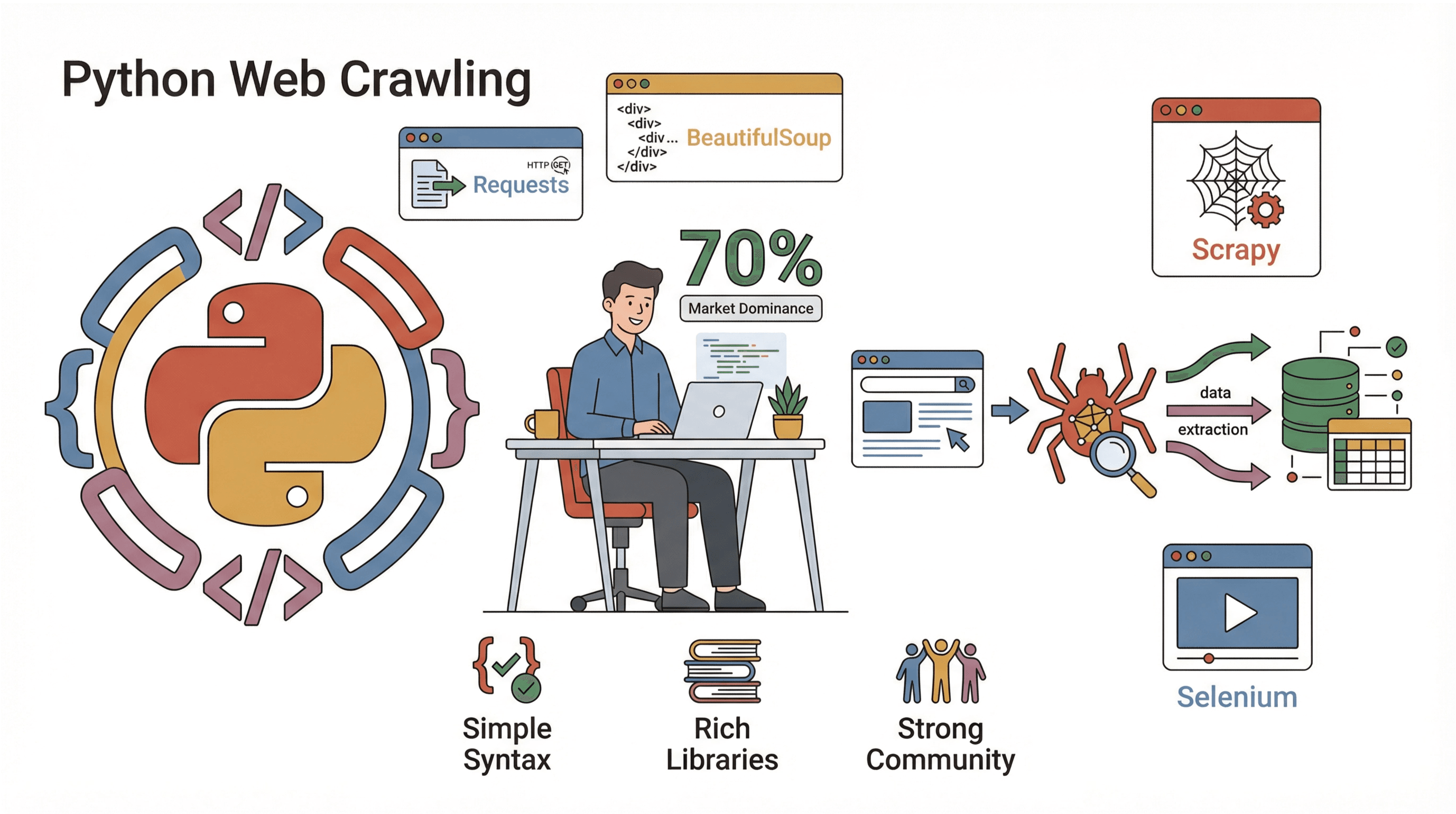

Python: De Favoriet voor het Bouwen van een Website Crawler

Waarom is Python zo populair voor webcrawling? Drie hoofdredenen:

Waarom is Python zo populair voor webcrawling? Drie hoofdredenen:

- Eenvoud: Python is makkelijk te lezen, toegankelijk voor beginners en je hebt met weinig code al een werkende crawler.

- Uitgebreide libraries: Voor elke stap van het crawlen heeft Python handige libraries—van het ophalen van pagina’s tot het parsen van HTML en omgaan met JavaScript.

- Grote community: Bijna draait op Python, dus er zijn volop tutorials, voorbeelden en oplossingen voor elk probleem.

Populaire Python-libraries voor webcrawling:

- Requests: De makkelijkste manier om webpagina’s op te halen (HTTP GET/POST).

- BeautifulSoup: Dé tool om HTML te parsen en elementen te vinden.

- Scrapy: Een compleet framework voor grootschalige crawlers.

- Selenium: Automatiseert browsers, ideaal voor sites die veel JavaScript gebruiken.

Vergeleken met andere talen (zoals Java of C#) kun je met Python veel sneller van idee naar een werkende crawler. En als je met data werkt, kun je de output direct in Pandas analyseren—zonder gedoe met exporteren of importeren.

Vergelijking van Parse-methodes: Regex vs. BeautifulSoup vs. Scrapy

Als je data uit webpagina’s wilt halen, heb je verschillende opties. Zo verhouden de belangrijkste methodes zich tot elkaar:

| Method | How It Works | Pros 🟢 | Cons 🔴 | Best For |

|---|---|---|---|---|

| Regex | Zoekt patronen in ruwe HTML | Snel bij simpele, voorspelbare patronen | Kwetsbaar, breekt bij HTML-wijzigingen | Snelle hacks, URLs extraheren |

| BeautifulSoup | Zet HTML om in een boomstructuur, zoekt op tags | Makkelijk, flexibel, kan met rommelige HTML omgaan | Langzamer bij grote pagina’s, handmatig crawlen | De meeste kleine/middelgrote scripts |

| Scrapy | Compleet framework, CSS/XPath parsing | Snel, schaalbaar, regelt crawling én parsing | Steilere leercurve, meer opzet nodig | Grote, professionele crawlers |

- Regex is als een metaaldetector op het strand—snel, maar je mist dingen als het zand verschuift.

- BeautifulSoup is alsof je een kaart en een schep hebt—je kunt overal graven, maar je moet het strand zelf aflopen.

- Scrapy is als een team met vrachtwagens en GPS—overkill voor een zandbak, maar onverslaanbaar voor grote klussen.

Voor beginners raad ik aan te starten met Requests + BeautifulSoup. Zo leer je de basis, en kun je later altijd overstappen op Scrapy als je wilt opschalen.

Stap-voor-stap: Zelf een Simpele Website Crawler Bouwen in Python

Klaar om te beginnen? We bouwen een eenvoudige crawler die pagina’s bezoekt, links volgt en data verzamelt. Ik neem je mee door elke stap, met code die je direct kunt gebruiken.

Stap 1: Je Python-omgeving Inrichten

Zorg eerst dat je Python 3.10+ hebt geïnstalleerd. (Check met python --version.) Maak een virtuele omgeving aan voor je project:

1python -m venv venv

2source venv/bin/activate # Op Windows: venv\Scripts\activateInstalleer vervolgens de benodigde libraries:

1pip install requests beautifulsoup4Dat is alles! Open je favoriete code-editor en je kunt aan de slag.

Stap 2: Je Eerste Website Crawler Script Schrijven

We starten met het ophalen van één pagina. Hier een simpel script:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # Geeft foutmelding als het geen 200 OK is

5 print(response.text[:500]) # Laat de eerste 500 tekens zien

6crawl_page("https://www.scrapingcourse.com/ecommerce/")Je zou nu een stuk HTML in je console moeten zien—het bewijs dat je verbinding hebt met het web.

Stap 3: Links Volgen en Meer Data Verzamelen

Nu laten we de crawler meerdere pagina’s bezoeken door links te volgen. We houden een lijst bij van te bezoeken URLs en een set van reeds bezochte URLs (om rondjes te voorkomen):

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # Veiligheidslimiet

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Failed to retrieve {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Crawled: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) and url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)Dit script crawlt tot 20 pagina’s en volgt alleen links binnen dezelfde site. Je ziet elke URL zodra deze bezocht is.

Stap 4: Data Uithalen uit Pagina’s

Stel, je wilt productnamen en prijzen verzamelen van elke pagina. Zo doe je dat:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ... (zelfde als hierboven)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url of current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ... (rest van de crawl-logica)

18# Opslaan als CSV

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"Scraped {len(product_data)} products.")Nu heb je een CSV-bestand met alle gescrapete producten—klaar voor analyse, uploaden of om te laten zien aan je collega’s.

Stap 5: Je Crawler Debuggen en Optimaliseren

Een crawler bouwen is één ding; zorgen dat hij stevig draait, is iets anders. Hier wat tips uit eigen ervaring (en een paar lessen uit de praktijk):

- Stel een User-Agent in: Sommige sites blokkeren standaard “Python-requests”. Doe je voor als browser:

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - Fouten netjes afhandelen: Gebruik try/except om kapotte of geblokkeerde pagina’s over te slaan.

- Voorkom oneindige lussen: Houd altijd bezochte URLs bij en stel een maximum aantal pagina’s in.

- Vertraag je verzoeken: Voeg

time.sleep(1)toe tussen verzoeken om blokkades te voorkomen. - Check robots.txt: Respecteer altijd de crawlregels van een site ().

- Log je voortgang: Print of log elke URL die je crawlt—onmisbaar bij het oplossen van problemen.

Wordt je crawler geblokkeerd, krijg je rare content of mis je data? Controleer je headers, vertraag je verzoeken en kijk of je niet tegen anti-botmaatregelen aanloopt.

Thunderbit: Website Crawlen Makkelijk Gemaakt met AI

Tijd voor de “easy button” van webcrawling: . Hoe leuk Python ook is, soms wil je gewoon snel de data—zonder gedoe met installatie, debugging of onderhoud. Thunderbit is een AI-webscraper Chrome-extensie waarmee je met een paar klikken data van elke website kunt halen.

Wat maakt Thunderbit uniek?

- AI Suggest Fields: Thunderbit’s AI scant de pagina en stelt automatisch voor welke data je kunt extraheren—geen HTML inspecteren of selectors schrijven nodig.

- No-code, in je browser: Werkt direct in je browser, dus ook op ingelogde sites en pagina’s met veel JavaScript.

- Subpagina’s scrapen: Meer details nodig? Thunderbit bezoekt automatisch subpagina’s (zoals productdetails) en vult je tabel aan.

- Direct exporteren: Exporteer je data direct naar Excel, Google Sheets, Airtable of Notion—geen gedoe met CSV’s.

- Cloud of lokaal scrapen: Kies voor snelle cloud scraping (voor openbare sites) of browsermodus (voor ingelogde of complexe sites).

- Automatisch plannen: Stel scrapes in die automatisch draaien—geen servers of cronjobs nodig.

Voor zakelijke gebruikers is Thunderbit echt een gamechanger. Je gaat van “ik heb deze data nodig” naar “hier is mijn spreadsheet” in minuten, niet uren. En als developer kun je Thunderbit als aanvulling gebruiken—voor snelle klussen of als backup als je eigen code even niet werkt.

Benieuwd hoe het werkt? en probeer je favoriete site te scrapen. Met het gratis pakket kun je een aantal pagina’s scrapen, en betaalde abonnementen starten vanaf slechts $15/maand voor 500 credits.

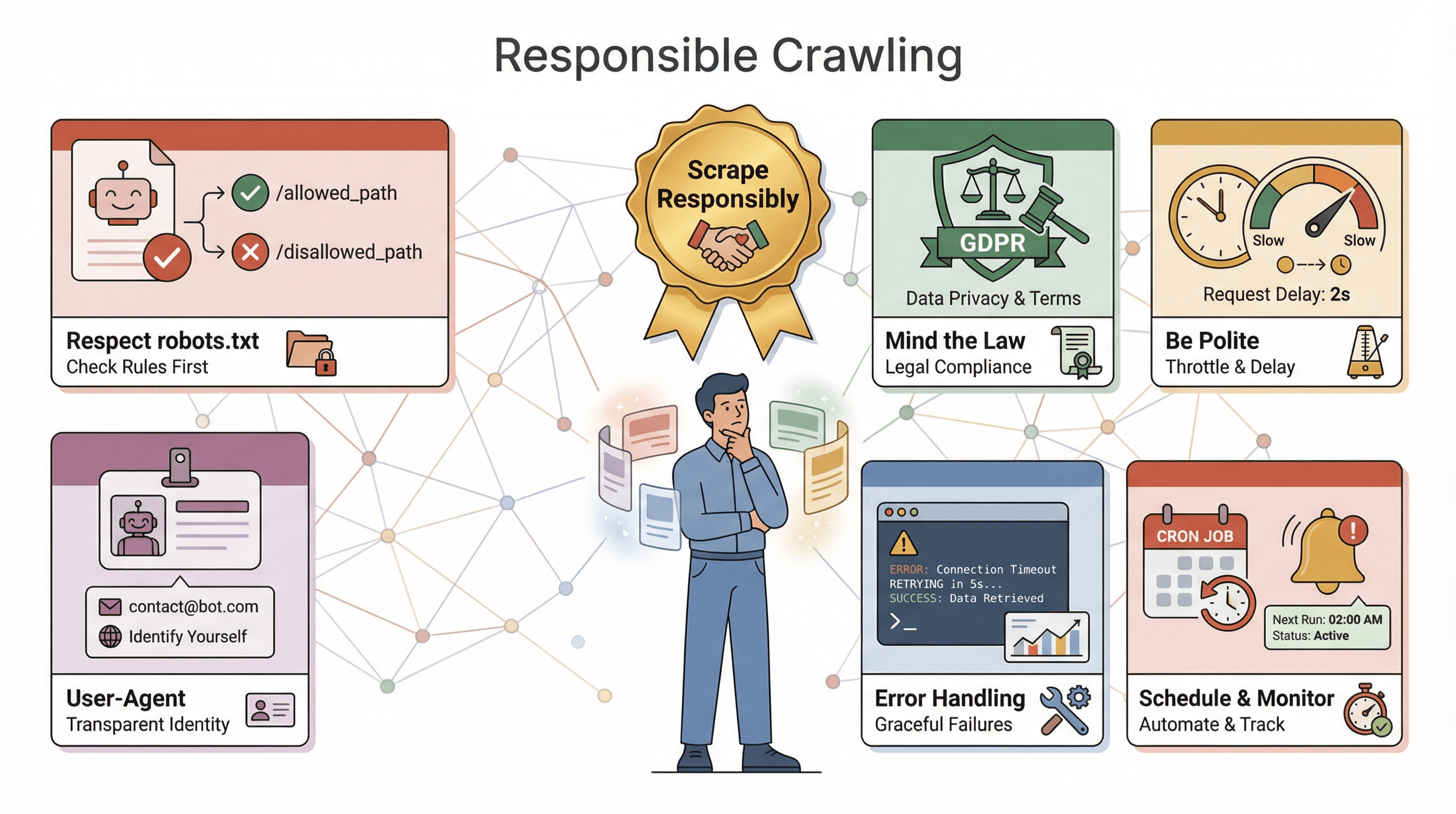

Belangrijke Aandachtspunten bij het Bouwen van een Website Crawler in Python

Voordat je je crawler loslaat op het web, een paar belangrijke tips (en waarschuwingen):

Voordat je je crawler loslaat op het web, een paar belangrijke tips (en waarschuwingen):

- Respecteer robots.txt: De meeste sites publiceren een

robots.txt-bestand met regels voor crawlers. Negeer je deze, dan kun je geblokkeerd worden—of erger, juridische problemen krijgen. Check en volg altijd deze regels (). - Let op de wetgeving: Sommige sites verbieden scrapen in hun gebruiksvoorwaarden. Verzamel je persoonlijke data, dan gelden privacywetten als AVG of CCPA (). Twijfel je? Blijf bij openbare, niet-gevoelige data.

- Wees beleefd: Overlaad sites niet met verzoeken—vertraag je crawler, randomiseer wachttijden en vermijd piekuren.

- Identificeer jezelf: Gebruik een eigen User-Agent en overweeg contactinformatie toe te voegen als je op grote schaal crawlt.

- Fouten en logging: Verwacht dat sites veranderen, pagina’s kapot gaan en data rommelig wordt. Bouw foutafhandeling, logging en monitoring in zodat je snel kunt bijsturen.

- Plan en monitor: Voor regelmatige crawls kun je planningshulpmiddelen gebruiken (zoals cron of de ingebouwde scheduler van Thunderbit) en alerts instellen als je crawler faalt of geen data meer vindt.

De gouden regel: scrape verantwoord. Het web is van iedereen—zorg dat je niet die bot bent die het voor anderen verpest.

Geavanceerde Tips: Je Python Website Crawler Opschalen en Verbeteren

Heb je de basis onder de knie? Dan kun je je crawler verder uitbreiden. Hier wat geavanceerde tips:

- Omgaan met JavaScript: Gebruik Selenium of Playwright om sites te scrapen die data dynamisch laden.

- Schaalbaarheid: Voor grote projecten kun je overstappen op Scrapy of asynchrone libraries (zoals

aiohttp) voor gelijktijdige verzoeken. - Gebruik proxies: Wissel van IP-adres om blokkades te voorkomen bij veelvuldig crawlen.

- Automatiseer je datastroom: Schrijf direct naar databases of koppel aan cloudopslag voor grote datasets.

- Monitor en alert: Zet logging, health checks en notificaties op voor langdurige crawlers.

Wordt je crawler echt bedrijfskritisch? Overweeg dan managed services of API’s om het zware werk uit te besteden. En als je meerdere sites met verschillende layouts scraped, maak je code modulair zodat je makkelijk kunt aanpassen.

Samenvatting & Belangrijkste Leerpunten

Zelf een websitecrawler bouwen in Python is één van de meest waardevolle skills in deze data-gedreven tijd. Dit hebben we behandeld:

- Websitecrawlers automatiseren het bezoeken en verzamelen van data van webpagina’s—onmisbaar voor automatisering, onderzoek en concurrentieanalyse.

- Python is de beste keuze dankzij de eenvoudige syntax, krachtige libraries en grote community.

- Parse-methodes zijn belangrijk: gebruik regex voor snelle hacks, BeautifulSoup voor de meeste scripts en Scrapy voor grote projecten.

- Stap voor stap kun je van het ophalen van één pagina doorgroeien naar het crawlen van een hele site en het opslaan van gestructureerde data—zonder dat je een expert hoeft te zijn.

- Thunderbit maakt het nóg makkelijker: data scrapen met AI, zonder code, en direct exporteren—ideaal voor zakelijke gebruikers of iedereen die snel resultaat wil.

- Verantwoord crawlen is essentieel: respecteer regels, bouw foutafhandeling in en zet ethiek voorop.

- Opschalen kan met de juiste tools—of dat nu Selenium is voor JavaScript, Scrapy voor schaalbaarheid, of Thunderbit voor no-code automatisering.

De beste manier om te leren is gewoon beginnen—schrijf een script, probeer Thunderbit en ontdek welke data je kunt verzamelen. Het web ligt voor je open (of als je net zo’n datanerd bent als ik: het is een onbeperkt databuffet).

Meer weten? Check deze bronnen:

- voor meer tips, handleidingen en geavanceerde technieken.

Veel succes met crawlen—moge je webscrapers snel zijn, je data schoon en je koffie altijd warm.

Veelgestelde Vragen

1. Wat is het verschil tussen een websitecrawler en een webscraper?

Een crawler bezoekt en ontdekt systematisch webpagina’s (zoals het in kaart brengen van een site), terwijl een webscraper specifieke data uit die pagina’s haalt. In de praktijk gebruik je meestal beide: crawlen om pagina’s te vinden, scrapen om de data te verzamelen.

2. Waarom is Python zo populair voor het bouwen van websitecrawlers?

Python is makkelijk te leren, heeft krachtige libraries (zoals Requests, BeautifulSoup, Scrapy, Selenium) en een grote community. Bijna 70% van de webscraping-projecten gebruikt Python—het is de standaard in de branche.

3. Wanneer gebruik je regex, BeautifulSoup of Scrapy voor parsing?

Gebruik regex voor simpele, voorspelbare patronen. BeautifulSoup is ideaal voor de meeste scripts—makkelijk en flexibel. Scrapy is perfect voor grote of professionele crawlers die snelheid, schaalbaarheid en robuuste features nodig hebben.

4. Hoe verhoudt Thunderbit zich tot zelf een crawler coderen in Python?

Met Thunderbit kun je data scrapen met AI en zonder code—gewoon klikken, velden selecteren en exporteren. Ideaal voor zakelijke gebruikers of snelle klussen. Python geeft je meer controle en maatwerk, maar vereist wel programmeren en onderhoud.

5. Met welke juridische of ethische zaken moet ik rekening houden bij het crawlen van websites?

Check en respecteer altijd robots.txt, volg de gebruiksvoorwaarden van de site, verzamel geen gevoelige of persoonlijke data zonder toestemming en doseer je verzoeken om servers niet te overbelasten. Verantwoord scrapen houdt het web toegankelijk voor iedereen.

Zelf aan de slag? of open je favoriete Python-editor en begin met crawlen. De data ligt voor het oprapen—ga ervoor!

Meer weten