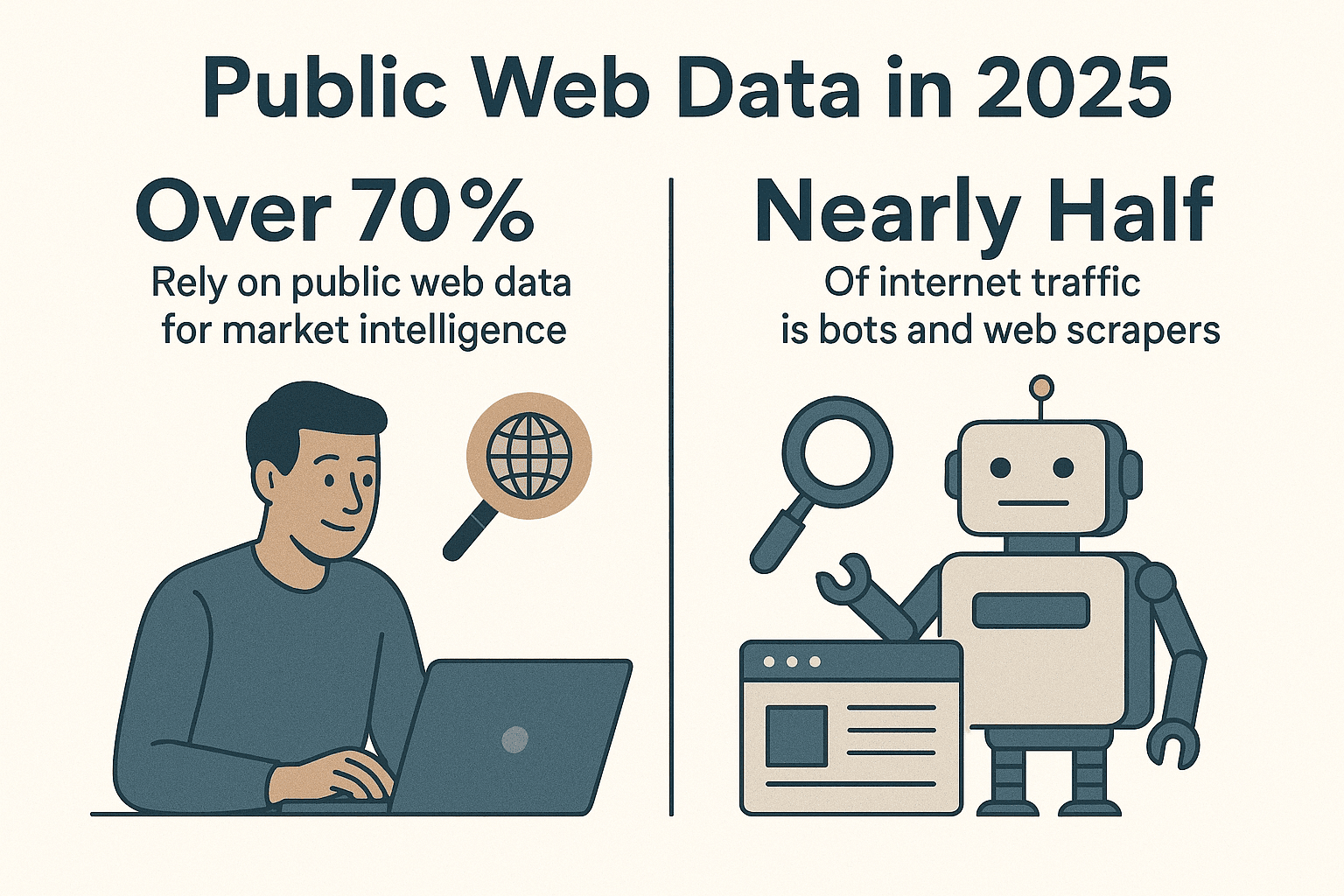

Het internet is één grote bron van data en bedrijven proberen die wirwar om te zetten in waardevolle inzichten. Wist je dat tegenwoordig meer dan ? En bijna de helft van al het internetverkeer bestaat inmiddels uit bots en webscrapers, niet uit mensen (). Als iemand die al jaren automatiseringstools bouwt (en ja, een paar webspiders die waarschijnlijk meer websites hebben bezocht dan ikzelf), kan ik je vertellen: als je nog geen Python webspider inzet om je dataverzameling te automatiseren, laat je echt een enorme efficiëntieslag liggen.

Python is dé standaardtaal geworden voor webscraping, en dat is niet voor niets. Of je nu in sales, marketing, operations of onderzoek werkt: een goed gebouwde Python webspider bespaart je uren werk en geeft je inzichten die je anders nooit zou krijgen. In deze gids neem ik je stap voor stap mee in het opzetten van een efficiënte Python webspider, deel ik mijn favoriete libraries en best practices, en ontdek je hoe tools als je workflow een flinke boost geven—vooral bij die lastige, dynamische websites waar zelfs ervaren programmeurs soms moedeloos van worden.

Python is dé standaardtaal geworden voor webscraping, en dat is niet voor niets. Of je nu in sales, marketing, operations of onderzoek werkt: een goed gebouwde Python webspider bespaart je uren werk en geeft je inzichten die je anders nooit zou krijgen. In deze gids neem ik je stap voor stap mee in het opzetten van een efficiënte Python webspider, deel ik mijn favoriete libraries en best practices, en ontdek je hoe tools als je workflow een flinke boost geven—vooral bij die lastige, dynamische websites waar zelfs ervaren programmeurs soms moedeloos van worden.

Waarom Python kiezen voor een webspider?

Laten we eerlijk zijn: Python is de absolute koning in de wereld van webscraping. Volgens recente cijfers gebruikt bijna , veel meer dan JavaScript of andere talen. In 2024 heeft Python zelfs JavaScript ingehaald als populairste taal op GitHub (), vooral dankzij de dominantie in data science en automatisering.

Waarom is Python zo geschikt voor webspiders?

- Lekker leesbaar en simpel: De syntax van Python is duidelijk en logisch, waardoor je snel aan de slag kunt, of je nu beginner bent of gevorderd.

- Uitgebreide bibliotheek: Libraries als , , , en regelen alles van het ophalen van pagina’s tot het parsen van HTML en het automatiseren van browsers.

- Actieve community: Loop je vast? Er is een gigantische community die je graag helpt, plus talloze tutorials en codevoorbeelden voor elk scrapingprobleem.

- Flexibel: Of je nu een snel scriptje schrijft of een spider die duizenden pagina’s crawlt, Python groeit met je mee.

Vergeleken met andere talen biedt Python de perfecte mix van kracht en toegankelijkheid. JavaScript (Node.js) is handig voor dynamische content, maar de asynchrone aanpak kan lastig zijn voor beginners. Java en C# zijn robuust, maar vaak omslachtig. Python laat je focussen op de data, niet op de randzaken.

Je Python webspider-omgeving opzetten

Voordat je begint, is een goede basis belangrijk. Zo pak ik elk nieuw project aan:

1. Installeer Python 3

Download de nieuwste Python 3.x van of via je pakketbeheerder. Zorg dat python of python3 werkt in je terminal.

2. Maak een virtuele omgeving aan

Houd je project afhankelijkheden gescheiden met een virtuele omgeving:

1python3 -m venv .venv

2# Op Unix/Mac

3source .venv/bin/activate

4# Op Windows

5.venv\Scripts\activateZo houd je je packages overzichtelijk en voorkom je conflicten.

3. Installeer de belangrijkste libraries

Met je virtuele omgeving actief, installeer je de benodigde libraries:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemyWat doet elke library?

- Requests: Haalt webpagina’s op via HTTP.

- BeautifulSoup: Parseert en doorzoekt HTML.

- lxml: Supersnelle HTML/XML-parser (gebruikt door BeautifulSoup).

- Scrapy: Volledig scraping-framework voor grootschalige crawls.

- Selenium: Automatiseert browsers voor dynamische, JavaScript-rijke sites.

- pandas: Voor het opschonen en bewerken van data.

- SQLAlchemy: Slaat data op in databases.

Je bent nu klaar om alles te bouwen: van een simpel script tot een complete webspider-vloot.

De juiste Python webspider-library kiezen

Python biedt een rijk aanbod aan scrapingtools. Zo maak ik mijn keuze:

| Library/Tool | Gebruiksgemak | Snelheid & Schaal | Ideaal voor |

|---|---|---|---|

| Requests + BeautifulSoup | Zeer eenvoudig | Gemiddeld (één pagina tegelijk) | Beginners, statische pagina’s, snelle klusjes |

| Scrapy | Iets hogere leercurve | Zeer snel (async, gelijktijdig) | Grootschalige crawls, hele websites |

| Selenium/Playwright | Gemiddeld | Langzamer (browser overhead) | JavaScript-rijke sites, pagina’s achter login |

| aiohttp + asyncio | Gemiddeld (async) | Zeer snel (veel URL’s tegelijk) | Hoge volumes, statische scraping |

| Thunderbit (No-Code) | Makkelijkst (AI-gestuurd) | Snel (cloud/lokaal) | Niet-programmeurs, dynamische sites, snel resultaat |

Mijn vuistregel:

- Voor een paar statische pagina’s is Requests + BeautifulSoup ideaal.

- Voor honderden of duizenden pagina’s, of als je ingebouwde crawling wilt, is Scrapy je beste vriend.

- Voor alles wat een echte browser vereist (zoals “infinite scroll” of login), gebruik Selenium of Playwright.

- Voor “ik wil nú data en geen code schrijven”, is een uitkomst.

Een eenvoudige Python webspider bouwen: stap voor stap

Laten we een simpele webspider maken die de titels van Hacker News-verhalen ophaalt. Dit is mijn favoriete “hello world” voor webscraping.

1. Haal de webpagina op

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. Parseer de HTML

1soup = BeautifulSoup(html_content, "html.parser")3. Data extraheren

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. Paginering afhandelen

Hacker News heeft onderaan een “More”-link. Zo volg je die:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (extract articles as above)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # Wees beleefd!

11 else:

12 page_url = None5. Foutafhandeling en beleefdheid

- Controleer altijd

response.status_code. - Gebruik

time.sleep()om de server niet te overbelasten. - Stel een eigen User-Agent in:

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)Deze basis-webspider kun je aanpassen voor bijna elke statische site. Voor complexere klussen kun je Scrapy inzetten.

Je webspider uitbreiden met Scrapy

Worden je scrapingbehoeften groter? Dan is Scrapy de volgende stap. Zo begin je:

1. Start een Scrapy-project

1scrapy startproject myspider2. Maak een spider aan

In myspider/spiders/quotes_spider.py:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. Draai de spider

1scrapy crawl quotes -o quotes.jsonScrapy crawlt alle pagina’s, regelt gelijktijdigheid, volgt links en exporteert je data in JSON (of CSV, XML, enz.)—met minimale code.

Waarom ik fan ben van Scrapy:

- Ingebouwde ondersteuning voor gelijktijdigheid, rate limiting en beleefd crawlen

- Automatische robots.txt-afhandeling

- Makkelijk data exporteren en pipelines voor opschonen of opslaan

- Schaalbaar van een paar pagina’s tot miljoenen

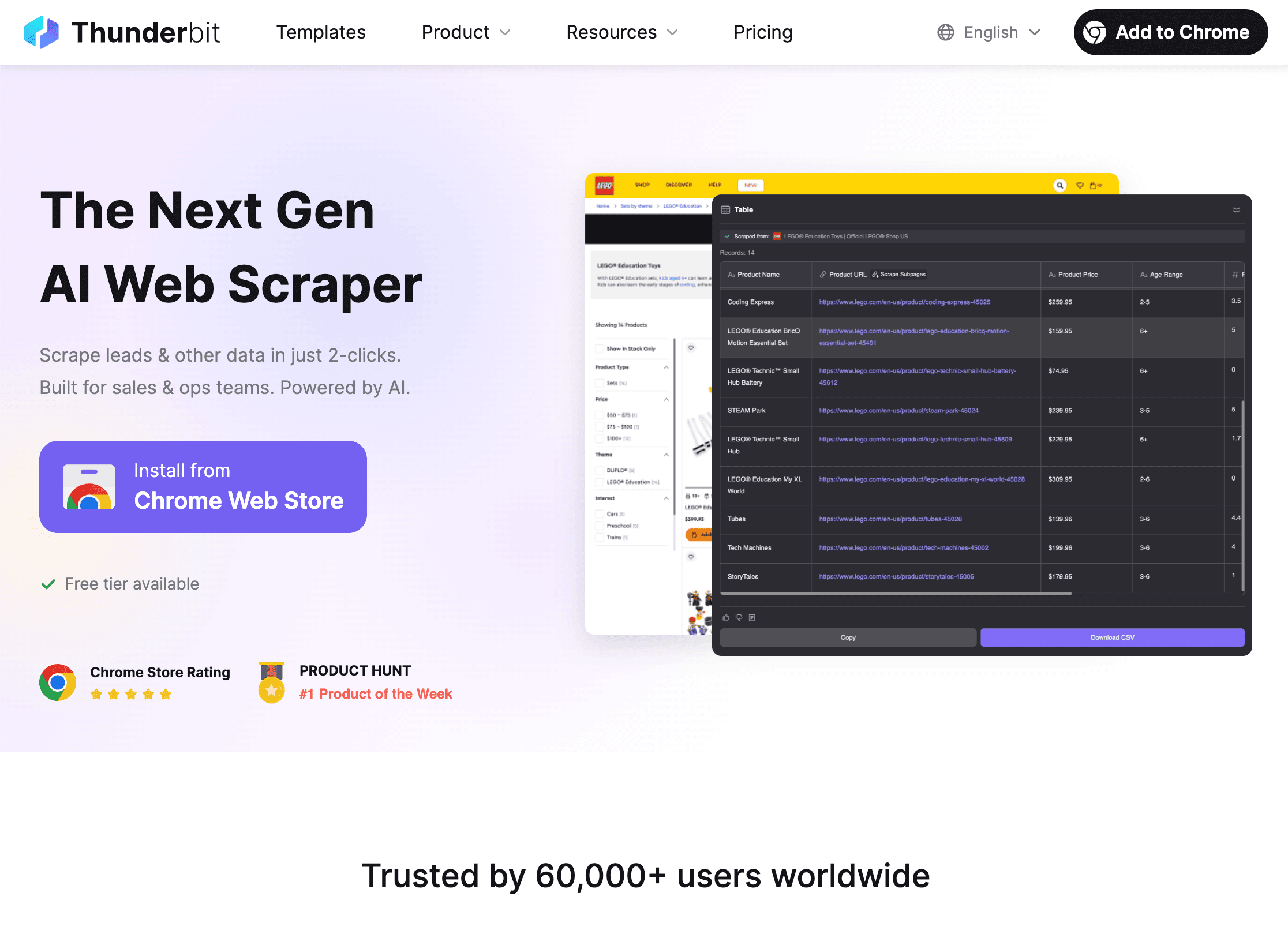

Thunderbit gebruiken om je Python webspider te versterken

Dan nu het grote struikelblok: dynamische websites. Hoe goed Python ook is, sommige sites zijn gewoon lastig—veel JavaScript, anti-botmaatregelen of steeds veranderende layouts. Daar komt om de hoek kijken.

Wat maakt Thunderbit uniek?

- AI Suggest Fields: Open de , klik op “AI Suggest Fields” en Thunderbit’s AI stelt automatisch voor welke data je kunt extraheren—geen HTML inspecteren of selectors schrijven nodig.

- Subpagina’s scrapen: Thunderbit volgt links naar detailpagina’s (zoals product- of profielpagina’s) en voegt die data samen in je hoofdtafel.

- Dynamische content aan: Omdat Thunderbit in een echte browser draait, kan het JavaScript-rijke sites, infinite scrolls en zelfs formulieren invullen met AI-autovullen.

- No-code, natuurlijke taal: Beschrijf gewoon wat je wilt (“Haal alle functietitels en locaties van deze pagina”) en Thunderbit regelt de rest.

- Direct data exporteren: Exporteer je data naar CSV, Excel, Google Sheets, Airtable of Notion—gratis en onbeperkt.

- Geplande scraping: Stel terugkerende taken in (“elke dag om 9 uur”) en Thunderbit levert automatisch verse data.

Hoe Thunderbit Python aanvult

Mijn favoriete workflow:

- Gebruik Thunderbit voor lastige of dynamische sites—vooral als je snel data nodig hebt of geen zin hebt om kwetsbare code te onderhouden.

- Exporteer de data als CSV of Excel.

- Laad het in Python met pandas voor opschonen, analyse of verdere automatisering.

Zo combineer je het beste van twee werelden: Thunderbit regelt de lastige extractie, Python doet de zware data-analyse.

Wanneer kies je voor Thunderbit of Python webspider?

- Thunderbit: Ideaal voor niet-programmeurs, dynamische sites, snelle eenmalige klussen, of als je business users zelf data wilt laten verzamelen.

- Python: Perfect voor maatwerk, grootschalige of geplande crawls, of als je diep wilt integreren met andere systemen.

- Beide: Gebruik Thunderbit voor extractie, Python voor analyse en automatisering. Ik noem dit de “pindakaas-en-jam”-aanpak—los goed, samen nog beter.

Meer over hybride workflows? Lees .

Blijf legaal en respecteer website-regels

Webscraping is krachtig, maar met grote kracht komt verantwoordelijkheid (en soms boze e-mails van systeembeheerders). Zo blijf je netjes:

1. Respecteer robots.txt

De meeste sites publiceren een robots.txt-bestand waarin staat wat wel en niet gecrawld mag worden. Zo check je dat in Python:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("Scrapen niet toegestaan volgens robots.txt")Scrapy volgt robots.txt standaard (ROBOTSTXT_OBEY=True).

2. Wees beleefd

- Gebruik vertragingen (

time.sleep()of Scrapy’sDOWNLOAD_DELAY) om servers niet te overbelasten. - Stel een duidelijke User-Agent in met contactgegevens.

- Scrape geen persoonlijke of beschermde data.

- Word je geblokkeerd of gevraagd te stoppen? Respecteer dat.

3. Omgaan met rate limits en CAPTCHAs

- Krijg je 429-fouten (“Too Many Requests”)? Vertraag of gebruik proxyrotatie.

- Ga geen CAPTCHAs forceren—als je er één krijgt, is het tijd om te stoppen.

Meer over ethiek en regelgeving? Zie .

Data organiseren en opslaan met Python

Na het scrapen wil je je data opschonen, transformeren en opslaan voor analyse. Zo pak ik dat aan:

1. Opschonen en transformeren met pandas

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. Exporteren naar CSV of Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. Opslaan in een database met SQLAlchemy

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)Zo bouw je eenvoudig een complete datapijplijn—van webspider tot dashboard.

Datapijplijnen automatiseren

Voor terugkerende taken kun je alles automatiseren:

- Cronjobs: Plan je Python-scripts dagelijks, elk uur, enz.

- Apache Airflow: Voor complexe workflows kun je met Airflow scraping, opschonen en rapportage orkestreren.

- Thunderbit Scheduling: Laat Thunderbit het scrapen plannen en trigger daarna je Python-script voor verdere verwerking.

Meer weten? Lees .

Problemen oplossen en je Python webspider optimaliseren

Zelfs de beste webspiders lopen soms vast. Mijn checklist voor veelvoorkomende issues:

- Geblokkeerde verzoeken (403/429): Wissel User-Agents, vertraag of gebruik proxies. Check robots.txt.

- Ontbrekende data: Controleer je selectors. De HTML kan veranderd zijn.

- Dynamische content: Gebruik Selenium of Thunderbit voor JavaScript-rijke sites.

- Performance: Gebruik async (aiohttp) of Scrapy’s gelijktijdigheid voor snelheid. Schrijf data tussentijds weg om geheugenproblemen te voorkomen.

- Debuggen: Print logs, gebruik browser devtools en check altijd je output op vreemde waarden.

Meer tips? Zie .

Samenvatting & belangrijkste punten

Een efficiënte Python webspider bouwen is een leerproces—maar het levert je enorm veel tijd en betere data op. Dit hebben we behandeld:

- Python is de beste keuze voor webspiders dankzij eenvoud, libraries en community.

- Zorg voor een goede basis met virtualenv en de juiste libraries (Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy).

- Kies het juiste gereedschap—simpele scripts voor kleine taken, Scrapy voor schaal, Selenium voor dynamische sites, Thunderbit voor no-code/AI-scraping.

- Schrijf nette, beleefde webspiders die robots.txt en sitevoorwaarden respecteren.

- Sla data op en verwerk het met pandas en SQLAlchemy, en automatiseer je pijplijn voor terugkerende taken.

- Combineer Python en Thunderbit voor maximale flexibiliteit—laat AI de lastige extractie doen, gebruik Python voor analyse en automatisering.

Klaar om je webscraping naar een hoger niveau te tillen? en ontdek hoe eenvoudig zelfs de lastigste sites te scrapen zijn. Meer leren? Bekijk de voor meer handleidingen, tips en praktijkvoorbeelden.

Veel succes met scrapen—en moge je webspiders altijd de data terugbrengen die je zoekt (en nooit vastlopen in een CAPTCHA-web).

Veelgestelde vragen

1. Waarom is Python de beste taal voor webspiders?

Python is makkelijk te leren, heeft een enorme bibliotheek (zoals Requests, BeautifulSoup, Scrapy) en een actieve community. Daardoor kun je snel webspiders bouwen, opschalen en onderhouden—van kleine tot grote projecten.

2. Wanneer kies ik voor Thunderbit in plaats van zelf een Python-webspider te schrijven?

Thunderbit is ideaal voor niet-programmeurs, dynamische of JavaScript-rijke sites, of als je snel data wilt zonder code te schrijven of te onderhouden. Voor maatwerk, grootschalige of diep geïntegreerde projecten blijft Python de beste keuze. Veel teams combineren beide: Thunderbit voor extractie, Python voor analyse.

3. Hoe zorg ik dat mijn webspider legaal en ethisch is?

Check altijd de robots.txt van een site, crawl beleefd (vertragingen, user-agent) en vermijd het scrapen van persoonlijke of beschermde data. Word je gevraagd te stoppen? Doe dat dan ook. Meer weten? Zie .

4. Wat is de beste manier om gescrapete data op te slaan en te verwerken?

Gebruik pandas om data op te schonen en te transformeren, exporteer naar CSV/Excel om te delen, en gebruik SQLAlchemy om data in databases (zoals SQLite of PostgreSQL) op te slaan voor grotere of terugkerende datasets.

5. Hoe automatiseer ik mijn webscraping-pijplijn?

Gebruik cronjobs of Apache Airflow om je Python-scripts te plannen. Thunderbit ondersteunt ook geplande scraping, wat je kunt combineren met Python voor een volledig geautomatiseerde datapijplijn.

Meer praktijkvoorbeelden? Bekijk en abonneer je op het voor tutorials en demo’s.