Het web staat bomvol data en in 2026 is de strijd om die digitale chaos om te zetten in bruikbare bedrijfsinformatie heftiger dan ooit. Ik heb van dichtbij gezien hoe sales-, e-commerce- en operationele teams hun hele manier van werken hebben omgegooid door saaie, tijdrovende copy-paste klusjes te automatiseren. Gebruik je nu nog geen webscraper, dan loop je niet alleen achter – je zit waarschijnlijk nog steeds vast in eindeloze spreadsheets, terwijl je concurrenten al relaxed aan hun tweede bakkie koffie zitten.

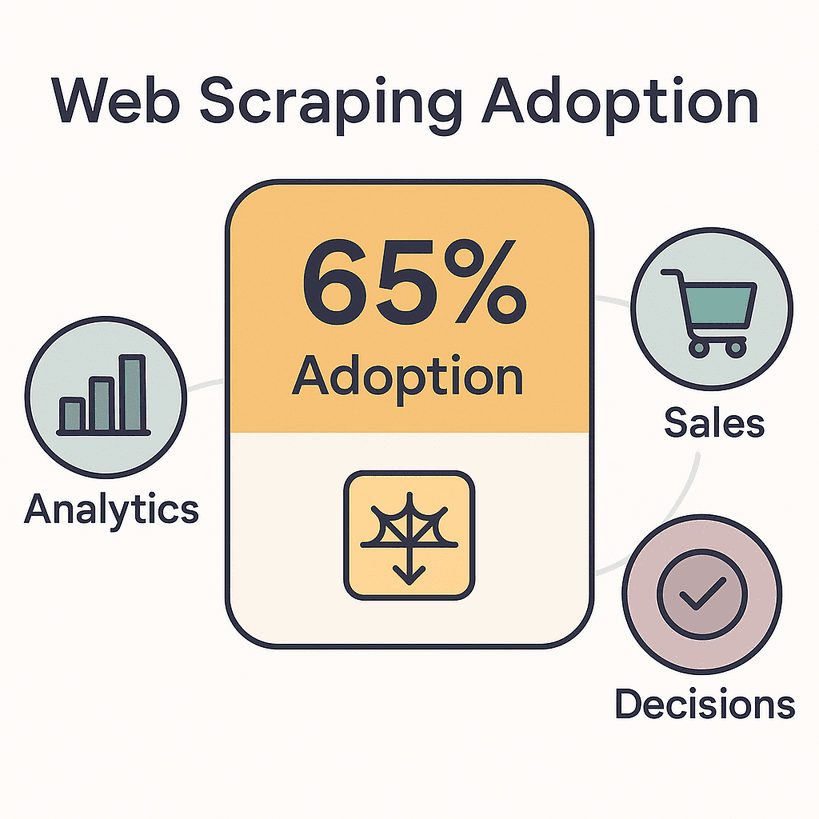

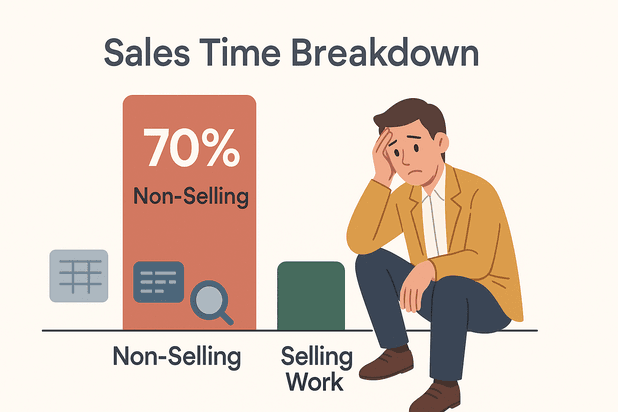

De cijfers liegen er niet om: om hun analyses, sales en beslissingen te voeden. De wereldwijde markt voor webdata-extractie is nu al , en die verdubbelt waarschijnlijk tegen 2030. Salesmedewerkers besteden tot wel aan taken die niks met verkopen te maken hebben, zoals data-invoer en research. Dat is zonde van de tijd – die kun je beter besteden aan deals sluiten of gewoon een lekkere lunchpauze nemen.

Wat is nu de beste webscraper voor 2026? Ik heb de vijf meest opvallende tools op een rij gezet die het verschil maken voor teams van elk formaat en elk technisch niveau. Of je nou geen regel code wilt aanraken of juist als developer maximale vrijheid zoekt – er zit sowieso iets voor je tussen.

Waar moet de beste webscraper aan voldoen?

Laten we eerlijk zijn: niet elke webscraper is hetzelfde. De beste webscraping software van 2026 blinkt uit doordat data snel, betrouwbaar en voor iedereen toegankelijk wordt – niet alleen voor mensen die in Python denken.

Hier let ik op (en zakelijke gebruikers trouwens ook):

- Gebruiksgemak: Kunnen niet-technische gebruikers binnen een paar minuten een scraping-taak opzetten? No-code en AI-interfaces zijn tegenwoordig onmisbaar.

- Flexibiliteit in databronnen: Kan de tool overweg met webpagina’s, PDF’s, afbeeldingen en dynamische content (zoals infinite scroll of AJAX)? Hoe meer bronnen, hoe beter.

- Automatisering & Planning: Kun je terugkerende scrapes inplannen, paginering aansturen en automatisch subpagina’s laten volgen? Automatisering maakt het verschil tussen “instellen en klaar” of “instellen en blijven controleren”.

- Integratie & Export: Kan de tool direct exporteren naar Excel, Google Sheets, Notion, Airtable of via een API? Hoe minder handmatig werk, hoe beter voor je team.

- Benodigde technische kennis: Is het echt no-code, of moet je toch nog met regex aan de slag? De beste tools zijn geschikt voor zowel beginners als gevorderden.

- Schaalbaarheid: Kan de software honderden of duizenden pagina’s aan zonder problemen?

- Support & Community: Is er goede documentatie, snelle support en een actieve gebruikersgroep?

Deze punten zijn niet zomaar leuk meegenomen – ze bepalen of een tool je uren werk bespaart of juist extra tijd kost. In 2026, nu , is de juiste webscraper een echt concurrentievoordeel.

Laten we nu de top vijf bekijken.

De 5 Beste Webscraping Software van 2026

- voor no-code, AI-gedreven scraping van meerdere bronnen

- voor enterprise-niveau, geïntegreerde datapijplijnen

- voor open-source flexibiliteit voor ontwikkelaars

- voor visuele, no-code scraping met planningsopties

- voor gebruiksvriendelijke, point-and-click data-extractie

1. Thunderbit: De makkelijkste AI-webscraper voor webdata

is mijn absolute aanrader voor iedereen die webdata wil verzamelen zonder te programmeren. En ja, ik ben een beetje bevooroordeeld – ik heb meegebouwd aan deze tool. Maar geloof me: Thunderbit is gemaakt voor zakelijke gebruikers die resultaat willen, geen hoofdpijn.

Waarom springt Thunderbit eruit?

- AI Suggest Fields: Klik op “AI Suggest Fields” en Thunderbit’s AI leest de pagina, stelt voor wat je kunt extraheren en zet de scraper voor je klaar. Geen selectors, geen sjablonen, geen gedoe.

- Meerdere databronnen: Haal niet alleen data van webpagina’s, maar ook uit PDF’s en afbeeldingen. Thunderbit kan tekst, links, e-mails, telefoonnummers en afbeeldingen extraheren – alles in twee klikken.

- Automatische subpagina’s & paginering: Wil je details van elke product- of profielpagina? Thunderbit volgt links, haalt extra info op en voegt het samen in je tabel. Ook infinite scroll en paginering worden moeiteloos verwerkt.

- Batch & geplande scraping: Plak een lijst met URL’s, plan terugkerende taken in en laat Thunderbit het zware werk doen – of het nu gaat om dagelijkse prijsupdates of wekelijkse leads.

- Direct exporteren: Exporteer direct naar Excel, Google Sheets, Airtable, Notion, CSV of JSON. Nooit meer eindeloos kopiëren en plakken.

- Aangepaste AI-prompts: Wil je data categoriseren, vertalen of labelen tijdens het scrapen? Voeg een eigen instructie toe en Thunderbit’s AI regelt het.

- Cloud- of browsermodus: Draai scrapes in de cloud (tot 50 pagina’s tegelijk) of lokaal voor sites waar je moet inloggen.

Thunderbit wordt vertrouwd door meer dan , van sales teams tot makelaars en kleine webshops. Met het gratis abonnement kun je tot 6 pagina’s scrapen (of 10 met een proefboost), en je betaalt alleen voor wat je gebruikt – één credit per resultaatregel.

Waarom ik fan ben: Thunderbit is de enige tool die ik ken waarmee een niet-technische gebruiker binnen vijf minuten van “ik heb deze data nodig” naar “hier is mijn spreadsheet” kan gaan. De interface is echt gebruiksvriendelijk (daar hebben we hard aan gewerkt) en de AI past zich aan als websites veranderen, zodat je niet steeds kapotte scrapers hoeft te repareren.

Ideaal voor: Sales, e-commerce, operations en iedereen die zonder code, met AI, data wil scrapen zonder onderhoud.

Bekijk de voor meer handleidingen.

2. Import.io: Enterprise webscraping en integratie

is de zwaargewicht voor grote bedrijven die webdata op schaal nodig hebben – en die data direct willen koppelen aan hun bedrijfsprocessen.

Wat maakt Import.io uniek?

- Enterprise-ready pipelines: Import.io is meer dan een webscraper; het is een compleet webdata-integratieplatform. Zie het als “data-as-a-service” met continue, geautomatiseerde feeds.

- Zelfherstellende AI: Als een website verandert, probeert de AI van Import.io automatisch de velden opnieuw te koppelen, zodat je pipelines niet ineens stoppen.

- Krachtige automatisering: Plan scrapes per uur, per dag of op maat. Ontvang meldingen als er iets misgaat of als de data afwijkt.

- Interactieve workflows: Werkt met sites met logins, formulieren of meerstapsnavigatie. Import.io kan complexe handelingen opnemen en herhalen.

- Compliance & governance: Automatische detectie en afscherming van persoonsgegevens, plus auditlogs – essentieel voor gereguleerde sectoren.

- API & integratie: Stuur data direct naar Google Sheets, Excel, Tableau, Power BI, databases of je eigen apps via API.

Import.io wordt gebruikt door merken als Unilever, Volvo en RedHat. Het is dé keuze voor bijvoorbeeld prijsmonitoring op duizenden webshops, marktanalyse of het voeden van AI/ML-modellen met actuele webdata.

Prijs: Import.io is een premium oplossing, vanaf ongeveer $299/maand voor self-service. Er is een gratis proefperiode, maar geen blijvend gratis abonnement. Als webdata cruciaal is, is de investering het waard.

Ideaal voor: Grote bedrijven en datagedreven organisaties die betrouwbaarheid, schaal, compliance en diepe integratie nodig hebben.

3. Scrapy: Open-source webscraping framework voor ontwikkelaars

is de open-source krachtpatser voor ontwikkelaars die maximale controle en flexibiliteit willen. Kun je (of je team) programmeren in Python, dan is Scrapy het Zwitsers zakmes onder de webscrapers.

Waarom ontwikkelaars Scrapy waarderen:

- Volledige aanpasbaarheid: Schrijf spiders (scripts) om data precies te crawlen, parseren en verwerken zoals jij wilt. Ondersteunt meerstapsflows, eigen logica en complexe datacleaning.

- Asynchroon & snel: Scrapy is gebouwd voor snelheid en schaal – scrape honderden pagina’s per minuut, of miljoenen met gedistribueerde crawlers.

- Uitbreidbaar: Groot ecosysteem van plugins en middleware voor proxies, headless browsers (Splash/Playwright) en integraties.

- Gratis & open source: Geen licentiekosten. Draai het op je eigen hardware of in de cloud, en schaal zo groot als je wilt.

- Community support: Meer dan 55.000 GitHub-sterren en een enorme gebruikersgroep. Als je vastloopt, is er altijd wel iemand met een oplossing.

Let op: Scrapy vereist Python-kennis en command-line ervaring. Er is geen point-and-click interface – dit is echt voor de codeerders. Maar voor maatwerkprojecten, AI-trainingsdata of grootschalige crawls is er niets beters.

Ideaal voor: Organisaties met eigen ontwikkelaars, maatwerkdatapijplijnen of grote, complexe scrapingbehoeften.

4. Octoparse: Visuele webscraping zonder code

is populair bij niet-programmeurs die krachtige scraping willen met een visuele, point-and-click interface.

Waarom Octoparse geliefd is:

- Visuele workflowbouwer: Klik op elementen in een ingebouwde browser en Octoparse herkent automatisch patronen. Geen code, gewoon klikken en extraheren.

- Dynamische content aan: Scrape AJAX, infinite scroll en sites met login. Simuleer klikken, scrollen en formulierinvoer.

- Cloudscraping & planning: Draai taken in de cloud (sneller, parallel) en plan terugkerende jobs voor altijd actuele data.

- Vooraf ingestelde sjablonen: Honderden sjablonen voor populaire sites (Amazon, Twitter, Zillow, enz.) zodat je direct kunt starten.

- Export & API: Download resultaten als CSV, Excel, JSON of haal data op via API. Koppel met Google Sheets of databases.

Octoparse wordt vaak omschreven als “super eenvoudig, zelfs voor beginners”. De gratis versie is beperkt, maar betaalde abonnementen (vanaf ca. $83/maand) bieden cloudruns, planning en meer snelheid.

Ideaal voor: Niet-technische gebruikers, marketeers, onderzoekers en kleine teams die regelmatig data willen verzamelen zonder te programmeren.

5. ParseHub: Gebruiksvriendelijke data-extractie voor dagelijks gebruik

is een andere no-code favoriet, vooral voor kleine bedrijven en freelancers die dagelijkse datataken willen automatiseren.

Wat maakt ParseHub sterk:

- Simpel point-and-click: Selecteer data door te klikken in een browserweergave. Bouw visuele workflows – geen code nodig.

- Dynamische sites & JS: Scrape pagina’s met veel JavaScript, infinite scroll en meerstapsnavigatie.

- Cloud & lokaal draaien: Draai scrapes op je desktop of in de cloud. Plan terugkerende taken en krijg API-toegang (bij hogere abonnementen).

- Exportopties: Download data als CSV, Excel of JSON. API-toegang voor automatisering.

- Cross-platform: Beschikbaar voor Windows, Mac en Linux.

Het gratis ParseHub-abonnement is beperkt (200 pagina’s per run), maar betaalde plannen (vanaf ca. $189/maand) bieden meer kracht, snelheid en API-toegang.

Ideaal voor: Kleine bedrijven, freelancers en teams met eenvoudige scrapingbehoeften die een betrouwbare, visuele tool zoeken.

Vergelijkingstabel: Beste webscraping software in één oogopslag

| Tool | Gebruiksgemak | Databronnen | Automatisering & Planning | Integratie & Export | Technische kennis | Prijs |

|---|---|---|---|---|---|---|

| Thunderbit | No-code, AI-gestuurd | Web, PDF, Afbeeldingen | Subpagina’s, paginering, gepland, batch | Excel, Sheets, Notion, Airtable, CSV, JSON | Geen | Freemium (per resultaat) |

| Import.io | Point-and-click UI | Web (statisch/dynamisch, login) | Zelfherstellend, gepland, meldingen | API, BI-tools, Sheets, Excel, DB | Laag–Middel | $299+/maand |

| Scrapy | Code vereist | Web, API’s, (JS via add-ons) | Volledige automatisering via code | Alles (via code) | Python devs | Gratis (open source) |

| Octoparse | Visueel, no-code | Web (dynamisch, login) | Cloudplanning, sjablonen | CSV, Excel, JSON, API | Geen | $83+/maand |

| ParseHub | Visueel, no-code | Web (JS, dynamisch) | Cloud/lokaal, gepland | CSV, Excel, JSON, API | Geen | $189+/maand |

Hoe kies je de beste webscraper voor jouw bedrijf?

Twijfel je welke tool het beste bij je past? Hier is mijn snelle advies:

- Niet-technische gebruikers, snel resultaat: Kies voor of . Thunderbit is onovertroffen voor directe, AI-gedreven scraping en ondersteuning van meerdere bronnen (web, PDF, afbeeldingen). Octoparse is ideaal voor visuele, geplande scrapes.

- Enterprise integratie, compliance en schaal: is de beste keuze. Gebouwd voor continue, betrouwbare datapijplijnen en diepe integratie.

- Ontwikkelaars, maatwerk of grootschalige crawls: is jouw tool. Je hebt Python-kennis nodig, maar krijgt maximale flexibiliteit.

- Kleine bedrijven, freelancers of dagelijkse taken: is een solide, gebruiksvriendelijke keuze voor point-and-click scraping en eenvoudige automatisering.

Tips voor het kiezen van de juiste tool:

- Stem de tool af op de technische vaardigheden en databehoeften van je team.

- Kijk naar de complexiteit van de sites die je wilt scrapen (dynamische content? logins?).

- Bedenk hoe je de data wilt gebruiken – heb je directe export naar Sheets nodig, of juist diepe API-integratie?

- Begin met een gratis proefperiode of freemium-abonnement om echte taken te testen.

- Onderschat het belang van goede support en documentatie niet.

Conclusie: Meer waarde uit je bedrijf met de beste webscraping software

Webdata is in 2026 de brandstof voor slimmere bedrijfsbeslissingen. De juiste webscraper bespaart je uren werk, vermindert fouten en geeft je team een voorsprong – of je nu leads verzamelt, concurrenten monitort of je analytics voedt.

Samengevat:

- Thunderbit is de makkelijkste, AI-gedreven no-code webscraper voor zakelijke gebruikers.

- Import.io is de enterprise-oplossing voor continue, geïntegreerde datapijplijnen.

- Scrapy is het open-source gereedschap voor ontwikkelaars die alles zelf willen bepalen.

- Octoparse en ParseHub maken visuele, no-code scraping toegankelijk voor iedereen.

De meeste tools bieden gratis proefperiodes of freemium-abonnementen – probeer ze gerust uit. Automatiseer het saaie werk, ontdek nieuwe inzichten en laat je team zich richten op wat echt belangrijk is.

Veel succes met scrapen – en moge je data altijd actueel, gestructureerd en klaar voor gebruik zijn.

Veelgestelde vragen

1. Waarvoor wordt webscraping software gebruikt?

Webscraping software automatiseert het verzamelen van informatie van websites, PDF’s en afbeeldingen. Het wordt gebruikt voor leadgeneratie, prijsmonitoring, marktonderzoek, contentaggregatie en meer.

2. Is webscraping legaal?

Webscraping is toegestaan als je openbare data verzamelt en de gebruiksvoorwaarden en privacyregels van websites respecteert. Controleer altijd het beleid van de site en ga zorgvuldig met data om.

3. Moet ik kunnen programmeren om webscraping software te gebruiken?

Niet per se! Tools als Thunderbit, Octoparse en ParseHub zijn speciaal voor niet-programmeurs. Voor complexere of maatwerkprojecten zijn ontwikkelaarstools als Scrapy soms nodig.

4. Hoe exporteer ik gescrapete data naar Excel of Google Sheets?

De meeste moderne webscrapers (Thunderbit, Octoparse, ParseHub) bieden één-klik export naar Excel, Google Sheets, CSV of zelfs directe integratie met Notion en Airtable.

5. Kan webscraping software omgaan met dynamische sites of logins?

Ja – top tools als Import.io, Octoparse en ParseHub kunnen dynamische content (AJAX, infinite scroll) en sites met login aan. Thunderbit ondersteunt ook scraping van dynamische pagina’s en subpagina’s.

Benieuwd hoe moderne webscraping eruitziet? of check de voor meer tips, tutorials en diepgaande uitleg over AI-gedreven data-extractie.