Het internet in 2025 is echt een wildernis—de helft van al het verkeer komt niet eens meer van mensen. Geloof het of niet, bots zijn inmiddels goed voor bijna , en anti-bot systemen worden steeds slimmer en strenger. Na jaren knutselen aan automatiseringstools en webscraping-workflows weet ik: één verkeerde move—zoals een verkeerde user agent gebruiken—en je dataproject ligt meteen op z’n gat. Voor sales-, e-commerce- en operationele teams is geblokkeerd worden door een website niet alleen irritant; het kan je ook leads, actuele prijzen of zelfs omzet kosten.

Gelukkig hoef je geen techneut te zijn om deze valkuilen te ontwijken. In deze gids leg ik uit waarom een slimme user agent-strategie onmisbaar is voor webscraping, hoe je de klassieke fouten voorkomt, en hoe user agent management zo makkelijk maakt dat je er niet eens meer over na hoeft te denken. Of je nu leads wilt verzamelen, producten wilt monitoren of je spreadsheets up-to-date wilt houden—dit is jouw cheat sheet om altijd een stapje voor te blijven.

Waarom de Juiste User Agent Zo’n Groot Verschil Maakt

Eerst even terug naar de basis: wat is een user agent? Zie het als het “pasje” van je browser. Elke keer dat je een website bezoekt—of je nou een mens of een bot bent—stuurt je browser een User-Agent string mee in de request headers. Daarmee zegt je browser bijvoorbeeld: “Hoi, ik ben Chrome op Windows,” of “Ik ben Safari op een iPhone” (). Een doorsnee Chrome user agent ziet er zo uit:

1Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36Websites gebruiken deze info vooral om twee redenen:

- Om de juiste content te tonen (zoals mobiele of desktopversie).

- Om bots en webscrapers te spotten.

Als je user agent iets zegt als “python-requests/2.28.1” of “Scrapy/2.9.0”, kun je net zo goed een bordje om je nek hangen met “Hoi, ik ben een bot!” Veel sites houden lijsten bij van deze herkenbare identifiers en gooien je er direct uit met een “403 Forbidden”. Gebruik je daarentegen een actuele browser user agent, dan val je veel minder op.

Kortom: je user agent is je vermomming. Hoe beter je je voordoet als een doorsnee gebruiker, hoe groter de kans dat je de data krijgt die je zoekt.

De Rol van User Agent bij Succesvol Webscrapen

Waarom is de keuze van je user agent zo doorslaggevend? Omdat het vaak de eerste barrière is van anti-bot systemen. Dit kan er misgaan als je het niet goed aanpakt:

- Directe blokkades (403/429 errors): Gebruik je de standaard user agent van een scraping library, dan kom je vaak niet eens op de homepage ().

- Lege of nepdata: Sommige sites laten lege of misleidende pagina’s zien aan verdachte user agents.

- CAPTCHAs of redirects: Een bot-achtige user agent triggert “Ben je een mens?”-controles of oneindige inloglussen.

- Throttling en bans: Als je te vaak met dezelfde user agent komt, word je vertraagd of zelfs geblokkeerd op IP-niveau.

Zo pakt het uit met verschillende user agents:

This paragraph contains content that cannot be parsed and has been skipped.

De moraal? Kies je vermomming slim. En vergeet niet—moderne anti-bot systemen kijken niet alleen naar je user agent. Ze checken ook of je andere headers (zoals Accept-Language of Referer) kloppen. Doe je je voor als Chrome, maar stuur je niet de juiste headers mee, dan val je alsnog door de mand ().

Hier komt Thunderbit om de hoek kijken. Ik spreek regelmatig zakelijke gebruikers—van sales tot e-commerce managers—die gewoon data willen, zonder zich te verdiepen in HTTP headers. Daarom zorgt Thunderbit ervoor dat user agent management volledig automatisch en onzichtbaar is.

Thunderbit: User Agent Management Zonder Gedoe

Met Thunderbit’s hoef je zelf geen user agent te kiezen. Onze AI kiest automatisch de meest realistische, actuele browser signature voor elke website. Of je nu de gebruikt (die letterlijk de echte Chrome user agent gebruikt) of cloud scraping inzet (waarbij onze AI steeds wisselt tussen actuele browser user agents), je valt altijd weg in het normale verkeer.

En het gaat verder dan alleen de user agent. Thunderbit stuurt een complete, kloppende set headers mee—zoals Accept-Language, Accept-Encoding en Client Hints—zodat je verzoeken exact lijken op die van een echte browser. Geen rare combinaties meer, geen “bot”-signalen.

Het mooiste? Je hoeft niks in te stellen. Thunderbit’s AI regelt alles achter de schermen, zodat jij je kunt focussen op wat telt: betrouwbare, hoogwaardige data verzamelen.

Waarom Dynamische User Agent Rotatie Onmisbaar Is

Stel, je hebt de perfecte user agent gevonden. Kun je die dan voor elke request gebruiken? Helaas niet. In 2025 is steeds dezelfde user agent gebruiken een dooddoener. Echte gebruikers hebben verschillende browsers, versies en apparaten. Als je webscraper 500 keer achter elkaar met dezelfde user agent komt, valt dat direct op.

Daarom is dynamische user agent rotatie tegenwoordig de standaard. Het idee: wissel bij elke request of sessie tussen een lijst van realistische, actuele user agents. Zo lijkt je webscraper op een diverse groep echte bezoekers, niet op één script ().

Thunderbit’s AI-gestuurde rotatie gaat nog verder. Bij het scrapen van meerdere pagina’s of geplande taken wisselt Thunderbit automatisch van user agent én proxy IP. Wordt een site achterdochtig, dan past Thunderbit zich direct aan—door user agents te wisselen, headers aan te passen of het tempo te verlagen. Alles gebeurt automatisch, zodat je webscraping onopgemerkt blijft en je data blijft binnenstromen.

User Agent en Request Headers: Consistentie is Key

Een tip van een ervaringsdeskundige: de user agent is maar één stukje van de “vingerafdruk” van je verzoek. Moderne anti-bot systemen checken of je user agent overeenkomt met andere headers zoals Accept-Language, Accept-Encoding en Referer. Doe je je voor als Chrome op Windows, maar stuur je een Franse Accept-Language vanaf een Nederlands IP, dan val je op ().

Best practice:

- Stuur altijd een volledige set headers die past bij je user agent.

- Zorg dat Accept-Language en Accept-Encoding overeenkomen met je user agent en (indien mogelijk) je IP-locatie.

- Gebruik de ontwikkelaarstools van je browser om echte verzoeken te inspecteren en kopieer de volledige header set voor je gekozen user agent.

Thunderbit regelt dit allemaal voor je. Onze AI zorgt ervoor dat elke request perfect klopt—user agent, headers en zelfs browser fingerprinting. Zo krijg je een menselijk profiel zonder zelf iets te hoeven doen.

Veelgemaakte Fouten: Wat Je Niet Moet Doen met User Agents

Ik heb veel webscraping-projecten zien stranden op dezelfde fouten. Dit zijn de grootste valkuilen:

- Standaard user agents van scraping libraries gebruiken: Strings als

python-requests/2.x,Scrapy/2.9.0ofJava/1.8worden direct geblokkeerd. - Verouderde browser versies: Je voordoen als Chrome 85 in 2025? Verdacht! Gebruik altijd actuele browser versies.

- Niet-matchende headers: Stuur geen Chrome user agent met ontbrekende of niet-passende Accept-Language, Accept-Encoding of Client Hints.

- Bekende crawler user agents: Alles met “bot”, “crawler”, “spider” of toolnamen (zoals AhrefsBot) valt direct op.

- Lege of onzin user agents: Soms toegestaan, maar meestal verdacht en onbetrouwbaar.

Snelle checklist voor veilige user agents:

- Gebruik echte, actuele browser user agents (Chrome, Firefox, Safari).

- Wissel tussen meerdere user agents.

- Houd headers consistent met je user agent.

- Werk je user agent-lijst maandelijks bij (browsers updaten snel).

- Vermijd alles wat op “automatisering” lijkt.

Thunderbit in de Praktijk: Voor Sales en Operations

Laten we het praktisch maken. Zo helpt Thunderbit’s user agent management echte teams:

| Toepassing | Vroeger: handmatig scrapen | Met Thunderbit | Resultaat |

|---|---|---|---|

| Sales leadgeneratie | Vaak geblokkeerd, missende data | AI kiest beste user agent, roteert, simuleert echt surfen | Meer leads, hogere kwaliteit, minder bounces |

| E-commerce monitoring | Script crasht, IP-bans | Cloud scraping met dynamische user agent & proxy rotatie | Betrouwbare prijs- en voorraadtracking |

| Vastgoedaanbod | Veel handwerk, blokkades | AI past user agent/headers aan, regelt subpagina’s automatisch | Complete, actuele woninglijsten |

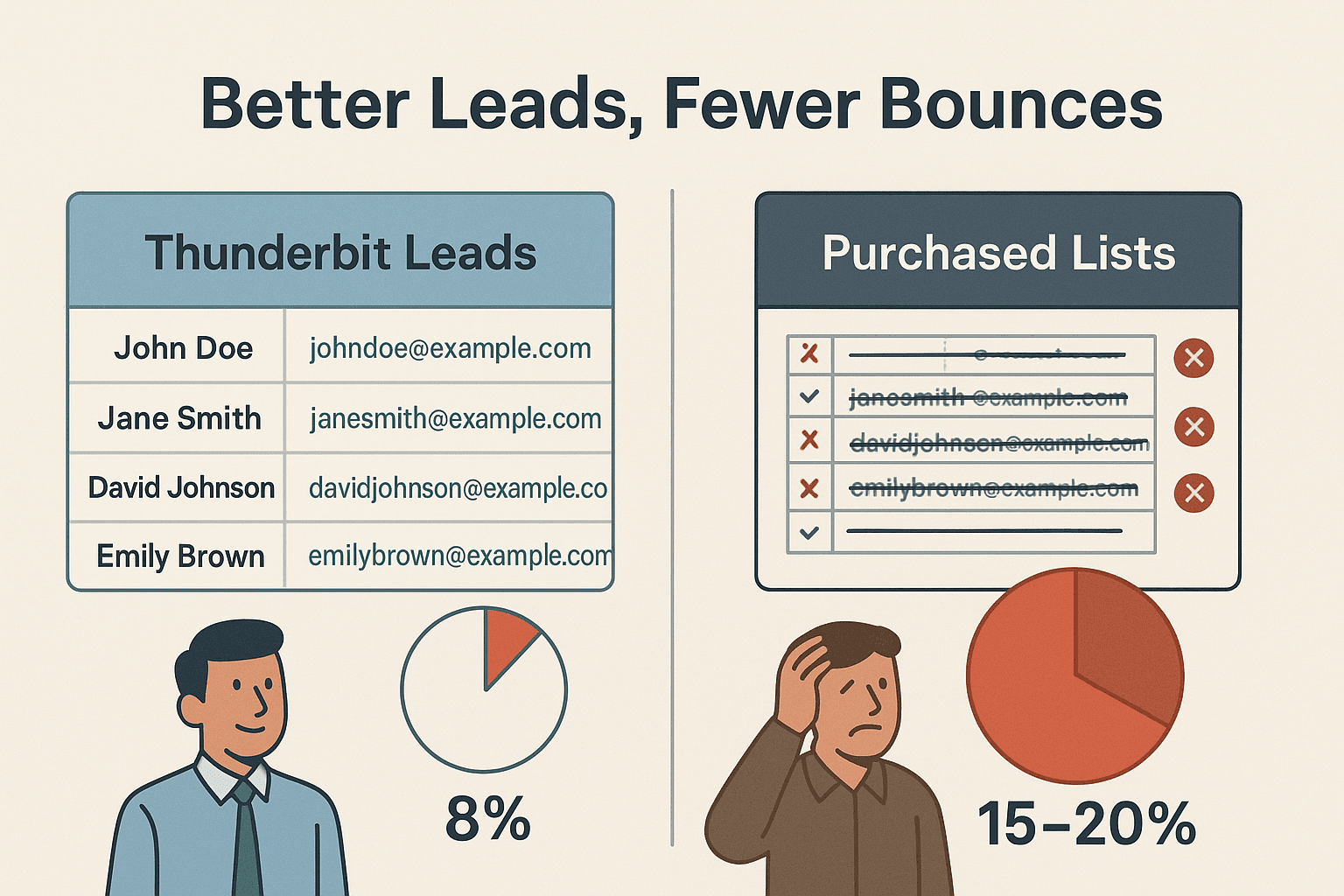

Een sales team dat Thunderbit gebruikte, scrape duizenden websites voor leads en had slechts ~8% e-mail bounce rate—tegenover 15–20% bij gekochte lijsten (). Dat is de kracht van actuele, mensachtige webscraping.

Stapsgewijs: Zo Scrape je met de Beste User Agent via Thunderbit

Zo makkelijk is starten met Thunderbit—je hoeft geen techneut te zijn:

- Installeer de .

- Ga naar de website die je wilt scrapen. Log in als dat nodig is—Thunderbit werkt ook op ingelogde pagina’s.

- Klik op “AI Suggest Fields.” Thunderbit’s AI scant de pagina en stelt de beste kolommen voor om te scrapen.

- Check en pas velden aan als je wilt. Hernoem, voeg toe of verwijder kolommen naar wens.

- Klik op “Scrapen.” Thunderbit haalt de data op, met automatische rotatie van user agents en headers.

- Exporteer je data. Stuur het direct naar Excel, Google Sheets, Airtable, Notion of download als CSV/JSON.

Je hoeft geen user agents te kiezen of bij te werken—Thunderbit’s AI regelt alles en past zich aan per website voor het beste resultaat.

Thunderbit versus Traditioneel User Agent Management

Hoe steekt Thunderbit af tegen de ouderwetse, handmatige aanpak?

| Functie/Taak | Handmatig scrapen | Thunderbit aanpak |

|---|---|---|

| User agent instellen | Zelf uitzoeken & in code zetten | Automatisch, AI-gestuurd per site |

| User agents up-to-date houden | Handmatig, snel vergeten | AI werkt automatisch bij met browsertrends |

| User agent rotatie | Zelf logica programmeren | Ingebouwd, slimme rotatie |

| Header consistentie | Handmatig headers matchen | AI zorgt voor volledige, consistente headers |

| Omgaan met blokkades/CAPTCHAs | Zelf wisselen, veel onderhoud | AI past aan, probeert opnieuw en roteert indien nodig |

| Technische kennis nodig | Veel (coderen, HTTP-kennis) | Geen—ontworpen voor zakelijke gebruikers |

| Tijd kwijt aan troubleshooting | Vaak, frustrerend | Minimaal—focus op data, niet op scrapingproblemen |

Thunderbit is gemaakt voor iedereen die betrouwbaar en schaalbaar wil webscrapen—zonder technische ballast.

Samenvatting: Zo Bouw Je een Toekomstbestendige User Agent Strategie

Dit zijn mijn belangrijkste lessen over user agent management in 2025:

- Gebruik nooit standaard of verouderde user agents. Ze zijn de nummer 1 reden dat webscrapers worden geblokkeerd.

- Wissel user agents dynamisch af. Variatie is je beste vriend—laat je webscraper niet opvallen als een robotparade.

- Houd headers consistent en realistisch. Je user agent is zo sterk als de rest van je request.

- Blijf up-to-date. Browser versies veranderen snel; je user agent-lijst dus ook.

- Laat AI het zware werk doen. Tools als Thunderbit nemen best practices automatisch over, zodat jij je kunt richten op resultaat.

Ben je het zat om geblokkeerd te worden, scripts te debuggen of wil je gewoon professioneel webscrapen zonder gedoe? . Onze AI-webscraper wordt wereldwijd door duizenden gebruikers vertrouwd en maakt webdata toegankelijk voor iedereen—zonder technische kopzorgen.

Meer tips, tutorials en diepgaande uitleg over webscraping vind je op de .

Veelgestelde Vragen

1. Wat is een user agent en waarom is het belangrijk voor webscraping?

Een user agent is een string die bij elk webverzoek wordt meegestuurd en je browser en besturingssysteem identificeert. Websites gebruiken dit om de juiste content te tonen en bots te herkennen. De juiste user agent helpt je webscraper onopvallend te blijven en blokkades te voorkomen.

2. Waarom moet ik niet de standaard user agent van mijn scraping library gebruiken?

Standaard user agents zoals python-requests/2.x zijn bekende botsignalen en worden vaak direct geblokkeerd. Gebruik altijd realistische, actuele browser user agents.

3. Hoe regelt Thunderbit user agent rotatie?

Thunderbit’s AI roteert automatisch door een pool van actuele, realistische browser user agents bij elke request of sessie. Zo lijkt je webscraping op echt, divers gebruikersverkeer.

4. Moet ik zelf headers als Accept-Language of Referer instellen bij Thunderbit?

Nee! Thunderbit’s AI zorgt ervoor dat alle headers consistent zijn en passen bij je user agent, zodat je verzoeken net als die van een echte browser zijn.

5. Wat als een site mijn verzoeken toch blokkeert?

Thunderbit herkent blokkades of CAPTCHAs en past zich direct aan—door user agents te wisselen, headers aan te passen of opnieuw te proberen. Zo krijg je betrouwbare data zonder handmatig te hoeven ingrijpen.

Klaar om slimmer te webscrapen? en laat onze AI het kat-en-muisspel met user agents voor je oplossen. Succes met webscrapen!

Meer weten?