Het internet is tegenwoordig dé grootste bron van data ter wereld—en laten we eerlijk zijn, iedereen wil het mooiste zandkasteel bouwen. Of je nu in sales, e-commerce, onderzoek werkt of gewoon een echte datanerd bent zoals ik, webscraping is het geheime ingrediënt voor slimmere keuzes en snellere workflows. In 2025 zijn het allang niet meer alleen de grote techreuzen die data verzamelen; , en geven aan dat datagedreven beslissingen essentieel zijn voor hun succes. Wat opvalt? Python is de drijvende kracht achter deze revolutie, vooral dankzij het enorme aanbod aan webscraping-bibliotheken en tools.

Na jaren in SaaS en automatisering heb ik gezien hoe de juiste Python webscrapingtool uren handmatig werk kan terugbrengen tot een klusje van twee minuten. Maar met zoveel opties—van klassieke libraries tot browserautomatisering, no-code platforms en zelfs AI-gedreven tools—hoe maak je de juiste keuze? In deze gids neem ik je mee langs de 12 beste Python webscraping-bibliotheken voor automatisering, van toegankelijke klassiekers tot innovatieve AI-oplossingen zoals . Of je nu developer bent, operationeel manager of gewoon snel data wilt verzamelen zonder gedoe, er zit sowieso iets voor je tussen.

Waarom de juiste Python webscrapingtool kiezen belangrijk is

Niet elk webscrapingproject is hetzelfde, dat weet je vast. De tool die je kiest, bepaalt of je soepel en geautomatiseerd aan de slag kunt, of dat je een week lang vastzit aan het debuggen van scripts. Ik heb een recruitmentbureau hun sales tien keer zien groeien in drie maanden door leads automatisch te scrapen—elke medewerker bespaarde 8 uur per week en er werden duizenden nieuwe leads gegenereerd (). Maar ik heb ook teams dagen zien verliezen omdat ze een library kozen die niet met dynamische content overweg kon of geblokkeerd werd door anti-botmaatregelen.

Daarom is je keuze zo belangrijk:

- Zakelijke impact: De juiste tool automatiseert leadgeneratie, prijsmonitoring, concurrentieanalyse en workflowautomatisering—en geeft je zo een flinke voorsprong in sales, e-commerce en onderzoek ().

- Statische vs. dynamische data: Sommige sites zijn simpele HTML, andere zijn een doolhof van JavaScript. Kan je tool geen dynamische content aan, dan mis je waardevolle data.

- Schaalbaarheid en betrouwbaarheid: Een paar pagina’s scrapen lukt met bijna alles. Maar wil je dagelijks duizenden pagina’s crawlen? Dan heb je een framework als Scrapy of een cloudoplossing nodig.

Pro tip: —bijvoorbeeld Beautiful Soup voor statische pagina’s en Selenium voor dynamische. De juiste mix is jouw geheime wapen.

Hoe we de beste Python webscraping-bibliotheken hebben beoordeeld

Met zoveel libraries en platforms heb ik vooral gekeken naar wat er echt toe doet voor zowel zakelijke als technische gebruikers:

- Gebruiksgemak: Kunnen niet-programmeurs ermee werken? Is de API logisch? Visuele/no-code opties krijgen extra punten.

- Automatisering & schaalbaarheid: Kan het meerdere pagina’s crawlen, plannen en grote datasets verwerken? Werkt het in de cloud of lokaal?

- Ondersteuning voor dynamische content: Kan het JavaScript-rijke sites, infinite scroll of content achter een login scrapen?

- Integratie & export: Hoe makkelijk krijg je data in Excel, Google Sheets, databases of je workflow?

- Community & onderhoud: Wordt het actief ontwikkeld? Zijn er veel tutorials en support?

- Kosten: Is het gratis, open-source of betaald? Wat is de waarde voor teams en bedrijven?

Ik heb deze tools zelf getest, gebruikersreviews gelezen en praktijkvoorbeelden bekeken. Hier zijn de top 12.

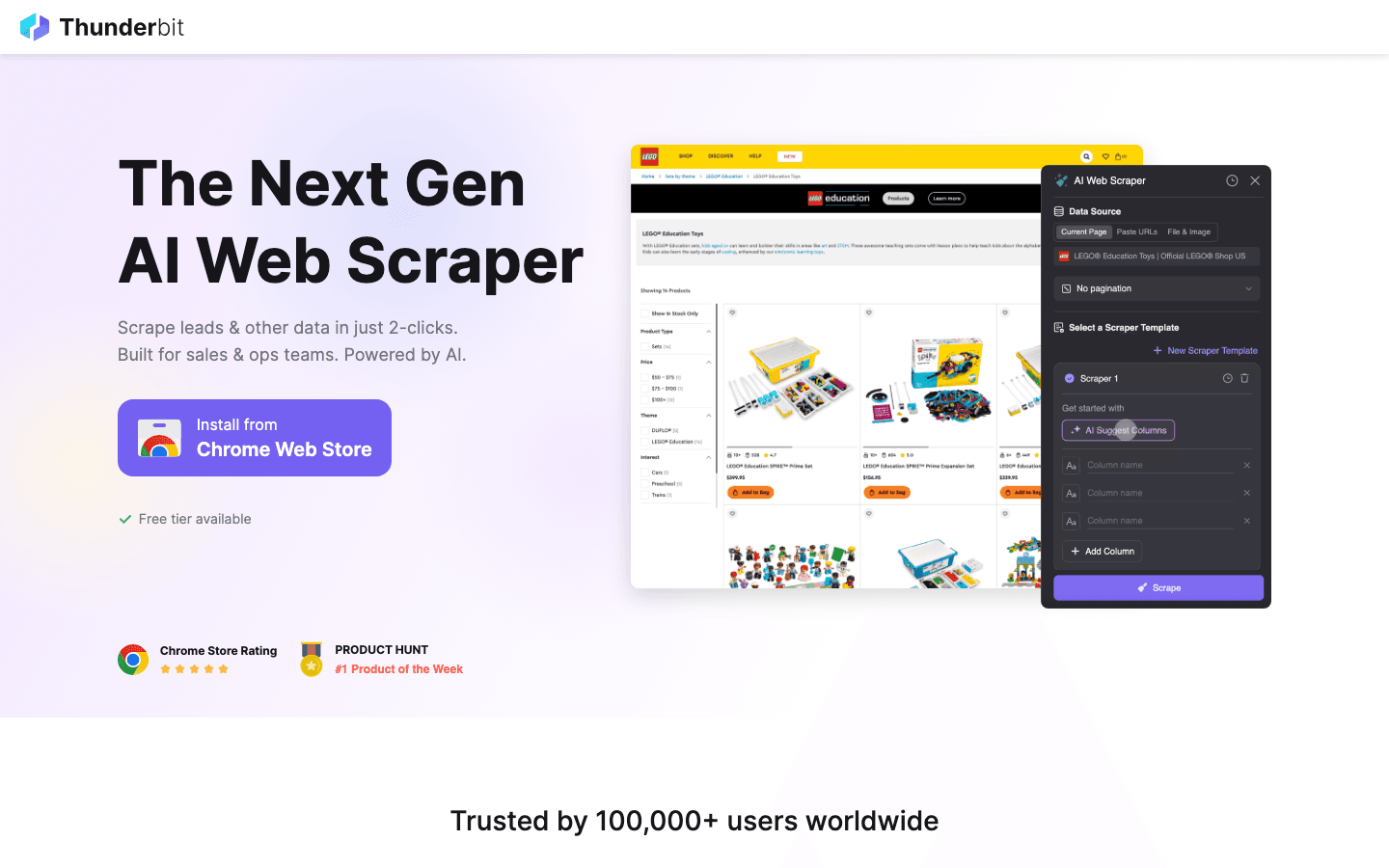

1. Thunderbit

is mijn absolute favoriet voor iedereen die zonder gedoe wil webscrapen. Het is een waarmee je met twee klikken data van elke website haalt—geen code, geen sjablonen, geen stress.

is mijn absolute favoriet voor iedereen die zonder gedoe wil webscrapen. Het is een waarmee je met twee klikken data van elke website haalt—geen code, geen sjablonen, geen stress.

Waarom ik fan ben: Thunderbit is gemaakt voor zakelijke gebruikers—sales, operations, e-commerce, vastgoed—die snel data willen zonder te rommelen met Python-scripts. Klik op “AI Suggest Fields”, laat de AI de pagina lezen en druk op “Scrape”. Thunderbit regelt subpagina’s, paginering, dynamische content en vult zelfs online formulieren voor je in. Je exporteert gratis naar Excel, Google Sheets, Airtable of Notion.

Opvallende functies:

- AI-gedreven veldsuggesties: Thunderbit’s AI leest de pagina en stelt voor wat je kunt extraheren—namen, prijzen, e-mails, noem maar op.

- Subpagina-scraping: Meer details nodig? Thunderbit bezoekt automatisch subpagina’s (zoals product- of contactpagina’s) en verrijkt je tabel.

- Directe sjablonen: Voor sites als Amazon, Zillow of Instagram kies je gewoon een sjabloon en ga je aan de slag.

- Cloud- of browserscraping: Scrape tot 50 pagina’s tegelijk in de cloud, of gebruik je browser voor sites waar je moet inloggen.

- Gratis data-export: Geen betaalmuur om je data te exporteren.

Ideaal voor: Niet-technische teams, sales, e-commerce en iedereen die snel resultaat wil—zonder te programmeren.

Beperkingen: Het is geen Python-library, dus als je direct in een Python-codebase wilt integreren, moet je de data exporteren en importeren. Maar voor 99% van de zakelijke scrapingbehoeften is het een uitkomst.

Wil je het in actie zien? Check de of ons .

2. Beautiful Soup

is de klassieke Python-library voor het parsen van HTML en XML. Het was mijn eerste webscrapingtool en blijft mijn aanrader voor beginners.

is de klassieke Python-library voor het parsen van HTML en XML. Het was mijn eerste webscrapingtool en blijft mijn aanrader voor beginners.

Waarom het top is: Simpel, vergevingsgezind en ideaal voor snelle projecten. Je haalt een pagina op met Requests, geeft de HTML aan Beautiful Soup en gebruikt de toegankelijke API om data te vinden en te extraheren. Zelfs rommelige HTML is geen probleem.

Ideaal voor: Kleine tot middelgrote projecten, datacleaning en iedereen die webscraping wil leren.

Beperkingen: Geen ingebouwde ondersteuning voor dynamische (JavaScript) content. Daarvoor moet je het combineren met Selenium of een andere browserautomatiseringstool.

3. Scrapy

is het krachtige Python-framework voor grootschalig, geautomatiseerd webcrawlen. Wil je duizenden (of miljoenen) pagina’s scrapen, datastromen bouwen of geplande taken uitvoeren, dan is Scrapy je beste vriend.

is het krachtige Python-framework voor grootschalig, geautomatiseerd webcrawlen. Wil je duizenden (of miljoenen) pagina’s scrapen, datastromen bouwen of geplande taken uitvoeren, dan is Scrapy je beste vriend.

Waarom het krachtig is: Scrapy is asynchroon, snel en gemaakt voor schaal. Je definieert “spiders” die sites crawlen, links volgen, paginering afhandelen en data verwerken via pipelines. Het is de ruggengraat van veel enterprise scrapingprojecten.

Ideaal voor: Ontwikkelaars die robuuste, schaalbare crawlers bouwen; multi-page of multi-site scraping; productie-datapijplijnen.

Beperkingen: Steilere leercurve dan Beautiful Soup. Standaard geen JavaScript-ondersteuning, maar je kunt integreren met Splash of Selenium voor dynamische sites.

4. Selenium

is de browserautomatiseringstool waarmee je Chrome, Firefox en andere browsers vanuit Python aanstuurt. Onmisbaar voor het scrapen van dynamische, JavaScript-rijke sites of het automatiseren van complexe webinteracties.

is de browserautomatiseringstool waarmee je Chrome, Firefox en andere browsers vanuit Python aanstuurt. Onmisbaar voor het scrapen van dynamische, JavaScript-rijke sites of het automatiseren van complexe webinteracties.

Waarom het essentieel is: Selenium kan gebruikersacties simuleren—klikken, formulieren invullen, scrollen—en alles scrapen wat in de browser verschijnt, net als een mens.

Ideaal voor: Dynamische sites, scrapen na inloggen, infinite scroll of als je met de pagina moet interacteren.

Beperkingen: Langzamer en zwaarder dan pure HTTP-libraries. Niet ideaal voor duizenden pagina’s tenzij je krachtige hardware hebt.

5. Requests

is de “HTTP for Humans”-library. Het vormt de basis van de meeste Python-scrapingscripts—pagina’s ophalen, formulieren versturen en cookies beheren.

is de “HTTP for Humans”-library. Het vormt de basis van de meeste Python-scrapingscripts—pagina’s ophalen, formulieren versturen en cookies beheren.

Waarom het onmisbaar is: Simpele API, betrouwbaar en werkt perfect samen met Beautiful Soup of lxml. Ideaal voor statische sites en API’s.

Ideaal voor: Statische HTML ophalen, API’s aanroepen of als basis voor een eigen scraper.

Beperkingen: Kan geen JavaScript-rendered content aan. Voor dynamische sites moet je combineren met Selenium of iets vergelijkbaars.

6. LXML

is de razendsnelle HTML- en XML-parser voor Python. Ondersteunt krachtige XPath- en CSS-selectors.

is de razendsnelle HTML- en XML-parser voor Python. Ondersteunt krachtige XPath- en CSS-selectors.

Waarom het favoriet is: Als je grote pagina’s moet scrapen of geavanceerde queries wilt uitvoeren, is lxml je tool. Scrapy gebruikt het zelfs onder de motorkap.

Ideaal voor: Prestaties, grote datasets of als je XPath wilt gebruiken voor complexe extracties.

Beperkingen: Iets steilere leercurve en installatie kan lastig zijn op sommige systemen.

7. PySpider

is een Python-scrapingframework met een webgebaseerde interface. Het lijkt op Scrapy, maar dan met een dashboard om je scrapingjobs te beheren, plannen en monitoren.

is een Python-scrapingframework met een webgebaseerde interface. Het lijkt op Scrapy, maar dan met een dashboard om je scrapingjobs te beheren, plannen en monitoren.

Waarom het uniek is: Je schrijft spiders in Python, plant ze in en bekijkt de resultaten—allemaal vanuit je browser. Ideaal voor teams die overzicht en automatisering willen.

Ideaal voor: Teams met meerdere scrapingprojecten, geplande crawls of wie een visuele interface wil.

Beperkingen: Minder actief onderhouden dan Scrapy en beperkte ondersteuning voor moderne JavaScript-sites.

8. MechanicalSoup

is een lichte Python-library voor het automatiseren van eenvoudige browsertaken—zoals formulieren invullen en links volgen—zonder de overhead van Selenium.

is een lichte Python-library voor het automatiseren van eenvoudige browsertaken—zoals formulieren invullen en links volgen—zonder de overhead van Selenium.

Waarom het handig is: Combineert Requests en Beautiful Soup, waardoor je makkelijk kunt inloggen, formulieren versturen en de resulterende pagina’s scrapen.

Ideaal voor: Logins automatiseren, formulieren invullen of simpele webworkflows zonder JavaScript.

Beperkingen: Kan niet overweg met JavaScript-rijke sites of complexe interacties.

9. Octoparse

is een no-code webscrapingtool met een drag-and-drop interface. Perfect voor zakelijke gebruikers die data willen scrapen zonder te programmeren.

is een no-code webscrapingtool met een drag-and-drop interface. Perfect voor zakelijke gebruikers die data willen scrapen zonder te programmeren.

Waarom het populair is: Octoparse kan paginering, dynamische content en zelfs geplande cloud-scrapes aan. Er zijn sjablonen voor veelgebruikte sites en je exporteert data naar Excel, CSV of Google Sheets.

Ideaal voor: Niet-programmeurs, marktonderzoek, leadgeneratie en teams die snel resultaat willen.

Beperkingen: Gratis versie is beperkt; geavanceerde functies vereisen een betaald abonnement (vanaf ca. $75/maand).

10. ParseHub

is een andere visuele scrapingtool waarmee je complexe workflows bouwt door simpelweg door de site te klikken. Ideaal voor dynamische sites, conditionele logica en geplande cloudtaken.

is een andere visuele scrapingtool waarmee je complexe workflows bouwt door simpelweg door de site te klikken. Ideaal voor dynamische sites, conditionele logica en geplande cloudtaken.

Waarom het opvalt: ParseHub’s conditionele logica en meerstapsworkflows zijn perfect voor lastige sites met pop-ups, tabbladen of verborgen data.

Ideaal voor: Niet-programmeurs die complexe, dynamische websites willen scrapen; geplande dataverzameling.

Beperkingen: Gratis plan heeft limieten; betaalde plannen kunnen prijzig zijn bij veelvuldig gebruik.

11. Colly

is een razendsnel webscrapingframework—geschreven in Go, niet in Python, maar het vermelden waard vanwege de prestaties. Sommige Python-teams gebruiken Colly als microservice voor zware crawls en verwerken de data vervolgens in Python.

is een razendsnel webscrapingframework—geschreven in Go, niet in Python, maar het vermelden waard vanwege de prestaties. Sommige Python-teams gebruiken Colly als microservice voor zware crawls en verwerken de data vervolgens in Python.

Waarom het bijzonder is: Colly kan duizenden pagina’s per seconde ophalen met minimaal geheugenverbruik. Voor scraping op grote schaal is het een uitstekende cross-platform optie.

Ideaal voor: Engineeringteams die snelheid en gelijktijdigheid nodig hebben; Go-crawlers integreren in Python-workflows.

Beperkingen: Vereist kennis van Go; geen directe Python-library.

12. Portia

is een open-source visuele scraper van Scrapinghub (nu Zyte). Hiermee bouw je Scrapy-spiders door elementen in je browser aan te klikken—geen code nodig.

is een open-source visuele scraper van Scrapinghub (nu Zyte). Hiermee bouw je Scrapy-spiders door elementen in je browser aan te klikken—geen code nodig.

Waarom het handig is: Portia overbrugt de kloof tussen niet-programmeurs en de kracht van Scrapy. Je definieert extractieregels visueel en draait de spider vervolgens in Scrapy of op Zyte’s cloud.

Ideaal voor: Niet-programmeurs in datateams of iedereen die een Scrapy-spider visueel wil prototypen.

Beperkingen: Minder actief onderhouden en heeft moeite met zeer dynamische of interactieve sites.

Vergelijkingstabel: Beste Python webscraping-bibliotheken in één oogopslag

| Tool/Library | Gebruiksgemak | Dynamische Content | Automatisering & Schaal | Ideaal Voor | Prijs |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | ★★★★☆ | ★★★★☆ | Niet-programmeurs, zakelijke gebruikers, snel resultaat | Gratis + credits |

| Beautiful Soup | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | Beginners, statische pagina’s, datacleaning | Gratis |

| Scrapy | ★★★☆☆ | ★★★☆☆ | ★★★★★ | Ontwikkelaars, grootschalige crawls | Gratis |

| Selenium | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | Dynamische sites, browserautomatisering | Gratis |

| Requests | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | Statische HTML, API’s, snelle scripts | Gratis |

| LXML | ★★★☆☆ | ★☆☆☆☆ | ★★★★☆ | Prestaties, grote datasets, XPath | Gratis |

| PySpider | ★★★★☆ | ★★★☆☆ | ★★★★★ | Teams, geplande crawls, webinterface | Gratis |

| MechanicalSoup | ★★★★☆ | ★☆☆☆☆ | ★★☆☆☆ | Formulieren automatiseren, logins, simpele workflows | Gratis |

| Octoparse | ★★★★★ | ★★★★☆ | ★★★★☆ | No-code, zakelijke gebruikers, geplande scrapes | Gratis + betaald |

| ParseHub | ★★★★★ | ★★★★☆ | ★★★★☆ | No-code, complexe/dynamische sites | Gratis + betaald |

| Colly | ★★☆☆☆ | ★☆☆☆☆ | ★★★★★ | Hoge snelheid, cross-platform, Go-integratie | Gratis |

| Portia | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | Visuele Scrapy-spiders, niet-programmeurs | Gratis |

De juiste Python webscrapingtool kiezen voor jouw bedrijf

Welke tool past nu het beste bij jou? Hier een kort overzicht:

- Niet-programmeurs of zakelijke gebruikers: Start met , of . Ze zijn snel, visueel en je hebt geen programmeerkennis nodig.

- Ontwikkelaars, grootschalige projecten: Ga voor of als je robuuste, herhaalbare crawlers wilt bouwen.

- Dynamische/JavaScript-rijke sites: Gebruik of een visuele tool met browserautomatisering.

- Snel statische pagina’s scrapen: + blijft de snelste manier om te starten.

- Prestatiekritisch of cross-platform: Overweeg voor Go-microservices, of combineer het met Python voor het beste van beide werelden.

- Visueel prototypen voor Scrapy: is een mooie brug tussen niet-programmeurs en ontwikkelaars.

Mijn tip: Begin met de eenvoudigste tool die aan je eisen voldoet. Twijfel je? Probeer voor een vliegende start, of zet een Scrapy-project op als je voor schaal gaat.

En onthoud: de beste tool is degene die je de data oplevert die je nodig hebt—betrouwbaar, efficiënt en zonder frustratie.

Veelgestelde vragen

1. Waarom is Python zo populair voor webscraping?

Python is dé taal voor webscraping dankzij de makkelijke syntax, het enorme aanbod aan libraries en de actieve community. ), waardoor het de standaard is voor zowel beginners als professionals.

2. Wat is de beste Python-library voor het scrapen van dynamische (JavaScript) websites?

Voor dynamische sites is de klassieke keuze, omdat het een echte browser aanstuurt. Voor no-code oplossingen kunnen , en ook goed overweg met JavaScript-rijke pagina’s.

3. Hoe kies ik tussen Scrapy en Beautiful Soup?

Gebruik voor snelle, eenvoudige projecten of als je net begint. Kies voor grote, geautomatiseerde crawls, multi-page projecten of als je robuuste pipelines en planning nodig hebt.

4. Kan ik Thunderbit integreren in mijn Python-workflow?

Zeker. laat je data exporteren naar CSV, Excel of Google Sheets, die je vervolgens in je Python-scripts kunt importeren voor analyse of verdere verwerking.

5. Wat is de makkelijkste manier om te starten met webscraping als ik geen ontwikkelaar ben?

Probeer , of . Met deze tools kun je visueel data scrapen—geen code nodig. Voor meer tips en uitleg, check de .

Veel succes met scrapen—en moge je data altijd schoon, gestructureerd en binnen handbereik zijn.

Meer weten?