De wereld van webscraping in 2026 doet denken aan een bruisende markt in de vroege ochtend: iedereen is op jacht naar de meest verse data, en de beste tools zorgen ervoor dat je razendsnel je slag slaat voordat het echt druk wordt. Steeds meer bedrijven vertrouwen op data die via webscraping is verzameld, voor alles van het vinden van nieuwe klanten tot het analyseren van de concurrentie. De keuze voor de juiste Python-bibliotheek voor webscraping is dus niet alleen een technische, maar vooral een slimme, strategische zet. En laten we eerlijk zijn: met zoveel opties (en nog meer ‘ultieme gidsen’) lijkt het soms alsof je een universitaire scriptie moet schrijven om je ideale toolkit samen te stellen.

Na jaren ervaring in SaaS en automatisering heb ik gezien hoe de juiste Python webscraping tools een klus van een week kunnen terugbrengen tot een ochtendje werk. Of je nu een developer bent die stevige pipelines bouwt, of een zakelijke gebruiker die gewoon schone data in een spreadsheet wil, deze lijst zet de 12 beste Python-bibliotheken voor webscraping in 2026 voor je op een rij—plus één AI-oplossing die het hele speelveld verandert voor zowel niet-programmeurs als professionals.

Waarom het kiezen van de juiste Python webscraping-bibliotheek zo belangrijk is

Webscraping draait niet alleen om data verzamelen—het gaat om de juiste data, op het juiste moment, zonder dat je er gek van wordt. In 2026 gebruikt meer dan in de VS geautomatiseerde webscraping voor sales, marktonderzoek en operationele processen. Elke dag worden er gecrawld. De inzet is hoog: de verkeerde tool betekent gemiste kansen, kapotte scripts of urenlang debuggen.

Waar moet je op letten bij het kiezen van je Python webscraping tools?

- Prestaties: Kan de tool grote hoeveelheden data aan zonder vast te lopen?

- Gebruiksgemak: Ben je meer tijd kwijt aan coderen of aan resultaten?

- Browser- & JavaScript-ondersteuning: Werkt het met moderne, dynamische websites?

- Schaalbaarheid: Kan het meegroeien met jouw behoeften?

- Integratie: Hoe makkelijk past het in je datastroom of bedrijfsproces?

Typische zakelijke toepassingen? Denk aan leadgeneratie, prijsmonitoring, concurrentieanalyse en het automatiseren van saaie data-entry klussen. De juiste bibliotheek maakt het verschil tussen een sales team dat altijd voorop loopt en een team dat vastzit in eindeloze spreadsheets.

Hoe we de beste Python-bibliotheken voor webscraping hebben beoordeeld

Voor deze lijst heb ik gekeken naar:

- Prestaties & schaalbaarheid: Hoe goed werkt het bij grote en complexe websites?

- Gebruiksgemak: Is het geschikt voor beginners, of heb je een Python-expert nodig?

- Browser- & JavaScript-ondersteuning: Kan het omgaan met dynamische content en moderne webapps?

- Veiligheid & onderhoud: Wordt de tool actief onderhouden en is het veilig in gebruik?

- Community & support: Zijn er documentatie, tutorials en een actieve community?

- Integratiemogelijkheden: Kun je het combineren met andere tools (of AI-oplossingen zoals Thunderbit) voor extra kracht?

Ook heb ik gekeken naar echte zakelijke behoeften—want uiteindelijk is je code maar zo goed als de data die het oplevert.

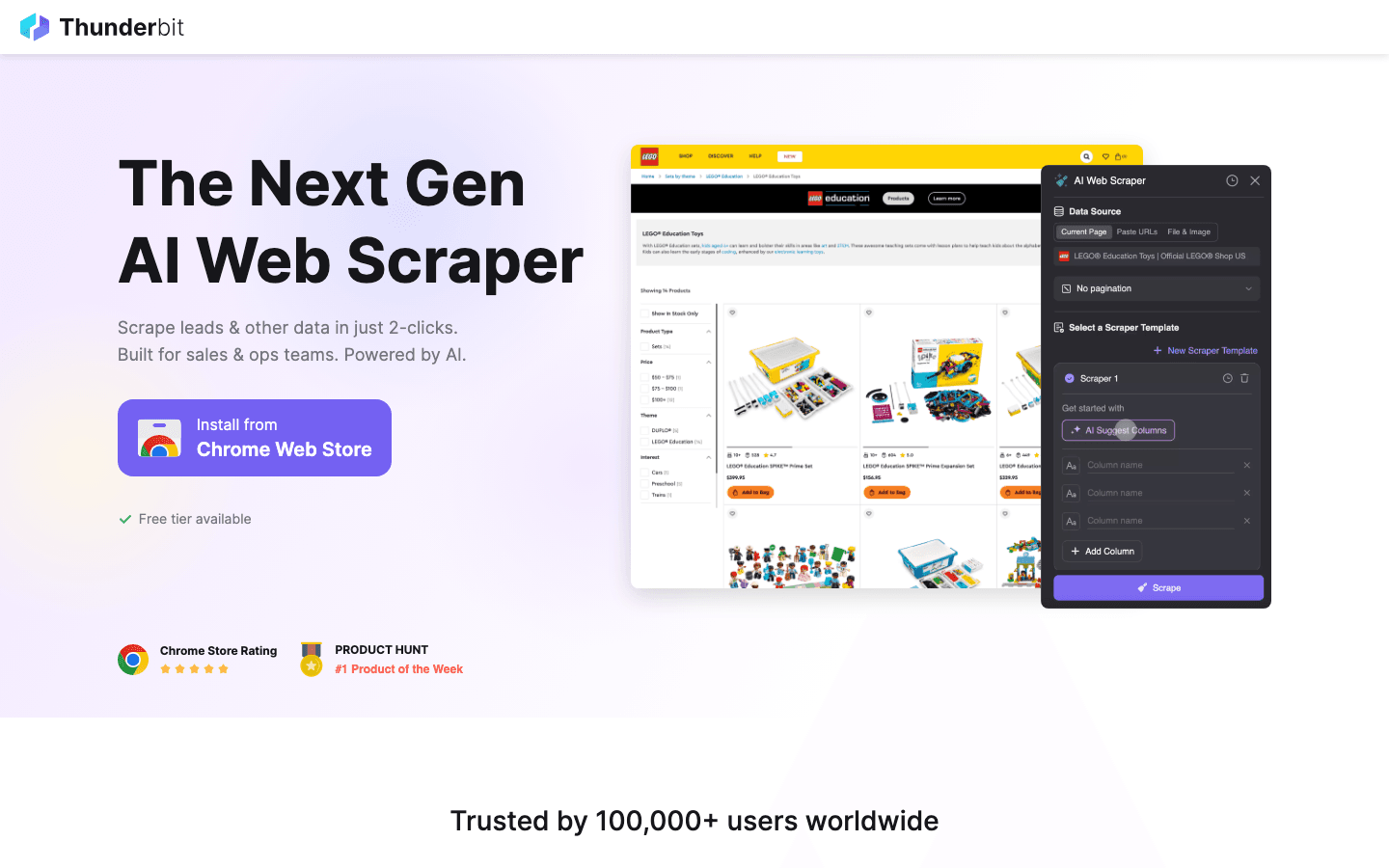

1. Thunderbit

is geen klassieke Python-bibliotheek, maar een die in 2026 de manier waarop bedrijven en ontwikkelaars webscraping aanpakken, compleet op z’n kop zet. Daarom verdient het absoluut een plek in deze lijst.

is geen klassieke Python-bibliotheek, maar een die in 2026 de manier waarop bedrijven en ontwikkelaars webscraping aanpakken, compleet op z’n kop zet. Daarom verdient het absoluut een plek in deze lijst.

Belangrijkste functies:

- AI-veldherkenning: Beschrijf wat je zoekt en Thunderbit’s AI bepaalt automatisch de kolommen en datatypes.

- Subpagina scraping: Bezoekt en haalt automatisch data op van subpagina’s (zoals productdetails of LinkedIn-profielen).

- Directe sjablonen: Met één klik scrapen van populaire sites (Amazon, Zillow, Shopify, enz.).

- Gratis data-export: Exporteer naar Excel, Google Sheets, Airtable, Notion, CSV of JSON—zonder extra kosten.

- No-code workflow: Ideaal voor niet-technische gebruikers, maar ook te integreren met Python-tools voor geavanceerde workflows.

Beste toepassingen: Leadgeneratie, prijsmonitoring in e-commerce, vastgoedaanbod, operationele data—overal waar je snel gestructureerde data nodig hebt.

Voordelen:

- Geen code nodig—wijs aan, klik en beschrijf

- AI past zich aan veranderende websites aan

- Kan moeiteloos rommelige, ongestructureerde webdata verwerken

- Combineerbaar met Python-bibliotheken (zoals Scrapy of Beautiful Soup) voor hybride workflows

Nadelen:

- Geen pure Python-bibliotheek (maar werkt goed samen met Python)

- Vooral geschikt voor zakelijke gebruikers of als aanvulling op code-based scraping

Tip: Gebruik Thunderbit om snel webscrapers te prototypen of om lastige, eenmalige klussen te klaren. Voor grootschalige automatisering kun je de gestructureerde data van Thunderbit exporteren en verder verwerken in je Python-scripts.

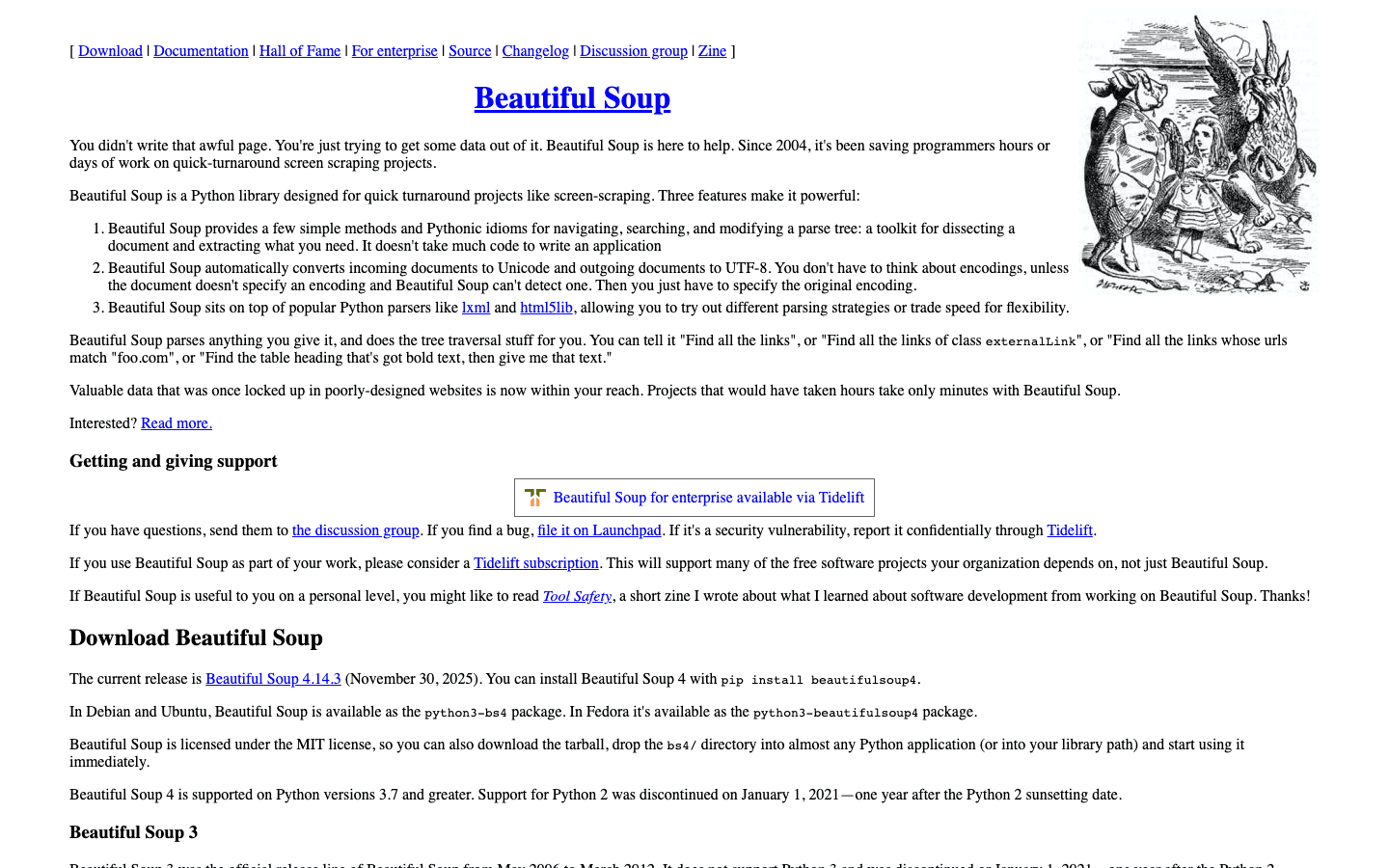

2. Beautiful Soup

is dé Python-bibliotheek voor het parsen en navigeren van HTML of XML. Iedereen die ooit een rommelige webpagina heeft moeten opschonen, weet waarom deze tool zo geliefd is bij zowel beginners als gevorderden.

is dé Python-bibliotheek voor het parsen en navigeren van HTML of XML. Iedereen die ooit een rommelige webpagina heeft moeten opschonen, weet waarom deze tool zo geliefd is bij zowel beginners als gevorderden.

Belangrijkste functies:

- Intuïtieve syntax voor zoeken, navigeren en aanpassen van HTML/XML

- Kan slecht opgemaakte of gebroken markup goed verwerken

- Werkt naadloos samen met om pagina’s op te halen

Beste toepassingen: Snel en eenvoudig scrapen, data opschonen, kleine tot middelgrote pagina’s parsen.

Voordelen:

- Zeer eenvoudig te leren

- Ideaal voor het opschonen van rommelige HTML

- Flexibel en vergevingsgezind

Nadelen:

- Langzamer dan bij grote documenten

- Geen ingebouwde JavaScript-ondersteuning

Tip: Voor snelheid kun je Beautiful Soup combineren met de lxml parser. Voor complexere, dynamische sites kun je het koppelen aan Selenium of Pyppeteer.

3. Selenium

is de kampioen als het gaat om browserautomatisering. Het kan Chrome, Firefox, Edge en meer aansturen—perfect voor het scrapen van dynamische, JavaScript-rijke websites.

is de kampioen als het gaat om browserautomatisering. Het kan Chrome, Firefox, Edge en meer aansturen—perfect voor het scrapen van dynamische, JavaScript-rijke websites.

Belangrijkste functies:

- Automatiseert echte browsers (Chrome, Firefox, enz.)

- Ondersteunt headless-modus voor snellere, GUI-loze werking

- Kan formulieren invullen, knoppen aanklikken en gebruikersacties simuleren

Beste toepassingen: Scrapen van sites die inloggen, klikken of veel JavaScript vereisen.

Voordelen:

- Kan vrijwel elke website aan, hoe dynamisch ook

- Ondersteunt meerdere browsers en platforms

- Ideaal voor testen en scrapen in één tool

Nadelen:

- Langzamer dan headless-only oplossingen

- Vraagt meer van je systeem

- Scripts kunnen breken als de site-indeling verandert

Tip: Gebruik Selenium voor sites waar andere tools falen, maar voor snelheid en schaalbaarheid zijn Scrapy of Pyppeteer vaak beter.

4. Requests

is dé HTTP-bibliotheek voor Python. Het vormt de ruggengraat van veel scraping-workflows en maakt het eenvoudig om GET/POST-verzoeken te doen en antwoorden te verwerken.

is dé HTTP-bibliotheek voor Python. Het vormt de ruggengraat van veel scraping-workflows en maakt het eenvoudig om GET/POST-verzoeken te doen en antwoorden te verwerken.

Belangrijkste functies:

- Duidelijke, Pythonic API voor HTTP-verzoeken

- Ondersteunt cookies, sessies en authenticatie

- Werkt goed samen met parsers als Beautiful Soup en LXML

Beste toepassingen: Ophalen van statische pagina’s, API’s, of als bouwsteen voor eigen scrapers.

Voordelen:

- Zeer gebruiksvriendelijk

- Betrouwbaar en goed onderhouden

- Perfect voor snelle scripts en prototyping

Nadelen:

- Geen ingebouwde HTML-parser

- Kan geen JavaScript-rendered content aan

Tip: Combineer Requests met Beautiful Soup of LXML voor een klassieke, lichte scraping-stack.

5. LXML

is de snelheidsduivel onder de Python HTML/XML-parsers. Moet je grote documenten verwerken of complexe XPath-queries uitvoeren? Dan is LXML je beste vriend.

is de snelheidsduivel onder de Python HTML/XML-parsers. Moet je grote documenten verwerken of complexe XPath-queries uitvoeren? Dan is LXML je beste vriend.

Belangrijkste functies:

- Razendsnelle parsing dankzij C-backend

- Volledige ondersteuning voor XPath en CSS-selectors

- Geschikt voor zowel HTML als XML

Beste toepassingen: Grootschalig parsen, complexe documentstructuren, projecten waar snelheid telt.

Voordelen:

- Veel sneller dan Beautiful Soup bij grote klussen

- Krachtige selector-ondersteuning

- Robuuste foutafhandeling

Nadelen:

- Minder vergevingsgezind bij gebroken HTML

- Iets steilere leercurve

Tip: Gebruik LXML als parser voor Beautiful Soup voor het beste van twee werelden: gebruiksgemak én snelheid.

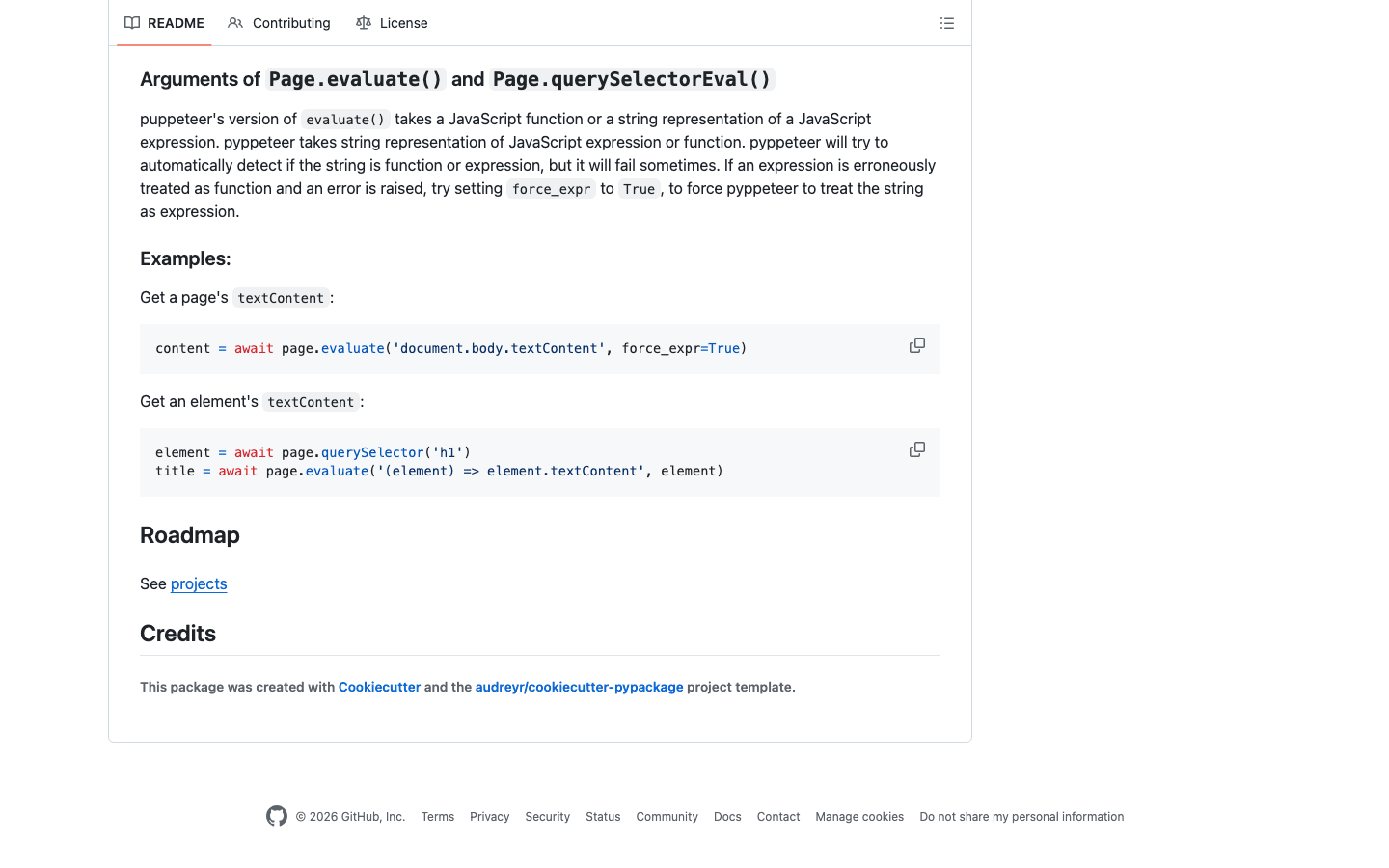

6. Pyppeteer

is de Python-versie van Puppeteer en geeft je volledige controle over headless Chrome voor geavanceerde scraping-taken. Ideaal voor moderne webapps met veel JavaScript.

is de Python-versie van Puppeteer en geeft je volledige controle over headless Chrome voor geavanceerde scraping-taken. Ideaal voor moderne webapps met veel JavaScript.

Belangrijkste functies:

- Volledige controle over headless Chrome (of Chromium)

- Uitstekende JavaScript-rendering en gebruikerssimulatie

- Kan complexe navigatie, screenshots en PDF-generatie aan

Beste toepassingen: Scrapen van moderne, JavaScript-rijke sites, automatiseren van gebruikersflows, omzeilen van anti-botmaatregelen.

Voordelen:

- Topklasse JavaScript-ondersteuning

- Simuleert menselijk gedrag voor lastige sites

- Ideaal voor SPAs (Single Page Apps)

Nadelen:

- Zwaarder en trager dan Requests of Scrapy

- Onderhoudsstatus kan wisselen—check altijd de laatste updates

- Meer installatie vereist

Tip: Voor sites die Selenium breekt, lukt het vaak wel met Pyppeteer. Voor zakelijke workflows kun je Thunderbit’s AI gebruiken om data-velden vooraf te definiëren en daarna Pyppeteer inzetten voor de navigatie.

7. Splash

is een lichte browser-engine, speciaal ontworpen voor het renderen van JavaScript op grote schaal. Vaak gebruikt in combinatie met Scrapy voor dynamische sites.

is een lichte browser-engine, speciaal ontworpen voor het renderen van JavaScript op grote schaal. Vaak gebruikt in combinatie met Scrapy voor dynamische sites.

Belangrijkste functies:

- Headless browser met HTTP API

- Rendered JavaScript en levert HTML, screenshots of HAR-bestanden

- Integreert met Scrapy via middleware

Beste toepassingen: Batchverwerking van JavaScript-rijke pagina’s, schaalbare scraping-pipelines, server-side rendering.

Voordelen:

- Snel en efficiënt voor grootschalig renderen

- API-gebaseerd—makkelijk te integreren

- Minder systeembronnen nodig dan volledige browserautomatisering

Nadelen:

- Minder interactief dan Selenium of Pyppeteer

- Enige leercurve bij installatie en scripting

Tip: Voor grootschalig scrapen van dynamische sites is Scrapy + Splash een ijzersterke combinatie.

8. MechanicalSoup

is een lichte Python-bibliotheek die webformulieren en eenvoudige navigatie automatiseert. Gebouwd op Requests en Beautiful Soup.

is een lichte Python-bibliotheek die webformulieren en eenvoudige navigatie automatiseert. Gebouwd op Requests en Beautiful Soup.

Belangrijkste functies:

- Automatiseert formulierinvoer en navigatie

- Behoudt sessiestatus en cookies

- Simpele, gebruiksvriendelijke API

Beste toepassingen: Inloggen op sites, formulieren invullen, scrapen van statische of licht dynamische pagina’s.

Voordelen:

- Minimale setup—ideaal voor snelle automatisering

- Beheert cookies en sessies standaard

- Perfect voor sites met eenvoudige login- of zoekformulieren

Nadelen:

- Geen JavaScript-ondersteuning

- Niet geschikt voor grootschalige of zeer dynamische scraping

Tip: Gebruik MechanicalSoup voor loginflows en schakel daarna over op Requests + Beautiful Soup voor de rest.

9. Twisted

is een event-driven netwerkengine voor Python. Geen webscraper op zich, maar wel de basis voor het bouwen van eigen, krachtige scraping-pipelines.

is een event-driven netwerkengine voor Python. Geen webscraper op zich, maar wel de basis voor het bouwen van eigen, krachtige scraping-pipelines.

Belangrijkste functies:

- Asynchrone netwerken voor HTTP, TCP en meer

- Schaalbaar tot duizenden gelijktijdige verbindingen

- Gebruikt in maatwerk, gedistribueerde scraping-systemen

Beste toepassingen: Bouwen van eigen, grootschalige scrapers; integratie met andere async frameworks.

Voordelen:

- Zeer schaalbaar en krachtig

- Ondersteunt veel protocollen

- Ideaal voor gevorderde gebruikers

Nadelen:

- Steile leercurve

- Overkill voor standaard scraping-klussen

Tip: Moet je op grote schaal scrapen (denk miljoenen pagina’s)? Dan is Twisted het leren waard.

10. Scrapy

is het Zwitsers zakmes onder de Python webscraping-frameworks. Ontworpen voor grootschalige, productieklare projecten, met een asynchrone architectuur waarmee je duizenden pagina’s kunt crawlen zonder problemen.

is het Zwitsers zakmes onder de Python webscraping-frameworks. Ontworpen voor grootschalige, productieklare projecten, met een asynchrone architectuur waarmee je duizenden pagina’s kunt crawlen zonder problemen.

Belangrijkste functies:

- Asynchrone, event-driven engine voor hoge doorvoer

- Ingebouwde ondersteuning voor pipelines, middleware en data-export (JSON, CSV, XML)

- Regelt crawling, parsing en data cleaning op één plek

- Uitbreidbaar met plugins voor proxies, user agents en meer

Beste toepassingen: Scraping op ondernemingsniveau, gestructureerde data-extractie, projecten die snelheid en betrouwbaarheid vereisen.

Voordelen:

- Razendsnel bij grote klussen

- Zeer aanpasbaar en uitbreidbaar

- Sterke community en documentatie

Nadelen:

- Steile leercurve voor beginners

- Niet ideaal voor dynamische, JavaScript-rijke sites zonder extra tools

Tip: Scrapy werkt uitstekend samen met voor JavaScript-rendering, of met voor AI-gedreven veldherkenning en datastructurering.

11. PyQuery

brengt jQuery-achtige selectors naar Python. Ben je fan van jQuery’s syntax? Dan voel je je hier meteen thuis.

brengt jQuery-achtige selectors naar Python. Ben je fan van jQuery’s syntax? Dan voel je je hier meteen thuis.

Belangrijkste functies:

- jQuery-achtige API voor selecteren en aanpassen van HTML

- Gebouwd op lxml voor snelheid

- Ondersteunt CSS-selectors en DOM-manipulatie

Beste toepassingen: Ontwikkelaars met jQuery-ervaring, snel prototypen, projecten die snelle, flexibele selectors nodig hebben.

Voordelen:

- Snel en efficiënt

- Intuïtief voor wie jQuery kent

- Goed voor zowel parsen als aanpassen van HTML

Nadelen:

- Kleinere community dan Beautiful Soup of LXML

- Beperkte ondersteuning voor gebroken HTML

Tip: Gebruik PyQuery als je de kracht van lxml wilt, maar liever CSS-selectors gebruikt dan XPath.

12. Parsel

is een krachtige bibliotheek voor het extraheren van data uit HTML en XML met XPath en CSS-selectors. Het is het geheime wapen achter de parsing-engine van Scrapy.

is een krachtige bibliotheek voor het extraheren van data uit HTML en XML met XPath en CSS-selectors. Het is het geheime wapen achter de parsing-engine van Scrapy.

Belangrijkste functies:

- Geavanceerde ondersteuning voor XPath en CSS-selectors

- Duidelijke API voor data-extractie en opschoning

- Te gebruiken als standalone of binnen Scrapy

Beste toepassingen: Complexe data-extractie, projecten met geavanceerde selectorlogica, integratie met Scrapy.

Voordelen:

- Zeer flexibel en krachtig

- Ideaal voor lastige paginalay-outs

- Goed gedocumenteerd en actief onderhouden

Nadelen:

- Vereist enige kennis van selectors

- Geen volledig scraping-framework—vooral als parsing-component

Tip: Gebruik Parsel voor het zware werk in je eigen Scrapy-spiders of standalone parsing-scripts.

Vergelijkingstabel: Python webscraping-tools in één oogopslag

| Library | Main Features | Performance | Ease of Use | JavaScript Support | Best For | Integration Options |

|---|---|---|---|---|---|---|

| Thunderbit | AI-gestuurd, no-code, subpagina’s | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Ja (browser-based) | Zakelijke gebruikers, hybride workflows | Excel, Sheets, Notion, Python |

| Beautiful Soup | HTML/XML-parsing, vergevingsgezind | ⭐⭐ | ⭐⭐⭐⭐⭐ | Nee | Data cleaning, kleine klussen | Requests, LXML, Thunderbit |

| Selenium | Browserautomatisering, dynamische content | ⭐⭐ | ⭐⭐ | Ja | Dynamische sites, gebruikersinteractie | Beautiful Soup, PyQuery |

| Requests | HTTP-verzoeken, sessies | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Nee | Statische pagina’s, API’s | Beautiful Soup, LXML |

| LXML | Snelle parsing, XPath, CSS-selectors | ⭐⭐⭐⭐ | ⭐⭐⭐ | Nee | Grote documenten, complexe parsing | Beautiful Soup, PyQuery |

| Pyppeteer | Headless Chrome, JS-rendering | ⭐⭐ | ⭐⭐ | Ja | Moderne JS-sites, SPAs | Thunderbit, Pandas |

| Splash | JS-rendering, API-gebaseerd | ⭐⭐⭐ | ⭐⭐ | Ja | Batch JS-scraping, pipelines | Scrapy, Thunderbit |

| MechanicalSoup | Formulieren, navigatie | ⭐⭐ | ⭐⭐⭐⭐ | Nee | Eenvoudige formulieren, logins | Requests, Beautiful Soup |

| Twisted | Async netwerken, maatwerk pipelines | ⭐⭐⭐⭐⭐ | ⭐ | Nee | Hoge volumes, maatwerk scrapers | Scrapy, custom frameworks |

| Scrapy | Hoge prestaties, async, pipelines | ⭐⭐⭐⭐⭐ | ⭐⭐ | Beperkt (via Splash) | Enterprise-schaal, gestructureerde data | Splash, Parsel, Thunderbit |

| PyQuery | jQuery-style selectors, snel | ⭐⭐⭐ | ⭐⭐⭐⭐ | Nee | jQuery-fans, snel prototypen | LXML, Requests |

| Parsel | XPath/CSS-selectors, flexibele parsing | ⭐⭐⭐⭐ | ⭐⭐⭐ | Nee | Complexe extractie, Scrapy-gebruikers | Scrapy, Standalone |

Hoe kies je de beste Python webscraping-bibliotheek voor jouw situatie?

Hier is mijn snelle beslisboom:

-

Werk je met statische pagina’s of API’s?

Gebruik Requests + Beautiful Soup of LXML. -

Wil je snel grote hoeveelheden data scrapen?

Scrapy is je beste keuze. Voor asynchrone netwerken kun je Twisted overwegen. -

Moet je dynamische, JavaScript-rijke sites scrapen?

Probeer Selenium, Pyppeteer of Splash (met Scrapy). -

Wil je jQuery-achtige selectors?

PyQuery is dan ideaal. -

Automatiseer je formulieren of logins?

MechanicalSoup is eenvoudig en effectief. -

Geen programmeur, of wil je snel aan de slag?

Met Thunderbit kun je in gewone taal aangeven wat je wilt, waarna je gestructureerde data direct naar je favoriete tools exporteert. -

Hybride aanpak?

Gebruik Thunderbit om snel te prototypen en je data te structureren, en verwerk het daarna verder in je Python-scripts.

Checklist voor het kiezen van je tool:

- Hoe complex is de site (statisch vs. dynamisch)?

- Hoeveel data wil je scrapen?

- Moet je formulieren of logins automatiseren?

- Hoe vertrouwd ben je met Python en selectors?

- Moet je exporteren naar zakelijke tools (Excel, Sheets, Notion)?

- Is onderhoud op de lange termijn belangrijk?

Conclusie: Haal het maximale uit Python webscraping in 2026

Webscraping met Python is krachtiger en toegankelijker dan ooit. Of je nu opschaalt met Scrapy, data opschoont met Beautiful Soup, JavaScript te lijf gaat met Selenium of Pyppeteer, of gewoon data in een spreadsheet wilt krijgen zonder te programmeren—er is altijd een geschikte tool.

Het echte geheim? Combineer verschillende tools. Elke Python webscraping-bibliotheek heeft zijn eigen kracht, en door ze slim te combineren (of AI-oplossingen zoals toe te voegen) bespaar je uren werk, voorkom je fouten en ontdek je nieuwe zakelijke inzichten.

In 2026 zijn de winnaars niet alleen de snelste programmeurs—maar vooral degenen die de juiste tools kiezen, saaie taken automatiseren en zich richten op wat echt telt: webdata omzetten in waarde voor je bedrijf.

Veelgestelde vragen

1. Wat is de beste Python-bibliotheek voor webscraping als ik beginner ben?

Beautiful Soup wordt vaak aanbevolen voor beginners vanwege de eenvoudige syntax en vergevingsgezindheid. Voor niet-programmeurs biedt Thunderbit een AI-gedreven, no-code alternatief.

2. Welke Python webscraping-tool is het beste voor dynamische of JavaScript-rijke websites?

Selenium, Pyppeteer en Splash zijn de beste keuzes voor dynamische content. Pyppeteer is vooral sterk bij moderne JavaScript-apps.

3. Kan ik Thunderbit combineren met Python-bibliotheken zoals Scrapy of Beautiful Soup?

Zeker! Thunderbit kan snel data structureren en exporteren, waarna je deze verder kunt verwerken met je favoriete Python-bibliotheken.

4. Wat is de snelste Python-bibliotheek voor het parsen van grote HTML-documenten?

LXML is doorgaans het snelst voor grootschalig parsen, vooral bij gebruik van XPath of CSS-selectors.

5. Hoe kies ik tussen Scrapy en Selenium?

Gebruik Scrapy voor grootschalige, gestructureerde scraping van vooral statische sites. Kies Selenium als je moet interacteren met dynamische elementen, logins of JavaScript-rijke pagina’s.

Benieuwd hoe Thunderbit jouw webscraping kan versnellen? en bekijk meer handleidingen op de . Veel succes met scrapen!

Meer weten