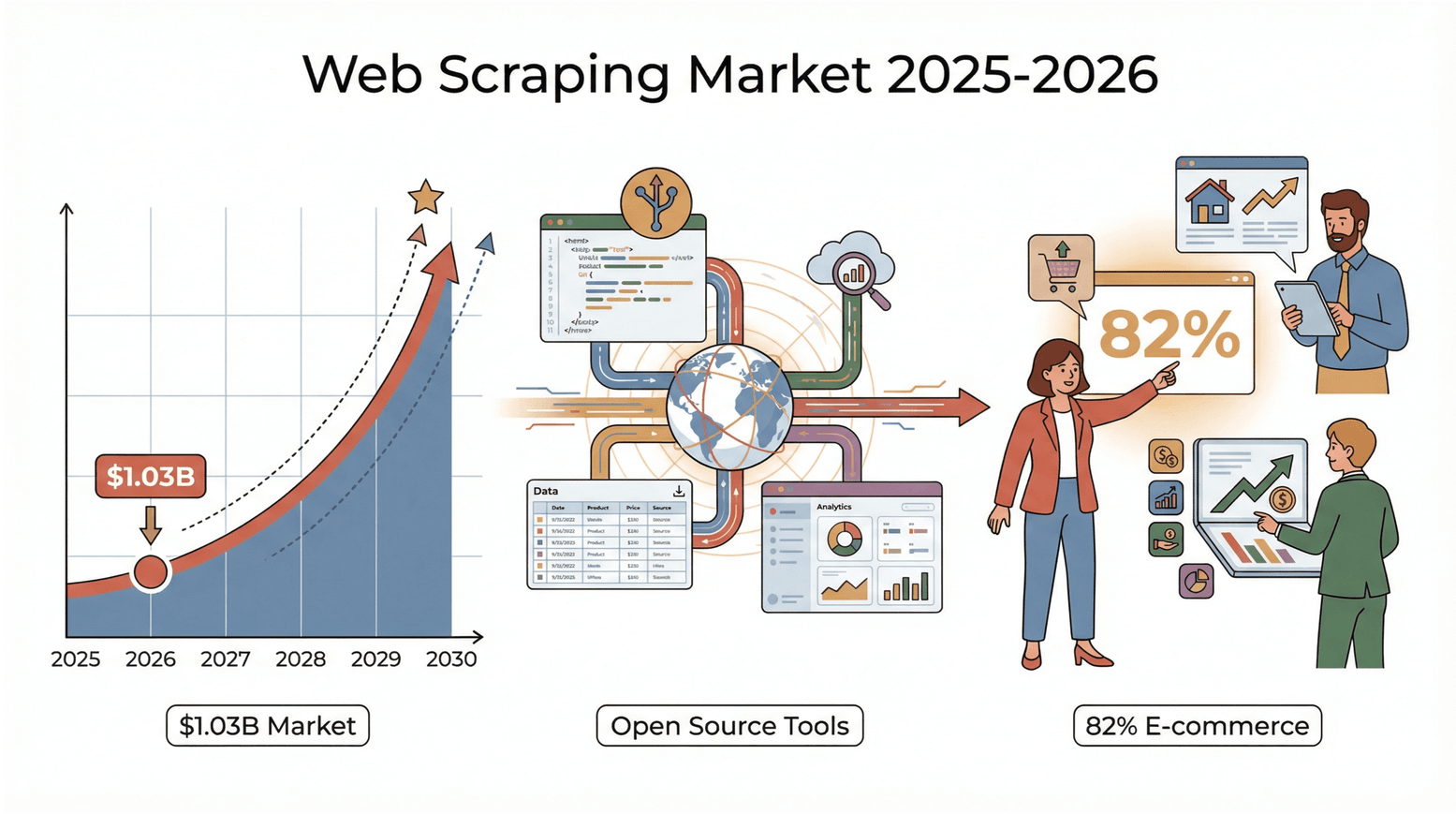

Het internet is tegenwoordig één grote bron van data, en in 2026 is de jacht op waardevolle inzichten uit al die informatie feller dan ooit. Of je nu in sales, e-commerce, vastgoed werkt of gewoon een echte dataliefhebber bent zoals ik, je hebt vast gemerkt dat ouderwets ‘kopiëren en plakken’ allang niet meer volstaat. Wist je dat de wereldwijde webscraping-markt in waard was? En die markt verdubbelt waarschijnlijk nog voor 2030. En het zijn niet alleen de grote techspelers—82% van de e-commercebedrijven en meer dan een derde van de investeringsmaatschappijen gebruiken webscraping voor leads, prijsvergelijkingen en marktonderzoek (). Kortom: als je nog geen webscraper inzet, laat je kansen én inzichten liggen.

Gelukkig zijn open source webscrapers tegenwoordig krachtiger, toegankelijker en meer community-gedreven dan ooit. Of je nu een Python-fanaat bent, liever met JavaScript werkt, of gewoon snel data wilt verzamelen zonder gedoe—er is altijd wel een tool die bij je past. Na jaren in SaaS en automatisering heb ik deze wereld flink zien groeien. Daarom deel ik graag de 5 beste open source webscraping tools die je in 2026 niet mag missen—plus handige tips om de juiste keuze te maken.

Waarom Open Source Webscraping Tools Gebruiken?

Open source webscrapers zijn echt de Zwitserse zakmessen voor dataverzameling. Ze zijn betaalbaar (geen licentiekosten), flexibel (je kunt alles aanpassen) en transparant (je ziet precies wat er gebeurt). Maar het grootste voordeel? De community. Open source tools worden gedragen door duizenden ontwikkelaars en gebruikers die plug-ins, handleidingen en oplossingen delen—je staat er dus nooit alleen voor ().

In vergelijking met commerciële tools heb je met open source veel meer controle. Je zit niet vast aan de grillen van een leverancier en je kunt je webscraper direct aanpassen als een website verandert. Sterker nog, veel commerciële scrapingdiensten zijn gebouwd op deze open source engines—waarom zou je dan niet meteen de bron gebruiken?

Hoe Hebben We de Beste Open Source Webscraping Tools Geselecteerd?

Met zoveel keuze heb ik gelet op een paar belangrijke punten:

- Gebruiksgemak: Kunnen niet-programmeurs snel aan de slag? Zijn er visuele of AI-gestuurde opties?

- Schaalbaarheid: Kan de tool grote projecten aan of alleen kleine klusjes?

- Taal- en platformondersteuning: Python, JavaScript, browser-based, desktop—voor elke stack wat wils.

- Community en onderhoud: Wordt de tool actief bijgewerkt? Zijn er forums, documentatie en plug-ins?

- Unieke functies: AI-veldherkenning, subpagina scraping, plannen, cloud-integratie, enzovoort.

Ook heb ik gekeken naar praktijkervaringen en zakelijke toepassingen—want de beste tool is degene die jouw probleem oplost.

De Top 5 Beste Open Source Webscraping Tools om te Ontdekken

Hier volgt mijn selectie, van AI-gestuurde eenvoud tot krachtige frameworks voor ontwikkelaars.

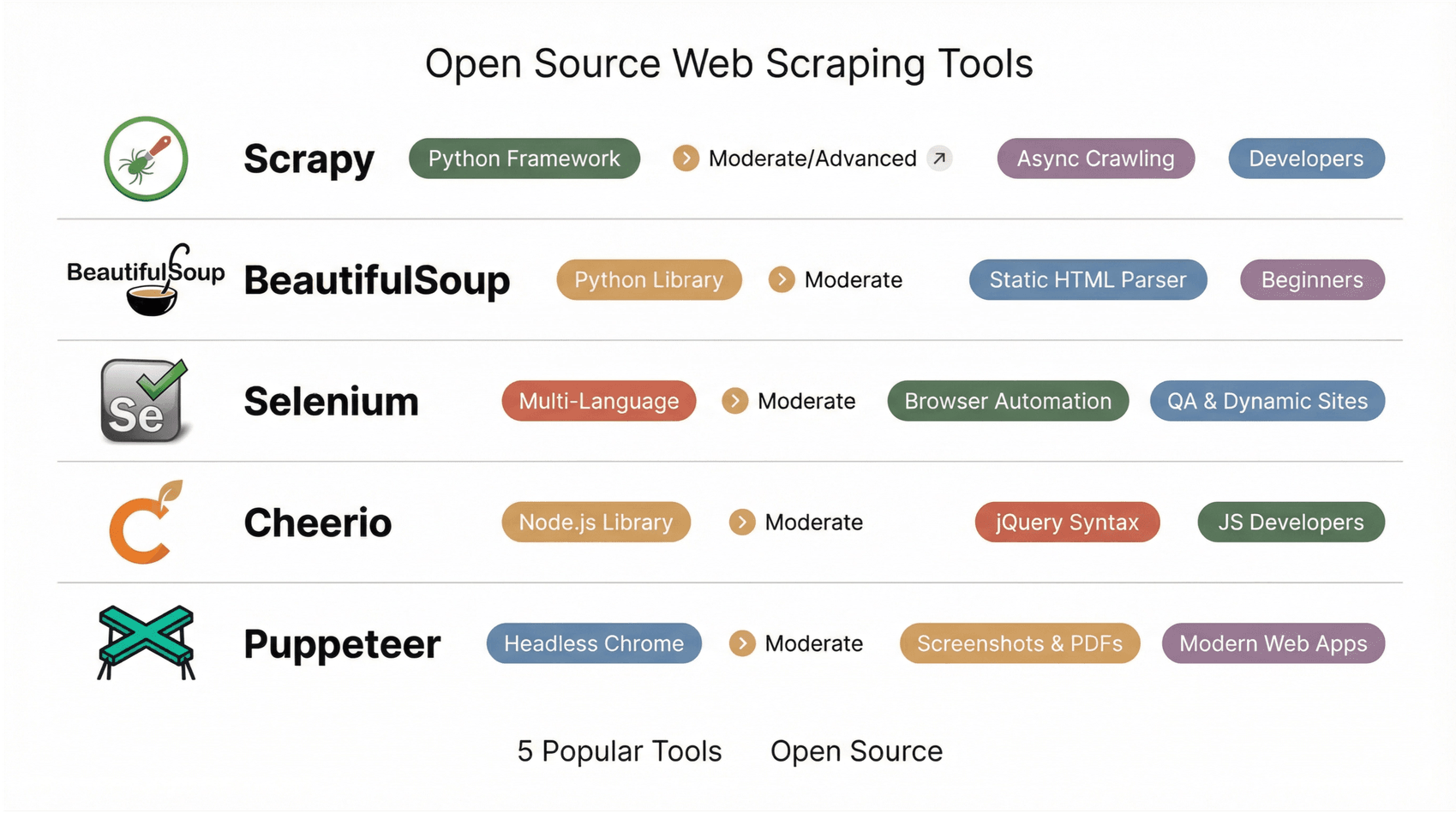

1. Scrapy

is dé droomtool voor Python-ontwikkelaars. Het is een robuust framework waarmee je schaalbare, aanpasbare crawlers en datapijplijnen bouwt. Dankzij asynchrone netwerken kan Scrapy razendsnel duizenden tot miljoenen pagina’s verwerken. Je definieert ‘spiders’ in Python en Scrapy regelt de wachtrij, vertragingen en export naar JSON, CSV of XML.

Het plug-in ecosysteem is enorm, met middleware voor proxies, cookies en zelfs headless browser-integratie voor dynamische sites. Scrapy is ideaal voor grote projecten, zoals het crawlen van complete e-commerce catalogi of het verzamelen van nieuws. De leercurve is wat steil voor niet-programmeurs, maar wie kracht en flexibiliteit zoekt, zit hier goed ().

2. Beautiful Soup

is de klassieke Python-bibliotheek voor snel en eenvoudig HTML-parsen. Zowel beginners als gevorderden zijn fan vanwege de eenvoudige syntax en de tolerante parser (zelfs rommelige HTML wordt verwerkt). Je haalt een pagina op (meestal met requests), laadt deze in Beautiful Soup en gebruikt simpele methodes om elementen te vinden en te extraheren.

Perfect voor kleine projecten, prototypes en educatieve doeleinden. Nadeel: Beautiful Soup voert geen JavaScript uit, dus werkt alleen op statische HTML. Voor dynamische sites combineer je het met bijvoorbeeld Selenium of requests_html ().

3. Selenium

is de originele browserautomatiseringstool. Oorspronkelijk bedoeld voor testen, maar inmiddels favoriet voor het scrapen van dynamische, JavaScript-rijke websites. Selenium start een echte browser (zoals Chrome of Firefox) en simuleert gebruikersacties—klikken, scrollen, inloggen, noem maar op. Alles wat een mens kan zien, kan Selenium scrapen.

Het ondersteunt meerdere programmeertalen (Python, Java, JS, C#) en is ideaal voor scraping achter logins of interactieve flows. Nadelen? Het is trager en zwaarder dan pure HTTP-scrapers en het beheren van browserdrivers kan wat gedoe zijn. Maar voor lastige sites is Selenium onmisbaar ().

4. Cheerio

is de jQuery van de Node.js-wereld. Hiermee kun je HTML op de server parsen met een vertrouwde, jQuery-achtige syntax. Het is razendsnel en ideaal voor statische pagina’s—haal de HTML op (met Axios of Fetch), laad het in Cheerio en gebruik selectors om de gewenste data te pakken.

Cheerio voert geen JavaScript uit, dus is vooral geschikt voor statische content. Maar het werkt naadloos samen met andere Node.js-tools en is populair bij ontwikkelaars die alles in JavaScript willen houden ().

5. Puppeteer

is een Node.js-bibliotheek om Chrome of Chromium headless aan te sturen. Zie het als de moderne, JavaScript-native variant van Selenium. Puppeteer is ideaal voor het scrapen van moderne webapps, single-page applicaties en alles wat echte browserweergave vereist. Je kunt screenshots maken, PDF’s genereren en netwerkverzoeken onderscheppen—alles via een overzichtelijke async/await-API.

Het is vooral gericht op ontwikkelaars, maar als je sites wilt scrapen die zwaar op JavaScript leunen, is Puppeteer onmisbaar ().

Snel Vergelijkingsoverzicht: Beste Open Source Webscraping Tools

| Tool | Gebruiksgemak | Platform/Taal | Dynamische Content | Ideaal Voor | Unieke Sterktes |

|---|---|---|---|---|---|

| Scrapy | Gemiddeld/Geavanceerd (code) | Python framework | Gedeeltelijk | Ontwikkelaars, data scientists | Asynchrone crawling, plug-ins, grote community |

| BeautifulSoup | Gemiddeld (eenvoudige code) | Python bibliotheek | Nee | Beginners, snelle parsing | Tolerante parser, ideaal voor statische HTML |

| Selenium | Gemiddeld (scripting) | Meerdere talen | Ja | QA, scraping van dynamische sites | Echte browserautomatisering, logins, gebruikersacties |

| Cheerio | Gemiddeld (JS-code) | Node.js bibliotheek | Nee | JS-ontwikkelaars, statische pagina’s | jQuery-syntax, snelle HTML-parsing |

| Puppeteer | Gemiddeld (JS-code) | Node.js (headless Chrome) | Ja | Ontwikkelaars, moderne webapps | Screenshots, PDF’s, SPA-scraping, async/await-API |

Hoe Kies je de Juiste Open Source Webscraper voor Jouw Doel?

Hier is mijn handige keuzehulp:

- Technische kennis: Geen programmeur? Begin met Thunderbit, Octoparse, ParseHub of WebHarvy. Ontwikkelaars? Scrapy, Cheerio, Puppeteer of Apify.

- Projectgrootte: Eenmalige of kleine klus? Beautiful Soup, Cheerio, WebHarvy. Grote of terugkerende projecten? Scrapy, Apify, Thunderbit (met planning).

- Datatype: Statische HTML? Gebruik Cheerio, Beautiful Soup of WebHarvy. Dynamisch/veel JavaScript? Puppeteer, Selenium, Thunderbit, Octoparse.

- Integratie: Data exporteren naar Sheets, Notion of databases? Thunderbit en Octoparse maken het makkelijk. APIs of eigen pipelines nodig? Scrapy en Apify zijn dan geschikt.

- Community & Support: Zoek naar actieve forums, recente updates en veel tutorials. Scrapy, Cheerio en Selenium hebben grote communities; Thunderbit en Octoparse groeien snel en bieden veel handleidingen.

Test een paar tools op een klein project en kijk welke het beste bij jouw werkwijze past. En mix gerust: soms is een snelle visuele scrape de beste start, gevolgd door een diepere crawl met een code-framework.

De Waarde van Community en Doorlopende Support bij Open Source Scraping

Eén van de grootste pluspunten van open source? De community. Actieve forums, GitHub-repositories en Stack Overflow-tags zorgen ervoor dat je nooit vastloopt. Als je ergens tegenaan loopt, is de kans groot dat iemand het al heeft opgelost—of je graag helpt. Community-gedreven tools krijgen regelmatig updates en nieuwe functies, en je vindt volop tutorials, plug-ins en best practices ().

Voor visuele tools zoals Thunderbit en Octoparse zijn gebruikersfora en het delen van sjablonen goud waard. Voor ontwikkelaarstools zijn GitHub-issues en Discord/Slack-groepen de plekken waar je moet zijn. Door te kiezen voor open source, word je onderdeel van een wereldwijd netwerk van probleemoplossers—en dat is onbetaalbaar.

Thunderbit: De Makkelijkste No-code Webscraper voor Iedereen

Open source is fantastisch—maar soms wil je gewoon snel bruikbare data, zonder zelf een webscraper te bouwen en te onderhouden. Niet elk scraping-vraagstuk is met open source code op te lossen—en daar komt Thunderbit perfect van pas. Als je tot hier hebt gelezen en denkt: “Deze tools zijn krachtig, maar ik wil gewoon data zonder gedoe,” dan is Thunderbit de logische volgende stap.

is een AI-gedreven Chrome-extensie, speciaal voor zakelijke gebruikers die resultaat willen zonder technische rompslomp. In plaats van selectors of scripts te schrijven, klik je op AI Suggest Fields. De AI begrijpt de pagina, stelt kolommen voor en met één klik scrape je de data. Paginering, subpagina’s en lijst-detail flows worden automatisch afgehandeld.

Een van de grootste pluspunten van Thunderbit is de brug tussen menselijke intentie en gestructureerde data. Je beschrijft simpelweg wat je wilt (“verzamel productnamen, prijzen en beoordelingen”) en Thunderbit zet dat om in een overzichtelijke tabel. Subpagina scraping maakt het eenvoudig om diepere data te verzamelen door automatisch detailpagina’s te bezoeken. Exporteren naar Excel, Google Sheets, Notion en Airtable is ingebouwd, dus je kunt direct aan de slag met je data.

Thunderbit is vooral populair bij sales-, marketing-, e-commerce- en vastgoedteams die betrouwbare data willen zonder open source pipelines te hoeven beheren. Het ondersteunt tientallen talen, werkt goed op dynamische sites en biedt een royaal gratis instapmodel. Hoewel het geen open source is, vult het open source tools perfect aan—zie het als de snelste manier om ideeën te testen of terugkerende business-scrapes te doen zonder technische ballast.

Conclusie: Haal Meer uit Webdata met de Beste Open Source Tools

Webscraping is allang niet meer alleen voor programmeurs of grote bedrijven. Met de huidige open source tools kan iedereen het web omzetten in gestructureerde, bruikbare data—of je nu een leadlijst bouwt, prijzen monitort of je volgende AI-project voedt. Het draait om de juiste tool voor jouw situatie: AI-gestuurde en visuele tools voor snelheid en gemak, code-frameworks voor kracht en schaalbaarheid.

Wat nu? Kies een tool uit deze lijst, probeer hem uit op een echte taak en ontdek hoeveel tijd en moeite je bespaart. Wil je snel resultaat? en ervaar hoe eenvoudig webscraping kan zijn. Het web ligt voor je open—haal die waardevolle data binnen.

Voor meer diepgaande uitleg en tutorials, bekijk de . Veel succes met scrapen!

Veelgestelde Vragen

1. Wat is het grootste voordeel van open source webscraping tools ten opzichte van commerciële alternatieven?

Open source tools zijn voordelig, flexibel en hebben een actieve community. Je kunt ze aanpassen, zit niet vast aan een leverancier en profiteert van gedeelde kennis en regelmatige updates.

2. Welke open source tool is het meest geschikt voor niet-technische zakelijke gebruikers?

Thunderbit, Octoparse, ParseHub en WebHarvy zijn allemaal geschikt voor niet-programmeurs. Thunderbit springt eruit door de AI-gestuurde, tweekliks workflow en directe exportmogelijkheden.

3. Kunnen open source tools omgaan met dynamische, JavaScript-rijke websites?

Zeker! Tools als Thunderbit, Selenium, Puppeteer, Octoparse en ParseHub kunnen dynamische content scrapen door pagina’s te renderen in een echte of headless browser.

4. Hoe weet ik of een tool actief wordt onderhouden en ondersteund?

Check GitHub op recente commits, openstaande issues en activiteit van bijdragers. Kijk ook naar actieve forums, recente blogposts en veelgebruikte plug-ins of sjablonen.

5. Wat is de beste manier om te starten met webscraping als beginner?

Begin met een visuele of AI-gedreven tool zoals Thunderbit of Octoparse. Probeer een kleine dataset te scrapen, exporteer naar Excel of Sheets en experimenteer. Als je meer ervaring krijgt, kun je overstappen op code-gebaseerde tools voor geavanceerdere projecten.

Wil je Thunderbit in actie zien? en sluit je aan bij 30.000+ gebruikers die het web omzetten in data—zonder te programmeren.

Meer weten?