Een website runnen in 2025 voelt soms als een never-ending survivalrun. De ene dag ben je bezig met het fixen van dode links, de volgende dag staat er een contentmigratie op de planning, en tussendoor vraag je je af waarom Google ineens je oude 'test'-pagina uit 2019 heeft opgepikt. Geloof me, ik heb het allemaal meegemaakt – vaker dan me lief is. En als jij een beetje op mij lijkt, heb je vast ook wel eens midden in de nacht gezocht op 'beste gratis website crawler', hopend op een tool die gewoon doet wat je wilt (zonder dat je een IT-diploma nodig hebt).

Maar let op: niet elke website crawler is hetzelfde. En – kleine spoiler – veel mensen halen 'web crawler' en 'webscraper' door elkaar alsof het hetzelfde is. Dat klopt dus niet. In deze gids leg ik het verschil uit, vertel ik waarom online webcrawlers belangrijker zijn dan ooit, en neem ik je mee langs de 10 beste gratis website crawlers voor 2025. En omdat ik mede-oprichter ben van , laat ik je ook zien wanneer het slimmer is om de technische diepte in te ruilen voor een AI-oplossing die je direct de data geeft die je zoekt. Klaar? Laten we gaan crawlen.

Wat is een Website Crawler? De Basis

Eerst even het verschil duidelijk maken: een website crawler is niet hetzelfde als een webscraper. Ik weet het, de termen worden vaak door elkaar gebruikt, maar ze doen echt iets anders. Zie een crawler als de verkenner van je site – die loopt overal doorheen, volgt alle links en maakt een plattegrond van al je pagina’s. Het doel is ontdekken: URLs vinden, de structuur van je site in kaart brengen en content indexeren. Zo werken zoekmachines als Google, en zo checken SEO-tools de gezondheid van je website ().

Een webscraper daarentegen is de goudzoeker. Die wil niet de hele kaart, maar alleen de schatten: productprijzen, bedrijfsnamen, reviews, e-mails, noem maar op. Scrapers halen specifieke gegevens van de pagina’s die crawlers vinden ().

Even een metafoor:

- Crawler: De persoon die elke gang in de supermarkt afloopt en een inventaris maakt van alle producten.

- Scraper: Degene die direct naar het koffieschap loopt en alleen de prijzen van de biologische blends noteert.

Waarom is dit belangrijk? Als je alleen alle pagina’s van je site wilt vinden (bijvoorbeeld voor een SEO-audit), heb je een crawler nodig. Wil je alle productprijzen van een concurrent verzamelen, dan heb je een scraper nodig – of het liefst een tool die beide kan.

Waarom een Online Web Crawler Gebruiken? Zakelijke Voordelen

Waarom zou je in 2025 nog een online webcrawler gebruiken? Nou, het internet groeit alleen maar door. Meer dan om hun sites te optimaliseren, en sommige SEO-tools crawlen dagelijks .

Wat kun je met crawlers doen?

- SEO-audits: Vind kapotte links, ontbrekende titels, dubbele content, weespagina’s en meer ().

- Linkcontrole & QA: Spoor 404’s en redirect-lussen op voordat je bezoekers ze tegenkomen ().

- Sitemap genereren: Maak automatisch XML-sitemaps voor zoekmachines en planning ().

- Content-inventaris: Krijg een overzicht van al je pagina’s, hun hiërarchie en metadata.

- Toegankelijkheid & Compliance: Controleer elke pagina op WCAG, SEO en juridische eisen ().

- Performance & Beveiliging: Signaleer trage pagina’s, te grote afbeeldingen of beveiligingsproblemen ().

- Data voor AI & Analyse: Gebruik gecrawlde data in analytics of AI-tools ().

Hier een overzichtstabel met toepassingen en wie er baat bij heeft:

| Toepassing | Ideaal voor | Voordeel / Resultaat |

|---|---|---|

| SEO & Site-auditing | Marketing, SEO, Kleine ondernemers | Vind technische issues, optimaliseer structuur, verbeter ranking |

| Content-inventaris & QA | Contentmanagers, Webmasters | Controleer/migreer content, vind kapotte links/afbeeldingen |

| Leadgeneratie (Scraping) | Sales, Business Development | Automatiseer prospecting, vul CRM met nieuwe leads |

| Concurrentieanalyse | E-commerce, Productmanagers | Volg prijzen, nieuwe producten, voorraad bij concurrenten |

| Sitemap & Structuur klonen | Developers, DevOps, Consultants | Kopieer sitestructuur voor redesigns of back-ups |

| Contentaggregatie | Onderzoekers, Media, Analisten | Verzamel data van meerdere sites voor analyse of trends |

| Marktonderzoek | Analisten, AI-trainingsteams | Verzamel grote datasets voor analyse of AI-training |

()

Hoe We de Beste Gratis Website Crawlers Hebben Geselecteerd

Ik heb heel wat nachten (en bakken koffie) gestoken in het testen van crawlers, het doorspitten van handleidingen en het draaien van proefscans. Hier lette ik op:

- Technische mogelijkheden: Kan de tool moderne sites aan (JavaScript, logins, dynamische content)?

- Gebruiksgemak: Is het ook te doen voor niet-techneuten, of moet je command-line skills hebben?

- Gratis limieten: Is het écht gratis, of alleen een lokkertje?

- Toegankelijkheid: Is het een cloudtool, desktop-app of codebibliotheek?

- Unieke features: Heeft het iets speciaals – zoals AI-extractie, visuele sitemaps of event-driven crawling?

Ik heb elke tool zelf getest, gebruikerservaringen bekeken en de functies vergeleken. Als een tool me gek maakte, staat hij niet in deze lijst.

Snel Vergelijken: De 10 Beste Gratis Website Crawlers

| Tool & Type | Belangrijkste functies | Beste toepassing | Technische vereisten | Gratis limieten |

|---|---|---|---|---|

| BrightData (Cloud/API) | Enterprise crawling, proxies, JS-rendering, CAPTCHA-oplossing | Grootschalige dataverzameling | Enige technische kennis handig | Gratis proef: 3 scrapers, 100 records elk (ca. 300 records totaal) |

| Crawlbase (Cloud/API) | API-crawling, anti-bot, proxies, JS-rendering | Devs die backend crawling nodig hebben | API-integratie | Gratis: ~5.000 API-calls voor 7 dagen, daarna 1.000/maand |

| ScraperAPI (Cloud/API) | Proxyrotatie, JS-rendering, async crawl, kant-en-klare endpoints | Devs, prijsmonitoring, SEO-data | Minimale setup | Gratis: 5.000 API-calls voor 7 dagen, daarna 1.000/maand |

| Diffbot Crawlbot (Cloud) | AI-crawl + extractie, knowledge graph, JS-rendering | Gestructureerde data op schaal, AI/ML | API-integratie | Gratis: 10.000 credits/maand (ca. 10k pagina’s) |

| Screaming Frog (Desktop) | SEO-audit, link/meta-analyse, sitemap, custom extractie | SEO-audits, sitebeheerders | Desktop-app, GUI | Gratis: 500 URLs per crawl, alleen basisfuncties |

| SiteOne Crawler (Desktop) | SEO, performance, toegankelijkheid, security, offline export, Markdown | Devs, QA, migratie, documentatie | Desktop/CLI, GUI | Gratis & open-source, 1.000 URLs in GUI-rapport (instelbaar) |

| Crawljax (Java, OpenSrc) | Event-driven crawl voor JS-sites, statische export | Devs, QA voor dynamische webapps | Java, CLI/config | Gratis & open-source, geen limieten |

| Apache Nutch (Java, OpenSrc) | Gedistribueerd, plugin-based, Hadoop-integratie, custom search | Eigen zoekmachines, grootschalige crawl | Java, command-line | Gratis & open-source, alleen infra-kosten |

| YaCy (Java, OpenSrc) | Peer-to-peer crawl & search, privacy, web/intranet-indexering | Private search, decentralisatie | Java, browser UI | Gratis & open-source, geen limieten |

| PowerMapper (Desktop/SaaS) | Visuele sitemaps, toegankelijkheid, QA, browsercompatibiliteit | Bureaus, QA, visuele mapping | GUI, eenvoudig | Gratis proef: 30 dagen, 100 pagina’s (desktop) of 10 pagina’s (online) per scan |

BrightData: Enterprise-Cloud Website Crawler

BrightData is de krachtpatser onder de webcrawlers. Het is een cloudplatform met een gigantisch proxy-netwerk, JavaScript-rendering, CAPTCHA-oplossingen en een eigen IDE voor maatwerkcrawls. Wil je op grote schaal data verzamelen – bijvoorbeeld prijzen monitoren op honderden webshops – dan is BrightData bijna niet te kloppen ().

Pluspunten:

- Kan lastige sites met anti-botmaatregelen aan

- Schaalbaar voor enterprise-gebruik

- Vooraf ingestelde templates voor veelgebruikte sites

Minpunten:

- Geen blijvend gratis versie (alleen proef: 3 scrapers, 100 records elk)

- Overkill voor simpele audits

- Enige leercurve voor niet-technische gebruikers

Wil je grootschalig crawlen, dan is BrightData als een Formule 1-wagen huren. Maar gratis blijft het niet na de proefrit ().

Crawlbase: API-Gedreven Gratis Web Crawler voor Developers

Crawlbase (voorheen ProxyCrawl) draait helemaal om geautomatiseerd crawlen via API. Je stuurt een URL naar hun API en krijgt de HTML terug – proxies, geotargeting en CAPTCHAs worden automatisch geregeld ().

Pluspunten:

- Hoge succesratio (99%+)

- Geschikt voor JavaScript-rijke sites

- Ideaal voor integratie in eigen apps of workflows

Minpunten:

- Vereist enige API- of SDK-integratie

- Gratis: ~5.000 API-calls voor 7 dagen, daarna 1.000/maand

Ben je developer en wil je grootschalig crawlen (en eventueel scrapen) zonder proxygedoe? Dan is Crawlbase een goede keuze ().

ScraperAPI: Eenvoudig Dynamisch Web Crawlen

ScraperAPI is de 'haal het gewoon voor me op'-API. Je geeft een URL, zij regelen proxies, headless browsers en anti-botmaatregelen, en je krijgt de HTML (of gestructureerde data voor sommige sites). Vooral handig voor dynamische pagina’s en een royaal gratis pakket ().

Pluspunten:

- Super eenvoudig voor developers (gewoon een API-call)

- Omzeilt CAPTCHAs, IP-bans, JavaScript

- Gratis: 5.000 API-calls voor 7 dagen, daarna 1.000/maand

Minpunten:

- Geen visuele crawlrapporten

- Je moet zelf de crawl-logica scripten als je links wilt volgen

Wil je webcrawling snel in je code integreren? Dan is ScraperAPI een logische keuze.

Diffbot Crawlbot: Automatische Website-structuur Ontdekking

Diffbot Crawlbot is waar het slim wordt. Het crawlt niet alleen, maar gebruikt AI om pagina’s te classificeren en gestructureerde data (artikelen, producten, evenementen, enz.) in JSON te zetten. Het is als een robotstagiair die echt begrijpt wat hij leest ().

Pluspunten:

- AI-gedreven extractie, niet alleen crawlen

- Kan JavaScript en dynamische content aan

- Gratis: 10.000 credits/maand (ca. 10k pagina’s)

Minpunten:

- Gericht op developers (API-integratie)

- Geen visuele SEO-tool – meer voor dataprojecten

Wil je gestructureerde data op schaal, vooral voor AI of analytics, dan is Diffbot een krachtpatser.

Screaming Frog: Gratis Desktop SEO Crawler

Screaming Frog is de klassieker onder de desktopcrawlers voor SEO-audits. Je kunt tot 500 URLs per scan crawlen (gratis versie) en krijgt alles: kapotte links, meta-tags, dubbele content, sitemaps en meer ().

Pluspunten:

- Snel, grondig en vertrouwd in de SEO-wereld

- Geen code nodig – voer een URL in en start

- Gratis tot 500 URLs per crawl

Minpunten:

- Alleen desktop (geen cloudversie)

- Geavanceerde functies (JS-rendering, planning) alleen in betaalde versie

Ben je serieus met SEO bezig, dan is Screaming Frog onmisbaar – maar verwacht niet dat je er gratis 10.000 pagina’s mee crawlt.

SiteOne Crawler: Statische Site Export & Documentatie

SiteOne Crawler is het Zwitsers zakmes voor technische audits. Open-source, cross-platform, en kan crawlen, auditen en zelfs je site exporteren naar Markdown voor documentatie of offline gebruik ().

Pluspunten:

- Behandelt SEO, performance, toegankelijkheid, security

- Exporteert sites voor archivering of migratie

- Gratis & open-source, zonder gebruikslimieten

Minpunten:

- Technischer dan sommige GUI-tools

- Auditrapport in GUI standaard beperkt tot 1.000 URLs (instelbaar)

Ben je developer, QA of consultant en wil je diepgaande inzichten (en hou je van open source), dan is SiteOne een verborgen parel.

Crawljax: Open Source Java Web Crawler voor Dynamische Pagina’s

Crawljax is een specialist: ontworpen om moderne, JavaScript-rijke webapps te crawlen door gebruikersinteracties te simuleren (klikken, formulieren invullen, enz.). Event-driven en kan zelfs een statische versie van een dynamische site genereren ().

Pluspunten:

- Ongeëvenaard voor SPAs en AJAX-rijke sites

- Open-source en uitbreidbaar

- Geen gebruikslimieten

Minpunten:

- Vereist Java en wat programmeerkennis/configuratie

- Niet voor niet-technische gebruikers

Wil je een React- of Angular-app crawlen als een echte gebruiker? Dan is Crawljax je vriend.

Apache Nutch: Schaalbare Gedistribueerde Website Crawler

Apache Nutch is de oervader van open-source crawlers. Ontworpen voor massale, gedistribueerde crawls – denk aan het bouwen van je eigen zoekmachine of het indexeren van miljoenen pagina’s ().

Pluspunten:

- Schaalbaar tot miljarden pagina’s met Hadoop

- Zeer configureerbaar en uitbreidbaar

- Gratis & open-source

Minpunten:

- Steile leercurve (Java, command-line, configs)

- Niet geschikt voor kleine sites of incidenteel gebruik

Wil je het web op grote schaal crawlen en schrik je niet van de command-line? Dan is Nutch jouw tool.

YaCy: Peer-to-Peer Web Crawler en Zoekmachine

YaCy is uniek: een gedecentraliseerde crawler en zoekmachine. Elke installatie crawlt en indexeert sites, en je kunt deelnemen aan een peer-to-peer netwerk om indexen te delen ().

Pluspunten:

- Privacygericht, geen centrale server

- Ideaal voor private of intranet-zoekmachines

- Gratis & open-source

Minpunten:

- Resultaten hangen af van de dekking van het netwerk

- Enige setup vereist (Java, browser UI)

Ben je fan van decentralisatie of wil je je eigen zoekmachine? Dan is YaCy een interessante optie.

PowerMapper: Visuele Sitemap Generator voor UX en QA

PowerMapper draait om het visualiseren van je sitestructuur. Het crawlt je site en maakt interactieve sitemaps, en controleert op toegankelijkheid, browsercompatibiliteit en SEO-basiszaken ().

Pluspunten:

- Visuele sitemaps zijn ideaal voor bureaus en ontwerpers

- Controleert toegankelijkheid en compliance

- Eenvoudige GUI, geen technische kennis nodig

Minpunten:

- Alleen gratis proef (30 dagen, 100 pagina’s desktop/10 online per scan)

- Volledige versie is betaald

Wil je een sitemap presenteren aan klanten of compliance checken? Dan is PowerMapper een handige tool.

De Juiste Gratis Web Crawler Kiezen

Met zoveel opties, hoe kies je? Hier mijn snelle advies:

- Voor SEO-audits: Screaming Frog (kleine sites), PowerMapper (visueel), SiteOne (diepe audits)

- Voor dynamische webapps: Crawljax

- Voor grootschalig of eigen zoekmachine: Apache Nutch, YaCy

- Voor developers met API-behoefte: Crawlbase, ScraperAPI, Diffbot

- Voor documentatie of archivering: SiteOne Crawler

- Voor enterprise-schaal met proef: BrightData, Diffbot

Belangrijke factoren:

- Schaalbaarheid: Hoe groot is je site of crawlklus?

- Gebruiksgemak: Ben je handig met code, of wil je gewoon klikken?

- Data-export: Heb je CSV, JSON of integratie met andere tools nodig?

- Support: Is er een community of documentatie als je vastloopt?

Wanneer Web Crawling en Web Scraping Samenkomen: Waarom Thunderbit Slimmer Is

De realiteit: de meeste mensen crawlen websites niet om mooie kaarten te maken. Het echte doel is bijna altijd gestructureerde data – of het nu om productlijsten, contactgegevens of contentoverzichten gaat. Daar komt om de hoek kijken.

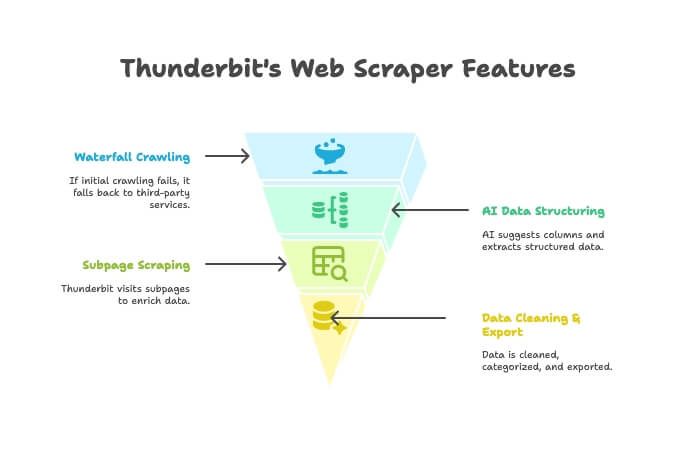

Thunderbit is niet zomaar een crawler of scraper – het is een AI-gedreven Chrome-extensie die beide combineert. Zo werkt het:

- AI Crawler: Thunderbit verkent de site, net als een crawler.

- Waterfall Crawling: Kan Thunderbit zelf een pagina niet bereiken (bijvoorbeeld door anti-botmaatregelen), dan schakelt het automatisch over op externe crawlingdiensten – zonder dat je iets hoeft in te stellen.

- AI Data Structurering: Zodra de HTML binnen is, stelt Thunderbit’s AI de juiste kolommen voor en haalt gestructureerde data (namen, prijzen, e-mails, enz.) op – zonder dat je zelf selectors hoeft te maken.

- Subpagina Scraping: Wil je details van elke productpagina? Thunderbit bezoekt automatisch alle subpagina’s en vult je tabel aan.

- Data opschonen & exporteren: Je kunt data samenvatten, categoriseren, vertalen en met één klik exporteren naar Excel, Google Sheets, Airtable of Notion.

- No-code gemak: Als je een browser kunt gebruiken, kun je met Thunderbit werken. Geen code, geen proxies, geen gedoe.

Wanneer kies je voor Thunderbit in plaats van een traditionele crawler?

- Als je einddoel een bruikbare spreadsheet is, niet alleen een lijst met URLs.

- Als je het hele proces (crawlen, extraheren, opschonen, exporteren) wilt automatiseren.

- Als je je tijd en energie wilt besparen.

Je kunt en zelf ervaren waarom zoveel zakelijke gebruikers overstappen.

Conclusie: Haal het Maximale uit Gratis Website Crawlers in 2025

Website crawlers zijn flink geëvolueerd. Of je nu marketeer, developer of gewoon een site-eigenaar bent die zijn website gezond wil houden, er is altijd een gratis (of op zijn minst gratis te proberen) tool voor jou. Van enterprise-platforms als BrightData en Diffbot, tot open-source parels als SiteOne en Crawljax, tot visuele tools als PowerMapper – de keuze is groter dan ooit.

Maar wil je slimmer en sneller van 'ik heb deze data nodig' naar 'hier is mijn spreadsheet', probeer dan Thunderbit. Het is gemaakt voor zakelijke gebruikers die resultaat willen, niet alleen rapporten.

Klaar om te crawlen? Download een tool, start een scan en ontdek wat je tot nu toe hebt gemist. En wil je in twee klikken van crawl naar bruikbare data, .

Voor meer praktische tips en diepgaande uitleg, bezoek de .

FAQ

Wat is het verschil tussen een website crawler en een webscraper?

Een crawler ontdekt en brengt alle pagina’s van een site in kaart (denk aan een inhoudsopgave maken). Een scraper haalt specifieke gegevens (zoals prijzen, e-mails of reviews) van die pagina’s. Crawlers vinden, scrapers graven ().

Welke gratis webcrawler is het meest geschikt voor niet-technische gebruikers?

Voor kleine sites en SEO-audits is Screaming Frog gebruiksvriendelijk. Voor visuele mapping is PowerMapper ideaal (tijdens de proefperiode). Thunderbit is het makkelijkst als je gestructureerde data wilt en een no-code, browserervaring zoekt.

Zijn er websites die webcrawlers blokkeren?

Ja, sommige sites gebruiken robots.txt of anti-botmaatregelen (zoals CAPTCHAs of IP-bans) om crawlers te weren. Tools als ScraperAPI, Crawlbase en Thunderbit (met waterfall crawling) kunnen hier vaak omheen, maar crawl altijd netjes en respecteer de regels van de site ().

Hebben gratis website crawlers limieten qua pagina’s of functies?

Meestal wel. Screaming Frog’s gratis versie is bijvoorbeeld beperkt tot 500 URLs per crawl; PowerMapper’s proef tot 100 pagina’s. API-tools hebben vaak maandelijkse limieten. Open-source tools als SiteOne of Crawljax hebben meestal geen harde limieten, maar je bent afhankelijk van je eigen hardware.

Is het legaal en privacyvriendelijk om een webcrawler te gebruiken?

In het algemeen is het legaal om openbare webpagina’s te crawlen, maar check altijd de voorwaarden en robots.txt van een site. Crawl nooit privé- of afgeschermde data zonder toestemming, en let op privacywetgeving als je persoonsgegevens verzamelt ().