Heb je ooit gedacht: “Dit moet toch slimmer kunnen, al die data uit webpagina’s, spreadsheets of PDF’s halen?” Je bent zeker niet de enige. Na jaren bouwen aan automatiseringstools en praten met teams die gek worden van eindeloos knippen en plakken, weet ik: in 2025 is de hoeveelheid ongestructureerde data gigantisch—80–90% van alle nieuwe bedrijfsdata is ongestructureerd, en maar een klein deel van de bedrijven haalt er echt waarde uit (). Handmatig data verzamelen is niet alleen saai, maar ook duur, foutgevoelig en funest voor je productiviteit.

Daar komen data-extractors om de hoek kijken. Of je nu in sales, operations, e-commerce of onderzoek werkt: met het juiste hulpmiddel bespaar je uren (of zelfs dagen), verhoog je de nauwkeurigheid en kan je team zich focussen op wat er echt toe doet. Maar met zoveel tools—van AI Chrome-extensies tot no-code platforms en frameworks voor ontwikkelaars—hoe kies je de beste voor jouw situatie? Ik heb de 12 beste data-extractors van 2025 voor je op een rij gezet, met hun plus- en minpunten en wanneer je ze het beste inzet. Laten we erin duiken.

Waarom bedrijven data-extractors nodig hebben voor maximale efficiëntie

Wist je dat 94% van de bedrijven tijd verliest aan repetitieve, tijdrovende taken zoals handmatig data invoeren ()? En het gaat niet alleen om tijd—handmatig data ophalen kost gemiddeld $1.500 per medewerker per maand (). Data-extractors nemen dit saaie werk uit handen, zodat je:

- Tot 77% tijd bespaart op data verzamelen ().

- De operationele efficiëntie met 40% verhoogt ().

- De verwerkingstijd met 50% of meer verkort ().

- Tot 99,9% nauwkeurigheid behaalt bij het vastleggen van documentdata ().

Het resultaat? Snellere beslissingen, betere datakwaliteit en een blijer team. Of je nu leads verzamelt, prijzen van concurrenten volgt of data in je BI-tools laadt: een goede extractor is als een digitale collega die nooit moe wordt (en geen loonsverhoging vraagt).

Hoe kies je de beste data-extractor: Belangrijke criteria

Niet elke data-extractor is hetzelfde. Hier let ik altijd op als ik een tool aanbeveel:

- Gebruiksgemak: Kunnen niet-technische gebruikers er direct mee aan de slag? Is er AI of een klik-en-klaar setup?

- Aanpasbaarheid & Flexibiliteit: Kan de tool complexe sites, logins of dynamische content aan? Is scripting mogelijk voor gevorderden?

- Ondersteunde datatypes: Haalt het tekst, cijfers, afbeeldingen, e-mails, telefoonnummers, PDF’s, enz. op?

- Schaalbaarheid & Prestaties: Kan het duizenden pagina’s verwerken? Is er cloud- of multi-threaded scraping?

- Integratie & Automatisering: Kun je direct exporteren naar Excel, Google Sheets, Airtable, Notion of via API koppelen?

- Prijs & Waarde: Is er een gratis versie? Zijn betaalde plannen betaalbaar voor jouw gebruik?

- Support & Community: Is er goede documentatie, tutorials en snelle ondersteuning?

Verschillende teams leggen andere accenten. Sales wil vooral snel en makkelijk exporteren, ontwikkelaars zoeken juist maximale aanpasbaarheid en API-toegang.

Data-extractors voor e-commerce en marktonderzoek

Voor e-commerce en marktonderzoek draait alles om actuele data—denk aan prijsmonitoring, review-analyse en concurrentieonderzoek. Je hebt tools nodig die grootschalig kunnen scrapen, anti-botmaatregelen aankunnen en taken kunnen inplannen.

- : Bekend om de gebruiksvriendelijke no-code interface en honderden kant-en-klare templates voor o.a. Amazon en eBay. Ideaal voor prijsmonitoring en review scraping.

- : Richt zich op het integreren van webdata in BI-tools, met plannings- en wijzigingsdetectie. Perfect voor marktonderzoekers die continu data nodig hebben.

- : Enterprise-niveau, met workflow-automatisering en datatransformatie. Wordt gebruikt door grote retailers voor concurrentie-informatie en prijsanalyse.

Deze tools zijn gemaakt voor schaal en kunnen de anti-scrapingmaatregelen van grote e-commerce sites aan.

Data-extractors voor technische teams en maatwerk

Heb je ontwikkelaars in je team (of ben je zelf technisch), dan wil je maximale flexibiliteit:

- : Dé standaard voor Python-scraping. Open-source, extreem aanpasbaar en geschikt voor grote projecten. Ideaal voor het bouwen van eigen crawlers of integratie in je app.

- : Visuele workflowbouwer die dynamische, JavaScript-rijke sites aankan. Ondersteunt logica, eigen JS en API-koppelingen.

- : Cloudplatform voor het draaien van eigen scripts (“Actors”) in JavaScript of Python. Perfect voor workflow-automatisering, headless browser scraping en schaalbaarheid.

Deze tools zijn ideaal als je lastige sites wilt scrapen, meerstapsprocessen wilt automatiseren of iets wilt bouwen dat niet met een simpele kliktool kan.

Data-extractors voor data-integratie en workflow-automatisering

Sommige teams willen meer dan alleen ruwe data—ze willen het hele proces automatiseren, van extractie tot analyse:

- : Zoals eerder genoemd, blinkt uit in het integreren van webdata in BI-dashboards, met planning en API-levering.

- : Gemaakt voor end-to-end automatisering, inclusief datacleaning, transformatie en integratie met CRM’s, databases en meer.

- : Enterpriseplatform met scripting, foutafhandeling en uitgebreide integratieopties. Wordt gebruikt door grote organisaties voor kritische data-aggregatie.

Als je workflow uit meerdere stappen bestaat of je data direct in je systemen wilt laten stromen, zijn dit de extractors om te overwegen.

Vergelijkingstabel: De 12 beste data-extractors in één oogopslag

Hier een handig overzicht om snel te vergelijken:

| Toolnaam | Gebruiksgemak | Beste toepassing | Prijs | Aanpasbaarheid | Ondersteunde datatypes |

|---|---|---|---|---|---|

| Thunderbit | ⭐ Zeer makkelijk | Alle sectoren, niet-technisch | Gratis & Betaald | Low-code AI-prompts | Tekst, cijfers, data, URL’s, e-mails, telefoons, afbeeldingen, PDF’s |

| Octoparse | 🙂 Gemiddeld | E-commerce, marktonderzoek | Gratis & Betaald | Hoog (visueel, regex) | Tekst, cijfers, URL’s, afbeeldingen |

| ParseHub | 🙂 Gemiddeld | Dynamische sites, tech users | Betaald | Hoog (JS, logica) | Tekst, cijfers, URL’s, afbeeldingen |

| Import.io | 😀 Makkelijk | Data-integratie, BI | Betaald (Enterprise) | Gemiddeld | Tekst, tabellen, lijsten |

| Scrapy | 😐 Moeilijk | Maatwerk, grootschalig | Gratis (Open-source) | Zeer hoog (code) | Alles (door dev bepaald) |

| Apify | 😐 Moeilijk | Workflow-automatisering, devs | Gratis & Betaald | Zeer hoog (code) | Alle webcontent |

| Dexi.io | 🙂 Gemiddeld | Enterprise, workflow | Betaald (Enterprise) | Hoog (visueel, script) | Tekst, afbeeldingen, bestanden |

| WebHarvy | 😀 Makkelijk | Kleine bedrijven, statische sites | Eenmalige licentie | Laag-middel | Tekst, cijfers, URL’s, afbeeldingen |

| Data Miner | 😀 Makkelijk | Snel web-naar-sheet, sales | Gratis & Betaald | Gemiddeld (recepten) | Tekst, tabellen, lijsten |

| Visual Web Ripper | 🙂 Gemiddeld | Grote statische, complexe logica | Eenmalige licentie | Hoog (templates, API) | Tekst, afbeeldingen, bestanden |

| Helium Scraper | 🙂 Gemiddeld | Maatwerklogica, relationele data | Eenmalige licentie | Hoog (JS, SQL) | Tekst, URL’s, afbeeldingen, bestanden |

| Content Grabber | 🙂 Gemiddeld | Enterprise, automatisering | Betaald (Enterprise) | Zeer hoog (scripting) | Alle content, gestructureerde export |

Legenda: 😀 Makkelijk (voor niet-technische gebruikers), 🙂 Gemiddeld (enige leercurve), 😐 Moeilijk (coderen vereist)

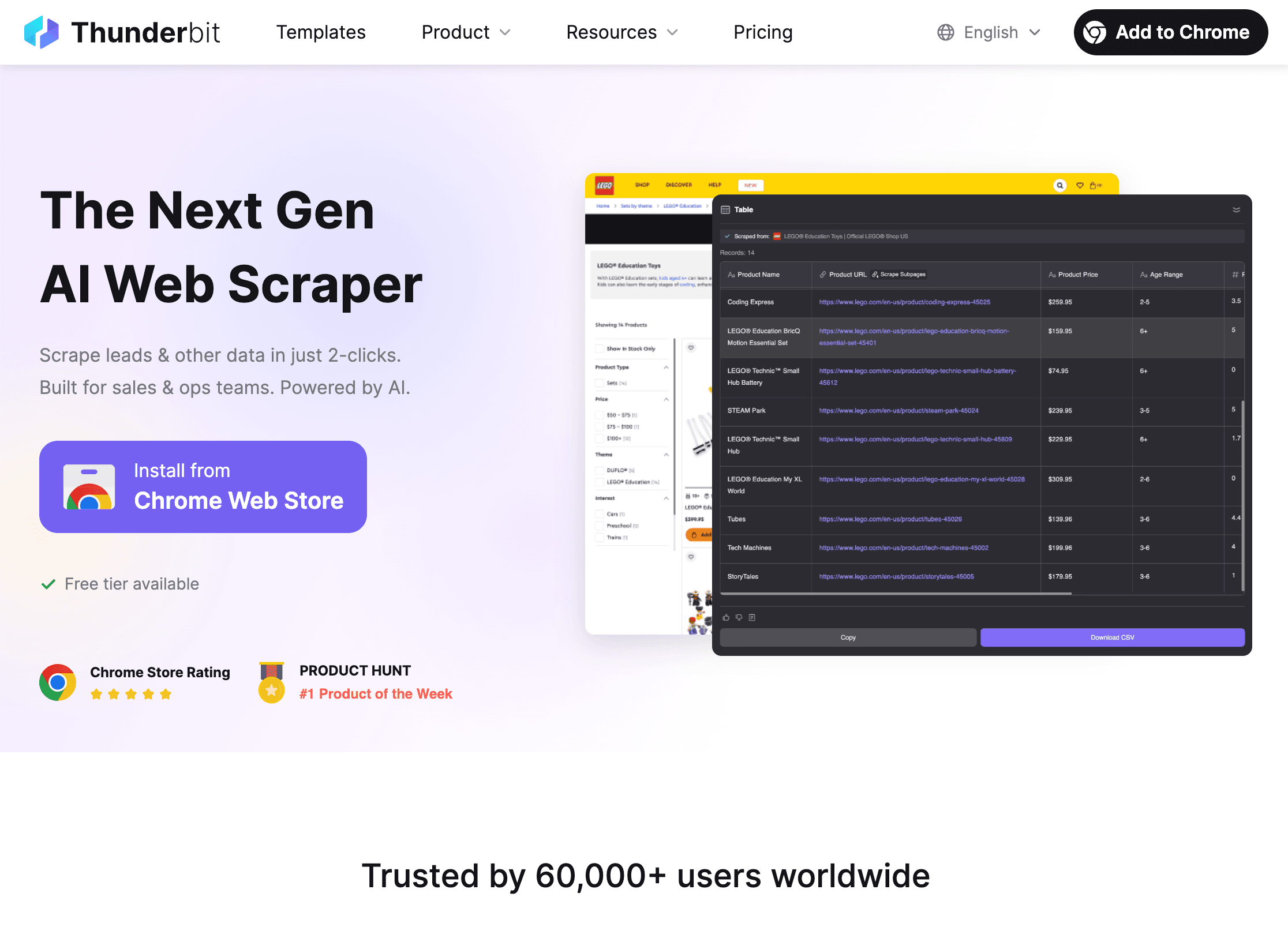

1. Thunderbit

is mijn favoriet voor niet-technische gebruikers die snel en efficiënt data willen verzamelen. Als is het ideaal voor sales, operations, vastgoed en e-commerce—je krijgt direct de data zonder gedoe.

is mijn favoriet voor niet-technische gebruikers die snel en efficiënt data willen verzamelen. Als is het ideaal voor sales, operations, vastgoed en e-commerce—je krijgt direct de data zonder gedoe.

Belangrijkste functies:

- AI Kolomsuggesties: Met één klik leest Thunderbit de pagina en stelt automatisch de beste velden voor—geen handmatig instellen nodig.

- 2-Kliks Scraping: Bevestig de velden, klik op “Scrapen” en klaar. Zelfs mijn moeder kan het (en die belt me nog als haar wifi uitvalt).

- Subpagina’s Scrapen: Meer details nodig? Thunderbit bezoekt automatisch subpagina’s (zoals product- of profielpagina’s) en vult je tabel aan.

- Gratis Data Export: Exporteer direct naar Excel, Google Sheets, Airtable of Notion—zonder extra kosten.

- Eén-klik e-mail, telefoon en afbeeldingsextractie: Ideaal voor leadgeneratie of contactinfo verzamelen.

- Cloud of Browser Scraping: Kies voor snelle cloud-scraping op openbare sites of browsermodus voor ingelogde pagina’s.

- Ondersteunt 34 talen: Perfect voor internationale teams.

Voordelen: Super eenvoudig, geen code, werkt met ongestructureerde data en past zich automatisch aan websitewijzigingen aan. Gratis voor kleine klussen, voordelige betaalde plannen voor grotere projecten.

Nadelen: Minder aanpasbaar dan ontwikkelaarstools voor extreem complexe sites. Krediet-gebaseerde prijs voor grootverbruikers.

Ideaal voor: Sales, e-commerce, makelaars en iedereen die binnen vijf minuten van “ik wil deze data” naar “hier is mijn spreadsheet” wil gaan. .

2. Octoparse

is een krachtpatser voor e-commerce en marktonderzoek. Het is een no-code desktopapp (Windows) met een visuele workflowbouwer en honderden templates voor o.a. Amazon, eBay en Zillow.

is een krachtpatser voor e-commerce en marktonderzoek. Het is een no-code desktopapp (Windows) met een visuele workflowbouwer en honderden templates voor o.a. Amazon, eBay en Zillow.

Belangrijkste functies:

- Klik-en-klaar interface: Bouw scraping-taken door simpelweg elementen aan te klikken.

- Cloud scraping & planning: Betaalde versies laten je jobs in de cloud draaien en automatisch inplannen.

- IP-rotatie & anti-bot: Omzeilt blokkades met ingebouwde proxy’s en captcha-oplossingen.

- Templatebibliotheek: 500+ kant-en-klare templates voor populaire sites.

- Meerdere niveaus & paginering: Kan complexe navigatie en detailpagina’s aan.

Voordelen: Ideaal voor grootschalige prijsmonitoring, reviewanalyse en e-commerce monitoring. Geen code nodig voor de meeste taken.

Nadelen: Alleen desktop, kan prijzig worden bij intensief gebruik, en er is een leercurve voor geavanceerde workflows.

Ideaal voor: E-commerce analisten, marktonderzoekers en iedereen die veel producten of concurrenten wil volgen.

3. ParseHub

is een flexibele visuele scraper die uitblinkt op dynamische, JavaScript-rijke sites. Het is een desktopapp (Windows, Mac, Linux) met een workflowbouwer die logica, eigen JS en API-toegang ondersteunt.

is een flexibele visuele scraper die uitblinkt op dynamische, JavaScript-rijke sites. Het is een desktopapp (Windows, Mac, Linux) met een workflowbouwer die logica, eigen JS en API-toegang ondersteunt.

Belangrijkste functies:

- Dynamische content: Werkt met single-page apps, AJAX en interactieve sites.

- Workflow & scripting: Bouw meerstapsflows, voeg eigen JS toe en gebruik regex voor precisie.

- Cloud & lokaal draaien: Draai jobs op je eigen computer of in de cloud (betaald).

- API-toegang: Integreer scraping in je eigen apps of automatiseer met webhooks.

Voordelen: Zeer aanpasbaar voor techneuten, kan lastige sites aan en ondersteunt complexe logica.

Nadelen: Trager bij grote jobs, gemiddelde leercurve, cloud runs kosten extra.

Ideaal voor: Technische analisten, ontwikkelaars of iedereen die interactieve sites wil scrapen.

4. Import.io

draait om het integreren van webdata in je business intelligence-processen. Het is een webplatform met een klik-en-klaar interface en sterke plannings- en API-functies.

draait om het integreren van webdata in je business intelligence-processen. Het is een webplatform met een klik-en-klaar interface en sterke plannings- en API-functies.

Belangrijkste functies:

- Automatische tabelherkenning: Plak een URL en Import.io probeert direct gestructureerde data te halen.

- Planning & wijzigingsdetectie: Stel jobs in op schema en ontvang meldingen bij dataveranderingen.

- API-integratie: Haal data op via API of stuur het naar je BI-tools.

- Datatransformatie: Maak en formatteer data binnen het platform.

Voordelen: Gebruiksvriendelijk, ideaal voor business analisten, sterke integratie met analysetools.

Nadelen: Enterprise-prijs, beperkt op interactieve sites, minder controle voor gevorderden.

Ideaal voor: Marktonderzoekers, business analisten en operationele teams die continu data nodig hebben.

5. Scrapy

is het open-source Python-framework waar ontwikkelaars dol op zijn. Wil je volledige controle, schaalbaarheid en eigen crawlers bouwen? Dan is Scrapy je beste vriend.

is het open-source Python-framework waar ontwikkelaars dol op zijn. Wil je volledige controle, schaalbaarheid en eigen crawlers bouwen? Dan is Scrapy je beste vriend.

Belangrijkste functies:

- Asynchrone crawling: Snel, efficiënt en geschikt voor grote projecten.

- Volledige codecontrole: Schrijf spiders in Python, pas alles aan en integreer met elk systeem.

- Middleware & plugins: Proxyrotatie, logins en uitbreidingen via de community.

- Gestructureerde output: Exporteer naar JSON, CSV, databases of eigen formaten.

Voordelen: Gratis, extreem flexibel en ondersteund door een grote community.

Nadelen: Vereist Python-kennis, geen GUI, onderhoud ligt bij jou.

Ideaal voor: Ontwikkelaars, data engineers en iedereen die scraping in eigen apps of pipelines wil bouwen.

6. Apify

is een cloudplatform voor het draaien en delen van scraping scripts (“Actors”) in JavaScript of Python. Ideaal voor automatisering, workflow chaining en schaalbaarheid in de cloud.

is een cloudplatform voor het draaien en delen van scraping scripts (“Actors”) in JavaScript of Python. Ideaal voor automatisering, workflow chaining en schaalbaarheid in de cloud.

Belangrijkste functies:

- Actors & SDK: Schrijf eigen scripts of gebruik kant-en-klare actors uit de Apify Store.

- Headless browser automatisering: Scrape dynamische sites, logins en webtaken.

- Workflow chaining: Koppel actors aan elkaar, automatiseer meerstapsprocessen.

- API & integraties: Koppel met Zapier, Make, Google Drive, AWS en meer.

Voordelen: Krachtig voor ontwikkelaars, schaalbaar en ideaal voor complexe automatisering.

Nadelen: Coderen vereist voor maatwerk, prijs op basis van gebruik, enige leercurve.

Ideaal voor: Startups, dev-teams en iedereen die grootschalig, geautomatiseerd wil scrapen in de cloud.

7. Dexi.io

(voorheen CloudScrape) is een enterprise-platform voor het automatiseren van dataverzameling en integratie. Gericht op end-to-end workflows van extractie tot transformatie en levering.

(voorheen CloudScrape) is een enterprise-platform voor het automatiseren van dataverzameling en integratie. Gericht op end-to-end workflows van extractie tot transformatie en levering.

Belangrijkste functies:

- Visuele robotdesigner: Bouw meerstapsworkflows met klik-en-klaar logica.

- Clouduitvoering & planning: Draai robots in de cloud, plan jobs en verwerk grote volumes.

- Dataverwerking & integratie: Maak, transformeer en exporteer data naar CRM’s, databases of API’s.

- Enterprise-functies: Gebruikersbeheer, compliance en on-premise opties.

Voordelen: Schaalbaar, krachtig voor complexe workflows, sterke integratie.

Nadelen: Enterprise-prijs, niet voor beginners, enige training nodig voor geavanceerd gebruik.

Ideaal voor: Grote organisaties, retail intelligence teams en iedereen die meerstapsdatapijplijnen automatiseert.

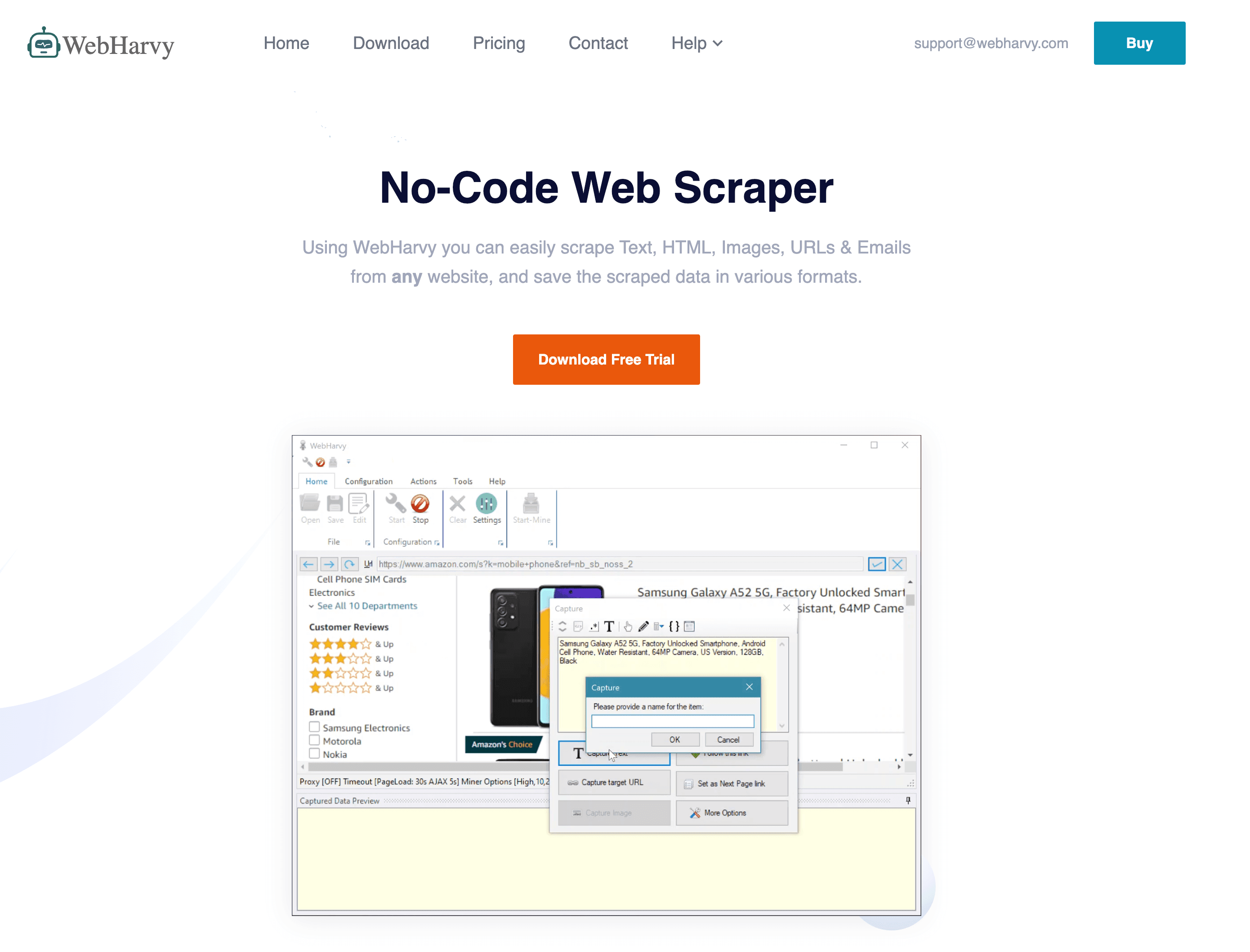

8. WebHarvy

is een Windows-desktop scraper die bekend staat om zijn pure klik-en-klaar eenvoud en eenmalige licentie.

is een Windows-desktop scraper die bekend staat om zijn pure klik-en-klaar eenvoud en eenmalige licentie.

Belangrijkste functies:

- Visuele selectie: Klik elementen aan in de ingebouwde browser om velden te definiëren.

- Automatische patroonherkenning: Herkent lijsten en tabellen automatisch.

- Afbeeldingen & bestanden downloaden: Haal afbeeldingen en documenten op naast tekst.

- Planning: Automatiseer runs via Windows Taakplanner.

Voordelen: Betaalbare eenmalige prijs, makkelijk voor simpele sites, werkt offline.

Nadelen: Moeite met zware JavaScript of anti-bot sites, alleen Windows, beperkte geavanceerde opties.

Ideaal voor: Kleine bedrijven, onderzoekers en iedereen die een budgetvriendelijke, eenvoudige scraper zoekt voor statische sites.

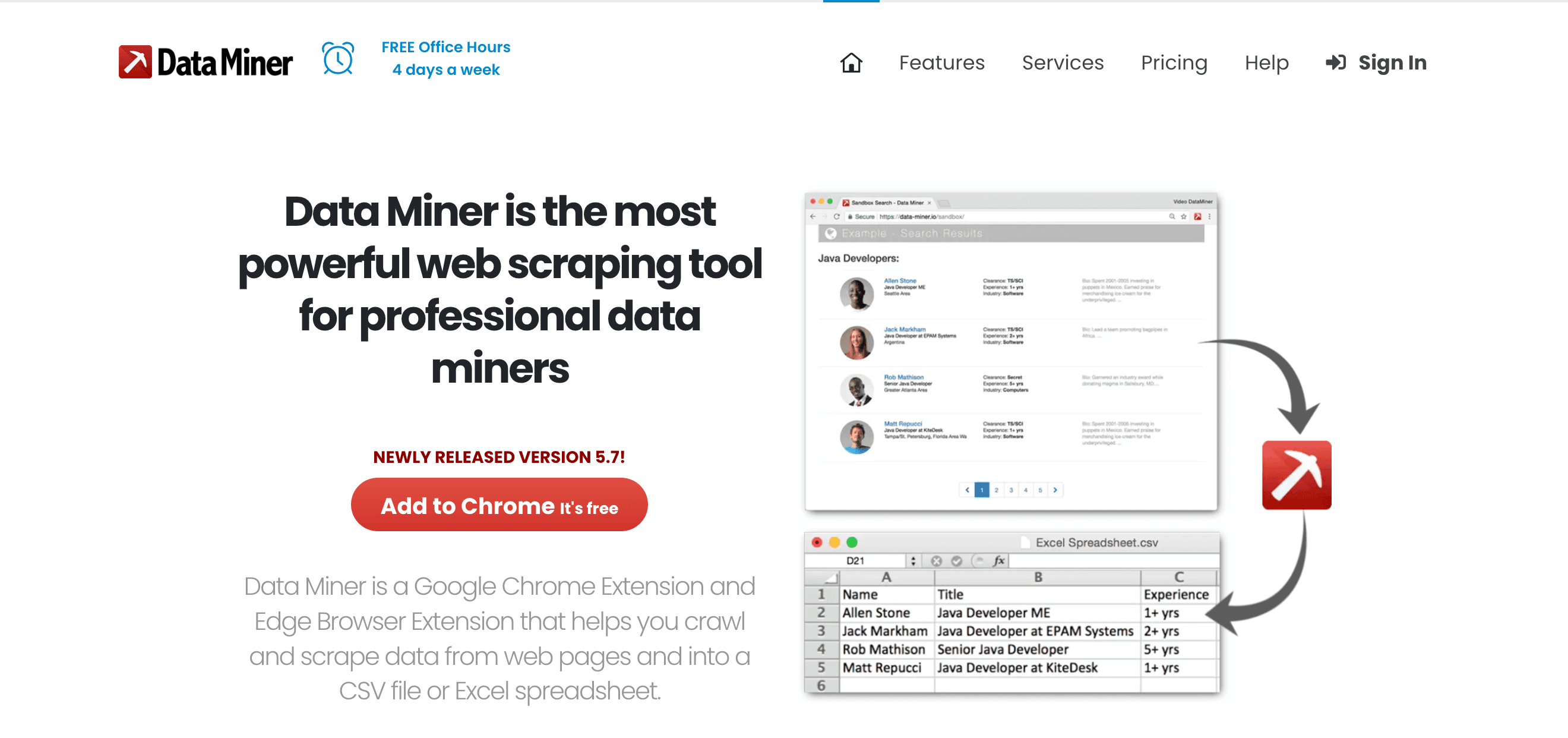

9. Data Miner

is een Chrome/Edge-extensie die ideaal is voor snelle, template-gebaseerde webdata-extractie—vooral voor sales en operations.

is een Chrome/Edge-extensie die ideaal is voor snelle, template-gebaseerde webdata-extractie—vooral voor sales en operations.

Belangrijkste functies:

- 60.000+ publieke recepten: Eén klik scraping voor populaire sites.

- Klik-en-klaar receptbouwer: Maak je eigen extractieregels.

- Directe tabelscraping: Haal HTML-tabellen of lijsten in seconden binnen.

- Direct exporteren: Stuur data naar Google Sheets, Excel of CSV.

Voordelen: Snel, browsergebaseerd, geen code, werkt goed op ingelogde sites.

Nadelen: Beperkt door browsersnelheid, paginalimieten op gratis/betaalde plannen, niet geschikt voor enorme jobs.

Ideaal voor: Sales, snelle research en iedereen die een “Exporteer naar Excel”-knop voor het web wil.

10. Visual Web Ripper

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

is een uitgebreide desktopoplossing voor grootschalige webdata-extractie, met focus op templateprojecten en automatisering.

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

is een uitgebreide desktopoplossing voor grootschalige webdata-extractie, met focus op templateprojecten en automatisering.

Belangrijkste functies:

- Template- & projectsysteem: Ontwerp meerlaagse crawls met templates.

- Geavanceerde opties: Regex, XPath en debugging voor complexe sites.

- Export naar databases: Directe output naar SQL, Excel, XML en meer.

- Automatisering: Plan jobs en draai multi-threaded extracties.

Voordelen: Krachtig voor complexe, statische sites; eenmalige licentie; ondersteunt geavanceerde logica.

Nadelen: Verouderde interface, alleen Windows, minder geschikt voor moderne dynamische sites.

Ideaal voor: Consultants, bureaus en power users die grote, gestructureerde scrapingprojecten beheren.

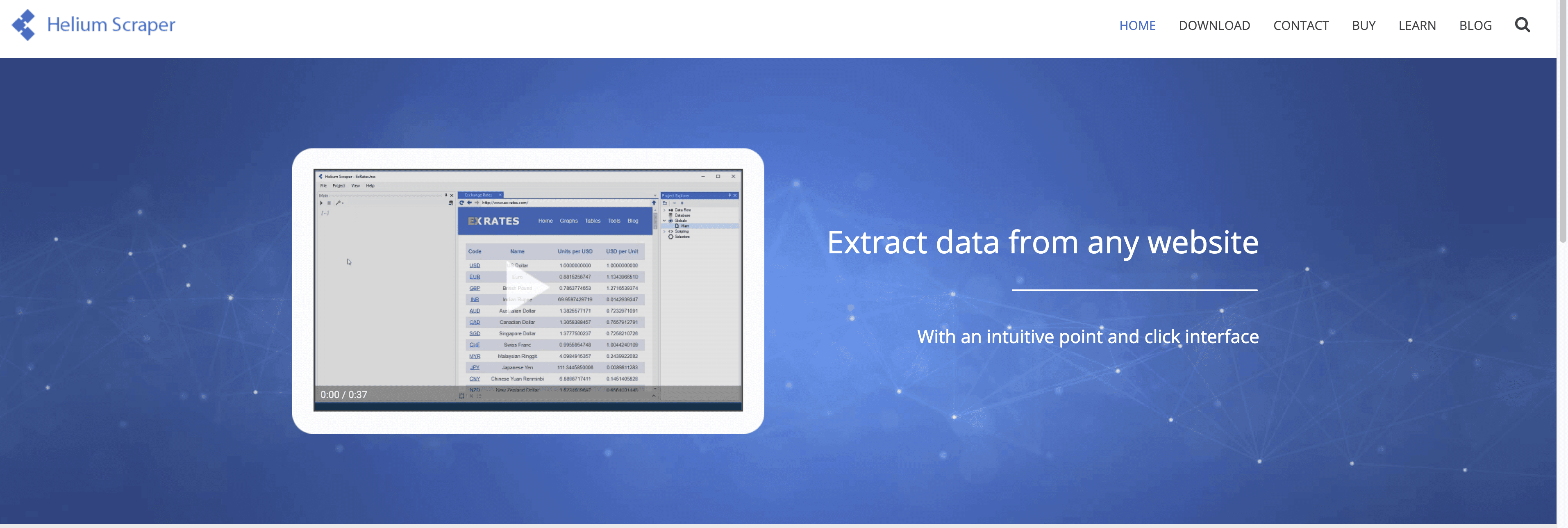

11. Helium Scraper

is een Windows-app die drag-and-drop eenvoud combineert met diepe aanpasbaarheid.

is een Windows-app die drag-and-drop eenvoud combineert met diepe aanpasbaarheid.

Belangrijkste functies:

- Kinds & Actions-model: Definieer datapatronen visueel, stel acties in voor extractie.

- Meerdere niveaus & relationele data: Output ouder-kindrelaties, voer SQL-queries uit op gescrapete data.

- Eigen scripting: Voeg JavaScript of SQL toe voor geavanceerde logica.

- Multi-threading: Scrape meerdere pagina’s tegelijk voor snelheid.

Voordelen: Flexibel, ondersteunt complexe datastructuren, betaalbare eenmalige prijs.

Nadelen: Leercurve voor het “Kinds”-concept, alleen Windows, minder mainstream support.

Ideaal voor: Analisten en techliefhebbers die meer willen dan simpele kliktools, maar niet helemaal zelf willen coderen.

12. Content Grabber

is een enterpriseplatform voor grootschalige, geautomatiseerde data-extractie en integratie.

is een enterpriseplatform voor grootschalige, geautomatiseerde data-extractie en integratie.

Belangrijkste functies:

- Visuele agent-editor: Bouw scraping agents met klik-en-klaar, voeg C# of VB.NET toe voor maatwerk.

- Enterprise planning & monitoring: Centrale controle, foutafhandeling en notificaties.

- On-premise deployment: Houd data in eigen beheer voor compliance.

- API & integratie: Exporteer naar databases, API’s en message queues.

Voordelen: Extreem krachtig, schaalbaar en geschikt voor kritische workflows.

Nadelen: Duur, complex en vooral geschikt voor organisaties met een eigen IT-team.

Ideaal voor: Grote bedrijven, dataproviders en iedereen die webdata-extractie als kernproces ziet.

Welke data-extractor past bij jou? Gebruiksscenario’s en aanbevelingen

- Sales leadgeneratie: (AI, makkelijk exporteren), (browser, snelle recepten).

- E-commerce monitoring: (templates, planning), (enterprise, integratie).

- Technisch maatwerk: (Python, open-source), (cloud, workflow-automatisering), (visueel, dynamische sites).

- Data-integratie & automatisering: (BI-workflows), (enterprise, on-premise).

- Snelle, kleinschalige taken: (klik-en-klaar, eenmalige prijs), (drag-and-drop, maatwerklogica).

Tip: De meeste tools bieden gratis proefversies—test er een paar uit op je eigen datavraagstuk voordat je kiest.

Conclusie: Haal maximale efficiëntie met de juiste data-extractor

Handmatig data verzamelen is echt verleden tijd. Met de juiste data-extractor automatiseer je uren werk, verhoog je de nauwkeurigheid en neem je betere beslissingen—of je nu zzp’er bent, in een salesteam werkt of een Fortune 500-bedrijf runt. Het draait om de juiste tool voor jouw situatie, technische kennis en budget.

Wil je razendsnel van “ik heb deze data nodig” naar “het staat in mijn spreadsheet”? is een uitstekend startpunt. Maar wat je behoefte ook is, er staat een tool in deze lijst die je slimmer laat werken.

Klaar om je dataprocessen te verbeteren? Probeer een paar van deze extractors en ontdek hoeveel tijd (en frustratie) je bespaart.

Veelgestelde vragen

1. Wat is een data-extractor en waarom heb ik er een nodig?

Een data-extractor automatiseert het verzamelen van gestructureerde informatie van websites, documenten of databases. Het bespaart tijd, voorkomt fouten en laat je focussen op analyse in plaats van handmatig kopiëren en plakken.

2. Welke data-extractor is het beste voor niet-technische gebruikers?

springt eruit dankzij AI, 2-klik setup en natuurlijke taalprompts. Speciaal ontworpen voor zakelijke gebruikers die snel resultaat willen zonder code of ingewikkelde instellingen.

3. Kunnen data-extractors omgaan met dynamische of JavaScript-rijke websites?

Ja—tools als , en (met headless browser support) zijn uitstekend voor dynamische en interactieve sites.

4. Hoe kies ik tussen een gratis en betaalde data-extractor?

Gratis tools zijn prima voor kleine, incidentele klussen. Voor doorlopende, grootschalige of kritische taken bieden betaalde plannen meer functies, hogere limieten en betere support. Begin altijd met een gratis proefversie om te testen.

5. Is het legaal om data-extractors te gebruiken?

In het algemeen is het verzamelen van publiek beschikbare data toegestaan, maar controleer altijd de gebruiksvoorwaarden van de website en respecteer privacywetgeving. Voor gevoelige of persoonlijke data: zorg voor naleving van regels zoals de AVG.

Meer tips over webscraping, automatisering en productiviteit? Bekijk de voor diepgaande artikelen, tutorials en het laatste nieuws over AI-gedreven data-extractie.

Meer weten