Het internet is allang niet meer alleen een digitale speeltuin—het is nu de grootste databron ter wereld, waar iedereen van sales tot marktonderzoekers op jaagt. Maar laten we eerlijk zijn: handmatig webdata verzamelen is ongeveer net zo frustrerend als een IKEA-kast in elkaar zetten zonder handleiding (en met een paar schroeven over). Nu bedrijven steeds meer vertrouwen op actuele marktinzichten, concurrerende prijzen en leadgeneratie, is de vraag naar efficiënte en betrouwbare webscrapingtools groter dan ooit. Wist je dat inmiddels voor hun beslissingen? De wereldwijde webscrapingmarkt zal naar verwachting zelfs .

Ben je het zat om eindeloos te kopiëren en plakken, mis je nieuwe leads, of ben je gewoon benieuwd wat er allemaal mogelijk is als je automatisering het werk laat doen? Dan zit je hier helemaal goed. Na jaren bouwen en testen van webscrapingtools (en ja, als leider van het team bij ), weet ik als geen ander hoe de juiste tool uren werk kan omtoveren tot een klus van twee klikken. Of je nu geen programmeerkennis hebt en direct resultaat wilt, of juist als ontwikkelaar volledige controle zoekt: deze top 10 data crawling tools helpen je gegarandeerd verder.

Waarom de juiste data crawling tool kiezen zo belangrijk is

Laten we eerlijk zijn: het verschil tussen een goede en een matige data crawling tool is niet alleen gemak—het heeft direct impact op je bedrijfsresultaat. Door webextractie te automatiseren, bespaar je niet alleen tijd (een G2-reviewer meldde zelfs te besparen), je voorkomt ook fouten, ontdekt nieuwe kansen en zorgt dat je team altijd werkt met de meest actuele en betrouwbare data. Handmatig onderzoek is traag, foutgevoelig en vaak alweer achterhaald als je klaar bent. Met de juiste tool kun je concurrenten volgen, prijzen monitoren of leadlijsten bouwen in minuten—niet dagen.

Een praktijkvoorbeeld: een cosmeticawinkel gebruikte webscraping om voorraad en prijzen van concurrenten te volgen, en . Dat bereik je niet met spreadsheets en handwerk.

Hoe we de beste data crawling tools hebben beoordeeld

Met zoveel opties voelt de juiste tool kiezen soms als speeddaten op een techbeurs. Dit zijn de criteria die ik heb gebruikt om de toppers te selecteren:

- Gebruiksgemak: Kun je direct aan de slag zonder programmeerkennis? Is er een visuele interface of AI-hulp voor niet-programmeurs?

- Automatisering: Kan de tool omgaan met paginering, subpagina’s, dynamische content en planningen? Werkt het in de cloud voor grote klussen?

- Prijs en schaalbaarheid: Is er een gratis versie of instapabonnement? Hoe groeit de prijs mee met je databehoefte?

- Functies en integraties: Kun je exporteren naar Excel, Google Sheets of via API? Zijn er sjablonen, planningen of ingebouwde datacleaning?

- Voor wie: Is de tool bedoeld voor zakelijke gebruikers, ontwikkelaars of grote teams?

Achteraan vind je een handige vergelijkingstabel om de tools snel naast elkaar te zetten.

Laten we nu de top 10 beste data crawling tools voor efficiënte webextractie in 2025 bekijken.

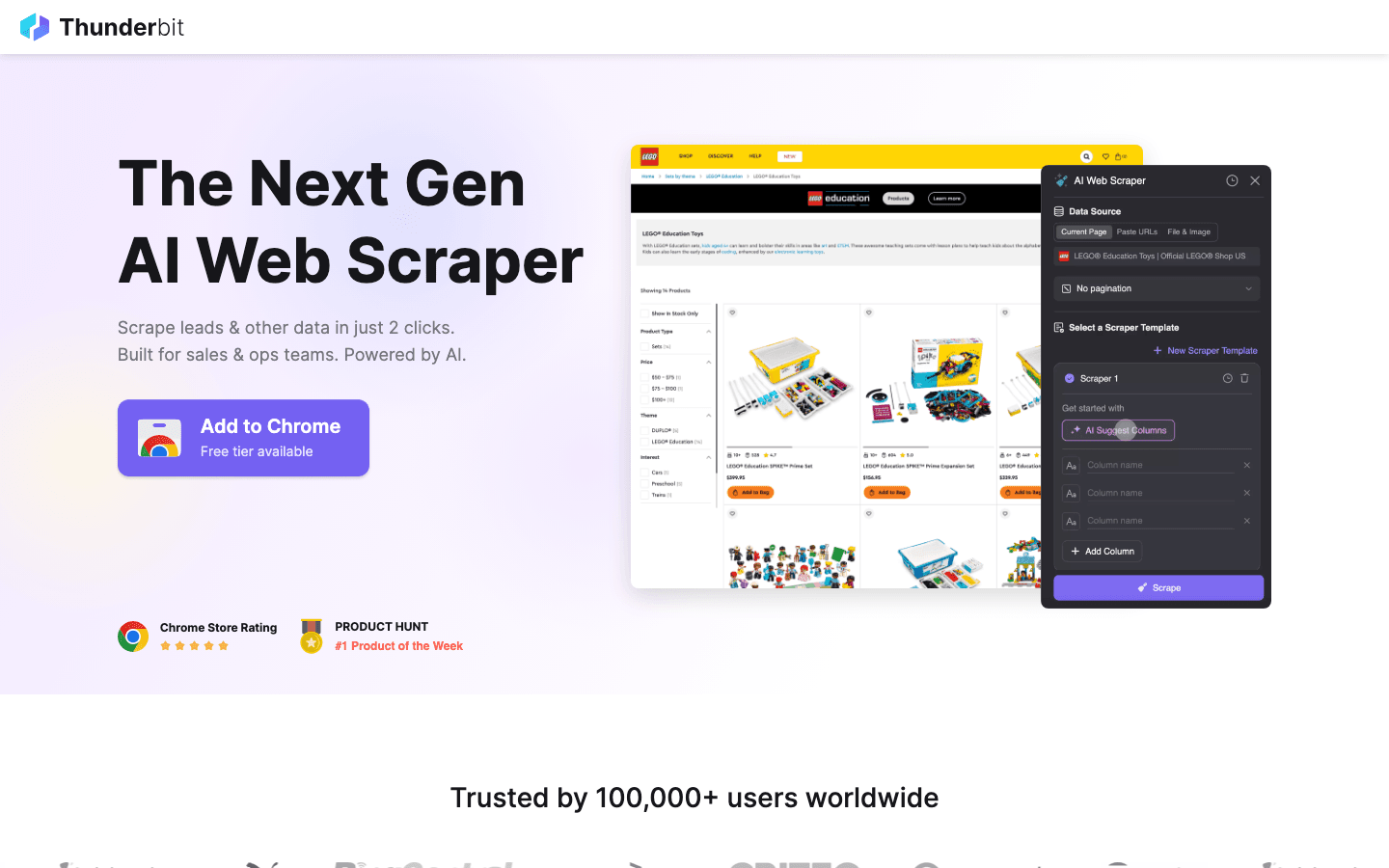

1. Thunderbit

is mijn absolute aanrader voor iedereen die webscraping net zo makkelijk wil maken als eten bestellen. Deze AI-webscraper werkt als een Chrome-extensie en draait om scrapen in 2 klikken: klik op “AI Suggest Fields” en de AI herkent automatisch de relevante data op de pagina, daarna op “Scrape” om alles op te halen. Geen code, geen gedoe met selectors—gewoon direct resultaat.

is mijn absolute aanrader voor iedereen die webscraping net zo makkelijk wil maken als eten bestellen. Deze AI-webscraper werkt als een Chrome-extensie en draait om scrapen in 2 klikken: klik op “AI Suggest Fields” en de AI herkent automatisch de relevante data op de pagina, daarna op “Scrape” om alles op te halen. Geen code, geen gedoe met selectors—gewoon direct resultaat.

Waarom is Thunderbit zo populair bij sales-, marketing- en e-commerceteams? Het sluit perfect aan op dagelijkse bedrijfsprocessen:

- AI Suggest Fields: De AI leest de pagina en stelt automatisch de beste kolommen voor—namen, prijzen, e-mails, noem maar op.

- Subpagina’s scrapen: Meer details nodig? Thunderbit bezoekt automatisch subpagina’s (zoals productdetails of LinkedIn-profielen) en verrijkt je tabel.

- Direct exporteren: Stuur je data direct naar Excel, Google Sheets, Airtable of Notion. Alle exports zijn gratis.

- One-click sjablonen: Voor populaire sites (Amazon, Zillow, Instagram) zijn er kant-en-klare sjablonen voor supersnel resultaat.

- Gratis data-export: Je data ophalen is altijd gratis.

- Geplande scraping: Stel terugkerende taken in met gewone taal (“elke maandag om 9 uur”)—ideaal voor prijsmonitoring of wekelijkse leads.

Thunderbit werkt met een creditsysteem (1 credit = 1 rij), met een tot 6 pagina’s (of 10 met een proefboost). Betaalde abonnementen starten vanaf $15/maand voor 500 credits, dus geschikt voor elk team.

Wil je Thunderbit in actie zien? Bekijk ons of de . Dit is de tool die ik vroeger zelf had willen hebben toen ik nog handmatig data invoerde.

2. Octoparse

is een zwaargewicht in de wereld van webscraping, vooral voor bedrijven die veel kracht nodig hebben. Het biedt een visuele desktopinterface (Windows en Mac) waarmee je met aanwijzen en klikken extractieworkflows bouwt—zonder te programmeren. Maar vergis je niet: onder de motorkap regelt Octoparse logins, oneindig scrollen, proxyrotatie en zelfs CAPTCHA’s.

is een zwaargewicht in de wereld van webscraping, vooral voor bedrijven die veel kracht nodig hebben. Het biedt een visuele desktopinterface (Windows en Mac) waarmee je met aanwijzen en klikken extractieworkflows bouwt—zonder te programmeren. Maar vergis je niet: onder de motorkap regelt Octoparse logins, oneindig scrollen, proxyrotatie en zelfs CAPTCHA’s.

- 500+ kant-en-klare sjablonen: Start direct met sjablonen voor Amazon, Twitter, LinkedIn en meer.

- Cloudscraping: Draai taken op de servers van Octoparse, plan ze in en schaal op voor grote projecten.

- API-toegang: Integreer gescrapete data direct in je bedrijfsapps of databases.

- Geavanceerde automatisering: Kan omgaan met dynamische content, paginering en meerstapsworkflows.

Er is een voor maximaal 10 taken, maar de meeste bedrijven kiezen voor het Standard-abonnement (~$83/maand) of Professional (~$299/maand). De leercurve is wat steiler dan bij Thunderbit, maar voor grootschalige, betrouwbare scraping is Octoparse een topkeuze.

3. Scrapy

is dé standaard voor ontwikkelaars die volledige controle willen over hun scrapingprojecten. Het is een open-source Python-framework waarmee je zelf spiders (crawlers) programmeert voor elke website. Alles wat je kunt bedenken, kun je bouwen met Scrapy.

is dé standaard voor ontwikkelaars die volledige controle willen over hun scrapingprojecten. Het is een open-source Python-framework waarmee je zelf spiders (crawlers) programmeert voor elke website. Alles wat je kunt bedenken, kun je bouwen met Scrapy.

- Volledige programmeerbaarheid: Schrijf Python-code om precies te bepalen hoe je crawlt en data ophaalt.

- Snel en asynchroon: Scrapy verwerkt duizenden pagina’s tegelijk—ideaal voor grote projecten.

- Uitbreidbaar: Voeg middleware toe voor proxies, headless browsers of eigen logica.

- Sterke community: Veel tutorials, plugins en hulp bij lastige scrapingklussen.

Scrapy is gratis en open-source, maar vereist wel programmeerkennis. Heb je een technisch team of wil je een eigen datastroom bouwen, dan is Scrapy onovertroffen. Voor niet-programmeurs is het echter een flinke uitdaging.

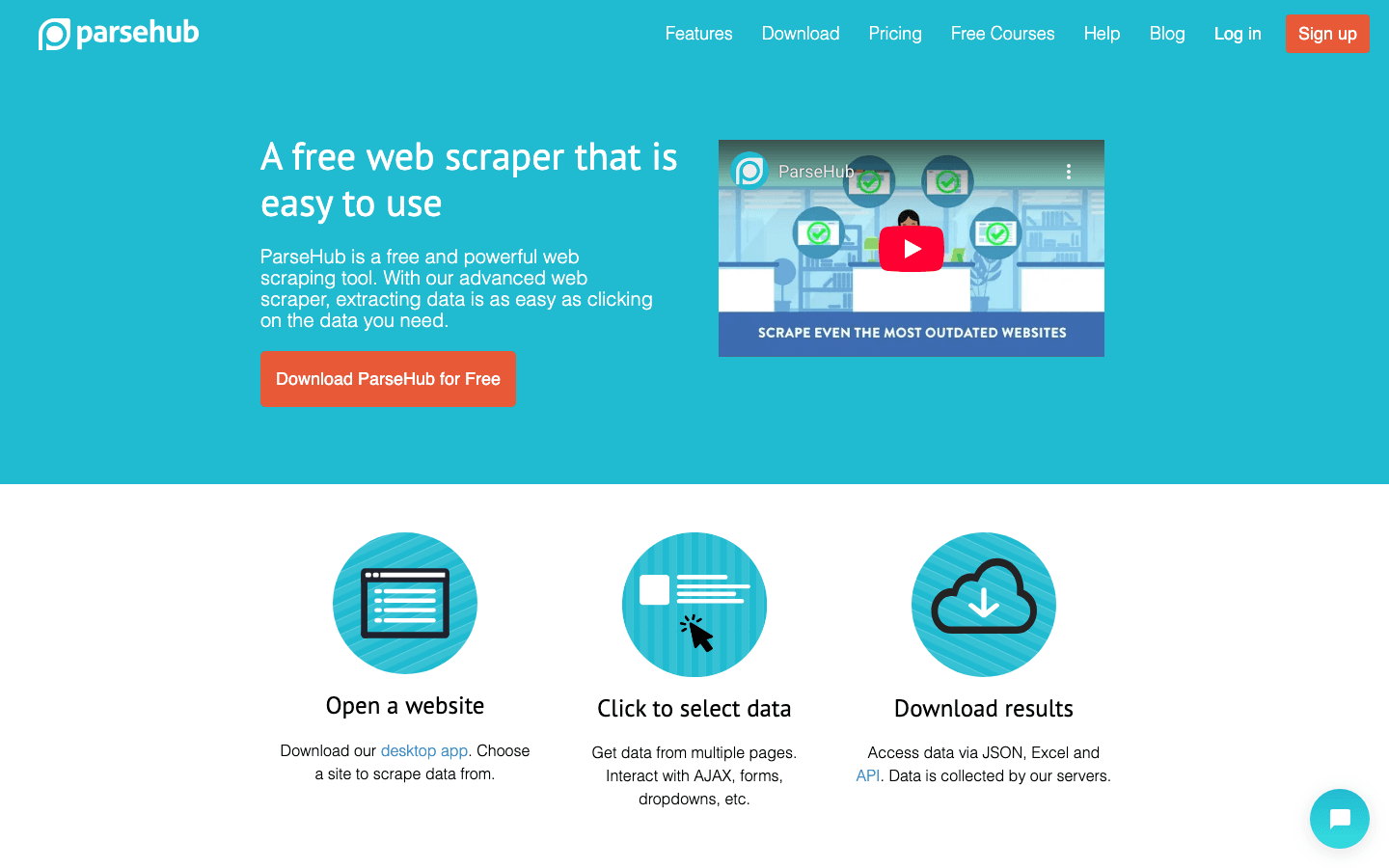

4. ParseHub

is een visuele, no-code webscraper die ideaal is voor niet-programmeurs die complexe websites willen aanpakken. Met de point-and-click interface selecteer je eenvoudig elementen, stel je acties in en bouw je scrapingworkflows—ook voor sites met dynamische content of lastige navigatie.

is een visuele, no-code webscraper die ideaal is voor niet-programmeurs die complexe websites willen aanpakken. Met de point-and-click interface selecteer je eenvoudig elementen, stel je acties in en bouw je scrapingworkflows—ook voor sites met dynamische content of lastige navigatie.

- Visuele workflowbouwer: Klik om data te selecteren, stel paginering in en handel pop-ups of dropdowns af.

- Dynamische content: Werkt met JavaScript-rijke en interactieve pagina’s.

- Cloudruns & planning: Draai scrapes in de cloud en plan terugkerende taken.

- Export naar CSV, Excel of via API: Eenvoudige integratie met je favoriete tools.

ParseHub heeft een gratis plan (5 projecten), met betaalde plannen vanaf . Het is wat duurder dan sommige concurrenten, maar de visuele aanpak maakt het toegankelijk voor analisten, marketeers en onderzoekers die meer willen dan een simpele extensie.

5. Apify

is zowel een platform als een marktplaats voor webscraping. Je vindt er een enorme bibliotheek met kant-en-klare “Actors” (scrapers) voor populaire sites, maar je kunt ook zelf geavanceerde crawlers bouwen en draaien in de cloud.

is zowel een platform als een marktplaats voor webscraping. Je vindt er een enorme bibliotheek met kant-en-klare “Actors” (scrapers) voor populaire sites, maar je kunt ook zelf geavanceerde crawlers bouwen en draaien in de cloud.

- 5.000+ kant-en-klare Actors: Scrape direct Google Maps, Amazon, Twitter en meer.

- Eigen scripting: Ontwikkelaars kunnen JavaScript of Python gebruiken voor maatwerk.

- Cloudschaalbaarheid: Draai taken parallel, plan ze in en beheer data in de cloud.

- API & integratie: Koppel resultaten aan je apps, workflows of datastromen.

Apify heeft een flexibel , met betaalde abonnementen vanaf $29/maand (pay-as-you-go voor rekentijd). Er is een kleine leercurve, maar voor plug-and-play én volledige aanpasbaarheid is Apify erg krachtig.

6. Data Miner

is een Chrome-extensie voor snelle, sjabloongebaseerde webscraping. Ideaal voor zakelijke gebruikers die snel data uit tabellen of lijsten willen halen zonder gedoe.

is een Chrome-extensie voor snelle, sjabloongebaseerde webscraping. Ideaal voor zakelijke gebruikers die snel data uit tabellen of lijsten willen halen zonder gedoe.

- Grote sjabloonbibliotheek: Meer dan duizend recepten voor bekende sites (LinkedIn, Yelp, enz.).

- Point-and-click extractie: Kies een sjabloon, bekijk de data en exporteer direct.

- Browsergebaseerd: Werkt met je huidige sessie—ook achter logins.

- Export naar CSV of Excel: Zet je data in seconden in een spreadsheet.

Het dekt 500 pagina’s per maand, met betaalde plannen vanaf $20/maand. Perfect voor kleine, eenmalige klussen of als je direct data nodig hebt—verwacht alleen geen grootschalige automatisering.

7. Import.io

is een platform op enterpriseniveau voor organisaties die continu betrouwbare webdata-integratie nodig hebben. Het is meer dan een scraper—het is een managed service die schone, gestructureerde data direct in je bedrijfsprocessen levert.

is een platform op enterpriseniveau voor organisaties die continu betrouwbare webdata-integratie nodig hebben. Het is meer dan een scraper—het is een managed service die schone, gestructureerde data direct in je bedrijfsprocessen levert.

- No-code extractie: Visueel instellen welke data je wilt ophalen.

- Realtime datafeeds: Stroom data direct naar dashboards, analysetools of databases.

- Compliance & betrouwbaarheid: Regelt IP-rotatie, anti-botmaatregelen en juridische naleving.

- Managed services: Het team van Import.io kan je scrapers opzetten en onderhouden.

De prijs is , met een gratis proefperiode van 14 dagen. Als je bedrijf afhankelijk is van altijd actuele webdata (denk aan retail, finance of marktonderzoek), is Import.io het overwegen waard.

8. WebHarvy

is een desktop-scraper voor Windows-gebruikers die een point-and-click oplossing willen zonder abonnement. Vooral populair bij kleine bedrijven en particulieren die liever eenmalig betalen.

is een desktop-scraper voor Windows-gebruikers die een point-and-click oplossing willen zonder abonnement. Vooral populair bij kleine bedrijven en particulieren die liever eenmalig betalen.

- Visuele patroonherkenning: Klik op data-elementen en WebHarvy herkent automatisch herhalende patronen.

- Tekst, afbeeldingen en meer: Haalt alle gangbare datatypes op, inclusief e-mails en URL’s.

- Paginering & planning: Navigeer door meerpagina-sites en stel geplande scrapes in.

- Export naar Excel, CSV, XML, JSON of SQL: Flexibele output voor elk proces.

Een single-user licentie kost , wat het een voordelige keuze maakt voor regelmatig gebruik—let wel, alleen voor Windows.

9. Mozenda

is een cloudgebaseerd webscrapingplatform voor bedrijven die continu data nodig hebben. Het combineert een desktopdesigner (Windows) met krachtige clouduitvoering en automatisering.

is een cloudgebaseerd webscrapingplatform voor bedrijven die continu data nodig hebben. Het combineert een desktopdesigner (Windows) met krachtige clouduitvoering en automatisering.

- Visuele agentbouwer: Ontwerp extractieroutines met een point-and-click interface.

- Cloudschaalbaarheid: Draai meerdere agents tegelijk, plan taken en beheer data centraal.

- Databeheerconsole: Combineer, filter en schoon datasets na extractie.

- Enterprise support: Toegewijde accountmanagers en managed services voor grote teams.

Abonnementen starten vanaf , met hogere niveaus voor meer gebruikers en capaciteit. Mozenda is ideaal voor bedrijven die betrouwbare, herhaalbare webdata nodig hebben als onderdeel van hun dagelijkse processen.

10. BeautifulSoup

is de klassieke Python-bibliotheek voor het parsen van HTML en XML. Het is geen volledige crawler, maar geliefd bij ontwikkelaars voor kleinschalige, maatwerk scrapingprojecten.

is de klassieke Python-bibliotheek voor het parsen van HTML en XML. Het is geen volledige crawler, maar geliefd bij ontwikkelaars voor kleinschalige, maatwerk scrapingprojecten.

- Eenvoudig HTML parsen: Haal makkelijk data uit statische webpagina’s.

- Werkt met Python Requests: Combineer met andere libraries voor ophalen en crawlen.

- Flexibel & lichtgewicht: Ideaal voor snelle scripts of educatieve projecten.

- Grote community: Veel tutorials en antwoorden op Stack Overflow.

BeautifulSoup is , maar je moet zelf code schrijven en de crawlinglogica regelen. Het is vooral geschikt voor ontwikkelaars of wie de basis van webscraping wil leren.

Vergelijkingstabel: Data crawling tools in één oogopslag

| Tool | Gebruiksgemak | Automatiseringsniveau | Prijs | Exportopties | Beste keuze voor |

|---|---|---|---|---|---|

| Thunderbit | Zeer eenvoudig, no-code | Hoog (AI, subpagina’s) | Gratis proef, vanaf $15/mnd | Excel, Sheets, Airtable, Notion, CSV | Sales, marketing, e-commerce, niet-programmeurs |

| Octoparse | Gemiddeld, visuele UI | Zeer hoog, cloud | Gratis, $83–$299/mnd | CSV, Excel, JSON, API | Bedrijven, datateams, dynamische sites |

| Scrapy | Laag (Python vereist) | Hoog (aanpasbaar) | Gratis, open-source | Alles (via code) | Ontwikkelaars, grootschalige maatwerkprojecten |

| ParseHub | Hoog, visueel | Hoog (dynamische sites) | Gratis, vanaf $189/mnd | CSV, Excel, JSON, API | Niet-programmeurs, complexe webstructuren |

| Apify | Gemiddeld, flexibel | Zeer hoog, cloud | Gratis, $29–$999/mnd | CSV, JSON, API, cloudopslag | Devs, bedrijven, kant-en-klare of maatwerk actors |

| Data Miner | Zeer eenvoudig, browser | Laag (handmatig) | Gratis, $20–$99/mnd | CSV, Excel | Snel, eenmalige extracties, kleine datasets |

| Import.io | Gemiddeld, managed | Zeer hoog, enterprise | Maatwerk, volumegebaseerd | CSV, JSON, API, directe integratie | Bedrijven, continue dataintegratie |

| WebHarvy | Hoog, desktop | Gemiddeld (planning) | $129 eenmalig | Excel, CSV, XML, JSON, SQL | MKB, Windows-gebruikers, regelmatig scrapen |

| Mozenda | Gemiddeld, visueel | Zeer hoog, cloud | $250–$450+/mnd | CSV, Excel, JSON, cloud, DB | Doorlopende, grootschalige bedrijfsprocessen |

| BeautifulSoup | Laag (Python vereist) | Laag (handmatig coderen) | Gratis, open-source | Alles (via code) | Ontwikkelaars, studenten, kleine maatwerkscripts |

Hoe kies je de juiste data crawling tool voor jouw team?

De beste tool is niet per se de krachtigste, maar die welke past bij de vaardigheden, behoeften en het budget van jouw team. Mijn advies:

- Niet-programmeurs of zakelijke gebruikers: Begin met Thunderbit, ParseHub of Data Miner voor direct resultaat en eenvoudige installatie.

- Enterprise of grootschalige behoeften: Kijk naar Octoparse, Mozenda of Import.io voor automatisering, planning en support.

- Ontwikkelaars of maatwerkprojecten: Scrapy, Apify of BeautifulSoup bieden volledige controle en flexibiliteit.

- Budgetvriendelijk of eenmalige klussen: WebHarvy (Windows) of Data Miner (browser) zijn voordelig en simpel.

Test altijd je favorieten met een gratis proefversie op je echte doelwebsites—wat werkt op de ene site, werkt niet altijd op de andere. En denk aan integratie: als je data in Sheets, Notion of een database nodig hebt, check dan of je tool dat standaard ondersteunt.

Conclusie: Meer waarde uit je business met de beste data crawling tools

Webdata is het nieuwe goud—maar alleen als je de juiste tools hebt om het te winnen en te verfijnen. Met moderne data crawling tools verander je uren handmatig werk in minuten aan geautomatiseerd inzicht. Zo werk je slimmer in sales, marketing en operations. Of je nu leads bouwt, concurrenten volgt of gewoon klaar bent met kopiëren en plakken: er is altijd een tool die je werk makkelijker maakt.

Bekijk dus goed wat jouw team nodig heeft, probeer een paar tools uit en ontdek hoeveel meer je kunt bereiken als je automatisering het zware werk laat doen. Wil je zien hoe AI-gestuurd, scrapen in 2 klikken eruitziet? . Veel succes met scrapen—en moge je data altijd actueel, gestructureerd en klaar voor gebruik zijn.

Veelgestelde vragen

1. Wat is een data crawling tool en waarom heb ik er een nodig?

Een data crawling tool automatiseert het verzamelen van informatie van websites. Het bespaart tijd, voorkomt fouten en helpt teams om actuele data te verzamelen voor sales, marketing, onderzoek en operations—veel efficiënter dan handmatig kopiëren en plakken.

2. Welke data crawling tool is het beste voor niet-technische gebruikers?

Thunderbit, ParseHub en Data Miner zijn toppers voor niet-programmeurs. Thunderbit blinkt uit door de 2-klik AI-workflow, terwijl ParseHub een visuele aanpak biedt voor complexere sites.

3. Hoe verschillen de prijsmodellen van data crawling tools?

De prijzen lopen uiteen: sommige tools (zoals Thunderbit en Data Miner) bieden gratis versies en betaalbare maandabonnementen, terwijl enterprise-platforms (zoals Import.io en Mozenda) werken met maatwerk- of volumebased prijzen. Kijk altijd of de prijs past bij je databehoefte.

4. Kan ik deze tools gebruiken voor doorlopende, geplande data-extractie?

Ja—tools als Thunderbit, Octoparse, Apify, Mozenda en Import.io ondersteunen geplande of terugkerende scrapes. Ideaal voor prijsmonitoring, leadgeneratie of marktonderzoek.

5. Waar moet ik op letten bij het kiezen van een data crawling tool?

Let op de technische vaardigheden van je team, de complexiteit van de sites die je wilt scrapen, het datavolume, integratiebehoeften en je budget. Test een paar tools met je echte taken voordat je een betaald abonnement neemt.

Meer praktische tips en verdiepende artikelen vind je op de .

Meer weten?