Het internet groeit tegenwoordig zo hard dat zelfs de meest ervaren data-analist er tureluurs van wordt. Naar verwachting zal de , vooral omdat bedrijven steeds meer behoefte hebben aan actuele, bruikbare data. Maar er is een uitdaging: traditioneel scrapen is vaak frustrerend—scripts crashen, anti-botbeveiliging wordt steeds slimmer, en als je geen programmeur bent, ben je eindeloos aan het knippen en plakken. Gelukkig zijn er nu AI-webscrapingtools die het verzamelen van data veranderen van een technisch obstakel in een productiviteitsboost voor sales, operations en iedereen die webdata nodig heeft om betere keuzes te maken.

Na jarenlange ervaring in SaaS en automatisering heb ik zelf gezien hoe AI-webscraping alles op z’n kop zet. Of je nu een lijst met leads samenstelt, concurrenten in de gaten houdt of je spreadsheets up-to-date wilt houden: met de juiste tool bespaar je uren werk (en misschien wat grijze haren). Daarom heb ik de 10 beste AI-webscrapingtools voor 2026 op een rij gezet—van no-code oplossingen tot favorieten onder developers, zodat je makkelijk de beste keuze maakt voor jouw workflow.

Waarom AI-webscrapingtools onmisbaar zijn voor moderne bedrijven

Webdata is tegenwoordig goud waard, maar het verzamelen ervan zou geen technisch gevecht moeten zijn. De ouderwetse manier—zelf scripts bouwen, eindeloos onderhoud en vechten tegen anti-botmaatregelen—werkt gewoon niet meer. heeft het speelveld veranderd, waardoor niet alleen developers, maar ook zakelijke gebruikers makkelijk data kunnen verzamelen, structureren en exporteren.

Wat is er nu anders?

- Geen kwetsbare scripts meer: AI past zich automatisch aan als websites veranderen, dus je hoeft niet steeds kapotte code te fixen ().

- No-code en low-code opties: Sales-, operations- en marketingteams kunnen nu zelf data scrapen, zonder afhankelijk te zijn van IT.

- Slimmere extractie: AI herkent patronen, vult ontbrekende velden aan en kan zelfs data direct samenvatten of categoriseren.

- Schaalbaarheid: Moderne tools kunnen alles aan, van eenmalige scrapes tot geplande, grootschalige dataverzameling.

Het resultaat? Bedrijven die AI-webscrapers inzetten, rapporteren en een veel snellere doorlooptijd voor belangrijke projecten.

Veelvoorkomende toepassingen:

- Leadgeneratie: Gericht lijsten bouwen uit bedrijvengidsen, LinkedIn of evenementenwebsites.

- Marktonderzoek: Prijzen, reviews en trends van concurrenten monitoren.

- Operationeel: Data-entry automatiseren, voorraad bijhouden en compliance checks uitvoeren.

Hoe we de beste AI-webscrapingtools hebben geselecteerd

Met zoveel tools op de markt voelt kiezen soms als daten op een techbeurs. Zo heb ik de top 10 bepaald:

- Gebruiksgemak: Kunnen niet-programmeurs snel aan de slag? Is het makkelijk te leren?

- AI-aanpassingsvermogen: Kan de tool omgaan met veranderende websites, dynamische content en ongestructureerde data?

- Automatisering: Ondersteunt het plannen, cloudscraping en workflow-integratie?

- Prijsstelling: Is er een gratis versie? Transparante prijzen voor zakelijke gebruikers?

- Support en community: Goede documentatie, actieve gebruikers en snelle ondersteuning?

- Voor wie geschikt: Is het gericht op zakelijke gebruikers, developers of enterprise teams?

Ik heb een mix opgenomen van no-code, code-based, browserextensies en cloudplatforms—dus of je nu zzp’er bent of een enterprise datateam hebt, er zit iets voor je bij.

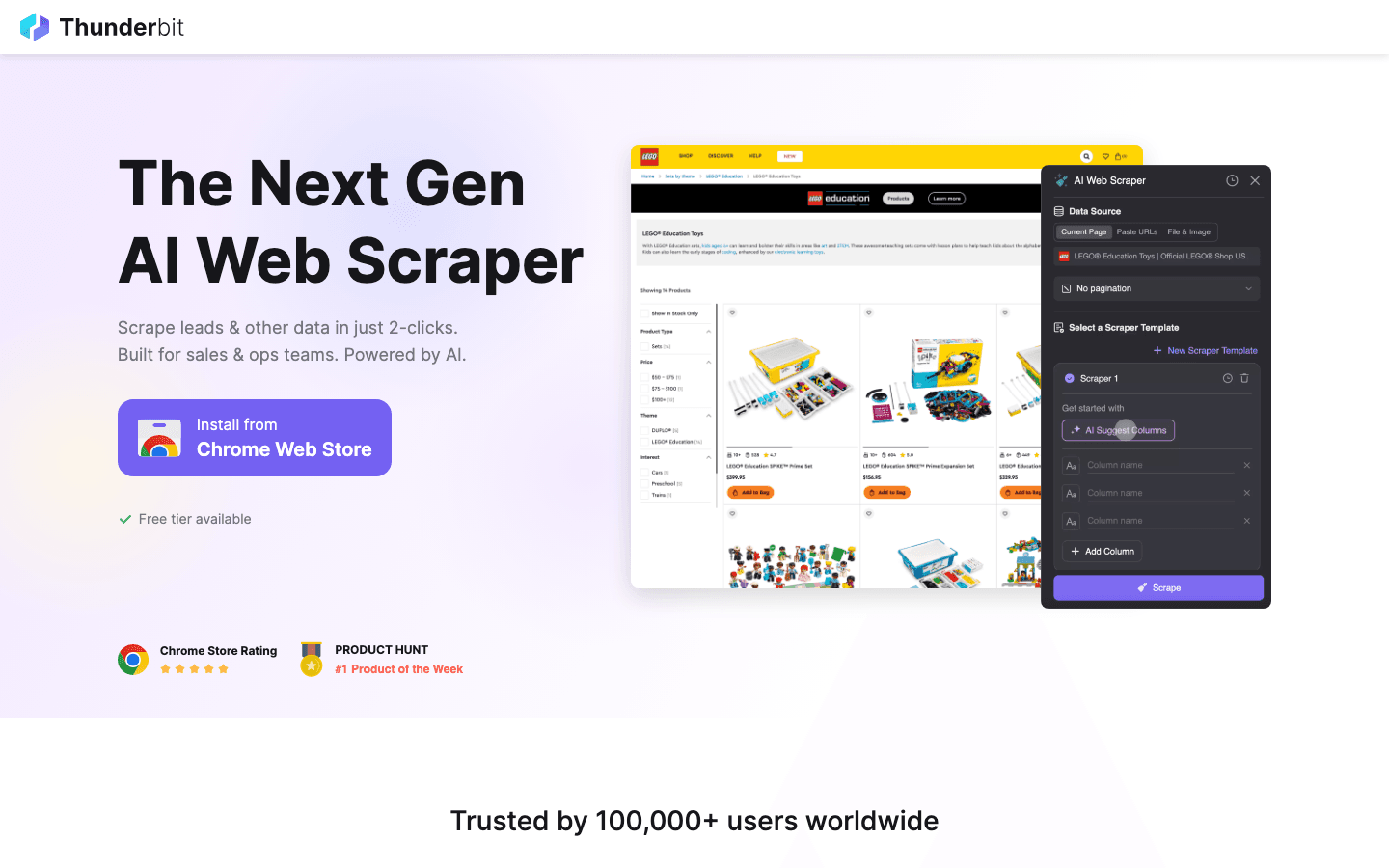

1. Thunderbit

is mijn absolute favoriet voor zakelijke gebruikers die zonder gedoe met AI willen webscrapen. Als medeoprichter ben ik misschien een beetje bevooroordeeld, maar Thunderbit is juist gebouwd voor mensen die geen zin hebben in code, sjablonen of eindeloze instellingen. Omschrijf gewoon wat je wilt, klik op “AI Suggest Fields” en de AI regelt de rest.

Belangrijkste functies:

- Scrapen in 2 klikken: Natuurlijke taal + AI-veldherkenning = direct resultaat.

- Subpagina’s & paginering: Haal makkelijk data van detailpagina’s, reviews of lijsten, zonder extra werk.

- Directe sjablonen: Eén klik voor scrapers van Amazon, Zillow, Shopify en meer.

- Gratis data-export: Exporteer direct naar Excel, Google Sheets, Notion of Airtable.

- AI-autovullen: Automatiseer niet alleen data-extractie, maar ook formulieren en workflows.

- Geleidelijke leercurve: Begin simpel, ontdek geavanceerde functies als je groeit.

Waarom Thunderbit opvalt:

Het is de makkelijkste manier voor niet-technische gebruikers om gestructureerde data te verzamelen—zelfs van lastige, afgeschermde of dynamische websites. Sales- en operationele teams gebruiken het graag voor leadgeneratie, prijsmonitoring en vastgoeddata. Bovendien is er een royaal gratis pakket (tot 6 pagina’s scrapen, of 10 met een proefboost), en betaalde abonnementen starten al vanaf $15 per maand.

Zelf proberen? of check ons voor tutorials.

2. Octoparse

is een visuele, no-code AI-webscraper met een gebruiksvriendelijke interface en een enorme bibliotheek aan sjablonen. Ideaal voor zakelijke gebruikers die flexibiliteit willen zonder te programmeren.

Belangrijkste functies:

- Visuele workflowbouwer: Klik en wijs aan wat je wilt scrapen.

- AI-veldherkenning: Herkent automatisch data op de meeste websites.

- Sjabloonbibliotheek: Meer dan 60.000 kant-en-klare sjablonen voor populaire sites.

- Cloud & lokaal scrapen: Draai taken op je desktop of in de cloud.

- Plannen & automatiseren: Stel terugkerende scrapes in voor actuele data.

Prijs:

Gratis voor kleine taken (tot 10 taken, 50.000 rijen/maand). Betaalde pakketten vanaf $75/maand voor meer volume en extra functies.

Beste voor:

Teams die een visuele, sjabloongedreven aanpak willen en regelmatig verschillende sites moeten scrapen.

3. Scrapy

is dé standaard voor developers die maatwerk, schaalbaarheid en open source belangrijk vinden. Gebouwd in Python, super uitbreidbaar en goed te combineren met machine learning en AI-modules.

Belangrijkste functies:

- Volledige codecontrole: Bouw eigen spiders voor elke site of workflow.

- Schaalbare pipelines: Verwerk miljoenen pagina’s, koppel aan databases en ML-modellen.

- Actieve community: Veel plugins, documentatie en support.

- AI-integratie: Combineer met NLP of computer vision voor geavanceerde datastructurering.

Prijs:

Gratis en open source—alleen je eigen tijd en infrastructuur.

Beste voor:

Technische gebruikers, data engineers en iedereen die grootschalige, maatwerk scrapingprojecten bouwt.

4. ParseHub

biedt een klikbare, visuele interface voor het scrapen van zelfs de meest complexe, JavaScript-rijke websites. Geen code nodig, maar je kunt wel geavanceerde logica toepassen.

Belangrijkste functies:

- Wijs-en-klik setup: Selecteer elementen visueel, ook op dynamische pagina’s.

- AI-herkenning: Kan omgaan met lastige layouts en geneste data.

- Cloudscraping & plannen: Automatiseer terugkerende taken, exporteer naar Excel/JSON.

- API-toegang: Integreer met je eigen workflows.

Prijs:

Gratis voor basisgebruik. Betaalde pakketten vanaf $149/maand voor meer volume en extra functies.

Beste voor:

Zakelijke gebruikers die complexe sites willen scrapen en een visuele, logische aanpak zoeken.

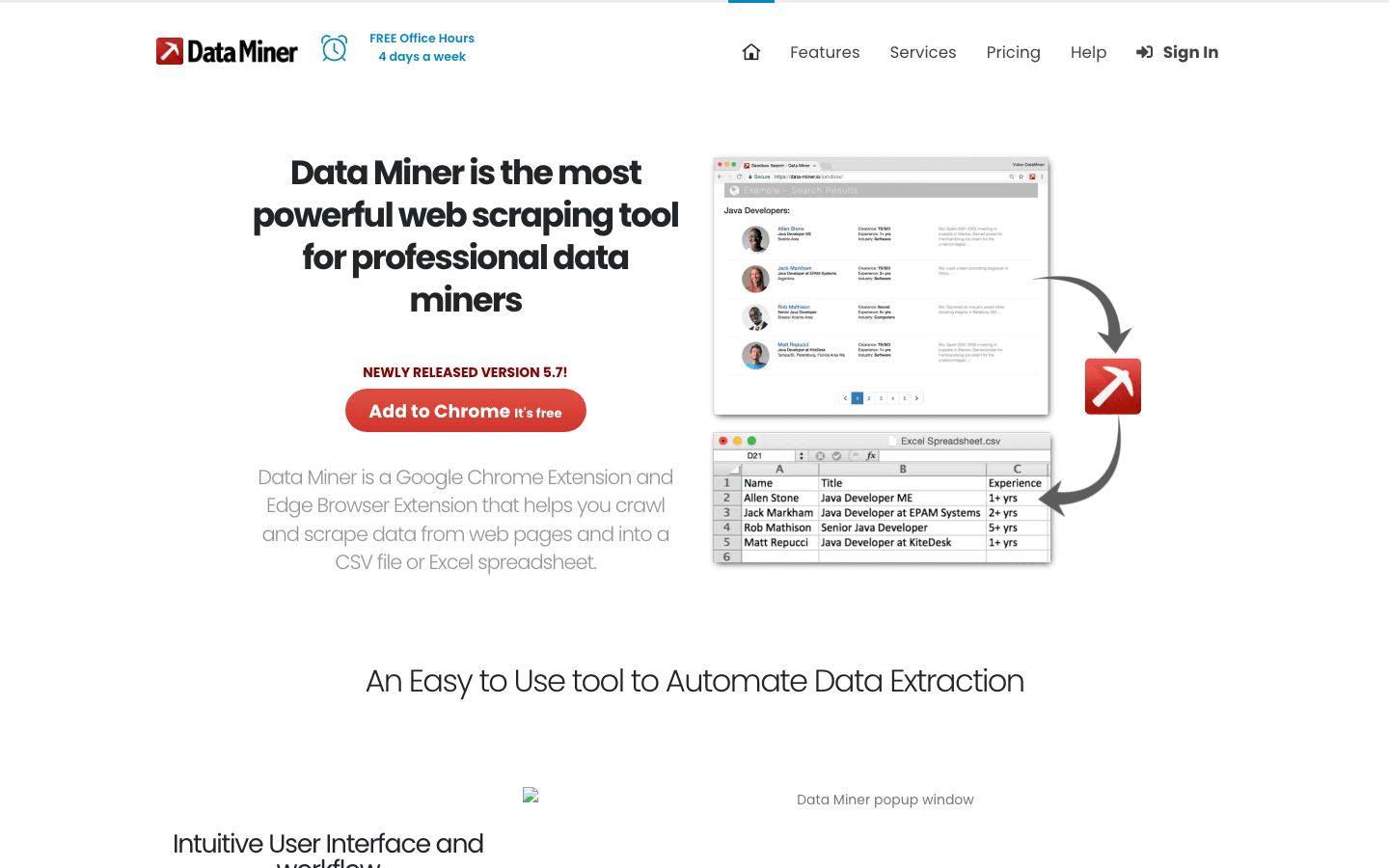

5. DataMiner

is een Chrome/Edge-extensie voor snelle, sjabloongedreven scraping. Ideaal voor kleine taken, lijsten of als je snel data nodig hebt.

Belangrijkste functies:

- Browsergebaseerd: Geen installatie—voeg gewoon de extensie toe.

- 60.000+ openbare sjablonen: Scrape Google, LinkedIn, bedrijvengidsen en meer.

- Eén-klik export: Download naar CSV, Excel of Google Sheets.

- Eigen recepten: Bouw je eigen sjablonen voor terugkerende taken.

Prijs:

Gratis tot 500 pagina’s/maand. Betaalde pakketten vanaf $19/maand voor meer volume en functies.

Beste voor:

Sales, onderzoek of iedereen die snel data wil verzamelen zonder de browser te verlaten.

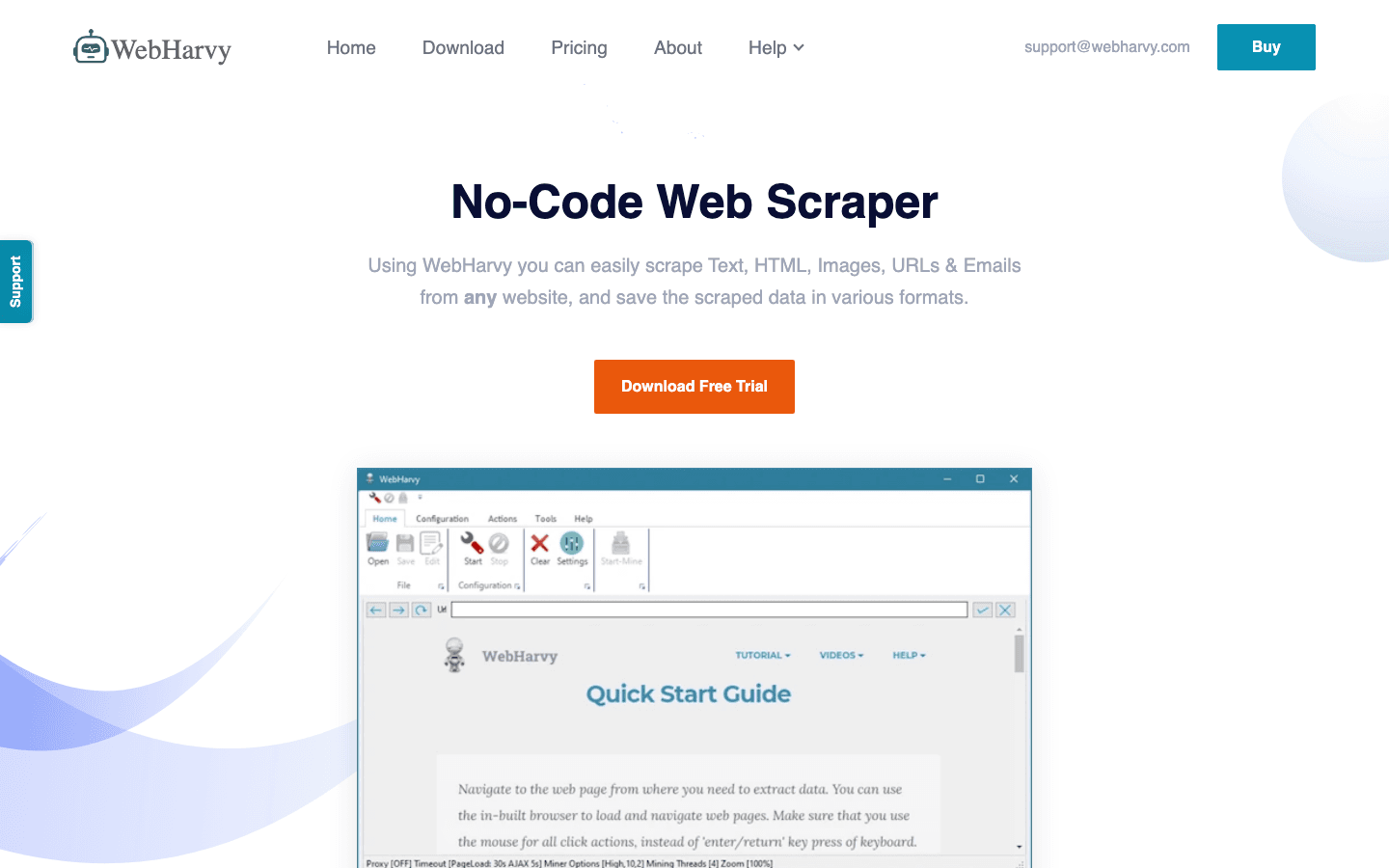

6. WebHarvy

is een desktopapplicatie (Windows) met een klik-en-wijs interface en automatische patroonherkenning. Vooral sterk in het scrapen van afbeeldingen en gemengde content.

Belangrijkste functies:

- Visuele selectie: Klik op elementen om tekst, afbeeldingen of links te extraheren.

- Patroonherkenning: Herkent herhalende data voor batchscraping.

- Paginering: Scrape makkelijk lijsten over meerdere pagina’s.

- Exportopties: Excel, CSV, XML of direct naar databases.

Prijs:

Eenmalige licentie (ca. $139), inclusief een jaar updates en support.

Beste voor:

Niet-technische gebruikers die een desktoptool zoeken voor sites met veel afbeeldingen of complexe layouts.

7. Import.io

is een cloudplatform voor grootschalige, geautomatiseerde AI-webscraping. Gericht op enterprise, met uitgebreide plannings-, workflow- en compliancefuncties.

Belangrijkste functies:

- Cloudautomatisering: Plan terugkerende scrapes, verwerk grote volumes.

- AI-extractie: Kan omgaan met logins, CAPTCHAs en dynamische content.

- Workflow-integratie: Koppel aan BI-tools, CRM’s en meer.

- Datacleaning: Ingebouwde tools voor deduplicatie en validatie.

Prijs:

Maatwerkoffertes, meestal vanaf $299/maand. Geen gratis versie.

Beste voor:

Enterprises en datateams die behoefte hebben aan beheerde, schaalbare en conforme datapijplijnen.

8. Content Grabber

is een enterprise-grade desktop/webscraper met geavanceerde automatisering en integratie. Ideaal voor operationele teams die grootschalige data-extractie en rapportage beheren.

Belangrijkste functies:

- Automatisering: Plan, monitor en beheer meerdere scraping agents.

- Integratie: Exporteer naar databases, API’s of eigen workflows.

- Foutafhandeling: Uitgebreide logging en herstel voor kritieke taken.

- Custom scripting: Uitbreiden met C# of .NET voor diepgaande aanpassingen.

Prijs:

Geen gratis versie; betaalde licenties vanaf ca. $2.995 (eenmalig).

Beste voor:

Grote organisaties, bureaus of iedereen die industriële scraping en rapportage nodig heeft.

9. BeautifulSoup

is een lichte Python-bibliotheek voor het parsen van HTML en XML. Favoriet bij developers die maatwerk scrapingoplossingen bouwen, zeker in combinatie met AI voor datastructurering.

Belangrijkste functies:

- Flexibel parsen: Haal en reinig data uit rommelige HTML.

- AI-integratie: Combineer met NLP of ML-modellen voor slimmere extractie.

- Open source: Gratis, met een grote ontwikkelaarscommunity.

Prijs:

Gratis en open source.

Beste voor:

Ontwikkelaars die volledige controle willen en comfortabel zijn met Python.

10. Apify

is een cloudplatform met duizenden kant-en-klare “Actors” (vooraf gebouwde scrapers) en een AI-SDK voor maatwerkworkflows. Gericht op schaal, automatisering en beheerde infrastructuur.

Belangrijkste functies:

- Actor marketplace: 10.000+ direct inzetbare scrapers voor populaire sites.

- AI SDK: Bouw, implementeer en plan eigen AI-workflows.

- Cloudschaal: Draai taken parallel, verwerk enorme datavolumes.

- Integratie: Exporteer naar Sheets, databases of via API.

Prijs:

Gratis versie (beperkt aantal runs), betaalde pakketten vanaf $39/maand.

Beste voor:

Teams die schaalbare, geautomatiseerde scraping willen zonder serverbeheer, of eigen AI-workflows willen bouwen.

Vergelijkingstabel AI-webscrapingtools

Hier vind je een handig overzicht om snel de juiste tool te kiezen:

| Tool | Gebruikerservaring | Technische kennis | Automatisering | Prijs | Beste voor |

|---|---|---|---|---|---|

| Thunderbit | No-code, 2 klikken, AI | Geen | Ja | Gratis/$15+/mnd | Niet-tech, sales, operations |

| Octoparse | Visueel, sjablonen | Laag | Ja | Gratis/$75+/mnd | Zakelijk, terugkerende taken |

| Scrapy | Code-based, flexibel | Hoog | Ja | Gratis | Ontwikkelaars, maatwerk |

| ParseHub | Visueel, logica | Laag | Ja | Gratis/$149+/mnd | Complexe, dynamische sites |

| DataMiner | Browserextensie | Geen | Beperkt | Gratis/$19+/mnd | Snel, kleine taken |

| WebHarvy | Desktop, klik-en-wijs | Geen | Ja | $139 (eenmalig) | Afbeeldingen, niet-tech |

| Import.io | Cloud, enterprise | Laag/Midden | Ja | $299+/mnd | Enterprise, grote volumes |

| Content Grabber | Desktop, enterprise | Midden/Hoog | Ja | $2.995+ (licentie) | Operations, grootschalig |

| BeautifulSoup | Python-bibliotheek | Hoog | Nee | Gratis | Devs, maatwerk parsing |

| Apify | Cloud, actors, SDK | Laag/Midden | Ja | Gratis/$39+/mnd | Schaal, beheerde automatisering |

Hoe kies je de juiste AI-webscrapingtool voor jouw bedrijf?

De beste keuze hangt af van de skills van je team, je databehoefte en je budget. Een kort overzicht:

- Niet-technische gebruikers: of Octoparse—eenvoudig op te zetten, geen code, snel resultaat.

- Ontwikkelaars: Scrapy of BeautifulSoup—volledige controle, maatwerk, open source.

- Complexe/dynamische sites: ParseHub of WebHarvy—visuele logica, geschikt voor lastige layouts.

- Snel, kleine taken: DataMiner—browsergebaseerd, direct exporteren.

- Enterprise/schaal: Import.io, Content Grabber of Apify—automatisering, planning, integraties.

Denk na over:

- Hoe vaak ga je scrapen? (Eenmalig of terugkerend)

- Hoeveel data heb je nodig? (Kleine lijsten of miljoenen rijen)

- Moet het integreren met je workflow? (Export naar Sheets, CRM’s, API’s)

- Wat is je budget? (Gratis, pay-as-you-go of enterprise)

Twijfel je? Begin met een gratis proefversie—de meeste tools bieden die aan. En onthoud: de beste tool is degene die je team daadwerkelijk gebruikt.

Conclusie: Maak je datastrategie toekomstbestendig met AI-webscraping

Webdata wordt steeds waardevoller—en lastiger om te verzamelen. AI-webscrapingtools maken het voor zowel zakelijke gebruikers als developers mogelijk om makkelijk toegang te krijgen tot de rijkste databronnen online, zonder de gebruikelijke frustraties. Of je nu een leadlijst bouwt, de markt volgt of je CRM up-to-date wilt houden: met de juiste tool bespaar je tijd, geld en een hoop ergernis.

Benieuwd wat AI-webscraping voor jouw team kan betekenen? of ontdek de andere tools uit deze lijst. Meer tips, uitleg en inspiratie vind je op de .

Veel succes met scrapen—en moge je data altijd schoon, gestructureerd en direct bruikbaar zijn.

Veelgestelde vragen

1. Wat is AI-webscraping en hoe verschilt het van traditioneel scrapen?

AI-webscraping gebruikt machine learning om data te herkennen, extraheren en structureren—zelfs als websites veranderen of de content ongestructureerd is. In tegenstelling tot traditionele scraping, dat afhankelijk is van kwetsbare scripts, passen AI-webscrapers zich automatisch aan en is er minder onderhoud nodig.

2. Welke AI-webscrapingtool is het beste voor niet-technische gebruikers?

en Octoparse zijn ideaal voor wie niet kan programmeren. Beide bieden een visuele interface, AI-veldherkenning en eenvoudige export naar Excel of Google Sheets.

3. Kunnen deze tools omgaan met dynamische of afgeschermde websites?

Ja—tools zoals Thunderbit, ParseHub en Import.io ondersteunen het scrapen van dynamische content en kunnen werken met inlogpagina’s, al verschilt de setup per tool.

4. Wat kost AI-webscraping?

De prijzen variëren van gratis (Scrapy, BeautifulSoup) tot betaalbare SaaS (Thunderbit vanaf $15/maand, Octoparse vanaf $75/maand) tot enterprise (Import.io, Content Grabber). De meeste tools bieden gratis proefversies of pakketten voor kleine taken.

5. Is webscraping legaal en veilig voor zakelijk gebruik?

Webscraping is legaal als je het netjes doet—respecteer altijd de voorwaarden van websites, vermijd misbruik van persoonsgegevens en houd je aan privacywetgeving. De meeste AI-tools bieden functies om compliant te blijven en scraping-snelheden te beheren.

Meer weten?

Bekijk deze bronnen: