Laat ik je een geheimpje vertellen: vroeger dacht ik dat webscraping alleen was weggelegd voor hackers met capuchontruien of dataspecialisten met meer schermen dan gezond is. Maar tegenwoordig is data van een website halen net zo normaal op kantoor als je eerste bakkie pleur – en gelukkig hoef je er geen Python-wizard voor te zijn of liters espresso achterover te slaan. Dankzij de opkomst van AI-webscraper tools kan zelfs iemand die denkt dat 'HTML' een nieuwe tosti bij de lunchzaak is, gestructureerde data van het web plukken.

Heb je jezelf wel eens betrapt op eindeloos copy-pasten van productinfo, leads of prijslijsten naar een spreadsheet? Je bent zeker niet de enige. Maar liefst gebruikt webscraping voor marktinzichten en concurrentieanalyse. En met een verwachte marktwaarde van is het duidelijk: gegevens extractie is allang niet meer alleen voor nerds. Of je nu in sales, marketing of gewoon klaar bent met handmatig data inkloppen, deze gids is voor jou. Ik neem je mee door de basics, vergelijk traditionele en AI-gestuurde methodes en laat je zien hoe je zelf aan de slag kunt – zonder hoodie.

Webscraper Basis: Wat houdt data van een website halen in?

Laten we bij het begin beginnen. Een webscraper is gewoon een tool (of script, of Chrome-extensie) die automatisch data van websites binnenharkt. Zie het als een razendsnelle stagiair die nooit moppert over saaie klusjes. In plaats van zelf rij voor rij te kopiëren en plakken, doet een webscraper dit in een paar seconden – zonder pauze te nemen.

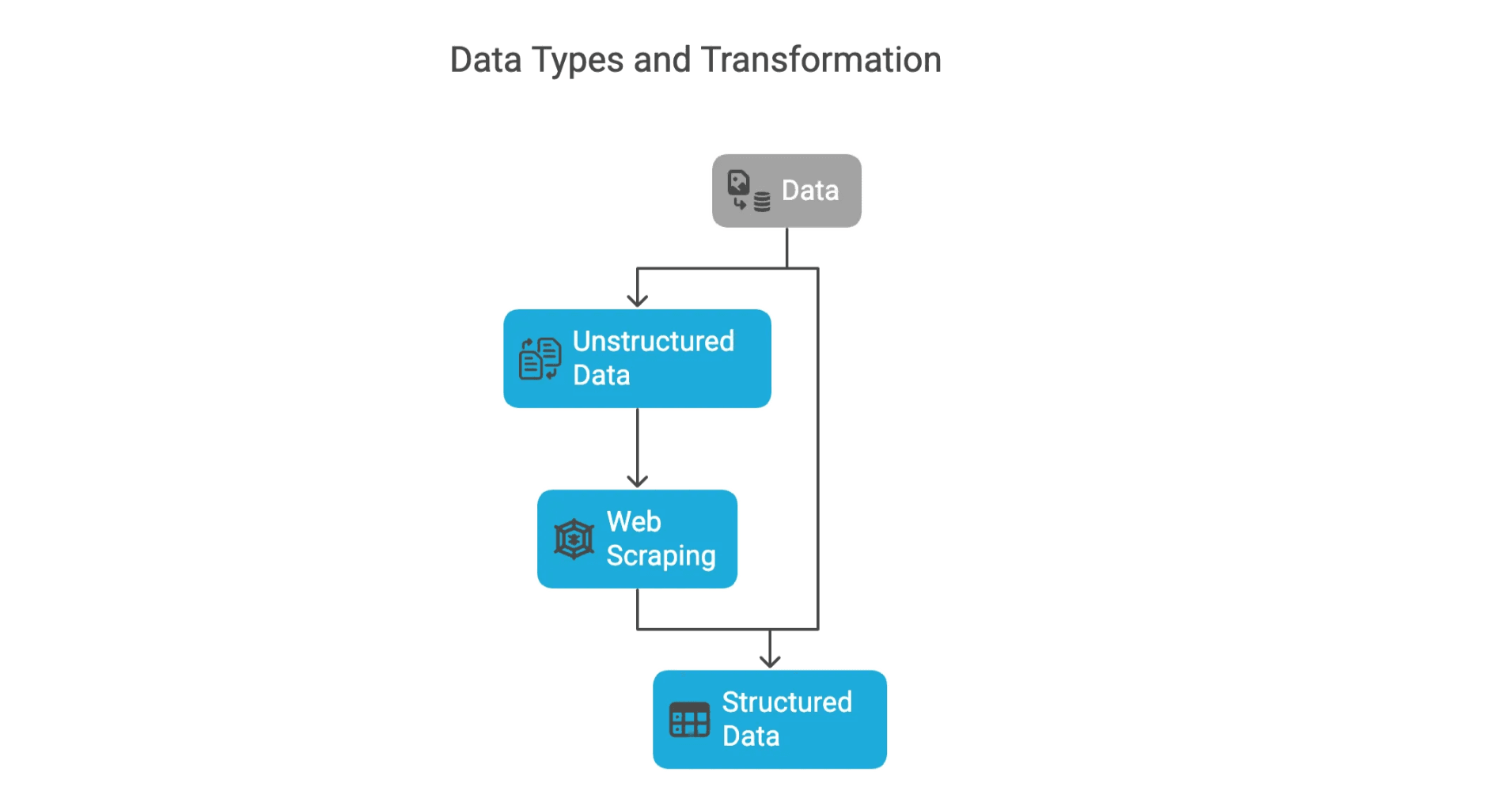

Je komt grofweg twee soorten data tegen:

- Gestructureerde data: Dit is de overzichtelijke, direct bruikbare info – denk aan tabellen met productnamen, prijzen of e-mailadressen. Alles netjes op een rijtje en makkelijk te analyseren.

- Ongestructureerde data: Dit is de rauwe, ongeorganiseerde info – blogposts, reviews, afbeeldingen of alles wat niet in een tabel past. De meeste webscraping-projecten zijn erop gericht om ongestructureerde data om te zetten naar gestructureerde data, zodat je er echt iets mee kunt.

Heb je ooit een tabel van een website naar Excel gekopieerd? Gefeliciteerd – je hebt handmatig webscraping gedaan. Stel je nu voor dat je dat voor 10.000 pagina’s moet doen. (Niet aan beginnen! Daar zijn webscrapers voor.)

Waarom data van websites halen? De zakelijke voordelen

Waarom zou je eigenlijk data van websites willen halen? Simpel: bedrijven draaien op data, en het web is de grootste databank die er is. Of je nu in sales, marketing, e-commerce of vastgoed zit, webdata kan je een flinke voorsprong geven.

Hier zijn een paar veelvoorkomende toepassingen:

| Toepassing | Beschrijving | Voorbeeld van voordeel |

|---|---|---|

| Leadgeneratie | Contactgegevens, e-mails of bedrijfsnamen verzamelen uit directories of sociale netwerken | Sales teams besparen uren en vinden sneller gekwalificeerde leads |

| Prijsmonitoring | Prijzen, voorraad of acties van concurrenten realtime volgen | Winkels passen prijzen direct aan en verhogen omzet met 4% |

| Marktonderzoek | Reviews, nieuws of social media sentiment verzamelen om trends te spotten | Marketeers stemmen campagnes af op actuele inzichten |

| Concurrentieanalyse | Productassortiment, lanceringen of content van concurrenten volgen | Bedrijven reageren sneller op marktveranderingen |

| Vastgoedinzichten | Woningen, prijzen en beschikbaarheid scrapen | Makelaars en investeerders zien kansen eerder dan de markt |

Wist je dat in het VK en Europa hun prijzen dynamisch aanpassen op basis van concurrentie-data? Grote namen als John Lewis en ASOS boeken aantoonbaar meer omzet door slim gebruik te maken van webdata.

Traditionele webscraper tools: Hoe werken ze?

Even terug naar de ‘klassieke’ manier van data scrapen – voordat AI het overnam. Traditionele webscrapers zijn meestal scripts (vaak in Python) of browserextensies die volgens vaste regels data ophalen.

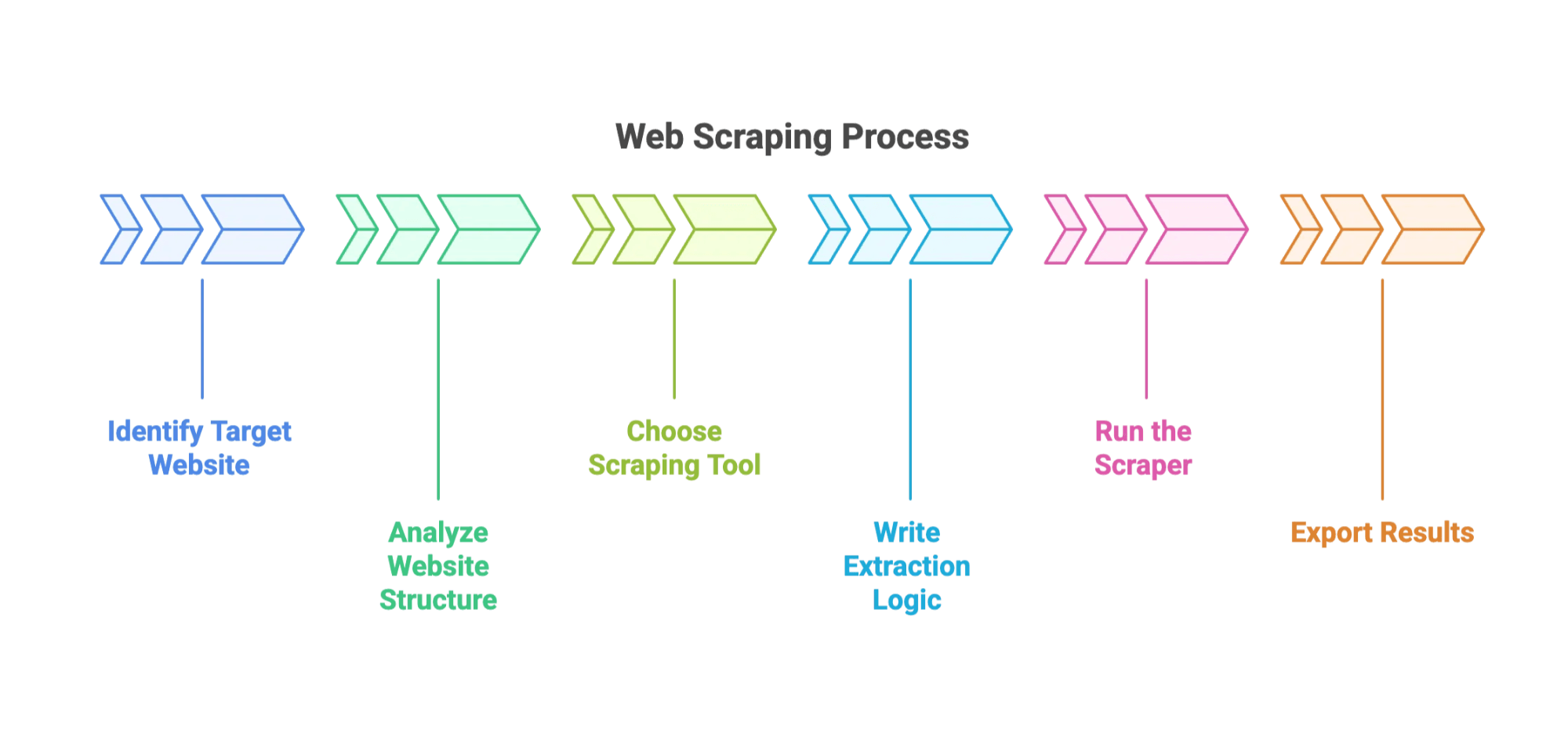

Zo werkt het meestal:

- Bepaal de website en velden die je wilt scrapen.

- Analyseer de structuur van de site. (Met de Developer Tools van je browser – een soort digitale speurtocht.)

- Kies je tool: Populaire opties zijn , of browser-plugins.

- Schrijf de extractielogica: Geef aan waar de data staat, meestal via CSS-selectors of XPath.

- Voer de scraper uit: Laat hem data verzamelen over meerdere pagina’s.

- Exporteer de resultaten: Vaak als CSV, JSON of direct naar Excel.

Stap-voor-stap: Data scrapen met een traditionele webscraper

Stel, je wilt productinformatie van een webshop halen. Zo pak je het aan:

- Stap 1: Installeer Python en de BeautifulSoup-bibliotheek.

- Stap 2: Gebruik je browser om de HTML van de productpagina te bekijken. Zoek de tags met de productnaam en prijs.

- Stap 3: Schrijf een kort script om de pagina op te halen, de HTML te lezen en de juiste velden te pakken.

- Stap 4: Herhaal dit voor meerdere pagina’s (paginering).

- Stap 5: Exporteer de data naar een CSV-bestand.

Klinkt makkelijk, maar geloof me: je eerste script gaat waarschijnlijk stuk. (Mijn eerste poging leverde 500 rijen “None” op omdat ik een classnaam verkeerd had getypt. Oeps.)

Veelvoorkomende uitdagingen bij traditionele webscrapers

Hier wordt het lastig:

- Website verandert: Een kleine aanpassing in de site kan je scraper breken. werkt elke week niet meer door wijzigingen.

- Anti-botmaatregelen: CAPTCHAs, IP-blokkades en limieten kunnen je tegenhouden. Je moet werken met proxies, vertragingen en soms zelfs CAPTCHAs oplossen.

- Technische kennis vereist: Je moet kunnen programmeren en HTML/CSS begrijpen.

- Onderhoud: Scrapers hebben regelmatig updates nodig.

- Rommelig resultaat: Je bent vaak tijd kwijt aan het opschonen van onvolledige of vreemd opgemaakte data.

Voor beginners voelt dit als een taart bakken terwijl het recept steeds verandert en de oven soms op slot zit.

De opkomst van de AI-webscraper: Data-extractie voor iedereen

Nu het leuke deel. AI-webscrapers gooien het roer om. In plaats van code schrijven of selectors zoeken, vertel je de tool gewoon in normaal Nederlands wat je wilt. De AI regelt de rest.

Thunderbit (dat zijn wij!) is een goed voorbeeld van deze nieuwe generatie. Met kun je gestructureerde data van elke website halen met gewone taal – zonder te programmeren. Of je nu in sales, marketing of e-commerce werkt, je verzamelt in minuten de data die je nodig hebt.

Thunderbit AI-webscraper: Zo wordt data-extractie simpel

Zo maakt Thunderbit je leven makkelijker:

- AI Suggest Fields: Klik op “AI Suggest Fields” en Thunderbit leest de website, stelt kolomnamen voor en geeft suggesties voor het extraheren van elk veld.

- Subpagina’s scrapen: Meer details nodig? Thunderbit bezoekt automatisch subpagina’s (zoals productpagina’s) en vult je datatabel aan.

- Directe templates: Voor bekende sites als Amazon of Zillow zijn er kant-en-klare sjablonen – direct te gebruiken.

- Gratis data-export: Exporteer je data naar Excel, Google Sheets, Airtable of Notion. Download als CSV of JSON. Geen verborgen kosten.

- Geplande scraping: Stel terugkerende scrapes in om je data actueel te houden – ideaal voor prijsmonitoring of leadlijsten.

- AI Autofill: Laat AI online formulieren voor je invullen (zelfs die ellenlange onboarding-formulieren).

- E-mail, telefoon en afbeelding extractors: Haal contactgegevens of afbeeldingen met één klik binnen.

En het mooiste? Je hoeft geen regel code te kennen. De Chrome-extensie van Thunderbit vind je , en meer info staat op onze .

Traditioneel vs. AI-webscraper: de vergelijking

Hoe verhouden de twee methodes zich tot elkaar?

| Aspect | Traditionele webscraper | AI-webscraper (Thunderbit) |

|---|---|---|

| Gebruiksgemak | Programmeren of complexe setup nodig | Geen code, werkt met gewone taal |

| Aanpasbaarheid | Snel stuk bij sitewijzigingen | AI past zich automatisch aan |

| Onderhoud | Veel – vaak bijwerken | Weinig – AI regelt het meeste |

| Technische kennis | Programmeren en HTML vereist | Gemaakt voor zakelijke gebruikers |

| Snelheid opzetten | Uren tot dagen | Minuten |

| Dataverwerking | Handmatig opschonen nodig | AI structureert en maakt data schoon |

| Kosten | Gratis (open source), maar tijdrovend | Betaalbare abonnementen, gratis export |

Voor de meeste zakelijke gebruikers – zeker beginners – zijn AI-webscrapers zoals Thunderbit de beste keuze qua snelheid, eenvoud en betrouwbaarheid. Traditionele tools zijn vooral handig voor heel specifieke of grootschalige projecten, maar voor 95% van de gevallen is AI de beste optie.

Stappenplan: Zo haal je als beginner data van een website

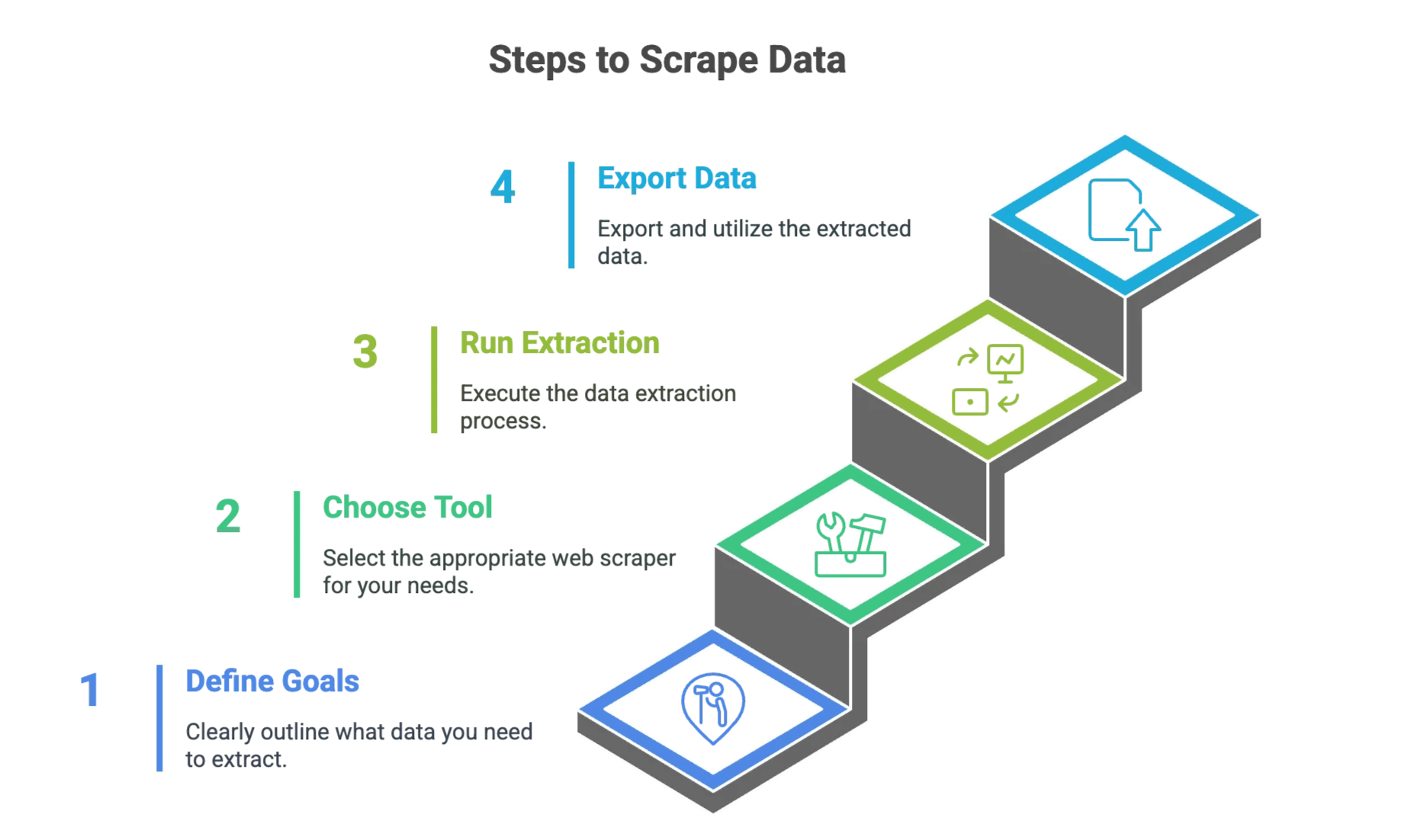

Stap 1: Bepaal je doel

Voordat je begint, is het slim om helder te hebben wat je wilt. Vraag jezelf:

- Welke website(s) wil ik scrapen?

- Welke data is belangrijk? (bijv. productnaam, prijs, e-mail, telefoon)

- Hoe vaak heb ik deze data nodig? (Eenmalig of herhaald?)

Maak een checklist. Bijvoorbeeld: “Ik wil productnamen, prijzen en beoordelingen van de eerste 5 pagina’s van verzamelen.”

Stap 2: Kies de juiste webscraper tool

Een korte beslisboom:

- Handig met code en alles zelf willen regelen? Probeer een traditionele tool zoals BeautifulSoup of Scrapy.

- Snel, makkelijk en zonder code? Kies een AI-webscraper zoals .

Twijfel je? Begin met AI. Je kunt altijd later dieper duiken.

Stap 3: Zet je gegevens extractie op en voer uit

Traditionele aanpak

- Installeer je tool: Zet Python en de benodigde libraries op.

- Inspecteer de website: Gebruik browser DevTools om de HTML-structuur te vinden.

- Schrijf je script: Geef aan hoe je elk veld vindt en ophaalt.

- Test op één pagina: Controleer of je de juiste data krijgt.

- Schaal op: Voeg paginering of loops toe voor meer pagina’s.

- Exporteer je data: Sla op als CSV of JSON.

AI-aanpak (Thunderbit)

- Installeer de Thunderbit Chrome-extensie: .

- Open de gewenste website: Ga naar de pagina die je wilt scrapen.

- Klik op “AI Suggest Fields”: Thunderbit leest de pagina en stelt kolommen voor.

- Bekijk de preview: Controleer of de data klopt. Pas kolommen aan indien nodig.

- Klik op “Scrape”: Thunderbit verzamelt de data voor je.

- Exporteer je data: Download naar Excel, Google Sheets, Airtable of Notion.

Wil je het stap voor stap zien? Bekijk ons .

Stap 4: Exporteer en gebruik je data

Als je data binnen is:

- Exporteer naar je favoriete tool: Excel, Google Sheets, Airtable, Notion, CSV of JSON.

- Integreer in je workflow: Gebruik het voor sales, prijsanalyse, marktonderzoek of wat je maar wilt.

- Controleer en maak schoon: Ook met AI is het slim om je data steekproefsgewijs te checken.

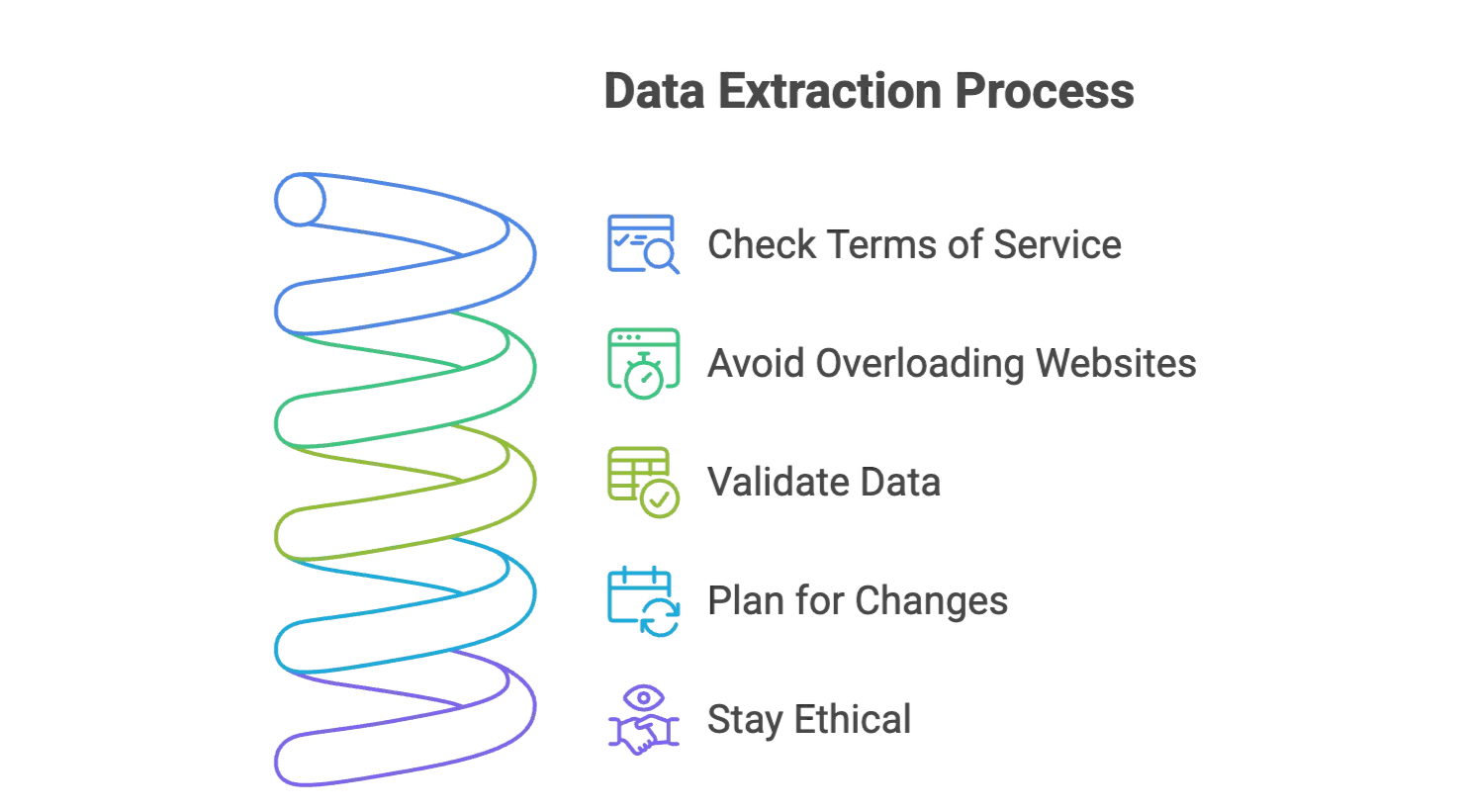

Tips voor succesvolle gegevens extractie: veelgemaakte fouten voorkomen

- Check de gebruiksvoorwaarden van de website: Zorg dat je mag scrapen. Blijf bij openbare info en vermijd gevoelige persoonsgegevens.

- Overbelast websites niet: Voeg vertragingen toe tussen verzoeken (bij traditionele tools) of laat Thunderbit dit automatisch regelen.

- Controleer je data: Kijk altijd een steekproef na op juistheid.

- Wees voorbereid op veranderingen: Websites veranderen vaak. AI-scrapers zoals Thunderbit passen zich meestal aan, maar houd grote wijzigingen in de gaten.

- Blijf netjes: Haal alleen wat je nodig hebt en geef credits als je data gebruikt in rapporten of publicaties.

Meer tips? Lees onze en .

Samenvatting & belangrijkste punten

Webscraping is flink veranderd – van handmatig coderen tot de huidige AI-gedreven, supertoegankelijke tools. De grootste verschillen?

- Traditionele scrapers geven je veel controle, maar vragen om code, onderhoud en geduld.

- AI-webscrapers zoals maken gegevens extractie toegankelijk voor iedereen, met gewone taal, directe previews en handige functies zoals subpagina- en geplande scraping.

Ben je nieuw met webscraping? Laat je niet afschrikken. De tools zijn nog nooit zo makkelijk geweest en de zakelijke waarde is enorm. Of je nu leads wilt genereren, prijzen wilt volgen of gewoon wilt stoppen met kopiëren en plakken: AI-webscrapers zijn je nieuwe beste maatje.

Dus, de volgende keer dat je tegen een berg webdata aankijkt: je hebt geen IT-diploma of hoodie nodig. Alleen een duidelijk doel, de juiste tool en misschien een goede kop koffie.

Zelf proberen? en ontdek hoe makkelijk gegevens extractie kan zijn.

Meer weten? Check de voor uitgebreide artikelen over het scrapen van Amazon, Google, PDF’s en meer. Succes!

Veelgestelde vragen

Vraag 1: Is webscraping legaal? Antwoord: Ja, het scrapen van openbare data is in veel landen toegestaan. Controleer altijd de gebruiksvoorwaarden van een website en vermijd het scrapen van gevoelige of persoonlijke gegevens.

Vraag 2: Kan ik websites scrapen waarvoor je moet inloggen? Antwoord: Ja, maar dit is lastiger en kan tegen de regels van de site zijn. Je hebt dan sessiebeheer of speciale scrapingtools nodig. Check altijd de juridische gevolgen.

Vraag 3: Hoe kan ik data scrapen van websites die veel JavaScript gebruiken? Antwoord: Gebruik tools die dynamische weergave ondersteunen, zoals headless browsers of AI-scrapers die menselijke interacties nabootsen en JavaScript-content kunnen lezen.

Vraag 4: Wat zijn de beste manieren om blokkades te voorkomen? Antwoord: Gebruik limieten, willekeurige vertragingen, wissel van user-agent en scrape niet te agressief. AI-scrapers regelen dit vaak automatisch.

Meer lezen

-

Overzicht van juridische richtlijnen, branchecijfers en ethische best practices.

-

Trends, marktgroei en de rol van AI in gegevens extractie (2024–2025).

-

Leer hoe je robots.txt-bestanden leest voor ethisch en legaal scrapen.