Laten we eerlijk zijn: Amazon is tegenwoordig hét digitale winkelcentrum, de supermarkt én de elektronicazaak van het internet. Werk je in sales, e-commerce of operations? Dan weet je dat alles wat op Amazon gebeurt, direct invloed heeft op je prijzen, voorraad en zelfs je volgende productlancering. Maar er is een uitdaging: al die waardevolle productinformatie, prijzen, beoordelingen en reviews zitten verstopt achter een website die is gemaakt voor shoppers, niet voor teams die data willen verzamelen. Dus hoe kom je aan die data zonder je weekenden te verspillen aan eindeloos kopiëren en plakken?

Hier komt webscraping om de hoek kijken. In deze gids laat ik je twee manieren zien om Amazon-productdata te verzamelen: de klassieke route waarbij je zelf in Python aan de slag gaat, en de moderne aanpak waarbij je AI het werk laat doen met een no code webscraper zoals . Ik neem je mee door echte Python-code (inclusief valkuilen en oplossingen) en laat daarna zien hoe Thunderbit je dezelfde data in een paar klikken oplevert—zonder te programmeren. Of je nu developer bent, business-analist, of gewoon klaar bent met handmatig data invoeren: deze gids is voor jou.

Waarom Amazon-productdata verzamelen? (amazon scraper python, webscraping met python)

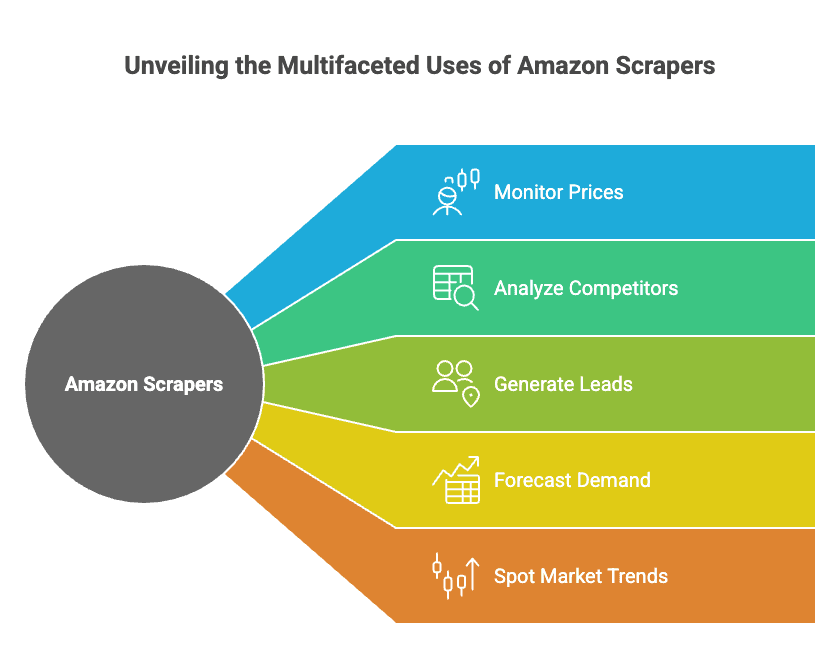

Amazon is niet alleen de grootste online retailer ter wereld, maar ook een gigantische bron van marktinformatie. Met en is Amazon een goudmijn voor iedereen die wil:

- Prijzen monitoren (en je eigen prijzen direct aanpassen)

- Concurrenten analyseren (nieuwe producten, beoordelingen en reviews volgen)

- Leads genereren (verkopers, leveranciers of partners vinden)

- Vraag voorspellen (door voorraadniveaus en verkoopranks te volgen)

- Markttrends ontdekken (door reviews en zoekresultaten te analyseren)

En dit is niet alleen theorie—bedrijven zien hier echt resultaat mee. Zo gebruikte een elektronicawinkel gescrapete Amazon-prijsdata om , en een ander merk zag na het automatiseren van prijsvergelijkingen.

Hier een overzicht van toepassingen en de mogelijke opbrengst:

| Toepassing | Wie gebruikt het | Typisch resultaat / voordeel |

|---|---|---|

| Prijsmonitoring | E-commerce, Operations | 15%+ hogere marge, 4% meer omzet, 30% minder analystentijd |

| Concurrentieanalyse | Sales, Product, Operations | Snellere prijsaanpassingen, betere concurrentiepositie |

| Marktonderzoek (Reviews) | Product, Marketing | Snellere productverbetering, betere advertentieteksten, SEO-inzichten |

| Leadgeneratie | Sales | 3.000+ leads/maand, 8+ uur bespaard per medewerker per week |

| Voorraad & Vraagvoorspelling | Operations, Supply Chain | 20% minder overstock, minder out-of-stock situaties |

| Trendspotting | Marketing, Directie | Vroegtijdige signalering van populaire producten en categorieën |

En het belangrijkste: haalt aantoonbaar waarde uit data-analyse. Als je Amazon niet scrape, laat je kansen (en geld) liggen.

Overzicht: Amazon Scraper Python vs. No Code Webscraper Tools

Er zijn grofweg twee manieren om Amazon-data uit de browser in je spreadsheet of dashboard te krijgen:

-

Amazon Scraper Python (webscraping met python):

Je schrijft zelf een script met Python-libraries zoals Requests en BeautifulSoup. Je hebt volledige controle, maar je moet kunnen programmeren, omgaan met anti-botmaatregelen en je script onderhouden als Amazon iets aanpast.

-

No Code Webscraper Tools (zoals Thunderbit):

Je gebruikt een tool waarmee je simpelweg aanwijst, klikt en data ophaalt—zonder te programmeren. Moderne tools zoals gebruiken zelfs AI om automatisch de juiste data te herkennen, subpagina’s en paginering te verwerken, en direct te exporteren naar Excel of Google Sheets.

Zo vergelijken ze:

| Criteria | Python Scraper | No Code (Thunderbit) |

|---|---|---|

| Installatie | Veel werk (installeren, coderen, debuggen) | Snel (extensie installeren) |

| Vaardigheid | Programmeren vereist | Geen (wijzen & klikken) |

| Flexibiliteit | Onbeperkt | Hoog voor standaardtoepassingen |

| Onderhoud | Je onderhoudt zelf de code | Tool werkt zichzelf bij |

| Anti-bot | Zelf proxies/headers regelen | Ingebouwd, automatisch geregeld |

| Schaalbaarheid | Handmatig (threads, proxies) | Cloud scraping, parallel verwerkt |

| Data export | Zelf instellen (CSV, Excel, DB) | Eén klik naar Excel, Sheets |

| Kosten | Gratis (je tijd + proxies) | Freemium, betalen voor meer gebruik |

In de volgende secties laat ik beide methodes zien—eerst hoe je een Amazon scraper in Python bouwt (met echte code), daarna hoe je hetzelfde doet met Thunderbit’s AI-webscraper.

Aan de slag met Amazon Scraper Python: Benodigdheden & Setup

Voordat je gaat coderen, eerst je omgeving klaarzetten.

Wat heb je nodig:

- Python 3.x (download via )

- Een code-editor (bijvoorbeeld VS Code, maar alles werkt)

- De volgende libraries:

requests(voor HTTP-verzoeken)beautifulsoup4(voor HTML-parsing)lxml(snelle HTML-parser)pandas(voor tabellen/export)re(reguliere expressies, standaard in Python)

Installeer de libraries:

1pip install requests beautifulsoup4 lxml pandasProject opzetten:

- Maak een nieuwe map voor je project.

- Open je editor en maak een nieuw Python-bestand aan (bijv.

amazon_scraper.py). - Je bent klaar om te beginnen!

Stapsgewijs: Webscraping met Python voor Amazon-productdata

We beginnen met het scrapen van één Amazon-productpagina. (Geen zorgen, straks pakken we meerdere producten en pagina’s.)

1. Verzoeken sturen en HTML ophalen

Eerst halen we de HTML van een productpagina op. (Vervang de URL door een willekeurige Amazon-productpagina.)

1import requests

2url = "<https://www.amazon.com/dp/B0ExampleASIN>"

3response = requests.get(url)

4html_content = response.text

5print(response.status_code)Let op: Deze simpele request wordt vaak door Amazon geblokkeerd. Je krijgt dan een 503-fout of een CAPTCHA in plaats van de productpagina. Waarom? Amazon ziet dat je geen echte browser bent.

Omgaan met Amazon’s anti-botmaatregelen

Amazon houdt niet van bots. Om blokkades te voorkomen, moet je:

- Een User-Agent header instellen (doen alsof je Chrome of Firefox bent)

- User-Agents roteren (niet steeds dezelfde gebruiken)

- Verzoeken vertragen (willekeurige pauzes toevoegen)

- Proxies gebruiken (voor grootschalig scrapen)

Zo stel je headers in:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)... Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4}

5response = requests.get(url, headers=headers)Wil je het geavanceerder? Gebruik een lijst met User-Agents en roteer ze per request. Voor grote projecten zijn proxies handig, maar voor kleinschalig scrapen zijn headers en vertragingen vaak voldoende.

Belangrijke productvelden extraheren

Nu je de HTML hebt, kun je deze parsen met BeautifulSoup.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html_content, "lxml")Nu de belangrijkste data ophalen:

Producttitel

1title_elem = soup.find(id="productTitle")

2product_title = title_elem.get_text(strip=True) if title_elem else NonePrijs

De prijs kan op verschillende plekken staan. Probeer dit:

1price = None

2price_elem = soup.find(id="priceblock_ourprice") of soup.find(id="priceblock_dealprice")

3if price_elem:

4 price = price_elem.get_text(strip=True)

5else:

6 price_whole = soup.find("span", {"class": "a-price-whole"})

7 price_frac = soup.find("span", {"class": "a-price-fraction"})

8 if price_whole and price_frac:

9 price = price_whole.text + price_frac.textBeoordeling en aantal reviews

1rating_elem = soup.find("span", {"class": "a-icon-alt"})

2rating = rating_elem.get_text(strip=True) if rating_elem else None

3review_count_elem = soup.find(id="acrCustomerReviewText")

4reviews_text = review_count_elem.get_text(strip=True) if review_count_elem else ""

5reviews_count = reviews_text.split()[0] # bijv. "1.554 beoordelingen"Hoofdafbeelding-URL

Amazon verstopt soms hoge resolutie-afbeeldingen in JSON in de HTML. Een snelle regex-methode:

1import re

2match = re.search(r'"hiRes":"(https://.*?.jpg)"', html_content)

3main_image_url = match.group(1) if match else NoneOf pak de hoofdafbeelding uit de img-tag:

1img_tag = soup.find("img", {"id": "landingImage"})

2img_url = img_tag['src'] if img_tag else NoneProductdetails

Specificaties zoals merk, gewicht en afmetingen staan meestal in een tabel:

1details = {}

2rows = soup.select("#productDetails_techSpec_section_1 tr")

3for row in rows:

4 header = row.find("th").get_text(strip=True)

5 value = row.find("td").get_text(strip=True)

6 details[header] = valueOf als Amazon het “detailBullets”-formaat gebruikt:

1bullets = soup.select("#detailBullets_feature_div li")

2for li in bullets:

3 txt = li.get_text(" ", strip=True)

4 if ":" in txt:

5 key, val = txt.split(":", 1)

6 details[key.strip()] = val.strip()Resultaten printen:

1print("Titel:", product_title)

2print("Prijs:", price)

3print("Beoordeling:", rating, "op basis van", reviews_count, "reviews")

4print("Hoofdafbeelding-URL:", main_image_url)

5print("Details:", details)Meerdere producten scrapen en paginering verwerken

Eén product is leuk, maar je wilt waarschijnlijk een hele lijst. Zo scrape je zoekresultaten en meerdere pagina’s.

Productlinks ophalen van een zoekpagina

1search_url = "<https://www.amazon.com/s?k=bluetooth+headphones>"

2res = requests.get(search_url, headers=headers)

3soup = BeautifulSoup(res.text, "lxml")

4product_links = []

5for a in soup.select("h2 a.a-link-normal"):

6 href = a['href']

7 full_url = "<https://www.amazon.com>" + href

8 product_links.append(full_url)Paginering verwerken

Amazon’s zoek-URL’s gebruiken &page=2, &page=3, enzovoort.

1for page in range(1, 6): # eerste 5 pagina’s scrapen

2 search_url = f"<https://www.amazon.com/s?k=bluetooth+headphones&page={page}>"

3 res = requests.get(search_url, headers=headers)

4 if res.status_code != 200:

5 break

6 soup = BeautifulSoup(res.text, "lxml")

7 # ... productlinks extraheren zoals hierboven ...Door productpagina’s loopen en exporteren naar CSV

Verzamel je productdata in een lijst van dictionaries en gebruik pandas:

1import pandas as pd

2df = pd.DataFrame(product_data_list) # lijst van dicts

3df.to_csv("amazon_products.csv", index=False)Of naar Excel:

1df.to_excel("amazon_products.xlsx", index=False)Best practices voor Amazon Scraper Python-projecten

Amazon verandert zijn site continu en beschermt zich actief tegen webscrapers. Zo houd je je project werkend:

- Headers en User-Agents roteren (gebruik bijvoorbeeld

fake-useragent) - Proxies gebruiken bij grootschalig scrapen

- Verzoeken vertragen (willekeurige

time.sleep()tussen requests) - Fouten netjes afhandelen (opnieuw proberen bij 503, pauzeren bij blokkade)

- Flexibele parsing schrijven (meerdere selectors per veld proberen)

- HTML-wijzigingen monitoren (als je script ineens niks meer vindt, check de pagina)

- robots.txt respecteren (Amazon verbiedt scraping op veel plekken—scrape verantwoord)

- Data direct opschonen (valutasymbolen, komma’s, spaties verwijderen)

- Blijf op de hoogte via de community (fora, Stack Overflow, Reddit’s r/webscraping)

Checklist voor onderhoud van je scraper:

- [ ] User-Agents en headers roteren

- [ ] Proxies gebruiken bij grote volumes

- [ ] Willekeurige vertragingen toevoegen

- [ ] Code modulair houden voor snelle updates

- [ ] Monitoren op bans of CAPTCHAs

- [ ] Data regelmatig exporteren

- [ ] Selectors en logica documenteren

Meer weten? Lees mijn .

Het no-code alternatief: Amazon scrapen met Thunderbit AI-webscraper

Je hebt nu de Python-methode gezien. Maar wat als je niet wilt programmeren—of gewoon snel data wilt verzamelen zonder gedoe? Dan is ideaal.

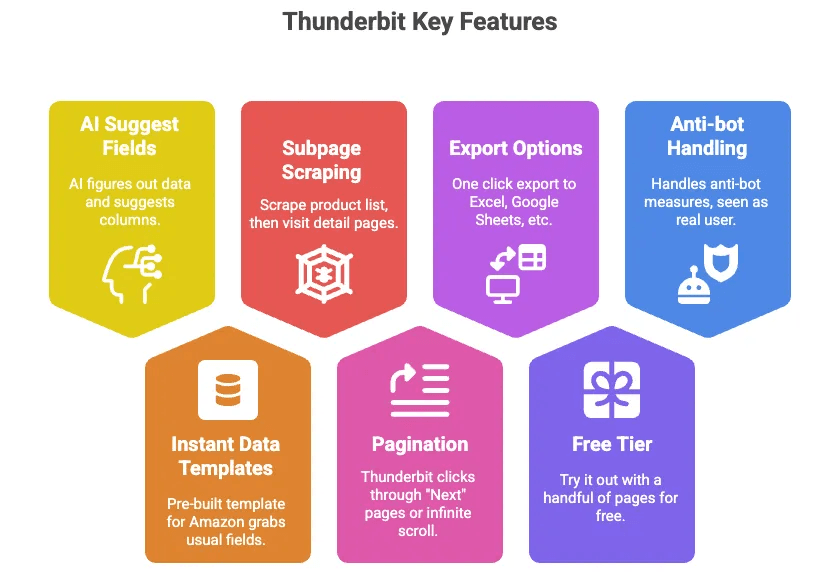

Thunderbit is een AI-webscraper Chrome-extensie waarmee je Amazon-productdata (en data van praktisch elke website) kunt verzamelen zonder te coderen. Waarom ik fan ben:

- AI Suggest Fields: Met één klik herkent Thunderbit’s AI automatisch de relevante data op de pagina en stelt kolommen voor (zoals Titel, Prijs, Beoordeling, enz.).

- Directe datatemplates: Voor Amazon is er een kant-en-klaar template dat alle standaardvelden ophaalt—geen setup nodig.

- Subpagina’s scrapen: Verzamel eerst een lijst met producten, laat Thunderbit daarna automatisch elke productpagina bezoeken voor meer details.

- Paginering: Thunderbit klikt zelf door naar “Volgende” pagina’s of verwerkt oneindig scrollen.

- Exporteren naar Excel, Google Sheets, Airtable, Notion: Eén klik en je data is klaar voor gebruik.

- Gratis instapniveau: Probeer het gratis uit met een beperkt aantal pagina’s.

- Anti-bot automatisch geregeld: Omdat het in je browser (of in de cloud) draait, ziet Amazon je als een echte gebruiker.

Stappenplan: Amazon-productdata scrapen met Thunderbit

Zo makkelijk is het:

-

Installeer Thunderbit:

Download de en log in.

-

Open Amazon:

Ga naar de Amazon-pagina die je wilt scrapen (zoekresultaten, productpagina, enz.).

-

Klik op “AI Suggest Fields” of kies een template:

Thunderbit stelt automatisch kolommen voor (of kies het Amazon Product-template).

-

Kolommen aanpassen:

Pas de kolommen aan als je wilt (velden toevoegen/verwijderen, namen wijzigen, enz.).

-

Klik op “Scrape”:

Thunderbit haalt de data op en toont deze in een tabel.

-

Subpagina’s & paginering verwerken:

Heb je een lijst gescrapet? Klik op “Scrape Subpages” om automatisch alle productpagina’s te bezoeken. Thunderbit kan ook zelf door “Volgende” pagina’s klikken.

-

Data exporteren:

Klik op “Exporteren naar Excel” of “Exporteren naar Google Sheets”. Klaar.

-

(Optioneel) Scraping plannen:

Wil je dagelijks data ophalen? Gebruik de scheduler van Thunderbit om dit te automatiseren.

Dat is alles. Geen code, geen debugging, geen proxies, geen hoofdpijn. Wil je het in actie zien? Bekijk het of de .

Amazon Scraper Python vs. No Code Webscraper: Vergelijking naast elkaar

Alles op een rij:

| Criteria | Python Scraper | Thunderbit (No Code) |

|---|---|---|

| Installatie | Veel werk (installeren, coderen, debuggen) | Snel (extensie installeren) |

| Vaardigheid | Programmeren vereist | Geen (wijzen & klikken) |

| Flexibiliteit | Onbeperkt | Hoog voor standaardtoepassingen |

| Onderhoud | Je onderhoudt zelf de code | Tool werkt zichzelf bij |

| Anti-bot | Zelf proxies/headers regelen | Ingebouwd, automatisch geregeld |

| Schaalbaarheid | Handmatig (threads, proxies) | Cloud scraping, parallel verwerkt |

| Data export | Zelf instellen (CSV, Excel, DB) | Eén klik naar Excel, Sheets |

| Kosten | Gratis (je tijd + proxies) | Freemium, betalen voor meer gebruik |

| Beste keuze voor | Developers, maatwerk | Zakelijke gebruikers, snel resultaat |

Ben je developer en wil je alles zelf regelen? Dan is Python je vriend. Wil je snelheid, gemak en geen code? Dan is Thunderbit de beste keuze.

Wanneer kies je Python, No Code of AI-webscraper voor Amazon-data?

Kies Python als:

- Je maatwerk nodig hebt of scraping wilt integreren in je backend

- Je op grote schaal wilt scrapen (tienduizenden producten)

- Je wilt leren hoe scraping technisch werkt

Kies Thunderbit (no code, AI-webscraper) als:

- Je snel data wilt zonder te programmeren

- Je een zakelijke gebruiker, analist of marketeer bent

- Je je team zelf data wilt laten verzamelen

- Je geen zin hebt in proxies, anti-botmaatregelen en onderhoud

Gebruik beide als:

- Je snel wilt prototypen met Thunderbit en daarna een Python-oplossing wilt bouwen voor productie

- Je Thunderbit gebruikt voor dataverzameling en Python voor data-analyse of opschoning

Voor de meeste zakelijke gebruikers dekt Thunderbit 90% van je Amazon-scrapingbehoefte in een fractie van de tijd. Voor de overige 10%—zeer maatwerk, grootschalig of diep geïntegreerd—blijft Python onmisbaar.

Samenvatting & belangrijkste punten

Amazon-productdata scrapen is een superkracht voor elk sales-, e-commerce- of operationeel team. Of je nu prijzen volgt, concurrenten analyseert of je team wilt verlossen van eindeloos kopiëren en plakken: er is altijd een oplossing.

- Python-scraping geeft je maximale controle, maar vraagt om technische kennis en onderhoud.

- No code webscrapers zoals Thunderbit maken Amazon-data toegankelijk voor iedereen—geen code, geen gedoe, direct resultaat.

- De beste aanpak? Kies de tool die past bij jouw vaardigheden, planning en bedrijfsdoelen.

Nieuwsgierig? Probeer Thunderbit gratis—je zult versteld staan hoe snel je de data binnenhaalt. En ben je developer? Combineer gerust: soms is de snelste route om AI het saaie werk te laten doen.

Veelgestelde vragen

1. Waarom zou een bedrijf Amazon-productdata willen scrapen?

Door Amazon te scrapen kunnen bedrijven prijzen monitoren, concurrenten analyseren, reviews verzamelen voor productonderzoek, vraag voorspellen en salesleads genereren. Met meer dan 600 miljoen producten en bijna 2 miljoen verkopers is Amazon een enorme bron van marktinformatie.

2. Wat zijn de belangrijkste verschillen tussen scrapen met Python en no-code tools zoals Thunderbit?

Python-scrapers bieden maximale flexibiliteit, maar vereisen programmeerkennis, installatie en onderhoud. Thunderbit, een no-code AI-webscraper, laat gebruikers direct Amazon-data verzamelen via een Chrome-extensie—zonder code, met ingebouwde anti-botbescherming en export naar Excel of Sheets.

3. Is het legaal om data van Amazon te scrapen?

Volgens de gebruiksvoorwaarden van Amazon is scrapen meestal niet toegestaan en Amazon neemt actief maatregelen tegen bots. Toch verzamelen veel bedrijven publiek toegankelijke data, zolang ze zich verantwoordelijk gedragen, bijvoorbeeld door limieten te respecteren en niet te veel verzoeken te sturen.

4. Welke data kan ik met webscrapingtools van Amazon halen?

Veelgebruikte velden zijn producttitels, prijzen, beoordelingen, aantal reviews, afbeeldingen, productspecificaties, beschikbaarheid en verkopersinformatie. Thunderbit ondersteunt ook subpagina’s en paginering om data van meerdere producten en pagina’s te verzamelen.

5. Wanneer kies ik voor Python-scraping en wanneer voor een tool als Thunderbit?

Gebruik Python als je volledige controle, maatwerk of integratie met backend-systemen nodig hebt. Kies Thunderbit als je snel resultaat wilt zonder te programmeren, makkelijk wilt opschalen of als je een zakelijke gebruiker bent die weinig onderhoud wil.

Meer weten? Bekijk deze bronnen:

Succes met scrapen—en moge je spreadsheets altijd up-to-date zijn.