Het web staat bomvol data, maar zeg nou zelf: wie heeft er nog zin om eindeloos te knippen en plakken? In 2025, als je nog steeds handmatig leads bij elkaar sprokkelt of concurrentieprijzen één voor één checkt, loop je echt achter—terwijl de rest allang op volle snelheid vooruitgaat. Gelukkig zijn AI-webscraper tools tegenwoordig niet meer weg te denken. Ze maken het voor sales-, marketing- en operationele teams supermakkelijk om chaotische websites om te toveren tot overzichtelijke, gestructureerde data—en dat allemaal zonder te hoeven programmeren.

Na jaren in SaaS en automatisering weet ik: de juiste AI-webscraper bespaart je team honderden uren, zorgt voor meer nauwkeurigheid en levert inzichten op waar je echt wat aan hebt. Of je nu prospectlijsten bouwt, markttrends volgt of gewoon minder werkdruk wilt, deze top 10 AI-webscraper tools voor 2025 helpen je om de juiste keuze te maken—en wie weet houd je zelfs weer wat vrije weekenden over.

Waarom AI-webscraper tools onmisbaar zijn voor productiviteit

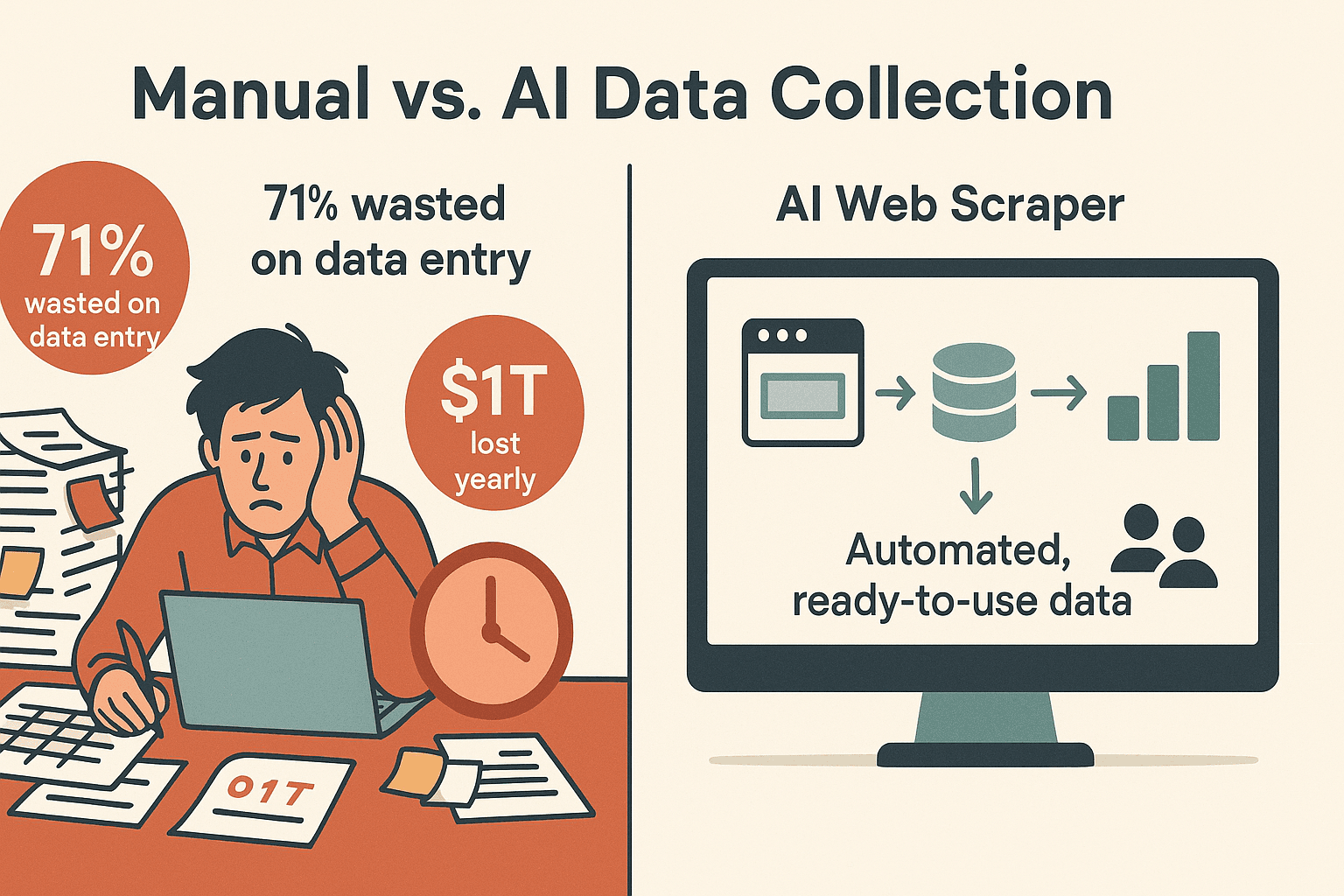

Laten we eerlijk zijn: handmatig data verzamelen is funest voor je productiviteit. geeft aan veel te veel tijd kwijt te zijn aan data-invoer in plaats van verkopen, en slecht leadbeheer en tijdverlies kosten bedrijven tot wel . AI-webscrapers draaien dit om door saaie webtaken te automatiseren en websites direct om te zetten in gestructureerde datasets—klaar voor analyse, opvolging of rapportage.

Waarom zijn AI-webscrapers nu zo belangrijk voor bedrijven?

- Tijdbesparing: AI-webscrapers kunnen de tijd die je kwijt bent aan dataverzameling met 30–40% verkorten ten opzichte van handmatig werk, zodat je meer tijd overhoudt voor analyse en actie ().

- Nauwkeurigheid: AI-gestuurde extractie haalt )—zelfs op dynamische of rommelige sites, waardoor je minder hoeft op te schonen.

- Kan complexe sites aan: Moderne AI-webscrapers kunnen overweg met JavaScript, oneindig scrollen, logins en subpagina’s—geen gedoe meer met “laad meer”-knoppen.

- Geen code nodig: De meeste tools werken met een klik-en-klaar interface of zelfs met gewone taal, dus iedereen kan ermee aan de slag—ook als je laatste “script” je boodschappenlijstje was.

Veelvoorkomende zakelijke toepassingen:

- Leadgeneratie: Verzamel prospects uit bedrijvengidsen, LinkedIn of evenementenwebsites.

- Concurrentiemonitoring: Houd prijzen, productcodes of reviews bij op e-commerce sites.

- Marktonderzoek: Verzamel artikelen, advertenties of forumberichten voor analyse.

- Operations: Haal productspecificaties, compliance-informatie of leveranciersdata op—zonder afhankelijk te zijn van IT.

Met een , worden deze tools razendsnel het geheime wapen van datagedreven teams.

Hoe hebben we de beste AI-webscraper tools gekozen?

Niet elke webscraper is hetzelfde—zeker niet als het gaat om AI-functies en gebruiksgemak voor bedrijven. Hier heb ik op gelet bij het samenstellen van de top 10:

- Gebruiksgemak: Kunnen niet-technische gebruikers snel resultaat boeken? Is er een no-code interface of AI-assistent?

- Automatiseringskracht: Kan de tool omgaan met paginering, subpagina’s, logins en dynamische content? Kun je terugkerende scrapes plannen?

- Data-export & integratie: Kun je exporteren naar Excel, Google Sheets, Airtable, Notion of via een API?

- Schaalbaarheid: Ondersteunt het cloud scraping, gelijktijdige taken of grote hoeveelheden data?

- Prijsstelling: Is er een gratis versie of proefperiode? Zijn de betaalde plannen betaalbaar voor bedrijven?

- Support & community: Is er goede documentatie, tutorials of snelle ondersteuning?

Elke tool in deze lijst heeft zijn eigen sterke punten—dus laten we erin duiken.

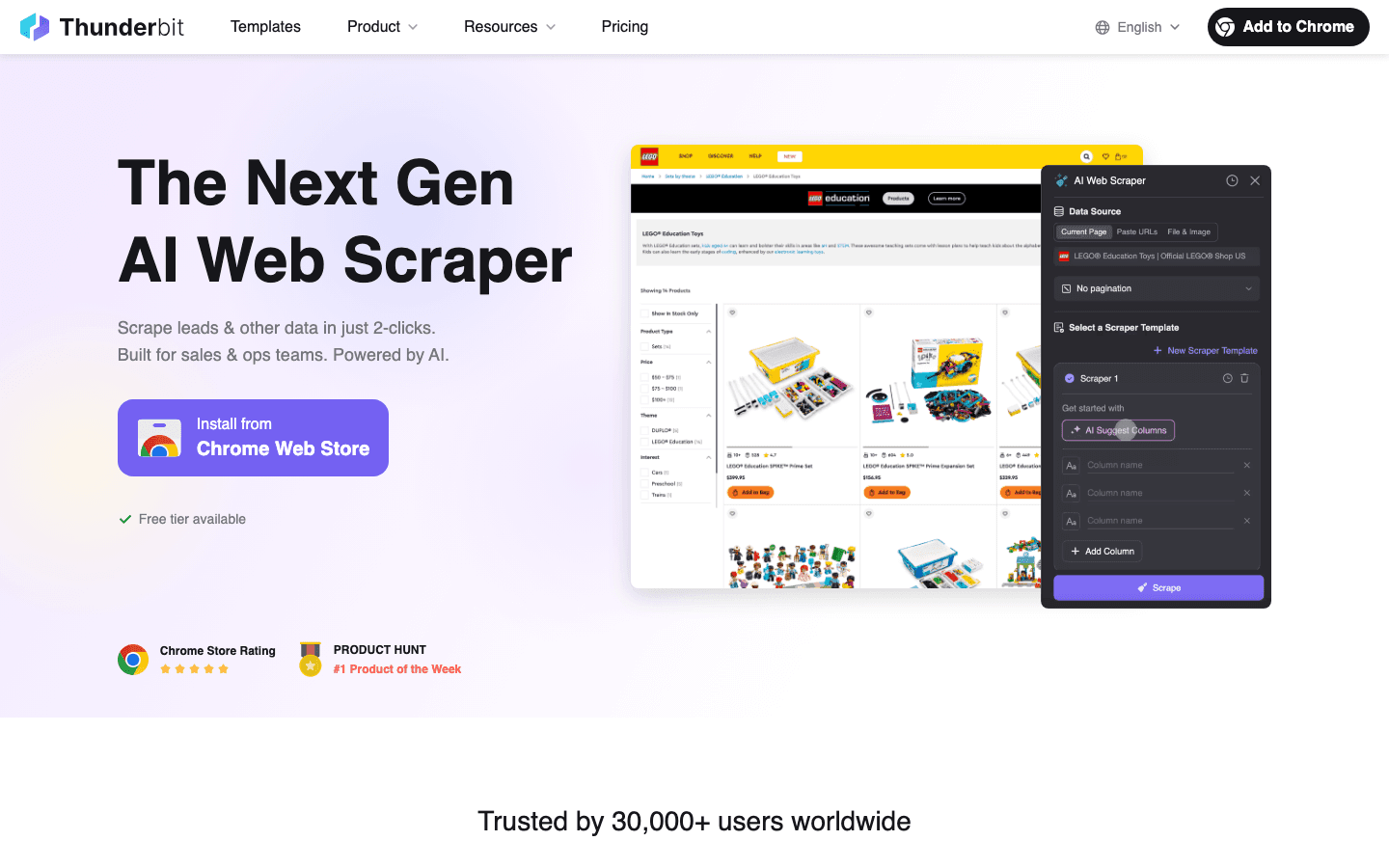

1. Thunderbit: AI-webscraper voor moeiteloos data-extractie

is mijn absolute favoriet voor iedereen die binnen vijf minuten van “ik heb deze data nodig” naar “hier is mijn spreadsheet” wil gaan. Als Chrome-extensie maakt Thunderbit webscraping supersimpel: klik op “AI Suggest Fields” en daarna op “Scrape”. De AI leest de pagina, bepaalt wat er moet worden opgehaald, en klaar ben je.

Belangrijkste functies:

- AI-gestuurde 2-klik scraping: Geen sjablonen, geen code—de AI doet het werk.

- Subpagina- & paginering-ondersteuning: Scrape lijsten en laat Thunderbit automatisch doorklikken voor extra details.

- Directe sjablonen: Eén klik voor populaire sites als Amazon, Zillow en Google Maps.

- Gratis data-export: Exporteer naar Excel, Google Sheets, Airtable of Notion—zonder extra kosten.

- AI-autovullen: Laat de AI webformulieren voor je invullen (ideaal voor repetitieve taken).

- Geplande cloud scraping: Stel terugkerende taken in met natuurlijke taal (“elke maandag om 9 uur”).

- Meertalig: Ondersteunt 34 talen.

- Gratis e-mail-, telefoon- en afbeelding-extractors: Haal contactgegevens of afbeeldingen van elke site met één klik.

Voordelen:

- Supersnelle setup—perfect voor niet-technische gebruikers.

- Kan rommelige, dynamische sites en subpagina’s beter aan dan de meeste tools.

- Alle export- en geavanceerde functies inbegrepen bij betaalde plannen.

- Royale gratis versie (6 pagina’s per maand; 10 met proefperiode).

Nadelen:

- Creditsysteem—intensieve gebruikers hebben een betaald plan nodig.

- Zeer complexe sites kunnen soms extra AI-prompts vereisen.

- Geen standaard CRM-integraties (wel API beschikbaar).

Prijs:

- Gratis tot 6 pagina’s per maand (onbeperkt aantal rijen per pagina).

- Betaalde plannen vanaf $15/maand voor 500 credits (1 credit = 1 rij), tot $249/maand voor 20.000 credits.

Ideaal voor:

Sales-, marketing- en operationele teams die snel en accuraat data willen verzamelen zonder gedoe met code of ingewikkelde instellingen. Perfect voor leadgeneratie, concurrentiemonitoring en prijsvergelijkingen in e-commerce.

Wil je het zelf proberen? en start gratis.

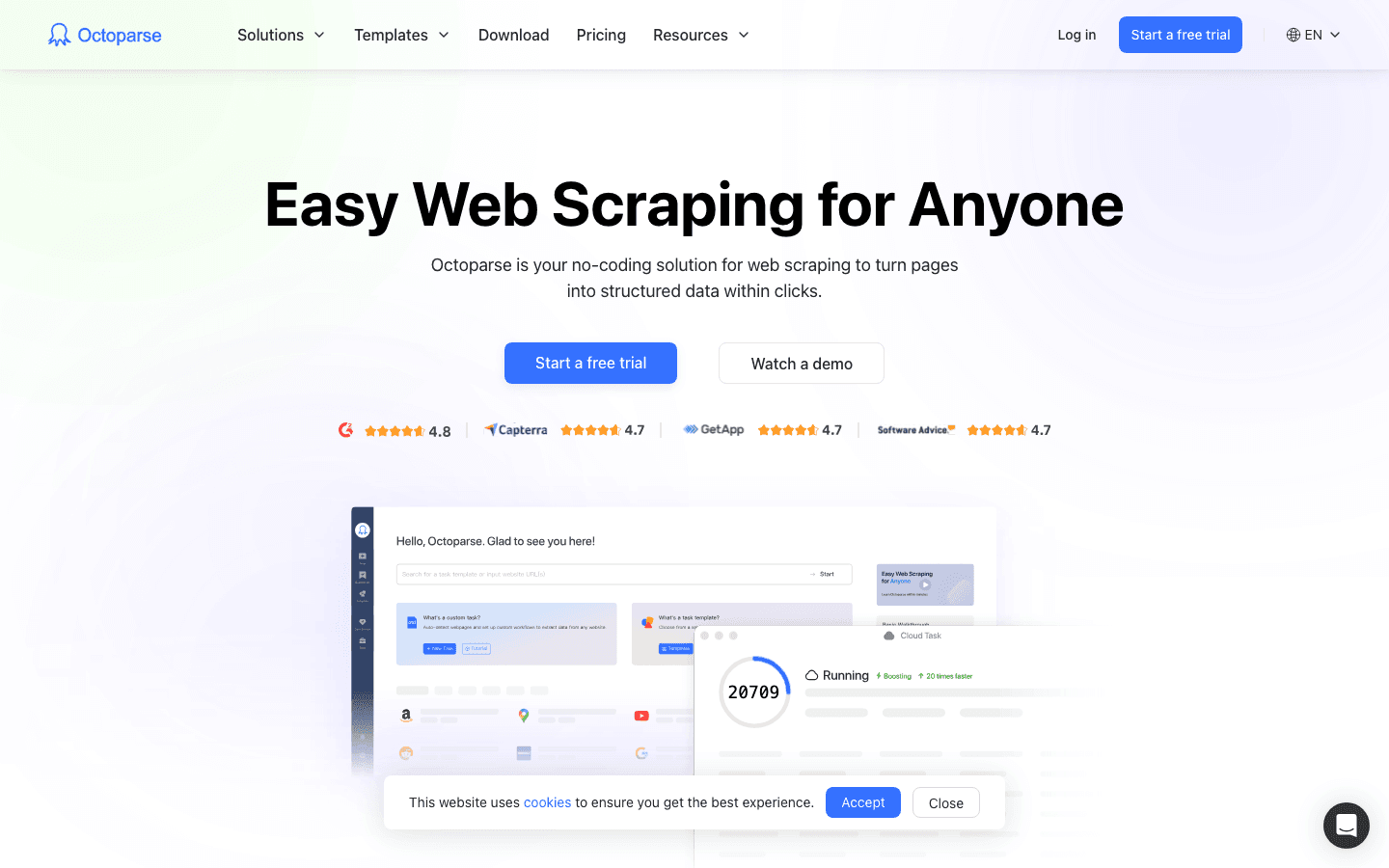

2. Octoparse: Batch data-extractie met een visuele interface

is een bekende naam in no-code scraping, vooral door de krachtige drag-and-drop interface en batch scraping. Het is een desktop-app (Windows/Mac) met een visuele workflowbouwer—klik door de site en Octoparse neemt je acties op.

Belangrijkste functies:

- Visuele workflow designer: Bouw scrapers met aanwijzen en klikken, geen code nodig.

- Cloud & lokaal uitvoeren: Draai taken op je eigen pc of in de cloud (voor snelheid en betrouwbaarheid).

- 100+ sitesjablonen: Voorgebouwde sjablonen voor Amazon, eBay, Twitter, Google Maps en meer.

- Smart Mode: AI detecteert automatisch datalijsten voor snellere setup.

- Ondersteunt logins, AJAX, infinite scroll: Ideaal voor dynamische sites.

- Export naar CSV, Excel, JSON, HTML of via API.

Voordelen:

- Gebruiksvriendelijk voor beginners, maar krachtig genoeg voor gevorderden.

- Enorme sjabloonbibliotheek voor veelgebruikte sites.

- Cloudplanning voor terugkerende taken.

- Meertalige ondersteuning.

Nadelen:

- Alleen voor Windows/Mac (geen Linux of webinterface).

- Leercurve voor geavanceerde functies (XPath, logica).

- Gratis versie is beperkt; hogere plannen kunnen prijzig zijn voor intensief gebruik.

Prijs:

- Gratis plan (10 taken).

- Standaard: ~$75/maand (jaarlijks).

- Professional: ~$209/maand (jaarlijks).

Ideaal voor:

Analisten, kleine teams of mkb’s die regelmatig grote hoeveelheden data willen scrapen—vooral van populaire sites met sjablonen.

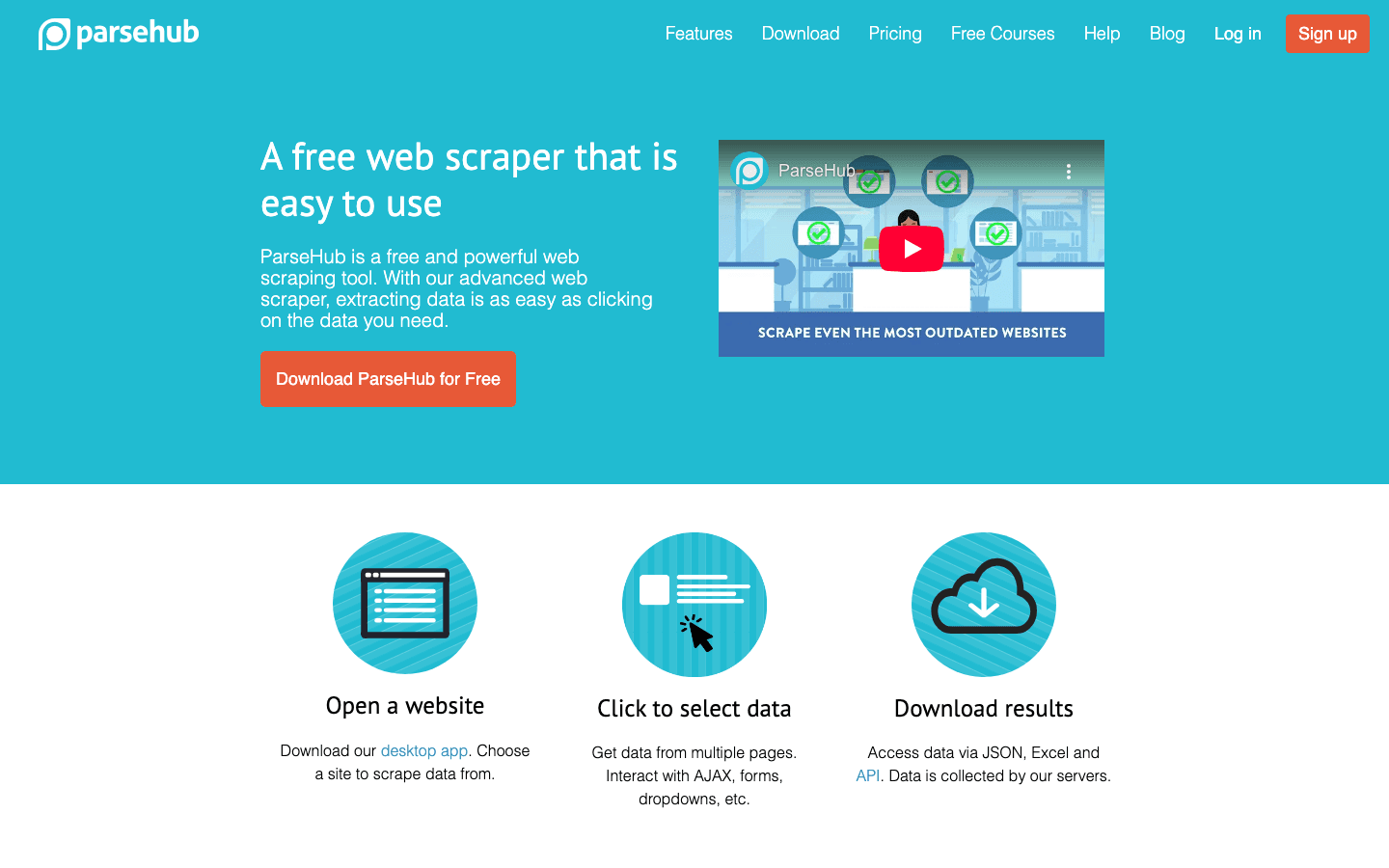

3. ParseHub: Krachtige visuele scraping voor complexe websites

is een desktop-app (Windows, Mac, Linux) die is gemaakt voor het scrapen van complexe, dynamische websites—denk aan JavaScript-rijke pagina’s, oneindig scrollen of meerstapsnavigatie.

Belangrijkste functies:

- Visuele workflowbouwer: Selecteer elementen, stel lussen in en definieer acties met klikken.

- Ondersteunt AJAX, kaarten, logins: Ideaal voor lastige sites.

- Geplande scraping: Draai taken op schema (betaalde plannen).

- Cross-platform: Werkt op Windows, Mac en Linux.

- Export naar JSON, CSV, Excel.

Voordelen:

- Uitstekend voor dynamische of interactieve sites.

- Royale gratis versie (200 pagina’s/run, 5 projecten).

- Ondersteuning voor meerdere platforms.

Nadelen:

- Draait lokaal voor de meeste taken (je computer moet aanstaan).

- Leercurve voor geavanceerde workflows.

- Betaalde plannen zijn prijzig voor incidenteel gebruik.

Prijs:

- Gratis: 5 projecten, 200 pagina’s/run.

- Standaard: $189/maand (10.000 pagina’s/run).

- Professional: $599/maand (onbeperkt aantal pagina’s/run).

Ideaal voor:

Technisch onderlegde gebruikers, datajournalisten of teams die complexe sites met veel dynamische content willen scrapen.

4. DataMiner: Chrome-extensie voor point-and-click scraping

is een browserextensie (Chrome/Edge) waarmee je tabellen en lijsten met een paar klikken kunt scrapen—zonder te programmeren. Het geheim? Meer dan 60.000 kant-en-klare “recepten” voor populaire sites.

Belangrijkste functies:

- Point-and-click data selectie: Markeer tabellen of lijsten direct in je browser.

- Receptenbibliotheek: Eén klik scraping voor Google, Amazon, LinkedIn en meer.

- Paginering-ondersteuning: Klikt automatisch op “Volgende” en combineert resultaten.

- Google Sheets-integratie: Zet data direct in je spreadsheet.

- Cloud scraping (betaalde plannen): Draai taken op hun servers.

Voordelen:

- Supereenvoudig voor snelle, on-page dataverzameling.

- Enorme receptenbibliotheek voor veelgebruikte sites.

- Gratis trainingsmateriaal en snelle support.

Nadelen:

- Gratis plan beperkt tot 500 pagina’s/maand.

- Geavanceerde functies (meerdere niveaus, automatisering) vereisen leren en een betaald plan.

- Geen ingebouwde IP-rotatie—geschikt voor matig gebruik.

Prijs:

- Gratis: 500 pagina’s/maand.

- Solo: $19,99/maand (500 pagina’s, alle functies).

- Small Business: $49/maand (1.000 pagina’s).

- Business: $99/maand (4.000 pagina’s).

Ideaal voor:

Sales-, marketing- en onderzoeksprofessionals die snel, spreadsheetvriendelijke data willen verzamelen zonder hun browser te verlaten.

5. Scrapy: Open source flexibiliteit voor gevorderde gebruikers

is het gereedschap voor ontwikkelaars—een Python-gebaseerd open source framework voor het bouwen van eigen webcrawlers en grootschalige scrapingprojecten.

Belangrijkste functies:

- Code-gedreven: Schrijf je eigen spiders in Python.

- Supersnelle, asynchrone crawling: Scrape duizenden pagina’s per uur.

- Uitbreidbaar: Voeg proxies, CAPTCHAs, aangepaste parsing en meer toe.

- Export naar CSV, JSON, databases of elk gewenst formaat.

- Grote community & ecosysteem.

Voordelen:

- Onbeperkte flexibiliteit en schaalbaarheid.

- Volledig gratis (open source).

- Integreert met elke workflow of datapijplijn.

Nadelen:

- Vereist Python-kennis—hoge leercurve voor niet-ontwikkelaars.

- Kan standaard niet overweg met JavaScript-rijke sites (integratie met headless browsers nodig).

- Je bent zelf verantwoordelijk voor infrastructuur en onderhoud.

Prijs:

- Gratis (self-hosted, open source).

Ideaal voor:

Ontwikkelteams of data engineers die eigen, grootschalige scrapingoplossingen willen bouwen.

6. Import.io: Enterprise AI-webscraper voor grote databehoeften

is een platform voor grote bedrijven dat een visuele extractor combineert met machine learning en krachtige datatransformatie.

Belangrijkste functies:

- Visuele point-and-click extractie: Bouw extractors zonder code.

- Gekoppelde extractors: Scrape lijsten en laat automatisch subpagina’s volgen.

- Datacleaning & transformatie: Ingebouwde tools voor normalisatie en kwaliteit.

- Planning & API-integratie: Automatiseer terugkerende taken en koppel aan BI-tools.

- Enterprise governance: Gebruikersbeheer, audit logs, SLA’s.

Voordelen:

- Geschikt voor grote, complexe projecten met hoge betrouwbaarheid.

- Sterke focus op datakwaliteit en transformatie.

- Toegewijde support en SLA’s voor enterprise gebruikers.

Nadelen:

- Prijs begint hoog (enkele honderden tot $1.000+/maand).

- Minder flexibel voor eenmalige of kleine projecten.

- Onboarding en setup zijn uitgebreider.

Prijs:

- Maatwerk enterprise pricing (vanaf ~$499/maand).

- Gratis proefperiode beschikbaar.

Ideaal voor:

Grote bedrijven of datagedreven organisaties die betrouwbare, grootschalige webdatafeeds nodig hebben.

7. WebHarvy: Visuele scraping met patroonherkenning

is een Windows desktop-app waarmee je data kunt scrapen door simpelweg te klikken op wat je wilt hebben. De patroonherkenning selecteert automatisch vergelijkbare items—ideaal voor lijsten en tabellen.

Belangrijkste functies:

- Point-and-click interface: Klik op data en WebHarvy pakt de hele lijst.

- Automatische patroonherkenning: Geen gedoe met selectors.

- Meerdere pagina’s & afbeeldingen scrapen: Ondersteunt paginering en downloadt afbeeldingen.

- Formulieren invullen & keyword scraping: Automatiseer zoekopdrachten en haal resultaten op.

- Eenmalige licentie: Eenmalig aanschaffen, onbeperkt gebruiken.

Voordelen:

- Zeer gebruiksvriendelijk voor beginners.

- Eenmalige aanschaf is voordelig op de lange termijn.

- Werkt offline—data blijft op je eigen computer.

Nadelen:

- Alleen voor Windows (geen Mac/Linux).

- Geen cloudcomponent—pc moet aanstaan voor geplande taken.

- Voor geavanceerde dynamische sites kan scripting nodig zijn.

Prijs:

- $129 eenmalig (per pc-licentie; inclusief 1 jaar updates).

- 15 dagen gratis proberen.

Ideaal voor:

Zelfstandige professionals, kleine bedrijven of onderzoekers op Windows die een betaalbare, eenvoudige tool zoeken voor periodieke data-extractie.

8. Apify: Cloudautomatisering en marktplaats voor AI-webscraping

is een cloudplatform met een enorme marktplaats van kant-en-klare “actors” (scraping bots) en de mogelijkheid om eigen scripts te draaien in JavaScript of Python.

Belangrijkste functies:

- Marktplaats met 5.000+ actors: Eén klik scrapers voor Google Maps, Amazon, Facebook en meer.

- Ondersteuning voor eigen scripts: Bouw je eigen bots met Node.js of Python.

- Cloudinfrastructuur: Regelt schaalbaarheid, planning, proxies en opslag.

- API & integratie: Koppel aan Zapier, Make, Google Sheets, AWS en meer.

- Anti-blokkade functies: IP-rotatie en herhaalde pogingen.

Voordelen:

- Combineert kant-en-klare scrapers met eigen code.

- Zeer schaalbaar voor grote projecten.

- Actieve community en veel integratiemogelijkheden.

Nadelen:

- Interface kan overweldigend zijn voor absolute beginners.

- Credit-gebaseerde prijsstructuur kan verwarrend zijn.

- Afhankelijkheid van community actors kan onderhoud lastig maken.

Prijs:

- Gratis versie (beperkte credits).

- Personal: $49/maand.

- Scale: $499/maand.

- Enterprise: $999+/maand.

Ideaal voor:

Ontwikkelaars, technisch onderlegde teams of iedereen die schaalbare, aanpasbare scraping wil—vooral als je gebruik wilt maken van kant-en-klare bots.

9. Dexi.io: Cloudgebaseerde AI-webscraper voor workflowautomatisering

(voorheen CloudScrape) is een cloudplatform op enterpriseniveau voor het bouwen en automatiseren van complexe webdataworkflows—denk aan RPA voor webscraping.

Belangrijkste functies:

- Visuele robotbouwer: Ontwerp scrapingworkflows met logica, lussen en condities.

- Clouduitvoering: Robots draaien op de servers van Dexi—geen eigen infrastructuur nodig.

- Datatransformatie & integratie: Maak data schoon en exporteer naar databases, API’s of analysetools.

- Teamwork: Ondersteuning voor meerdere gebruikers, versiebeheer en rollen.

- Planning & monitoring: Automatiseer terugkerende taken en volg prestaties.

Voordelen:

- Ideaal voor het automatiseren van uitgebreide, samenwerkende workflows.

- Sterke integratie- en nabewerkingsmogelijkheden.

- Betrouwbaar voor grootschalige projecten.

Nadelen:

- Steile leercurve voor geavanceerde workflows.

- Prijs begint hoog ($119+/maand).

- Kleinere gebruikerscommunity—support vooral via Dexi zelf.

Prijs:

- Vanaf ongeveer $119/maand.

- Gratis proefperiode beschikbaar.

Ideaal voor:

Middelgrote tot grote bedrijven of bureaus die uitgebreide webdataworkflows willen automatiseren met teamfunctionaliteit.

10. Content Grabber: Automatisering en integratie voor power users

is een Windows-gebaseerd, enterprise scrapingplatform voor power users en IT-teams die diepgaande automatisering en integratie nodig hebben.

Belangrijkste functies:

- Volledige IDE-omgeving: Visuele editor plus scripting in C# of VB.NET.

- Ingebouwde planner & logging: Automatiseer, monitor en ontvang meldingen over scrapingjobs.

- Database & API-integratie: Exporteer direct naar SQL, XML, JSON of Excel.

- Standalone uitvoerbare bestanden: Compileer scrapers tot .EXE-bestanden voor distributie.

- Enterprise management console: Gecentraliseerd beheer voor grote implementaties.

Voordelen:

- Zeer krachtig en uitbreidbaar.

- On-premises controle voor gevoelige data.

- Eenmalige licentie of abonnement mogelijk.

Nadelen:

- Steile leercurve—vooral geschikt voor technisch onderlegde gebruikers.

- Alleen voor Windows.

- Hoge instapkosten voor kleine projecten.

Prijs:

- Professional: ~$995 eenmalig of $149/maand.

- Premium: ~$2.495 eenmalig of $299/maand.

- Server editie: $449/jaar.

Ideaal voor:

Enterprises, IT-afdelingen of dataproviders die grootschalige, sterk aangepaste scraping met diepe integratie nodig hebben.

Snel overzicht: AI-webscraper tools in één oogopslag

| Tool | Kernfuncties | Prijs (vanaf) | Ideaal voor | Unieke pluspunten |

|---|---|---|---|---|

| Thunderbit | Chrome-extensie, AI 2-klik scraping, subpagina’s | Gratis/ $15/mnd | Niet-technische zakelijke gebruikers | Eenvoudigste setup, AI-veldherkenning, gratis export |

| Octoparse | Visuele desktop-app, 100+ sjablonen, cloud/lokaal | Gratis/ $75/mnd | Analisten, mkb, sjabloongebaseerd scrapen | Enorme sjabloonbibliotheek, hybride cloud/desktop |

| ParseHub | Visuele workflow, dynamische sites, cross-platform | Gratis/ $189/mnd | Tech-savvy gebruikers, complexe sites | Sterk op JS-rijke sites, royale gratis versie |

| DataMiner | Chrome-extensie, 60k+ recepten, Sheets-integratie | Gratis/ $19,99/mnd | Sales, marketing, snelle dataverzameling | Enorme receptenbibliotheek, makkelijke Sheets-export |

| Scrapy | Python-framework, code-gedreven, schaalbaar | Gratis (open source) | Ontwikkelteams, eigen grootschalige jobs | Onbeperkte flexibiliteit, geen licentiekosten |

| Import.io | Enterprise cloud, ML-extractie, datacleaning | ~$499/mnd (maatwerk) | Grote bedrijven, betrouwbare datafeeds | End-to-end oplossing, sterke support/SLA’s |

| WebHarvy | Windows-app, patroonherkenning, eenmalige licentie | $129 eenmalig | Zelfstandigen, kleine bedrijven op Windows | Gebruiksvriendelijk, eenmalige kosten, offline gebruik |

| Apify | Cloud, 5k+ actors, eigen scripts, API | Gratis/ $49/mnd | Ontwikkelaars, schaalbaar/aangepast scrapen | Marktplaats + eigen code, zeer schaalbaar |

| Dexi.io | Cloud visuele bouwer, workflowautomatisering | ~$119/mnd | Enterprises, teamautomatisering | ETL-workflow focus, samenwerkingsfuncties |

| Content Grabber | Windows IDE, scripting, planning, integratie | $995 eenmalig/ $149/mnd | Enterprises, IT met diepe integratie | Zeer uitgebreid, on-premises, standalone bots |

De juiste AI-webscraper kiezen voor jouw bedrijf

Welke AI-webscraper past het beste bij jou? Mijn advies:

- Absolute beginners, sales/marketing of wie niet van instellen houdt: is je beste keuze—snel, accuraat en zonder leercurve.

- Fan van sjablonen of batch scraping: en zijn ideaal voor populaire sites en herhaalwerk.

- Complexe, dynamische websites of technisch onderlegde teams: , of bieden de kracht en flexibiliteit om alles aan te kunnen.

- Enterprise-schaal, workflowautomatisering of diepe integratie: , en zijn hiervoor gebouwd.

Tip: Begin met een gratis proefperiode. De meeste tools laten je eerst testen—probeer ze uit op je eigen taak en kijk welke het beste bij jouw workflow en kennisniveau past.

De toekomst van AI-webscraper tools: trends om in de gaten te houden

AI-webscrapers worden steeds slimmer. Wat kun je verwachten?

- Betere verwerking van dynamische content: AI-scrapers leren pagina’s “zien” als mensen, waardoor ze beter bestand zijn tegen lay-outwijzigingen en JavaScript-rijke sites ().

- Slimmere datatransformatie: Meer ingebouwde opschoning, categorisatie en verrijking—waardoor rommelige webdata direct bruikbaar wordt ().

- Natuurlijke taalopdrachten: Tools als Thunderbit lopen voorop—beschrijf wat je wilt, en de AI regelt het ().

- Diepere workflowautomatisering: Scrapers zullen steeds vaker automatisch acties triggeren—zoals je CRM bijwerken of een e-mailcampagne starten—zonder handmatig ingrijpen.

- Multimodale scraping: Toekomstige tools halen niet alleen tekst, maar ook afbeeldingen, video’s en audio van het web.

Kortom: de volgende generatie AI-webscrapers maakt data-extractie bijna volledig automatisch, zodat jij je kunt focussen op wat echt telt—je bedrijf laten groeien met data.

Veelgestelde vragen

1. Wat is een AI-webscraper en hoe verschilt die van traditionele scrapers?

Een AI-webscraper gebruikt kunstmatige intelligentie om automatisch data te herkennen, te extraheren en te structureren van websites. In tegenstelling tot traditionele scrapers die code of handmatige setup vereisen, kunnen AI-scrapers zich aanpassen aan veranderende lay-outs, dynamische content verwerken en vaak werken met gewone taal—waardoor ze toegankelijk zijn voor niet-technische gebruikers.

2. Welke AI-webscraper is het beste voor niet-technische gebruikers?

wordt veel geprezen om zijn twee-klik setup en AI-veldherkenning, ideaal voor zakelijke gebruikers zonder programmeerkennis. en zijn ook sterke opties voor beginners.

3. Kunnen AI-webscrapers omgaan met dynamische of JavaScript-rijke websites?

Ja—tools als , en zijn gemaakt voor dynamische content, oneindig scrollen en logins. Voor de meest complexe sites bieden ontwikkelaarsframeworks als (met headless browser integratie) volledige controle.

4. Hoe kies ik de juiste AI-webscraper voor mijn bedrijf?

Kijk naar je technische kennis, de complexiteit van de doelwebsites, exportbehoeften en budget. Begin met een gratis proefperiode om te zien welke tool het beste bij jouw workflow past. Voor snelle, no-code taken zijn Thunderbit of Octoparse ideaal; voor grootschalige of maatwerkprojecten zijn Apify of Scrapy beter geschikt.

5. Zijn er juridische of ethische aandachtspunten bij webscraping?

Check altijd de gebruiksvoorwaarden van een website en respecteer privacywetgeving. De meeste AI-webscrapers bieden opties om verzoeken te beperken en sites niet te overbelasten. Gebruik scraping op een ethische manier—focus op publiek beschikbare data en verzamel geen gevoelige informatie zonder toestemming.

Klaar om je productiviteit te boosten? Probeer of lees meer tips op de . Veel succes met scrapen—en moge je data altijd gestructureerd, accuraat en direct bruikbaar zijn.

Meer weten: