Imagine un instant : tu es en train de chercher LA paire de baskets parfaite sur le web. Tu cliques, tu scrolles, tu passes de page en page avec « Suivant » ou « Charger plus », et arrivé à la douzième page, tu te demandes : « Mais ça s’arrête où, ce truc ? » Maintenant, imagine que tu ne fais pas que du shopping, mais que tu veux récupérer toutes les fiches produits pour comparer les prix, ou que tu bosses dans la vente et que tu cherches des prospects cachés dans un annuaire géant. C’est là que la pagination web devient bien plus qu’un simple détail (parfois relou) : c’est un vrai casse-tête technique.

Après des années à bosser dans le SaaS, l’automatisation et l’IA, j’ai vu à quel point la gestion de la pagination peut faire ou défaire un projet de collecte de données. Et avec l’arrivée d’outils d’extraction IA comme , la façon de gérer la pagination évolue à toute vitesse. Dans ce guide, je t’explique ce qu’est la pagination web, pourquoi elle est cruciale pour l’extraction de données, et comment les outils modernes (surtout ceux boostés à l’IA) rendent la récupération de jeux de données complets plus simple que jamais, même quand l’info est planquée sur des dizaines de pages.

C’est quoi la pagination web ? Explication simple et efficace

On part de la base. La pagination web, c’est juste le fait de couper une longue liste d’éléments en plusieurs pages plus digestes. Si un site propose 500 produits, il ne va pas tout balancer d’un coup (sauf s’il veut faire crasher ton navigateur !). À la place, il en montre 20 par page, avec des boutons pour naviguer — numéros de page, « Suivant », « Charger plus » — pour que tu puisses avancer petit à petit.

Mais pourquoi les sites font ça ? Trois raisons principales :

- Expérience utilisateur : Personne n’a envie de scroller une page sans fin avec 1 000 articles. La pagination aide à s’y retrouver, à se rappeler où on en était (« La promo était page 3 ! ») et à ne pas se perdre.

- Performance : Charger le contenu par petits morceaux, c’est plus rapide et ça évite de faire chauffer ton ordi (et les serveurs du site). Ça économise aussi la data, surtout avec les images.

- Navigation & structure : La pagination met de l’ordre. Tu peux aller direct au début, à la fin, ou à une section précise. C’est comme avoir un sommaire au lieu d’un rouleau infini.

Sans pagination, beaucoup de sites seraient juste inutilisables. Imagine un site e-commerce qui balance 10 000 produits sur une seule page — ton PC s’envole !

Pourquoi la pagination web est indispensable pour l’extraction de données

C’est là que ça devient intéressant pour ceux qui utilisent un extracteur web. Si tu ne récupères que la première page, tu passes à côté de la majorité des infos. Et dans le monde pro, des données incomplètes, c’est comme une pizza sans garniture : ça ne sert à rien.

Regarde quelques exemples concrets :

| Cas d’usage | Pourquoi aller au-delà de la page 1 est essentiel |

|---|---|

| Génération de leads (extraction de contacts dans des annuaires ou sur LinkedIn) | La plupart des contacts ne sont pas sur la première page. Sans pagination, tu ne récupères qu’une infime partie des prospects. |

| Veille tarifaire (produits concurrents sur des sites e-commerce) | Les offres et prix concurrents sont répartis sur plein de pages. Se limiter à la page 1, c’est rater des produits ou des prix intéressants plus loin. |

| Études de marché/SEO (résultats de recherche, classements) | Une marque peut apparaître en page 2, 3 ou plus loin. Pour une analyse complète, il faut tout collecter. |

| Agrégation d’annonces (immobilier, emploi, etc.) | Les annonces importantes peuvent être n’importe où dans une liste de 100+ pages. Un scraping incomplet, c’est des opportunités ratées. |

Comme le dit un : « Sans gestion de la pagination, ton jeu de données est incomplet. Et des données incomplètes, ça ne sert à rien. »

Les types de pagination les plus répandus sur le web

Les sites rivalisent d’imagination (parfois trop !) pour paginer leur contenu. Voici les styles les plus courants :

Pagination numérotée

Le classique : en bas de la liste, tu as des liens de pages numérotées (1, 2, 3, …, 10, Suivant >). On le voit partout — Google, Amazon, eBay, Walmart. Tu peux aller direct à une page ou cliquer sur « Suivant ».

![]()

Avantages :

- Hyper simple à comprendre.

- Navigation libre.

- Souvent, le numéro de page est dans l’URL (genre

?page=2), ce qui facilite la vie des extracteurs web.

Inconvénients :

- Parcourir beaucoup de pages, c’est long.

- Certains sites cachent les numéros ou n’en montrent que quelques-uns.

Pour l’extraction de données, la pagination numérotée, c’est la plus simple : tu incrémentes le numéro dans l’URL ou tu cliques sur « Suivant » jusqu’à la fin ().

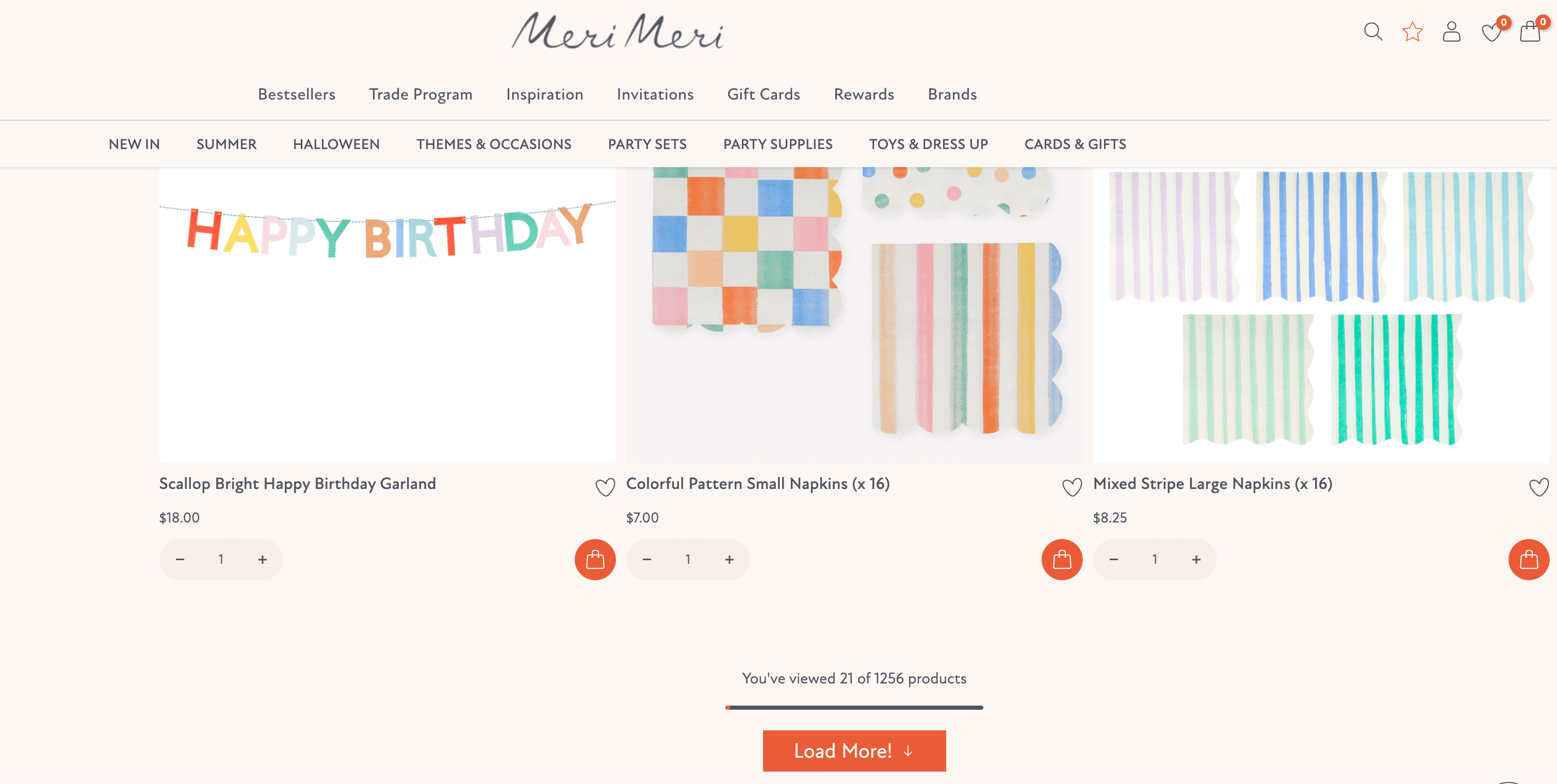

Pagination avec bouton « Charger plus »

Au lieu de pages, certains sites mettent un gros bouton « Charger plus » en bas. Un clic, et hop, de nouveaux éléments s’ajoutent à la liste, sans recharger la page. C’est courant sur mobile et dans les fils d’actu.

Avantages :

- Expérience utilisateur fluide.

- Tout reste sur une seule page.

Inconvénients :

- Pour les extracteurs, il faut simuler le clic sur le bouton (pas juste changer l’URL).

- Parfois, le bouton déclenche des appels API cachés, plus durs à reproduire.

Les outils d’extraction doivent donc simuler le clic ou refaire la requête réseau ().

Pagination à scroll infini

Le fameux « scroll infini » — la tentation de « juste un post de plus » popularisée par les réseaux sociaux. Plus tu descends, plus le contenu se charge tout seul. Instagram, Twitter, Facebook, TikTok, et même certains sites e-commerce comme Nike utilisent ce système.

Avantages :

- Super engageant pour l’utilisateur (parfois trop !).

- Parfait sur mobile.

Inconvénients :

- Difficile de retrouver un élément vu plus tôt (pas de numéros de page).

- Pour les extracteurs, c’est le plus galère : il faut simuler le scroll et attendre que le contenu charge.

Le scroll infini demande souvent des outils d’automatisation de navigateur ou des extracteurs IA capables d’imiter un vrai utilisateur ().

Navigation Suivant/Précédent

Certains sites font simple : juste des liens « Suivant > » et « < Précédent », sans numéros de page. Tu avances page par page, comme tu feuilletterais un album photo.

Avantages :

- Interface épurée.

Inconvénients :

- Impossible d’aller direct à une page précise.

- Pour les extracteurs, il faut cliquer sur « Suivant » jusqu’à ce qu’il disparaisse.

On retrouve ce schéma sur certains blogs minimalistes, forums ou vieilles applis web.

Comment la pagination fonctionne pour l’extraction de données ?

Alors, comment un extracteur web gère la pagination ? Voilà le principe :

- On commence à la page 1 : L’extracteur charge la première page et récupère les données.

- Il repère les contrôles de pagination : Il détecte les indices — numéros de page, boutons « Suivant », « Charger plus » ou signes de scroll infini.

- Il enchaîne : Selon le type, il :

- Incrémente le numéro de page dans l’URL,

- Clique sur « Suivant » ou « Charger plus »,

- Ou scrolle pour charger plus de contenu.

- Il recommence : Extraction, clic ou scroll, jusqu’à ce qu’il n’y ait plus de pages ou d’éléments à charger.

- Il finalise : Une fois tout collecté, il fusionne les données, enlève les doublons et exporte le résultat.

Petit schéma pour visualiser :

1[Page 1] → [Extraire les données] → [Y a-t-il une page suivante ?] → Oui → [Aller à la page suivante] → [Extraire les données] → ... → Non → [Terminé !]Le « page suivante » peut être un lien, un bouton ou une action de scroll. Les extracteurs modernes (surtout ceux boostés à l’IA) savent le détecter tout seuls, mais c’est toujours utile de piger ce qui se passe derrière.

L’approche Thunderbit : la pagination intelligente avec l’IA

Passons à la partie innovante : comment change la donne pour la gestion de la pagination dans l’extraction de données.

En tant que cofondateur de Thunderbit, j’ai vu des utilisateurs galérer avec tous les types de pagination. C’est pour ça qu’on a conçu l’IA de Thunderbit pour gérer la pagination automatiquement — plus besoin de boucles, de sélecteurs ou de code.

Comment Thunderbit gère la pagination :

- Détection automatique : L’IA de Thunderbit analyse la page et repère la pagination — que ce soit des liens numérotés, un bouton « Suivant », « Charger plus » ou du scroll infini. Si pagination il y a, elle sait comment cliquer ou scroller.

- Extraction en mode navigateur : Thunderbit fonctionne dans Chrome, donc il voit tout ce qu’un utilisateur voit — y compris le contenu chargé en JavaScript. C’est crucial pour le scroll infini et les boutons dynamiques.

- Extraction cloud ultra-rapide : Besoin de récupérer plein de pages ? Le mode cloud de Thunderbit peut extraire jusqu’à 50 pages en même temps. C’est comme avoir 50 assistants qui cliquent sur « Suivant » pour toi — sans pause café !

- Aucun script manuel : Clique sur « IA Suggérer les champs », laisse Thunderbit détecter les colonnes, puis lance l’extraction. S’il y a de la pagination, Thunderbit continue tout seul. Pas de code, pas de XPath, pas de prise de tête.

- Gère le clic et le scroll : Que le site utilise une pagination cliquable ou un scroll infini, Thunderbit s’adapte. Laisse l’IA choisir ou sélectionne le mode toi-même.

- Extraction de sous-pages : Après avoir extrait une liste, Thunderbit peut même visiter chaque fiche pour récupérer plus d’infos — parfait pour l’e-commerce ou l’immobilier.

En résumé, l’IA de Thunderbit considère la pagination comme une partie normale de la page. Elle sait « tourner la page » pour toi, que ce soit en cliquant, en scrollant ou autrement. (Et contrairement à moi, elle ne s’ennuie jamais !)

Thunderbit vs. pagination classique des extracteurs web

Comparons Thunderbit à l’ancienne méthode :

| Fonctionnalité | Extracteur traditionnel | Thunderbit (IA) |

|---|---|---|

| Temps de configuration | Manuel : sélectionner « Suivant », écrire des boucles, ajuster les sélecteurs | Automatique : cliquer sur « IA Suggérer les champs », lancer l’extraction |

| Gère le scroll infini | Nécessite de l’automatisation navigateur, du code sur-mesure | Mode IA intégré, simple à activer |

| S’adapte aux changements de site | Casse si la mise en page change | L’IA réanalyse la page à chaque fois |

| Vitesse | Séquentiel (une page à la fois) | Mode cloud : jusqu’à 50 pages en parallèle |

| Maintenance | Élevée — scripts à mettre à jour | Faible — l’IA s’adapte, l’équipe met à jour les modèles |

| Anti-bot | Manuel : ajouter des délais, des proxys | Intégré : timing humain, IP cloud |

| Extraction de sous-pages | Configuration manuelle pour chaque niveau | Un clic « Extraire les sous-pages » |

Thunderbit, c’est comme un assistant super efficace qui trouve chaque page, clique sur chaque bouton, et ne se perd jamais — même si le site essaie de brouiller les pistes.

Les bons réflexes pour gérer la pagination lors de l’extraction de données

Que tu utilises Thunderbit ou un autre outil, voici quelques conseils pour ne rien louper :

- Identifier le type de pagination : Avant de lancer l’extraction, regarde comment le site pagine. Numérotation ? « Charger plus » ? Scroll infini ? Ça t’aide à choisir le bon outil ou mode.

- Utiliser l’outil adapté : Pour une pagination simple, un extracteur basique suffit. Pour le scroll infini ou les sites dynamiques, privilégie un outil basé navigateur ou IA comme Thunderbit.

- Ne rate aucune page : Vérifie toujours que tu as bien tout récupéré. Si le site annonce « 500 résultats », assure-toi d’en avoir autant.

- Évite les doublons : Certains sites répètent des éléments entre les pages. Utilise des identifiants uniques (genre l’URL produit) pour dédupliquer.

- Modère la cadence : N’y va pas trop fort — des requêtes trop rapides peuvent te faire bloquer. Thunderbit imite le rythme humain, mais si tu codes, ajoute des délais.

- Utilise des proxys pour les gros volumes : Si tu extrais des centaines de pages, fais tourner les IP pour éviter les blocages. Le mode cloud de Thunderbit gère ça tout seul.

- Prévois les erreurs : Parfois, une page ne charge pas. Note les erreurs, relance les pages ratées, et vérifie toujours tes résultats.

- Exploite les fonctions IA : Pour les paginations complexes (AJAX, curseur), les extracteurs IA gèrent la galère pour toi.

- Respecte les règles du site : Vérifie toujours si l’extraction est autorisée. N’encombre pas les serveurs et respecte la vie privée.

Exemples concrets de pagination pour l’extraction de données

Voyons comment ça se passe sur quelques sites connus :

1. Amazon (pagination numérotée, anti-bot)

Amazon utilise une pagination classique, mais avec une protection anti-bot sérieuse. Thunderbit détecte le bouton « Suivant » ou les liens de page et les clique, en mode navigateur pour imiter un vrai utilisateur. En mode cloud, il peut extraire plusieurs pages en même temps. Si Amazon affiche un captcha, le mode navigateur de Thunderbit (avec un timing humain) aide à éviter les blocages.

2. Zillow (numérotée, limite de pages)

Zillow pagine les annonces immobilières, mais limite à 20 pages (environ 800 annonces). Thunderbit clique automatiquement de la page 1 à 20, puis s’arrête. Pour aller plus loin, il faut affiner la recherche (Thunderbit peut t’aider à filtrer et extraire par lots).

3. LinkedIn (scroll infini hybride)

La recherche d’emploi LinkedIn (hors connexion) utilise le scroll infini — plus tu descends, plus d’offres apparaissent. Thunderbit passe en mode scroll infini, fait défiler et extrait jusqu’à ce qu’il n’y ait plus de nouveaux résultats. Si tu es connecté et que tu vois des numéros de page, Thunderbit s’adapte et clique.

4. Yelp (pagination par offset)

Yelp utilise une pagination basée sur un offset (genre start=10 dans l’URL). Thunderbit clique sur « Suivant » ou incrémente l’offset automatiquement. Si Yelp demande ta localisation, le mode navigateur de Thunderbit gère la demande.

5. AliExpress (hybride : scroll + pages)

AliExpress charge plus de produits au scroll, puis affiche parfois un bouton « Suivant ». Thunderbit scrolle pour charger un max, puis clique sur la page suivante si besoin. C’est le couteau suisse de la pagination !

Résoudre les galères de pagination lors de l’extraction

Même avec les meilleurs outils, il peut y avoir des couacs. Voici les pièges classiques — et comment Thunderbit les gère :

- Seule la première page récupérée : Vérifie que la pagination est activée dans ton outil. Sur Thunderbit, active l’option « Paginer ». Si besoin, clique manuellement sur « Extraire la page suivante ».

- Données manquantes : Compare le nombre de résultats à ce qu’annonce le site. Si des données manquent, relance l’extraction ou cible les pages manquantes.

- Extracteur bloqué : Le scroll infini peut bloquer si le contenu charge lentement. Sur Thunderbit, essaie le mode navigateur ou fixe un temps de scroll maximal.

- Doublons ou données en vrac : Déduplique par identifiant unique. Thunderbit garde généralement l’ordre, mais tu peux trier dans Excel si besoin.

- Pages répétées ou vides : Assure-toi que l’extracteur s’arrête à la fin. L’IA de Thunderbit sait quand s’arrêter, mais si tu codes, sors de la boucle quand il n’y a plus de nouvelles données.

L’IA de Thunderbit est conçue pour gérer la plupart de ces soucis automatiquement — détection de la pagination, délais humains, relance des pages ratées. Et si tu tombes sur un cas rare, l’équipe Thunderbit met régulièrement à jour l’IA pour gérer de nouveaux schémas.

À retenir : réussir l’extraction sur des sites paginés

Voici une checklist pour extraire efficacement sur des sites paginés :

- Comprendre le type de pagination : Numérotation, « Charger plus », scroll infini ou suivant/précédent ? Repère le schéma.

- Choisir le bon outil : Privilégie les extracteurs IA comme pour les sites complexes ou dynamiques.

- Extraire toutes les pages : Ne t’arrête pas à la première — vise l’ensemble du jeu de données.

- Vérifier les erreurs : Surveille les données manquantes, doublons ou blocages.

- Modérer et faire tourner : Évite les blocages en espaçant les requêtes et en utilisant des proxys si besoin.

- Planifier les extractions : Pour les tâches récurrentes, utilise un planificateur (celui de Thunderbit fonctionne en langage naturel).

- Nettoyer les données avec l’IA : L’IA de Thunderbit peut étiqueter, dédupliquer et organiser tes données à la volée.

- S’inspirer des schémas réels : Repère les comportements courants des sites et adapte ta stratégie.

- Utiliser les modèles : Thunderbit propose des modèles prêts à l’emploi pour plein de sites — gagne du temps !

- Rester éthique : Respecte toujours les règles et la vie privée des sites.

La pagination web peut sembler être un obstacle, mais avec les bons outils et réflexes, ce n’est qu’une étape vers des données complètes et fiables. Grâce à l’approche IA de Thunderbit, tu passes moins de temps à galérer avec la pagination, et plus à exploiter tes données.

FAQ

1. C’est quoi la pagination web et pourquoi les sites l’utilisent ?

La pagination web, c’est le fait de couper de longues listes de contenus (produits, résultats de recherche, etc.) en plusieurs pages. Les sites l’utilisent pour améliorer l’expérience utilisateur, accélérer le chargement et structurer l’info.

2. Pourquoi la pagination est importante pour l’extraction de données ?

Si ton extracteur ne collecte que la première page, tu rates la majorité des données utiles. Beaucoup de cas d’usage pro — génération de leads, veille tarifaire, études de marché — nécessitent d’aller au-delà de la page 1 pour avoir un jeu de données complet.

3. Quels sont les types de pagination les plus courants ?

Les principaux types sont :

- Pagination numérotée : pages 1, 2, 3, etc.

- Boutons « Charger plus » : ajoutent des résultats sans recharger la page.

- Scroll infini : le contenu se charge automatiquement au scroll.

- Liens Suivant/Précédent : navigation page par page.

Chaque type demande une stratégie d’extraction différente.

4. Comment Thunderbit gère la pagination ?

Thunderbit utilise l’IA pour détecter et gérer automatiquement tous les types de pagination — liens numérotés, boutons « Charger plus », scroll infini. Il fonctionne en mode navigateur pour les pages dynamiques et peut extraire jusqu’à 50 pages en parallèle en mode cloud, sans écrire une ligne de code.

5. Quelles sont les bonnes pratiques pour extraire sur des sites paginés ?

- Identifie le type de pagination avant de commencer.

- Utilise des outils capables de gérer le contenu dynamique (comme Thunderbit).

- Vérifie que toutes les pages ont bien été extraites.

- Déduplique les données avec des identifiants uniques.

- Modère la cadence et utilise des proxys pour les gros volumes.

- Respecte les conditions d’utilisation et la politique de données des sites.

Pour aller plus loin :