Tu t’es déjà retrouvé à vouloir surveiller des centaines de sites concurrents, pour vite te rendre compte qu’il te faudrait une armée (ou des litres de café) pour tout copier-coller à la main ? Rassure-toi, tu n’es clairement pas le seul. Aujourd’hui, la donnée web, c’est de l’or pour les boîtes, que ce soit pour la vente, le marketing, la recherche ou l’opérationnel. D’ailleurs, le web scraping pèse maintenant plus d’, et 81% des entreprises américaines utilisent des extracteurs automatiques pour surveiller les prix (). Bref, les bots font le sale boulot à notre place.

Mais au fond, comment bossent ces robots ? Et pourquoi tant d’équipes misent sur Node.js — le moteur JavaScript qui fait tourner une bonne partie du web — pour créer leur extracteur web ? Après des années dans le SaaS et l’automatisation (et en tant que CEO de ), j’ai vu comment les bons outils peuvent transformer la collecte de données web en vrai super-pouvoir business. On va décortiquer ensemble ce qu’est un extracteur web Node, comment ça marche, et pourquoi même sans être dev, tu peux t’y mettre.

Extracteur web Node : les bases

On va faire simple. Un extracteur web Node, c’est un programme — codé avec Node.js — qui va automatiquement sur des pages web, suit les liens et récupère les infos qui t’intéressent. Imagine-le comme un assistant digital qui ne dort jamais : tu lui files une URL de départ, il navigue, il collecte les données, et il continue jusqu’à avoir tout ce qu’il te faut sur le site (ou la partie qui t’intéresse).

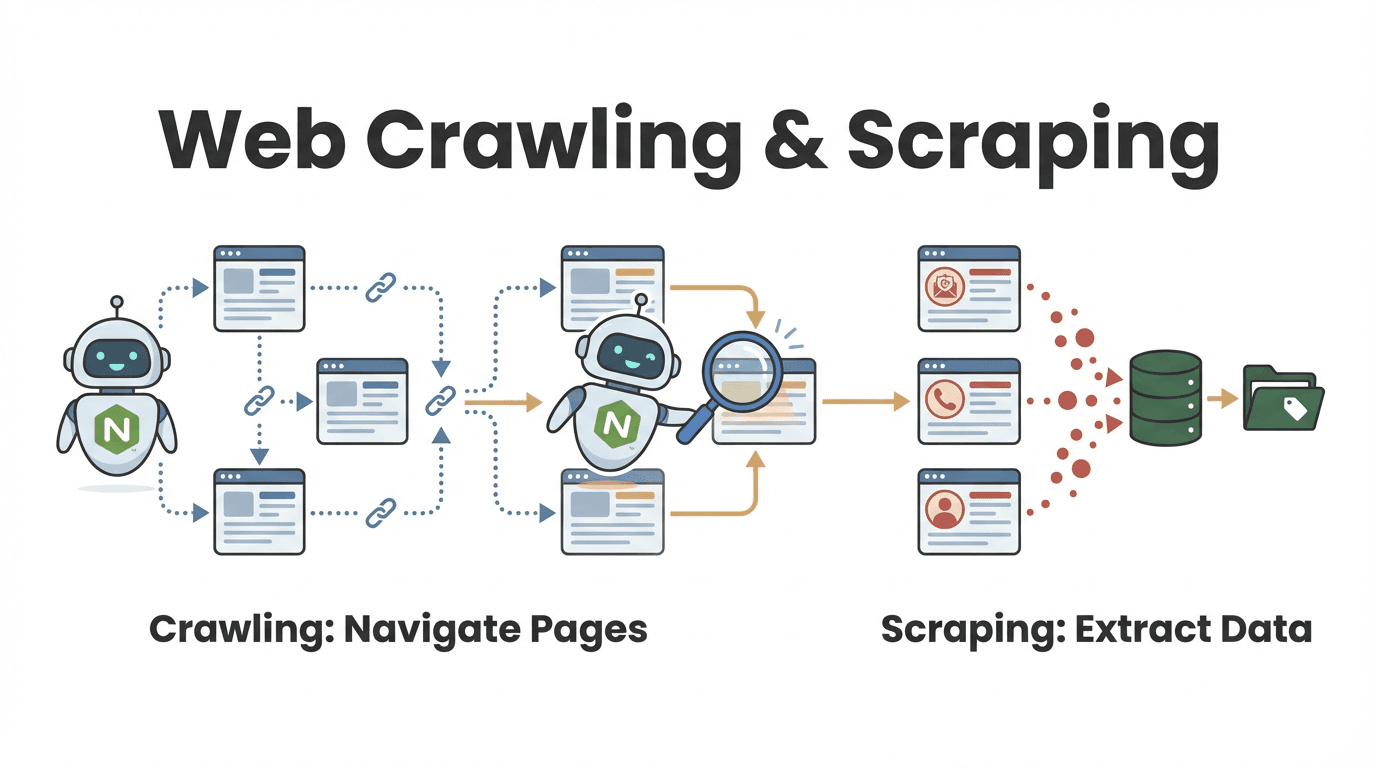

Mais alors, c’est quoi la différence entre exploration web (web crawling) et extraction web (web scraping) ? C’est une question qui revient souvent, surtout côté business :

- Exploration web : c’est découvrir et parcourir plein de pages. Imagine que tu feuillettes tous les livres d’une bibliothèque pour repérer ceux qui t’intéressent.

- Extraction web : c’est récupérer des infos précises sur ces pages — comme recopier les meilleures citations de chaque livre.

En vrai, la plupart des extracteurs web Node font les deux : ils trouvent les pages utiles et extraient les données dont tu as besoin (). Par exemple, une équipe commerciale peut explorer un annuaire pour lister tous les profils d’entreprise, puis extraire les coordonnées de chaque fiche.

Comment fonctionne un extracteur web Node ?

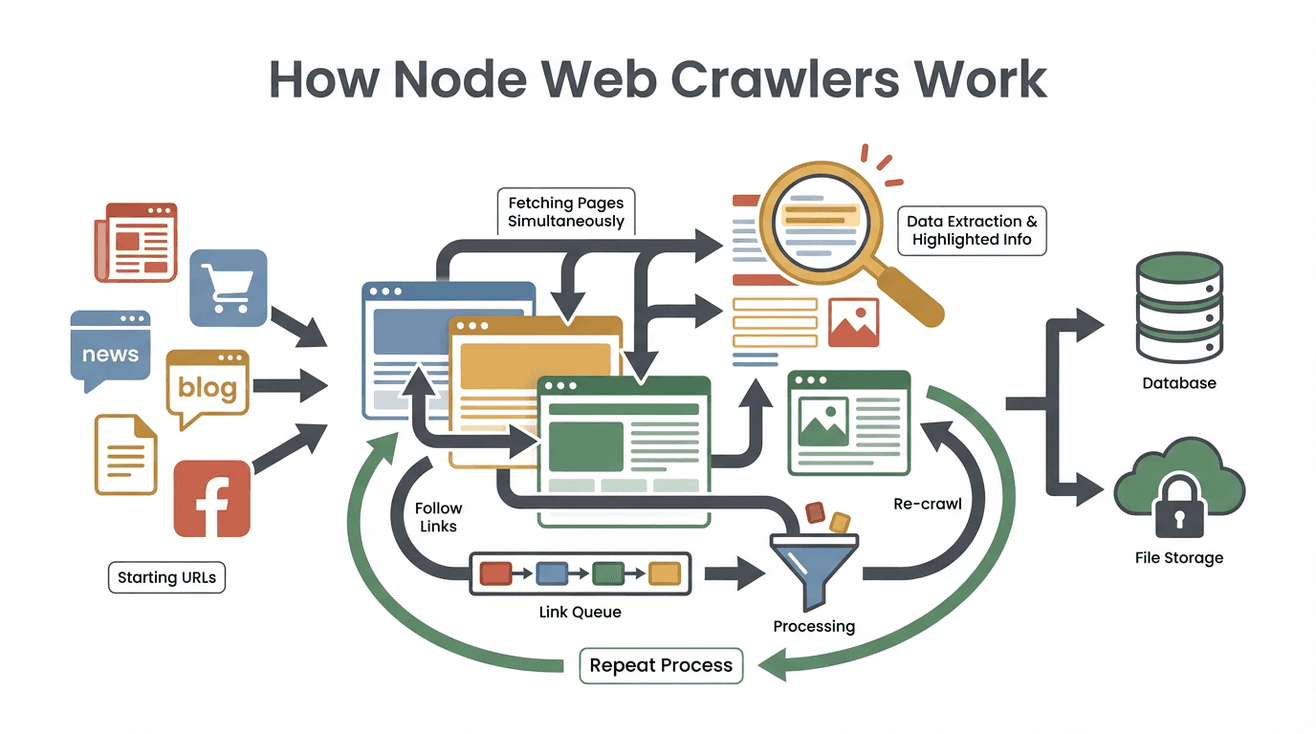

On va casser le mythe. Voilà comment bosse un extracteur web Node classique, étape par étape :

- Définir les URLs de départ : Tu donnes au robot une ou plusieurs adresses de départ (page d’accueil, liste de produits, etc.).

- Télécharger le contenu des pages : L’extracteur récupère le code HTML de chaque page — comme un navigateur, mais sans l’affichage.

- Extraire les données utiles : Avec des outils comme Cheerio (le jQuery de Node), il repère et extrait les infos que tu veux : noms, prix, emails, etc.

- Détecter et ajouter de nouveaux liens : Il scanne chaque page pour trouver d’autres liens (genre « page suivante », détails produit) et les ajoute à sa liste de tâches (le « front de crawl »).

- Répéter le process : L’extracteur visite les nouveaux liens, extrait les données, et élargit sa couverture jusqu’à avoir tout collecté selon tes critères.

- Stocker les résultats : Toutes les données extraites sont sauvegardées — souvent en CSV, JSON, ou direct dans une base de données.

- Arrêter à la fin : Le robot s’arrête quand il n’a plus de nouveaux liens à explorer ou qu’il atteint une limite.

Un exemple concret : tu veux toutes les offres d’emploi d’un site carrière. Tu démarres sur la page principale, tu chopes tous les liens d’annonces, tu visites chaque fiche, tu récupères les détails, et tu continues jusqu’à avoir tout le catalogue.

Le secret derrière tout ça ? L’architecture événementielle et non bloquante de Node.js permet à l’extracteur de traiter plein de pages en même temps, sans attendre que chaque site réponde. C’est comme avoir une team d’assistants qui bossent en parallèle — sans la facture pizza.

Pourquoi Node.js cartonne pour les extracteurs web ?

Mais alors, pourquoi Node.js plutôt que Python, Java ou autre ? Voilà ce qui fait la force de Node.js pour l’extraction web :

- Entrées/sorties événementielles et non bloquantes : Node.js gère des dizaines (voire des centaines) de requêtes en même temps, sans ralentir. Pendant qu’une page charge, il en traite déjà d’autres ().

- Super perfs : Node tourne sur le moteur V8 de Google (le même que Chrome), donc il est ultra rapide pour analyser et traiter de gros volumes de données web.

- Écosystème blindé : Il y a une bibliothèque Node pour tout : Cheerio pour parser le HTML, Got pour les requêtes HTTP, Puppeteer pour la navigation sans interface, et des frameworks comme Crawlee pour gérer de gros volumes ().

- Synergie avec JavaScript : Comme la majorité des sites tournent en JavaScript, Node.js s’intègre naturellement. Il gère aussi super bien les données JSON, omniprésentes sur le web.

- Capacité temps réel : Besoin de surveiller plein de sites pour détecter des changements de prix ou des news ? Node gère la concurrence quasi en temps réel.

Pas étonnant que des outils Node comme Crawlee et Cheerio soient utilisés par .

Fonctions clés d’un extracteur web Node

Les extracteurs web Node, c’est un peu le couteau suisse de la donnée web. Voici leurs fonctions principales — et comment elles servent les besoins métiers :

| Fonctionnalité | Comment ça marche avec Node | Exemple d'usage métier |

|---|---|---|

| Navigation automatisée | Suit automatiquement les liens et les pages paginées | Génération de leads : explorer toutes les pages d’un annuaire en ligne |

| Extraction de données | Récupère des champs précis (nom, prix, contact) via des sélecteurs ou motifs | Veille tarifaire : extraire les prix produits chez les concurrents |

| Gestion multi-pages simultanée | Télécharge et traite de nombreuses pages en parallèle (grâce à l’asynchrone Node.js) | Actualités en temps réel : surveiller plusieurs sites d’info à la fois |

| Sortie de données structurée | Sauvegarde les résultats en CSV, JSON ou directement en base de données | Analytics : alimenter des tableaux de bord BI ou des CRM |

| Logique & filtres personnalisés | Ajout de règles, filtres ou nettoyage de données personnalisés dans le code | Contrôle qualité : ignorer les pages obsolètes, transformer les formats de données |

Par exemple, une équipe marketing peut utiliser un extracteur Node pour collecter tous les articles de blogs d’un secteur, extraire les titres et URLs, puis tout balancer dans Google Sheets pour planifier ses contenus.

Thunderbit : l’alternative no-code aux extracteurs web Node

C’est là que ça devient fun (et carrément plus accessible pour ceux qui ne codent pas). est une extension Chrome d’extraction web boostée à l’IA, qui te permet de collecter des données web — sans écrire une seule ligne de code.

Comment ça marche ? Tu ouvres l’extension, tu cliques sur « Suggestions IA de champs », et l’IA de Thunderbit analyse la page, te propose les données pertinentes à extraire et les range dans un tableau. Tu veux tous les noms et prix de produits d’un site ? Dis-le simplement en français, Thunderbit s’occupe du reste. Besoin d’extraire des sous-pages ou de gérer la pagination ? Un clic et c’est plié.

Quelques atouts de Thunderbit :

- Interface en langage naturel : Tu expliques ce que tu veux, l’IA gère la technique.

- Suggestions de champs IA : Thunderbit scanne la page et te propose les meilleures colonnes à extraire.

- Exploration de sous-pages sans code : Récupère les pages de détail (produits, profils…) et fusionne les données automatiquement.

- Export structuré : Balance tes données direct dans Excel, Google Sheets, Airtable ou Notion.

- Export de données gratuit : Pas de frais cachés pour télécharger tes résultats.

- Automatisation & planification : Programme des extractions récurrentes en langage naturel (« chaque lundi à 9h »).

- Extraction de contacts : Récupère en un clic emails, numéros de téléphone et images — totalement gratuit.

Pour les pros, ça veut dire passer de « j’ai besoin de ces données » à « voilà mon tableau » en quelques minutes, pas en plusieurs jours. Et d’après les , même les non-techniciens créent des listes de prospects, surveillent les prix et font de la veille — sans jamais toucher au code.

Comparatif : extracteur web Node vs Thunderbit pour les pros

Alors, tu choisis quoi ? Voici un comparatif clair :

| Critère | Extracteur web Node.js (code personnalisé) | Thunderbit (extracteur IA sans code) |

|---|---|---|

| Temps de mise en place | De quelques heures à plusieurs jours (dev, debug, config) | Quelques minutes (installation, clic, extraction) |

| Compétences requises | Programmation nécessaire (Node.js, HTML, sélecteurs) | Aucun code ; langage naturel & clics |

| Personnalisation | Extrêmement flexible ; toute logique ou workflow possible | Limité aux fonctions intégrées et à l’IA |

| Scalabilité | Peut monter en charge (serveurs, proxies, etc.) | Grattage cloud intégré pour des volumes moyens à élevés |

| Maintenance | Continue (adapter le code aux changements de sites) | Minime (l’IA de Thunderbit s’adapte automatiquement) |

| Gestion anti-bot | À gérer soi-même (proxies, délais, navigation headless…) | Géré automatiquement par Thunderbit |

| Intégration | Intégration poussée possible (API, bases, workflows) | Export vers Sheets, Notion, Airtable, Excel, CSV |

| Coût | Outils gratuits, mais temps dev et serveurs à prévoir | Offre gratuite, puis paiement à l’usage ou abonnement |

À privilégier avec Node.js :

- Besoin de logique ou d’intégration très personnalisée.

- Ressources dev à dispo et envie de tout maîtriser.

- Extraction à très grande échelle ou création d’un produit autour de la donnée web.

À privilégier avec Thunderbit :

- Résultats rapides, sans prise de tête.

- Pas de compétences techniques (ou pas envie de coder).

- Extraction variée pour les besoins métiers du quotidien.

- Priorité à la simplicité et à l’adaptabilité de l’IA.

Beaucoup d’équipes commencent avec Thunderbit pour aller vite, puis passent à du Node sur-mesure si leurs besoins deviennent plus costauds ou complexes.

Les défis courants avec les extracteurs web Node

Les extracteurs Node, c’est puissant, mais ça vient avec quelques galères. Voici les principaux pièges (et comment les anticiper) :

- Défenses anti-scraping : Les sites balancent des CAPTCHAs, bloquent les IP, détectent les bots. Il faut donc gérer la rotation de proxies, bidouiller les entêtes, et parfois simuler une vraie navigation avec Puppeteer ().

- Contenu dynamique : Beaucoup de sites chargent les données en JavaScript ou via scroll infini. Un simple parsing HTML ne suffit pas — il faut parfois simuler la navigation ou utiliser des APIs.

- Nettoyage et parsing des données : Les pages web sont rarement bien rangées. Il faut gérer les formats bizarres, les données manquantes, les encodages chelous.

- Maintenance : Les sites changent. Ton code peut casser. Prévoyez des mises à jour régulières et une gestion des erreurs.

- Aspects légaux et éthiques : Respecte toujours le

robots.txt, les conditions d’utilisation et la législation sur la vie privée. N’extrais pas de données sensibles ou protégées.

Bonnes pratiques :

- Utilise des frameworks comme Crawlee qui gèrent déjà pas mal de ces soucis.

- Prévoyez des relances, des délais et des logs d’erreur.

- Mets à jour tes extracteurs régulièrement.

- Sois responsable : n’inonde pas les sites et respecte leurs règles.

Intégrer un extracteur web Node avec le cloud

Pour des projets de collecte de données web sérieux et récurrents, faire tourner ton extracteur Node sur ton ordi, ça ne suffit pas. D’où l’intérêt du cloud :

- Fonctions serverless : Déploie ton extracteur Node en tant que fonction AWS Lambda ou Google Cloud Function. Programme-le pour tourner automatiquement (tous les jours, toutes les heures…), et stocke les résultats sur S3 ou BigQuery ().

- Extracteurs conteneurisés : Emballe ton extracteur dans un Docker et fais-le tourner sur AWS Fargate, Google Cloud Run ou Kubernetes. Parfait pour traiter des milliers de pages en parallèle.

- Workflows automatisés : Utilise des planificateurs cloud (AWS EventBridge, etc.) pour déclencher les extractions, stocker les résultats et alimenter des dashboards ou modèles d’IA.

Les avantages ? Scalabilité, fiabilité, et automatisation sans prise de tête. D’ailleurs, — et ça grimpe chaque année.

Quand choisir un extracteur web Node ou une solution no-code ?

Tu hésites encore ? Voici un guide express pour trancher :

-

Besoin de personnalisation poussée, de workflows uniques ou d’intégration avec tes systèmes internes ?

→ Extracteur web Node.js -

Tu veux des données vite, sans coder ?

→ Thunderbit (ou un autre outil no-code) -

Tâche ponctuelle ou peu fréquente ?

→ Thunderbit -

Projet critique, récurrent, à grande échelle ?

→ Node.js (avec intégration cloud) -

Tu as des ressources dev et du temps pour la maintenance ?

→ Node.js -

Tu veux rendre tes équipes non techniques autonomes sur la donnée ?

→ Thunderbit

Mon conseil ? Commence par le no-code pour des résultats rapides et des prototypes. Si tes besoins évoluent, tu pourras toujours investir dans un extracteur Node sur-mesure. Beaucoup d’équipes constatent que Thunderbit couvre 90% de leurs cas d’usage — et fait gagner un temps fou.

Conclusion : Libère la puissance de la donnée web pour ton business

L’extraction de données web, ce n’est plus réservé aux « geeks » — c’est devenu un levier incontournable pour les entreprises. Que tu développes ton propre extracteur web Node ou que tu utilises un outil IA comme , l’objectif reste le même : transformer le chaos du web en infos structurées et exploitables.

Node.js, c’est la flexibilité et la puissance ultime, surtout pour les projets costauds ou à grande échelle. Mais pour la majorité des pros, l’essor des outils no-code et de l’IA permet d’obtenir les données nécessaires — vite, de façon fiable, et sans coder.

Alors que près de , les équipes qui maîtrisent la donnée web prennent une vraie longueur d’avance. Que tu sois dev, marketeur ou juste lassé du copier-coller, c’est le moment parfait pour exploiter la puissance de l’exploration web.

Envie de tester par toi-même ? gratuitement et découvre à quel point l’extraction de données web peut être simple. Pour aller plus loin, checke le pour des guides, astuces et retours d’expérience sur l’automatisation web.

FAQ

1. Quelle est la différence entre un extracteur web Node et un extracteur web classique ?

Un extracteur web Node découvre et parcourt automatiquement les pages web (comme une araignée sur sa toile), alors qu’un extracteur web classique se concentre sur l’extraction de données précises. La plupart des extracteurs Node font les deux : ils trouvent les pages et récupèrent les infos utiles.

2. Pourquoi Node.js est-il populaire pour créer des extracteurs web ?

Node.js est événementiel et non bloquant, ce qui lui permet de gérer plein de requêtes en parallèle. Il est rapide, a un écosystème de bibliothèques énorme, et il est top pour l’extraction de données en temps réel ou à grande échelle.

3. Quels sont les principaux défis avec les extracteurs web Node ?

Les galères classiques : protections anti-bot (CAPTCHAs, blocages IP), contenu dynamique (sites blindés de JavaScript), nettoyage des données, et maintenance continue au fil des changements de sites. Les frameworks et bonnes pratiques aident, mais il faut des compétences techniques.

4. En quoi Thunderbit diffère-t-il d’un extracteur web Node ?

Thunderbit est un extracteur web IA sans code. Au lieu de coder, tu utilises une extension Chrome et le langage naturel pour extraire tes données. C’est parfait pour les pros qui veulent des résultats rapides, sans programmation.

5. Quand utiliser un extracteur web Node ou Thunderbit ?

Utilise Node.js pour des projets très personnalisés, à grande échelle ou nécessitant une intégration poussée — surtout si tu as des ressources dev. Privilégie Thunderbit pour des extractions rapides, quotidiennes, ou pour rendre tes équipes non techniques autonomes sur la donnée.

Prêt à passer à la vitesse supérieure ? Teste ou explore le pour aller plus loin. Bonne exploration !

Pour aller plus loin