Le web d’aujourd’hui, c’est un vrai terrain de jeu pour les passionnés de données — bien loin de l’époque où un simple « clic droit, enregistrer sous » suffisait pour récupérer ce qu’on voulait. Les sites sont devenus de vrais casse-têtes, avec des contenus dynamiques, des liens planqués, des pop-ups à gogo et des menus à tiroirs. Si tu as déjà essayé de collecter toutes les fiches produits d’un site e-commerce ou de rassembler chaque annonce d’un portail immobilier, tu sais que les extracteurs web classiques ne font plus le poids. C’est là que les deep crawlers entrent en scène : ces outils nouvelle génération sont pensés pour aller gratter en profondeur et ramener les infos vraiment utiles, même dans les coins les plus planqués du web.

Mais alors, c’est quoi exactement un deep crawler ? Pourquoi tout le monde — des commerciaux aux analystes — s’y intéresse autant ? Et comment un outil comme peut rendre le deep crawling aussi simple qu’un double-clic, même si tu n’as jamais touché une ligne de code ? On va décortiquer tout ça ensemble, des bases jusqu’à l’impact business, pour comprendre pourquoi les deep crawlers sont en train de devenir l’arme secrète de l’extraction de données web.

Deep Crawler : le b.a.-ba

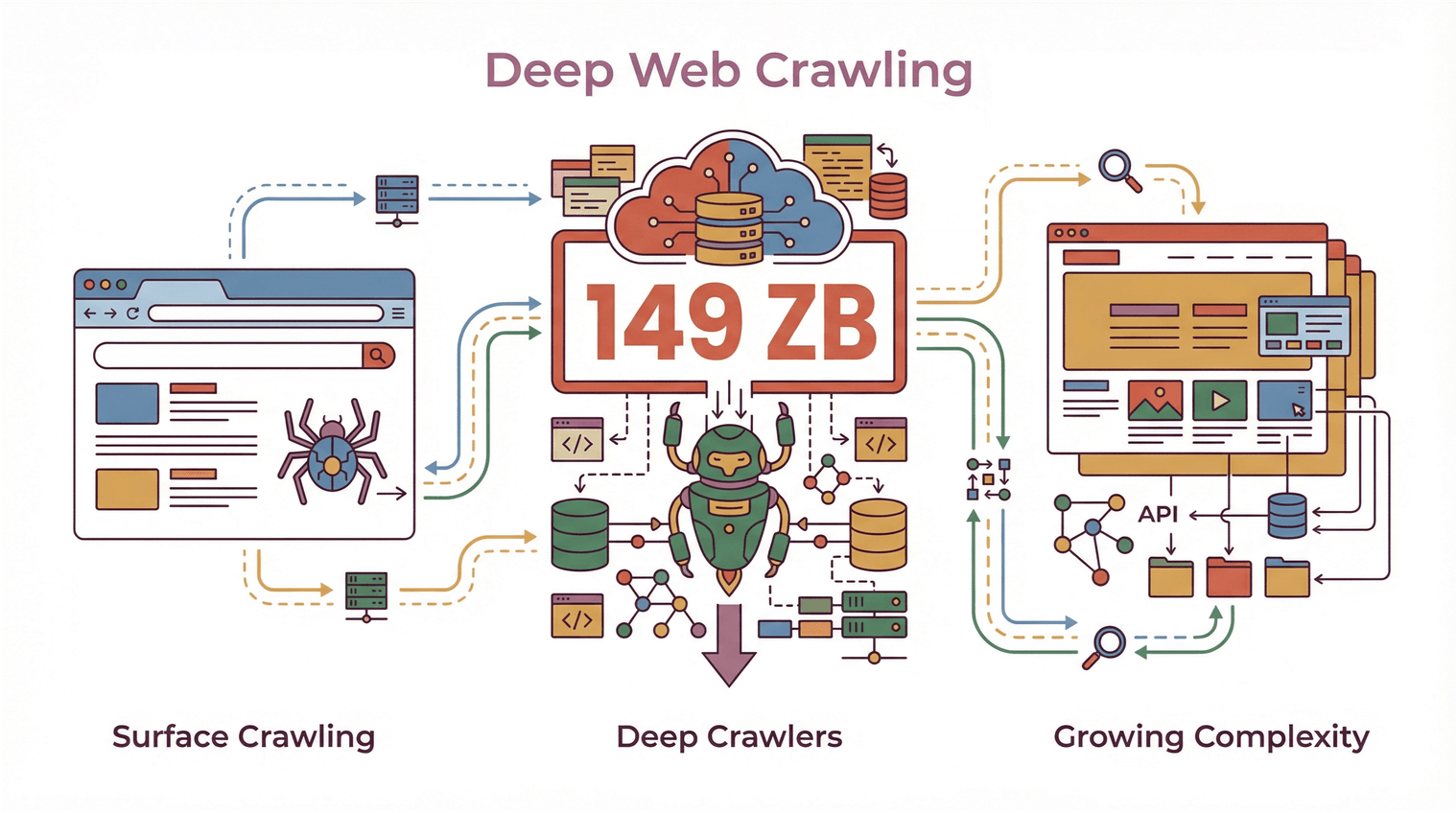

Un deep crawler, c’est tout simplement un extracteur web taillé pour naviguer et extraire des données sur des sites complexes, à plusieurs étages et souvent bourrés de contenu dynamique. Là où les crawlers classiques se contentent de survoler la page d’accueil et de prendre ce qui traîne, un deep crawler va suivre les liens, explorer chaque recoin, et gérer tout ce qui est listes paginées, contenus cachés derrière des onglets ou sections repliables.

Imagine un crawler classique comme quelqu’un qui jette un œil rapide aux livres en vitrine d’une bibliothèque. Un deep crawler, lui, va fouiller chaque rayon, ouvrir chaque bouquin, lire les notes de bas de page et même regarder derrière la porte « réservé au personnel » (tant qu’elle n’est pas fermée à clé).

En pratique, un deep crawler peut :

- Naviguer à travers plusieurs niveaux d’un site (catégories, sous-catégories, pages de détails)

- Extraire du contenu dynamique chargé par JavaScript ou caché derrière des interactions utilisateur

- Gérer la pagination complexe et le scroll infini

- Suivre les liens internes pour ne rien louper d’important

Avec un volume de données web mondial qui atteint et des sites qui deviennent de plus en plus complexes, les deep crawlers sont vite devenus incontournables pour ceux qui veulent aller plus loin qu’un simple survol du web.

Avec un volume de données web mondial qui atteint et des sites qui deviennent de plus en plus complexes, les deep crawlers sont vite devenus incontournables pour ceux qui veulent aller plus loin qu’un simple survol du web.

Deep Crawler vs. Crawler classique : le match

Soyons clairs : qu’est-ce qui fait vraiment la différence entre un deep crawler et un crawler « classique » ?

Crawlers classiques : le survol express

Les extracteurs web classiques (ou « crawlers superficiels ») sont faits pour aller vite et couvrir large. Ils scannent un site à toute vitesse, récupèrent ce qui est visible sur les pages principales, puis passent à autre chose. C’est la méthode des moteurs de recherche : indexer un max de pages, le plus vite possible, sans forcément fouiller partout.

Leurs limites :

- Ils passent à côté des données cachées derrière la navigation, les onglets ou les éléments dynamiques

- Ils galèrent avec les sites bourrés de JavaScript ou les contenus qui se chargent après coup

- Ils ne gèrent pas les navigations à plusieurs étapes ou les structures de pages complexes

- Résultat : des jeux de données souvent incomplets ou fragmentés

Deep Crawlers : l’exploration en profondeur

À l’inverse, un deep crawler est pensé pour explorer un site à fond : il suit chaque lien utile, clique sur les listes paginées, va chercher les infos sur les sous-pages, pop-ups et contenus dynamiques. Ici, ce n’est pas la vitesse qui compte, mais la précision et la complétude.

Ce qui fait la force des deep crawlers :

- Navigation avancée : suit les liens de façon récursive, gère les sites à plusieurs niveaux, évite les impasses et les doublons ().

- Extraction de contenu dynamique : interagit avec le JavaScript, déplie les sections cachées, va chercher les données qui apparaissent après une action utilisateur ().

- Efficacité : cible les zones vraiment utiles, évite les doublons ou les données inutiles, ne rate rien d’important ().

- Données complètes : capture tous les niveaux d’info — listes principales, pages de détails, documents associés — en une seule passe.

Si tu as déjà voulu extraire tous les avis d’un produit ou récupérer chaque annonce d’un portail immobilier (y compris les infos de l’agent planquées sur une sous-page), tu as sûrement vu les limites des crawlers classiques. C’est là que les deep crawlers font toute la différence.

Comment les Deep Crawlers assurent une collecte complète et une navigation intelligente

Mais concrètement, comment ça marche un deep crawler ? Tout repose sur le suivi des liens, la navigation récursive et la gestion futée du contenu dynamique.

Extraction sur sous-pages et navigation à plusieurs étages

Un deep crawler ne s’arrête pas à la première page. Il va :

- Repérer les liens internes (genre « Voir les détails », « Page suivante », « En savoir plus »)

- Suivre ces liens vers les sous-pages, les vues détaillées ou même les pop-ups

- Extraire les données à chaque niveau, pour tout rassembler dans un tableau bien structuré

Cette technique, qu’on appelle « crawling récursif » ou « extraction multi-niveaux », est parfaite pour les sites où l’info est disséminée sur plusieurs pages — comme les listes de produits avec pages de détails, ou les annuaires où les coordonnées ne sont accessibles qu’après un clic.

Pagination et contenu dynamique : rien ne leur échappe

Les sites modernes adorent cacher les infos derrière des boutons « Charger plus », des scrolls infinis ou des onglets pilotés par JavaScript. Les deep crawlers sont faits pour :

- Détecter et cliquer sur les contrôles de pagination

- Scroller ou interagir avec les éléments dynamiques

- Attendre que tout soit chargé avant d’extraire les données

Résultat : tu récupères un jeu de données complet, pas juste ce qui était visible au premier chargement ().

Suivi des liens profonds et extraction multi-couches

Le vrai défi du deep crawling, c’est de ne pas louper les données cachées ou imbriquées. Les deep crawlers utilisent des algos pour :

- Suivre les liens déjà visités (pour éviter les doublons ou les boucles)

- Prioriser les pages importantes (vues détaillées, documents à télécharger…)

- Gérer les cas particuliers (pop-ups, sections repliables, contenu chargé via AJAX)

C’est crucial pour les pros : rater un contact ou une caractéristique produit, c’est parfois rater une opportunité ou fausser une analyse ().

Thunderbit : le deep crawling à la portée de tous grâce à l’IA

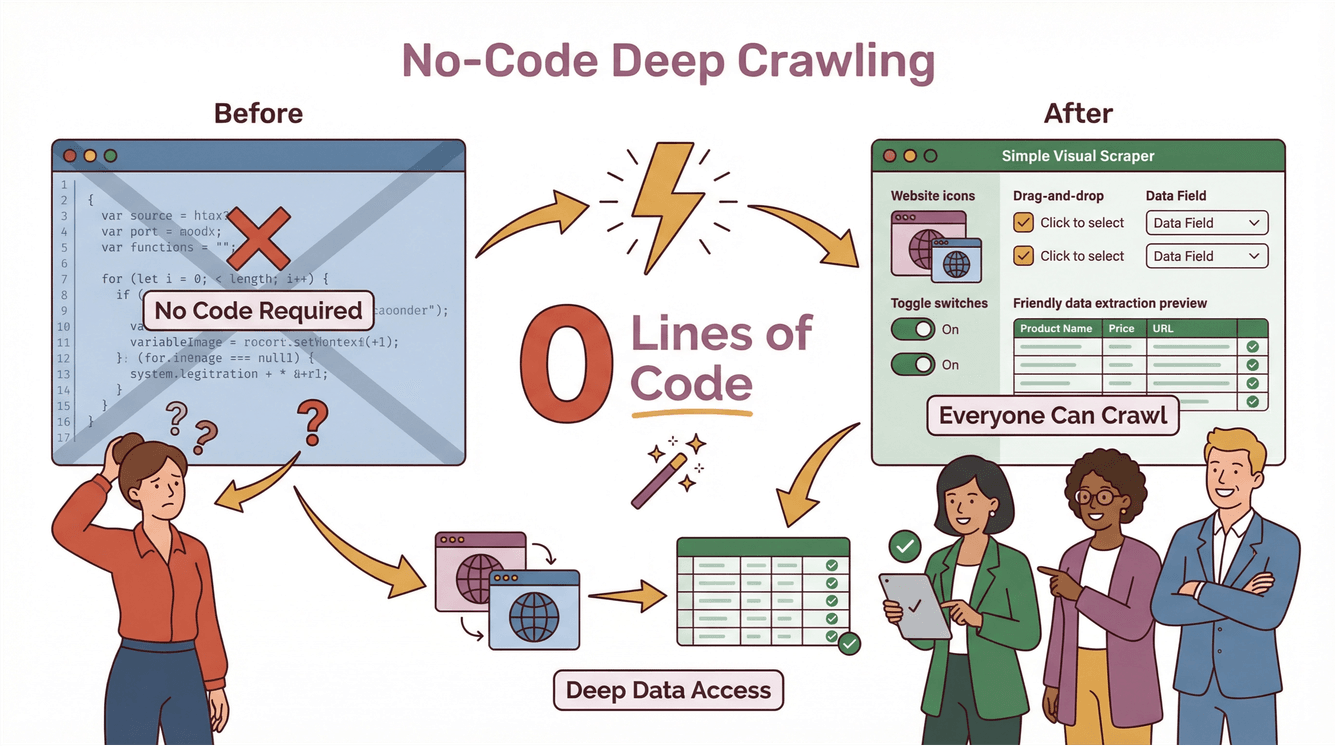

Soyons francs : avant, le deep crawling, c’était réservé aux développeurs aguerris. Il fallait coder des scripts maison, gérer les cas tordus et tout refaire dès qu’un site changeait. Avec , le but, c’est de rendre le deep crawling accessible à tout le monde — même sans écrire une seule ligne de code.

Les points forts du Deep Crawler Thunderbit

Voilà comment Thunderbit te simplifie la vie :

- AI Suggest Fields : Clique sur « Suggérer les champs par IA » et l’IA de Thunderbit analyse la page, propose les meilleures colonnes à extraire et crée même des prompts pour chaque champ.

- Extraction sur sous-pages : Besoin de plus d’infos ? Thunderbit va automatiquement sur chaque sous-page (détails produits, profils d’agents, onglets d’avis…) et enrichit ton tableau avec toutes les données.

- Gestion du contenu dynamique : Thunderbit gère la pagination, le scroll infini et les éléments dynamiques — sans que tu aies à configurer quoi que ce soit.

- Processus sans code en deux étapes : Tu décris ce que tu veux, tu cliques sur « Extraire » et Thunderbit fait le reste. Tes données sont prêtes à être exportées vers Excel, Google Sheets, Notion ou Airtable — sans frais cachés ni limites ().

Exemple concret : deep crawling avec Thunderbit

Imaginons que tu veuilles extraire toutes les annonces immobilières d’un site, y compris les coordonnées des agents cachées sur des sous-pages :

- Ouvre la page des annonces dans Chrome.

- Clique sur l’extension Thunderbit.

- Utilise « Suggérer les champs par IA » pour que Thunderbit te propose des colonnes comme « Titre de l’annonce », « Prix », « Adresse » et « Lien vers l’agent ».

- Clique sur « Extraire ». Thunderbit récupère toutes les annonces principales.

- Clique sur « Extraire les sous-pages ». Thunderbit visite chaque profil d’agent, extrait numéros de téléphone, emails, etc., et fusionne tout dans ton tableau principal.

- Exporte tes données vers Google Sheets ou Excel — prêtes à l’emploi pour tes équipes.

Pas de code, pas de modèle à bidouiller, pas de prise de tête. Et si le site change, l’IA de Thunderbit s’adapte toute seule ().

Les bénéfices business : pourquoi les deep crawlers font la différence

Ok, les deep crawlers, c’est cool — mais concrètement, à quoi ça sert pour ton business ? C’est là que ça devient vraiment intéressant.

Des insights précieux pour l’e-commerce, l’immobilier et la veille concurrentielle

Pour les équipes commerciales et marketing, les deep crawlers sont une vraie mine d’or. Ils permettent de :

- Extraire chaque produit, prix et avis sur les sites e-commerce — même si les infos sont planquées derrière plusieurs couches ou onglets

- Agréger les annonces immobilières (y compris les infos cachées sur les agents ou les détails des biens)

- Surveiller les sites concurrents pour repérer les nouveaux produits, les changements de prix ou les tendances du marché ()

- Constituer des listes de prospects enrichies en capturant les coordonnées sur des annuaires, sites d’événements ou portails spécialisés

Avec le deep crawling, tu n’as pas juste plus de données — tu as des données plus pertinentes et directement exploitables pour booster ton business.

Deep scraping pour la veille concurrentielle

Imagine que ton équipe commerciale veut cibler les boîtes qui viennent de lancer un nouveau produit. Un deep crawler peut :

- Scanner les sites concurrents à la recherche de nouvelles pages produits

- Suivre les liens vers les communiqués de presse ou les actus investisseurs

- Extraire les infos clés (dates de lancement, prix, fonctionnalités)

- Intégrer tout ça dans ton CRM ou tes outils d’analyse

Résultat : des décisions plus rapides, plus malines — et un vrai avantage sur ceux qui se contentent d’un scraping de surface.

Conformité et bonnes pratiques : deep crawling responsable

Un grand pouvoir d’extraction, c’est aussi une grande responsabilité. Les deep crawlers peuvent accéder à beaucoup de données — mais ça ne veut pas dire qu’il faut tout prendre sans réfléchir. Voici ce qu’il faut garder en tête :

Données perso et droits d’auteur

- Respecte les conditions d’utilisation des sites : Beaucoup de sites précisent ce qui est autorisé dans leurs CGU. Les ignorer peut te causer des soucis juridiques ().

- N’extrais pas de données personnelles ou confidentielles sans autorisation claire.

- Attention au droit d’auteur : Ne republie ou ne vends pas de contenu extrait sans vérifier les droits.

Extraction responsable

- Limite la fréquence de tes requêtes : N’inonde pas les sites de demandes en rafale.

- Consulte le fichier robots.txt : Ce n’est pas une obligation légale, mais c’est une question de respect.

- Reste à jour sur la loi : Des règles comme le RGPD ou le CCPA peuvent impacter ce que tu peux collecter et comment tu l’utilises ().

Pour aller plus loin, checke .

Choisir le bon Deep Crawler pour ton équipe

Comment choisir le bon deep crawler ? Voici mes critères :

- Facilité d’utilisation : Est-ce que même les non-techniciens peuvent s’en servir facilement ? (Thunderbit : oui.)

- Scalabilité : Est-ce que ça gère les gros sites, les milliers de pages et le contenu dynamique ?

- Outils de conformité : Est-ce que ça aide à rester dans les clous côté légalité ?

- Intégration : Peut-on exporter les données vers les outils déjà utilisés (Excel, Sheets, Notion, Airtable) ?

- Maintenance : Est-ce que ça s’adapte tout seul aux changements de sites, ou faut-il bricoler des scripts chaque semaine ?

Thunderbit a été pensé pour cocher toutes ces cases. Il est déjà adopté par , des freelances aux grandes boîtes, et son prix permet même aux petites équipes de s’y mettre dès 15 $/mois.

À retenir : le deep crawling, un atout clé pour la data en entreprise

En résumé :

- Les deep crawlers sont devenus indispensables pour extraire des données complètes et fiables sur les sites web complexes et dynamiques d’aujourd’hui.

- Ils vont bien plus loin que les crawlers classiques en gérant la navigation multi-niveaux, le contenu dynamique et les infos cachées.

- Les équipes business s’en servent pour obtenir des insights, booster les ventes, surveiller la concurrence et accélérer la prise de décision.

- La conformité, c’est la base : extrais toujours de façon responsable, respecte la vie privée et les règles du jeu.

- Thunderbit rend le deep crawling accessible à tous, grâce à l’IA, une interface sans code et l’export en un clic.

Prêt à passer à la vitesse supérieure et à explorer le web en profondeur ? et découvre par toi-même la simplicité du deep crawling. Pour plus d’astuces, va faire un tour sur le : guides, bonnes pratiques et nouveautés sur l’extraction web boostée à l’IA.

FAQ

1. C’est quoi un deep crawler et en quoi c’est différent d’un crawler web classique ?

Un deep crawler, c’est un extracteur web qui va naviguer à travers toutes les couches d’un site, extraire des données sur les sous-pages, le contenu dynamique et les sections cachées. Contrairement aux crawlers classiques qui restent en surface, les deep crawlers assurent une collecte complète en suivant les liens et en gérant les structures complexes.

2. Pourquoi les entreprises ont-elles besoin de deep crawlers en 2025 ?

Les sites web sont plus complexes que jamais, avec des infos souvent cachées derrière la navigation, des onglets ou des éléments dynamiques. Les deep crawlers permettent aux entreprises d’extraire des jeux de données complets pour la vente, le marketing, la veille ou la recherche concurrentielle — ce que les extracteurs classiques ne peuvent pas faire.

3. Comment Thunderbit rend le deep crawling facile pour les non-techniciens ?

Thunderbit utilise l’IA pour suggérer les champs, gérer l’extraction sur sous-pages et le contenu dynamique — tout ça via une interface simple et sans code. Il suffit de décrire ce que tu veux, de cliquer sur « Extraire » et d’exporter les résultats vers tes outils préférés.

4. Quelles questions de conformité faut-il se poser avec un deep crawler ?

Respecte toujours les conditions d’utilisation des sites, évite d’extraire des données personnelles ou confidentielles sans autorisation, et reste à jour sur les lois comme le RGPD ou le CCPA. Une extraction responsable et un usage éthique des données sont essentiels pour éviter les soucis juridiques.

5. Les deep crawlers peuvent-ils aider mon équipe commerciale et marketing à performer ?

Carrément. Les deep crawlers donnent accès à des données plus riches et exploitables sur l’e-commerce, l’immobilier ou la concurrence — pour générer des leads, analyser le marché et accélérer la prise de décision. Avec des outils comme Thunderbit, même les équipes non techniques peuvent accéder aux insights qui font la différence.

Pour aller plus loin