Vous vous êtes déjà demandé comment certaines boîtes arrivent toujours à connaître les prix de leurs rivaux, flairer les tendances du marché avant tout le monde ou monter des listes de prospects XXL en un temps record ? Pas de panique, tu n’es pas le seul à te poser la question. Le secret de cette réactivité, c’est ce qu’on appelle l’extraction de données. Aujourd’hui, savoir piocher dans les infos du web, c’est un peu comme avoir un super-pouvoir (sans le costume moulant ni la cabine téléphonique).

On vit une époque où le web déborde d’infos : d’ici fin 2025, on estime que la planète aura généré la bagatelle de de données numériques. Autant dire que c’est vertigineux ! Pour les entreprises, cette avalanche de données en ligne, c’est à la fois un filon et un vrai casse-tête. La vraie question, c’est : comment transformer ce flot d’infos éparpillées en ressources vraiment utiles ? C’est là que l’extraction de données entre en scène – et pourquoi elle est devenue incontournable, que tu sois une start-up ou un mastodonte.

On va voir ensemble ce que c’est vraiment l’extraction de données, pourquoi c’est devenu essentiel, comment ça s’applique à plein de secteurs, et comment des outils boostés à l’IA comme rendent tout ça accessible (et carrément plus simple) à tout le monde.

Qu’est-ce que l’extraction de données ? Définition et contexte

En deux mots, l’extraction de données (ou web scraping) c’est le fait de récupérer automatiquement des infos sur des sites web ou des sources numériques, puis de les organiser dans un format carré – genre un tableau, une base de données ou un dashboard. Imagine : tu gères une boutique en ligne et tu veux surveiller les prix de tes concurrents. Plutôt que de checker chaque page à la main (et d’y laisser ta santé mentale), un extracteur de données fait le boulot à ta place : il visite chaque page, récupère les prix, les noms de produits, les avis, et te livre tout ça bien rangé.

En résumé : l’extraction de données automatise la corvée du copier-coller sur le web, et transforme le contenu brut en données exploitables. C’est comme avoir une armée de stagiaires numériques qui ne dorment jamais, ne font pas de fautes de frappe et ne râlent jamais sur les tâches répétitives ().

Pourquoi l’extraction de données est-elle devenue si cruciale ?

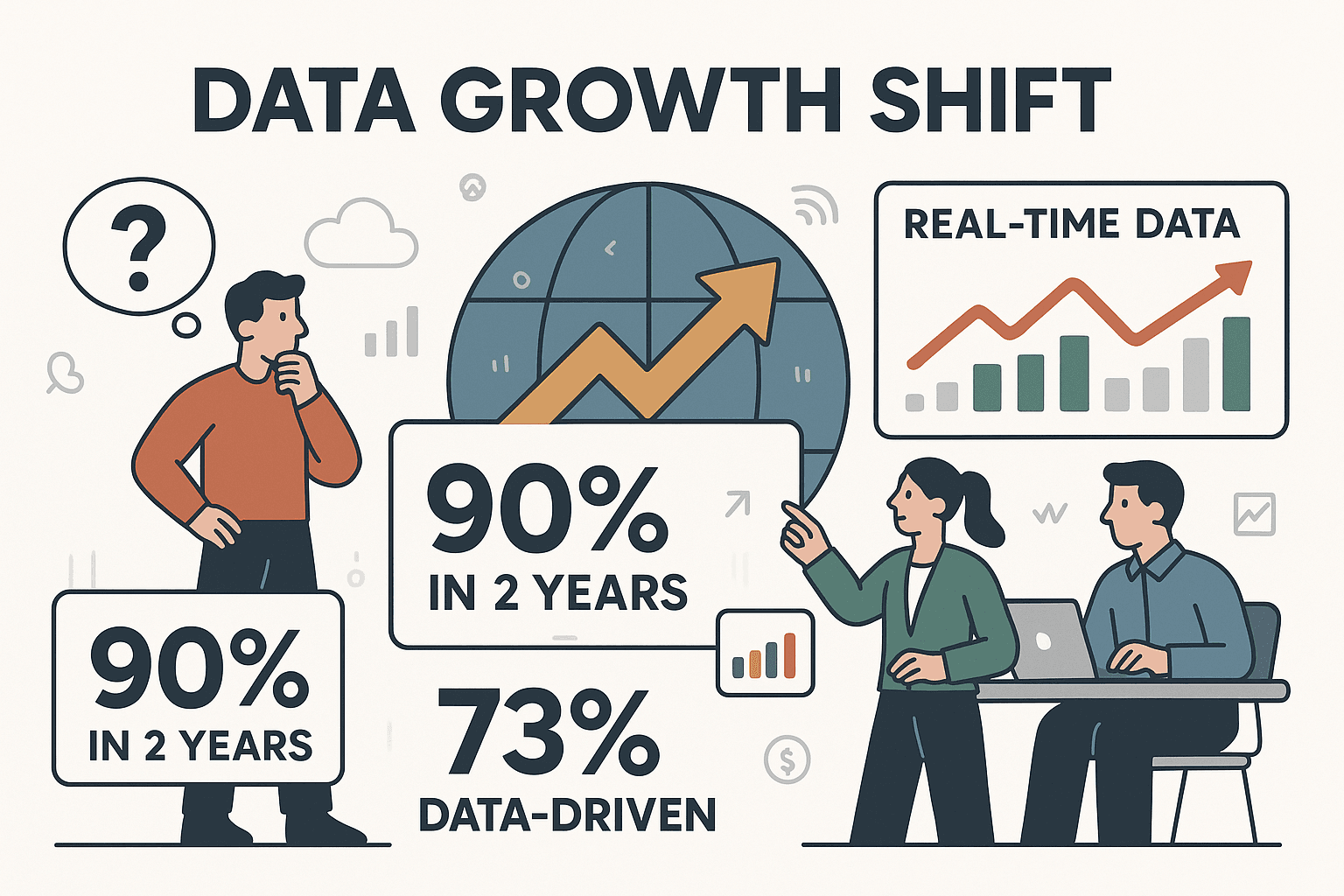

Le monde numérique s’étend à une vitesse folle. En fait, . Les boîtes ne se fient plus à leur instinct, mais à des données en temps réel. Plus de affirment que leurs décisions sont systématiquement guidées par la donnée.

Mais voilà le hic : la majorité des données précieuses ne sont pas dans tes systèmes internes. Elles sont éparpillées sur le web – sites concurrents, articles, réseaux sociaux, fiches produits, etc. L’extraction de données fait le pont entre ces ressources externes et ton entreprise, t’apportant le contexte et l’intelligence pour garder une longueur d’avance.

Web Scraping vs. Web Crawling : quelle différence ?

On confond souvent les deux. Le web crawling c’est envoyer un robot explorer et cartographier toutes les pages d’un site (comme le font les moteurs de recherche). Le web scraping, lui, sert à extraire des données précises de ces pages – genre des prix, des emails ou des caractéristiques produits (). En gros, le crawler repère les pages, et l’extracteur récupère les infos qui t’intéressent.

Applications concrètes de l’extraction de données dans différents secteurs

L’extraction de données, ce n’est plus réservé aux geeks ou aux data scientists : c’est devenu l’arme secrète des équipes commerciales, e-commerce, marketing, immobilier, finance, et bien d’autres. Voilà comment différents secteurs s’en servent au quotidien :

| Secteur | Cas d'usage courant | Bénéfice métier |

|---|---|---|

| E-commerce | Veille tarifaire, analyse concurrentielle | Stratégie de prix en temps réel, marges optimisées, réaction rapide aux évolutions du marché |

| Ventes & Prospection | Constitution de listes de prospects depuis des annuaires, réseaux sociaux | Ciblage précis, pipeline enrichi, 5+ heures/semaine économisées sur la recherche de prospects |

| Marketing | Collecte d’avis, analyse des réseaux sociaux, forums | Ajustement des campagnes basé sur la donnée, réaction rapide aux tendances ou crises |

| Immobilier | Agrégation d’annonces immobilières multi-sites | Analyse de marché accélérée, inventaire centralisé, meilleures décisions d’investissement |

| Finance & Investissement | Extraction de cours de bourse, actualités financières, données économiques | Informations à la minute, décisions de trading éclairées, avantage concurrentiel |

| Opérations | Automatisation de la collecte de données fournisseurs/conformité | Reporting automatisé, moins d’erreurs, libération des équipes des tâches répétitives de saisie |

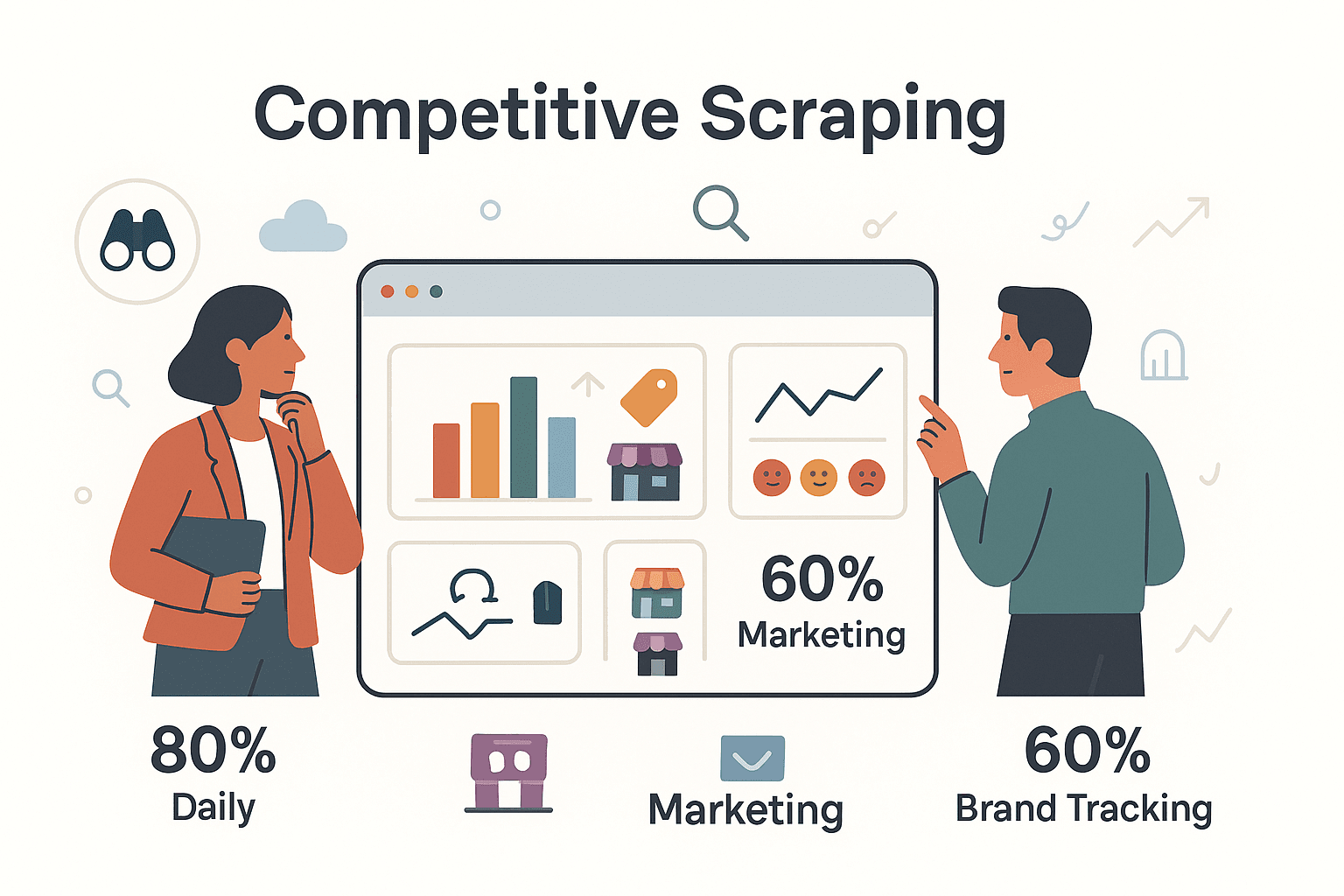

Et ce n’est pas juste quelques cas isolés. Plus de collectent chaque jour des données sur leurs concurrents, et environ utilisent le scraping pour surveiller la réputation de leur marque et les campagnes adverses. Même les fonds d’investissement et les agences immobilières s’en servent pour anticiper les mouvements du marché avant qu’ils ne fassent la une.

Panorama des techniques et outils d’extraction de données

Mais concrètement, comment on fait pour extraire des données du web ? Il y a plusieurs méthodes – des plus classiques aux plus innovantes.

Méthodes traditionnelles d’extraction de données

1. Copier-coller manuel

La méthode old school (et la plus fastidieuse) : ouvrir un site, copier les infos, les coller dans un tableau. Pratique pour trois pages, mais au-delà, bonjour la tendinite…

2. Scripts sur-mesure

Si tu touches un peu à Python ou JavaScript, tu peux écrire des scripts avec des outils comme BeautifulSoup ou Scrapy. C’est flexible, mais il faut tout maintenir à jour : au moindre changement sur le site, tout peut planter.

3. Outils no-code d’extraction web

Des solutions comme ParseHub, Octoparse ou l’extension Web Scraper pour Chrome permettent de sélectionner visuellement les données à extraire. Parfait pour les non-développeurs, mais il faut quand même créer des “recettes” ou “sitemaps” – et ces outils galèrent parfois avec les sites complexes ou dynamiques.

4. Automatisation du navigateur

Des frameworks comme Selenium ou Playwright simulent un vrai utilisateur dans le navigateur, ce qui permet de récupérer des données sur des sites très interactifs. Puissant, mais il faut des compétences techniques et de la patience.

5. OCR et extraction sur image

Quand les données sont coincées dans des images ou des PDF, l’OCR (reconnaissance optique de caractères) peut dépanner. Ce n’est pas parfait, mais c’est mieux que de déchiffrer des documents scannés toute la journée.

Le souci commun à toutes ces méthodes ? Elles demandent des compétences techniques, pas mal de configuration, et un entretien constant. Si tu as déjà passé plus de temps à réparer un extracteur qu’à exploiter les données, tu vois de quoi je parle.

Outils d’extraction de données boostés à l’IA

C’est là que ça devient vraiment intéressant – et que des outils comme changent la donne, même pour ceux qui ne codent pas.

Comment fonctionne l’extraction IA ?

- Détection automatique des champs : L’IA “lit” la page et te propose direct les données à extraire – fini de cliquer partout ou d’écrire des sélecteurs.

- Prompts en langage naturel : Tu expliques simplement ce que tu veux (“Récupère tous les noms de produits et les prix”), l’IA s’occupe du reste.

- Adaptabilité : Si le site change, l’IA retrouve souvent les données grâce au contexte, pas juste au code.

- Gestion du contenu dynamique : Les extracteurs IA peuvent cliquer sur “Charger plus”, scroller, voire se connecter si besoin.

- Nettoyage des données en temps réel : Besoin de traduire, catégoriser ou résumer les données à la volée ? L’IA gère tout ça.

- No-code et intuitif : La plupart des extracteurs IA sont pensés pour les utilisateurs métier, avec des interfaces simples et peu de configuration.

Les boîtes qui adoptent ces outils voient la précision des données grimper à , même sur des sites tordus ou mal fichus.

Aspects juridiques et éthiques de l’extraction de données

Avant de te lancer à l’assaut de tous les sites web, parlons un peu des règles du jeu. L’extraction de données, c’est puissant, mais ça implique de vraies responsabilités légales et éthiques.

Principaux risques juridiques

- Conditions d’utilisation des sites : Beaucoup de sites interdisent l’extraction dans leurs conditions. Les ignorer peut te valoir un blocage, voire des poursuites dans de rares cas ().

- Législation sur la vie privée : Des règlements comme le RGPD ou le CCPA protègent les données personnelles. Extraire des noms, emails ou infos sensibles sans consentement peut te mettre dans la panade ().

- Droits d’auteur : Les faits (comme les prix) sont généralement exploitables, mais copier massivement des textes ou images peut enfreindre le copyright.

- Mesures anti-scraping : Contourner des logins, des CAPTCHAs ou d’autres barrières techniques peut franchir la ligne rouge (voir le CFAA aux États-Unis).

Bonnes pratiques pour rester conforme

- Cible les données publiques et non sensibles : Limite-toi aux infos accessibles à tous et non identifiantes.

- Respecte le robots.txt : Si un site dit “pas d’extraction” dans son fichier robots.txt, respecte-le.

- Utilise les API officielles si possible : Les API sont la voie la plus sûre et la plus conforme pour accéder aux données.

- N’abuse pas des serveurs : Dose tes requêtes et évite de surcharger les sites.

- Sois transparent et éthique : Ne collecte que ce qui est nécessaire, et n’utilise pas les données extraites à des fins douteuses.

En cas de doute, demande à un juriste ou joue la prudence. Ce n’est pas parce qu’une donnée est publique qu’elle est libre de droits.

Comment Thunderbit optimise l’extraction de données

Voyons maintenant comment (l’outil développé par mon équipe) rend l’extraction de données non seulement plus simple, mais aussi plus intelligente et accessible à tous.

Automatisation et reconnaissance intelligente de Thunderbit

- Extraction en 2 clics : Ouvre la page, clique sur “Suggérer les champs IA”, et Thunderbit te propose direct les données à extraire. Clique sur “Extraire”, c’est plié. Pas de code, pas de modèles, pas de prise de tête ().

- Reconnaissance IA des champs : L’IA de Thunderbit “lit” la page comme un humain, donc même si la mise en page change, elle retrouve les infos recherchées.

- Interface en langage naturel : Dis simplement à Thunderbit ce dont tu as besoin, il configure l’extraction pour toi.

- Extraction sur sous-pages : Besoin de détails sur des pages liées (fiches produits, profils) ? Thunderbit visite chaque sous-page et enrichit automatiquement ton tableau ().

- Gestion de la pagination et du scroll infini : Thunderbit repère les boutons “Suivant” et le scroll infini, pour ne rien rater au-delà de la première page.

- Transformation des données à la volée : Ajoute des prompts personnalisés pour résumer, catégoriser ou traduire les données pendant l’extraction – sans étape supplémentaire.

- Modèles instantanés : Pour les sites populaires comme Amazon, Zillow ou LinkedIn, Thunderbit propose des modèles prêts à l’emploi pour une extraction en un clic ().

- Multiples options d’export : Exporte tes données vers Excel, CSV, Google Sheets, Airtable, Notion ou JSON – gratuitement et sans limite.

- Extraction cloud et planification : Extrayez jusqu’à 50 pages en simultané dans le cloud, ou programmez des extractions récurrentes avec un simple prompt en langage naturel.

Exemple concret : surveiller les prix des concurrents

Imaginons que tu sois e-commerçant et que tu veuilles suivre les prix de tes concurrents sur 100 pages produits. Avec Thunderbit :

- Ouvre la page de listing produits du concurrent.

- Clique sur “Suggérer les champs IA”. Thunderbit te propose des colonnes comme Nom du produit, Prix, Disponibilité.

- Clique sur “Extraire”. Thunderbit récupère toutes les données de chaque produit de la page.

- Besoin de plus de détails ? Clique sur “Extraire les sous-pages” pour obtenir les spécifications ou infos vendeur de chaque fiche produit.

- Exporte vers Excel ou Google Sheets – tu peux alors analyser ou ajuster tes propres prix.

Ce qui prenait des heures (ou nécessitait un développeur) se fait maintenant en quelques minutes – sans écrire une seule ligne de code.

Les atouts de Thunderbit sur les sites complexes

Thunderbit ne s’arrête pas aux sites basiques. Il gère aussi les environnements plus costauds :

- Sites dynamiques et riches en JavaScript : Thunderbit charge la page comme un vrai navigateur, ce qui lui permet de gérer le contenu qui apparaît après des clics ou du scroll.

- Pagination et navigation multi-niveaux : Thunderbit repère et suit les boutons “page suivante” ou le scroll infini, pour extraire des centaines ou milliers d’éléments sans configuration manuelle.

- Contournement des blocages anti-bot : Fonctionnant comme une extension Chrome, Thunderbit imite le comportement d’un utilisateur réel, ce qui limite les risques de blocage.

- Contenus mixtes : Thunderbit peut extraire des images, des PDF, et même utiliser l’OCR sur des documents scannés – tout dans un même flux.

- Modes navigateur ou cloud : Utilise le mode navigateur pour les sites nécessitant une connexion, ou le mode cloud pour la rapidité et l’échelle.

- Support multilingue : Thunderbit fonctionne dans 34 langues et peut traduire les données extraites en temps réel.

En bref, Thunderbit met la puissance de l’extraction pro à la portée de tous, dès que tu as un navigateur et un besoin métier.

Tendances et évolutions de l’extraction de données

Le secteur bouge vite – voilà ce qui arrive :

- Agents IA plus malins : Les extracteurs comprendront encore mieux les pages web, s’adapteront aux changements, et pourront même résumer ou analyser les données à la volée.

- Interfaces en langage naturel et vocal : Imagine demander à ton extracteur : “Trouve-moi toutes les offres d’emploi pour développeur à Paris”, et avoir le résultat en quelques minutes.

- Intégration poussée à l’analytique : Les données extraites alimenteront direct tes dashboards, outils BI, voire déclencheront des alertes ou automatisations.

- Scalabilité cloud et edge : L’extraction sera plus rapide et robuste, avec des plateformes cloud capables de lancer des milliers d’extractions en parallèle.

- Techniques furtives : À mesure que les sites se blindent, les extracteurs adopteront des méthodes plus subtiles pour passer inaperçus.

- Conformité intégrée : Les extracteurs proposeront des fonctions pour éviter les pièges juridiques – comme l’exclusion automatique des données personnelles ou le respect du robots.txt par défaut.

- Démocratisation : L’extraction n’est plus réservée aux géants du web. Avec des outils comme Thunderbit, PME, chercheurs et freelances accèdent aux mêmes données que les grands groupes.

D’ici 2025, auront intégré des outils d’extraction web à leur stack analytique. L’avenir est à la donnée, et l’extraction en est le moteur.

Conclusion : comment l’extraction de données booste la performance des entreprises

Pour résumer : l’extraction de données, c’est la clé pour dénicher les pépites cachées du web. C’est comme ça que les entreprises transforment le chaos de l’info en intelligence exploitable. Que tu surveilles les prix, construises des listes de prospects, analyses les tendances ou cherches à garder une longueur d’avance, l’extraction te permet de décider plus vite et plus intelligemment.

Le temps du copier-coller manuel ou des scripts fragiles est révolu. Avec des outils IA comme , tout le monde peut extraire des données – sans coder, sans prise de tête, juste des résultats. Et à mesure que l’extraction devient plus intelligente, plus éthique et mieux intégrée aux process métier, elle ouvre de nouvelles opportunités à toutes les équipes.

Envie de voir ce que l’extraction de données peut apporter à ton business ? et commence à transformer le web en mine d’or. Pour aller plus loin, checke le pour des guides, astuces et retours d’expérience.

FAQ

1. Qu’est-ce que l’extraction de données et en quoi est-ce différent du web crawling ?

L’extraction de données, c’est récupérer automatiquement des infos précises depuis des sites web ou sources numériques, pour les structurer (genre dans un tableau). Le web crawling sert à découvrir et indexer des pages, tandis que l’extraction cible les données qui t’intéressent ().

2. L’extraction de données est-elle légale ?

Extraire des données publiques et non sensibles est généralement légal, mais il faut respecter les conditions d’utilisation des sites, les lois sur la vie privée (RGPD/CCPA) et le droit d’auteur. Évite toujours de collecter des données personnelles sans consentement et privilégie les API officielles si elles existent ().

3. Quels sont les principaux bénéfices métier de l’extraction de données ?

L’extraction permet la veille tarifaire en temps réel, l’analyse concurrentielle, la génération de leads, la recherche de marché, etc. Elle automatise la collecte d’infos, fait gagner du temps et favorise la prise de décision basée sur la donnée dans tous les services (ventes, marketing, opérations…).

4. Comment Thunderbit simplifie-t-il l’extraction pour les non-techniciens ?

Thunderbit utilise l’IA pour détecter automatiquement les champs, gérer les sous-pages et la pagination, et transformer les données à la volée. Son workflow en 2 clics et ses prompts en langage naturel permettent à chacun d’extraire des données web – sans coder ni créer de modèles ().

5. Quelles tendances façonnent l’avenir de l’extraction de données ?

On peut s’attendre à des agents IA plus malins, des interfaces en langage naturel, une intégration analytique renforcée, une scalabilité cloud, une conformité intégrée et une accessibilité accrue. D’ici 2025, l’extraction de données sera un outil courant pour les entreprises de toutes tailles ().

Envie d’en savoir plus ou de te lancer ? et découvre à quel point l’extraction de données peut être simple. Bonne extraction – et que tes tableaux soient toujours bien remplis, sans jamais avoir à copier-coller !