Il fut un temps où je jonglais avec une multitude d’onglets ouverts, à copier-coller noms, adresses mail et prix dans un tableur, jusqu’à ce que mes doigts réclament une pause bien méritée. Si tu as déjà bossé dans la vente, l’e-commerce ou les opérations, tu connais sûrement ce tableau : des heures perdues à jouer au roi du copier-coller, pour finir avec un poignet en compote et un fichier truffé de coquilles. La vérité, c’est que la collecte manuelle de données est encore le cauchemar de bien des boîtes. En moyenne, un salarié de bureau passe environ , et réalise plus de . Multiplie ça par une équipe de 20 personnes, et tu dépasses le million de copier-coller chaque année. Ce n’est pas juste pénible : c’est un vrai gouffre pour la productivité.

Heureusement, le data scraping a bien changé la donne depuis ces années galère. Aujourd’hui, grâce à l’automatisation et à l’IA, des outils comme permettent à tout le monde – pas seulement aux geeks – d’extraire des données web en quelques minutes au lieu d’y passer des jours. On va voir ensemble ce qu’est vraiment le data scraping, pourquoi c’est devenu indispensable, et comment l’IA révolutionne la collecte de données pour tous les pros.

Définition du Data Scraping : C’est quoi au juste ?

Pour faire simple, le data scraping c’est utiliser un logiciel pour aller chercher des infos sur des sites web ou des documents numériques, puis les organiser dans un format bien propre – genre tableur, base de données ou Google Sheets. Si tu as déjà rêvé de cloner un stagiaire pour faire tout ce boulot répétitif, le data scraping, c’est comme envoyer un robot à ta place – un robot qui ne fatigue jamais, ne se laisse pas distraire par des vidéos de chats, et ne réclame pas d’augmentation.

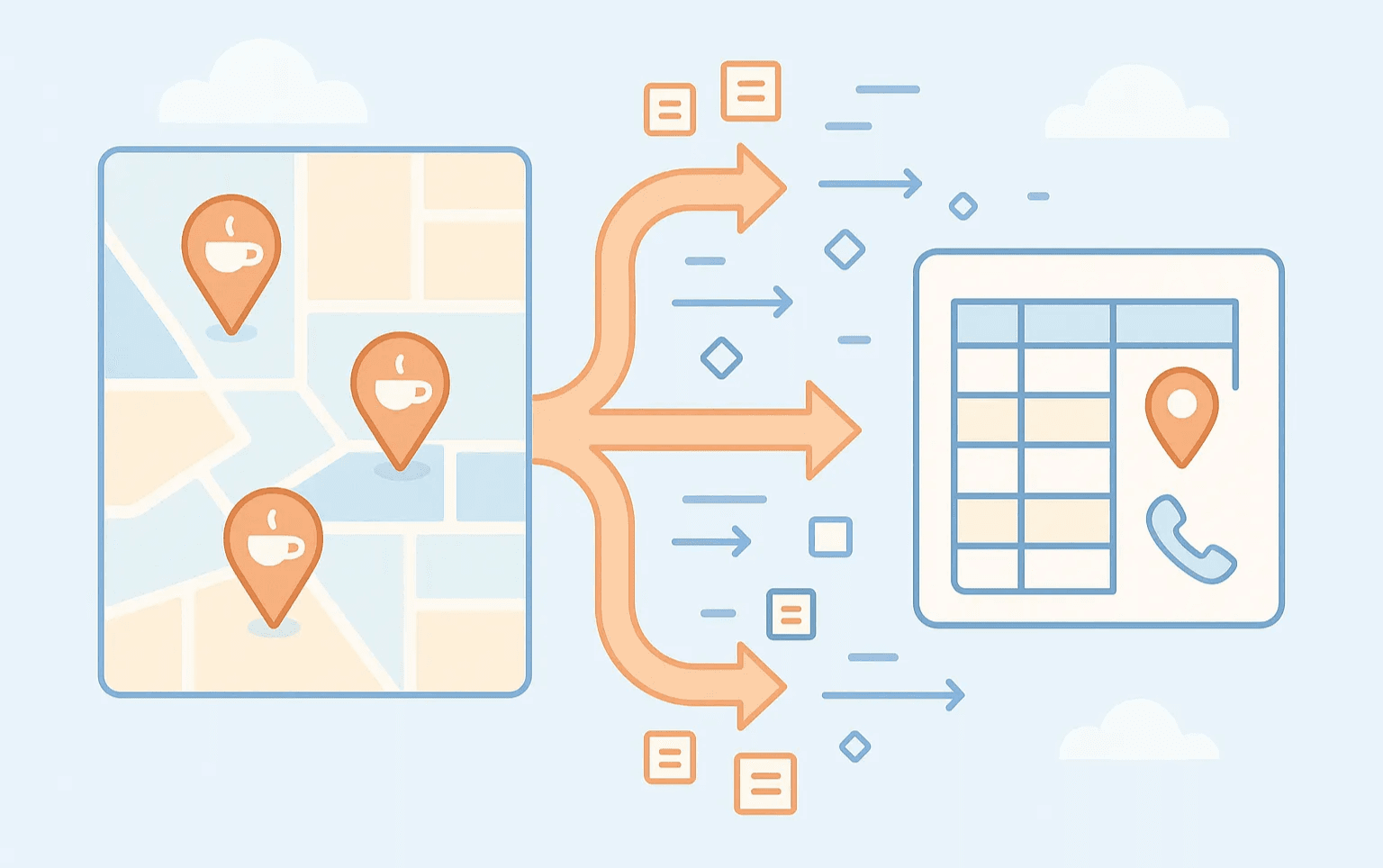

Concrètement, ça donne quoi ? Imagine que tu veux la liste de tous les cafés de ta ville, avec adresses et numéros. Plutôt que de tout recopier à la main, un outil de data scraping va sur le site, repère les infos utiles et te sort tout ça dans un tableau nickel. L’idée, c’est d’extraire des données de sources web ou numériques et de les transformer en un format exploitable – pour l’analyse, la prospection ou l’automatisation.

Les formats de sortie les plus courants :

- Fichiers Excel ou CSV

- Google Sheets

- Bases de données (pour les plus techniques)

- Intégrations directes avec des outils comme Airtable ou Notion

Et côté usages ? C’est partout : prospection commerciale, veille sur les prix, études de marché, analyse immobilière, et bien plus encore.

Pourquoi le Data Scraping est-il devenu vital pour les entreprises d’aujourd’hui ?

Soyons francs : dans le monde digital actuel, celui qui a les meilleures données a toujours une longueur d’avance. Que tu bosses dans la vente, l’e-commerce, le marketing ou l’immobilier, la capacité à collecter, analyser et exploiter rapidement les données web, c’est un vrai super-pouvoir. Voilà pourquoi le data scraping est devenu incontournable :

- Gain de temps : Fini la saisie répétitive, tu peux te concentrer sur des tâches à forte valeur ajoutée.

- Moins d’erreurs : Moins de fautes de frappe, des infos toujours à jour.

- Passage à l’échelle : Tu peux collecter des données sur des centaines ou milliers de pages – impossible à la main.

- Meilleur retour sur investissement : Plus de prospects, des prix ajustés en temps réel, des analyses de marché accélérées.

Pour te donner une idée :

| Fonction métier | Cas d’usage du data scraping | ROI/Bénéfice |

|---|---|---|

| Vente | Extraction de leads et contacts | 10x plus de prospects, des heures économisées |

| E-commerce | Veille sur les prix et les références concurrents | Ajustements tarifaires en temps réel, marges préservées |

| Immobilier | Collecte d’annonces et de prix | Découverte rapide d’opportunités, données marché actualisées |

| Marketing | Collecte de données de campagne ou d’insights sociaux | Ciblage affiné, campagnes plus performantes |

| Opérations | Automatisation de la collecte de données | Moins de coûts, moins d’erreurs |

Pas étonnant que estiment que l’automatisation fait gagner 10 à 50% du temps sur les tâches manuelles, et que près de pensent pouvoir économiser six heures ou plus par semaine si les tâches répétitives étaient automatisées.

Du Copier-Coller à l’ère des Outils de Data Scraping

On ne va pas se mentir : le copier-coller manuel, c’est la préhistoire du data scraping. On l’a tous fait avant de découvrir mieux. Mais c’est lent, source d’erreurs, et franchement, il y a plus fun dans la vie.

L’ancienne méthode : le copier-coller à la main

- Temps de mise en place : Aucun (tu ouvres ton navigateur et tu copies)

- Facilité d’utilisation : Simple, mais tu t’en lasses vite dès qu’il y a du volume

- Précision : Correct pour quelques lignes, mais les erreurs s’accumulent vite

- Scalabilité : Nulle – sauf si tu as une armée de stagiaires (et beaucoup de pizzas)

La première génération : les premiers outils de data scraping

Ensuite sont arrivés les premiers outils de data scraping : requêtes web dans Excel, extensions basiques pour navigateur, extracteurs « pointer-cliquer ». Ils automatisaient une partie du boulot, mais il fallait souvent :

- Sélectionner chaque champ de données à la main

- Comprendre un peu le HTML ou XPath

- Tout reconfigurer dès que le site changeait

C’était déjà un progrès, mais il fallait quand même quelques bases techniques (et parfois quelques tutos YouTube).

Comparatif des méthodes de data scraping

Petit tableau récap’ :

| Méthode | Temps de mise en place | Facilité d’utilisation | Précision & Maintenance | Scalabilité | Compétences requises |

|---|---|---|---|---|---|

| Copier-coller manuel | Aucun, mais lent | Facile, fastidieux | Erreurs fréquentes à grande échelle | Très faible | Bureautique de base |

| Outils traditionnels | Moyen à élevé | Modérée, apprentissage nécessaire | Précis si bien configuré, mais fragile | Élevée (avec effort) | Quelques notions web/tech |

| Data scraping IA | Minime | Très facile – il suffit de décrire ce que l’on veut | Très adaptatif, s’ajuste aux changements | Moyenne à élevée | Aucune – juste un navigateur |

En résumé : le scraping manuel, c’est bien pour trois lignes ; les outils classiques, ça passe à l’échelle mais il faut s’y connaître ; le scraping par IA, c’est la simplicité et la robustesse pour les pros.

L’essor du Data Scraping IA : la révolution

C’est là que ça devient vraiment intéressant. La dernière évolution, c’est le data scraping par IA : des outils capables de « comprendre » les pages web, d’extraire les bonnes infos, et même de nettoyer ou formater les données automatiquement.

Fini les règles d’extraction à configurer ou les sélecteurs CSS à apprendre : tu dis à l’IA ce que tu veux (« Donne-moi tous les noms de produits et prix de cette page »), et elle s’occupe du reste. Plus besoin de s’arracher les cheveux à chaque changement de site.

Ce passage de l’extraction basée sur des règles à la compréhension par l’IA, c’est un vrai saut de géant. Ça veut dire :

- Aucune configuration technique : Pas besoin de connaître le HTML, le scripting ou les détails techniques.

- Résultats rapides : Ce qui prenait des heures de réglages se fait en quelques minutes, voire secondes.

- Plus résistant : L’IA s’adapte aux changements de structure, donc tes extracteurs ne plantent pas à chaque mise à jour du site.

Thunderbit : Le Data Scraping IA pour tous

C’est un sujet qui me tient à cœur : . On a créé Thunderbit parce qu’on voyait que même les outils de data scraping « no-code » restaient trop compliqués pour les non-techniciens. Trop de réglages, prise en main laborieuse, et beaucoup de frustration.

Thunderbit change la donne. Voilà comment :

- Suggestions de champs par IA : Un clic, l’IA analyse la page, propose les champs à extraire et même les noms de colonnes. Fini la chasse aux sélecteurs CSS.

- Extraction sur sous-pages : Besoin d’infos sur des pages liées (fiches produits, annonces immo) ? Thunderbit visite chaque sous-page et enrichit ton tableau.

- Templates instantanés : Pour les sites connus (Amazon, Zillow, Google Maps, etc.), choisis un modèle et récupère tes données en un clic.

- Export gratuit des données : Envoie vers Excel, Google Sheets, Airtable ou Notion – sans frais cachés, sans prise de tête.

- Aucune barrière technique : Si tu sais utiliser un navigateur, tu sais utiliser Thunderbit. Pas de code, pas de configuration, juste des résultats.

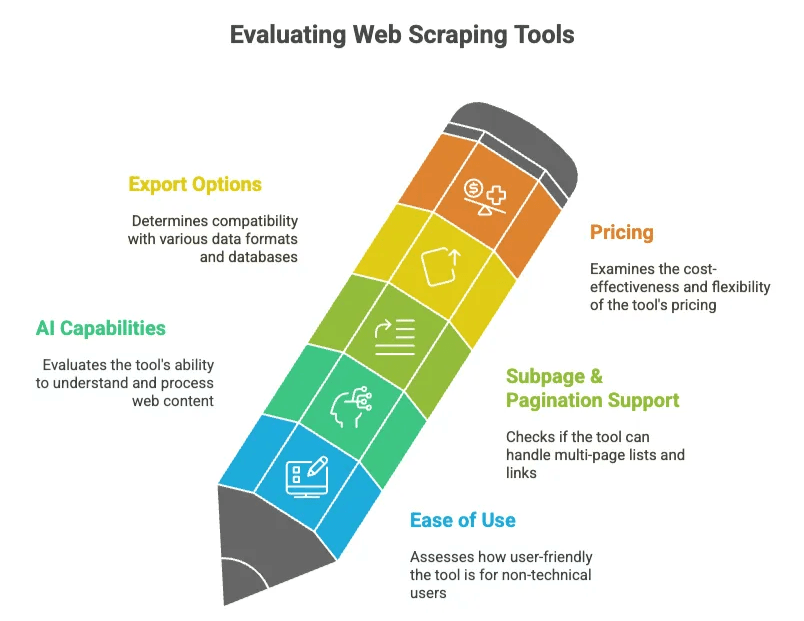

Outils de Data Scraping : Comment faire le bon choix ?

- Facilité d’utilisation : Un collègue non technique peut-il s’en sortir sans formation ?

- Fonctionnalités IA : L’outil « comprend-il » la page ou faut-il tout paramétrer à la main ?

- Gestion des sous-pages & pagination : Peut-il suivre les liens et gérer les listes sur plusieurs pages ?

- Options d’export : Compatible avec tes outils préférés (tableurs, bases de données) ?

- Tarifs : Tu paies pour des fonctions inutiles ou l’offre colle à tes besoins ?

Comparons Thunderbit à d’autres solutions populaires :

| Outil | Plateforme | Fonctionnalités clés | Facilité d’utilisation | Prix (dès) | Idéal pour |

|---|---|---|---|---|---|

| Thunderbit | Extension Chrome | IA, extraction sous-pages, export instantané | Très élevée | ~9$/mois | Utilisateurs non techniques |

| Octoparse | Desktop/Cloud | Workflow visuel, contenu dynamique, templates | Moyenne, apprentissage requis | ~119$/mois | Analystes, experts |

| ParseHub | Desktop/Cloud | Pointer-cliquer, sites dynamiques, planification | Moyenne | ~189$/mois | Scraping complexe |

| Apify | Cloud | Marketplace d’acteurs, API, planification | Variable (facile avec templates, technique sinon) | ~49$/mois | Développeurs, gros volumes |

| Browse.ai | Cloud/Extension | Enregistreur no-code, monitoring, intégrations | Élevée pour les bases | ~39$/mois | Veille de sites |

| Bardeen | Extension/Cloud | Automatisation, playbooks IA | Moyenne | ~10$/mois | Automatisation de workflows |

Thunderbit s’adresse à tous ceux qui veulent extraire des données vite et sans prise de tête. Que tu sois commercial, responsable e-commerce, agent immobilier ou marketeur, Thunderbit est pensé pour te permettre de te concentrer sur les résultats, pas sur la technique.

Les atouts des outils de data scraping nouvelle génération

Voici ce qui fait la différence avec les outils de data scraping modernes (surtout ceux boostés à l’IA) :

- Suggestions de champs par IA : Plus besoin de cliquer partout – l’IA repère les infos clés et propose les colonnes.

- Extraction sur sous-pages : Suit automatiquement les liens pour récupérer des infos détaillées (fiches produits, propriétaires, etc.).

- Gestion du contenu dynamique : Fonctionne avec le scroll infini, AJAX, sites JavaScript – sans réglages manuels.

- Scraping cloud ou navigateur : À toi de choisir : extraction dans le navigateur (pratique pour les sites avec connexion) ou dans le cloud (plus rapide pour les données publiques).

- Scraping planifié : Programme des extractions régulières – données fraîches chaque jour, semaine, etc.

- Nettoyage intégré : L’IA peut standardiser, traduire ou classer les données à la volée.

- Templates : Modèles prêts à l’emploi pour les sites populaires – tu gagnes du temps à chaque projet.

Tout ça pour un objectif : te permettre de passer de « j’ai besoin de ces données » à « voici mon tableau » en un clin d’œil.

Exemples concrets : le data scraping en action

Voyons comment les outils de data scraping IA comme Thunderbit sont utilisés au quotidien :

Vente : Extraction de leads et contacts

Une équipe commerciale veut se constituer une liste d’entreprises locales à démarcher. Plutôt que d’y passer des jours à copier noms et emails depuis des annuaires, elle utilise Thunderbit pour tout extraire en quelques minutes. Une agence a ainsi sur la recherche manuelle et constaté une .

E-commerce : Veille sur les prix et références concurrentes

Un responsable e-commerce doit surveiller les prix des concurrents. Plutôt que de vérifier chaque produit à la main, il programme Thunderbit pour extraire les prix chaque jour et recevoir une alerte en cas de baisse chez un rival. Cette réactivité permet de protéger les marges et d’ajuster l’offre instantanément.

Immobilier : Collecte d’annonces et de prix

Un agent immobilier veut rester à l’affût des nouvelles annonces. Thunderbit extrait les données de Zillow ou : prix, localisation, description… L’agent reçoit chaque jour un tableau des opportunités à ne pas manquer.

Marketing : Collecte de données de campagne ou d’insights sociaux

Une équipe marketing extrait toutes les adresses de salons sur Google Maps, avec notes et avis, pour planifier une campagne locale. Ou bien elle collecte les mentions sur les réseaux sociaux pour mesurer la perception de la marque – sans avoir à lire des milliers de posts à la main.

Les défis du data scraping et comment les surmonter

- Changements de site : Les extracteurs classiques plantent dès qu’un site change. Les extracteurs IA comme Thunderbit utilisent le contexte pour retrouver les bonnes infos, même si le HTML bouge.

- Anti-scraping : Beaucoup de sites essaient de bloquer les robots. Les extracteurs IA qui passent par le navigateur « imitent » un vrai utilisateur, donc moins de blocages.

- Données en vrac : L’IA nettoie et formate les données à l’extraction, moins de temps perdu à corriger les tableaux.

- Scalabilité : Les outils navigateur suffisent pour la plupart des besoins, mais le cloud prend le relais pour les gros volumes.

- Légalité : Vérifie toujours les conditions d’utilisation et le robots.txt du site, évite les données personnelles, respecte les limites. est un scraping durable.

La règle d’or ? Si tu n’es pas à l’aise d’expliquer comment tu as obtenu les données, mieux vaut s’abstenir.

L’avenir du data scraping : l’IA pour tous

On revient de loin depuis l’époque du copier-coller. Le data scraping est passé d’un truc de technicien à un outil indispensable, et grâce à l’IA, il devient accessible à tous.

La suite ? Des « agents de données » encore plus malins, capables de réaliser des tâches complexes à partir d’une simple demande en langage courant (« Donne-moi toutes les nouvelles annonces à moins de 500k€ à Lyon cette semaine »). Flux de données en temps réel, intégration plus poussée aux outils métiers, conformité renforcée… tout ça arrive très vite.

Chez Thunderbit, notre mission est de démocratiser le data scraping – le rendre si simple que chacun, quel que soit son métier, puisse profiter de la puissance des données web. Fini les galères techniques, fini le temps perdu. Tu expliques ce dont tu as besoin, l’IA s’occupe du reste.

Alors, la prochaine fois que tu t’apprêtes à cliquer sur « copier », pense-y : il y a mieux. L’avenir du data scraping est déjà là, et il carbure à l’IA. Tu veux tester ? et passe du manuel au magique (ok, j’avais promis pas de « magie », mais parfois, c’est vraiment l’impression que ça donne).

FAQ :

1. Qu’est-ce que le data scraping ?

Le data scraping, c’est utiliser un logiciel pour collecter des infos sur des sites web ou des documents numériques, puis les transformer en formats structurés comme des tableurs, bases de données ou Google Sheets.

Au lieu de copier-coller à la main, un extracteur « parcourt » les pages, repère les éléments importants (noms de produits, prix, contacts…) et les exporte dans des tableaux. Cette méthode accélère la collecte pour l’analyse, la prospection ou le reporting, tout en limitant les erreurs humaines.

2. Pourquoi le data scraping est-il important pour les entreprises ?

Dans un marché où tout va très vite, avoir des données fiables et à jour permet de prendre de meilleures décisions. L’automatisation du scraping fait gagner un temps fou, améliore la précision en évitant les fautes, et permet de traiter des centaines ou milliers de pages.

Que ce soit pour surveiller les prix concurrents, collecter des leads ou faire des études de marché, les entreprises gagnent en agilité et en profondeur d’analyse – transformant le web en intelligence exploitable.

3. Comment Thunderbit simplifie-t-il l’extraction de données web par IA ?

L’extension Chrome Thunderbit utilise l’IA pour suggérer les champs, suivre automatiquement les liens vers les sous-pages, et proposer des noms de colonnes – sans aucun code ni connaissance CSS. Grâce aux templates pour des sites comme Amazon ou Zillow, tu peux extraire prix, contacts, avis et plus en quelques minutes. Exporte directement vers Google Sheets, Airtable ou Excel, et programme des extractions régulières pour garder tes données à jour.

Pour aller plus loin, jette un œil à ces ressources :