Vous vous êtes déjà demandé comment les boîtes arrivent à transformer un vrai capharnaüm de données brutes, éparpillées un peu partout, en beaux tableaux de bord et en analyses boostées à l’IA ? Rassure-toi, tu n’es pas le seul ! Le secret, c’est l’ingestion de données – ce maillon clé, souvent sous-estimé, qui lance toute démarche data. Dans un monde où on prévoit de générer (oui, ça fait 21 zéros !), faire circuler les données vite, proprement et dans un format exploitable, c’est devenu vital.

Après des années à bosser dans le SaaS et l’automatisation, j’ai vu à quel point une bonne stratégie d’ingestion de données peut tout changer. Que tu veuilles centraliser tes leads, surveiller le marché ou juste fluidifier tes process, piger comment marche l’ingestion de données (et comment elle évolue) est la première étape pour créer de la valeur. Alors, on y va : c’est quoi l’ingestion de données, pourquoi c’est si important, et comment des outils modernes – comme – changent la donne pour les analystes comme pour les entrepreneurs ?

C’est quoi l’ingestion de données ? La base pour une boîte pilotée par la data

L’ingestion de données, c’est tout simplement le fait de collecter, importer et charger des données qui viennent de partout (tableurs, API, logs, pages web, capteurs…) dans un système central – base de données, data warehouse ou data lake – pour ensuite les analyser, les visualiser ou les utiliser pour prendre des décisions. Imagine ça comme la « porte d’entrée » de ton pipeline data : c’est là que tu rassembles toutes tes matières premières avant de commencer à « cuisiner » tes analyses.

L’ingestion de données, c’est le tout premier maillon de la chaîne (), celui qui casse les silos et garantit que tes données sont fiables et à jour pour l’analytique, la BI ou le machine learning. Sans ça, tes infos restent coincées dans des systèmes isolés – « invisibles pour ceux qui en ont besoin », comme le disent les pros.

Voilà comment ça s’imbrique :

- Ingestion de données : tu récupères les données brutes de différentes sources et tu les centralises.

- Intégration de données : tu combines et alignes les données de plusieurs systèmes pour qu’elles soient cohérentes.

- Transformation de données : tu nettoies, formates et enrichis les données pour qu’elles soient prêtes à être analysées.

Imagine : l’ingestion, c’est ramener tes courses de différents magasins. L’intégration, c’est ranger tout ça dans le placard, et la transformation, c’est préparer et cuisiner le repas.

Pourquoi l’ingestion de données est-elle si importante aujourd’hui ?

Soyons clairs : aujourd’hui, avoir des données bien ingérées et dispo à temps, c’est un vrai avantage. Les boîtes qui maîtrisent l’ingestion de données cassent les silos, accèdent à des analyses en temps réel et prennent de meilleures décisions, plus vite. À l’inverse, si l’ingestion est bancale, tu te retrouves avec des rapports à la traîne, des occasions ratées et des décisions basées sur des données dépassées ou incomplètes.

Quelques exemples concrets de la valeur d’une ingestion efficace :

| Cas d’usage | Comment une ingestion efficace aide |

|---|---|

| Génération de leads commerciaux | Centralise les leads issus de formulaires web, réseaux sociaux et bases de données dans un seul système, quasi en temps réel – pour permettre aux équipes commerciales de réagir plus vite et d’augmenter les taux de conversion. |

| Tableaux de bord opérationnels | Alimente en continu les plateformes d’analytique avec les données des systèmes de production, fournissant des indicateurs à jour pour la direction et permettant des actions correctives rapides. |

| Vue client 360° | Intègre les données clients issues du CRM, du support, de l’e-commerce et des réseaux sociaux pour créer des profils unifiés, favorisant un marketing personnalisé et un service proactif (Cake.ai). |

| Maintenance prédictive | Ingère de gros volumes de données capteurs et IoT, permettant aux modèles d’analytique de détecter les anomalies et d’anticiper les pannes – réduisant ainsi les arrêts et les coûts. |

| Analyse des risques financiers | Diffuse en temps réel les transactions et flux de marché dans les modèles de risque, offrant aux banques et traders une vision instantanée des expositions et une détection immédiate des fraudes. |

Et les chiffres sont parlants : , mais ça ne sert à rien si les données ne sont pas bien ingérées et fiables.

Ingestion, intégration, transformation : on démêle tout

Pas facile de s’y retrouver avec tous ces termes, alors on fait simple :

- Ingestion de données : c’est la première étape, tu récupères et importes les données brutes depuis les sources. En gros : « tout faire entrer dans la cuisine ».

- Intégration de données : tu combines et alignes les données de différentes sources pour qu’elles soient cohérentes et donnent une vision globale. En gros : « organiser le placard ».

- Transformation de données : tu transformes les données brutes en données prêtes à l’emploi – nettoyage, formatage, enrichissement. En gros : « préparer et cuisiner le repas ».

Beaucoup confondent ingestion et ETL (Extract, Transform, Load). En vrai, l’ingestion, c’est juste la phase “extract” – c’est l’import des données brutes. L’intégration et la transformation viennent après pour rendre les données exploitables ().

Pourquoi c’est important ? Si tu veux juste récupérer un jeu de données rapide depuis une page web, un outil d’ingestion léger suffit. Mais si tu dois combiner et nettoyer des données de plusieurs systèmes, il te faudra aussi l’intégration et la transformation.

Les méthodes classiques d’ingestion de données : ETL et ses limites

Pendant longtemps, la méthode de base pour l’ingestion de données, c’était l’ETL (Extract, Transform, Load). Les ingénieurs data écrivaient des scripts ou utilisaient des logiciels spécialisés pour extraire les données, les nettoyer et les charger dans un data warehouse. Tout ça, souvent en batch, la nuit.

Mais avec l’explosion du volume et de la diversité des données, l’ETL classique a montré ses limites :

- Mise en place longue et compliquée : Monter et maintenir des pipelines ETL, ça demandait beaucoup de code et des compétences pointues. Les équipes non techniques devaient attendre que l’IT fasse tout ().

- Traitement batch lent : Les jobs ETL tournaient en batch, donc les données arrivaient avec du retard. À l’ère du temps réel, attendre des heures ou des jours, c’est plus possible ().

- Difficile à faire évoluer : Les vieux pipelines galéraient avec les volumes actuels, il fallait tout le temps les ajuster.

- Rigide : Ajouter une nouvelle source ou changer le schéma, c’était galère et risqué.

- Maintenance lourde : Les pipelines plantaient souvent, il fallait surveiller en permanence.

- Limité aux données structurées : L’ETL classique, c’était pour des tableaux bien rangés – pas pour les données non structurées (pages web, images) qui représentent aujourd’hui .

Bref : l’ETL, c’était bien avant, mais aujourd’hui, ça ne suit plus le rythme ni la complexité des données.

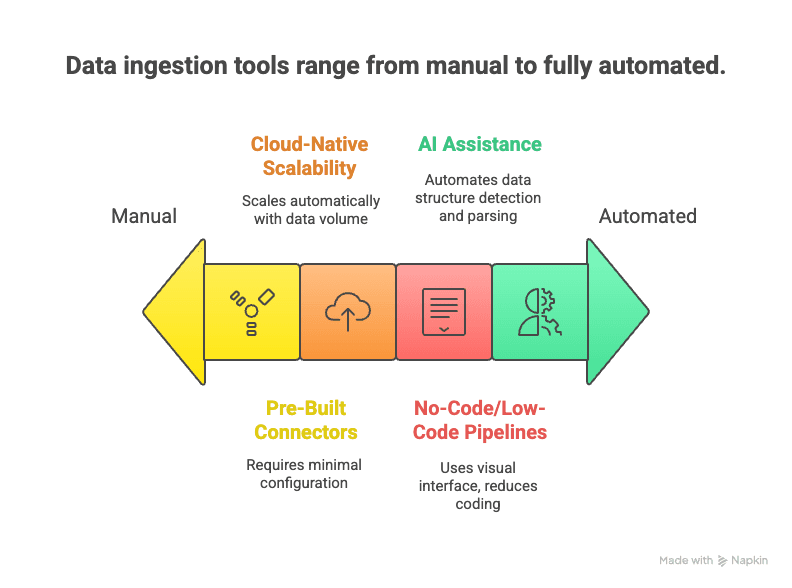

L’ingestion moderne : automatisation et IA à la rescousse

Place à la nouvelle génération : des outils d’ingestion de données modernes qui misent sur l’automatisation, le cloud et l’IA pour accélérer et simplifier la collecte de données.

Ce qui change la donne :

- Pipelines no-code/low-code : Interfaces drag & drop et assistants IA pour configurer des flux de données sans coder ().

- Connecteurs prêts à l’emploi : Des centaines de connecteurs pour les sources les plus courantes – tu rentres tes identifiants et c’est parti.

- Scalabilité cloud : Les services cloud gèrent des flux énormes en temps réel ().

- Support du temps réel et du streaming : Les outils modernes gèrent aussi bien le batch que le streaming, selon tes besoins ().

- Assistance IA : L’IA détecte la structure des données, propose des règles de parsing et fait des contrôles qualité à la volée ().

- Gestion des données non structurées : Le NLP et la vision par ordi transforment pages web, PDF ou images en tableaux structurés.

- Maintenance réduite : Les services managés s’occupent de la surveillance, de la montée en charge et des mises à jour – toi, tu te concentres sur l’exploitation des données.

Résultat : une ingestion de données plus rapide à mettre en place, plus flexible et capable de gérer la complexité d’aujourd’hui.

L’ingestion de données sur le terrain : secteurs et défis

Voyons comment l’ingestion de données s’applique concrètement selon les secteurs – et les galères rencontrées.

Commerce & e-commerce

Les enseignes récupèrent des données des caisses, sites e-commerce, applis de fidélité et capteurs en magasin. En consolidant transactions, parcours web et stocks, elles ont une vision en temps réel des ventes et tendances. Le défi ? Gérer des volumes énormes et intégrer des données de partout, surtout lors des pics.

Finance & banque

Banques et traders ingèrent des flux de transactions, données de marché et interactions clients. L’ingestion en temps réel est cruciale pour détecter la fraude et gérer les risques. Mais la conformité et la sécurité imposent une rigueur extrême.

Tech & internet

Les géants du web collectent des tonnes d’événements (clics, likes, partages) pour analyser les comportements et alimenter les moteurs de reco. L’enjeu : séparer le signal du bruit et garantir la qualité à grande échelle.

Santé

Les hôpitaux ingèrent des données des dossiers médicaux, labos et dispositifs médicaux pour créer des dossiers patients unifiés et développer l’analytique prédictive. Les obstacles : l’interopérabilité (systèmes différents) et la confidentialité.

Immobilier

Les agences immobilières collectent des données de portails d’annonces, sites spécialisés et registres publics pour bâtir des bases complètes. Le défi : fusionner des sources variées – souvent non structurées – et garder les infos à jour.

Les défis communs à tous :

- Gérer la variété des données (structurées, semi-structurées, non structurées)

- Trouver le bon équilibre entre temps réel et batch

- Assurer la qualité et la cohérence

- Respecter la sécurité et la conformité

- S’adapter à la croissance des volumes

Surmonter ces obstacles, c’est la clé pour des analyses plus précises, des décisions en temps réel et une conformité béton.

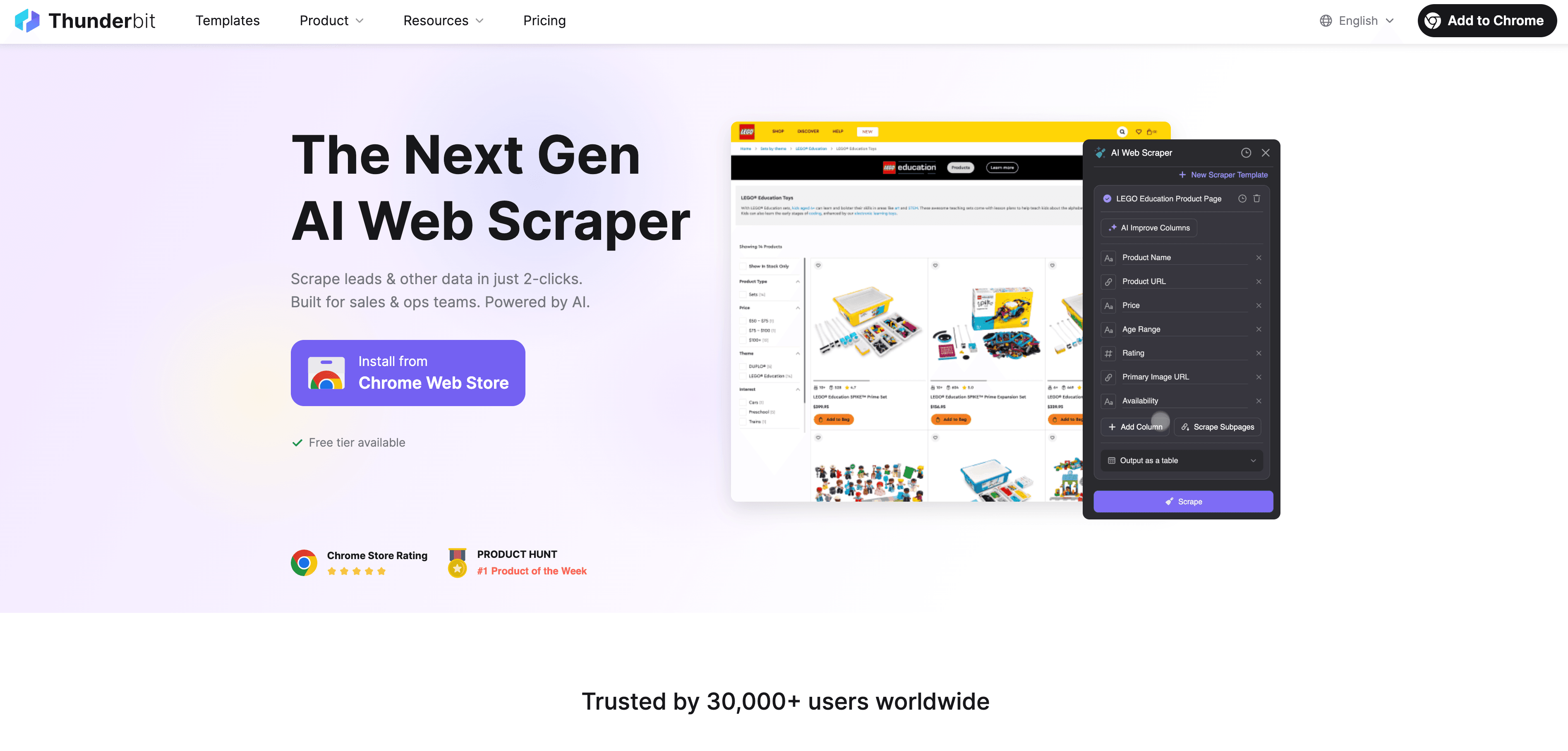

Thunderbit : l’ingestion de données web simplifiée avec l’Extracteur Web IA

Voyons comment Thunderbit s’insère dans tout ça. est une extension Chrome d’extracteur web IA pensée pour rendre l’ingestion de données web accessible à tous – même sans aucune compétence technique.

Pourquoi Thunderbit change la donne :

- Extraction web en 2 clics : Passe d’une page web en vrac à un jeu de données structuré en deux clics. Clique sur « Suggérer les champs IA », puis sur « Extraire » – c’est tout.

- Suggestions IA : L’IA de Thunderbit lit la page et propose les meilleures colonnes à extraire, que ce soit sur un annuaire, une liste de produits ou un profil LinkedIn.

- Extraction automatique des sous-pages : Besoin de détails en plus ? Thunderbit peut visiter chaque sous-page (fiche produit, profil) et enrichir ton tableau.

- Gestion de la pagination : Il gère les listes paginées et le scroll infini pour ne rien rater.

- Modèles prêts à l’emploi : Pour les sites comme Amazon, Zillow ou Shopify, Thunderbit propose des modèles 1-clic – rien à configurer.

- Export gratuit : Exporte direct vers Excel, Google Sheets, Airtable ou Notion – sans frais cachés.

- Extraction programmée : Planifie des extractions automatiques à la fréquence que tu veux (ex : veille tarifaire quotidienne).

- Auto-remplissage IA : Automatise aussi le remplissage de formulaires et les tâches web répétitives.

Thunderbit, c’est parfait pour les équipes commerciales à la chasse aux leads, les analystes e-commerce qui surveillent les prix ou les agents immobiliers qui collectent des annonces. L’idée : transformer vite des données web non structurées en infos exploitables.

Pour voir Thunderbit en action, check notre ou jette un œil à notre pour plus de tutos.

Outils d’ingestion de données : traditionnels vs modernes

Petit comparatif pour y voir clair :

| Critère | Outils ETL traditionnels | Outils IA/Cloud modernes | Thunderbit (Extracteur Web IA) |

|---|---|---|---|

| Niveau d’expertise requis | Élevé (code/IT nécessaire) | Modéré (low-code, configuration) | Faible (2 clics, sans code) |

| Sources de données | Structurées (bases, CSV) | Variées (bases, SaaS, API) | Tout site web, données non structurées |

| Vitesse de déploiement | Lente (semaines/mois) | Plus rapide (jours) | Instantané (minutes) |

| Support du temps réel | Limité (batch) | Fort (streaming/batch) | À la demande & programmé |

| Scalabilité | Difficile | Élevée (cloud-native) | Modérée/élevée (cloud scraping) |

| Maintenance | Élevée (pipelines fragiles) | Moyenne (services managés) | Faible (IA s’adapte aux changements) |

| Transformation | Rigide, en amont | Flexible, post-chargement | Basique (suggestions IA) |

| Cas d’usage idéal | Intégration batch interne | Pipelines analytiques | Données web, sources externes |

À retenir : choisis l’outil qui colle à ton besoin. Pour les données web ou non structurées, Thunderbit est souvent la solution la plus rapide et la plus simple.

L’avenir de l’ingestion de données : automatisation et cloud avant tout

Demain, l’ingestion de données sera encore plus intelligente et automatisée. Les grandes tendances à surveiller :

- Le temps réel devient la norme : Le batch laisse la place aux pipelines événementiels et temps réel ().

- Cloud-first et “Zero ETL” : Les plateformes cloud facilitent la connexion des sources et cibles sans pipelines manuels.

- Automatisation par l’IA : Le machine learning va configurer, surveiller et optimiser les pipelines – détecter les anomalies, corriger les erreurs, enrichir les données en temps réel.

- No-code et self-service : De plus en plus d’outils permettront aux métiers de créer des flux de données via le langage naturel ou des interfaces visuelles.

- Ingestion à la périphérie (Edge/IoT) : Avec la multiplication des données générées à la source, l’ingestion se fera au plus près, avec filtrage et agrégation intelligents.

- Gouvernance et métadonnées : L’étiquetage automatique, la traçabilité et la conformité seront intégrés à chaque étape.

En résumé : l’avenir, c’est une ingestion de données plus rapide, plus accessible et plus fiable – pour que tu puisses te concentrer sur l’analyse, pas sur la technique.

Conclusion : ce qu’il faut retenir

- L’ingestion de données, c’est la première étape clé de toute démarche data-driven. Pour avoir des insights, il faut d’abord collecter les données – vite et bien.

- Des outils modernes, boostés par l’IA comme Thunderbit, rendent l’ingestion accessible à tous, pas seulement aux experts IT. Avec l’extraction en 2 clics, les suggestions IA et la planification, transforme tes données web en or business.

- Le choix de l’outil est crucial : privilégie l’ETL traditionnel pour les données internes stables, les outils cloud pour l’analytique large, et Thunderbit pour les données web ou non structurées.

- Reste à la page : automatisation, cloud et IA rendent l’ingestion plus intelligente et plus simple. Ne reste pas bloqué dans le passé – explore les nouvelles solutions et anticipe l’avenir de ta stratégie data.

FAQ

1. C’est quoi l’ingestion de données, en deux mots ?

L’ingestion de données, c’est collecter et importer des données de différentes sources (sites web, bases de données, fichiers…) dans un système central pour les analyser ou les exploiter. C’est la toute première étape d’un pipeline data.

2. Quelle différence entre ingestion, intégration et transformation de données ?

L’ingestion, c’est faire entrer les données brutes. L’intégration, c’est les combiner et les aligner, la transformation, c’est les nettoyer et les formater pour l’analyse. En résumé : ingestion = collecte, intégration = organisation, transformation = préparation et cuisson.

3. Quels sont les principaux défis des méthodes classiques d’ingestion ?

Les méthodes classiques comme l’ETL sont longues à mettre en place, demandent beaucoup de code, gèrent mal les données non structurées et ne sont pas faites pour le temps réel. Elles sont aussi rigides et difficiles à maintenir quand les sources changent.

4. Comment Thunderbit simplifie l’ingestion de données ?

Thunderbit utilise l’IA pour permettre à tout le monde d’extraire et structurer des données web en deux clics – sans coder. Il gère les sous-pages, la pagination, la planification de tâches récurrentes et l’export direct vers Excel, Google Sheets, Airtable ou Notion.

5. Quel avenir pour l’ingestion de données ?

L’avenir, c’est l’automatisation, le cloud et des pipelines pilotés par l’IA. Attends-toi à plus de flux temps réel, une gestion intelligente des erreurs et des outils qui permettent de configurer l’ingestion via le langage naturel ou des interfaces visuelles.

Pour aller plus loin :