Le web, c’est un vrai tourbillon qui ne s’arrête jamais. Chaque jour, on voit débarquer des milliards de nouvelles pages, de produits, d’avis ou de jeux de données—que ce soit pour la veille marché, l’entraînement de l’IA ou même ton prochain panier sur Amazon. Après avoir passé pas mal d’années dans le SaaS et l’automatisation, j’ai vraiment vu à quel point avoir accès aux bonnes données peut tout changer dans une stratégie. Mais voilà, récupérer, mettre à jour et exploiter toutes ces infos en ligne, c’est de plus en plus galère. Les extracteurs web classiques ont du mal à suivre la cadence, et les boîtes cherchent des solutions plus futées et plus rapides pour transformer le web en infos actionnables. C’est là que le cloud crawler entre en scène—un outil qui, sans faire de bruit, révolutionne la façon dont les organisations dénichent et utilisent les données web à grande échelle.

Mais alors, c’est quoi exactement un cloud crawler ? Qu’est-ce qui le rend différent d’un extracteur web classique ? Et pourquoi les équipes commerciales, marketing ou opérationnelles misent-elles dessus pour garder une longueur d’avance dans ce monde où la data est reine ? On va décortiquer tout ça ensemble et voir comment les cloud crawlers (surtout celui de Thunderbit) changent la donne pour les entreprises d’aujourd’hui.

C’est quoi un Cloud Crawler ? La nouvelle façon de dénicher la data

Pour faire simple, un cloud crawler n’est pas juste un extracteur web qu’on a mis dans le cloud. C’est carrément un moteur de découverte de données : un système intelligent, hébergé dans le cloud, qui repère, extrait et analyse automatiquement des quantités énormes de données sur internet. Là où un extracteur web classique va gratter quelques pages (souvent une par une, et depuis un seul ordi), un cloud crawler joue dans une autre cour. Hébergé dans des data centers ultra-puissants, il peut explorer des milliers, voire des millions de pages en même temps, et gérer aussi bien du texte que des images ou des PDF—peu importe la taille ou la complexité du site.

Imagine un extracteur web comme un bibliothécaire qui recopie des passages d’un livre. Un cloud crawler, c’est une armée de superordinateurs qui scannent tous les livres de la bibliothèque d’un coup, tout en classant et analysant le contenu au passage. Résultat ? Les entreprises récupèrent des données plus riches, plus fraîches et prêtes à l’emploi—sans se prendre la tête avec le matos ou les tâches manuelles (, ).

Cloud Crawler vs. Extracteur Web Classique : le match

Si tu as déjà utilisé un extracteur web, tu connais le principe : tu cibles une page, tu choisis les infos à extraire, et l’outil fait le boulot. Mais plus le web devient complexe, plus cette méthode montre ses limites. Voilà comment les deux se comparent :

| Fonctionnalité/Aspect | Extracteur Web Traditionnel | Cloud Crawler |

|---|---|---|

| Déploiement | Fonctionne sur ton ordi ou serveur local | Fonctionne dans le cloud (data centers distants) |

| Évolutivité | Limité par la puissance de ton ordi | Massivement parallèle—des milliers de pages à la fois |

| Vitesse | Plus lent, surtout pour de gros volumes | Traitement rapide en lots |

| Maintenance | Faut mettre à jour souvent, fragile aux changements de sites | Automatique, plus robuste, s’adapte tout seul |

| Types de données | Surtout du texte, parfois des images | Texte, images, PDF, structures complexes |

| Accès | Lié à ton appareil/réseau | Accessible partout, sur n’importe quel appareil |

| Planification | Manuelle ou automatisation basique | Planification avancée, tâches récurrentes |

| Idéal pour | Petits projets, sites simples | Gros besoins, fréquents ou complexes |

Les cloud crawlers sont taillés pour le web d’aujourd’hui—où la data est partout, et où il faut aller vite et à grande échelle (, ).

Comment les Cloud Crawlers boostent la collecte de données

C’est là que ça devient vraiment cool. Les cloud crawlers profitent de la puissance du cloud pour traiter des milliers de pages web en même temps. Tu peux extraire tout un catalogue e-commerce, surveiller les prix de la concurrence sur plein de sites, ou rassembler des annonces immobilières de tous les portails majeurs—en un temps record, là où un extracteur classique mettrait des heures.

Pourquoi c’est si important ? Dans des secteurs comme l’e-commerce, la finance ou l’immobilier, avoir des données fraîches, c’est vital. Les prix, les stocks, les tendances changent à la minute. Attendre des heures (ou des jours) qu’un extracteur local ait fini, c’est plus possible. Les cloud crawlers ne sont pas limités par la mémoire de ton ordi ou la connexion du bureau : ils s’adaptent à la charge, et gèrent des volumes énormes sans broncher (, ).

Les secteurs qui en profitent le plus :

- E-commerce : Suivi des prix, agrégation de catalogues, analyse d’avis clients

- Immobilier : Centralisation d’annonces, suivi des tendances, comparaison de biens

- Finance : Veille d’actualités, analyse de sentiment, suivi des marchés boursiers/cryptos

- Ventes & Marketing : Génération de leads, veille concurrentielle, détection de tendances

Et ce n’est qu’un début. Si tu as besoin de data web à grande échelle, le cloud crawler, c’est ton meilleur pote.

Le Cloud Crawler Thunderbit : rapide, flexible, puissant

Je vais mettre ma casquette Thunderbit (en vrai, je la garde tout le temps). Le mode cloud de est pile dans l’air du temps : un cloud crawler pensé pour les pros qui veulent des résultats, sans prise de tête.

Ce qui fait la différence avec le cloud crawler de Thunderbit :

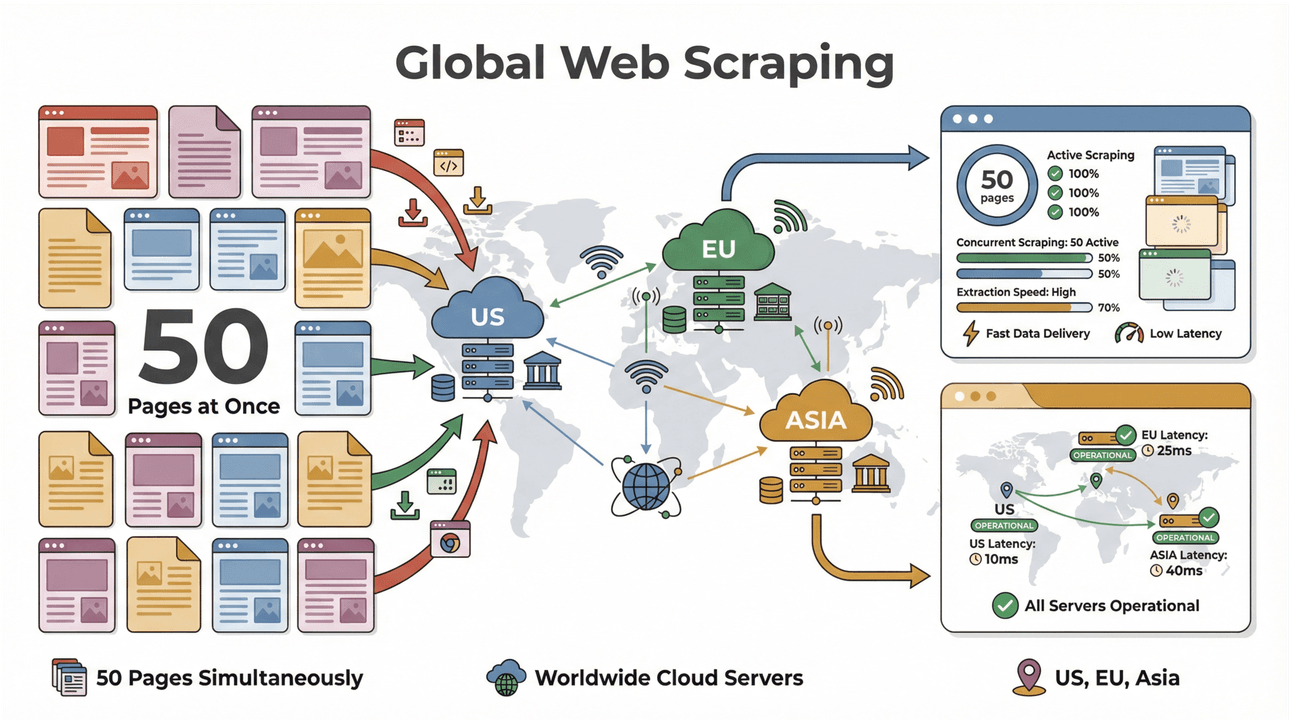

- Extraction en lot ultra-rapide : Jusqu’à 50 pages traitées en même temps, avec des serveurs cloud aux US, en Europe et en Asie pour une couverture mondiale. Fini d’attendre que ton ordi rame sur la liste !

- Gestion des pages complexes : L’IA de Thunderbit gère aussi bien les sites e-commerce dynamiques que les PDF tordus ou l’extraction d’images. Si c’est en ligne, Thunderbit peut sûrement l’extraire ().

- Exploration des sous-pages : Tu veux enrichir tes données avec des infos de sous-pages (fiches produits, bios d’auteurs…) ? L’IA de Thunderbit visite chaque sous-page et fusionne tout dans ton jeu de données principal ().

- Structuration intelligente des données : Utilise « Suggestion de champs IA » pour que Thunderbit analyse le site et te propose les meilleures colonnes—pas besoin de coder ou de galérer avec des modèles.

- Exportation flexible : Balance tes données direct dans Excel, Google Sheets, Airtable ou Notion. Ou télécharge-les en CSV/JSON, comme tu veux ().

- Zéro maintenance : L’IA de Thunderbit s’adapte aux changements de sites, donc plus besoin de réparer tes extracteurs à chaque fois ().

Et oui, tu peux tester tout ça gratos avec la —pas besoin de me croire sur parole.

Déployer un Cloud Crawler : cloud ou local, que choisir ?

Un des gros atouts des cloud crawlers, c’est leur flexibilité. Avec un extracteur local, tu dépends d’un appareil, d’un réseau, et souvent de réglages pénibles. Si ton ordi se met en veille ou si la connexion saute, tout s’arrête. Pour passer à la vitesse supérieure, il faut acheter du matos ou multiplier les scripts.

Les cloud crawlers changent la donne :

- Aucun matos à acheter : Toute la puissance est dans le cloud. Lance des extractions massives depuis un Chromebook, un Mac ou même ton smartphone.

- Accessible partout : En déplacement ou en télétravail ? Ton cloud crawler est toujours là.

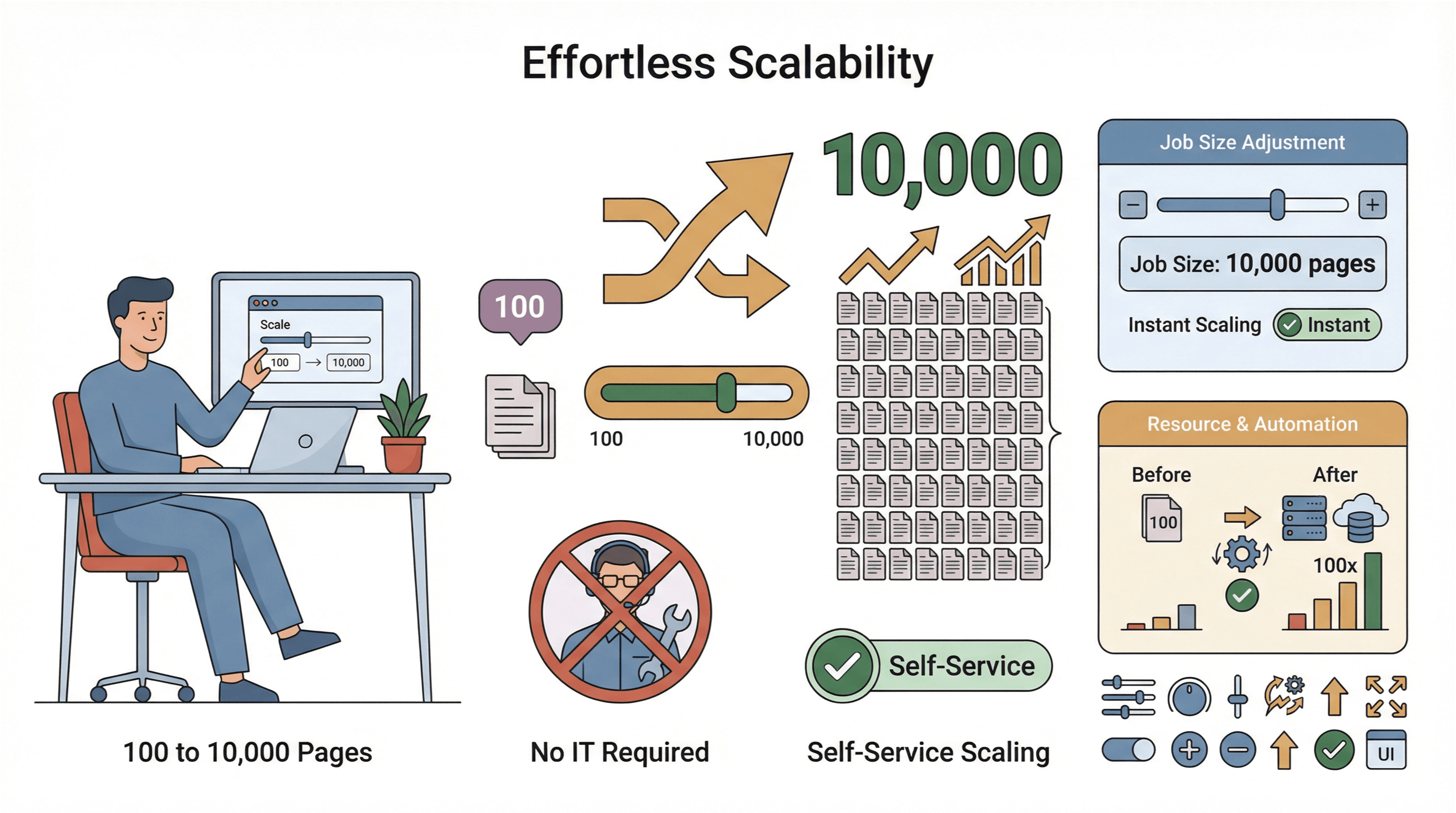

- Évolutivité instantanée : Tu veux passer de 100 à 10 000 pages ? Il suffit d’augmenter la taille du job—pas besoin d’appeler l’IT.

- Collecte mondiale de données : Grâce à des serveurs dans plusieurs régions, tu peux accéder à des contenus géo-bloqués et rester conforme ().

Bien sûr, la sécurité et la conformité restent super importantes. Les meilleurs cloud crawlers (Thunderbit inclus) utilisent des connexions chiffrées, respectent les conditions d’utilisation des sites et proposent des outils pour gérer les données sensibles de façon responsable.

Impact concret : comment les Cloud Crawlers changent la donne

Passons au concret. Pourquoi les entreprises adoptent les cloud crawlers ? Parce qu’elles voient des résultats directs :

- Analyse de marché en temps réel : Les distributeurs surveillent en direct les prix et stocks de la concurrence, pour ajuster leurs tarifs et réagir plus vite aux changements ().

- Anticipation des tendances : Les marques agrègent avis, posts sociaux et discussions de forums pour capter les signaux faibles et adapter leurs campagnes en temps réel.

- Génération de leads : Les équipes commerciales construisent des listes de prospects à jour à partir d’annuaires, d’événements ou même de PDF—et alimentent leur CRM avec des contacts qualifiés ().

- Veille réglementaire et opérationnelle : Les sociétés financières surveillent les évolutions réglementaires, actualités et dépôts officiels dans plusieurs pays—pour réduire les risques et anticiper les changements.

Le point commun ? Les cloud crawlers permettent d’aller plus vite, de prendre de meilleures décisions et de devancer les concurrents qui restent sur des méthodes lentes.

Les fonctionnalités clés à avoir dans un Cloud Crawler

Tous les cloud crawlers ne se valent pas. Voici les critères à checker (et sur lesquels Thunderbit brille) :

- Évolutivité : Peut-il gérer des milliers de pages sans ralentir ?

- Simplicité d’utilisation : L’interface est-elle accessible même si tu n’es pas un tech ? Peut-on lancer une extraction en quelques clics ?

- Support multi-données : Texte, images, PDF, sous-pages… tout est-il pris en charge ?

- Intégration : Peut-on exporter vers ses outils préférés (Excel, Sheets, Notion, Airtable) ?

- Planification : Peut-on programmer des extractions récurrentes pour avoir des données toujours fraîches ?

- Assistance IA : Suggestions de champs, enrichissement, adaptation automatique aux changements de sites ?

- Sécurité & conformité : Les données et identifiants sont-ils protégés ? L’outil aide-t-il à respecter la loi ?

Thunderbit coche toutes ces cases, ce qui en fait un choix top pour les équipes qui veulent la puissance sans la prise de tête.

Premiers pas : comment utiliser un Cloud Crawler pour ta boîte

Prêt à te lancer ? Voilà comment un pro peut démarrer avec un cloud crawler comme Thunderbit :

- Installe l’ : Installation rapide, pas besoin d’appeler l’IT.

- Choisis ta cible : Ouvre le site, la liste ou le doc à extraire.

- Clique sur « Suggestion de champs IA » : L’IA de Thunderbit analyse la page et propose les colonnes utiles.

- Personnalise si besoin : Ajoute, supprime ou renomme les champs selon tes besoins.

- Sélectionne le mode Cloud : Pour les gros volumes ou les sites costauds, passe en mode cloud pour aller à fond.

- Lance l’extraction : Thunderbit traite jusqu’à 50 pages à la fois dans le cloud.

- Vérifie et exporte : Prévisualise les résultats, puis exporte vers Excel, Google Sheets, Notion ou Airtable.

- Planifie des extractions récurrentes : Pour des besoins réguliers, programme des tâches—tes données seront mises à jour automatiquement ().

Petit conseil : commence par un projet simple pour te faire la main, puis accélère. Et n’hésite pas à consulter le support ou la doc Thunderbit—ils sont là pour t’aider.

L’avenir de la collecte de données : où vont les Cloud Crawlers ?

La révolution des cloud crawlers ne fait que commencer. Voici les tendances à surveiller dans les prochaines années :

- Extraction IA toujours plus intelligente : Les cloud crawlers vont mieux comprendre le contexte, les relations et même le ressenti—rendant la data collectée encore plus précieuse ().

- Support de nouveaux formats : Attends-toi à une meilleure gestion de la vidéo, de l’audio et des contenus interactifs—pas juste du texte ou des images.

- Automatisation avancée : De la planification automatique aux alertes en temps réel, les cloud crawlers vont devenir encore plus autonomes pour les métiers.

- Conformité renforcée : Avec les lois sur la vie privée qui évoluent, les cloud crawlers intégreront plus d’outils pour rester dans les clous.

- Intégration avec la BI et l’IA : Des pipelines directs vers les outils d’analyse, dashboards et plateformes de machine learning.

En clair, les cloud crawlers sont en train de devenir la colonne vertébrale de la stratégie digitale—du lancement produit à la prévision boostée par l’IA ().

Conclusion : pourquoi les Cloud Crawlers sont devenus indispensables

Pour résumer : le web déborde de données, et les méthodes classiques ne suffisent plus. Les cloud crawlers, c’est la nouvelle génération—rapides, massifs, intelligents, là où les extracteurs classiques plafonnent. Des outils comme permettent à toutes les équipes, tech ou pas, de profiter à fond du potentiel de la data web—pour des décisions plus malines, des réactions plus rapides et un vrai avantage sur la concurrence.

Si tu veux tourner la page du scraping manuel et des données qui traînent, c’est le moment de voir ce qu’un cloud crawler peut apporter à ton business. Teste le mode cloud de Thunderbit et découvre à quel point la collecte de données moderne peut être simple et puissante. Pour aller plus loin, checke le pour des guides, astuces et retours d’expérience.

FAQ

1. C’est quoi un cloud crawler, en deux mots ?

Un cloud crawler, c’est un outil basé sur le cloud qui repère, extrait et analyse automatiquement de grosses quantités de données sur le web. Contrairement aux extracteurs classiques qui tournent sur ton ordi, les cloud crawlers bossent dans des data centers puissants, avec une rapidité et une échelle imbattables.

2. Quelle différence entre un cloud crawler et un extracteur web classique ?

Les cloud crawlers bossent dans le cloud, gèrent des milliers de pages en même temps, prennent en charge des formats complexes (images, PDF…) et ne demandent ni maintenance ni matos local. Les extracteurs classiques sont limités par ton ordi et sont mieux pour les petits projets simples.

3. Les principaux avantages d’un cloud crawler ?

Les cloud crawlers permettent de collecter des données vite et en masse, gèrent les sites complexes, sont accessibles partout et proposent des fonctions avancées comme la planification ou l’extraction boostée par l’IA. Parfait pour les boîtes qui ont besoin de data fraîche et exploitable rapidement.

4. Comment marche le cloud crawler de Thunderbit pour les pros ?

Le cloud crawler de Thunderbit te permet de configurer une extraction en quelques clics—sans coder. Tu peux extraire des données de sites, PDF ou images, les enrichir via l’IA, et les exporter direct vers Excel, Google Sheets, Notion ou Airtable. Il est pensé pour les non-techs qui veulent des résultats, sans prise de tête.

5. Le cloud crawling, c’est sécurisé et conforme aux lois sur la vie privée ?

Oui, les cloud crawlers sérieux comme Thunderbit utilisent des connexions chiffrées et respectent les meilleures pratiques de sécurité. Pense toujours à extraire uniquement des données publiques et à respecter les conditions d’utilisation et la réglementation.

Prêt à tester le potentiel d’un cloud crawler ? et découvre la collecte de données à grande échelle, boostée par le cloud.

Pour aller plus loin