Tu t’es déjà retrouvé devant une tonne de pages web, en te disant que ce serait génial de tout rassembler dans un tableau en deux temps trois mouvements ? Rassure-toi, tu n’es pas le seul ! Aujourd’hui, la demande de données web dans le monde pro est juste énorme. Que ce soit pour surveiller les prix des concurrents, se faire une base de prospects ou analyser les tendances de l’immobilier, tout le monde veut transformer Internet en infos utiles. Et au centre de cette chasse à la donnée ? Le scrapper Python – devenu l’outil chouchou de tous ceux qui veulent automatiser la collecte d’infos.

Mais soyons honnêtes : si les scrappers Python sont bien connus des devs, pour la plupart des pros, ça reste un truc un peu mystérieux, genre boîte noire pleine de lignes de code. C’est ce que j’ai remarqué chez , où notre but, c’est de rendre l’extraction de données web aussi simple que commander un plat à emporter. Alors, on va éclaircir tout ça. C’est quoi exactement un scrapper Python ? Pourquoi c’est devenu la référence pour extraire des données web ? Et comment les nouveaux outils boostés à l’IA rendent cette superpuissance accessible à tout le monde, même sans aucune expérience en code ?

Scrapper Python : c’est quoi et à quoi ça sert ?

Pour faire simple, un scrapper Python (parfois écrit « scraper ») c’est un programme en Python qui automatise l’extraction d’infos depuis des sites web. Imagine un assistant digital super efficace : tu lui files une liste de sites, il va les visiter un par un, lit leur contenu et récupère pile les données que tu veux – noms, prix, emails, etc. – pour tout ranger dans un format bien propre, genre un tableur.

Pourquoi c’est si précieux pour les boîtes ? Parce que collecter des données à la main, c’est long, chiant et plein d’erreurs. Copier-coller des infos depuis des centaines (ou milliers) de pages web, c’est pas juste chronophage, c’est carrément décourageant. Les scrappers Python te libèrent de cette galère et te permettent de rassembler des tonnes de données en quelques minutes au lieu de plusieurs jours. Comme le dit un guide, un extracteur web « récupère automatiquement des infos sur des sites et les transforme en données structurées (genre un tableur) » – fini les sessions de copier-coller interminables, fini les occasions ratées ().

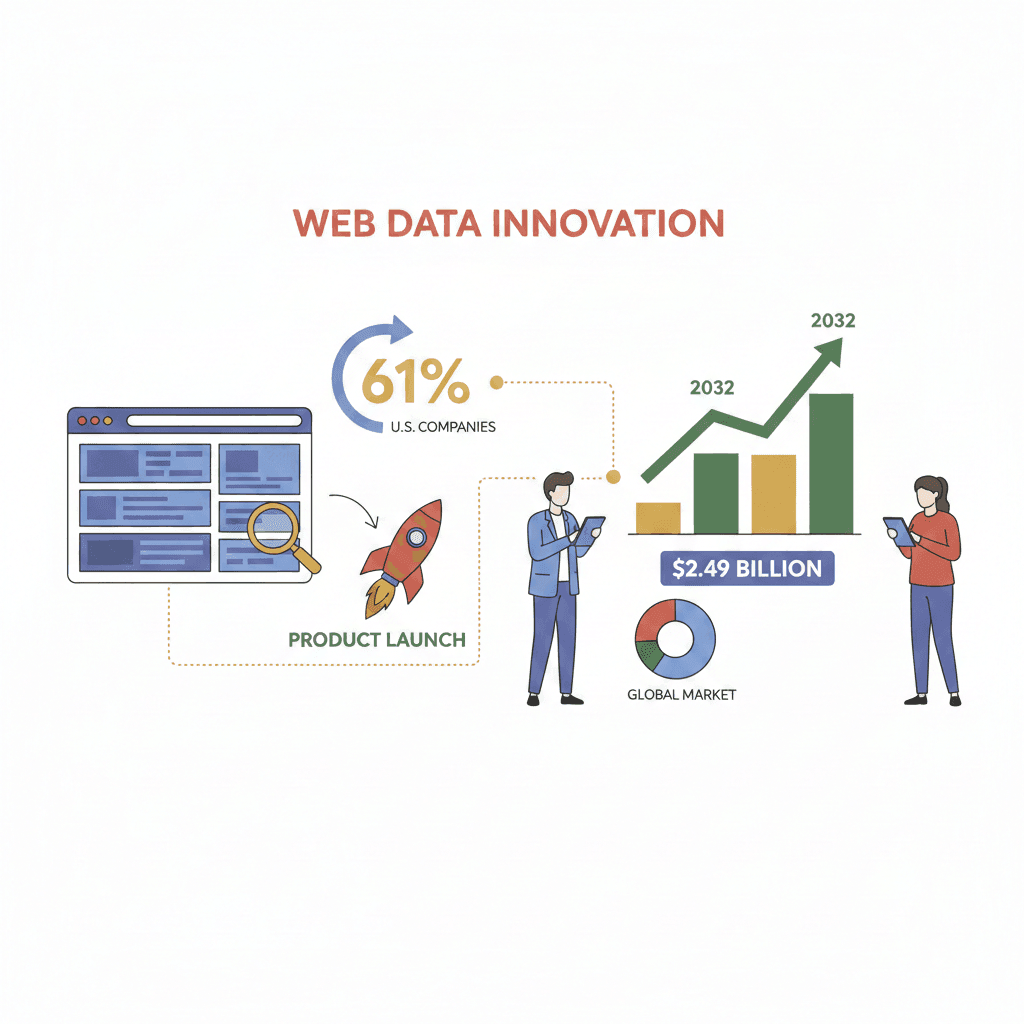

Et la demande explose. Près de utilisent maintenant des données web externes pour lancer de nouveaux produits ou fonctionnalités, et le marché mondial des logiciels d’extraction web devrait atteindre . Si tu ne profites pas de ces données, il y a de grandes chances que tes concurrents le fassent déjà.

Les super-pouvoirs d’un scrapper Python

Mais concrètement, un scrapper Python, ça sert à quoi ? À plein de trucs, en fait. Voilà pourquoi c’est un outil de collecte de données redoutable :

- Extraire tout type de données : Que ce soit des tableaux produits, des listes d’emails, des numéros de téléphone, des images ou même des métadonnées cachées, un scrapper Python peut choper quasiment tout ce qui est visible (ou pas) sur une page web. Besoin de coordonnées pour générer des leads ? Fastoche. D’infos produits, de prix ou d’avis clients ? Aucun souci.

- Gérer des tâches répétitives et à grande échelle : Un scrapper peut traiter des centaines ou des milliers de pages automatiquement et régulièrement. Il peut cliquer sur les boutons « Suivant », scroller des pages infinies, et il ne fatigue jamais.

- Suivre les liens et explorer les sous-pages : Tu veux plus de détails ? Les scrappers peuvent naviguer d’une page principale vers chaque fiche produit ou profil, extraire des données plus riches et tout regrouper dans un seul fichier.

- Gérer la pagination et le contenu dynamique : Beaucoup de sites modernes chargent leurs données via JavaScript ou les répartissent sur plusieurs pages. Les scrappers Python (avec les bonnes bibliothèques) savent gérer ça, en cliquant ou en attendant le chargement du contenu comme un vrai utilisateur.

- Exporter dans des formats adaptés à l’entreprise : Une fois les données collectées, elles sont exportées en CSV, Excel, JSON, ou même direct dans des bases de données – prêtes à être analysées, partagées ou intégrées à ton CRM.

Des bibliothèques Python comme , Scrapy ou Selenium rendent tout ça possible, mais il faut quand même quelques bases techniques.

Pourquoi le scrapper Python est-il imbattable pour collecter des données ?

Soyons clairs : la différence entre collecter à la main et utiliser un scrapper Python, c’est comme creuser un tunnel à la cuillère ou à la perceuse. Voilà pourquoi :

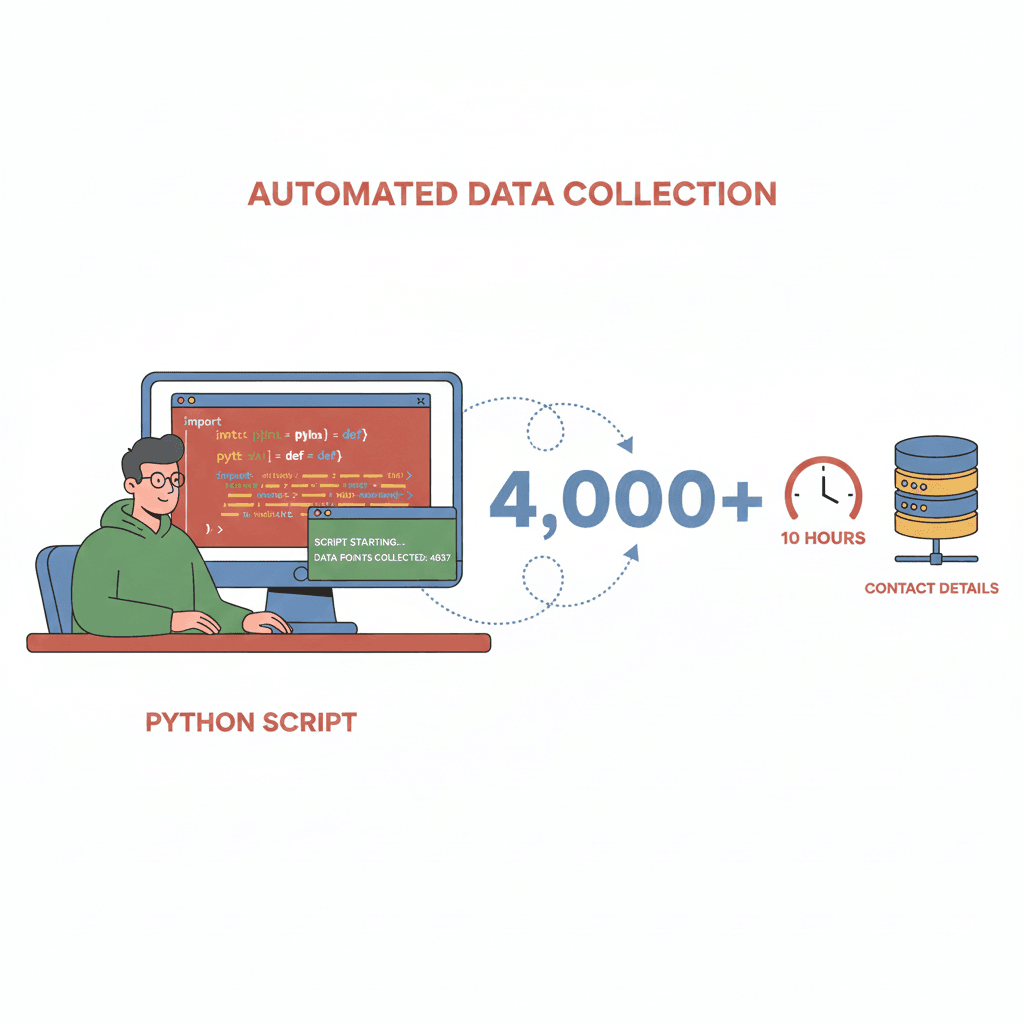

- Vitesse et efficacité : Ce qui prendrait des jours à une personne, un scrapper le fait en quelques minutes. Un dev a pu collecter – un boulot qui aurait pris des semaines à la main.

- Passage à l’échelle : Tu veux surveiller tous les produits d’un site concurrent ou agréger des milliers d’avis ? Les scrappers gèrent des volumes énormes, page après page, sans broncher.

- Précision et régularité : Les scrappers suivent tes instructions à la lettre, à chaque fois. Pas d’erreurs de saisie, pas d’oublis, pas de « je finirai demain ». Avec l’IA, la précision des données peut atteindre même sur des sites complexes ou dynamiques.

- Réduction des coûts : En automatisant ce qui demandait avant des équipes entières ou des prestataires chers, les scrappers peuvent .

Petit aperçu des usages courants en entreprise et du retour sur investissement :

| Cas d'usage | Données extraites | Impact business (ROI) |

|---|---|---|

| Génération de leads commerciaux | Noms, emails, téléphones depuis des annuaires | Constitution rapide de listes de prospects ; 4 000+ leads en quelques heures (Medium) |

| Veille tarifaire (e-commerce) | Prix concurrents, niveaux de stock | Tarification dynamique ; +4 % de ventes chez John Lewis (Browsercat) |

| Veille marché & concurrence | Fiches produits, avis, sentiment | 73 % des entreprises scrappent pour l'analyse marché (Browsercat) |

| Analyse immobilière | Annonces, prix, caractéristiques | Estimations et tendances à jour pour agents/investisseurs |

| Agrégation d'actualités & études | Titres, articles, données de recherche | Flux d'infos en temps réel pour les analystes ; plus besoin de chercher manuellement |

Scrapper Python en action : exemples concrets par secteur

Voyons comment les scrappers Python sont utilisés dans la vraie vie :

E-commerce & distribution

Les enseignes utilisent des scrappers pour surveiller les prix des concurrents, la dispo des produits et les avis clients. Environ font du scraping pour ajuster leurs prix en temps réel. Résultat : des ajustements plus rapides et parfois une vraie hausse des ventes.

Prospection commerciale

Les équipes commerciales scrappent des annuaires publics, des sites d’assos ou même Google Maps pour se faire des listes de prospects. Pourquoi acheter des bases de données dépassées quand tu peux collecter des milliers de contacts tout frais en une journée ?

Immobilier

Agents et investisseurs scrappent des sites comme Zillow ou Realtor.com pour suivre les annonces, les prix et les tendances. Un vrai avantage sur un marché qui bouge tout le temps.

Veille & analyse de marché

Les analystes scrappent sites d’actu, forums et réseaux sociaux pour suivre les tendances, le sentiment et les mouvements de la concurrence. Lire chaque article à la main ? Impossible à grande échelle.

Les galères classiques

Évidemment, tout n’est pas toujours simple. Les scrappers doivent gérer :

- Contenu dynamique : Les sites qui chargent les données via JavaScript.

- Mesures anti-scraping : CAPTCHAs, blocages d’IP, connexion obligatoire.

- Changements de structure : Une refonte du site peut casser ton script du jour au lendemain.

Mais comme tu vas le voir, les nouveaux outils boostés à l’IA rendent tout ça beaucoup plus simple à contourner.

Côté technique : comment marche un scrapper Python (sans prise de tête)

On va démystifier le truc. Voilà comment fonctionne un scrapper Python, version simple :

- Envoi d’une requête : Le scrapper « demande » le contenu de la page au site (comme ton navigateur).

- Récupération du contenu : Il reçoit le code HTML (et peut charger du contenu dynamique avec Selenium, par exemple).

- Analyse des données : Avec des bibliothèques comme BeautifulSoup, il parcourt le HTML pour trouver pile les infos que tu veux – noms de produits, prix, emails, etc.

- Nettoyage et structuration : Les données sont mises au propre – suppression des espaces en trop, formats uniformes, validation des numéros de téléphone, etc.

- Export : Le fichier final est sauvegardé en CSV, Excel ou tout autre format utile pour la boîte.

Si le web est une immense bibliothèque, un scrapper Python c’est comme un robot-bibliothécaire que tu programmes : « Trouve tous les livres sur les baskets, copie le prix et l’auteur, et mets-les dans mon tableau. » Le robot ne s’ennuie jamais, ne rate aucun livre, et bosse à la vitesse de l’éclair.

La courbe d’apprentissage : quelles compétences pour utiliser un scrapper Python ?

Voilà le revers de la médaille : les scrappers Python sont puissants, mais il faut quand même apprendre un peu.

- Bases en programmation : Il faut savoir coder en Python, installer des bibliothèques et déboguer.

- Comprendre le HTML/CSS : Scrapper, ça veut dire inspecter les pages web pour viser les bons éléments – genre « trouver la balise

<h2>avec la classe ‘product-title’ ». - Gérer les subtilités du web : Beaucoup de sites utilisent JavaScript, demandent une connexion ou essaient de bloquer les robots. Il faut donc adapter ses scripts.

- Maintenance continue : Les sites changent. Ton script peut casser et il faudra le réparer – parfois au pire moment.

Pour les non-techs, ça peut sembler insurmontable. Même pour les devs, écrire et maintenir des scrappers, ça prend du temps. Pas étonnant que beaucoup finissent par revenir au bon vieux copier-coller.

Thunderbit : la puissance du scrapper Python pour tout le monde

C’est là que ça devient vraiment cool – parce que c’est exactement ce qu’on a voulu résoudre avec . Thunderbit, c’est une qui te donne toute la puissance d’un scrapper Python, sans écrire une seule ligne de code.

Voilà comment Thunderbit te simplifie la vie :

- Suggestions de champs par l’IA : Un clic, et l’IA de Thunderbit analyse la page, propose les champs les plus pertinents à extraire (« Nom du produit », « Prix », « Email »…), et les nomme automatiquement.

- Extraction en 2 clics : Tu vérifies les colonnes suggérées, tu cliques sur « Extraire » et Thunderbit fait tout le reste – pagination, sous-pages, contenu dynamique, tout est géré.

- Export partout : Tu exportes direct tes données vers Excel, Google Sheets, Notion, Airtable, CSV ou JSON – sans frais cachés, sans prise de tête.

- Extraction des sous-pages : Besoin de détails en plus ? Thunderbit peut visiter chaque sous-page (fiche produit, profil LinkedIn…) et enrichir ton tableau automatiquement.

- Aucune config, aucune maintenance : Tu installes l’extension et c’est parti. Si un site change, tu recliques sur « Suggestions IA » – Thunderbit s’adapte en temps réel.

C’est comme avoir un scrapper Python en mode service, mais pensé pour tout le monde – pas juste pour les « magiciens du Python ».

Comment Thunderbit casse les barrières techniques

Comparons le workflow d’un scrapper Python classique à celui de Thunderbit :

| Étape | Scrapper Python traditionnel | Extracteur Web IA Thunderbit |

|---|---|---|

| Compétences requises | Programmation Python, HTML/CSS, débogage | Aucune – simple navigation web |

| Temps de mise en place | De quelques heures à plusieurs jours | Quelques minutes (installer, cliquer, c'est parti) |

| Gestion de la pagination | Boucles de code, débogage lors des changements | L'IA détecte et clique automatiquement |

| Extraction des sous-pages | Code spécifique pour chaque site | Un clic – l'IA gère la navigation et la fusion |

| Contenu dynamique | Selenium/Playwright, gestion de navigateurs | Extraction dans le navigateur – ce que vous voyez |

| Export vers Excel/Sheets | Code d'export, gestion des formats | Export en un clic vers Excel, Sheets, Notion, Airtable |

| Maintenance | Mise à jour du code à chaque changement de site | Cliquez sur « Suggestions IA » – l'IA s'adapte |

En résumé, Thunderbit enlève toute la complexité technique. Si tu sais naviguer sur Internet, tu sais utiliser Thunderbit.

IA + scrapper Python : des données plus propres et plus utiles

C’est là que l’innovation prend tout son sens. Thunderbit ne se contente pas de copier des données – il utilise l’IA pour les rendre plus intelligentes :

- Extraction intelligente : L’IA reconnaît les schémas, même sur des pages complexes ou dynamiques, et améliore la précision jusqu’à .

- Filtrage du bruit : L’IA de Thunderbit vire le contenu inutile (pubs, pieds de page, navigation) pour ne garder que l’essentiel.

- Normalisation des données : Tu veux tous les numéros de téléphone au format E.164 ? Des adresses uniformisées ? Des catégories produits bien rangées ? Ajoute une consigne personnalisée – l’IA s’en occupe pendant l’extraction.

- Enrichissement en temps réel : Traduire un texte, résumer une description, catégoriser un produit ? Les prompts IA de Thunderbit font tout ça à la volée, dès l’extraction.

Résultat : des jeux de données plus propres, prêts à l’emploi, sans passer des heures à tout nettoyer à la main.

Surmonter les galères du scraping avec les outils Python modernes

L’extraction web n’est pas sans obstacles, mais les outils récents rendent tout ça bien plus simple à gérer :

- Mesures anti-scraping : L’approche de Thunderbit, qui imite le comportement d’un vrai utilisateur, déclenche rarement des blocages ou des CAPTCHAs. Pour les sites plus coriaces, le mode cloud utilise des IPs rotatives et des techniques anti-bot en arrière-plan.

- Contenu dynamique : Si tu le vois dans ton navigateur, Thunderbit peut l’extraire – fini les galères avec le JavaScript ou les données cachées.

- Changements de structure : Si un site change, tu cliques juste sur « Suggestions IA ». L’IA de Thunderbit s’adapte, sans que tu aies à toucher une ligne de code.

- Qualité des données : Déduplication, gestion des erreurs et nettoyage IA intégrés garantissent des données fiables à chaque extraction.

- Conformité : Thunderbit encourage une extraction responsable – limitation du rythme, respect du robots.txt, et exclusion par défaut des données sensibles.

Bref, les galères techniques qui réservaient le scraping aux devs sont maintenant gérées automatiquement.

Conclusion : comment choisir la bonne solution d’extraction de données pour ta boîte

À retenir ? Un scrapper Python est un outil ultra-puissant pour transformer le web sauvage et non structuré en données business bien rangées et exploitables. C’est la colonne vertébrale de la prospection, de l’e-commerce, de la veille marché, et plus encore. Mais jusqu’à récemment, il fallait être à l’aise avec le code pour en profiter.

Aujourd’hui, avec des outils IA comme , cette barrière saute. Que tu sois commercial, marketeur ou agent immo, tu peux extraire les données qu’il te faut – en quelques minutes, sans code, sans config, sans maintenance. Juste des résultats.

Quand choisir un scrapper Python classique ? Si tu as une équipe tech dédiée, des besoins ultra-spécifiques ou une intégration profonde à tes systèmes internes, le sur-mesure peut avoir du sens. Mais pour 99 % des pros, les outils IA comme Thunderbit sont plus rapides, plus simples et plus fiables.

Envie de tester par toi-même ? et commence à extraire tes premières données web dès aujourd’hui. Tu te demanderas comment tu faisais avant !

Tu veux aller plus loin sur le scraping, l’extraction de données par IA ou l’automatisation business ? Va faire un tour sur le pour plus de guides, d’astuces et de retours d’expérience.

FAQ

1. C’est quoi un scrapper Python et en quoi c’est différent du copier-coller manuel ?

Un scrapper Python est un programme qui automatise l’extraction de données depuis des sites web, pour les transformer en formats structurés comme des tableurs. Contrairement au copier-coller manuel, il bosse à grande échelle, beaucoup plus vite et avec moins d’erreurs.

2. Quelles données peut-on extraire avec un scrapper Python ?

Les scrappers Python peuvent extraire des tableaux, listes, images, emails, numéros de téléphone, prix, détails produits, avis clients, etc. – bref, tout ce qui est visible (ou caché) sur une page web.

3. Faut-il savoir coder pour utiliser un scrapper Python ?

Les scrappers Python classiques demandent de savoir programmer. Mais des outils IA comme permettent à n’importe qui d’extraire des données en quelques clics, sans coder.

4. Comment Thunderbit simplifie le scraping pour les non-techs ?

Thunderbit utilise l’IA pour détecter automatiquement les champs de données, gérer la pagination et les sous-pages, et exporter les résultats vers Excel, Google Sheets, Notion ou Airtable. Tu décris ce que tu veux, Thunderbit s’occupe du reste.

5. Le scraping web, c’est légal et safe pour un usage pro ?

Le scraping web est légal s’il est fait de façon responsable : extraction de données publiques uniquement, respect des conditions d’utilisation des sites, et exclusion des données sensibles ou perso. Thunderbit encourage une pratique éthique et propose des options pour rester dans les clous.

Tu veux voir à quel point l’extraction de données web peut être simple ? et transforme le web en avantage business dès aujourd’hui.

Pour aller plus loin