Vous êtes-vous déjà demandé comment Google arrive à connaître chaque recoin du web, ou comment votre comparateur de prix préféré actualise les offres en temps réel ? Derrière tout ça, il y a des « araignées » numériques qui sillonnent Internet sans relâche, cartographiant ce vaste labyrinthe pour qu’on puisse trouver ce qu’on cherche en un clin d’œil. Aujourd’hui, près de la moitié du trafic internet est générée par des robots — principalement des crawlers — qui collectent, indexent et organisent discrètement l’information mondiale pour les moteurs de recherche, les modèles d’IA et les entreprises ().

Après plusieurs années à développer des outils d’automatisation et d’IA chez Thunderbit, j’ai pu voir à quel point comprendre les crawlers peut donner un vrai coup d’avance à n’importe quelle boîte. Que tu bosses dans la vente, l’e-commerce ou l’opérationnel, savoir ce qu’est un crawler — et comment des solutions modernes comme fonctionnent — te permet d’accéder à de nouvelles données, d’automatiser ta veille et de prendre une longueur d’avance sur la concurrence. On va lever le voile sur ces travailleurs de l’ombre et voir pourquoi ils sont devenus incontournables.

Qu’est-ce qu’un crawler ? Explications simples

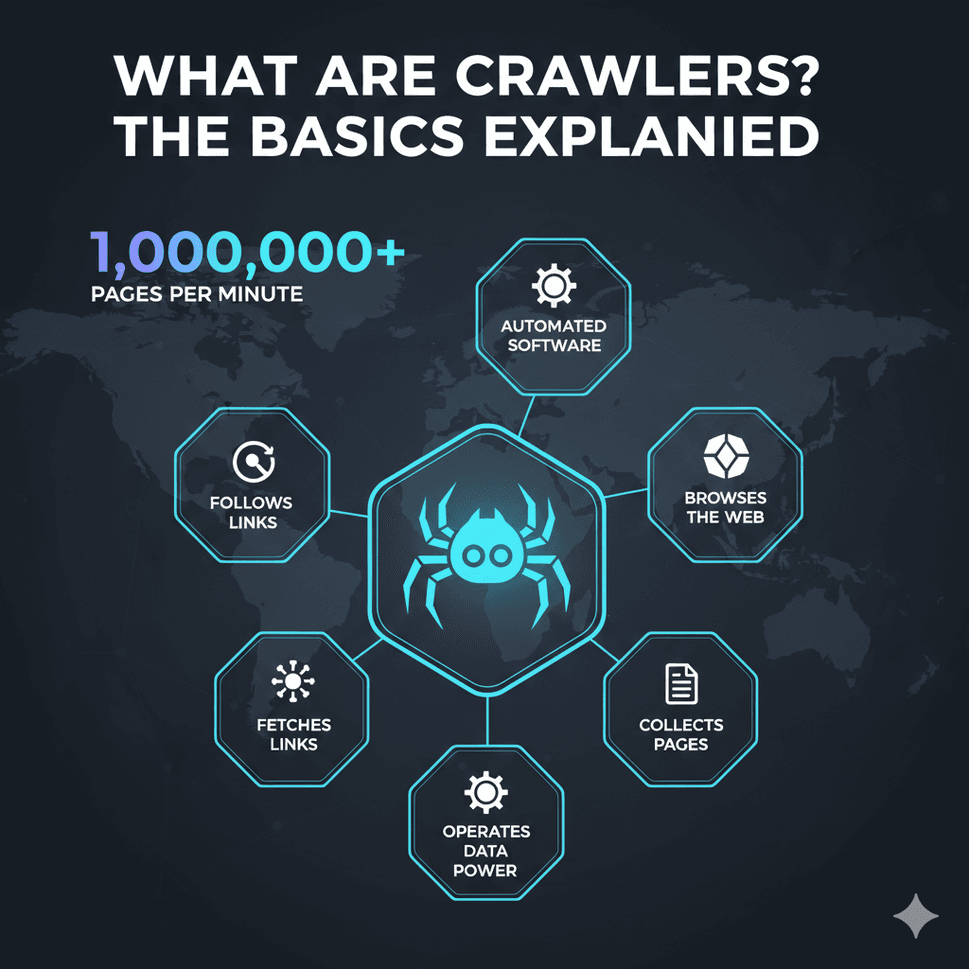

Alors, concrètement, qu’est-ce qu’un crawler ? Pour faire simple, un crawler (aussi appelé spider ou bot) est un programme qui parcourt automatiquement le web, visite des pages, suit les liens et collecte des infos au passage. Imagine les crawlers comme des bibliothécaires infatigables d’Internet : ils visitent les sites, lisent leur contenu et classent tout pour qu’on puisse le retrouver plus tard (, ).

Pour te donner une image : imagine le web comme une immense ville, et les crawlers comme des livreurs qui commencent à une adresse, notent ce qu’ils trouvent, puis suivent chaque panneau (lien hypertexte) vers la prochaine destination. Ils répètent ce processus à l’infini, construisant une carte géante et consultable d’Internet.

Parmi les crawlers les plus connus, on retrouve Googlebot (pour Google Search), Bingbot (pour Bing), et les nouveaux bots d’IA comme GPTBot (pour les modèles d’OpenAI). Ces robots indexent des centaines de milliards de pages web — rien que l’index de Google occupe plus de 100 millions de gigaoctets (). Sans crawlers, moteurs de recherche, assistants IA et de nombreux outils pros ne pourraient tout simplement pas tourner.

Pourquoi les crawlers sont-ils essentiels ? Fonctions clés et usages en entreprise

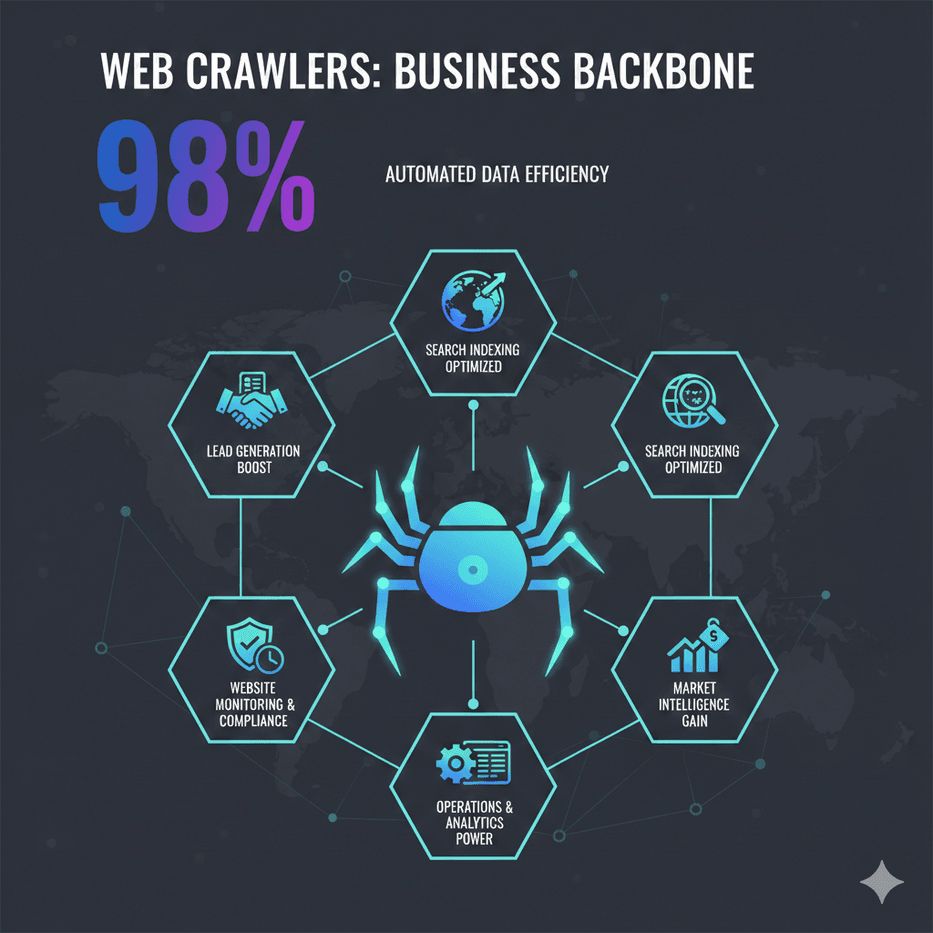

Les crawlers ne servent pas qu’aux moteurs de recherche : ils sont au cœur de plein de process métiers modernes. Voici leurs principaux atouts :

- Indexation pour les moteurs de recherche : Les crawlers scannent le web pour que les moteurs de recherche puissent fournir des résultats pertinents instantanément. Si ton site n’est pas exploré, il n’apparaîtra pas sur Google ou Bing ().

- Extraction de données & veille concurrentielle : Les entreprises utilisent des crawlers (et extracteurs) pour collecter les prix des concurrents, des fiches produits, des avis, etc. Par exemple, le distributeur britannique John Lewis a augmenté ses ventes de 4 % grâce à la veille tarifaire, tandis que ASOS a doublé ses ventes internationales en exploitant des données web régionales ().

- Surveillance de sites & conformité : Les crawlers peuvent surveiller ton site ou ceux de tes concurrents pour détecter des changements — nouveaux produits, mises à jour de prix, vérifications de conformité…

- Génération de leads : Les équipes commerciales s’appuient sur les crawlers pour collecter des contacts depuis des annuaires ou des bases d’entreprises, automatisant ainsi une tâche autrefois très chronophage.

- Opérations & analytique : De la gestion des stocks à l’agrégation d’annonces immobilières, les crawlers alimentent tableaux de bord et outils d’analyse pour des décisions plus éclairées.

Voici un tableau récapitulatif des usages des crawlers selon les équipes métier :

| Équipe/Fonction | Cas d’usage du crawler | Bénéfice obtenu |

|---|---|---|

| Ventes & Prospection | Collecte d’informations de contact sur des sites ou annuaires | Génération automatisée de listes de leads ; croissance du pipeline sans saisie manuelle |

| Marketing/Veille | Surveillance des sites concurrents et des avis en ligne | Veille marché en temps réel ; stratégie mieux informée |

| E-commerce & Retail | Extraction de prix et suivi de produits chez les concurrents | Tarification dynamique ; marges et revenus optimisés |

| Opérations/Produit | Détection de changements sur les sites pour conformité ou mises à jour | Contrôle qualité ; réaction rapide aux évolutions externes |

| Data & IA | Collecte massive de données pour l’analytique ou l’entraînement IA | Analyses avancées ; jeux de données pour le machine learning |

()

Comment fonctionnent les crawlers ? Étapes clés

Même si ça paraît très tech, le fonctionnement d’un crawler reste assez simple () :

- URLs de départ : Le crawler commence avec une liste d’adresses web initiales (les « seeds »), comme une page d’accueil, un sitemap ou une liste fournie.

- Collecte : Il visite chaque URL et télécharge le code HTML de la page (comme le ferait ton navigateur).

- Analyse & extraction : Il lit la page, extrait les infos utiles (texte, métadonnées, liens) et note chaque hyperlien trouvé.

- Stockage & indexation : Les données extraites sont enregistrées dans une base ou un index, prêtes à être recherchées ou analysées.

- Suivi des liens : Tous les nouveaux liens sont ajoutés à la file d’attente, et le crawler recommence, explorant sans fin le web.

Les crawlers modernes sont respectueux : ils consultent le fichier robots.txt d’un site pour savoir ce qu’ils peuvent explorer, et limitent leur fréquence pour ne pas surcharger les serveurs (). Les moteurs de recherche utilisent même des « budgets de crawl » pour décider à quelle fréquence revisiter un site, en privilégiant les pages importantes ou fréquemment mises à jour.

Crawler vs. Extracteur : quelle différence ?

On confond souvent « crawling » et « scraping », mais il y a une nuance importante () :

- Le crawling consiste à découvrir et indexer un maximum de pages (cartographier le web).

- Le scraping vise à extraire des données précises de pages ciblées (par exemple, récupérer les prix sur une fiche produit).

En pratique, les deux sont souvent complémentaires : on crawl un site pour trouver toutes les pages produits, puis on scrape chaque page pour obtenir les détails (prix, stock…). Pour les entreprises, comprendre cette différence permet de choisir le bon outil.

Types de crawlers : des moteurs de recherche aux bots IA

Tous les crawlers ne se ressemblent pas. Voici les principaux types que tu peux croiser () :

- Crawlers de moteurs de recherche : Les géants comme Googlebot, Bingbot, Baidu Spider, Yandex Bot. Leur mission : indexer tout le web pour le rendre consultable.

- Crawlers spécialisés : Conçus pour explorer des pages sur un sujet précis (ex : uniquement les sites d’emploi ou l’actualité sur le climat).

- Crawlers incrémentaux : Optimisés pour détecter et récupérer uniquement les contenus nouveaux ou mis à jour, afin d’économiser de la bande passante.

- Crawlers du web profond : Capables d’accéder à des contenus cachés derrière des formulaires, des connexions ou des pages non référencées.

- Crawlers d’audit de site : Outils comme Screaming Frog ou l’audit de site SEMrush, utilisés pour analyser son propre site (SEO, qualité…).

- Crawlers de veille/comparaison : Utilisés par les entreprises pour suivre les prix, les changements de produits ou la conformité sur des sites ciblés.

- Crawlers IA : Les nouveaux venus — comme GPTBot d’OpenAI ou CCBot de Common Crawl — conçus pour collecter des données pour l’IA ou utiliser l’IA pour décider quoi et comment explorer ().

Les crawlers IA changent déjà la donne. En 2025, les bots liés à l’IA représentent environ 30 % du trafic web — et cette part ne fait qu’augmenter ().

Limites des crawlers traditionnels et solutions modernes

À mesure que le web devient plus complexe, les crawlers classiques se heurtent à de vrais obstacles :

- Défenses anti-bot : CAPTCHAs, blocages d’IP, limitations de fréquence, fingerprinting… Plus de 95 % des échecs de scraping sont dus à ces protections ().

- Contenus dynamiques : Beaucoup de sites chargent leurs données en JavaScript ou via scroll infini, ce que les crawlers basiques ne gèrent pas. Les navigateurs sans interface et l’IA sont devenus indispensables ().

- Changements fréquents de sites : Au moindre changement de structure, les extracteurs classiques plantent et il faut tout corriger à la main. La maintenance devient vite galère.

- Échelle et rapidité : Explorer des millions de pages rapidement demande des systèmes distribués et du cloud — bien au-delà d’un simple ordi.

- Enjeux juridiques et éthiques : Respecter le

robots.txt, la vie privée et les conditions d’utilisation est plus crucial que jamais.

Les solutions modernes — surtout celles boostées à l’IA — relèvent ces défis. Elles s’adaptent aux changements de structure, simulent de vrais navigateurs et comprennent les pages comme le ferait un humain. Par exemple, les extracteurs IA savent maintenant extraire des données de PDF, d’images ou de pages web non standards, ce qui les rend bien plus costauds et polyvalents.

Thunderbit : des crawlers optimisés pour le web d’aujourd’hui

C’est là que Thunderbit entre en jeu. Chez , on a conçu un extracteur web et crawler IA pensé pour le web complexe et changeant de 2025. Notre but ? Rendre la donnée web accessible à tout le monde, pas seulement aux développeurs.

Qu’est-ce qui fait la différence avec Thunderbit ?

- Simplicité IA : Clique sur « Suggérer des champs IA » et l’IA de Thunderbit analyse la page, propose les meilleures colonnes (ex : « Nom du produit », « Prix », « Note ») et configure l’extraction. Pas besoin de coder, pas de prise de tête avec le HTML — il suffit de cliquer ().

- Gestion des pages complexes et de niche : L’IA de Thunderbit s’adapte aux structures atypiques, aux contenus dynamiques et même aux pages non conventionnelles. Parfait pour extraire des données de sites spécialisés ou de pages qui font planter les extracteurs classiques.

- Crawling de sous-pages & pagination : Besoin de détails sur chaque fiche produit d’une catégorie ? Thunderbit suit automatiquement les liens, explore les sous-pages et fusionne les données dans un seul tableau — sans configuration manuelle ().

- Modes cloud & navigateur : Opte pour le scraping cloud rapide sur les sites publics, ou le mode navigateur pour les sites qui demandent une connexion ou une protection renforcée.

- Export gratuit des données : Exporte tes données direct vers Excel, Google Sheets, Airtable ou Notion — sans frais cachés ().

- No-code, pensé pour l’entreprise : Thunderbit s’adresse aux équipes métier — ventes, marketing, e-commerce, opérations — qui veulent des résultats, pas une formation technique.

Thunderbit vs. crawlers traditionnels : comparatif des fonctionnalités

Voici comment Thunderbit se positionne face aux outils classiques :

| Fonctionnalité | Thunderbit (IA) | Crawlers/Extracteurs classiques |

|---|---|---|

| Temps de configuration | 2 clics grâce à l’IA | Configuration manuelle, apprentissage long |

| Adaptabilité | L’IA s’ajuste aux changements | Casse au moindre changement de structure |

| Gestion du contenu dynamique | Oui (IA & navigateur headless) | Limité ou configuration manuelle |

| Crawling sous-pages/pagination | Intégré, automatique | Script manuel nécessaire |

| Export de données | Gratuit vers Excel, Sheets, Notion | Souvent payant ou limité |

| Compétences requises | Aucune (no-code) | Compétences techniques ou code |

| Maintenance | Minime (l’IA réapprend) | Corrections manuelles fréquentes |

| Modèles pour sites populaires | 1 clic, toujours à jour | Communautaires, parfois obsolètes |

| Prix | Gratuité, offres abordables | Souvent cher pour toutes les fonctions |

()

Thunderbit de l’intérieur : des fonctionnalités innovantes pour simplifier le crawling

Zoom sur ce qui rend Thunderbit unique :

- Suggérer des champs IA : Mon coup de cœur ! Un clic, et l’IA de Thunderbit lit la page, propose les colonnes pertinentes et crée même les prompts d’extraction. Fini les sélecteurs CSS à deviner ou les noms de champs à inventer.

- Crawling de sous-pages : Après avoir extrait une page liste, clique sur « Extraire les sous-pages » et Thunderbit visite chaque page liée (ex : fiche produit), enrichissant automatiquement ton tableau.

- Modèles instantanés : Pour les sites populaires (Amazon, Zillow, Instagram, Shopify), Thunderbit propose des modèles prêts à l’emploi — aucun paramétrage, résultats immédiats.

- Extracteurs gratuits d’emails, téléphones et images : Besoin de récupérer tous les emails ou images d’une page ? Thunderbit le fait en un clic, gratuitement.

- Extraction planifiée : Programme des extractions récurrentes (quotidiennes, hebdomadaires…) en langage naturel. Parfait pour la veille tarifaire ou le suivi de marché.

- Scraping cloud ou navigateur : Choisis le mode adapté — cloud pour la rapidité, navigateur pour les sites complexes.

Thunderbit est déjà adopté par plus de 30 000 utilisateurs dans le monde, des entrepreneurs solos aux grandes entreprises (). Et bien sûr, une te permet de tester sans engagement.

Gérer l’accès des crawlers : bonnes pratiques pour les entreprises

Que tu sois propriétaire de site ou utilisateur de crawlers, gérer les accès est essentiel :

Pour les propriétaires de sites :

- Utilise

robots.txtpour définir les règles d’accès — bloque les sections sensibles, autorise les bots utiles, bloque les indésirables (). - Ajoute des balises meta (

noindex,nofollow) pour contrôler l’indexation. - Surveille le trafic des bots et ajuste la fréquence si besoin.

- Trouve le bon équilibre entre SEO (visibilité) et protection du contenu — ne bloque pas les bots utiles (comme Googlebot).

Pour les entreprises qui utilisent des crawlers :

- Respecte toujours le

robots.txtet les conditions d’utilisation — l’éthique avant tout. - Identifie ton bot avec un user-agent clair.

- Limite la fréquence des requêtes pour ne pas surcharger les serveurs.

- Privilégie les API quand elles existent, et ne scrape que les données publiques.

- Surveille l’impact de ton crawler et ajuste si besoin.

Conclusion : le rôle clé des crawlers dans la stratégie data des entreprises

Les crawlers sont passés du statut de simples « araignées » à celui de colonne vertébrale de la recherche, de l’IA et de l’intelligence économique. Dans un monde piloté par la donnée, comprendre ce qu’est un crawler — et comment exploiter des outils modernes comme Thunderbit — ouvre de nouvelles perspectives à toute équipe. Que tu veuilles booster ton SEO, automatiser ta veille ou bâtir des pipelines commerciaux plus malins, les crawlers sont tes alliés invisibles.

Et à mesure que le web évolue, les entreprises les plus performantes seront celles qui sauront adopter ces outils — de façon responsable et créative. Prêt à voir ce que le crawling IA peut apporter à ton activité ? et lance-toi. Pour plus de conseils et de guides pratiques, va faire un tour sur le .

FAQ

1. C’est quoi un crawler web, simplement ?

Un crawler web est un programme qui parcourt automatiquement Internet, visite des sites, suit les liens et collecte des infos. C’est un peu comme un bibliothécaire numérique qui classe les pages web pour qu’elles soient retrouvées par les moteurs de recherche ou utilisées par les entreprises.

2. Quelle différence entre crawler et extracteur ?

Les crawlers servent à découvrir et indexer un maximum de pages (cartographier le web), tandis que les extracteurs récupèrent des données précises sur des pages ciblées. En pratique, ils sont souvent complémentaires : on crawl pour trouver les pages, on extrait pour obtenir les infos utiles.

3. Pourquoi les entreprises utilisent-elles des crawlers ?

Les entreprises s’en servent pour le SEO (s’assurer que leur site est indexé), la veille concurrentielle (suivi des prix, des produits), la génération de leads, la recherche de marché et l’automatisation de la collecte de données pour l’analytique ou l’IA.

4. Quels sont les défis des crawlers traditionnels ?

Les crawlers classiques galèrent face aux protections anti-bot (CAPTCHAs, blocages IP), aux contenus dynamiques (JavaScript, scroll infini), aux changements fréquents de sites et aux contraintes légales/éthiques. Les outils modernes comme Thunderbit, boostés à l’IA, sont pensés pour surmonter ces obstacles.

5. Comment Thunderbit simplifie-t-il le crawling pour les pros ?

Thunderbit utilise l’IA pour reconnaître automatiquement la structure des pages, suggérer les champs de données et gérer des tâches complexes comme l’extraction de sous-pages ou de contenus dynamiques. C’est sans code, rapide à configurer et l’export se fait direct vers tes outils favoris — rendant la donnée web accessible à tous, pas seulement aux développeurs.

Envie de mettre les crawlers au service de ton entreprise ? et découvre à quel point la donnée web peut devenir simple.

Pour aller plus loin