Le web, c’est un vrai trésor de données : que tu bosses dans la vente, l’e-commerce ou l’analyse de marché, extraire des infos en ligne est devenu un réflexe pour trouver des leads, surveiller les prix ou garder un œil sur la concurrence. Mais il y a un hic : plus le scraping se répand, plus les sites se blindent. Aujourd’hui, plus de , et sont devenus la norme. Si tu as déjà vu ton script Python tourner nickel pendant 20 minutes avant de se prendre une pluie d’erreurs 403, tu sais à quel point ça peut être rageant.

Avec plusieurs années dans le SaaS et l’automatisation, j’ai vu des projets de scraping passer de « finger in the nose » à « pourquoi je me fais bloquer partout ? » en deux temps trois mouvements. On va donc aller droit au but : je vais t’expliquer comment faire du web scraping sans blocage en Python, partager les techniques et bouts de code qui marchent vraiment, et te montrer quand il vaut mieux passer à une solution IA comme . Que tu sois un pro de Python ou juste curieux, tu repartiras avec une vraie boîte à outils pour collecter des données sans te faire griller.

C’est quoi le web scraping sans blocage en Python ?

En gros, scraper sans se faire bloquer, c’est extraire des données de sites web sans déclencher leurs alarmes anti-bots. En Python, ça va bien plus loin qu’une simple boucle requests.get() : il faut se fondre dans la masse, copier le comportement humain et rester discret face aux radars des sites.

Pourquoi Python ? : syntaxe limpide, écosystème de dingue (requests, BeautifulSoup, Scrapy, Selenium), et super flexible, du petit script au crawler distribué. Mais ce succès a un revers : beaucoup de systèmes anti-bots sont calibrés pour repérer les schémas typiques des scripts Python.

Pour scraper tranquille, il faut donc aller plus loin. Comprendre comment les sites flairent les robots, et comment passer sous le radar — tout en restant clean et dans les clous.

Pourquoi éviter les blocages, c’est vital pour tes projets de scraping Python

Se faire bloquer, ce n’est pas juste un bug technique : ça peut mettre à l’arrêt tout un process métier. Regarde un peu :

| Cas d’usage | Conséquence d’un blocage |

|---|---|

| Génération de leads | Listes de prospects incomplètes ou obsolètes, opportunités perdues |

| Veille tarifaire | Changements de prix concurrents manqués, décisions tarifaires erronées |

| Agrégation de contenu | Données de veille ou d’actualité incomplètes |

| Intelligence de marché | Manque de visibilité sur la concurrence ou le secteur |

| Annonces immobilières | Données de biens inexactes ou dépassées, occasions manquées |

Quand ton extracteur se fait bloquer, ce n’est pas juste des données qui manquent : tu perds du temps, tu prends des risques de non-conformité, et parfois tu prends de mauvaises décisions parce que tes infos sont incomplètes. Et vu que , la fiabilité, c’est la base.

Comment les sites flairent et bloquent les extracteurs Python

Les sites sont devenus super malins pour repérer les robots. Voilà les techniques anti-scraping que tu vas croiser (, ) :

- Blocage d’IP : Trop de requêtes de la même IP ? Blocage direct.

- Vérif du User-Agent et des headers : Les headers par défaut de Python (genre

python-requests/2.25.1) sont grillés en deux secondes. - Limitation de débit : Trop de requêtes d’un coup = ralentissement ou ban.

- CAPTCHAs : Les fameux « prouvez que vous êtes humain ».

- Analyse comportementale : Les sites matent les actions trop répétitives ou trop régulières.

- Honeypots : Champs ou liens invisibles que seuls les bots activent.

- Fingerprinting navigateur : Le site collecte des infos sur ton navigateur et ton appareil pour flairer l’automatisation.

- Gestion des cookies et sessions : Les robots qui zappent les cookies ou les sessions se font vite repérer.

C’est comme à l’aéroport : si tu fais comme tout le monde, tu passes tranquille. Si tu te fais remarquer, contrôle renforcé direct.

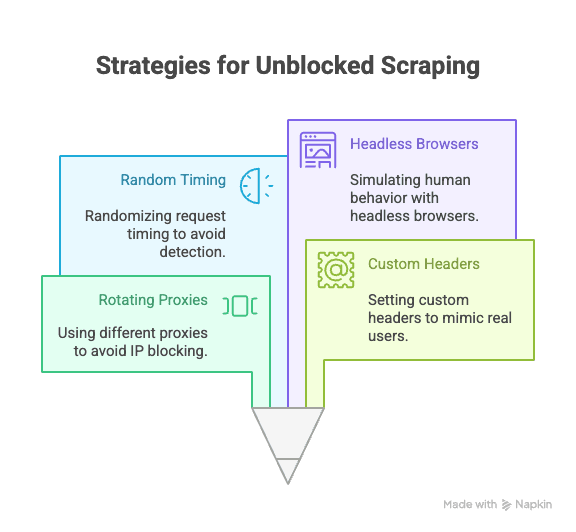

Les techniques Python incontournables pour scraper sans se faire bloquer

Passons à l’action : comment éviter les blocages quand tu scrapes avec Python ? Voici les stratégies à connaître :

Rotation des proxies et des adresses IP

Pourquoi c’est crucial : Si toutes tes requêtes viennent de la même IP, tu vas te faire bloquer vite fait. Utiliser des proxies rotatifs, ça permet de répartir les requêtes et de brouiller les pistes.

Comment faire en Python :

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...plus de proxies

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # traitement de la réponsePour être vraiment tranquille, privilégie les services de proxies payants (résidentiels ou rotatifs) ().

Personnalisation du User-Agent et des headers

Pourquoi c’est important : Les headers par défaut de Python, c’est le signal d’alarme pour les sites. Il faut faire comme un vrai navigateur en personnalisant le user-agent et les autres headers.

Exemple de code :

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "fr-FR,fr;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)Pour être encore plus discret, fais tourner plusieurs user-agents ().

Randomisation du rythme et des schémas de requêtes

Pourquoi c’est important : Les robots sont rapides et prévisibles, les humains sont lents et imprévisibles. Ajoute des pauses et varie tes parcours de navigation.

Astuce Python :

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # Pause aléatoire entre 2 et 7 secondesAvec Selenium, tu peux aussi simuler des clics et des scrolls aléatoires.

Gestion des cookies et des sessions

Pourquoi c’est important : Beaucoup de sites exigent des cookies ou des tokens de session pour accéder au contenu. Les robots qui les ignorent se font griller.

Comment faire en Python :

1import requests

2session = requests.Session()

3response = session.get(url)

4# la session gère automatiquement les cookiesPour des cas plus complexes, Selenium permet de capturer et réutiliser les cookies.

Simulation du comportement humain avec des navigateurs headless

Pourquoi c’est important : Certains sites analysent le JavaScript, les mouvements de souris ou le scroll pour vérifier si tu es bien humain. Les navigateurs headless comme Selenium ou Playwright peuvent simuler tout ça.

Exemple avec Selenium :

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))Ça permet de passer sous le radar de l’analyse comportementale et de gérer les contenus dynamiques ().

Stratégies avancées : contourner les CAPTCHAs et les honeypots en Python

Les CAPTCHAs sont là pour stopper les robots. Certaines librairies Python peuvent résoudre les CAPTCHAs simples, mais la plupart des scrapers avancés passent par des services externes (genre 2Captcha ou Anti-Captcha) pour les résoudre moyennant finance ().

Exemple d’intégration :

1# Pseudocode pour utiliser l’API 2Captcha

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# Attendre la solution, puis soumettre avec ta requêteLes honeypots sont des champs ou liens invisibles que seuls les robots activent. Évite d’interagir avec tout ce qui n’est pas visible dans un navigateur classique ().

Construire des headers solides avec les librairies Python

Au-delà du user-agent, tu peux faire tourner et personnaliser d’autres headers (Referer, Accept, Origin, etc.) pour mieux te fondre dans la masse.

Avec Scrapy :

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'fr-FR,fr;q=0.9',

6 # Autres headers

7 }

8 }Avec Selenium : Utilise des profils de navigateur ou des extensions pour définir les headers, ou injecte-les via JavaScript.

Garde tes headers à jour : inspire-toi des requêtes réelles que tu vois dans les DevTools de ton navigateur.

Quand le scraping Python classique ne suffit plus : la montée en puissance des anti-bots

La vérité, c’est que plus le scraping se développe, plus les sites se blindent. . L’IA, les seuils dynamiques et le fingerprinting rendent la vie dure, même aux scripts Python les plus affûtés ().

Parfois, même le meilleur code ne suffit plus. Il faut alors changer de stratégie.

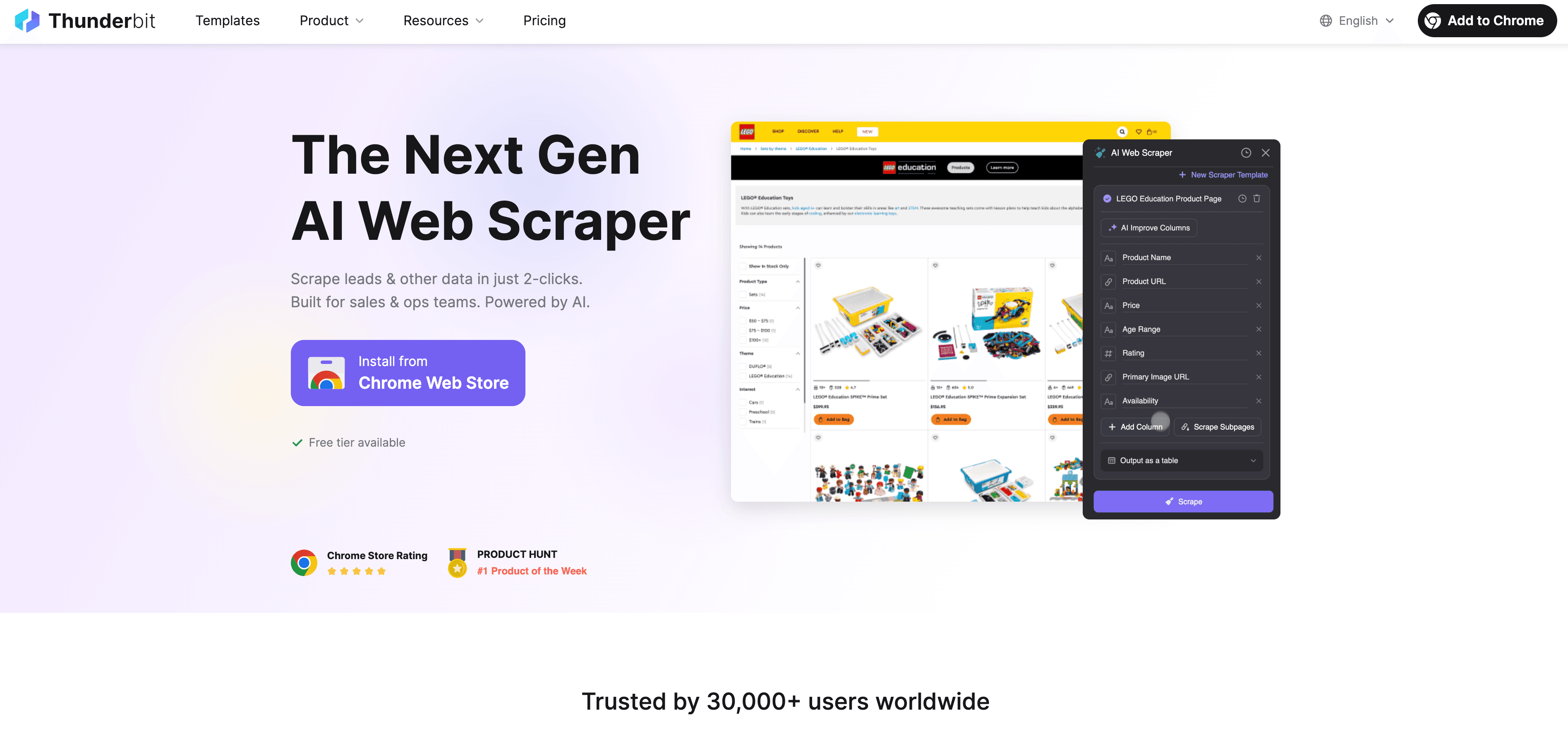

Thunderbit : l’alternative IA à l’extraction Python

Quand Python atteint ses limites, prend le relais : un extracteur web IA, sans code, pensé pour les pros. Fini la galère des proxies, headers ou CAPTCHAs : l’agent IA de Thunderbit lit la page, suggère les champs à extraire et gère tout, de la navigation aux sous-pages jusqu’à l’export des données.

Pourquoi Thunderbit sort du lot ?

- Suggestion IA des champs : Clique sur « Suggérer les champs IA » et Thunderbit analyse la page, propose les colonnes et génère les instructions d’extraction.

- Extraction des sous-pages : Thunderbit visite chaque sous-page (fiche produit, profil LinkedIn, etc.) et enrichit ton tableau automatiquement.

- Scraping cloud ou navigateur : Choisis la méthode la plus rapide : cloud pour les sites publics, navigateur pour les pages protégées par login.

- Extraction programmée : Planifie tes extractions pour garder tes données à jour sans prise de tête.

- Templates instantanés : Pour les sites populaires (Amazon, Zillow, Shopify…), Thunderbit propose des modèles prêts à l’emploi.

- Export gratuit des données : Exporte vers Excel, Google Sheets, Airtable ou Notion sans frais cachés.

Thunderbit, c’est déjà plus de , sans écrire une seule ligne de code.

Comment Thunderbit t’aide à éviter les blocages et à automatiser l’extraction

L’IA de Thunderbit ne fait pas que copier l’humain : elle s’adapte en temps réel à chaque site, ce qui limite à fond les risques de blocage. Concrètement :

- L’IA s’adapte aux changements de mise en page : Fini les scripts qui plantent à chaque update du site.

- Gestion automatique des sous-pages et de la pagination : Thunderbit suit les liens et les listes paginées comme un vrai utilisateur.

- Scraping cloud à grande échelle : Jusqu’à 50 pages extraites en même temps, super rapide.

- Aucune maintenance, aucun code : Passe plus de temps à analyser tes données, pas à déboguer.

Pour aller plus loin, découvre .

Python vs Thunderbit : quel outil choisir ?

Comparons les deux, point par point :

| Fonctionnalité | Scraping Python | Thunderbit |

|---|---|---|

| Temps de mise en place | Moyen à élevé (scripts, proxies, etc.) | Ultra rapide (2 clics, l’IA gère tout) |

| Compétences requises | Savoir coder | Aucun prérequis technique |

| Fiabilité | Variable (fragile aux changements) | Élevée (l’IA s’adapte) |

| Risque de blocage | Modéré à élevé | Faible (l’IA imite l’utilisateur) |

| Scalabilité | Faut coder ou passer au cloud | Cloud et extraction par lots intégrés |

| Maintenance | Fréquente (changements de site, blocages) | Minime (ajustement automatique IA) |

| Export des données | Manuel (CSV, base de données) | Direct vers Sheets, Notion, Airtable, CSV |

| Coût | Gratuit (mais chronophage) | Offre gratuite, forfaits payants pour l’échelle |

Quand utiliser Python :

- Tu veux un contrôle total, une logique sur-mesure ou intégrer à d’autres scripts Python.

- Tu cibles des sites peu protégés.

Quand choisir Thunderbit :

- Tu veux aller vite, avoir de la fiabilité et zéro prise de tête.

- Tu scrapes des sites complexes ou qui changent souvent.

- Tu ne veux pas gérer les proxies, les CAPTCHAs ou le code.

Tutoriel : configurer un scraping Python sans blocage, étape par étape

Prenons un cas concret : extraire des données produits d’un site, tout en appliquant les bonnes pratiques anti-blocage.

1. Installer les librairies nécessaires

1pip install requests beautifulsoup4 fake-useragent2. Préparer ton script

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # Mets tes URLs ici

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "fr-FR,fr;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # Extraction des données ici

16 print(soup.title.text)

17 else:

18 print(f"Bloqué ou erreur sur {url} : {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # Pause aléatoire3. Ajouter la rotation des proxies (optionnel)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # Plus de proxies

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...suite du code4. Gérer les cookies et les sessions

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...suite du code5. Conseils de dépannage

- Si tu as beaucoup d’erreurs 403/429, ralentis tes requêtes ou change de proxies.

- Si tu tombes sur des CAPTCHAs, tente Selenium ou un service de résolution de CAPTCHA.

- Vérifie toujours le fichier

robots.txtet les conditions d’utilisation du site.

Conclusion & points clés à retenir

Le web scraping en Python, c’est puissant, mais le risque de blocage est toujours là, surtout avec les anti-bots qui progressent. Pour limiter les blocages, combine les bonnes pratiques techniques (proxies rotatifs, headers réalistes, pauses aléatoires, gestion des sessions, navigateurs headless) et respecte toujours l’éthique et les règles des sites.

Mais parfois, même les meilleures astuces Python ne suffisent plus. C’est là que des outils IA comme font la différence : extraction sans code, résistante aux blocages, pensée pour les pros.

Envie de voir à quel point le scraping peut être simple ? et teste-la, ou va faire un tour sur notre pour plus d’astuces et de tutos.

FAQ

1. Pourquoi les sites bloquent-ils les extracteurs Python ?

Les sites veulent protéger leurs données, éviter la surcharge de serveurs et empêcher les abus automatisés. Les scripts Python sont faciles à repérer s’ils gardent les headers par défaut, ignorent les cookies ou envoient trop de requêtes trop vite.

2. Quelles sont les meilleures méthodes pour éviter d’être bloqué en Python ?

Utilise des proxies rotatifs, personnalise les user-agents et headers, varie le rythme des requêtes, gère cookies et sessions, et simule le comportement humain avec Selenium ou Playwright.

3. Comment Thunderbit limite-t-il les blocages par rapport à un script Python ?

Thunderbit s’appuie sur l’IA pour s’adapter à la structure des sites, imiter la navigation humaine et gérer automatiquement sous-pages et pagination. Il réduit les risques de blocage en s’ajustant en temps réel, sans code ni proxy à gérer.

4. Quand privilégier Python ou un outil IA comme Thunderbit ?

Utilise Python si tu as besoin de logique sur-mesure, d’intégration avec d’autres scripts ou si le site est peu protégé. Prends Thunderbit pour une extraction rapide, fiable et évolutive, surtout sur des sites complexes ou qui changent souvent.

5. Le web scraping est-il légal ?

Le scraping est légal pour les données publiques, mais il faut respecter les conditions d’utilisation, la vie privée et la loi. N’extrais jamais de données sensibles ou privées, et agis toujours de façon responsable.

Prêt à scraper plus malin ? Essaie Thunderbit et dis adieu aux blocages.

Pour aller plus loin :

- Scraper Google News avec Python : guide pas à pas

- Créer un outil de suivi de prix Best Buy avec Python

- 14 méthodes pour scraper sans se faire bloquer

- 10 conseils pour éviter les blocages lors du web scraping