Le web scraping s’est tranquillement imposé comme l’arme secrète des équipes business d’aujourd’hui. Que tu bosses en vente, en opérations ou que tu fasses de la veille concurrentielle, savoir extraire des données de sites web, c’est devenu un vrai must. Mais qu’est-ce qui a changé récemment ? Le web est devenu ultra interactif : dashboards dynamiques, scroll infini, contenus qui pop après un clic… Et derrière tout ça, il y a JavaScript, le langage qui fait tourner la majorité des sites qu’on visite.

Après des années dans le SaaS et l’automatisation, j’ai vu JavaScript et Node.js passer du petit bonus pour devs à l’outil central pour l’extraction de données. Les chiffres sont clairs : , et le marché mondial du web scraping explose jusqu’en 2030 (). Dans ce guide, je t’explique ce que ça veut dire concrètement de faire du web scraping avec JavaScript et Node.js, pourquoi c’est devenu incontournable, et surtout comment même sans être dev, tu peux t’y mettre grâce à des outils comme . Que tu sois technique ou non, c’est le moment de transformer le bazar du web en vraies opportunités business.

Qu’est-ce que le web scraping avec JavaScript ? Les bases à connaître

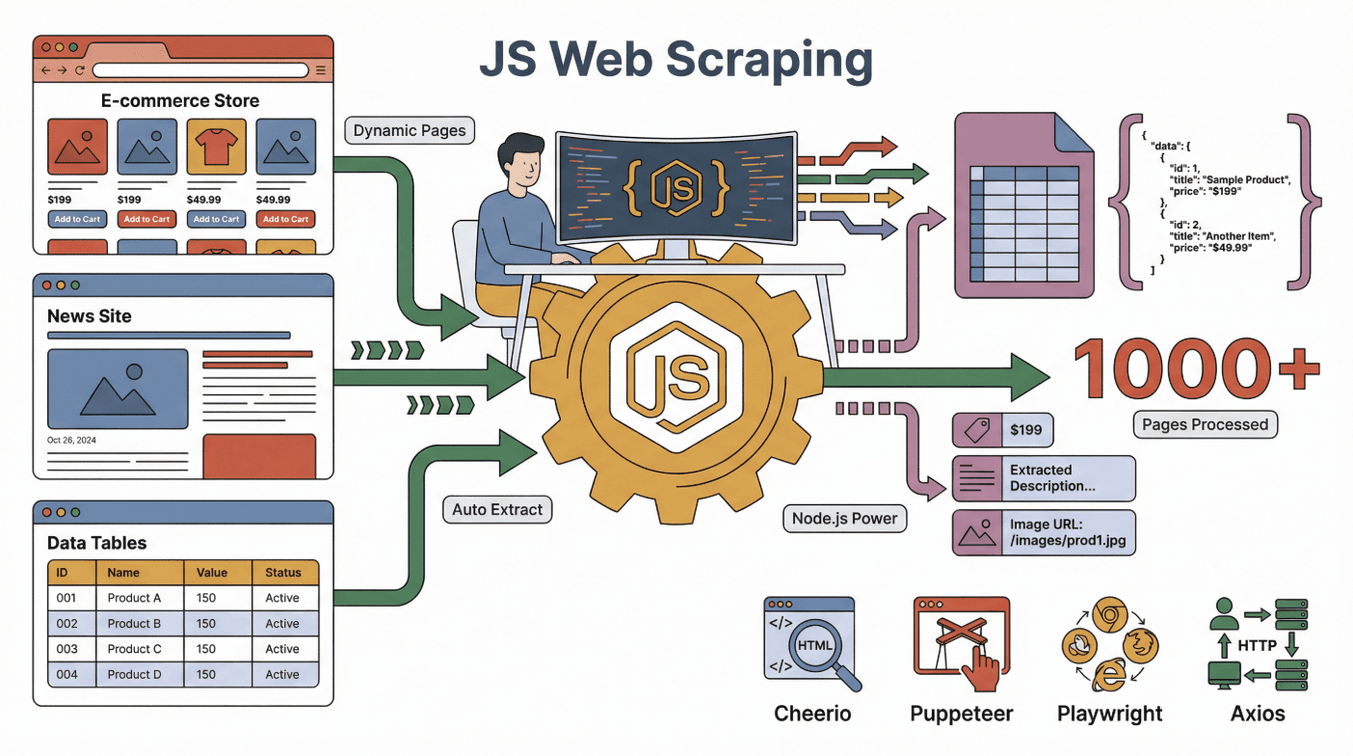

On commence par le début. Le web scraping avec JavaScript, c’est utiliser JavaScript (souvent avec Node.js) pour extraire automatiquement des infos de sites web. Imagine un assistant digital qui visite un site, lit la page et copie ce qui t’intéresse dans un tableau — sauf que cet assistant peut gérer des milliers de pages, ne fatigue jamais et sait même cliquer sur des boutons ou remplir des formulaires.

On commence par le début. Le web scraping avec JavaScript, c’est utiliser JavaScript (souvent avec Node.js) pour extraire automatiquement des infos de sites web. Imagine un assistant digital qui visite un site, lit la page et copie ce qui t’intéresse dans un tableau — sauf que cet assistant peut gérer des milliers de pages, ne fatigue jamais et sait même cliquer sur des boutons ou remplir des formulaires.

JavaScript est super puissant parce que c’est le langage des navigateurs pour construire et mettre à jour les pages web. Node.js permet de faire tourner JavaScript en dehors du navigateur, ce qui rend possible l’automatisation de tâches comme :

- Charger une page web (même si elle est interactive ou dynamique)

- Cliquer sur des boutons, scroller ou attendre que du contenu apparaisse

- Extraire du texte, des images, des prix, des emails ou n’importe quel élément visible

Quelques outils stars pour le web scraping en JavaScript :

- : Parfait pour analyser et extraire des données de pages HTML statiques (c’est un peu le jQuery côté serveur).

- : Automatise un vrai navigateur Chrome, idéal pour les sites dynamiques qui demandent des interactions.

- : Comme Puppeteer, mais encore plus costaud pour automatiser plusieurs navigateurs.

- : Pour faire des requêtes HTTP et récupérer des pages web ou des APIs.

La magie, c’est quand tu combines tout ça : Axios ou Puppeteer récupère la page, Cheerio analyse le HTML, et Node.js gère l’ensemble.

Pages statiques vs dynamiques : pourquoi JavaScript est devenu indispensable

- Pages statiques : Le contenu est fixe et chargé dès l’ouverture. Facile à extraire avec des outils simples.

- Pages dynamiques : Le contenu s’affiche après le chargement initial, souvent via JavaScript. Là, il faut automatiser le navigateur (avec Puppeteer par exemple) pour accéder aux données ().

Vu que la majorité des sites modernes (Amazon, LinkedIn, Zillow…) utilisent du contenu dynamique, le scraping basé sur JavaScript est devenu la norme pour choper les infos qu’il te faut.

Pourquoi choisir JavaScript pour le web scraping ? Les avantages clés

Si tu traînes sur les forums de devs, tu verras souvent le débat : JavaScript vs Python vs Ruby vs Go pour le scraping. Voici mon retour après des années à gratter le web :

Les points forts de JavaScript

- Gestion native du contenu dynamique : JavaScript, c’est le langage du navigateur, donc parfait pour les sites modernes bourrés d’interactions ().

- Automatisation du navigateur : Des outils comme Puppeteer et Playwright peuvent cliquer, scroller, remplir des formulaires — comme un vrai humain.

- Familiarité avec le front-end : Si ton équipe fait déjà du dev web, elle peut réutiliser ses skills pour le scraping ().

- Concurrence et rapidité : Node.js gère plein de tâches en même temps, ce qui accélère le traitement de gros volumes ().

- Écosystème riche : Des milliers de librairies, tutos et une communauté hyper active.

JavaScript face à Python, Ruby et Go

| Langage | Contenu dynamique | Automatisation navigateur | Communauté | Vitesse | Idéal pour |

|---|---|---|---|---|---|

| JavaScript | Excellente | Excellente | Énorme | Rapide | Sites interactifs, équipes front-end |

| Python | Bonne (avec Selenium/Playwright) | Bonne | Énorme | Rapide | APIs, sites statiques, data science |

| Ruby | Moyenne | Limitée | Niche | Moyenne | Scraping simple de sites statiques |

| Go | Limitée | Limitée | En croissance | Très rapide | Scraping à grande échelle, back-end |

Pour extraire des données de sites modernes et interactifs, JavaScript (avec Node.js) est souvent la solution la plus efficace (). Python n’est pas loin derrière, mais pour les pages très dynamiques, JavaScript reste le boss ().

Les outils incontournables pour le web scraping avec JavaScript et Node.js

Voici les outils de base pour scraper en JavaScript :

- Node.js : Le moteur qui fait tourner JavaScript hors du navigateur. C’est ton QG.

- Cheerio : Pour analyser le HTML et sélectionner les éléments (genre : « file-moi tous les noms de produits de cette page »).

- Puppeteer/Playwright : Pour automatiser un navigateur et gérer le contenu dynamique, les connexions et les interactions complexes.

- Axios/Fetch : Pour récupérer directement des pages web ou des APIs.

- Autres utilitaires : Librairies pour exporter les données (CSV, Excel), gérer les proxies ou planifier les extractions.

Comment tout ça marche ensemble ? Imagine Puppeteer comme ton navigateur-robot, Cheerio comme ton détective de données, et Node.js comme le chef d’orchestre qui gère tout le monde.

Comment fonctionne le web scraping avec JavaScript : le process étape par étape

On démystifie le truc. Voilà à quoi ressemble un workflow classique de scraping en JavaScript :

- Envoyer une requête : Utilise Axios ou Puppeteer pour charger la page web.

- Attendre le contenu : Si la page est dynamique, attends que JavaScript ait fini de charger (Puppeteer « voit » la page finale).

- Extraire les données : Utilise Cheerio ou les APIs du navigateur pour sélectionner et copier les infos que tu veux.

- Gérer la pagination/sous-pages : Clique sur « Suivant » ou suis les liens pour récupérer plus de données.

- Exporter les données : Sauvegarde tes résultats en CSV, Excel, Google Sheets ou dans une base de données.

En image : C’est comme envoyer un super stagiaire visiter chaque page, prendre des notes et tout ranger dans un tableau.

Contenu statique vs dynamique : quelle différence ?

- Exemple de site statique : Un blog où tous les articles sont visibles dans le HTML. Cheerio + Axios suffisent.

- Exemple de site dynamique : Un site e-commerce où les prix s’affichent après avoir scrollé. Là, il faut Puppeteer ou Playwright pour « voir » les prix finaux ().

Astuce : Si ton script récupère une page blanche, c’est sûrement du contenu dynamique — il est temps de sortir Puppeteer.

Thunderbit : le web scraping sans code, avec la puissance de JavaScript

C’est là que ça devient vraiment cool, surtout si tu n’es pas dev. Chez , notre but c’est de rendre le web scraping niveau JavaScript accessible à tout le monde, pas juste aux codeurs.

Notre vision : Ton extracteur web doit « comprendre les tâches comme un stagiaire » — tu expliques ce que tu veux, l’IA s’occupe du reste.

Comment Thunderbit démocratise le scraping JavaScript

- Suggestions IA de champs : Un clic, et l’IA de Thunderbit analyse la page, propose les données à extraire et configure l’extracteur pour toi.

- Extraction de sous-pages : Besoin de détails ? Thunderbit peut visiter chaque sous-page (fiche produit, profil…) et enrichir automatiquement ton tableau.

- Modèles instantanés : Pour les sites populaires (Amazon, Zillow, Shopify…), choisis un modèle et c’est parti — aucune config à faire.

- Export gratuit des données : Envoie tes données direct vers Excel, Google Sheets, Airtable ou Notion — sans frais cachés.

Exemple concret : J’ai vu des équipes commerciales utiliser Thunderbit pour collecter des centaines de prospects depuis un annuaire dynamique, avec emails et numéros de téléphone, en quelques clics — sans écrire une seule ligne de code. C’est comme avoir un dev JavaScript dans l’équipe, sans embaucher.

Cas d’usage populaires : le web scraping JavaScript pour les ventes et les opérations

Le web scraping en JavaScript, ce n’est pas réservé aux experts techniques. Voilà comment il est utilisé au quotidien :

| Équipe | Cas d’usage | Résultat |

|---|---|---|

| Ventes | Génération de leads depuis des annuaires | 10x plus de prospects, prêts à être importés dans le CRM |

| E-commerce | Veille tarifaire sur la concurrence | Tarification dynamique, réactivité accrue |

| Opérations | Agrégation d’inventaires | Vue unifiée des références chez les fournisseurs |

| Immobilier | Agrégation d’annonces immobilières | Données marché à jour dans un seul tableau |

| Marketing | Analyse d’avis et de sentiments | Insights rapides, ciblage de campagnes optimisé |

Exemple : Une équipe e-commerce m’a confié avoir économisé plus de 20 heures par semaine en surveillant les prix concurrents avec Thunderbit, ce qui leur permet d’ajuster leurs tarifs quasiment en temps réel ().

Aspects éthiques et légaux du web scraping JavaScript

On aborde le sujet qui fâche : Le web scraping, c’est légal ? En bref : oui, si tu extrais des données publiques et que tu respectes les règles du site (). Mais il y a quelques principes à suivre :

- Respecter le robots.txt : Si un site interdit le scraping, respecte-le.

- Lire les conditions d’utilisation : Certains sites interdisent clairement l’extraction de données.

- Protéger la vie privée : N’extrais pas de données perso ou sensibles.

- Ne pas surcharger les serveurs : Va mollo sur le rythme.

Les décisions de justice récentes tendent à autoriser le scraping de données publiques, mais le droit d’auteur et la protection des données restent à surveiller (). En cas de doute, demande à un juriste.

Bon réflexe : N’extrais que des données que tu serais prêt à partager publiquement, et cite toujours tes sources.

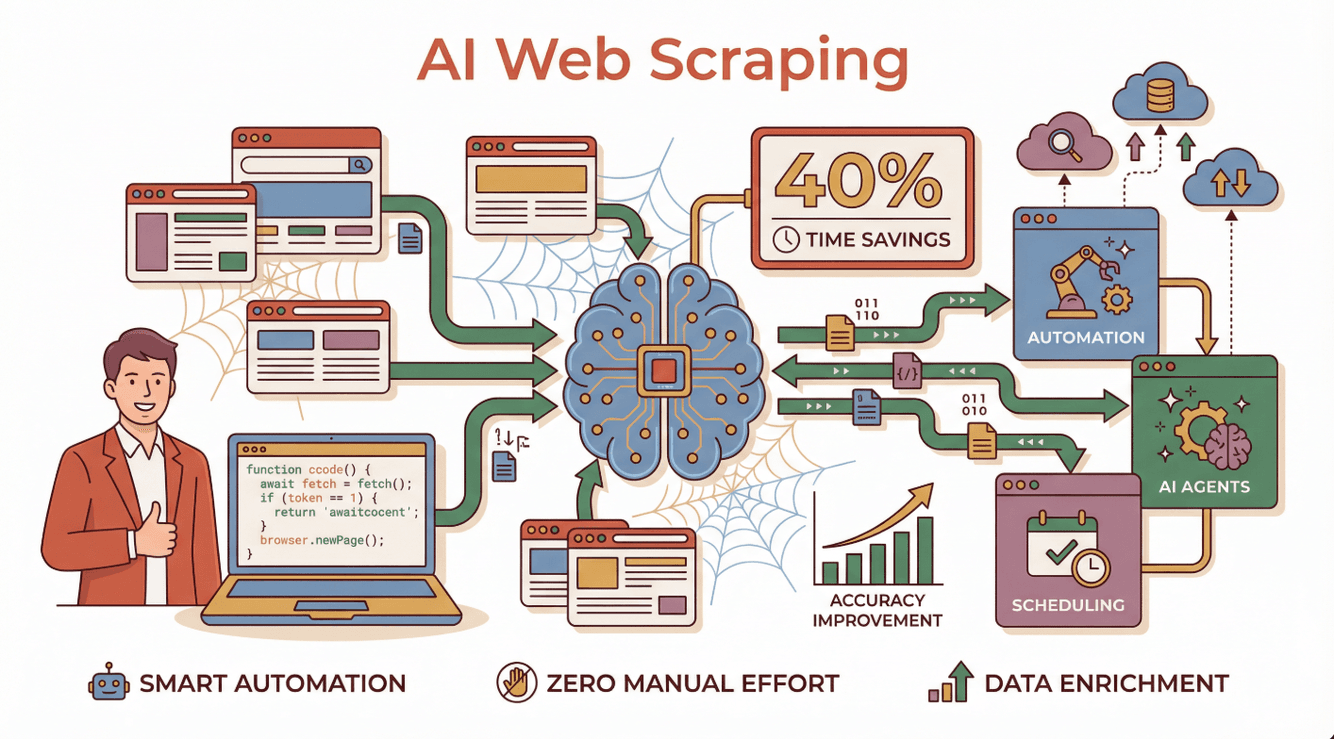

L’avenir du web scraping JavaScript : IA et automatisation

Là, ça va très vite. L’IA transforme le web scraping, autrefois galère et technique, en un process intelligent et automatisé. Les boîtes qui adoptent des extracteurs boostés à l’IA gagnent , sont plus précises et arrivent à gérer même les sites dynamiques les plus tordus ().

Là, ça va très vite. L’IA transforme le web scraping, autrefois galère et technique, en un process intelligent et automatisé. Les boîtes qui adoptent des extracteurs boostés à l’IA gagnent , sont plus précises et arrivent à gérer même les sites dynamiques les plus tordus ().

Concrètement, ça donne quoi ?

- Agents IA capables de lire des instructions en langage naturel, de s’adapter aux changements de site et de corriger les erreurs ().

- Programmation automatique : tu reçois des données fraîches chaque jour, sans rien faire.

- Enrichissement des données : l’IA peut catégoriser, résumer, voire traduire les données extraites en temps réel.

Thunderbit est à la pointe de cette révolution, permettant à chacun de créer et d’exécuter des extracteurs web boostés à l’IA — sans code, sans prise de tête.

Envie d’en savoir plus sur l’avenir du web scraping avec l’IA ? Va voir notre guide complet sur .

Bien démarrer : conseils pratiques pour les équipes business

Prêt à tester le web scraping avec JavaScript (ou la version sans code de Thunderbit) ? Voici comment te lancer :

- Définis ton objectif : Quelles données tu veux, et pourquoi ?

- Choisis ton outil : Si tu es technique, tente Node.js avec Puppeteer ou Cheerio. Sinon, et laisse l’IA bosser pour toi.

- Commence petit : Teste sur quelques pages avant de passer à la vitesse supérieure.

- Exporte et analyse : Envoie tes données vers Google Sheets, Excel ou Notion pour les exploiter.

- Reste éthique : Respecte toujours la vie privée, les conditions d’utilisation et les limites de données.

Pour aller plus loin : Check nos tutos pour débutants sur le , ou rejoins des communautés comme Stack Overflow ou r/webscraping sur Reddit pour échanger.

Conclusion : Libère la valeur business du web scraping avec JavaScript

En résumé : JavaScript et Node.js sont devenus la colonne vertébrale du web scraping moderne, surtout pour les sites dynamiques et interactifs. Que tu sois dev ou côté business, l’automatisation du navigateur, l’écosystème riche et maintenant les outils boostés à l’IA te permettent d’extraire les données qu’il te faut — plus vite et plus précisément que jamais.

Et avec des solutions sans code comme , plus besoin de coder pour profiter de la puissance du scraping JavaScript. Tu décris ce que tu veux, tu cliques, et tes données arrivent — prêtes à être analysées, utilisées pour la prospection ou tout autre besoin business.

Si tu veux transformer le chaos du web en infos structurées et actionnables, c’est le moment de t’y mettre. Bon scraping — et que tes données soient toujours propres, légales et en avance sur la concurrence !

FAQ

1. Qu’est-ce que le web scraping avec JavaScript et Node.js ?

Le web scraping avec JavaScript et Node.js, c’est utiliser du code JavaScript (souvent exécuté via Node.js) pour extraire automatiquement des données de sites web. Cette méthode est super efficace pour les sites dynamiques qui chargent leur contenu avec JavaScript.

2. Pourquoi JavaScript est-il plus adapté que Python ou Ruby pour extraire des sites dynamiques ?

JavaScript, c’est le langage utilisé par les navigateurs pour afficher et mettre à jour les pages web, donc il gère naturellement le contenu dynamique. Des outils comme Puppeteer et Playwright permettent d’automatiser un vrai navigateur, ce qui facilite l’extraction sur les sites qui reposent sur JavaScript.

3. Les utilisateurs non techniques peuvent-ils faire du web scraping avec JavaScript ?

Carrément. Des outils sans code comme rendent la puissance du scraping JavaScript accessible à tous. Il suffit de donner des instructions en langage naturel et l’IA s’occupe du reste.

4. Le web scraping est-il légal ?

En général, extraire des données publiques est légal, mais il faut respecter les conditions d’utilisation du site, le fichier robots.txt et la législation sur la vie privée. Évite de collecter des données personnelles ou protégées sans autorisation.

5. Comment l’IA change-t-elle le web scraping avec JavaScript ?

L’IA rend le web scraping plus intelligent et accessible. Elle s’adapte aux changements de sites, gère les erreurs et peut même traiter et enrichir les données extraites en temps réel — un vrai gain de temps et de précision. Thunderbit est un exemple phare de cette nouvelle génération d’extracteurs pilotés par l’IA.

Pour plus de conseils et de guides, va voir le ou abonne-toi à notre .

Pour aller plus loin