Laissez-moi vous embarquer dans une scène familière : je suis devant mon ordi, café à la main, face à un tableur aussi vide que mon frigo un dimanche soir. L’équipe commerciale réclame les prix des concurrents, le marketing veut des leads tout frais, et les opérations attendent des listings produits de douze sites… pour hier. Je sais que toutes ces infos sont là, quelque part sur le web, mais les récupérer ? C’est là que ça se corse. Si tu as déjà eu l’impression de jouer à la chasse aux taupes numérique avec du copier-coller, rassure-toi, tu n’es pas le seul.

Aujourd’hui, tout a changé. Le web scraping n’est plus réservé aux geeks : c’est devenu un levier stratégique pour les boîtes. JavaScript et Node.js sont devenus incontournables, que ce soit pour des scripts rapides ou des pipelines de données costauds. Mais même si les outils sont plus puissants que jamais, la prise en main peut toujours ressembler à une ascension de l’Everest en tongs. Que tu sois pro, passionné de data ou juste lassé de la saisie manuelle, ce guide est pour toi. Je vais te présenter l’écosystème, les bibliothèques clés, les pièges à éviter, et pourquoi, parfois, passer le relais à l’IA est le choix le plus malin.

Pourquoi le web scraping avec JavaScript et Node.js est devenu indispensable

Commençons par le « pourquoi ». En 2025, la donnée web n’est plus un bonus : c’est vital. D’après une étude récente, , et près de sont désormais dédiés à la collecte de données web. Le marché des données alternatives (dont le web scraping fait partie) pèse déjà et ne cesse de grossir.

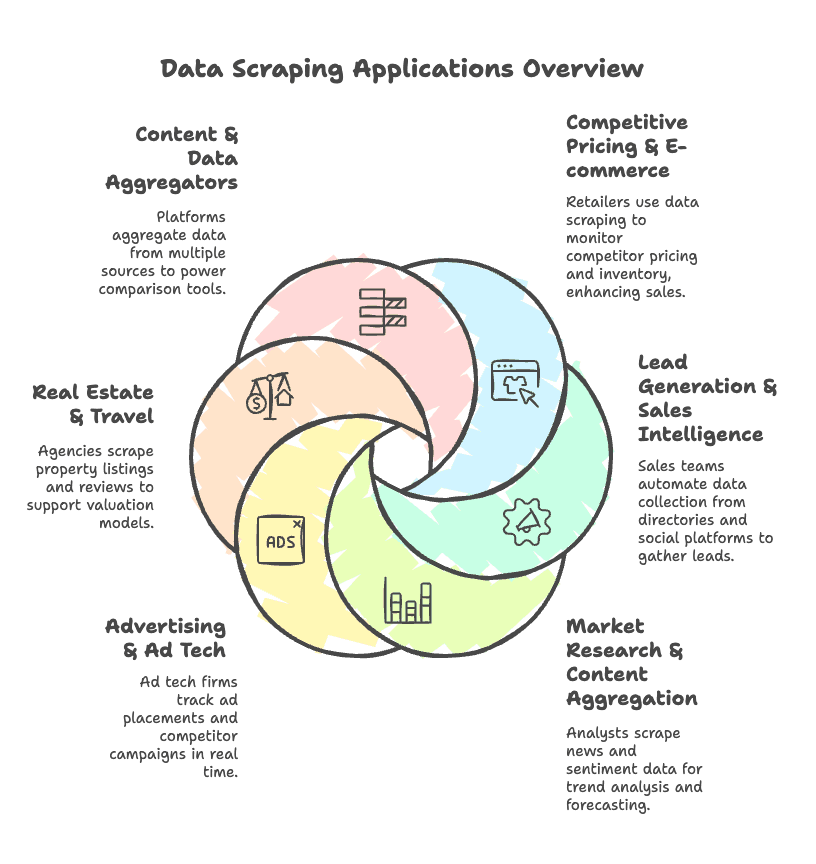

Pourquoi cet engouement ? Voici les usages les plus répandus :

- Veille concurrentielle & e-commerce : Les commerçants surveillent les prix et stocks des concurrents, ce qui peut booster les ventes de .

- Génération de leads & prospection : Les équipes commerciales automatisent la collecte d’emails, numéros et infos d’entreprises sur les annuaires et réseaux sociaux.

- Études de marché & agrégation de contenus : Les analystes extraient actualités, avis et tendances pour anticiper le marché.

- Publicité & ad tech : Les agences suivent en temps réel les campagnes et emplacements publicitaires des concurrents.

- Immobilier & voyage : Les agences collectent annonces, prix et avis pour alimenter leurs modèles d’évaluation.

- Plateformes d’agrégation : Les comparateurs centralisent des données issues de multiples sources pour alimenter leurs tableaux de bord.

JavaScript et Node.js sont devenus la stack de référence, surtout avec la généralisation des sites dynamiques. Node.js brille pour la gestion asynchrone, ce qui le rend parfait pour le scraping à grande échelle. Avec un écosystème ultra-riche, tu peux tout faire : du script express à l’extracteur robuste prêt pour la prod.

Le workflow de base : comment fonctionne le web scraping avec JavaScript et Node.js

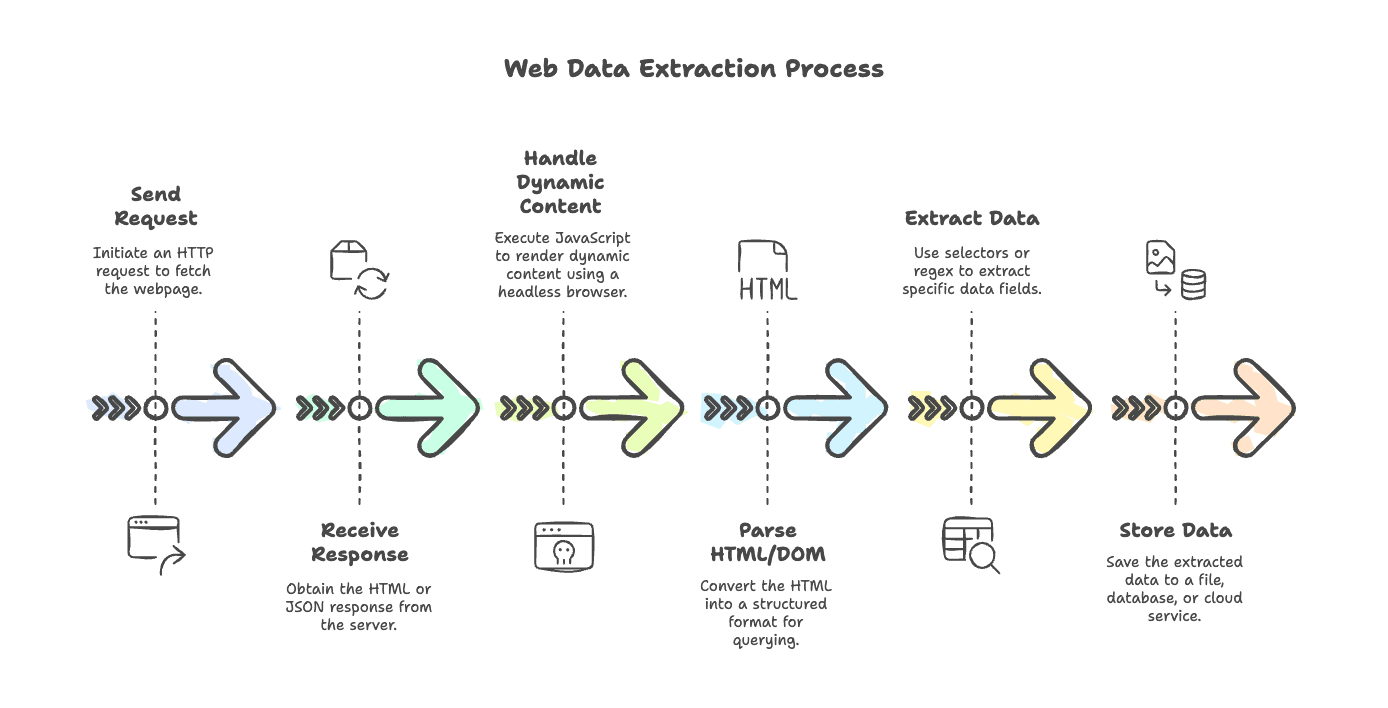

On va démystifier le process classique du web scraping. Que tu veuilles extraire un simple blog ou un site e-commerce ultra-dynamique, les étapes sont globalement les mêmes :

- Envoyer la requête : Utilise un client HTTP pour récupérer la page (

axios,node-fetch, ougot). - Recevoir la réponse : Récupère le HTML (ou parfois du JSON) du serveur.

- Gérer le contenu dynamique : Si la page est générée par JavaScript, utilise un navigateur headless (Puppeteer ou Playwright) pour exécuter les scripts et obtenir le rendu final.

- Parser le HTML/DOM : Utilise un parseur (

cheerio,jsdom) pour transformer le HTML en structure exploitable. - Extraire les données : Sélectionne les champs à extraire via des sélecteurs ou des regex.

- Stocker les données : Enregistre les résultats dans un fichier, une base de données ou un service cloud.

Chaque étape a ses outils et ses astuces, on va voir ça en détail.

Les bibliothèques HTTP à connaître pour le web scraping en JavaScript

La première étape de tout extracteur, c’est la requête HTTP. Node.js propose un large choix d’outils, des plus classiques aux plus modernes. Voici les principaux :

1. Axios

Un client HTTP basé sur les promesses, compatible Node et navigateur. L’outil « couteau suisse » du scraping.

1const axios = require('axios');

2const response = await axios.get('https://example.com/api/items', { timeout: 5000 });

3console.log(response.data);Points forts : Très complet, supporte async/await, parsing JSON automatique, gestion des proxies, interceptors.

Points faibles : Un peu plus lourd, parfois « magique » dans sa gestion des données.

2. node-fetch

Implémente l’API fetch du navigateur dans Node.js. Léger et moderne.

1import fetch from 'node-fetch';

2const res = await fetch('https://api.github.com/users/github');

3const data = await res.json();

4console.log(data);Points forts : Léger, API familière pour les devs front.

Points faibles : Moins de fonctionnalités, gestion des erreurs et des proxies plus manuelle.

3. SuperAgent

Une bibliothèque HTTP historique avec une API chaînable.

1const superagent = require('superagent');

2const res = await superagent.get('https://example.com/data');

3console.log(res.body);Points forts : Mûre, gère les formulaires, uploads, plugins.

Points faibles : API un peu datée, dépendance plus lourde.

4. Unirest

Client HTTP simple et multi-langages.

1const unirest = require('unirest');

2unirest.get('https://httpbin.org/get?query=web')

3 .end(response => {

4 console.log(response.body);

5 });Points forts : Syntaxe simple, parfait pour les scripts rapides.

Points faibles : Moins de fonctionnalités, communauté moins active.

5. Got

Client HTTP rapide et complet pour Node.js, avec des fonctionnalités avancées.

1import got from 'got';

2const html = await got('https://example.com/page').text();

3console.log(html.length);Points forts : Performant, supporte HTTP/2, gestion des flux et des retries.

Points faibles : Uniquement Node, API dense pour les débutants.

6. http/https natif de Node

La méthode « à l’ancienne » :

1const https = require('https');

2https.get('https://example.com/data', (res) => {

3 let data = '';

4 res.on('data', chunk => { data += chunk; });

5 res.on('end', () => {

6 console.log('Response length:', data.length);

7 });

8});Points forts : Aucune dépendance externe.

Points faibles : Verbeux, beaucoup de callbacks, pas de promesses.

.

Comment choisir le bon client HTTP ?

Voici mes critères principaux :

- Facilité d’utilisation : Axios et Got sont tops pour async/await et une syntaxe claire.

- Performance : Got et node-fetch sont rapides pour le scraping en masse.

- Support des proxies : Axios et Got facilitent la rotation des proxies.

- Gestion des erreurs : Axios lève les erreurs HTTP par défaut ; node-fetch demande des vérifications manuelles.

- Communauté : Axios et Got sont très populaires et bien documentés.

Mes conseils rapides :

- Scripts rapides ou prototypes : node-fetch ou Unirest.

- Scraping en production : Axios (pour ses fonctionnalités) ou Got (pour la perf).

- Automatisation de navigateur : Puppeteer ou Playwright gèrent les requêtes en interne.

Parsing HTML et extraction de données : Cheerio, jsdom et compagnie

Une fois le HTML récupéré, il faut le transformer en structure exploitable. C’est le rôle des parseurs.

Cheerio

Cheerio, c’est un peu le jQuery côté serveur. Rapide, léger, parfait pour du HTML statique.

1const cheerio = require('cheerio');

2const $ = cheerio.load('<ul><li class="item">Item 1</li></ul>');

3$('.item').each((i, el) => {

4 console.log($(el).text());

5});Points forts : Ultra-rapide, API familière, gère le HTML mal formé.

Points faibles : Ne gère pas l’exécution JavaScript—ne voit que le HTML brut.

.

jsdom

jsdom simule un DOM de navigateur dans Node.js. Il peut exécuter des scripts simples et se rapproche du comportement d’un vrai navigateur.

1const { JSDOM } = require('jsdom');

2const dom = new JSDOM(`<p id="greet">Hello</p><script>document.querySelector('#greet').textContent += ", world!";</script>`);

3console.log(dom.window.document.querySelector('#greet').textContent);Points forts : Peut exécuter des scripts, supporte toute l’API DOM.

Points faibles : Plus lent et lourd que Cheerio, ce n’est pas un navigateur complet.

.

Quand utiliser les expressions régulières ou d’autres méthodes de parsing

Les regex en scraping, c’est comme le piment : à utiliser avec modération ! Elles sont utiles pour :

- Extraire des motifs précis (emails, numéros, prix).

- Nettoyer ou valider les données extraites.

- Récupérer des infos dans des blocs de texte ou des balises script.

Exemple : extraire un nombre d’un texte

1const text = "Total sales: 1,234 units";

2const match = text.match(/([\d,]+)\s*units/);

3if (match) {

4 const units = parseInt(match[1].replace(/,/g, ''));

5 console.log("Units sold:", units);

6}Mais évite de parser tout le HTML avec des regex : préfère un parseur DOM. .

Gérer les sites dynamiques : Puppeteer, Playwright et navigateurs headless

Les sites modernes raffolent de JavaScript. Parfois, les données recherchées ne sont pas dans le HTML initial, mais générées après coup. C’est là qu’interviennent les navigateurs headless.

Puppeteer

Une bibliothèque Node.js signée Google pour piloter Chrome/Chromium. C’est comme avoir un robot qui navigue et clique à ta place.

1const puppeteer = require('puppeteer');

2const browser = await puppeteer.launch();

3const page = await browser.newPage();

4await page.goto('https://example.com');

5const title = await page.$eval('h1', el => el.textContent);

6console.log(title);

7await browser.close();Points forts : Rendu complet de Chrome, API simple, parfait pour le contenu dynamique.

Points faibles : Uniquement Chromium, gourmand en ressources.

.

Playwright

Nouvelle venue de Microsoft, Playwright gère Chromium, Firefox et WebKit. C’est le cousin cross-browser de Puppeteer.

1const { chromium } = require('playwright');

2const browser = await chromium.launch();

3const page = await browser.newPage();

4await page.goto('https://example.com');

5const content = await page.textContent('h1');

6console.log(content);

7await browser.close();Points forts : Multi-navigateurs, contextes parallèles, gestion automatique de l’attente des éléments.

Points faibles : Courbe d’apprentissage un peu plus raide, installation plus lourde.

.

Nightmare

Un ancien outil basé sur Electron. API simple, mais plus maintenu. À réserver aux projets existants.

Comparatif des solutions headless

| Aspect | Puppeteer (Chrome) | Playwright (Multi-browser) | Nightmare (Electron) |

|---|---|---|---|

| Support navigateurs | Chrome/Edge | Chrome, Firefox, WebKit | Chrome (ancien) |

| Performance & échelle | Rapide, mais lourd | Rapide, meilleur parallélisme | Plus lent, moins stable |

| Scraping dynamique | Excellent | Excellent + plus de fonctionnalités | OK pour sites simples |

| Maintenance | Bien maintenu | Très actif | Obsolète |

| Idéal pour | Scraping Chrome | Projets complexes, multi-navigateurs | Scripts simples, anciens |

Mon conseil : Pour les nouveaux projets costauds, privilégie Playwright. Puppeteer reste top pour Chrome uniquement. Nightmare, c’est surtout pour la nostalgie ou les vieux scripts.

Outils complémentaires : planification, environnement, CLI et stockage

Un extracteur en production, c’est bien plus que du fetch et du parse. Voici quelques outils indispensables :

Planification : node-cron

Pour automatiser l’exécution de tes extracteurs.

1const cron = require('node-cron');

2cron.schedule('0 9 * * MON', () => {

3 console.log('Scraping at 9 AM every Monday');

4});.

Gestion d’environnement : dotenv

Pour garder tes secrets et configs hors du code.

1require('dotenv').config();

2const apiKey = process.env.API_KEY;Outils CLI : chalk, commander, inquirer

- chalk : Pour colorer les sorties console.

- commander : Pour parser les options en ligne de commande.

- inquirer : Pour des prompts interactifs.

Stockage des données

- fs : Pour écrire dans des fichiers (JSON, CSV).

- lowdb : Base de données JSON légère.

- sqlite3 : Base SQL locale.

- mongodb : Base NoSQL pour les projets plus ambitieux.

Exemple : sauvegarder en JSON

1const fs = require('fs');

2fs.writeFileSync('output.json', JSON.stringify(data, null, 2));Les limites du web scraping traditionnel avec JavaScript et Node.js

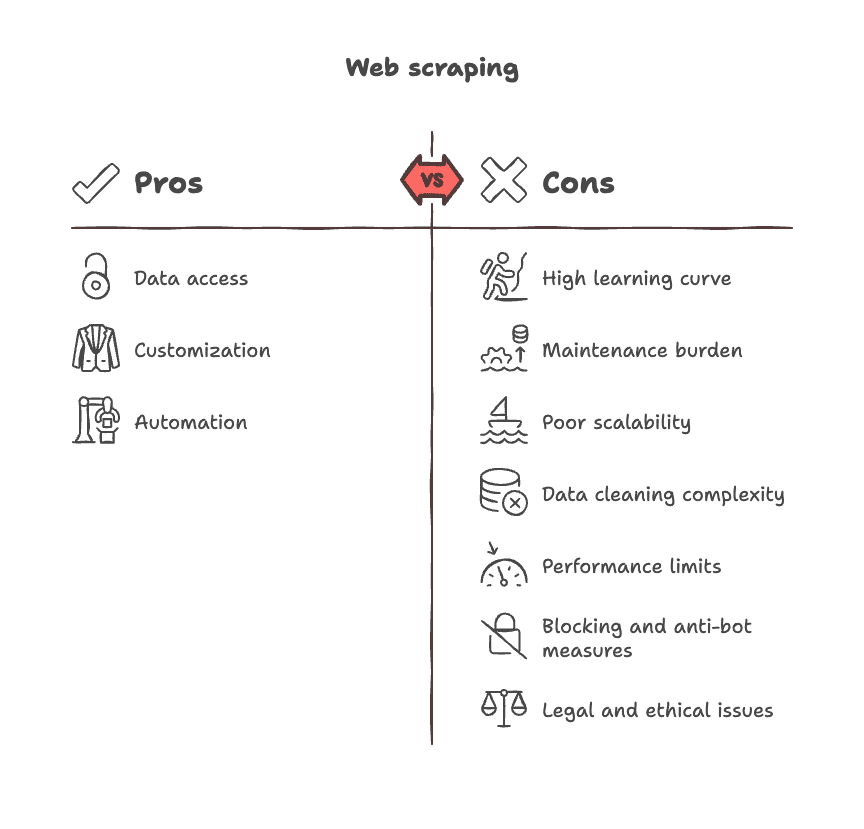

Soyons clairs : le scraping classique, ce n’est pas toujours une partie de plaisir. Voici les principaux écueils rencontrés :

- Courbe d’apprentissage raide : Il faut maîtriser le DOM, les sélecteurs, l’asynchrone, et parfois les subtilités des navigateurs.

- Maintenance chronophage : Les sites changent, les sélecteurs cassent, il faut sans cesse corriger le code.

- Scalabilité limitée : Chaque site nécessite son propre script ; il n’existe pas de solution universelle.

- Nettoyage des données complexe : Les données extraites sont souvent brutes—le nettoyage et le formatage prennent du temps.

- Limites de performance : L’automatisation de navigateur est lente et gourmande pour les gros volumes.

- Blocages et anti-bots : Les sites bloquent les extracteurs, affichent des CAPTCHAs ou cachent les données derrière des connexions.

- Zones grises légales et éthiques : Il faut jongler avec les CGU, la confidentialité et la conformité.

.

Thunderbit vs. web scraping traditionnel : la révolution de la productivité

Soyons directs : et si tu pouvais zapper tout le code, les sélecteurs et la maintenance ?

C’est là que entre en scène. En tant que cofondateur et CEO, je ne suis pas objectif, mais laisse-moi t’expliquer : Thunderbit a été pensé pour les pros qui veulent des données, pas des migraines.

Comparatif Thunderbit

| Aspect | Thunderbit (IA sans code) | Scraping JS/Node traditionnel |

|---|---|---|

| Mise en place | 2 clics, sans code | Écrire des scripts, déboguer |

| Contenu dynamique | Géré dans le navigateur | Scripting headless browser |

| Maintenance | L’IA s’adapte aux changements | Mises à jour manuelles du code |

| Extraction de données | Suggestions IA de champs | Sélecteurs manuels |

| Scraping de sous-pages | Intégré, 1 clic | Boucles et code par site |

| Export | Excel, Sheets, Notion | Intégration manuelle fichier/BDD |

| Post-traitement | Résumé, tag, formatage | Code ou outils supplémentaires |

| Pour qui ? | Tout utilisateur de navigateur | Développeurs uniquement |

L’IA de Thunderbit lit la page, suggère les champs et extrait les données en quelques clics. Elle gère les sous-pages, s’adapte aux changements de structure, et peut même résumer, taguer ou traduire les données à la volée. Tu peux exporter vers Excel, Google Sheets, Airtable ou Notion—aucune config technique à prévoir.

Cas d’usage où Thunderbit brille :

- Équipes e-commerce qui surveillent les prix et références concurrents

- Commerciaux qui extraient des leads et contacts

- Analystes qui agrègent actualités ou avis

- Agents immobiliers qui collectent annonces et détails de biens

Pour du scraping fréquent et critique, Thunderbit fait gagner un temps fou. Pour des projets sur-mesure, très intégrés ou à grande échelle, le scripting traditionnel garde son intérêt—mais pour la majorité des équipes, Thunderbit est le chemin le plus rapide du « j’ai besoin de données » au « j’ai mes données ».

ou explorez d’autres cas d’usage sur le .

Aide-mémoire : les bibliothèques JavaScript & Node.js à avoir sous la main pour le web scraping

Voici un résumé des outils phares du web scraping en JavaScript pour 2025 :

Requêtes HTTP

- : Client HTTP riche basé sur les promesses.

- : API Fetch pour Node.js.

- : Client HTTP rapide et avancé.

- : Requêtes HTTP chaînables et matures.

- : Client simple et multi-langages.

Parsing HTML

- : Parseur HTML rapide façon jQuery.

- : DOM de navigateur dans Node.js.

Contenu dynamique

- : Automatisation Chrome headless.

- : Automatisation multi-navigateurs.

- : Automatisation Electron, pour les anciens projets.

Planification

- : Tâches planifiées dans Node.js.

CLI & utilitaires

- : Mise en forme des chaînes en terminal.

- : Parsing des arguments CLI.

- : Prompts interactifs en CLI.

- : Chargement des variables d’environnement.

Stockage

- : Système de fichiers natif.

- : Mini base JSON locale.

- : Base SQL locale.

- : Base NoSQL.

Frameworks

- : Framework haut niveau pour le crawling et le scraping.

(Pense à vérifier la doc et les dépôts GitHub pour les dernières nouveautés.)

Ressources recommandées pour devenir un pro du web scraping en JavaScript

Envie d’aller plus loin ? Voici une sélection de ressources pour progresser :

Docs officielles & guides

Tutoriels & formations

Projets open-source & exemples

Communautés & forums

Livres & guides complets

- « Web Scraping with Python » d’O’Reilly (pour les concepts transversaux)

- Udemy/Coursera : formations « Web Scraping in Node.js »

(Vérifie toujours les éditions et les mises à jour récentes.)

Conclusion : quelle approche choisir pour ton équipe ?

En résumé : JavaScript et Node.js offrent une puissance et une flexibilité énormes pour le web scraping. Tu peux tout faire, du script rapide à l’extracteur scalable. Mais cette puissance a un prix : la maintenance. Le scripting traditionnel est parfait pour les projets sur-mesure, complexes, où tu veux tout contrôler et tu acceptes l’entretien régulier.

Pour tous les autres—business, analystes, marketeurs, ou toute personne qui veut juste la donnée—les solutions no-code modernes comme sont une vraie bouffée d’air frais. L’extension Chrome boostée à l’IA de Thunderbit permet d’extraire, structurer et exporter des données en quelques minutes, sans code ni sélecteurs.

Alors, quelle méthode choisir ? Si ton équipe a des devs et des besoins spécifiques, fonce dans la boîte à outils Node.js. Si tu veux la rapidité, la simplicité et la liberté de te concentrer sur l’analyse plutôt que sur la technique, essaie Thunderbit. Dans tous les cas, le web est ta base de données—à toi de jouer !

Et si tu bloques, rappelle-toi : même les meilleurs extracteurs ont commencé avec une page blanche et un bon café. Bon scraping !

Envie d’en savoir plus sur le scraping IA ou de voir Thunderbit en action ?

Des questions, des anecdotes ou des galères de scraping à partager ? Laisse un commentaire ou contacte-moi. J’adore découvrir comment chacun transforme le web en terrain de jeu data.

Reste curieux, garde ta tasse pleine, et scrape plus malin !

FAQ :

1. Pourquoi utiliser JavaScript et Node.js pour le web scraping en 2025 ?

Parce que la majorité des sites modernes tournent avec JavaScript. Node.js est rapide, gère l’asynchrone, et dispose d’un écosystème riche (Axios, Cheerio, Puppeteer…) pour tout faire, du simple fetch à l’extraction de contenu dynamique à grande échelle.

2. À quoi ressemble le workflow type pour scraper un site avec Node.js ?

En général :

Requête → Gestion de la réponse → (Exécution JS optionnelle) → Parsing HTML → Extraction des données → Sauvegarde ou export

Chaque étape peut être gérée par des outils dédiés comme axios, cheerio ou puppeteer.

3. Comment extraire des pages dynamiques générées par JavaScript ?

Utilise des navigateurs headless comme Puppeteer ou Playwright. Ils chargent la page complète (y compris le JS), ce qui permet d’extraire ce que voit réellement l’utilisateur.

4. Quels sont les plus gros défis du scraping traditionnel ?

- Changements de structure des sites

- Détection anti-bot

- Consommation de ressources navigateur

- Nettoyage manuel des données

- Maintenance élevée sur la durée

Tout ça complique le scraping à grande échelle ou pour les non-développeurs.

5. Quand privilégier Thunderbit plutôt que le code ?

Opte pour Thunderbit si tu veux la rapidité, la simplicité et que tu ne veux pas coder ni maintenir de scripts. C’est idéal pour les équipes commerciales, marketing ou études qui veulent extraire et structurer des données rapidement—même sur des sites complexes ou multi-pages.