Si tu as déjà mis les mains dans un terminal, tu as forcément croisé cURL. Véritable couteau suisse du web, cURL est ce petit outil discret installé sur des milliards d’appareils, toujours prêt à récupérer, envoyer ou diagnostiquer tout ce qui a une URL. Son créateur estime même qu’il y a dans le monde. Oui, tu as bien lu : vingt milliards.

Mais alors, pourquoi les développeurs (et soyons honnêtes, pas mal de pros d’autres horizons) continuent-ils d’utiliser cURL en 2025 alors que les extracteurs web boostés à l’IA se multiplient ? Tout simplement parce que cURL va droit au but : rapide, scriptable, sans prise de tête. Dans ce guide, je t’explique pourquoi l’extraction web avec cURL reste ultra pertinente, dans quels cas il est imbattable, comment l’utiliser efficacement, et comment tu peux booster tes workflows avec , notre extracteur web IA qui modernise la collecte de données.

Pourquoi l’extraction web avec cURL reste un incontournable en 2025

Je l’avoue : j’ai un faible pour cURL. Il y a un vrai plaisir à taper une commande et voir défiler les données brutes. Et je ne suis pas le seul ! Le a vu le nombre de participants grimper de 28% l’an dernier, et Stack Overflow regorge de sur le sujet. Les devs le décrivent comme « une valeur sûre », « génial » ou encore « le langage universel des requêtes web ». Même avec la vague de nouveaux outils, cURL continue d’évoluer : il gère désormais HTTP/3, entre autres.

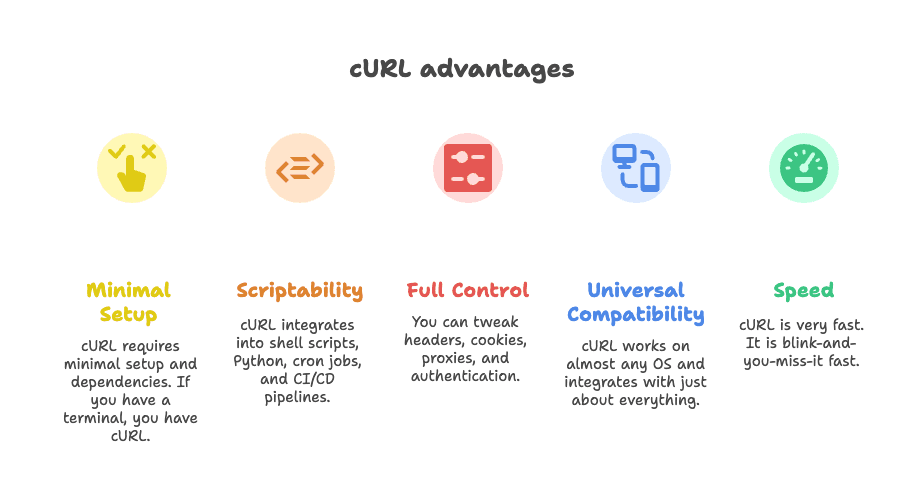

Mais qu’est-ce qui rend cURL aussi solide pour l’extraction web ?

- Installation ultra légère : Pas besoin de mille dépendances. Si tu as un terminal, tu as cURL.

- Scriptable à souhait : Parfait dans des scripts shell, Python, tâches planifiées ou pipelines CI/CD.

- Contrôle total : Tu règles les en-têtes, cookies, proxys et authentifications comme tu veux.

- Compatible partout : Fonctionne sur quasiment tous les systèmes et s’intègre à tout.

- Rapide comme l’éclair : Les résultats arrivent en un clin d’œil.

Comme le dit un dev : « Tout ce que tu veux faire, cURL peut le faire. » ()

Les meilleurs cas d’usage de cURL pour l’extraction web : quand l’utiliser ?

Soyons francs : cURL ne fait pas tout. Mais dans certains cas, il est imbattable. Voici là où il brille :

1. Récupérer des données JSON via des API REST

Beaucoup de sites modernes chargent leur contenu via des appels API en arrière-plan. Si tu trouves le bon endpoint (astuce : regarde l’onglet Réseau de ton navigateur), cURL peut choper le JSON en une commande. Parfait pour des extractions rapides, tester une API ou intégrer dans un script d’automatisation.

2. Extraire des données de pages statiques ou bien structurées

Si les infos sont directement dans le HTML (articles, annuaires, pages de catégories produits…), cURL les récupère en un éclair. Combine-le avec grep, sed ou jq pour un premier tri.

3. Déboguer et reproduire des requêtes HTTP complexes

Besoin de simuler une connexion, tester un webhook ou diagnostiquer une API ? cURL te donne accès à tous les en-têtes, cookies et payloads. C’est l’outil de référence pour voir ce qui se passe sous le capot.

4. Intégrer des extractions rapides dans des scripts

cURL est souvent utilisé dans des scripts shell, Python ou même des webhooks Zapier. C’est le liant de plein d’automatisations en coulisses.

Voici un tableau récap pour savoir quand cURL est pertinent (ou pas) :

| Cas d’usage | Pourquoi choisir cURL | Ses limites | Alternatives |

|---|---|---|---|

| Extraction d’API JSON | Rapide, scriptable, gère les en-têtes/tokens | Pas de parsing JSON natif, authentification complexe manuelle | Python Requests, Postman, Thunderbit |

| Pages HTML statiques | Léger, facile à intégrer avec des outils CLI | Pas de parsing HTML, ne gère pas le JavaScript | Scrapy, BeautifulSoup, Thunderbit |

| Extraction avec session | Gère cookies, en-têtes, authentification basique | Fastidieux pour les connexions multi-étapes, pas de JS | Sessions Requests, Selenium, Thunderbit |

| Intégration Shell/Python | Universel, fonctionne dans tout script | Parsing et gestion d’erreurs manuels | Librairies HTTP natives, Thunderbit |

Pour creuser ces scénarios, jette un œil à .

Techniques essentielles d’extraction web avec cURL en 2025

Passons à la pratique. Voici comment tirer le meilleur de cURL en 2025, avec quelques astuces à connaître.

Définir les en-têtes et User-Agent

Les sites bloquent souvent les requêtes cURL trop « brutes ». Pour passer sous le radar, choisis un User-Agent crédible et les bons en-têtes :

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/dataOu, pour plusieurs en-têtes :

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/dataLe choix des en-têtes fait souvent la différence entre une extraction réussie et un blocage. Pour en savoir plus, regarde .

Gérer les cookies et les sessions

Besoin de te connecter ou de garder une session ? Utilise le cookie jar de cURL :

1# Connexion et sauvegarde des cookies

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# Réutiliser les cookies pour les requêtes suivantes

4curl -b cookies.txt https://example.com/dashboardTu peux aussi passer les cookies directement :

1curl -b "SESSIONID=abcd1234" https://example.com/pageSi tu dois suivre des redirections (après une connexion, par exemple), ajoute -L pour garder les cookies.

Utiliser des proxys pour éviter les blocages

Tu es bloqué par ton IP ? Passe par un proxy :

1curl --proxy 198.199.86.11:8080 https://target.comPour faire tourner plusieurs proxys, script cURL pour lire une liste et les alterner. Attention, les proxys gratuits sont souvent capricieux : ne blâme pas cURL si tu tombes sur une erreur « connection refused ».

Sauvegarder et parser les réponses

cURL te donne les données brutes. Pour les exploiter, combine-le avec des outils en ligne de commande :

-

Pour le JSON : Utilise

jqpour formater ou extraire des champs.1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

Pour le HTML : Utilise

grepousedpour des motifs simples.1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

Pour des extractions plus complexes : Essaie

htmlq(pour les sélecteurs CSS) ou passe à Python avec BeautifulSoup.

Pour un tuto détaillé sur cURL et jq, lis .

Authentification et gestion des limites de requêtes avec cURL

Authentification :

-

Authentification basique :

1curl -u username:password https://api.example.com/data -

Tokens Bearer :

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

Cookies de session : Utilise les options

-cet-bcomme vu plus haut.

Pour des flux plus complexes (OAuth, par exemple), il faudra scripter l’échange – cURL le permet, mais ce n’est pas pour les débutants.

Limites de requêtes et relances :

-

Ajouter des délais :

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # délai aléatoire entre 2 et 4 secondes 4done -

Relances automatiques :

1curl --retry 3 --retry-delay 5 https://example.com/data

Sois respectueux : évite de surcharger les serveurs et surveille les réponses 429 Too Many Requests.

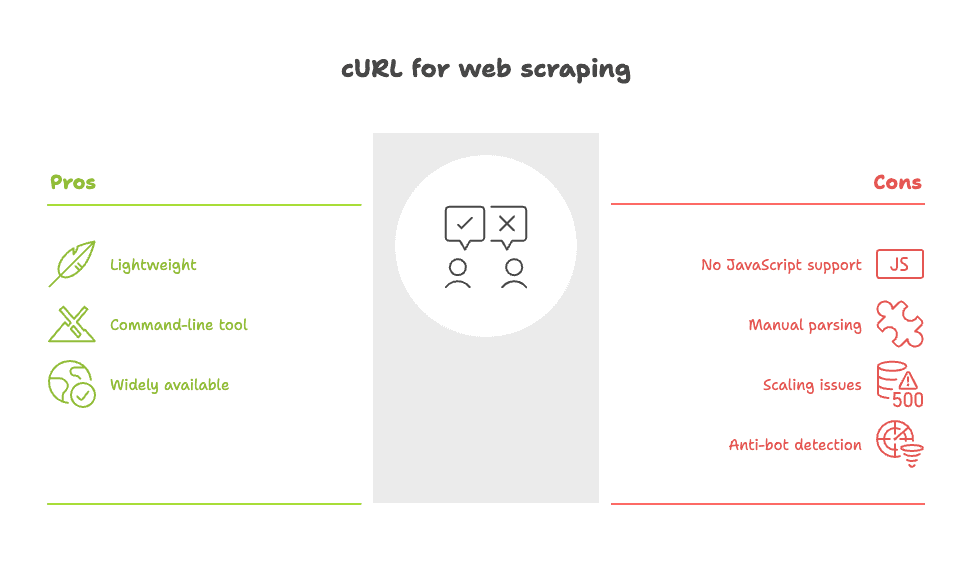

Limites de cURL pour l’extraction web : ce qu’il faut savoir

Soyons clairs : aussi pratique soit-il, cURL n’est pas toujours la meilleure option. Voici ses principales limites :

- Pas de support JavaScript : cURL ne peut pas exécuter de scripts ni afficher du contenu dynamique. Si les données apparaissent après le rendu de la page, cURL ne les verra pas. Il faudra trouver l’API sous-jacente ou passer à un outil basé navigateur.

- Parsing manuel : Tu obtiens du HTML ou du JSON brut. À toi de structurer les données, souvent à coups de

grep,sedou scripts maison. - Difficile à faire évoluer à grande échelle : Pour extraire des centaines ou milliers de pages, la gestion des erreurs, relances et nettoyage devient vite un casse-tête.

- Facilement repéré par les anti-bots : Beaucoup de sites détectent la signature réseau de cURL et le bloquent, même si tu modifies les en-têtes.

Comme le résume un utilisateur Reddit : « Curl ou wget suffisent pour des besoins simples, mais pour des sites complexes, tu vas galérer. » ()

Pour un tour d’horizon complet des limites de cURL, consulte .

Boostez votre extraction web cURL avec Thunderbit

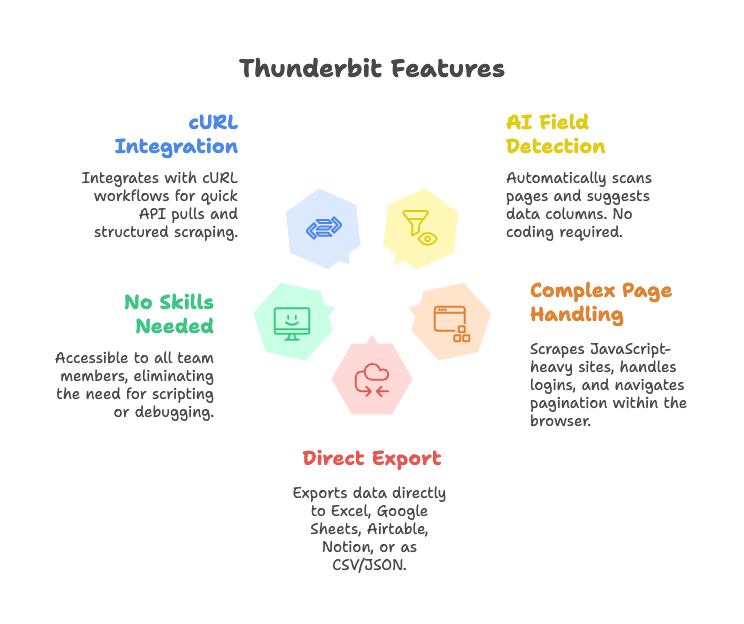

Et si tu pouvais garder la rapidité et le contrôle de cURL, sans la galère du traitement manuel ? C’est là que entre en scène.

Thunderbit, c’est l’extension Chrome d’extraction web IA qui simplifie la collecte de données. Voici comment il complète cURL :

- Détection intelligente des champs : Clique sur « Suggérer les champs IA » et Thunderbit analyse la page, propose des colonnes et structure tes données – sans sélecteurs ni code.

- Gère les pages complexes : Thunderbit fonctionne dans le navigateur, il peut donc extraire des sites dynamiques, gérer les connexions et naviguer dans les sous-pages ou la pagination.

- Export direct : Envoie tes données vers Excel, Google Sheets, Airtable, Notion ou télécharge-les en CSV/JSON.

- Aucune compétence technique requise : Toute l’équipe peut l’utiliser, sans écrire de script ni déboguer des en-têtes HTTP.

- S’intègre aux workflows cURL : Les devs peuvent continuer à utiliser cURL pour des extractions rapides, puis passer à Thunderbit pour des extractions structurées et répétables.

Pour voir Thunderbit en action, teste notre ou parcours notre pour d’autres cas d’usage.

Thunderbit + cURL : exemples de workflow pour les équipes business

Concrètement, voici comment les équipes peuvent combiner cURL et Thunderbit pour gagner un temps fou :

1. Veille concurrentielle express

- Utilise cURL pour tester rapidement si le site d’un concurrent propose une API publique ou du HTML statique.

- Si oui, script d’extraction ponctuelle pour un aperçu rapide.

- Pour une analyse approfondie (extraction de listings produits sur plusieurs pages, par exemple), passe à Thunderbit : l’IA détecte les champs, gère la pagination et exporte vers Sheets pour une analyse immédiate.

2. Génération de leads

- Utilise cURL pour récupérer des contacts via une API d’annuaire simple.

- Pour des sites plus complexes (profils type LinkedIn, annonces immobilières…), Thunderbit extrait noms, emails, téléphones et même images – sans parsing manuel.

3. Suivi de prix ou de catalogues produits

- Planifie des scripts cURL pour surveiller les changements de prix via une API REST.

- Pour les sites sans API, laisse Thunderbit extraire, structurer et envoyer les données vers Airtable ou Notion pour ton équipe opérationnelle.

Voici un schéma de workflow (imagine des petits bonshommes et des flèches) :

1[Navigateur/Terminal] --(test avec cURL)--> [Extraction rapide]

2 |

3 v

4[Extension Chrome Thunderbit] --(extraction IA)--> [Données structurées] --> [Sheets/Airtable/Notion]Les atouts clés : Thunderbit vs scripts cURL maison

Comparons-les côte à côte :

| Fonctionnalité | Thunderbit (Extracteur Web IA) | cURL (Outil CLI) |

|---|---|---|

| Temps de mise en place | Point & clic, détection IA des champs | Script manuel, nécessite des bases HTML |

| Facilité d’utilisation | Accessible à tous, retour visuel | Uniquement en ligne de commande, apprentissage technique |

| Résultat structuré | Oui – tableaux, colonnes, export vers Sheets/CRM | HTML/JSON brut, parsing manuel |

| Gère les pages dynamiques | Oui – fonctionne dans le navigateur, supporte JS, sous-pages, pagination | Non – uniquement HTML statique |

| Maintenance | Faible – l’IA s’adapte aux changements de site | Élevée – scripts à réécrire si le site change |

| Intégration | Exports intégrés vers outils business | Code personnalisé nécessaire |

| Multilingue/Traduction | Oui – l’IA traduit et normalise les champs | Non – tout est manuel |

| Passage à l’échelle | Idéal pour des volumes moyens | Bon pour de gros volumes si tu codes tout |

| Coût | Version gratuite, offres payantes dès ~9$/mois | Gratuit, mais coûte du temps développeur |

Pour plus de détails, consulte notre .

Grâce à l’IA de Thunderbit, tu passes moins de temps à coder et plus de temps à exploiter tes données. Que tu sois dev ou utilisateur métier, c’est la solution la plus rapide pour transformer les données web en valeur business.

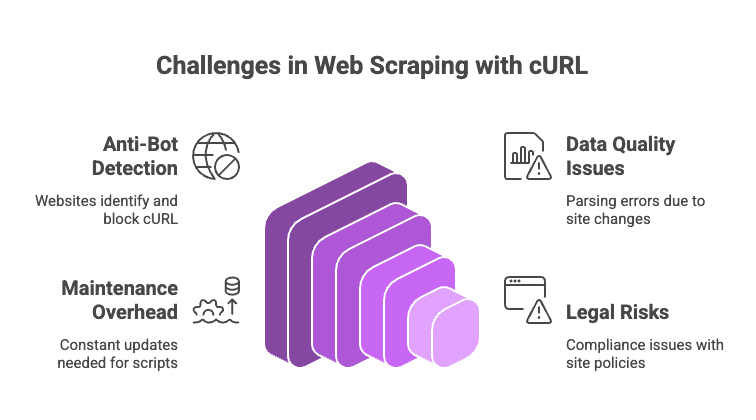

Défis et pièges à éviter avec l’extraction web cURL

L’extraction web en 2025, ce n’est pas toujours une promenade de santé. Voici les principaux obstacles (et comment les contourner) :

- Anti-bots : Des solutions comme Cloudflare, Akamai ou DataDome repèrent cURL très facilement. Même en modifiant les en-têtes, elles vérifient l’exécution JavaScript, l’empreinte TLS, etc. Si tu tombes sur un CAPTCHA, cURL ne pourra rien faire.

- Qualité et cohérence des données : Parser du HTML brut avec regex ou grep, c’est fragile. Le moindre changement de structure casse ton script (et ton moral).

- Maintenance chronophage : À chaque modif du site, il faut revoir le code, les sélecteurs ou la logique de parsing.

- Risques juridiques et conformité : Vérifie toujours les conditions d’utilisation et la politique de confidentialité du site. Ce n’est pas parce que c’est faisable que c’est autorisé.

Astuces pro :

- Alterne les user agents et les adresses IP si tu es bloqué.

- Ajoute des délais aléatoires entre les requêtes.

- Utilise

jqpour le JSON ethtmlqpour le HTML. - Pour les sites dynamiques ou protégés, passe à un outil navigateur comme Thunderbit ou à une API d’extraction.

Pour une liste complète des pièges à éviter, consulte .

Conclusion : choisir la bonne méthode d’extraction web en 2025

Mon avis : cURL reste imbattable pour des extractions rapides et ciblées – surtout pour les API, les pages statiques ou le débogage. C’est le moyen le plus direct de tester un site et d’explorer ses possibilités.

Mais dès que tu as besoin de données structurées, de contenu dynamique ou de workflows adaptés à l’entreprise, il est temps de passer à la vitesse supérieure. te permet d’éviter la corvée manuelle, de gérer les sites complexes et d’acheminer les données là où tu en as besoin – rapidement.

Adapte donc l’outil à la tâche. Pour les petits jobs scriptables, cURL est ton allié. Pour tout ce qui est plus volumineux, dynamique ou collaboratif, laisse Thunderbit faire le boulot.

FAQ : Extraction web avec cURL en 2025

1. cURL peut-il extraire du contenu généré par JavaScript ?

Non. cURL ne récupère que le HTML initial. Si les données sont chargées via JavaScript, il faut trouver l’API sous-jacente ou utiliser un outil navigateur comme Thunderbit.

2. Comment éviter d’être bloqué lors de l’extraction avec cURL ?

Définis des en-têtes crédibles (User-Agent, Accept), alterne IP et user agents, ajoute des délais entre les requêtes et réutilise les cookies. Pour les systèmes anti-bots avancés (Cloudflare…), essaie ou passe à un navigateur sans interface ou une API d’extraction.

3. Quelle est la meilleure façon de structurer les résultats de cURL ?

Pour le JSON, passe la sortie à jq. Pour le HTML, utilise grep, sed ou des parseurs HTML en ligne de commande comme htmlq. Pour des besoins plus complexes, passe à Python avec BeautifulSoup ou utilise Thunderbit pour une extraction automatisée.

4. cURL est-il adapté à des projets d’extraction à grande échelle ?

C’est possible, mais il faudra gérer beaucoup d’aspects : relances, erreurs, proxys, nettoyage des données… Pour de gros volumes, des frameworks comme Scrapy ou des outils navigateurs sont souvent plus efficaces.

5. En quoi Thunderbit améliore-t-il l’extraction par rapport à cURL ?

Thunderbit détecte automatiquement les champs, gère les pages dynamiques, les sessions et sous-pages, et exporte les données structurées directement vers tes outils business. Pas de script, pas de sélecteurs, pas de maintenance.

Prêt à simplifier l’extraction de données ? Essaie – ou installe notre pour voir comment l’IA peut transformer ton workflow.

Et si tu préfères toujours le terminal et le curseur qui clignote ? Pas de panique, cURL n’est pas près de disparaître. Pense juste à ménager les serveurs… et à offrir un café à ton admin système préféré.

Envie d’autres conseils sur l’extraction web, l’automatisation et la productivité boostée par l’IA ? Parcours le pour découvrir nos derniers guides et astuces.