Le web, c’est un peu le carburant caché de l’intelligence économique d’aujourd’hui. Que tu sois en train de surveiller les prix de tes concurrents, de te constituer une base de prospects ou d’analyser ce que pensent les clients, il y a de grandes chances que tu utilises des données qui, à un moment ou à un autre, ont été récupérées sur internet. Un chiffre qui fait réfléchir : d’ici 2025, près de la moitié du trafic internet sera générée par des bots, l’automatisation de la collecte de données boostant aussi bien l’e-commerce que les études de marché (). Dans cette chasse à l’or numérique, Python s’est imposé comme la star de l’extraction web, grâce à sa simplicité et à la puissance de ses bibliothèques spécialisées.

Après plusieurs années à bosser dans le SaaS et l’automatisation, j’ai vu à quel point le web scraping en Python peut changer la donne pour une boîte—à condition d’avoir les bons outils et la bonne méthode. Dans ce guide, je t’explique comment fonctionne l’extraction web avec Python, les outils à connaître absolument, comment éviter les galères classiques, et je te propose même un projet concret pour extraire des avis de films sur IMDB (avec une petite analyse de sentiment pour pimenter le tout). Et si tu préfères « avoir les données sans toucher une ligne de code », je te présente , notre extracteur web IA sans code qui rend l’extraction de données aussi simple que commander un plat sur une appli.

Prêt à transformer le web en ta propre mine de données ? On y va !

Qu’est-ce que le Web Scraping en Python ? Les bases à connaître

L’extraction web, ou web scraping, c’est tout simplement le fait de collecter automatiquement des infos sur des sites et de les organiser—imagine un robot qui fait du copier-coller à la vitesse de l’éclair et à grande échelle. Les entreprises s’en servent pour surveiller les prix, générer des leads, faire des études de marché ou encore analyser les tendances ().

Python, c’est un peu le couteau suisse de l’extraction web. Pourquoi ? Sa syntaxe est super claire, facile à prendre en main, et il existe plein de bibliothèques pour tous les cas de figure. Le schéma de base, c’est :

- Envoyer une requête au site (avec une bibliothèque comme

requests). - Télécharger le HTML de la page.

- Analyser le HTML (avec

Beautiful Soupou équivalent) pour repérer les infos qui t’intéressent. - Extraire et stocker les données dans un format propre (CSV, Excel, base de données…).

En résumé, ça donne :

1[Site web] → [Requête HTTP] → [Réponse HTML] → [Analyseur HTML] → [Données extraites] → [CSV/Excel/BDD]Le rôle de Python ? Il orchestre tout ça, rendant l’extraction web accessible aussi bien aux développeurs qu’aux pros qui veulent juste des données.

Pourquoi le Web Scraping en Python est-il un atout pour les entreprises ?

Concrètement, pourquoi autant d’entreprises misent sur l’extraction web en Python ? Parce que ça apporte une vraie valeur ajoutée dans plein de situations :

| Cas d'usage | Ce que vous obtenez | Impact business/ROI |

|---|---|---|

| Génération de leads | Listes de contacts, emails, numéros | Remplissez votre CRM avec des prospects ciblés |

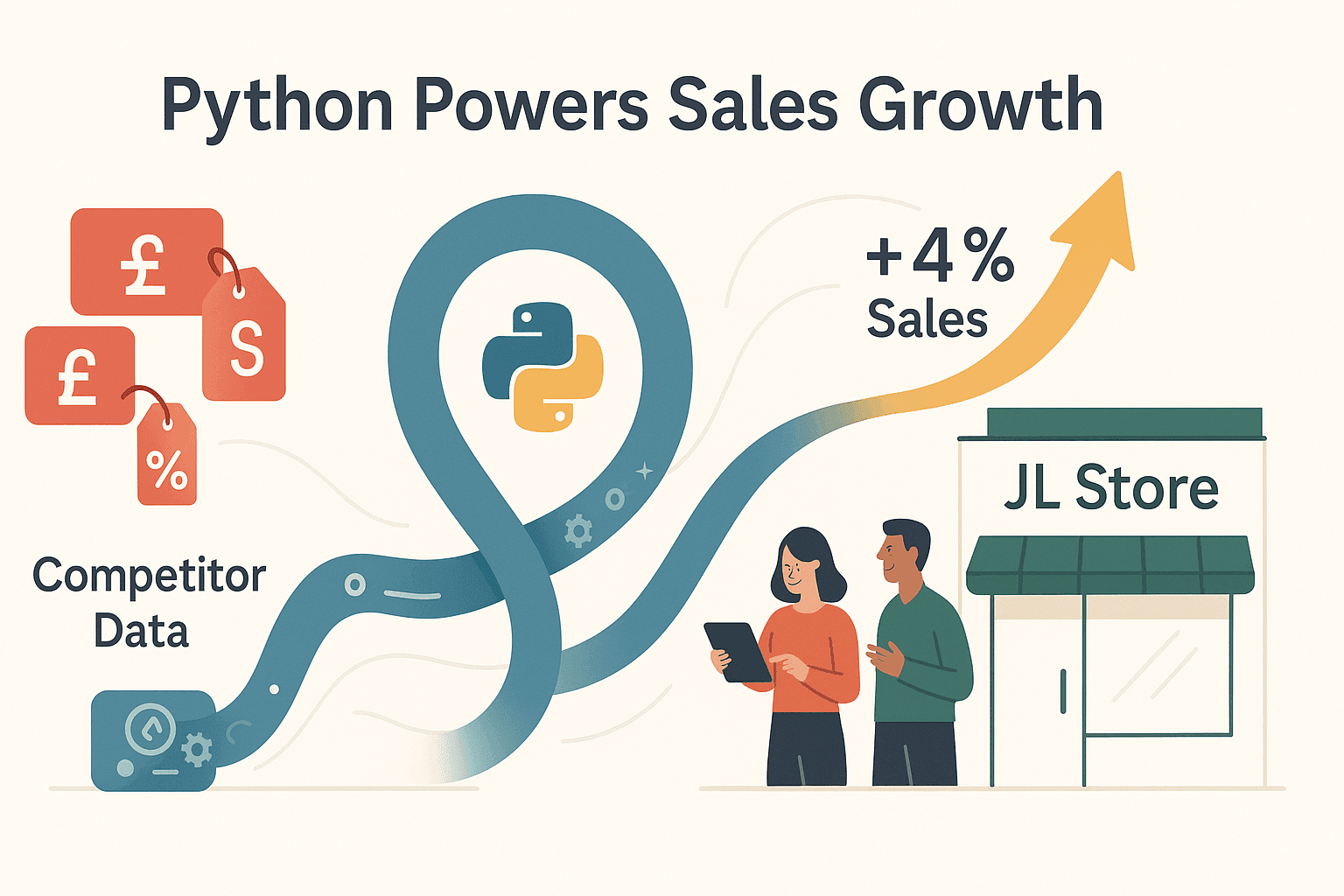

| Veille tarifaire | Prix concurrents, niveaux de stock | Tarification dynamique, +4% de ventes (Browsercat) |

| Études de marché | Avis produits, sentiment sur les réseaux | Analyse des tendances en temps réel, meilleures décisions produits |

| Agrégation de contenu | News, bons plans, catalogues produits | Alimentez des comparateurs, touchez 78% des acheteurs en ligne |

| Automatisation opérationnelle | Saisie de données en masse, reporting | Gagnez des centaines d'heures, réduisez les coûts de 40% |

Un exemple qui parle : le distributeur britannique John Lewis a utilisé Python pour surveiller les prix de ses concurrents et ajuster les siens, ce qui lui a permis d’augmenter ses ventes de 4% (). Autre cas : une équipe commerciale a extrait plus de 12 000 leads en une semaine grâce à un script Python, économisant « des centaines d’heures » de boulot manuel.

En bref : l’extraction web en Python transforme le web ouvert en avantage concurrentiel—et vite.

En bref : l’extraction web en Python transforme le web ouvert en avantage concurrentiel—et vite.

Les outils indispensables pour le Web Scraping en Python : constituez votre boîte à outils

Avant de te lancer, il faut préparer ton environnement Python et découvrir les outils clés. Voici ma config préférée :

1. Installation de Python & IDE

- Python 3.x : À télécharger sur .

- IDE : J’aime bien pour ses options avancées, mais ou Jupyter Notebooks font très bien le job aussi.

Petit conseil : crée un environnement virtuel pour chaque projet (python -m venv nom_env) pour bien gérer tes dépendances.

2. Bibliothèques incontournables

| Bibliothèque | Fonction principale | Idéal pour |

|---|---|---|

| requests | Récupère les pages web (requêtes HTTP) | Sites statiques, APIs |

| Beautiful Soup | Analyse le HTML, repère les données | HTML simple ou désordonné |

| Selenium | Automatise le navigateur (JS, clics, scroll) | Sites dynamiques, scroll infini, logins |

| Scrapy | Framework complet d’extraction | Grands volumes, multi-pages, asynchrone |

Pour les installer :

1pip install requests beautifulsoup4 selenium scrapy3. Tableau comparatif des outils

| Outil | Sites statiques | Sites dynamiques | Échelle | Courbe d'apprentissage | Remarques |

|---|---|---|---|---|---|

| requests + BS | Oui | Non | Petit/Moyen | Facile | Idéal pour débuter, tâches rapides |

| Selenium | Oui | Oui | Petit | Moyenne | Plus lent, simule un vrai navigateur |

| Scrapy | Oui | Limité | Grand | Plus élevée | Asynchrone, gère des milliers de pages |

| Playwright | Oui | Oui | Moyen | Moyenne | Automatisation navigateur moderne, rapide |

Pour la plupart des besoins business, commencer avec requests + Beautiful Soup, c’est le top. Passe à Selenium ou Scrapy si tu veux aller plus loin.

Comment fonctionne le Web Scraping en Python : de la requête à l’extraction de données

Voyons ensemble un exemple simple d’extraction avec Python. On va extraire les titres et prix de livres sur un site statique comme :

1import requests

2from bs4 import BeautifulSoup

3url = "https://books.toscrape.com/"

4response = requests.get(url)

5soup = BeautifulSoup(response.text, 'html.parser')

6for item in soup.find_all('article', {'class': 'product_pod'}):

7 title = item.find('h3').find('a')['title']

8 price = item.find('p', {'class': 'price_color'}).text

9 print(f"{title} -- {price}")Ce qui se passe ici :

requests.get()récupère le HTML de la page.BeautifulSoupanalyse le HTML.find_all()repère chaque fiche livre.- On extrait le titre et le prix, puis on affiche.

Pour les sites dynamiques (où les données s’affichent après chargement), il faut passer par Selenium :

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get(url)

4page_html = driver.page_source

5soup = BeautifulSoup(page_html, 'html.parser')

6# ...analyse identique...

7driver.quit()La différence ? Selenium lance un vrai navigateur, capable de « voir » le contenu généré par JavaScript.

Surmonter les défis courants du Web Scraping en Python

L’extraction web, ce n’est pas toujours un long fleuve tranquille—les sites mettent souvent des barrières. Voici comment contourner les obstacles les plus fréquents :

1. Contre-mesures anti-scraping

- Headers User-Agent : Mets toujours un user-agent de navigateur réel pour ne pas te faire griller comme bot ().

1headers = {"User-Agent": "Mozilla/5.0 ..."} 2requests.get(url, headers=headers) - Rotation de proxies : Si tu es bloqué pour trop de requêtes, utilise plusieurs proxies pour répartir le trafic.

- Limitation de fréquence : Ajoute

time.sleep(1)entre les requêtes pour ne pas surcharger le serveur. - CAPTCHAs : Pour les sites protégés, il faudra parfois Selenium ou des services spécialisés—mais reste toujours dans un cadre éthique.

2. Problèmes de format de données

- Problèmes d’encodage : Mets

response.encoding = 'utf-8'si tu vois des caractères bizarres. - HTML mal structuré : Beautiful Soup est tolérant, mais il faudra parfois nettoyer les espaces ou utiliser des regex pour les cas tordus.

3. Changements de site

- Sélecteurs fragiles : Si la structure du site change, ton script peut casser. Prévoyez un code flexible et sois prêt à l’adapter.

Liste de vérification dépannage

- Vérifie tes sélecteurs avec l’outil d’inspection du navigateur.

- Affiche le HTML brut pour comprendre les données manquantes.

- Utilise des blocs try/except pour gérer les champs absents.

- Respecte toujours le

robots.txtet les conditions d’utilisation du site.

Thunderbit : l’alternative sans code à l’extraction web Python

Tout le monde n’a pas envie de se prendre la tête avec le code, les proxies ou les navigateurs automatisés. C’est pour ça qu’on a créé : un extracteur web IA sans code, directement dans ton navigateur Chrome.

Avec Thunderbit, c’est simple :

- Ouvre la page à extraire.

- Clique sur AI Suggérer les champs—l’IA analyse la page et propose les données à extraire.

- Clique sur Extraire—Thunderbit récupère les données et les affiche dans un tableau.

- Exporte direct vers Excel, Google Sheets, Notion ou Airtable.

Pas de config, pas de code, pas de maintenance. Thunderbit gère même les sites dynamiques, les sous-pages et les extractions planifiées dans le cloud (jusqu’à 50 pages d’un coup pour aller plus vite).

Petit comparatif rapide :

| Fonctionnalité | Extraction Python | Thunderbit (Sans code) |

|---|---|---|

| Temps de mise en place | Heures (installation, code) | Minutes (installation extension) |

| Compétence technique | Python, HTML, débogage | Aucune—juste le navigateur |

| Gère les sites dynamiques | Oui (avec Selenium) | Oui (automatisation IA du navigateur) |

| Maintenance | Tu répares les scripts | L’IA s’adapte, aucune maintenance |

| Export de données | Code vers CSV/Excel | 1 clic vers Sheets/Notion/etc. |

| Automatisation | Tâches planifiées, serveurs | Planification intégrée |

| Coût | Gratuit, mais chronophage | Gratuit de base, paiement à l’usage |

Envie de voir Thunderbit en action ? et teste l’extraction sur ton site préféré. Tu vas halluciner sur le temps gagné !

Démo pratique : extraire et analyser des avis de films IMDB avec Python

Passons à la pratique avec un vrai projet : extraire des avis de films sur IMDB et faire une analyse de sentiment.

Étape 1 : Extraire les avis sur IMDB

On utilise requests et BeautifulSoup pour récupérer les avis du film « Les Évadés » :

1import requests

2from bs4 import BeautifulSoup

3review_url = "https://www.imdb.com/title/tt0111161/reviews"

4response = requests.get(review_url)

5soup = BeautifulSoup(response.content, 'html.parser')

6reviews = soup.find_all('div', class_='text show-more__control')

7for review in reviews[:3]:

8 print(review.get_text()[:100], "...")Ce script affiche les 100 premiers caractères de chaque avis.

Étape 2 : Analyse de sentiment avec TextBlob

On analyse maintenant le sentiment de chaque avis :

1from textblob import TextBlob

2for review in reviews[:5]:

3 text = review.get_text()

4 blob = TextBlob(text)

5 sentiment = blob.sentiment.polarity

6 sentiment_label = "positif" if sentiment > 0 else "négatif" if sentiment < 0 else "neutre"

7 print(f"Extrait d’avis : {text[:60]}...")

8 print(f"Score de sentiment : {sentiment:.2f} ({sentiment_label})\n")Tu obtiendras un résultat du genre :

1Extrait d’avis : "Un des films les plus inspirants que j’aie jamais vus. Les pre..."

2Score de sentiment : 0.65 (positif)En quelques lignes de Python, tu extraits des données réelles et tu fais une première analyse—imagine ce que tu pourrais faire avec des milliers d’avis !

Guide pas à pas : ton premier projet de Web Scraping Python

Envie de te lancer ? Voici un plan simple pour démarrer :

- Choisis un site cible : Prends un site statique simple (ex : ).

- Prépare ton environnement : Installe Python, ton IDE et les bibliothèques (

pip install requests beautifulsoup4). - Inspecte le HTML : Utilise l’outil d’inspection du navigateur pour repérer où sont les données (balises, classes).

- Écris ton script : Récupère la page, analyse-la avec Beautiful Soup, extrais les données.

- Gère la pagination : Si le site a plusieurs pages, boucle dessus.

- Stocke les données : Enregistre-les en CSV ou Excel avec le module

csvoupandas. - Peaufine et teste : Ajoute la gestion des erreurs, des commentaires, et teste sur différentes pages.

- Automatise (optionnel) : Planifie ton script avec un cron ou le planificateur de tâches Windows.

Petit conseil : Commence petit et avance étape par étape. Débogue au fur et à mesure—affiche le HTML, vérifie tes sélecteurs, et n’hésite pas à chercher les messages d’erreur sur Google (on le fait tous !).

Web Scraping Python vs. outils sans code : quel choix pour toi ?

Faut-il coder son propre extracteur ou utiliser un outil sans code comme Thunderbit ? Voici un guide rapide pour t’aider à choisir :

| Critère | Script Python | Thunderbit (Sans code) |

|---|---|---|

| Compétence technique | Requise | Aucune |

| Logique personnalisée | Illimitée | L’IA gère les cas standards |

| Maintenance | Tu corriges le code | L’IA s’adapte, rien à corriger |

| Échelle | Élevée (avec effort) | Élevée (avec extraction cloud) |

| Vitesse d’obtention | Plus lent (installation, code) | Instantané (2 clics) |

| Export de données | Code vers CSV/Excel | 1 clic vers Sheets/Notion/etc. |

| Coût | Gratuit, mais chronophage | Gratuit de base, paiement à l’usage |

Choisis Python si : tu as besoin de logique sur-mesure, d’intégration à d’autres scripts, ou si tu cibles des sites très complexes.

Prends Thunderbit si : tu veux des données vite, sans coder, ou pour permettre à des collègues non techniques d’accéder à l’extraction.

Points clés à retenir et prochaines étapes

- Le web scraping Python est un vrai atout pour les entreprises : puissant, flexible, soutenu par une grosse communauté.

- L’impact business est concret : génération de leads, veille tarifaire, décisions pilotées par la donnée et ROI élevé.

- Outils essentiels : commence avec requests + Beautiful Soup, puis passe à Selenium ou Scrapy si besoin.

- Pièges courants : attention aux protections anti-scraping, aux soucis d’encodage et aux changements de structure des sites.

- Les alternatives sans code comme rendent l’extraction accessible à tous—sans code, sans prise de tête, export instantané.

- Teste les deux : fais un petit extracteur Python pour apprendre, et essaie Thunderbit pour la rapidité et la simplicité.

Envie d’aller plus loin ? Voici quelques ressources utiles :

- pour plus de tutos et d’astuces

- pour tester l’extraction sans code dès aujourd’hui

Bonne extraction—et que tes données soient toujours propres, bien rangées et prêtes à l’emploi !

FAQ

1. C’est quoi le web scraping en Python ?

L’extraction web en Python, c’est utiliser des scripts Python pour collecter automatiquement des données sur des sites. Ça veut dire envoyer des requêtes HTTP, télécharger le HTML, l’analyser pour extraire les infos voulues, puis tout sauvegarder dans un format structuré.

2. Quelles sont les meilleures bibliothèques Python pour le web scraping ?

Les plus connues sont requests (pour récupérer les pages), Beautiful Soup (pour analyser le HTML), Selenium (pour automatiser le navigateur) et Scrapy (pour l’extraction asynchrone à grande échelle).

3. Comment gérer les sites qui bloquent les extracteurs ?

Utilise des headers user-agent réalistes, ajoute des pauses entre les requêtes, fais tourner les proxies, et pense à l’automatisation du navigateur (Selenium) pour les sites dynamiques ou protégés. Reste toujours dans l’éthique et respecte les règles des sites.

4. Quelle est la différence entre l’extraction Python et Thunderbit ?

L’extraction Python demande du code et de la maintenance, mais offre une flexibilité maximale. est une extension Chrome IA sans code qui permet à tout le monde d’extraire des données en 2 clics, avec export instantané vers Sheets, Notion, etc.—sans code ni maintenance.

5. Je peux automatiser les tâches de web scraping ?

Oui ! Avec Python, tu peux planifier tes scripts avec cron ou le planificateur de tâches. Avec Thunderbit, tu peux programmer des extractions en langage naturel, et le cloud s’occupe de tout—pas besoin de serveur ni de code.

Prêt à transformer le web en source de données ? ou lance ton premier script Python dès aujourd’hui. Et si tu veux aller plus loin, le regorge de guides, d’astuces et d’inspiration pour toutes tes aventures data.

Pour aller plus loin