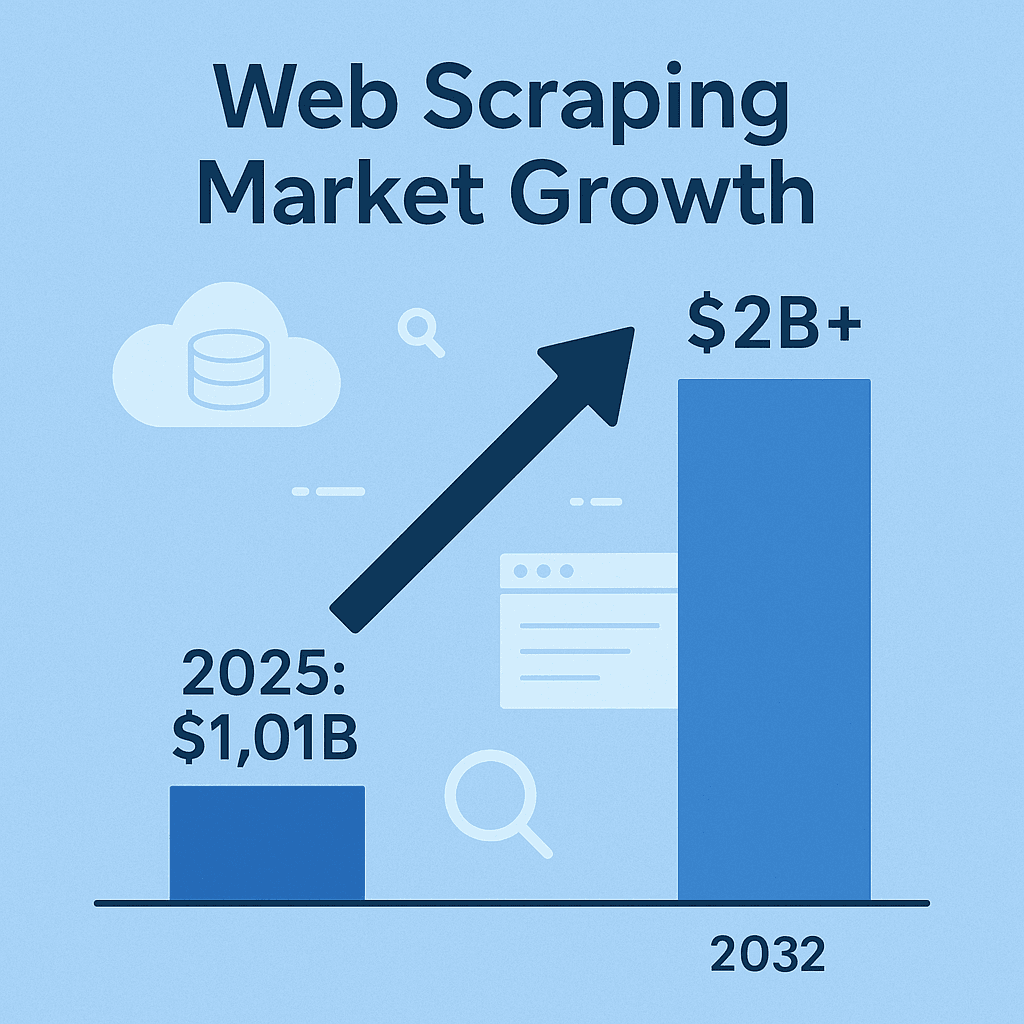

L’extraction web, c’est un peu le secret bien gardé des pros de la veille, des commerciaux et de tous ceux qui veulent garder une longueur d’avance sur le marché. Aujourd’hui, si tu ne récupères pas de données en ligne — que ce soit les prix des concurrents, des catalogues produits, des avis clients ou des leads — tu rates sûrement des infos que tes rivaux exploitent déjà. Le secteur des logiciels d’extraction web pèse déjà , et il va plus que doubler d’ici 2032. Ce n’est pas juste une mode geek, c’est un vrai raz-de-marée. Et même si Python fait beaucoup de bruit, Java reste le chouchou des équipes qui veulent du solide, du rapide et de l’intégration à grande échelle.

Avec plusieurs années dans le SaaS et l’automatisation derrière moi, je peux te le confirmer : l’extraction web en Java, c’est toujours d’actualité, surtout dans les boîtes où la stabilité, le multithreading et l’intégration big data sont la base. Mais attention, extraire des données, ce n’est pas juste les récupérer. Il faut le faire proprement, efficacement et — sauf si tu veux recevoir un mail du service juridique — dans les règles. Allez, on retrousse les manches et on voit ensemble comment cartonner en extraction web avec Java, que tu codes tes propres extracteurs ou que tu veuilles booster ta productivité avec des outils IA comme .

Comprendre l’extraction web en Java : ce qu’il faut capter

En gros, l’extraction web c’est automatiser la collecte d’infos sur des sites. Ton code envoie une requête HTTP à une page, récupère le HTML, fouille dedans pour choper ce qui t’intéresse (prix, noms de produits, avis, etc.), puis balance tout ça dans un format pratique — CSV, JSON ou direct dans une base de données ().

Pourquoi Java ? Si Python est top pour des scripts vite faits, Java s’impose quand il faut du costaud, du long terme, du gros volume. Son typage fort, sa robustesse et son écosystème blindé de bibliothèques pour le réseau, le parsing HTML et la gestion de la concurrence en font un allié de choix. Et si ta stack data ou ton pipeline est déjà en Java, l’intégration se fait les doigts dans le nez ().

En résumé : un extracteur Java peut tourner des jours, gérer des montagnes de données et s’intégrer nickel à ton infra. Mais encore faut-il choisir les bons outils au bon moment.

Tour d’horizon des outils et bibliothèques Java pour l’extraction web

Passons au concret. Voici les bibliothèques Java les plus utilisées pour l’extraction web, avec leurs points forts et leurs limites :

| Outil | Idéal pour | Points forts | Limites |

|---|---|---|---|

| Jsoup | Pages HTML statiques, extraction rapide | Léger, API intuitive, rapide, parfait pour les tâches simples | Ne gère pas le JavaScript ni les contenus dynamiques |

| Selenium | Sites dynamiques et interactifs | Automatisation de vrais navigateurs, gère le JS, actions utilisateur, grande communauté | Gourmand en ressources, plus lent, fragile si l’UI change, nécessite des drivers de navigateur |

| HtmlUnit | Navigation headless, JS modéré | 100% Java, exécute certains JS, pas besoin de navigateur externe | Plus lent que Jsoup, support limité des frameworks JS modernes, pas d’anti-blocage intégré |

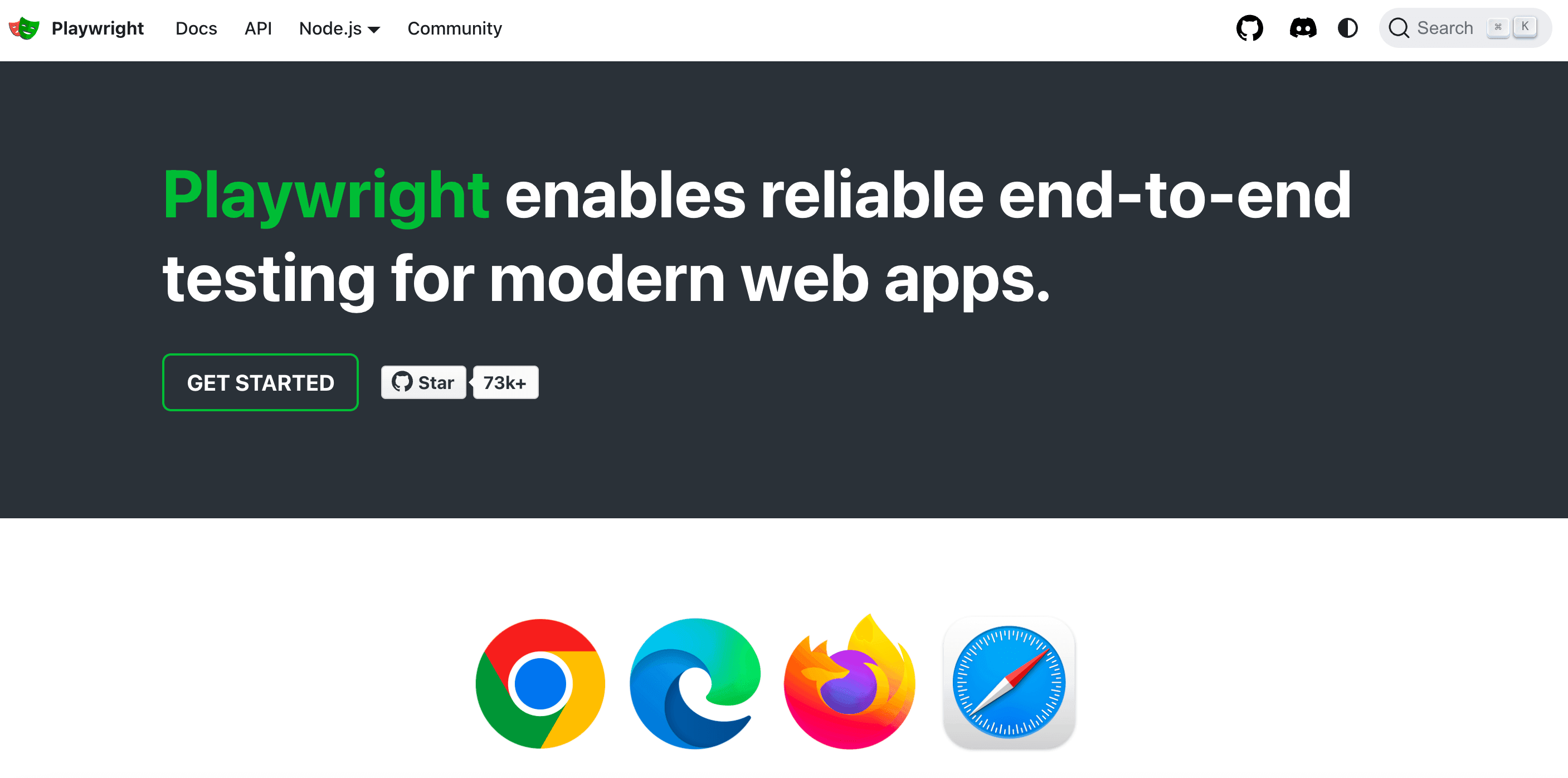

| Playwright | Sites modernes riches en JS, automatisation | Rapide, efficace, multi-navigateurs, gère pop-ups et parcours multi-pages, auto-attente | Écosystème plus récent, nécessite des ressources navigateur, moins natif en Java que Selenium |

(, )

Jsoup : la star pour l’extraction HTML statique

c’est l’outil incontournable pour extraire des données de pages statiques en Java. C’est un peu le jQuery du Java : tu récupères la page avec Jsoup.connect(URL).get(), puis tu utilises des sélecteurs CSS pour viser ce que tu veux. Tous les titres <h1> ? Fastoche. Les noms de produits dans un <div class="product-name"> ? Trois lignes et c’est plié.

Exemple : extraire les noms de produits d’une page e-commerce

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoup, c’est rapide, simple et parfait pour extraire des articles de blog, des catalogues produits ou des news. Mais attention : il ne gère pas le JavaScript. Si la donnée n’est pas dans le HTML de base, Jsoup ne la verra pas.

Selenium et HtmlUnit : pour les sites dynamiques

Parfois, les infos sont chargées via JavaScript ou cachées derrière des clics (genre un bouton « Charger plus »). C’est là que brille. Selenium permet à ton code Java de piloter un vrai navigateur (Chrome, Firefox, etc.), d’interagir avec la page et de récupérer le contenu comme un humain.

HtmlUnit, c’est l’alternative plus légère, 100% Java, qui peut exécuter un peu de JS, mais il galère vite sur les sites modernes blindés de JS. Pour du dynamique simple, ça passe, mais pour du React ou Angular, vise plutôt Selenium ou Playwright.

Quand utiliser un navigateur headless : Si tu dois te connecter, cliquer ou extraire du contenu généré à la volée, l’automatisation de navigateur est la solution. Mais attends-toi à des perfs moindres et plus de maintenance : les sites changent souvent.

Playwright : la nouvelle référence de l’automatisation

c’est la solution qui monte, développée par Microsoft, pensée pour la rapidité et la fiabilité. Jusqu’à 40–50% plus rapide que Selenium, il gère plusieurs moteurs de navigateur et s’occupe sans souci des pop-ups, du scroll infini ou des parcours multi-pages. Pour les sites modernes générés côté client, Playwright vaut vraiment le détour.

Choisir le bon outil d’extraction web Java selon ton projet

Chaque projet a ses besoins. Voici comment t’y retrouver :

- Complexité du site : HTML statique ? Jsoup. JavaScript dynamique ? Selenium ou Playwright. Un peu de JS mais pas trop ? HtmlUnit peut suffire.

- Volume et fréquence : Extraction ponctuelle ? Reste simple. Gros volumes ou tâches récurrentes ? Prends des outils qui gèrent le multithreading et les erreurs.

- Simplicité vs flexibilité : Jsoup s’apprend vite. Selenium/Playwright sont plus puissants, mais demandent plus de config.

- Contraintes et budget : Les bibliothèques open source sont gratos mais tout est à ta charge. Les API ou services cloud font gagner du temps, mais coûtent un peu.

Tableau de décision :

| Critère | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| HTML statique | ✔️ | ✔️ | ||

| JS dynamique | ✔️ | (limité) | ✔️ | |

| Rapidité | ✔️ | ✔️ | ||

| Facilité d’utilisation | ✔️ | |||

| Gère logins/clics | ✔️ | (basique) | ✔️ | |

| Gros volumes/Parallèle | ✔️ | (plus dur) | (ok) | ✔️ |

| Économique | ✔️ | ✔️ | ✔️ | ✔️ |

Commence simple, monte en puissance si besoin. Et n’hésite pas à mixer plusieurs outils : parfois, la meilleure solution, c’est un combo.

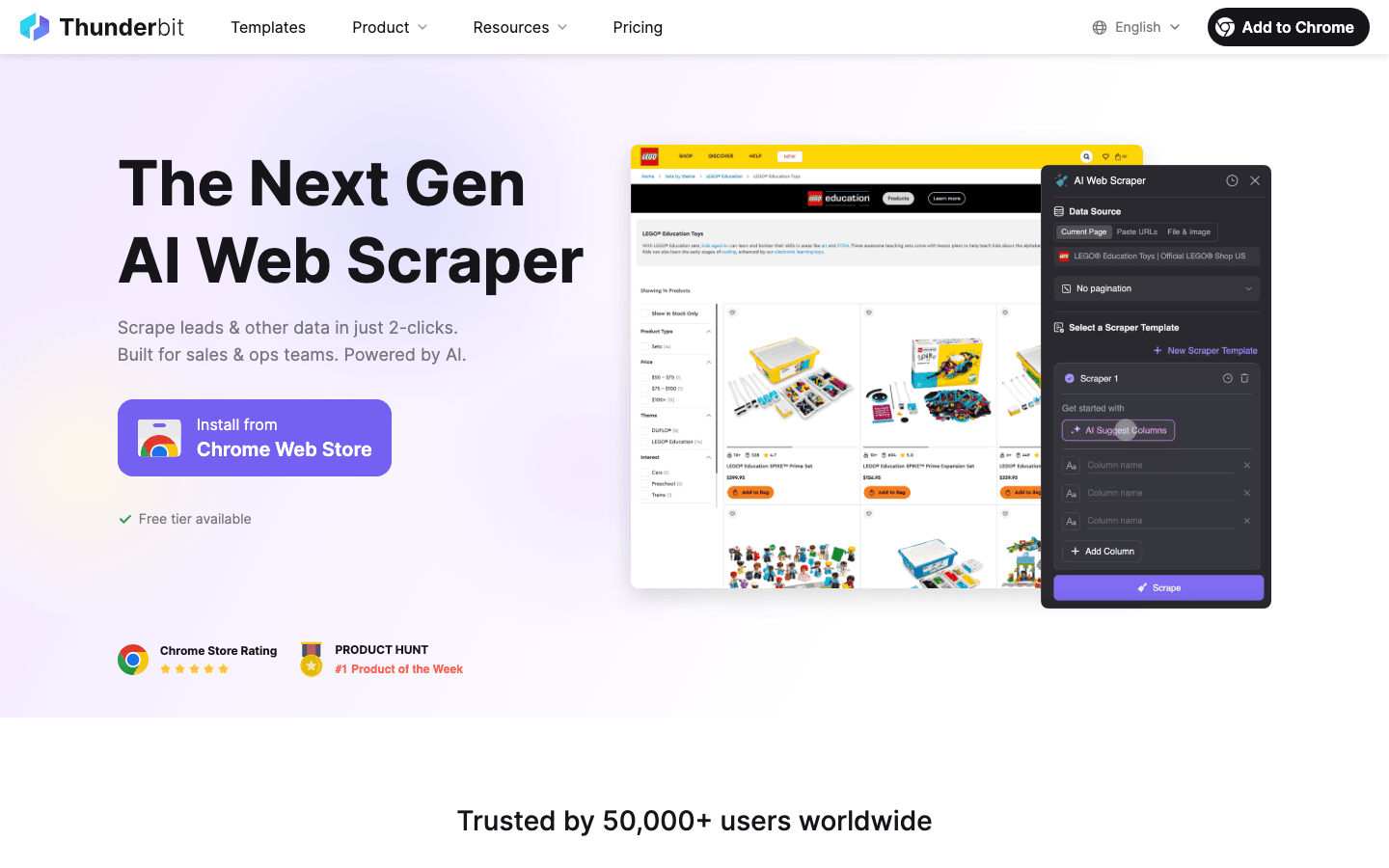

Thunderbit : l’extraction web simplifiée pour les devs Java

Parlons de ce qui a changé la donne pour plein d’équipes : . Thunderbit, c’est une extension Chrome d’extracteur web IA qui te permet d’extraire des données structurées de n’importe quel site en quelques clics — sans code, sans modèles, sans prise de tête.

Comment Thunderbit booste les devs Java et les équipes métier :

- Champs suggérés par l’IA : L’IA de Thunderbit analyse la page et propose direct les colonnes à extraire. Fini la galère des sélecteurs CSS ou du code fragile.

- Navigation sur sous-pages : Besoin d’infos sur des pages liées ? Thunderbit clique tout seul sur les sous-pages et enrichit ton dataset — parfait pour les fiches produits détaillées.

- Gestion de la pagination et du scroll infini : Thunderbit scrolle, clique sur « Suivant » et continue jusqu’à tout récupérer.

- Export structuré : Exporte direct vers Excel, Google Sheets, Airtable ou Notion. Ou télécharge en CSV/JSON pour alimenter ton appli Java.

- Extraction cloud ou navigateur : Lance tes extractions dans le cloud (jusqu’à 50 pages d’un coup, super rapide !) ou dans ton navigateur pour les sites qui demandent une connexion.

- Planification : Programme tes extractions tous les jours, chaque semaine ou comme tu veux. L’IA de Thunderbit comprend même les instructions en langage naturel (« chaque lundi à 9h »).

Pour les devs Java, Thunderbit fait gagner un temps fou pour prototyper, collecter vite des données ou même automatiser des workflows en prod — surtout si tu veux rendre tes collègues non techniques autonomes sur la collecte.

Thunderbit : le trait d’union entre équipes commerciales et opérationnelles

Thunderbit, ce n’est pas que pour les devs. Les équipes commerciales, marketing, e-commerce ou immo l’utilisent tous les jours pour :

- Générer des leads : Extraire des contacts depuis des annuaires, LinkedIn ou des listes d’événements — sans coder.

- Surveiller la concurrence : Suivre les prix, les catalogues ou les stratégies marketing des concurrents grâce à des extractions programmées.

- Centraliser les annonces : Rassembler des offres produits, immobilières ou d’emploi de plusieurs sites dans un tableau structuré.

J’ai vu des équipes passer de « il nous faudrait ces données » à « voilà le fichier » en moins de 10 minutes. Grâce à l’extraction sur sous-pages et à la détection intelligente des champs, même les sites les plus chaotiques deviennent exploitables.

Assurer la qualité des données dans tes projets d’extraction Java

Récupérer des données, c’est bien. Mais si elles sont incomplètes, obsolètes ou mal formatées, tu avances à l’aveugle. Voici mes tips pour garder tes extracteurs (et ta tranquillité) sous contrôle :

- Valider et nettoyer : Vérifie l’exactitude, la complétude et la cohérence. Profite du typage fort de Java pour repérer les valeurs bizarres (genre un prix « N/A » au lieu d’un chiffre). Uniformise les formats (dates, devises, numéros) pour faciliter l’analyse ().

- Dédupliquer : Les doublons, c’est courant. Utilise des clés uniques (URL, ID) et les collections

Setde Java pour les virer. - Automatiser les contrôles qualité : Après chaque extraction, vérifie le nombre d’éléments, la présence de champs vides, etc. Loggue les anomalies et mets des alertes si besoin.

- Stocker intelligemment : Pour les gros volumes, stocke dans une base de données (Postgres, MongoDB, etc.) plutôt qu’en mémoire. Ça facilite la gestion du schéma et la déduplication ().

Gestion des erreurs et robustesse : des extracteurs qui tiennent la route

L’extraction web, c’est du sport : sites down, HTML qui change, anti-bots… Voici comment éviter que ton extracteur ne plante au premier pépin :

- Gestion élégante des erreurs : Intercepte les erreurs HTTP (404, 500), les timeouts, les exceptions de parsing. Relance les requêtes ratées avec un backoff exponentiel — évite de spammer le serveur ().

- Résilience aux changements : Utilise des sélecteurs solides, des vérifs de nullité et des plans B. Si la structure change, loggue le HTML brut pour le debug.

- Logs et alertes : Trace chaque requête, succès et échec. Déclenche des alertes en cas de souci critique (genre zéro résultat alors que tu en attendais 100).

- Sauvegarde intermédiaire : Pour les longues extractions, sauvegarde régulièrement la progression. En cas de crash, tu reprends là où tu t’es arrêté.

- Limiter la fréquence : Sois cool : fais des pauses entre les requêtes, limite la concurrence, varie les User-Agent pour éviter la détection.

Exemple de logique de retry en Java :

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("Tentative " + attempt + " échouée : " + e.getMessage());

8 Thread.sleep(1000 * attempt); // Backoff exponentiel

9 }

10}()

Rester dans les clous : aspects légaux et éthiques de l’extraction web

L’extraction web, ce n’est pas le Far West. Il y a des règles — les zapper, c’est risquer le ban, voire pire.

- Respecter la propriété des données : Extraire des données publiques et non sensibles, c’est généralement ok, mais les données perso (noms, emails) sont protégées par des lois comme le RGPD ou le CCPA. N’extrais pas de données perso sans base légale ().

- Respecter les CGU et robots.txt : Si un site interdit l’extraction, respecte-le — ou assume le risque. Suis toujours robots.txt et les limites de fréquence.

- Ne pas surcharger les serveurs : Limite la fréquence, la concurrence, et n’extrais jamais au point de faire ramer le site ().

- Éviter les contenus protégés ou derrière login : N’extrais pas et ne republie pas de contenus sous copyright, et n’accède pas à des données derrière authentification sans autorisation.

- Sécuriser et anonymiser les données : Si tu collectes des infos sensibles, stocke-les de façon sécurisée et respecte les demandes de suppression.

Conseils pratiques pour une extraction web clean

- Lis les CGU et robots.txt avant de te lancer.

- Utilise un User-Agent explicite (évite « Java/1.8.0_201 »).

- Limite la fréquence et la concurrence des requêtes.

- Privilégie les API ou jeux de données publics si dispo.

- Garde une trace de ce que tu extrais et pourquoi.

- Reste à jour sur les lois et bonnes pratiques ().

Booster les perfs : passer à l’échelle avec Java

Quand tes besoins d’extraction grossissent, la perf devient clé. Voici comment scaler sans te prendre la tête (ni saturer le serveur cible) :

- Paralléliser les requêtes : Utilise

ExecutorServiceou des pools de threads pour traiter plusieurs pages en même temps. Contrôle la concurrence pour ne pas surcharger le site (). - Streamer les données : Écris les résultats dans une base ou un fichier au fil de l’eau, évite de tout garder en mémoire.

- Parsing efficace : Utilise les sélecteurs Jsoup pour viser juste. Pour les très gros volumes, pense au parsing en streaming ou plus léger.

- Exploiter le cloud : Lance tes extracteurs sur des serveurs cloud pour plus de bande passante et de fiabilité. Ou utilise des plateformes cloud d’extraction (comme le mode cloud de Thunderbit) pour les gros volumes.

- Optimiser le réseau : Utilise la compression, place tes extracteurs au plus près des cibles, et mets en cache quand tu peux.

Exemple d’extraction multi-threadée en Java :

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();()

En résumé : les clés pour réussir ton extraction web en Java

Petit récap’ pour cartonner en extraction web avec Java :

- Choisis le bon outil : Jsoup pour les pages statiques, Selenium/Playwright pour les sites dynamiques, HtmlUnit pour une extraction headless en Java.

- Mise sur l’automatisation et l’IA : Utilise des outils comme pour accélérer la détection des champs, l’extraction sur sous-pages et l’export des données — parfait pour les équipes métier ou le prototypage rapide.

- Priorise la qualité des données : Valide, nettoie, déduplique et stocke intelligemment tes données.

- Reste dans les clous : Respecte les règles légales et éthiques — extrais des données publiques, suis les règles des sites, évite les données perso sans base légale.

- Optimise pour l’échelle : Exploite la concurrence Java, le stockage efficace et le cloud pour gérer les gros volumes.

L’extraction web, ce n’est pas juste une compétence technique : c’est un vrai levier business. Que tu sois dev Java ou pro des ventes/ops qui utilise Thunderbit pour automatiser la collecte, appliquer ces bonnes pratiques t’assurera réussite et tranquillité.

Envie de tester l’extraction boostée à l’IA ? et découvre à quel point c’est simple de transformer n’importe quel site en jeu de données structuré. Pour aller plus loin, checke le pour d’autres tutos, comparatifs et retours d’expérience.

FAQ

1. Pourquoi Java reste-t-il un super choix pour l’extraction web ?

Java, c’est la fiabilité, la gestion avancée du multithreading et l’intégration fluide avec les systèmes d’entreprise. Parfait pour les extractions à grande échelle, longues ou qui demandent de la perf — surtout si ta data pipeline est déjà en Java ().

2. Quelle différence entre Jsoup, Selenium, HtmlUnit et Playwright ?

Jsoup, c’est pour le HTML statique ; Selenium et Playwright gèrent les sites dynamiques blindés de JS ; HtmlUnit, c’est un navigateur headless 100% Java pour du JS modéré. À choisir selon la complexité du site et tes besoins ().

3. Comment Thunderbit aide les devs Java et les équipes métier ?

Thunderbit utilise l’IA pour automatiser la détection des champs, la navigation sur sous-pages et la structuration des données — sans code. Parfait pour les équipes métier ou les devs qui veulent prototyper ou rendre la collecte accessible à tous ().

4. Quelles sont les bonnes pratiques pour garantir la qualité des données extraites ?

Valide et nettoie les données, vire les doublons, automatise les contrôles qualité et stocke les résultats en base pour les gros volumes. Considère toujours les données extraites comme une matière brute à traiter ().

5. Comment rester clean et éthique lors de l’extraction de données web ?

N’extrais que des données publiques et non sensibles ; respecte robots.txt et les CGU ; ne surcharge pas les serveurs ; n’extrais pas de données perso sans base légale. Reste à jour sur les lois comme le RGPD ou le CCPA ().

Prêt à passer à la vitesse supérieure ? Teste gratuitement Thunderbit, ou développe ton propre extracteur Java en suivant ces bonnes pratiques. Bonne extraction — et souviens-toi : code avec responsabilité, extrais dans les règles, et vérifie toujours tes données avant de prendre des décisions importantes.

Pour aller plus loin