Imagine un peu la scène : tu viens de mettre en ligne ton site web, prêt à accueillir une vague de nouveaux visiteurs, et là, tu découvres que la moitié de ton trafic… ce sont des robots. Pas des robots façon science-fiction, mais bien des crawlers numériques : moteurs de recherche, bots d’IA, spiders d’analytique – tous en train d’arpenter ton site, jour et nuit, comme une armée d’invités invisibles qui ne s’arrête jamais. En 2026, ce n’est plus juste une bizarrerie dans tes logs serveurs : c’est devenu la routine. Savoir qui (ou quoi) crawle ton site, à quelle fréquence et pourquoi, c’est devenu vital pour toute activité en ligne.

Après avoir passé des années dans le SaaS, l’automatisation et l’IA, j’ai vu le crawling web passer du statut de détail technique à enjeu business incontournable. Les chiffres donnent le tournis : aujourd’hui, les bots représentent quasiment la moitié du trafic internet, et parfois ils dépassent même les humains. Avec la montée en puissance des crawlers IA qui aspirent le contenu pour entraîner des modèles de langage, les enjeux n’ont jamais été aussi importants – pour ton infrastructure, ton budget et ton image de marque. On va plonger ensemble dans les dernières statistiques crawling web, les repères du secteur, et ce que ça veut dire pour ton business en 2026.

Le crawling web en 2026 : panorama du secteur

Le crawling web a pris une toute autre dimension, que ce soit en volume ou en complexité. Chaque jour, des milliards de requêtes automatisées circulent sur le web, générées par une multitude de crawlers. À la base, c’étaient surtout les bots des moteurs de recherche comme Googlebot ou Bingbot qui menaient la danse, indexant les pages pour les résultats de recherche. Mais aujourd’hui, ils sont rejoints par une nouvelle vague : crawlers IA, extracteurs de réseaux sociaux, bots d’analytique, et bien d’autres.

Le chiffre à retenir : , et dans certaines zones, le trafic des bots dépasse même celui des humains. Sur le réseau Cloudflare, . Et ce n’est pas tout : cette explosion ne vient plus seulement des moteurs de recherche, mais de plus en plus des crawlers IA qui collectent des données pour nourrir les derniers chatbots et outils génératifs.

Le paysage est plus varié que jamais :

- Bons bots : indexeurs de recherche, moniteurs de disponibilité, extracteurs de données légitimes.

- Mauvais bots : spam, tentatives de piratage, scraping non autorisé.

- Crawlers IA : les nouveaux venus, qui collectent du contenu pour entraîner l’IA ou répondre en temps réel.

Les crawlers IA ne se comportent pas tout à fait comme les bots classiques des moteurs de recherche. Ils peuvent aspirer tout le contenu d’une page pour l’analyser sémantiquement, pas juste pour indexer des mots-clés, et ils opèrent souvent à très grande échelle – certains sites reçoivent des millions de requêtes en quelques jours. Résultat ? , mélangeant indexation classique et appétit insatiable de l’IA pour les données.

Statistiques clés du crawling web à connaître en 2026

Passons aux chiffres qui dessinent le web en 2026. Ce ne sont pas de simples anecdotes : ce sont des repères pour orienter ton infrastructure, ta stratégie de contenu et tes choix business.

Bots vs humains : qui domine le trafic ?

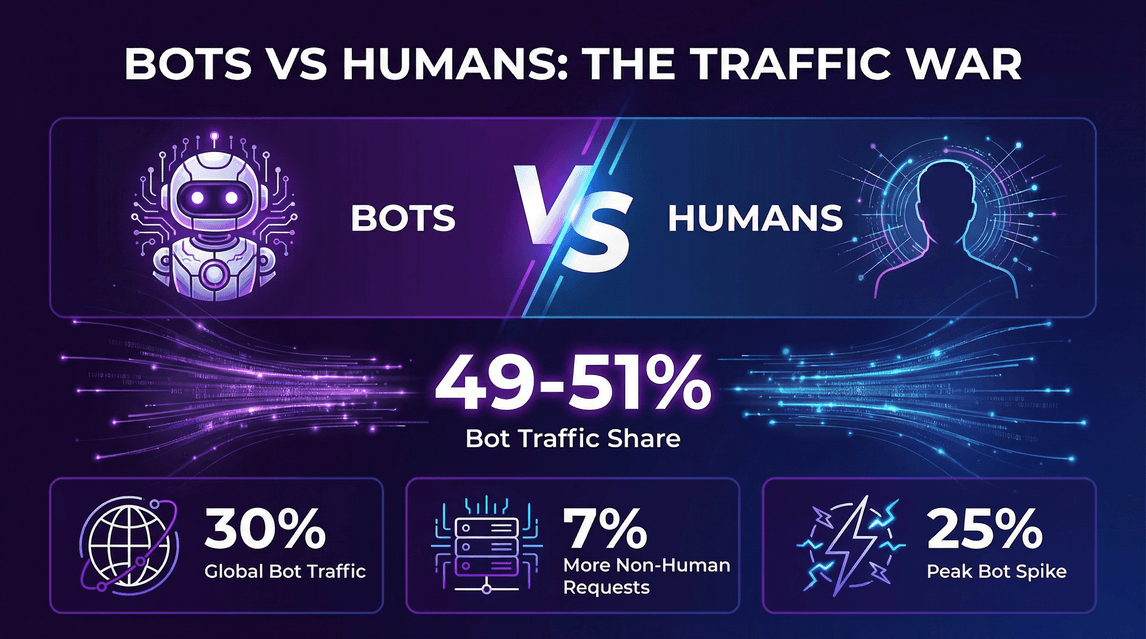

- 49 à 51 % du trafic internet est aujourd’hui généré par des bots, les requêtes automatisées égalant ou dépassant parfois les visites humaines ().

- Données Cloudflare : .

- Les requêtes non humaines vers les pages HTML étaient environ 7 % plus nombreuses que celles des humains ().

- À certains moments, le trafic des bots .

L’explosion des crawlers IA

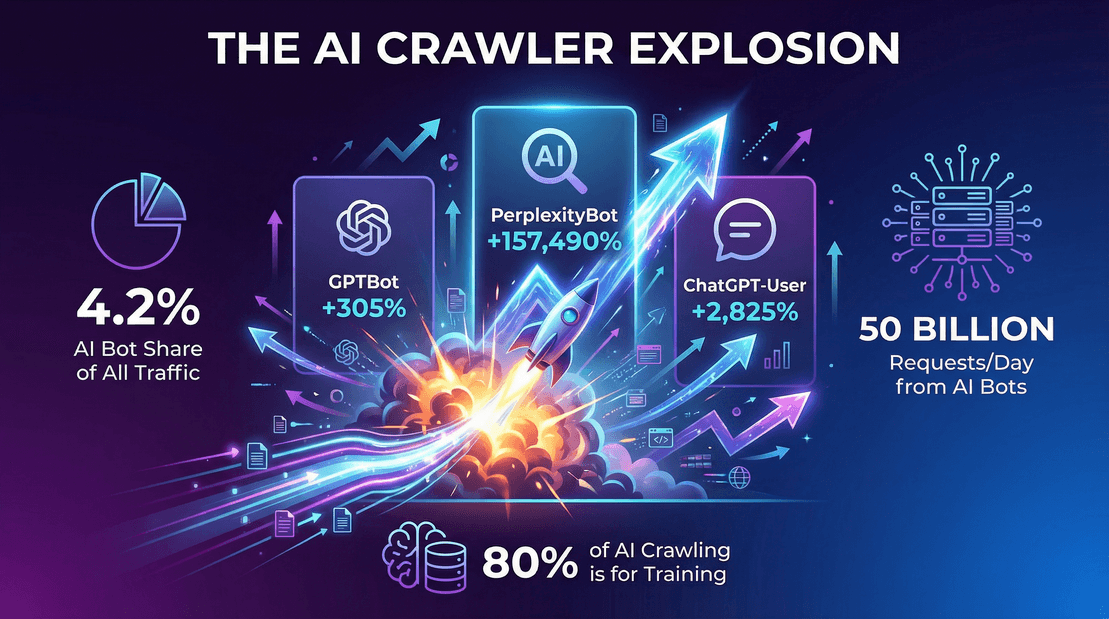

- Les bots IA représentaient 4,2 % de toutes les requêtes HTML en 2025 ().

- GPTBot d’OpenAI : est passé de zéro à , soit une croissance de 305 % en un an.

- Bot de Perplexity.ai : .

- Googlebot : , représentant environ 50 % de toutes les requêtes de crawlers de recherche/IA.

Trafic des crawlers : un exemple concret

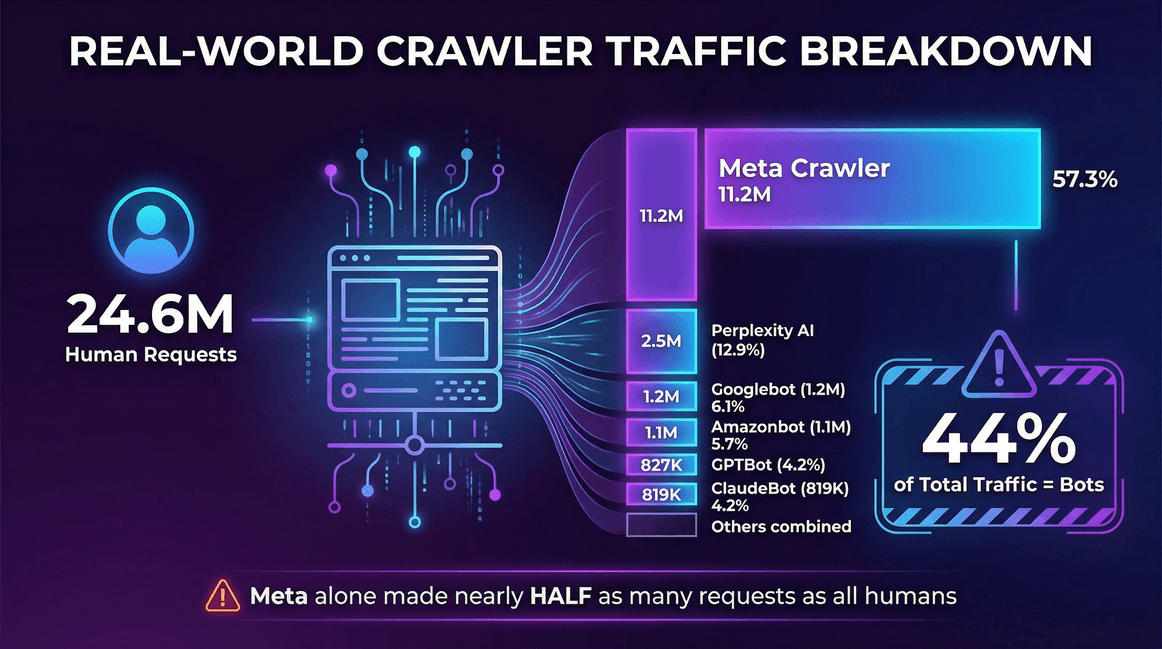

Voici un exemple réel tiré des logs serveur d’un :

| Source de trafic | Requêtes (mensuel) | Part des crawlers |

|---|---|---|

| Utilisateurs réels (humains) | 24 647 904 | -- |

| Meta Crawler (Facebook) | 11 175 701 | 57,3 % |

| Perplexity AI | 2 512 747 | 12,9 % |

| Googlebot | 1 180 737 | 6,1 % |

| Amazonbot | 1 120 382 | 5,7 % |

| OpenAI GPTBot | 827 204 | 4,2 % |

| ClaudeBot (Anthropic) | 819 256 | 4,2 % |

| Bingbot | 599 752 | 3,1 % |

| ChatGPT-User (OpenAI) | 557 511 | 2,9 % |

| Ahrefs Crawler | 449 161 | 2,3 % |

| ByteDance Spider | 267 393 | 1,4 % |

Sur ce site, les bots représentaient 44 % du trafic total – et le crawler de Meta à lui seul a généré presque autant de requêtes que tous les utilisateurs humains réunis.

Vue d’ensemble

- Le trafic des crawlers (recherche + IA) a augmenté de 18 % entre mai 2024 et mai 2025 sur un panel constant de sites ().

- Les bots d’entraînement LLM représentaient près de 80 % de tout le trafic “bot” sur certains grands CDN ().

- Le réseau Cloudflare a enregistré environ 50 milliards de requêtes de crawlers IA par jour fin 2025 ().

L’essor des crawlers IA : comment l’IA transforme le crawling web

Parlons de l’éléphant (ou plutôt du robot) dans la pièce : les crawlers IA. Ces bots ne se contentent plus d’indexer ton site pour la recherche – ils aspirent le contenu pour entraîner des modèles de langage ou fournir des réponses instantanées boostées à l’IA. Et ils le font à une échelle qui ferait pâlir n’importe quel moteur de recherche.

Qu’est-ce qui alimente la vague des crawlers IA ?

- Des modèles IA ultra gourmands en données : Les LLM modernes ont besoin d’énormes volumes de données variées. Le web est leur terrain de jeu, et ton contenu en fait partie.

- Entraînement vs réponses en temps réel : , pas seulement à répondre à des requêtes en direct.

- Nouveaux schémas de crawl : Les bots IA peuvent frapper fort, en crawlant des millions de pages en quelques jours, surtout lors de la mise à jour ou du réentraînement des modèles.

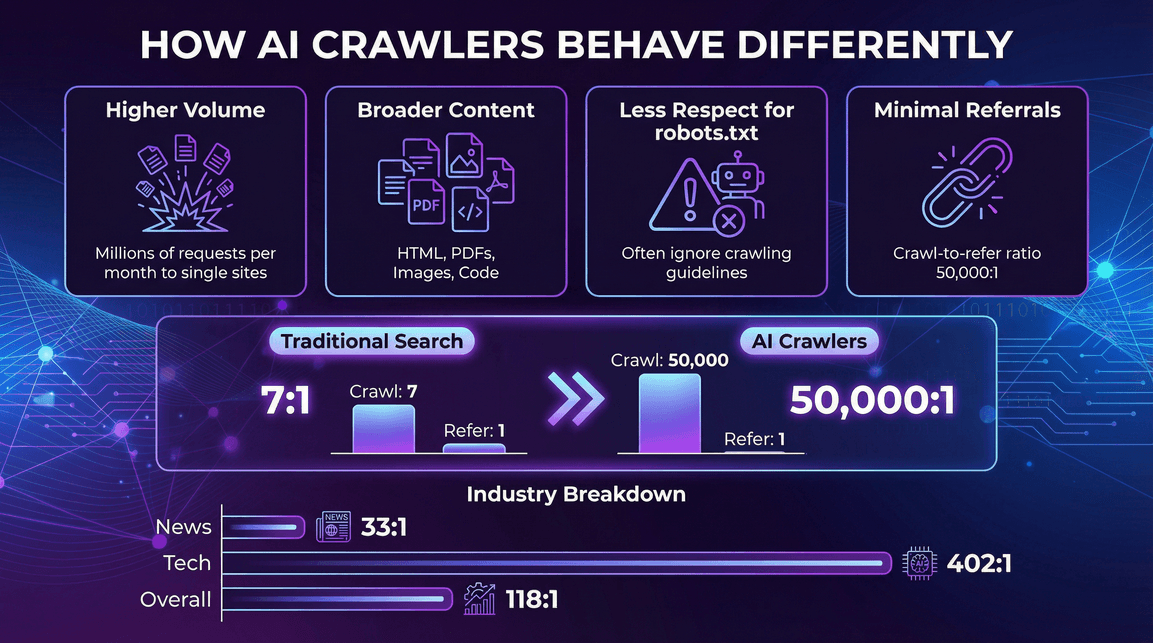

Les spécificités du comportement des crawlers IA

- Volume de requêtes énorme : Un seul bot IA peut générer des millions de requêtes par mois sur un site ().

- Types de contenus plus larges : Pas seulement du HTML – aussi des PDF, images, code, etc.

- Respect limité du robots.txt : Certains crawlers IA ignorent ou n’appliquent que partiellement les consignes de crawl ().

- Peu de trafic référent : Contrairement aux moteurs de recherche, les crawlers IA renvoient rarement des visiteurs sur ton site. .

Trafic des crawlers IA par secteur

Tous les secteurs ne sont pas logés à la même enseigne face au crawling IA. Par exemple :

- Actualités & médias : Forte activité des crawlers IA, mais ratios de renvoi un peu meilleurs (ex : ratio de Perplexity de 33:1 sur les sites d’info, contre 118:1 en moyenne) ().

- Technologie & électronique : GPTBot et Amazonbot dominent, avec des ratios de renvoi toujours élevés (ex : 402:1 pour OpenAI dans la tech) ().

- Finance, éducation, etc. : Chaque secteur a son propre mix de bots et de taux de renvoi, mais la tendance est claire : les crawlers IA sont partout, et la plupart ne génèrent que peu de trafic retour.

Les principaux crawlers web en 2026 : qui domine le marché ?

Qui sont les poids lourds de ce grand bal du crawling ? Voici le classement, selon les données Cloudflare de mi-2025 :

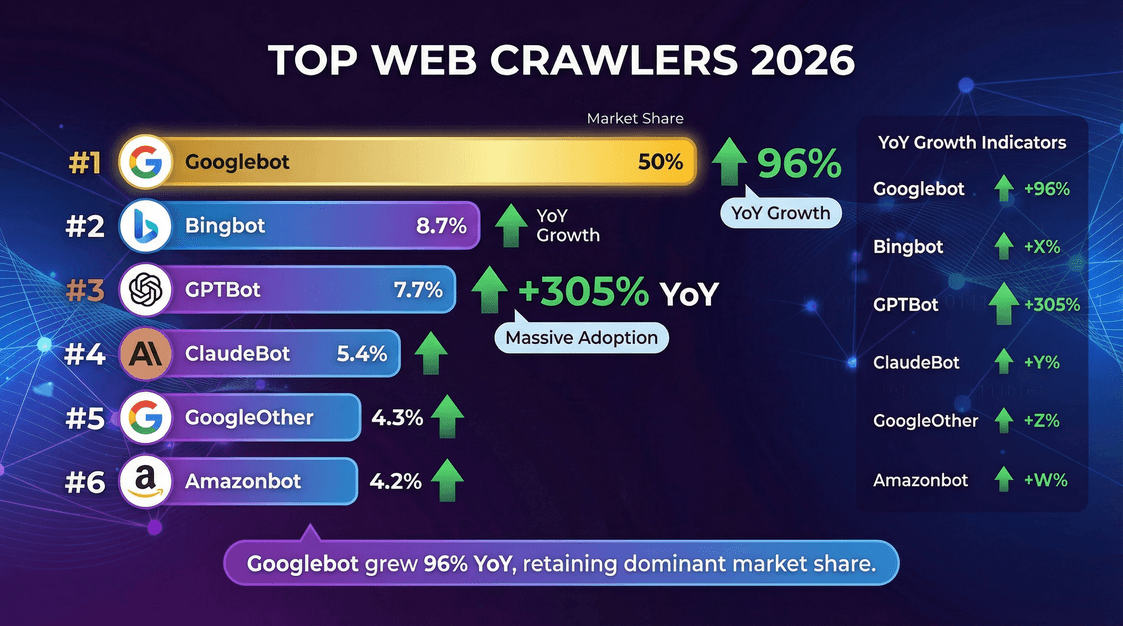

| Crawler (Propriétaire) | % des crawls (mai 2025) | Croissance annuelle |

|---|---|---|

| Googlebot (Google) | 50,0 % | +96 % |

| Bingbot (Microsoft) | 8,7 % | +2 % |

| GPTBot (OpenAI) | 7,7 % | +305 % |

| ClaudeBot (Anthropic) | 5,4 % | –46 % |

| GoogleOther (Google) | 4,3 % | +14 % |

| Amazonbot (Amazon) | 4,2 % | –35 % |

| Googlebot-Image (Google) | 3,3 % | –13 % |

| Bytespider (ByteDance) | 2,9 % | –85 % |

| YandexBot (Yandex) | 2,2 % | –10 % |

| ChatGPT-User (OpenAI) | 1,3 % | +2825 % |

| Applebot (Apple) | 1,2 % | –26 % |

| PerplexityBot | 0,2 % | +157 490 % |

À retenir :

- Googlebot reste le boss incontesté, responsable de la moitié de l’activité de crawling.

- GPTBot et le crawler de Meta sont ceux qui progressent le plus vite, avec une part de GPTBot qui a triplé en un an.

- PerplexityBot et ChatGPT-User restent petits en volume, mais leur croissance est juste hallucinante.

Repères du crawling web : vitesse, débit et performance

Le crawling web, ce n’est pas qu’une question de volume : la rapidité et l’efficacité sont tout aussi importantes. Voici les repères à connaître sur les vitesses de crawl et la performance en 2026.

Le crawling web, ce n’est pas qu’une question de volume : la rapidité et l’efficacité sont tout aussi importantes. Voici les repères à connaître sur les vitesses de crawl et la performance en 2026.

Vitesse de crawl : à quelle cadence les crawlers explorent-ils les pages ?

- La vitesse de crawl se mesure généralement en pages/seconde (ou requêtes/seconde) ().

- Threads/connections parallèles : Plus il y a de threads, plus le crawl est rapide. Par exemple, 200 threads avec un délai de 2 secondes par site permettent d’atteindre environ 100 pages/seconde ().

- Benchmarks réels : 100 à 200 pages/seconde, c’est courant pour un crawler bien optimisé sur un cluster de serveurs solide.

- Google et Bing : Probablement des milliers de pages/seconde à l’échelle mondiale, réparties sur des millions de sites.

Facteurs qui influencent la vitesse de crawl

- Nombre de threads/fetchers parallèles : Plus il y en a, plus c’est rapide (jusqu’à atteindre d’autres limites).

- Nombre de sites actifs : Crawler plusieurs domaines en même temps augmente le débit global.

- Délai de crawl/temps d’attente : Plus le délai est long, plus le crawl est lent.

- Limites de ressources : Bande passante, CPU, vitesse d’écriture en base de données peuvent tous devenir des goulots d’étranglement.

- Performance du site cible : Un site lent ou limité en débit ralentit le crawl.

Par exemple, avec 100 threads et un délai d’1 seconde par site, tu peux atteindre environ 100 pages/seconde – sauf si la base de données ne suit pas, auquel cas le stockage devient le facteur limitant.

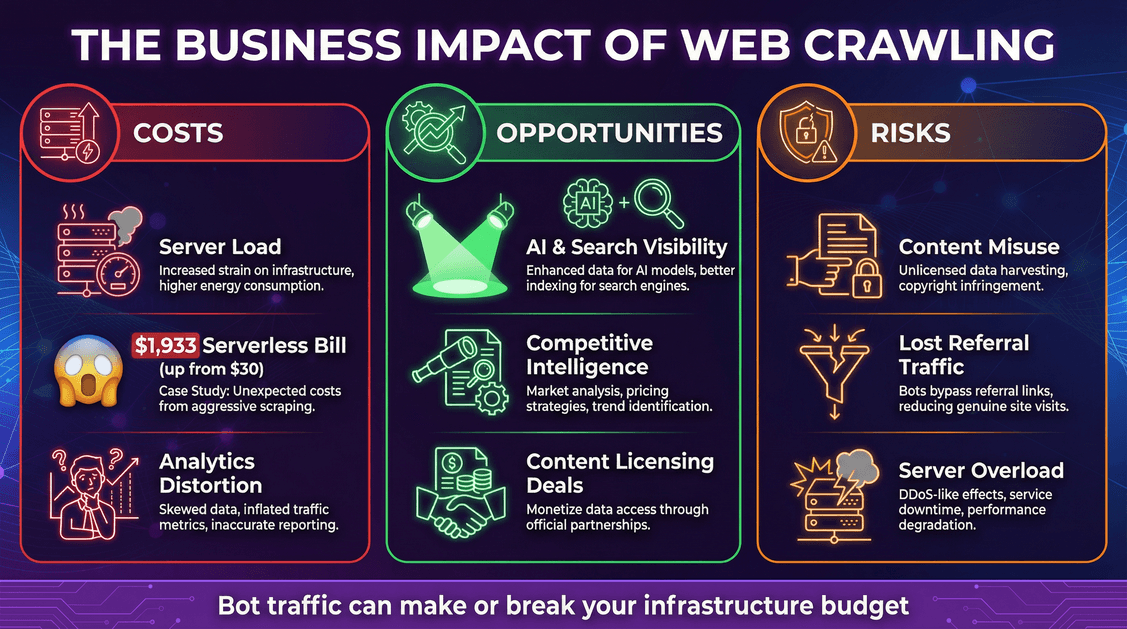

L’impact business du crawling web : coûts, opportunités et risques

Le crawling web, ce n’est pas juste une histoire de technique : ça a un impact direct sur ton business, avec des coûts et des opportunités bien réels.

Coûts : infrastructure et mauvaises surprises

- Charge serveur : Chaque requête de bot consomme du CPU, de la mémoire et de la bande passante.

- Factures cloud : Si tu payes à l’usage (serverless, etc.), les bots peuvent faire exploser la note. Un dev a vu .

- Distorsion des analytics : Les bots faussent tes stats web, rendant l’analyse du comportement réel des utilisateurs plus compliquée.

Opportunités : visibilité et valorisation des données

- Visibilité IA et recherche : Être inclus dans les données d’entraînement IA ou les index de recherche peut booster la notoriété de ta marque ().

- Veille concurrentielle : Les entreprises utilisent aussi les crawlers pour surveiller le marché, les prix, etc.

- Monétisation : Certains éditeurs commencent à .

Risques : usage abusif du contenu et perte de trafic

- Usage abusif du contenu : Les crawlers IA peuvent intégrer ton contenu dans leurs modèles, parfois sans autorisation ni compensation.

- Perte de trafic référent : Les réponses IA peuvent satisfaire les utilisateurs sans les renvoyer sur ton site, ce qui réduit ton audience directe.

- Sécurité et disponibilité : Des crawlers trop agressifs peuvent saturer tes serveurs, provoquant ralentissements ou pannes.

Gérer le trafic des crawlers web : bonnes pratiques

Comment éviter que les bots ne plombent ton budget (ou tes ressources) ?

1. Optimise ton robots.txt

- Utilise

robots.txtpour autoriser ou bloquer certains bots. La plupart des crawlers sérieux (comme Googlebot) le respectent, mais beaucoup de bots IA non (). - À la mi-2025, environ 14 % des sites majeurs avaient ajouté des règles spécifiques pour les bots IA ().

2. Utilise des outils de gestion des bots

- Les pare-feux applicatifs (WAF) et services spécialisés peuvent bloquer ou limiter le trafic suspect.

- Cloudflare et d’autres proposent des fonctions de mitigation des bots et même des outils “AI Audit” pour les créateurs de contenu ().

3. Mets en place du rate limiting et du cache

- Limite la fréquence des requêtes d’un même bot.

- Sers du contenu en cache aux bots autant que possible – évite qu’ils déclenchent des fonctions serverless ou des requêtes coûteuses en base ().

4. Surveille et analyse le trafic des bots

- Analyse régulièrement tes logs serveurs. Identifie quels bots te visitent, à quelle fréquence et à quels moments.

- Mets en place des alertes en cas de pics inhabituels.

5. Reste à l’affût des nouveaux standards

- Surveille l’apparition de nouvelles balises meta ou headers HTTP pour la gestion des droits IA (ex :

<meta name="ai:allow" content="no">). - Suis les initiatives du secteur comme ) ou les protocoles de paiement comme .

Tendances du crawling web à surveiller en 2026 et au-delà

Le paysage du crawling web évolue à toute vitesse. Voici ce que je garde à l’œil (et que tu devrais suivre aussi) :

- Le crawling piloté par l’IA va continuer de grimper : Attends-toi à voir encore plus de bots IA, sur tous types de contenus (texte, image, vidéo).

- Licences de contenu et standards de paiement : L’époque du “Far West” laisse place à et à .

- La régulation arrive : Attends-toi à plus de clarté juridique sur ce que les bots peuvent ou non faire, surtout pour l’entraînement IA ().

- Standards techniques pour l’usage du contenu : Nouvelles balises meta, extensions du robots.txt, déclarations machine-readable à prévoir.

- Collaboration éditeurs-IA : De plus en plus d’éditeurs vont négocier des flux de données structurés ou des API avec les sociétés d’IA, au lieu de subir le crawling.

Conclusion : que signifient ces statistiques de crawling web pour ton entreprise ?

En résumé : le crawling web est devenu un phénomène majeur en 2026, et la tendance ne ralentit pas. Les bots automatisés – surtout les crawlers IA – représentent désormais une part énorme de ton trafic, et leur impact sur ton infrastructure, ton budget et ta stratégie de contenu ne fait qu’augmenter.

Que faire ?

- Prévois un trafic bot massif : Adapte ton infrastructure, ton budget et ton monitoring en conséquence.

- Identifie tes crawlers : Tous les bots ne se valent pas – ajuste ta stratégie à chaque type.

- Surveille tes métriques : Suis le trafic des bots comme celui des visiteurs humains.

- Protège ton contenu et ton budget : Utilise des contrôles techniques, des accords juridiques et les nouveaux standards émergents.

- Profite des opportunités : Être inclus dans les index IA et recherche peut booster ta visibilité – assure-toi d’en tirer de la valeur.

- Reste informé et agile : Le secteur bouge vite. Suis les nouveaux standards, régulations et modèles économiques.

Après des années à concevoir des outils d’automatisation et d’IA (et aujourd’hui chez ), je peux te le dire : les entreprises qui réussiront dans cette nouvelle ère sont celles qui voient le crawling web comme un enjeu stratégique, pas juste une contrainte technique. Que tu sois dans la vente, l’e-commerce, le marketing ou l’immobilier, comprendre les statistiques et repères du crawling web est devenu indispensable.

Alors, la prochaine fois que tu vois défiler une armée de bots dans tes logs serveurs, ne te contente pas de soupirer. Analyse les données. Compare-toi aux benchmarks. Ajuste tes tactiques. Et rappelle-toi : à l’ère de l’IA, les bots ne sont pas en chemin – ils sont déjà là. Fais-en des alliés, pas des adversaires.

Reste attentif, curieux, et que tes logs serveurs te soient toujours favorables.

Envie d’aller plus loin sur le scraping web, l’automatisation et la productivité boostée par l’IA ? Parcours le pour des analyses détaillées, des tutos et les dernières tendances. Et si tu veux reprendre la main sur tes données, teste l’extension Chrome Thunderbit pour le scraping web par IA – sans code, sans prise de tête, juste des résultats.

Sources et lectures complémentaires :