Tu t’es déjà retrouvé devant un site web en te disant : « Si seulement je pouvais tout récupérer d’un coup pour tout mettre dans un tableau ! » ? Franchement, tu n’es pas le seul. J’ai moi-même passé des soirées à cliquer, copier, coller, en me demandant s’il n’existait pas un moyen plus malin de transformer le bazar du web en infos bien rangées. Bonne nouvelle : aujourd’hui, c’est possible, et ce n’est plus réservé aux geeks ou aux pros de la data.

Aujourd’hui, les sites web sont de vraies mines d’or pour l’info. Que tu sois dans une équipe commerciale, e-commerce, recherche ou même entrepreneur solo, tout le monde veut extraire, télécharger et exploiter les données du web en mode express. Les chiffres sont parlants : , et . Si tu continues à faire du copier-coller à la main, tu passes à côté d’un gain de temps énorme que les outils de site rip modernes peuvent t’apporter.

Alors, plongeons dans le monde du site rip : à quoi ça sert, qui s’en sert, et quels sont les meilleurs outils (y compris ceux boostés à l’IA) pour télécharger des fichiers depuis une URL, automatiser tes routines et transformer les sites web en vraies bases de données prêtes à l’emploi.

Site Rip : c’est quoi au juste ? Transformer un site en données utiles

On commence par la base : c’est quoi le « site rip » ? En gros, c’est le fait de télécharger tout ou partie du contenu d’un site web pour l’utiliser hors ligne, en faire une sauvegarde ou – mon préféré – en extraire les données. Imagine : tu prends un instantané d’un site, que ce soit tout le site ou juste les infos qui t’intéressent.

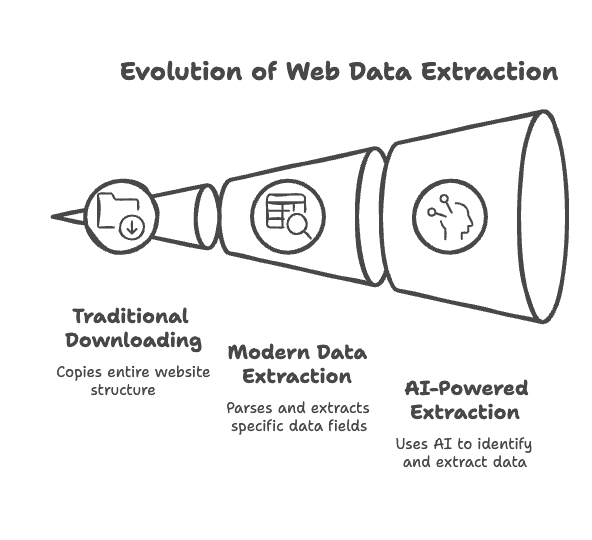

Les outils classiques de copie de site (aussi appelés ), comme HTTrack ou Wget, ont été pensés pour « dupliquer » des sites : ils récupèrent les pages HTML, images, PDF et autres fichiers, tout en gardant la structure des liens pour que tu puisses naviguer hors ligne comme sur le site d’origine. Parfait pour les sauvegardes, les migrations ou pour fouiller le code d’un site.

Mais aujourd’hui, on est passé à la vitesse supérieure : les outils de site rip modernes ne se contentent plus de copier des fichiers, ils . Au lieu d’un dossier rempli de fichiers, tu obtiens des tableaux, des fichiers CSV ou des feuilles de calcul directement issus des pages. Par exemple, au lieu de sauvegarder une page produit, un outil moderne te sort un tableau tout propre avec les noms, prix et notes des produits.

Et avec les extracteurs web IA, c’est encore plus futé. Ces outils comprennent le contenu des pages, s’adaptent aux changements et peuvent même transformer les résultats – genre résumer des textes ou classer les infos en direct. Bref, .

Qui utilise le Site Rip ? Un vrai couteau suisse pour la vente, l’opérationnel et plus encore

On pourrait croire que le site ripping, c’est un truc de hackers ou de développeurs, mais c’est dépassé. Aujourd’hui, tous les métiers s’en servent pour exploiter la richesse des données web. Petit tour d’horizon des profils qui utilisent le site rip et pourquoi :

| Groupe d'utilisateurs | Exemple d'utilisation | Bénéfice / ROI |

|---|---|---|

| Équipes commerciales | Extraire des annuaires d’entreprises ou des profils LinkedIn pour trouver des prospects | Génération de leads accélérée : listes de contacts en quelques minutes, plus de temps pour la vente |

| Équipes marketing | Surveiller les contenus des concurrents et regrouper les avis clients | Veille marché optimisée : informations à jour pour des campagnes plus efficaces |

| Opérations e-commerce | Suivre les prix et stocks des concurrents sur les sites marchands | Décisions en temps réel : suivi automatisé des prix et gestion dynamique des stocks |

| Chercheurs/Analystes | Collecter de grands volumes de données sur des sites d’actualités, forums ou bases publiques | Données fiables et volumineuses : jeux de données complets et précis pour des analyses approfondies |

| Agents immobiliers | Extraire des annonces et contacts depuis les portails immobiliers | Avantage concurrentiel : listings complets et actualisés pour mieux conseiller les clients |

| Responsables de contenu | Sauvegarder le contenu d’un site ou migrer des données vers une nouvelle plateforme | Préservation du contenu : copie hors ligne récente, migration et reprise simplifiées |

Dans tous les cas, le point commun, c’est . Les boîtes qui automatisent la collecte de données voient et, en 2023, environ .

Comment fonctionne le Site Rip ? Du téléchargement à l’extraction de données

Le principe du site ripping est simple, mais le choix de l’outil change tout.

Téléchargeurs de sites classiques :

Tu donnes l’URL du site, tu règles deux-trois options (types de fichiers à inclure, profondeur de crawl…), et l’outil parcourt les liens pour télécharger pages et fichiers. Des outils comme HTTrack ou Cyotek WebCopy sont parfaits pour ça : ils gardent la structure du site pour une navigation hors ligne. Mais ils copient tout, sans cibler des données précises.

Outils modernes d’extraction de données :

Là, on va plus loin. Au lieu de juste copier des fichiers, ces outils . Tu cliques sur un nom de produit ou un prix, et l’outil crée un flux pour extraire ces éléments sur toutes les pages similaires. Résultat : des données structurées en Excel, CSV, JSON, ou même direct dans Google Sheets.

Le rôle de l’IA :

C’est là que ça devient impressionnant. Les outils boostés à l’IA comme te permettent de décrire ce que tu veux en langage naturel (« nom du produit, prix, URL de l’image »), et l’IA s’occupe de tout extraire. Plus besoin de toucher au code HTML ou aux sélecteurs CSS. L’IA nettoie et structure aussi les données, et s’adapte si la mise en page du site change. En gros, .

Les 8 meilleurs outils Site Rip pour extraire des données facilement et rapidement

Passons au concret : les outils. J’ai testé, comparé et sélectionné les meilleures solutions, des classiques aux extracteurs IA. Voici mon top 8, avec les points forts de chacun.

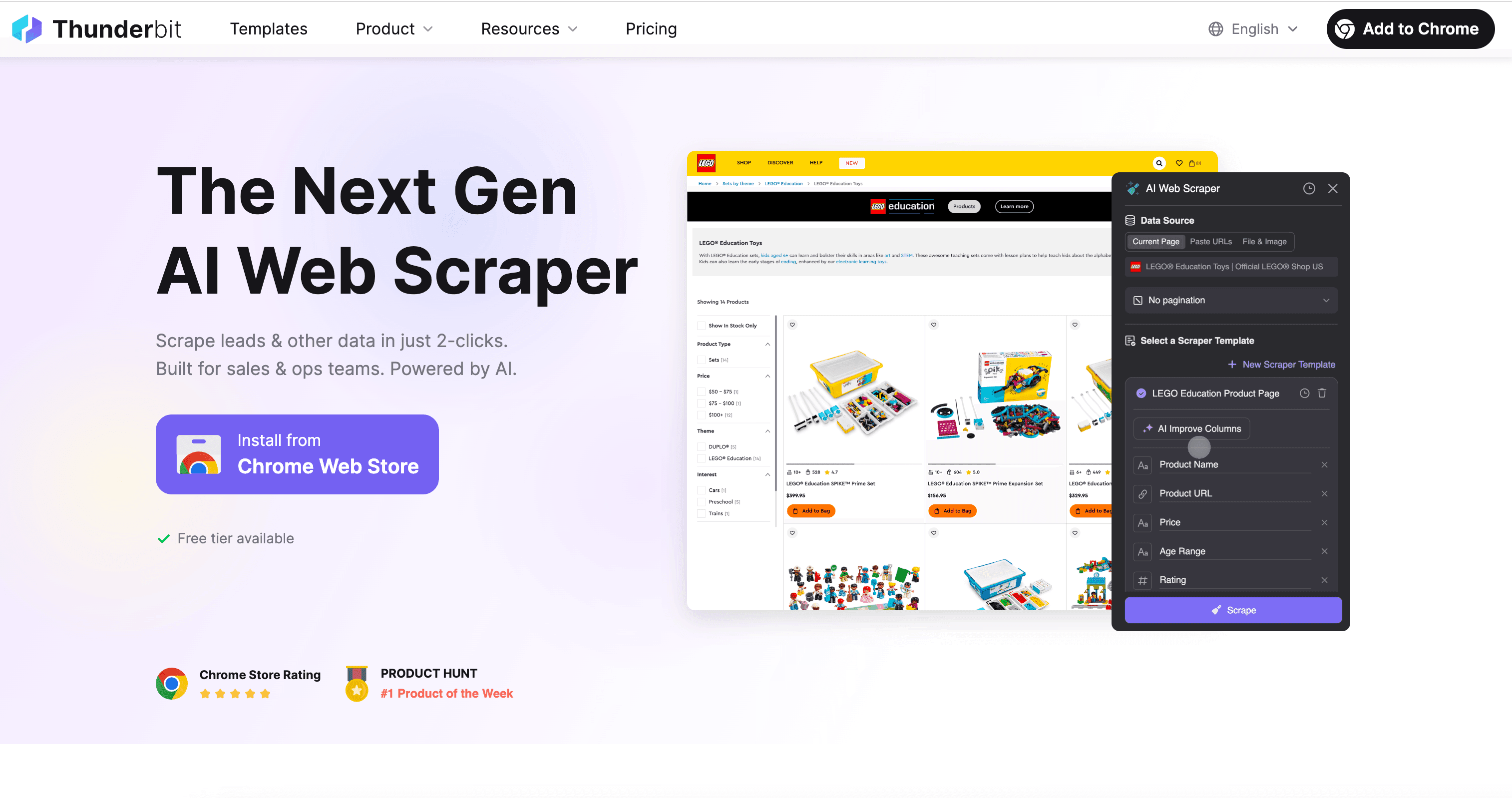

1. Thunderbit : le Site Rip IA pour tout le monde

Je l’avoue, je ne suis pas totalement objectif : Thunderbit, c’est le projet de mon équipe, pensé pour répondre pile aux besoins dont je parle ici. Notre philosophie : « Les sites web ne sont pas faits que pour être lus, ce sont des sources de données structurées à exploiter. » Le web, c’est une mine d’infos non structurées, et les outils de site rip sont la clé pour y accéder. L’IA, c’est le cerveau qui transforme tout ça en données utiles.

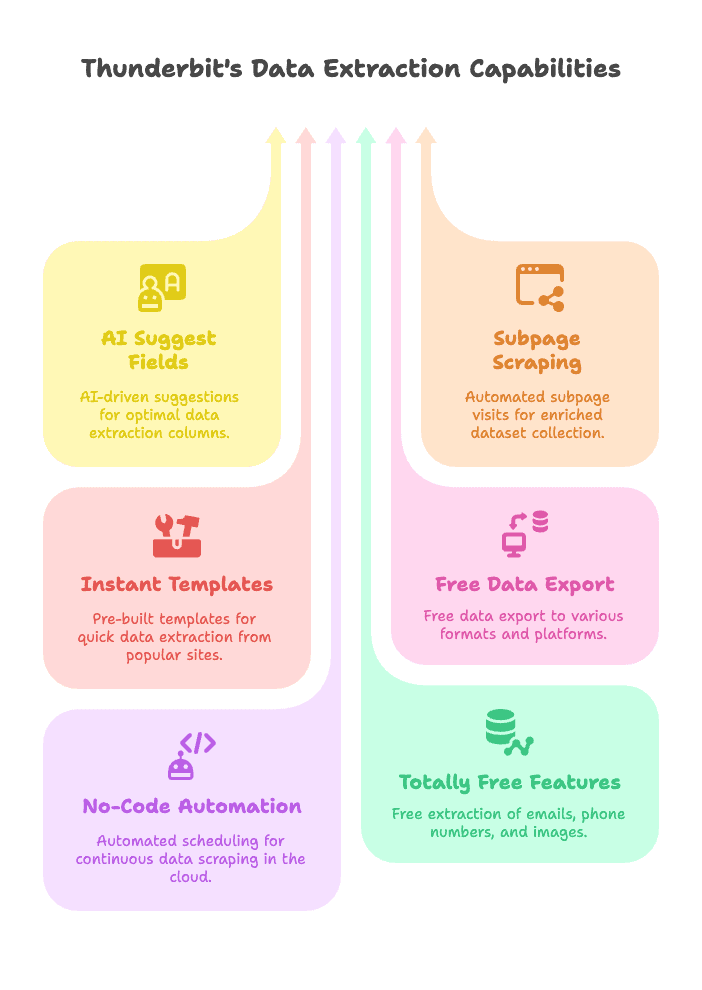

Pourquoi Thunderbit sort du lot

- Suggestions IA de champs à extraire : Un clic, et l’IA de Thunderbit analyse la page, propose les meilleures colonnes à extraire et configure l’extracteur pour toi. Fini les devinettes ou le code.

- Extraction sur sous-pages : Besoin de plus que la page de liste ? Thunderbit visite automatiquement chaque sous-page (ex : fiche produit) et enrichit ton jeu de données en un seul flux.

- Modèles instantanés : Pour les sites populaires (Amazon, Zillow, Instagram, Shopify…), utilise des modèles prêts à l’emploi pour extraire les données en un clic, sans prise de tête.

- Exportation gratuite des données : Exporte vers Excel, Google Sheets, Airtable, Notion ou télécharge en CSV/JSON. Aucun surcoût, même avec la version gratuite.

- Automatisation sans code : Programme des extractions automatiques (ex : suivi quotidien des prix) et laisse Thunderbit bosser dans le cloud.

- Fonctionnalités 100% gratuites : Extrais emails, numéros de téléphone et images de n’importe quel site en un clic – totalement gratuit.

- Disponible en 34 langues : L’extension Chrome est accessible partout.

Thunderbit a été pensé pour les non-techniciens : pas de code, pas besoin d’équipe IT. Il suffit de pointer, cliquer et extraire. Nos utilisateurs vont des commerciaux à la chasse aux leads, aux e-commerçants surveillant les prix, jusqu’aux agents immobiliers collectant des annonces. Le top ? .

Pour voir Thunderbit en action, va jeter un œil à notre ou découvre d’autres cas d’usage sur le .

Thunderbit, c’est la solution la plus simple pour extraire des données structurées de n’importe quel site, que tu sois commercial, e-commerçant ou chercheur. Grâce à la détection IA des champs et à l’extraction sur sous-pages, tu automatises la collecte de données en quelques clics.

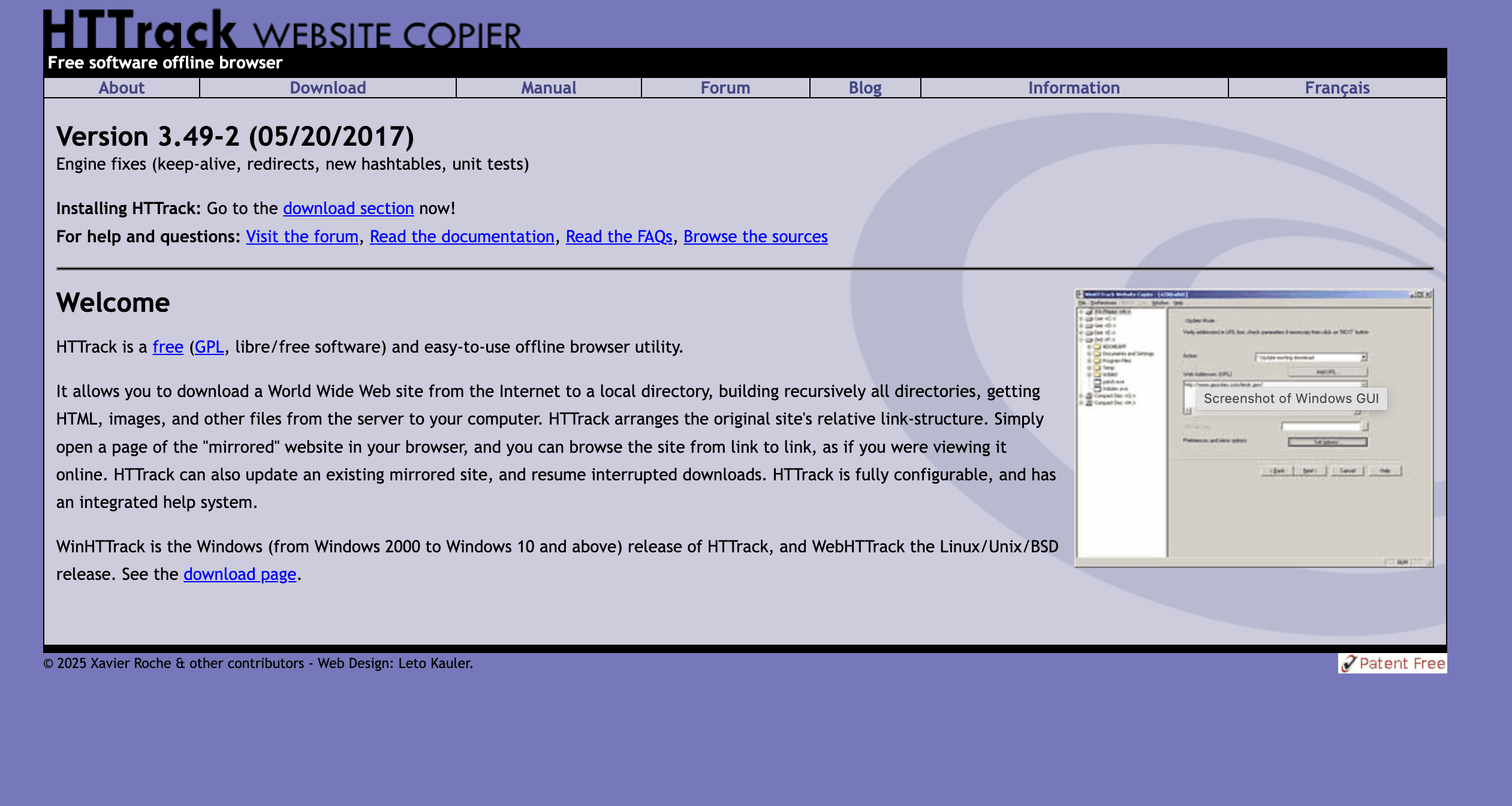

2. HTTrack : le téléchargeur de sites classique pour la navigation hors ligne

HTTrack, c’est le pionnier du site ripping. Présent depuis la fin des années 90, il reste adoré des archivistes, chercheurs et de tous ceux qui veulent une copie complète d’un site pour le consulter hors ligne.

Ce qu’il propose

- Navigation hors ligne : Télécharge l’intégralité d’un site (HTML, images, feuilles de style…) en gardant la structure des liens.

- Multi-plateforme : Disponible sur Windows, Linux et Android.

- Paramétrable : Filtres, profondeur de crawl, reprise des téléchargements interrompus.

Limites

- Pas de contenu dynamique : Galère avec les sites bourrés de JavaScript.

- Pas de données structurées : Génère des fichiers et dossiers, pas de tableaux de données.

- Trop complet parfois : Télécharge tout sauf si tu filtres.

HTTrack est top pour sauvegarder des sites statiques, archiver du contenu ou naviguer sans connexion. Gratuit et open source, mais pas adapté si tu veux des données prêtes à l’analyse.

3. Octoparse : extraction visuelle et cloud pour les pros de la donnée

Octoparse est une référence pour l’extraction web, surtout pour les boîtes qui ont besoin de workflows visuels costauds. C’est une appli Windows (avec plateforme cloud) qui permet de créer des tâches d’extraction en cliquant sur les pages – pas besoin de coder, mais il faut piger la structure des sites.

Points forts

- Workflow visuel : Sélection des champs par clic, gestion de la pagination, automatisation des connexions ou du scroll.

- Extraction cloud : Exécute les tâches sur les serveurs Octoparse, planifie-les et exporte dans plein de formats.

- Modèles prêts à l’emploi : Pour Amazon, Twitter, Yelp, etc.

- Options avancées : Rotation d’IP, anti-blocage, accès API, collaboration en équipe.

Avantages & inconvénients

- Avantages : Gère les sites complexes et dynamiques ; puissant pour l’extraction à grande échelle ; sans code.

- Inconvénients : Prise en main pas évidente pour les débutants ; formules payantes parfois salées ; surtout orienté Windows (cloud multi-plateforme).

Si tu es analyste ou responsable e-commerce et que tu dois extraire des milliers de données régulièrement, Octoparse est un choix solide. Prévoyez juste un peu de temps pour l’apprivoiser. Pour une comparaison détaillée, mate .

4. Cyotek WebCopy : Site Rip gratuit et flexible pour Windows

Cyotek WebCopy est un outil gratuit pour Windows qui permet de télécharger tout ou partie d’un site pour une utilisation hors ligne. Plus moderne que HTTrack, il offre un contrôle précis sur ce que tu télécharges.

Atouts

- Règles personnalisées : Inclure/exclure des URLs ou types de fichiers avec des jokers ou des regex.

- Réécriture des liens : Adapte les liens pour une navigation hors ligne fluide.

- Rapports : Génère des rapports pour repérer les liens manquants ou cassés.

Inconvénients

- Uniquement Windows : Pas de version Mac ou Linux.

- Pas d’exécution JavaScript : Comme HTTrack, ne gère pas le contenu dynamique.

- Courbe d’apprentissage : Beaucoup de réglages à maîtriser pour les tâches complexes.

Pour les utilisateurs Windows qui veulent contrôler finement leurs sauvegardes, Cyotek WebCopy est une option flexible et gratuite.

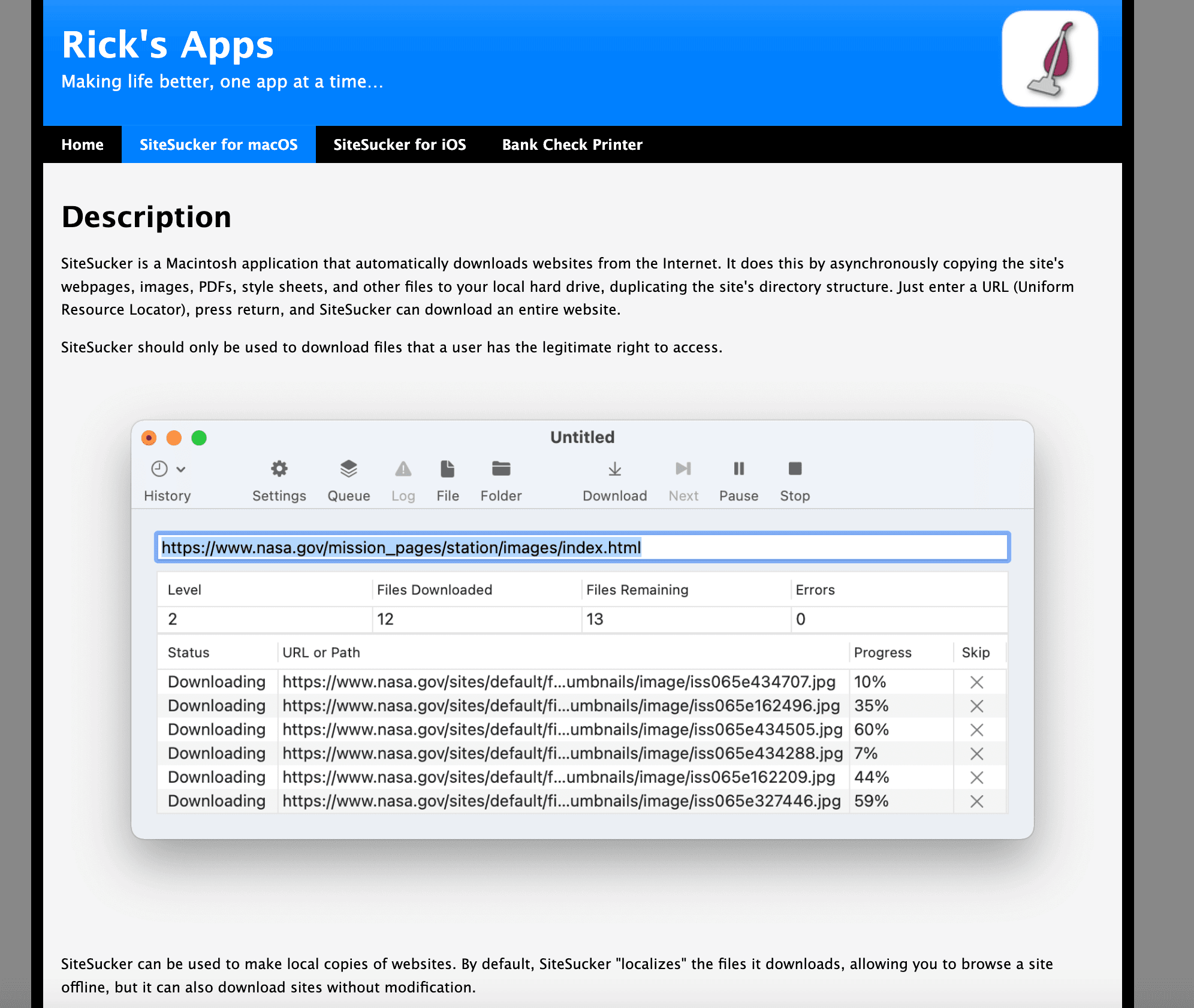

5. SiteSucker : le téléchargeur de sites pour Mac

SiteSucker, c’est la référence pour les utilisateurs Mac qui veulent télécharger des sites pour les consulter hors ligne. Disponible sur le Mac App Store, il est d’une simplicité redoutable.

Fonctionnalités

- Téléchargement en un clic : Tu mets l’URL, tu choisis un dossier, c’est parti.

- Pause/Reprise : Pratique pour les gros sites ou les connexions instables.

- Support multilingue : Localisé dans plusieurs langues.

Limites

- Exclusif Mac : Pas pour Windows ou Linux.

- Contenu statique uniquement : Ne gère pas les sites dynamiques ou interactifs.

- Application payante : Environ 5 €, mais la simplicité vaut souvent le prix.

SiteSucker est parfait pour archiver des blogs, documentations ou tout site à lire hors ligne. Pour l’extraction de données structurées, il faudra chercher ailleurs.

6. Getleft : téléchargeur open source et multilingue

Getleft est un outil open source moins connu, avec une interface simple et dispo en 14 langues. Léger et gratuit, il plaît aux étudiants et aux amateurs.

Points positifs

- Choix des types de fichiers : Tu sélectionnes ce que tu veux télécharger (HTML, images, PDF…).

- Réécriture des liens : Adapte les liens pour la navigation hors ligne.

- Reprise des téléchargements : Gère bien les interruptions.

Points faibles

- Obsolète : Ne gère pas les sites modernes bourrés de JavaScript.

- Pas de données structurées : Strictement pour le contenu HTML statique.

- Interface datée : Un look un peu vieillot.

Pour une solution open source sans chichi pour copier des sites simples, Getleft fait le job.

7. Website : télécharger des fichiers depuis une URL en un clic

Parfois, on veut juste une solution rapide, sans rien installer. Website est un outil en ligne où tu mets une URL et tu récupères une archive ZIP du site (HTML, CSS, images, etc.).

Avantages

- Aucune installation : Fonctionne dans n’importe quel navigateur.

- Résultats rapides : Idéal pour des téléchargements ponctuels ou sur un ordi verrouillé.

- Gère les fichiers statiques : Récupère HTML, images, PDF, etc.

Limites

- Limite de fichiers : Version gratuite limitée à environ 200 fichiers.

- Pas de données structurées : Tu obtiens les fichiers bruts, pas de tableaux.

- Contrôle limité : Pas de filtres, pas de gestion des connexions.

Si tu dois ou récupérer le code source d’un site en urgence, Website est bien pratique.

8. Mentions spéciales

Les sept outils ci-dessus couvrent la majorité des besoins, mais voici quelques alternatives de niche :

- Wget : Outil en ligne de commande pour les utilisateurs avancés, surtout sous Linux.

- Wayback Machine Downloader : Pour archiver des versions historiques de sites.

- Autres extensions Chrome : Il y en a plein, mais peu rivalisent avec les fonctions IA de Thunderbit.

Tableau comparatif rapide : quel outil Site Rip choisir ?

| Outil | Plateforme | Tarification | Fonctionnalités clés | Idéal pour | Limites |

|---|---|---|---|---|---|

| Thunderbit | Extension Chrome + Cloud | Gratuit/Payant | Détection IA des champs, sous-pages, modèles, planification, exports | Extraction de données structurées, utilisateurs sans code | Limites de crédits, nécessite Chrome |

| HTTrack | Windows/Linux/Android | Gratuit (Open Source) | Duplication complète, paramétrable, reprise, multi-plateforme | Navigation hors ligne, sauvegarde de site | Pas de JS, pas de tableaux de données |

| Cyotek WebCopy | Windows | Gratuit | Règles personnalisées, réécriture des liens, rapports | Copies hors ligne sur mesure | Windows uniquement, pas de JS, apprentissage |

| Octoparse | Windows + Cloud | Gratuit/Payant | Workflow visuel, extraction cloud, modèles, API | Analystes, e-commerce, gros volumes | Apprentissage, prix, orienté Windows |

| SiteSucker | macOS | Payant (~5€) | Téléchargement en un clic, pause/reprise, multilingue | Utilisateurs Mac, lecture hors ligne | Mac uniquement, contenu statique, pas de tableaux |

| Getleft | Windows/Linux | Gratuit (Open Source) | Choix des fichiers, multilingue, reprise | Fans open source, sites simples | Obsolète, pas de JS, pas de données structurées |

| Website Downloader.io | Web (tous OS) | Gratuit/Payant | En ligne, téléchargement ZIP rapide, fichiers statiques | Téléchargements rapides, sans installation | Limite de fichiers, pas de filtres, statique uniquement |

Pour plus de détails, va voir le .

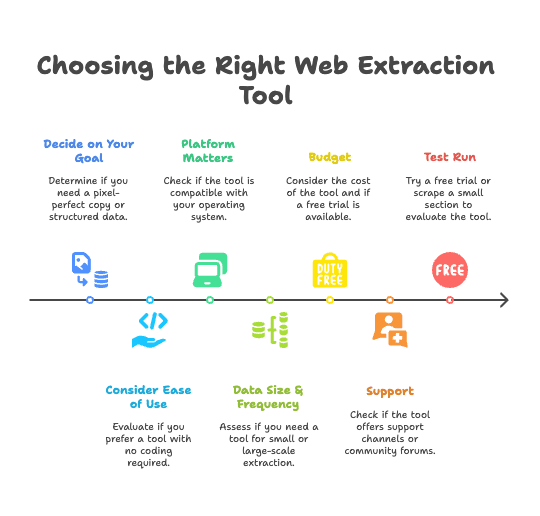

Comment choisir le bon outil Site Rip pour toi

Avec autant d’options, comment s’y retrouver ? Voici mes conseils pratiques, tirés de plusieurs années à aider des équipes à automatiser la collecte de données web :

- Définis ton objectif :

- Tu veux une copie fidèle pour consultation hors ligne ? Prends un téléchargeur classique (HTTrack, WebCopy, SiteSucker).

- Tu veux des données structurées (liste de produits, contacts…) ? Prends un extracteur de données (Thunderbit, Octoparse).

- Facilité d’utilisation :

- Résultat rapide, sans code ? est fait pour toi.

- Prêt à apprendre et besoin de contrôle avancé ? Essaie Octoparse ou Cyotek WebCopy.

- Plateforme :

- Mac ? Thunderbit (Chrome) ou SiteSucker.

- Windows ? Tous les choix sont possibles.

- Linux ? HTTrack, Getleft ou Thunderbit (via Chrome).

- Volume et fréquence :

- Petit besoin ponctuel ? Website ou un outil gratuit suffira.

- Extraction régulière et massive ? Investis dans l’automatisation avec Thunderbit ou Octoparse.

- Budget :

- Les outils gratuits/open source sont efficaces, mais les solutions payantes font souvent gagner plus de temps (et de galères) sur la durée.

- Beaucoup d’outils payants proposent des essais gratuits : profites-en pour tester.

- Support :

- Besoin d’aide ? Thunderbit et Octoparse offrent un support. Les outils open source reposent sur les forums communautaires.

- Teste avant d’adopter :

- Essaie une version gratuite ou teste sur une petite portion pour voir si l’outil te convient.

Exemples de scénarios :

Exemples de scénarios :

- Sales Ops : Tu dois collecter des leads chaque semaine ? L’IA et la planification de Thunderbit te feront gagner des heures.

- Archivage : Besoin d’une sauvegarde de ton site d’entreprise ? Utilise HTTrack ou WebCopy.

- Recherche : Tu veux les données produits d’un concurrent ? Thunderbit ou Octoparse te fourniront des tableaux structurés.

- Lecture hors ligne : Un super site de tutos à garder ? SiteSucker (Mac) ou HTTrack (Windows) sont parfaits.

Toujours indécis ? est une bonne porte d’entrée : vois si ça colle à tes besoins, sinon teste un autre outil.

Conclusion : l’avenir du Site Rip – de la copie manuelle à l’extraction IA

On a fait du chemin depuis l’époque où on copiait/collait des pages web dans Excel. Les outils de site rip sont passés de simples téléchargeurs à de vraies plateformes d’extraction de données boostées à l’IA. L’avenir ? Considérer les sites web comme des sources de données, pas juste comme des pages à lire.

La vision de Thunderbit est claire : « Les sites web ne sont pas faits que pour être lus, ils sont faits pour être exploités. » Les équipes les plus efficaces ne copient plus à la main : elles laissent l’IA faire le boulot. Avec le bon outil, chacun peut transformer la richesse du web en infos exploitables, sauvegardes ou produits.

Alors, oublie la galère du copier-coller et passe à l’automatisation. Que tu sois commercial, marketeur, chercheur ou juste curieux, il existe un outil de site rip fait pour toi. L’ère du site ripping piloté par l’IA est là, et elle rend la donnée web accessible à tous.

Prêt à passer à la vitesse supérieure ? et rejoins ceux qui ont définitivement tourné la page du copier-coller.

Pour aller plus loin :

Bonne extraction de données !

FAQ

1. Qu’est-ce que le Site Rip et comment ça marche ?

Le site rip, c’est le fait de télécharger tout ou partie du contenu d’un site web pour l’utiliser hors ligne, en faire une sauvegarde ou en extraire les données. Les outils classiques comme HTTrack dupliquent les sites pour une navigation hors ligne, alors que les outils modernes utilisent l’IA pour extraire des données structurées (tableaux, listes de produits, contacts) dans des formats comme CSV ou Excel.

2. Qui peut profiter des outils Site Rip ?

Les outils de site rip sont utiles à plein de profils : équipes commerciales pour la prospection, marketing pour la veille concurrentielle, e-commerce pour le suivi des prix, chercheurs pour la collecte de données, agents immobiliers pour les annonces, responsables de contenu pour les sauvegardes.

3. Quelle différence entre les outils Site Rip IA et les téléchargeurs classiques ?

Les outils IA comme Thunderbit comprennent le contenu des pages, détectent automatiquement les champs pertinents, s’adaptent aux changements de structure et exportent des données propres et structurées. Les outils classiques copient surtout les fichiers bruts sans analyser le contenu.

4. Quels sont les meilleurs outils Site Rip aujourd’hui ?

Parmi les meilleurs : Thunderbit pour l’extraction IA, HTTrack et Cyotek WebCopy pour la copie complète de sites, Octoparse pour les workflows visuels, SiteSucker pour les utilisateurs Mac, et Downloader.io pour les téléchargements rapides en ligne. Chaque outil répond à des besoins différents selon la plateforme, l’usage et le niveau technique.

5. Comment choisir le bon outil Site Rip ?

Commence par définir ton objectif (accès hors ligne ou extraction de données structurées), puis regarde ta plateforme (Windows, Mac…), la facilité d’utilisation, le budget et la fréquence/volume d’extraction. Par exemple, Thunderbit est parfait pour les utilisateurs sans code qui veulent des données structurées, alors que HTTrack est top pour sauvegarder des sites statiques.