Imagine la situation : il est 8h30, ton café fume encore, et ton manager (ou le boss de ton manager) débarque pour te demander un tableau complet des prix des concurrents, des avis clients, et – soyons fous – la garniture de pizza préférée du PDG d’en face. Tu pourrais passer la matinée à faire du copier-coller, ou alors laisser Python bosser à ta place. Mais si tu ne codes pas, ou que tu n’as pas envie de te battre avec du HTML dès le matin ? Ce guide est pile pour toi.

Je m’appelle Shuai Guan, cofondateur et CEO de , et ça fait des années que je baigne dans le SaaS, l’automatisation et l’IA pour aider les équipes à transformer le bazar des données web en infos vraiment utiles. Ici, je te présente les 10 meilleures bibliothèques python extraction web pour 2025 : à quoi elles servent, comment elles marchent, leurs points forts et leurs limites, et dans quels cas elles sont imbattables. Et si tu te dis « Ok, mais je ne sais toujours pas coder en Python », pas de stress. Je te montre aussi comment l’extracteur web IA sans code de Thunderbit te donne les mêmes résultats en deux clics – sans programmation, sans prise de tête, et sans finir accro à la caféine.

Pourquoi les bibliothèques python extraction web sont devenues incontournables pour les équipes business

- Génération de leads & prospection commerciale : Extraire des infos depuis des annuaires, réseaux sociaux ou forums pour monter des listes ciblées – noms, emails, profils, etc. Les commerciaux automatisent ainsi des tâches qui prenaient des heures ().

- Veille tarifaire & analyse concurrentielle : Les équipes e-commerce surveillent en direct les prix, stocks et promos des concurrents pour ajuster leur stratégie en temps réel ().

- Études de marché & détection de tendances : Extraire des avis, des posts sur les réseaux ou des articles de presse permet aux équipes marketing et produit de flairer les tendances et ressentis clients avant tout le monde ().

- Données immobilières : Les pros de l’immobilier agrègent annonces, prix et caractéristiques de biens depuis plusieurs sites pour mieux analyser le marché.

- Opérations e-commerce : De la gestion fournisseurs à l’audit de catalogue, l’extraction web fiabilise les données et évite les copier-coller sans fin.

En bref ? . Mais il y a un hic : la plupart des bibliothèques python extraction web partent du principe que tu sais coder. Pour les non-techs, c’est vite décourageant. C’est là que les outils sans code boostés à l’IA comme changent la donne – on en reparle juste après.

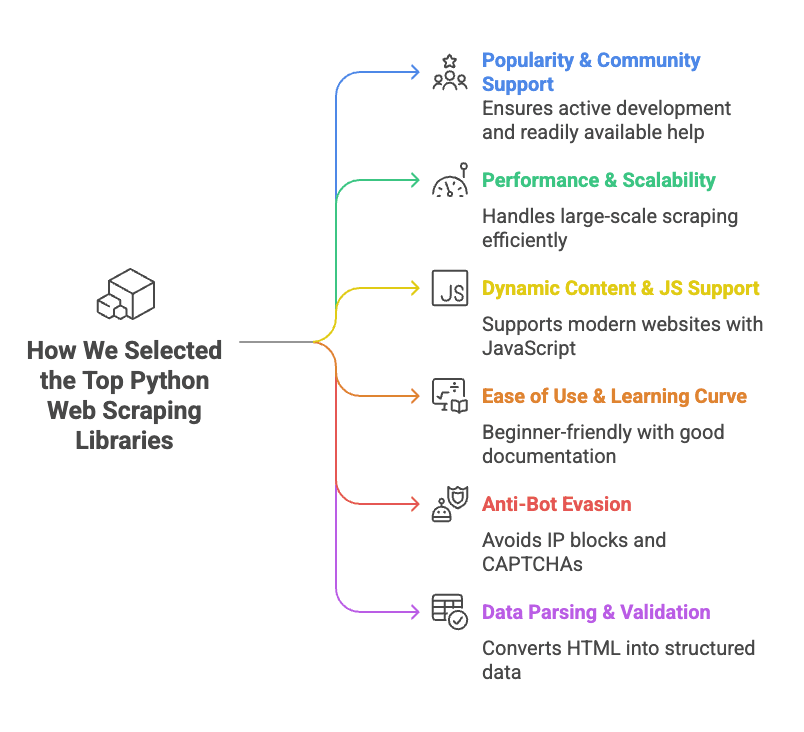

Comment on a sélectionné les meilleures bibliothèques python extraction web

- Popularité & communauté : On a privilégié les bibliothèques avec plein d’étoiles sur GitHub, une communauté active et des tutos à gogo. Si tu bloques, mieux vaut trouver des réponses vite fait !

- Performance & passage à l’échelle : L’outil tient-il la route sur des milliers de pages ? Supporte-t-il la concurrence ou l’asynchrone ? Est-il rapide ou tu regrettes de ne pas avoir pris un stagiaire ?

- Gestion du contenu dynamique & JavaScript : Beaucoup de sites modernes chargent les données via JavaScript. Les bibliothèques capables de gérer ça (via navigateur automatisé ou API) sont mises en avant.

- Facilité d’utilisation & prise en main : Certains outils sont prêts à l’emploi, d’autres demandent un doctorat en « Pourquoi ça bug ? ». On a mis en avant les solutions accessibles ou bien documentées.

- Contournement des anti-bots : L’outil gère-t-il les blocages IP, CAPTCHAs ou les limitations agressives ? Sinon, tu risques de scraper 5 minutes et d’être bloqué 5 jours.

- Parsing & validation des données : Récupérer du HTML, c’est bien, mais le transformer en données propres, c’est mieux. Les bibliothèques qui facilitent ce boulot ont eu des points bonus.

Pour chaque bibliothèque, tu trouveras son utilité, comment l’utiliser, ses points forts et faibles, et les cas où elle brille.

Tableau comparatif express : les bibliothèques python extraction web en un clin d’œil

Voici un comparatif rapide des 10 bibliothèques phares, pour choisir l’outil qui colle à tes besoins (et peut-être impressionner ton boss avec ton nouveau vocabulaire d’extraction web) :

| Bibliothèque | Facilité d’utilisation | Support JS | Requêtes HTTP | Parsing HTML | Anti-bot | Validation des données | Idéal pour |

|---|---|---|---|---|---|---|---|

| ZenRows | Très facile (API) | ✅ (navigateur) | ✅ (API) | ✅ | ✅ (proxies, bypass CAPTCHA) | ❌ | Extraction à grande échelle sur sites protégés |

| Selenium | Moyen | ✅ (navigateur) | ✅ (navigateur) | Partiel | ❌ | ❌ | Sites dynamiques et interactifs |

| Requests | Très facile | ❌ | ✅ | ❌ | ❌ | ❌ | Pages statiques, APIs |

| Beautiful Soup | Facile | ❌ | ❌ | ✅ | ❌ | ❌ | Parsing HTML de pages statiques |

| Playwright | Moyen | ✅ (navigateur) | ✅ (navigateur) | Accès DOM | ❌ | ❌ | Apps web modernes, multi-navigateurs |

| Scrapy | Moyen/Difficile | Partiel (add-ons) | ✅ (async) | ✅ | ❌ | Limité | Crawling structuré à grande échelle |

| urllib3 | Facile (bas niveau) | ❌ | ✅ | ❌ | ❌ | ❌ | HTTP custom, forte concurrence |

| HTTPX | Facile/Moyen | ❌ (async IO) | ✅ (async) | ❌ | ❌ | ❌ | Extraction asynchrone, haute performance |

| lxml | Moyen | ❌ | ❌ | ✅ (rapide) | ❌ | ❌ | Parsing rapide, HTML/XML complexe |

| Pydantic | Moyen | N/A | N/A | N/A | N/A | ✅ | Validation des données après extraction |

Note : « Support JS » = capacité à gérer le contenu généré par JavaScript. « Anti-bot » = protections intégrées, pas ce que tu peux bidouiller toi-même.

ZenRows : la solution Python tout-en-un pour l’extraction web

C’est quoi ?

est une API d’extraction web qui s’occupe des galères pour toi : rotation de proxies, CAPTCHAs, fingerprinting navigateur, rendu JavaScript. Un simple appel API, et ZenRows te renvoie la page.

Comment l’utiliser :

Inscris-toi pour une clé API, puis utilise la bibliothèque requests de Python :

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])Points forts :

- Contourne la plupart des protections anti-bot (proxies, CAPTCHAs, etc.)

- Gère les sites blindés de JavaScript

- API ultra simple – pas besoin de gérer navigateur ou proxies

- Passe à l’échelle sans prise de tête

Points faibles :

- Service payant (essai gratuit, mais usage régulier payant)

- Dépendance à une API externe

Parfait pour :

L’extraction à grande échelle, surtout sur des sites qui bloquent les robots ou nécessitent du JavaScript. Si tu en as marre d’être bloqué ou de résoudre des CAPTCHAs, ZenRows est à tester ().

Selenium : automatiser le navigateur pour l’extraction web dynamique

C’est quoi ?

est le vétéran de l’automatisation de navigateur. Il permet de piloter Chrome, Firefox ou d’autres navigateurs depuis Python, en simulant clics, saisies, scrolls, etc. Tout ce qu’un humain fait dans un navigateur, Selenium le fait aussi.

Comment l’utiliser :

Installe Selenium et un driver navigateur (ex : ChromeDriver), puis :

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()Points forts :

- Gère tout ce qu’un vrai navigateur peut faire (contenu dynamique, logins, pop-ups)

- Simule les interactions utilisateur (clics, saisies, etc.)

- Compatible multi-navigateurs

Points faibles :

- Gourmand en ressources (chaque instance consomme RAM et CPU)

- Plus lent que l’extraction via HTTP

- Prise en main plus longue (surtout pour la concurrence)

- Détectable par les anti-bots avancés

Parfait pour :

Les sites dynamiques, riches en JavaScript, qui demandent des interactions – LinkedIn, dashboards, contenus derrière login ().

Requests : le client HTTP incontournable de Python

C’est quoi ?

est la bibliothèque « HTTP for Humans ». C’est la façon la plus simple et fiable de récupérer des pages web ou des APIs en Python.

Comment l’utiliser :

Pour une page statique :

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])Points forts :

- API ultra simple

- Rapide et léger

- Gère cookies, redirections, etc.

- Communauté énorme, plein de tutos

Points faibles :

- Ne gère pas le JavaScript ni le contenu dynamique

- Pas de parsing HTML intégré (à coupler avec Beautiful Soup ou lxml)

- Pas de protections anti-bot (à bricoler soi-même)

Parfait pour :

Pages statiques, APIs, ou tout site où la donnée est dans le HTML de base. Pour débuter, Requests + Beautiful Soup, c’est le combo classique ().

Beautiful Soup : le parsing HTML facile pour l’extraction web python

C’est quoi ?

(BS4) est une bibliothèque Python pour parser HTML et XML. Elle ne récupère pas les pages elle-même – on l’utilise avec Requests ou Selenium – mais elle simplifie l’extraction de données dans le HTML.

Comment l’utiliser :

Extraire des noms de produits :

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)Points forts :

- Parfait pour débuter, tolère le HTML mal formé

- Recherche flexible (balise, classe, sélecteur CSS, regex)

- Léger et rapide pour la plupart des usages

- Documentation et exemples à foison

Points faibles :

- Ne récupère pas les pages ni le JavaScript

- Moins rapide que lxml sur de gros documents

- Moins puissant pour les requêtes complexes (prends lxml pour du XPath avancé)

Parfait pour :

Transformer du HTML brut en données propres – listes de produits, tableaux, liens. Si tu as le HTML, Beautiful Soup t’aide à l’exploiter ().

Playwright : l’automatisation moderne du navigateur pour l’extraction web python

C’est quoi ?

est la nouvelle star de l’automatisation navigateur, développée par Microsoft. Comme Selenium, il pilote les navigateurs, mais il est plus rapide, supporte plusieurs moteurs (Chromium, Firefox, WebKit) et propose une API moderne.

Comment l’utiliser :

Récupérer le contenu d’une page :

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()Points forts :

- Gère les sites dynamiques et blindés de JS

- Support multi-navigateurs (Chromium, Firefox, WebKit)

- Attente automatique des éléments (moins de bugs que Selenium)

- Supporte l’asynchrone et le parallélisme

Points faibles :

- Toujours gourmand en ressources (automatisation navigateur)

- Prise en main, surtout pour l’asynchrone

- Détectable par certains anti-bots

Parfait pour :

Applications web modernes, sites qui réagissent différemment selon le navigateur, ou besoin d’intercepter les requêtes réseau ().

Scrapy : le framework python extraction web pour le crawling massif

C’est quoi ?

est un framework complet d’extraction web. Pensé pour le crawling massif, il intègre la concurrence, des pipelines de traitement et plein d’options d’export. Si tu veux scraper des milliers de pages, Scrapy est ton allié.

Comment l’utiliser :

Définir un spider :

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }Lance avec scrapy crawl quotes dans un projet Scrapy.

Points forts :

- Haute performance, concurrence intégrée

- Structure de projet claire (spiders, pipelines, middlewares)

- Export facile vers CSV, JSON, bases de données

- Grande communauté, plein de plugins

Points faibles :

- Prise en main pour les débutants

- Nécessite une structure de projet (pas idéal pour un test rapide)

- Support JavaScript limité par défaut (add-ons nécessaires)

Parfait pour :

Crawling massif et structuré – par exemple, agréger des annonces immobilières sur plusieurs sites, ou extraire des catalogues produits entiers ().

Urllib3 : le HTTP fiable pour l’extraction web python

C’est quoi ?

est un client HTTP bas niveau qui alimente des bibliothèques comme Requests. Si tu veux un contrôle précis sur les connexions, les retries ou le pooling, urllib3 est fait pour toi.

Comment l’utiliser :

Récupérer une page :

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])Points forts :

- Pooling de connexions rapide et efficace

- Thread-safe, top pour le scraping concurrent

- Contrôle précis du comportement HTTP

Points faibles :

- Plus manuel que Requests

- Pas de parsing HTML ni de support JS

- Moins de documentation pour débutants

Parfait pour :

Scénarios HTTP personnalisés, extraction à forte concurrence, ou quand chaque milliseconde compte ().

HTTPX : la bibliothèque python moderne et asynchrone pour l’extraction web

C’est quoi ?

est le client HTTP nouvelle génération pour Python. C’est comme Requests, mais avec l’asynchrone et le HTTP/2 dès l’installation. Pour extraire des milliers de pages en parallèle, HTTPX est ton allié.

Comment l’utiliser :

Synchronisé :

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)Asynchrone :

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))Points forts :

- Support asynchrone pour extraction à grande échelle

- HTTP/2 natif (plus rapide sur plein de sites)

- API proche de Requests (migration facile)

- Meilleure gestion des erreurs

Points faibles :

- Plus récent, donc moins de tutos que Requests

- L’asynchrone demande de piger les event loops

- Pas de parsing HTML intégré

Parfait pour :

Extraction à haut débit, APIs, ou quand il faut scraper beaucoup de pages vite ().

lxml : parsing HTML/XML rapide et puissant pour l’extraction web python

C’est quoi ?

est une bibliothèque ultra-performante pour parser HTML et XML, avec support XPath et sélecteurs CSS. C’est le moteur de nombreux outils (dont les sélecteurs de Scrapy).

Comment l’utiliser :

Extraire citations et auteurs :

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))Points forts :

- Ultra rapide, même sur de gros documents

- Support XPath puissant pour requêtes complexes

- Efficace en mémoire

Points faibles :

- Prise en main pour XPath

- Documentation moins accessible que BS4

- Installation parfois capricieuse

Parfait pour :

Parsing de gros volumes ou de HTML/XML complexe, ou pour des requêtes avancées ().

Pydantic : validation des données pour des résultats d’extraction web propres en python

C’est quoi ?

n’est pas un extracteur – c’est une bibliothèque de validation et de modélisation des données. Après extraction, Pydantic t’aide à garantir que tes données sont propres, typées et prêtes à l’emploi.

Comment l’utiliser :

Valider des données extraites :

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))Points forts :

- Validation stricte (détecte les erreurs tôt)

- Conversion automatique des types (chaînes en nombres, dates, etc.)

- Modèles déclaratifs (code clair et maintenable)

- Gère les structures de données complexes

Points faibles :

- Prise en main pour la syntaxe des modèles

- Ajoute un peu de complexité à la chaîne d’extraction

Parfait pour :

S’assurer que tes données extraites sont propres, cohérentes et prêtes à être analysées ou importées ().

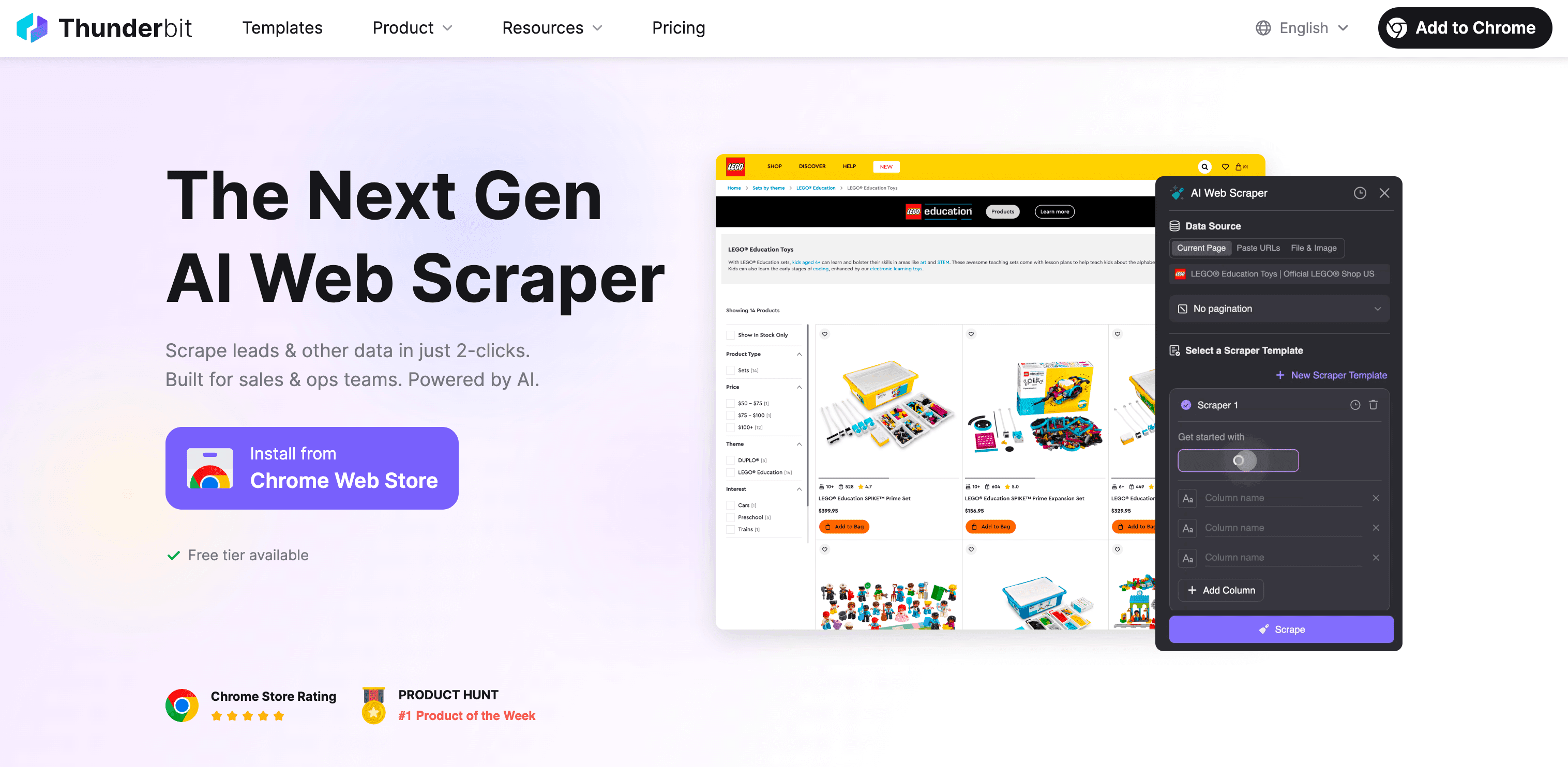

Alternative sans code : Thunderbit Extracteur Web IA pour les pros

Soyons clairs. Si tu es arrivé jusqu’ici et que tu te dis « Python, c’est cool, mais je n’ai pas envie d’apprendre XPath ce week-end », tu n’es pas le seul. C’est justement pour ça qu’on a créé .

Thunderbit, c’est quoi ?

Thunderbit, c’est une extension Chrome d’extraction web sans code, boostée à l’IA. Elle s’adresse aux pros – commerciaux, e-commerce, marketing, agents immobiliers – qui veulent des données web sans se prendre la tête avec le code, les proxies ou les anti-bots.

Pourquoi Thunderbit surpasse les bibliothèques python extraction web pour les non-codeurs :

- Zéro code : Clique sur « Suggérer les champs IA », laisse l’IA de Thunderbit lire la page, puis « Extraire ». C’est tout. Tu peux extraire n’importe quel site, PDF ou image en deux clics.

- Gère le contenu dynamique : Thunderbit fonctionne dans ton navigateur (ou dans le cloud), donc il récupère les données sur les sites JavaScript, scroll infini ou même derrière un login.

- Extraction de sous-pages : Besoin de détails sur chaque fiche produit ou profil ? Thunderbit visite chaque sous-page et enrichit ton tableau automatiquement.

- Structuration IA des données : Thunderbit propose les noms de champs, types de données, et même des prompts personnalisés. Tu peux étiqueter, formater, traduire et organiser tes données à la volée.

- Résistant aux anti-bots : Pas besoin de proxies ni de craindre les blocages – Thunderbit utilise de vraies sessions navigateur et l’IA pour contourner la plupart des protections.

- Export partout : Télécharge tes données vers Excel, Google Sheets, Airtable, Notion, CSV ou JSON – gratuitement et sans limite.

- Templates prêts à l’emploi : Pour les sites populaires (Amazon, Zillow, Instagram, Shopify, etc.), choisis un modèle et c’est parti. Aucun paramétrage.

- Fonctionnalités gratuites : Extraction d’emails, téléphones et images totalement gratuite. L’auto-remplissage IA des formulaires en ligne aussi.

Thunderbit vs bibliothèques python extraction web :

| Fonctionnalité | Bibliothèques Python | Thunderbit |

|---|---|---|

| Code requis | Oui | Non |

| Contenu dynamique | Parfois (navigateur) | Oui (navigateur/cloud) |

| Gestion anti-bot | Manuel (proxies, headers) | Intégré (session navigateur, IA) |

| Structuration des données | Manuelle (code, parsing) | Automatique, IA |

| Extraction sous-pages | Code personnalisé | 1 clic |

| Export | CSV/JSON (code) | Excel, Google Sheets, Airtable, Notion, etc. |

| Templates | DIY ou communauté | Intégrés pour sites populaires |

| Maintenance | À votre charge | L’équipe Thunderbit s’en occupe |

Pour qui Thunderbit est fait ?

Si tu bosses dans la vente, l’e-commerce, le marketing ou l’immobilier et que tu as besoin de données web – leads, prix, infos produits, annonces – sans bagage technique, Thunderbit est fait pour toi. C’est le moyen le plus rapide de passer de « J’ai besoin de cette donnée » à « Voilà le tableau », sans une ligne de Python.

Envie de voir comment ça marche ? et teste gratuitement. Ou découvre plus d’astuces sur le .

Conclusion : comment choisir la bonne bibliothèque python extraction web (ou un outil sans code)

En résumé, les bibliothèques python extraction web sont puissantes, flexibles et peuvent tout faire – à condition d’être à l’aise avec le code et d’y consacrer du temps. Petit rappel :

- ZenRows : Parfait pour extraire à grande échelle sur des sites protégés, avec anti-bot intégré.

- Selenium & Playwright : Top pour les sites dynamiques et interactifs, mais plus lourds et techniques.

- Requests & HTTPX : Idéals pour les pages statiques et APIs ; HTTPX brille pour l’asynchrone et la vitesse.

- Beautiful Soup & lxml : Les références pour parser le HTML – BS4 pour débuter, lxml pour la perf.

- Scrapy : Le framework pour les crawls structurés à grande échelle.

- urllib3 : Pour les besoins HTTP personnalisés et la concurrence élevée.

- Pydantic : Pour garantir la propreté et la cohérence de tes données extraites.

Mais si tu n’es pas développeur – ou que tu veux aller vite – est ton raccourci. Pas de code, pas de maintenance, juste des résultats.

Mon conseil :

- Si tu aimes Python et veux tout maîtriser, choisis la bibliothèque adaptée à ton cas et à ton niveau.

- Si tu veux juste la donnée (et dormir un peu plus), laisse l’IA de Thunderbit faire le boulot.

Dans tous les cas, le web déborde de données prêtes à devenir des pépites. Que tu sois expert Python ou pro qui préfère éviter le code, il y a une solution pour toi en 2025. Et si tu veux papoter extraction, automatisation ou garnitures de pizza de PDG, tu sais où me trouver.

Bonne extraction !

FAQ

1. Quelles sont les bibliothèques python extraction web les plus populaires ?

Parmi les bibliothèques python extraction web les plus utilisées, tu trouveras Requests pour les pages statiques, Selenium pour les sites dynamiques avec JavaScript, et Scrapy pour les crawls à grande échelle. Le choix dépend de la complexité des données, du besoin de concurrence et du niveau de dynamisme du contenu.

2. Comment gérer les sites riches en JavaScript lors de l’extraction ?

Pour les sites blindés de JavaScript, Selenium et Playwright sont de super options. Ces bibliothèques simulent les actions d’un utilisateur et chargent le contenu dynamique. ZenRows est aussi une alternative simple, avec une API qui gère le JavaScript et contourne les protections anti-bot sans prise de tête.

3. Comment Thunderbit peut-il aider mon entreprise à extraire des données web ?

Thunderbit est un extracteur web IA sans code qui permet aux pros de collecter des données web sans aucune programmation. Que ce soit pour surveiller les prix des concurrents, générer des leads ou extraire des infos produits, Thunderbit simplifie l’extraction grâce à l’automatisation IA, la gestion du contenu dynamique, les protections anti-bot et des exports en deux clics.

Pour aller plus loin :