Imagine la situation : il est 14h un mardi, ton manager débarque et te demande une liste de prix de concurrents. Tu te retrouves face à un site blindé de données précieuses… mais tout est planqué derrière une montagne de HTML. Tu vas vraiment coder un extracteur Python à la main ? Ou tu rêves d’un bouton magique qui fait tout à ta place ?

L’extraction web, ce n’est plus réservé aux hackers ou aux data scientists entourés d’écrans noirs. Aujourd’hui, c’est devenu un super-pouvoir pour les équipes business, les marketeurs, les chercheurs, ou toute personne qui veut transformer des pages web en tableaux de données. Le secteur explose : il pesait déjà et ça ne fait qu’augmenter. Mais avec tous les outils qui existent, choisir le bon, c’est parfois comme hésiter entre un couteau suisse et un scalpel. Aujourd’hui, on fait le point sur deux stars de Python — Scrapy et Beautiful Soup — et on regarde comment des solutions no-code comme s’intègrent pour ceux qui veulent zapper le code.

Scrapy vs. Beautiful Soup : Les bases de l’extraction web en Python

Si tu as déjà tapé « Python scraper » sur Google, tu es forcément tombé sur Scrapy et Beautiful Soup. Ces deux outils sont incontournables, mais ils ne servent pas exactement à la même chose.

- Scrapy est un framework. Imagine-le comme un robot multifonction : il gère tout, de la récupération des pages à l’export des résultats, en passant par le suivi des liens et le parsing des données. Il est taillé pour les gros volumes — des centaines ou milliers de pages, avec gestion des requêtes et automatisation du flux de données.

- Beautiful Soup est une bibliothèque. C’est plutôt le couteau du chef : parfait pour découper et manipuler du HTML, mais il faut apporter les ingrédients (le HTML) et faire le reste (récupération, navigation, sauvegarde) soi-même.

Les deux servent à créer des « extracteurs Python » — des scripts qui extraient des données de sites web. Mais le choix dépend surtout de ton projet et de ton aisance avec le code.

Quand utiliser Scrapy : Puissance et passage à l’échelle pour vos projets d’extraction

Imaginons que tu dois extraire tout un site e-commerce — des milliers de fiches produits, des mises à jour régulières, et peut-être même contourner quelques protections anti-bot. Là, Scrapy est dans son élément.

Scrapy est pensé pour l’extraction web automatisée à grande échelle. Il propose :

- Requêtes asynchrones : Récupère des dizaines de pages en même temps.

- Crawling intégré : Suit automatiquement les liens, gère la pagination et la file d’attente des URLs.

- Pipelines : Nettoie, valide et exporte tes données en CSV, JSON ou base de données, sans te prendre la tête.

- Rotation des proxies et user-agents : Déjoue les blocages basiques grâce à des middlewares intégrés.

- Planification : Lance tes spiders à intervalles réguliers pour surveiller ou rafraîchir tes données.

Si tu as besoin d’un outil qui tourne tous les jours, gère les erreurs et s’adapte à la montée en charge, Scrapy, c’est comme embaucher une brigade de cuisine pro.

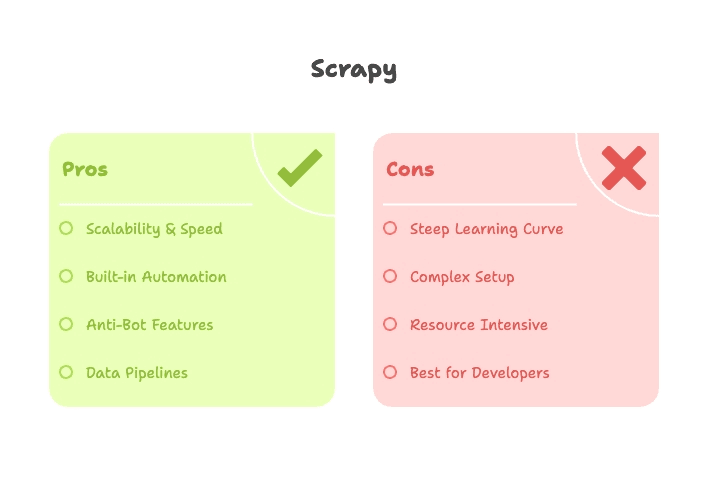

Les points forts de Scrapy pour l’extraction Python

- Scalabilité : Scrapy peut parcourir des milliers (voire des millions) de pages tout en optimisant la mémoire et la concurrence ().

- Rapidité : Son moteur asynchrone permet d’aller très vite, parfait pour les gros volumes ().

- Extensible : Besoin de résoudre des CAPTCHAs, de gérer du JavaScript ou d’exporter vers S3 ? Il y a des plugins pour tout ça.

- Automatisation : Scrapy est fait pour l’extraction récurrente et en production — tu le lances, il s’occupe du reste.

Les limites et la courbe d’apprentissage de Scrapy

Mais attention : Scrapy n’est pas le plus simple pour débuter. Il faut piger les spiders, pipelines, middlewares et la structure des projets. L’installation peut être un peu galère (merci Twisted), et le débogage des sélecteurs sans interface visuelle demande de la patience.

- Courbe d’apprentissage raide : Compte quelques heures (voire jours) pour faire tourner ton premier spider ().

- Trop lourd pour les petits besoins : Pour une seule page, Scrapy peut sembler disproportionné.

- Gestion limitée du JavaScript : Scrapy seul ne gère pas le JavaScript — il faut l’associer à Splash ou Selenium pour les contenus dynamiques.

Beautiful Soup : Rapide, flexible et parfait pour débuter

À l’inverse, si tu veux juste récupérer les derniers titres d’actualité d’une page ou extraire un tableau Wikipédia pour une analyse ponctuelle, Beautiful Soup est l’outil parfait.

Beautiful Soup est une bibliothèque légère de parsing HTML/XML. Elle ne télécharge pas les pages — on l’utilise généralement avec la bibliothèque requests pour obtenir le HTML, puis Beautiful Soup pour naviguer et extraire les données.

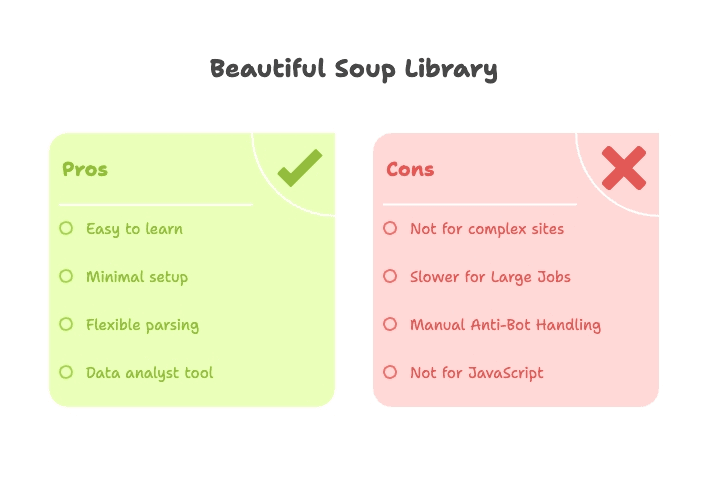

- Installation ultra-simple : Un pip install, un import, et c’est parti.

- Courbe d’apprentissage douce : Même sans être un pro de Python, tu obtiens des résultats en une ou deux heures ().

- Parsing flexible : Recherche par balise, classe, ID ou texte — parfait pour du HTML un peu fouillis.

Les avantages de Beautiful Soup pour les débutants

- Accessible : Pas besoin de framework — juste du Python de base et un peu de HTML.

- Résultats rapides : Idéal pour prototyper, les projets académiques ou les extractions ponctuelles.

- Flexible : S’intègre facilement avec d’autres outils Python (requests, pandas, etc.).

- Tolérant au HTML mal formé : Beautiful Soup gère même les balises cassées.

Les limites de Beautiful Soup

Mais Beautiful Soup n’est pas une solution tout-en-un :

- Pas de crawling intégré : Il faut écrire soi-même les boucles pour parcourir les pages.

- Moins rapide sur de gros volumes : Fonctionne de façon séquentielle, donc lent sur des centaines de pages.

- Peu d’outils anti-bot : À toi de gérer les headers, proxies, et de contourner les blocages.

- Gestion limitée du contenu dynamique : Pour les sites JavaScript, il faut ajouter Selenium ou Playwright.

Scrapy vs. Beautiful Soup : Comparatif des fonctionnalités

Comparons-les point par point :

| Fonctionnalité | Scrapy | Beautiful Soup |

|---|---|---|

| Type | Framework (tout-en-un) | Bibliothèque (parser uniquement) |

| Installation | Structure de projet, CLI, fichiers de config | Script simple, pip install |

| Idéal pour | Extraction à grande échelle, automatisée et récurrente | Petits besoins, prototypage, tâches ponctuelles |

| Vitesse | Rapide à grande échelle (async, concurrence) | Rapide pour une page, lent à grande échelle |

| Crawling | Intégré (suit liens, pagination) | Manuel (boucles à écrire soi-même) |

| Anti-bot | Proxies, rotation user-agent, retries, plugins | Manuel (headers, proxies dans requests) |

| Extensible | Plugins, middlewares, pipelines | À combiner avec d’autres libs Python |

| Courbe d’apprentissage | Raide (spiders, pipelines, async) | Douce (Python + HTML de base) |

| Contenu dynamique | Plugins nécessaires (Splash, Selenium) | Nécessite Selenium/Playwright |

| Export de données | CSV, JSON, BDD (intégré) | Manuel (fichier ou pandas) |

| Public cible | Développeurs, data engineers, projets récurrents | Débutants, analystes, scripts rapides |

En résumé : Scrapy est fait pour les projets d’extraction volumineux, complexes ou récurrents — si tu es à l’aise avec Python et les frameworks. Beautiful Soup est parfait pour les petits besoins ciblés ou pour débuter.

Courbe d’apprentissage : Quel extracteur Python est le plus accessible ?

Soyons clairs : personne n’a envie de passer une semaine à apprendre un outil juste pour extraire un tableau.

- Beautiful Soup : Tu peux passer de zéro à extraction en une après-midi. Un peu de Python, un peu de HTML, et c’est tout. Il y a plein de tutos, et les résultats sont rapides ().

- Scrapy : Il faut comprendre les spiders, pipelines, l’asynchrone et les outils en ligne de commande. Ce n’est pas insurmontable, mais c’est plus qu’un simple « hello world » ().

Si tu n’es pas technique ou que tu veux aller vite, Beautiful Soup est une porte d’entrée idéale. Mais si tu veux un extracteur robuste, automatisé et évolutif, investir du temps dans Scrapy sera payant.

Performance et gestion des blocages : Scrapy vs. Beautiful Soup en pratique

Performance :

- Scrapy : Gère la concurrence nativement. Tu peux extraire 16, 32 pages ou plus en parallèle, ce qui accélère vraiment les gros volumes ().

- Beautiful Soup : Fonctionne page par page, sauf si tu ajoutes toi-même du threading ou de l’async. Parfait pour quelques pages, lent pour des centaines.

Anti-bot :

- Scrapy : Middleware pour proxies, rotation des user-agents, retries, et même des plugins pour résoudre les CAPTCHAs ou gérer le JavaScript ().

- Beautiful Soup : À toi de jouer. Tu peux définir headers ou proxies dans requests, mais il n’y a pas de protection intégrée. En cas de blocage, il faudra bricoler ().

Cas d’usage typiques : Quel extracteur Python pour quel projet ?

Petit pense-bête pour choisir :

| Cas d’usage | Outil recommandé | Pourquoi ? |

|---|---|---|

| Génération de leads (petit volume) | Beautiful Soup | Extraction rapide et ponctuelle sur quelques pages |

| Génération de leads (gros volume/récurrent) | Scrapy ou Thunderbit | Scrapy pour les devs, Thunderbit pour les non-techs — gestion du volume et de l’automatisation |

| Veille tarifaire e-commerce | Scrapy ou Thunderbit | Scrapy pour des crawls personnalisés, Thunderbit pour une extraction instantanée sans code |

| Veille de contenu/actualités | Scrapy ou Thunderbit | Scrapy pour des crawls planifiés multi-sites, Thunderbit pour une mise en place rapide |

| Audit SEO (quelques pages) | Beautiful Soup | Script facile, résultats rapides |

| Audit SEO (site complet) | Scrapy | Crawl massif, export structuré |

| Extraction réseaux sociaux | Thunderbit | Modèles prêts à l’emploi, gère le contenu dynamique, sans code |

| Recherche académique (ponctuel) | Beautiful Soup | Prototypage rapide, installation minimale |

| Enrichissement/agrégation de données | Thunderbit | Enrichissement par IA, export facile vers Sheets/Airtable |

Pour la plupart des pros, si tu n’es pas développeur, des outils comme changent la donne (ou plutôt… te font gagner un temps fou).

Au-delà de Python : Thunderbit, l’extracteur web no-code

Soyons honnêtes : tout le monde n’a pas envie de coder. Et franchement, ce n’est pas indispensable — surtout si ton but, c’est juste de transformer une page web en tableur, pas de piloter une fusée.

C’est là que entre en jeu. Thunderbit, c’est un extracteur web IA sans code — une extension Chrome qui te permet d’extraire des données de n’importe quel site en quelques clics. Voilà comment il te simplifie la vie :

- Aucun Python, aucune config : Installe l’extension, ouvre la page, c’est prêt.

- Suggestion de champs par IA : Clique sur « Suggérer des champs IA » et Thunderbit lit la page, propose les colonnes et prépare ton tableau automatiquement ().

- Extraction sur sous-pages : Besoin de récupérer des infos sur des pages liées ? Thunderbit suit les liens et enrichit tes données — sans te prendre la tête avec des boucles ou des spiders ().

- Pagination et scroll infini : Gère les listes multi-pages ou le scroll infini d’un simple clic.

- Export instantané : Envoie tes données direct vers Google Sheets, Airtable, Notion ou télécharge-les en CSV/Excel ().

- Aperçu en temps réel : Visualise tes résultats au fur et à mesure — fini le « run and pray » du code.

- Enrichissement par IA : Résume, catégorise ou traduis tes données à la volée ().

Thunderbit propose aussi des modèles prêts à l’emploi pour des sites populaires comme Amazon, LinkedIn, Google Maps, etc. Pour la plupart des besoins business, c’est la solution la plus proche du « bouton magique ».

Pourquoi choisir Thunderbit plutôt que les outils Python ?

- Aucune courbe d’apprentissage : Pas besoin de Python, HTML ou de déboguer des erreurs 403. Si tu sais utiliser un navigateur, tu sais utiliser Thunderbit.

- Rapidité : Passe de « j’ai besoin de ces données » à « voici le tableau » en quelques minutes, pas en heures ou jours.

- Zéro maintenance : L’IA de Thunderbit s’adapte à plein de changements de sites, et les modèles sont mis à jour par l’équipe. Fini les scripts qui plantent la nuit.

- Gestion des blocages : Fonctionne dans ton navigateur (comme un vrai utilisateur) ou dans le cloud, avec des stratégies intégrées pour éviter les blocages.

- Collaboration : Partage modèles et résultats avec ton équipe, sans dépôt de code ni galère de versions.

- Économique : Offre gratuite pour les petits besoins, formules abordables pour les projets plus ambitieux ().

Pour les équipes commerciales, marketing, opérations, ou toute personne qui veut des données tout de suite, Thunderbit est une vraie bouffée d’air frais. (Et pour avoir passé trop de nuits à déboguer des scripts Python, je peux te dire que ça change la vie !)

Comment choisir le bon outil d’extraction web ?

Alors, tu choisis quoi ? Voici un guide express :

- À l’aise avec Python ?

- Oui : Passe à l’étape 2.

- Non : Utilise ou un autre outil no-code.

- Ton projet est-il petit (une page, ponctuel, prototype) ?

- Oui : Beautiful Soup (avec requests) suffit.

- Non : Scrapy pour les gros besoins récurrents ou complexes.

- Faut-il gérer des blocages, la concurrence ou l’automatisation ?

- Oui : Scrapy est fait pour ça.

- Non : Beautiful Soup suffit pour les tâches simples et peu risquées.

- Tu veux des résultats instantanés, un export facile ou collaborer en équipe ?

- Oui : Thunderbit est la solution — sans code, sans prise de tête.

Petit tableau récap’ :

| Votre besoin | Outil recommandé |

|---|---|

| Pas de code, résultats immédiats | Thunderbit |

| Petit projet ponctuel, scriptable | Beautiful Soup |

| Extraction massive, automatisée, complexe | Scrapy |

| Collecte de données business récurrente | Thunderbit ou Scrapy |

| Prototypage académique | Beautiful Soup |

Conclusion : Scrapy, Beautiful Soup ou Thunderbit — lequel choisir ?

L’extraction web est aujourd’hui plus accessible — et plus essentielle — que jamais. Que tu sois développeur à la recherche d’un pipeline solide ou pro qui veut transformer une page web en tableur, il y a un outil fait pour toi.

- Scrapy : Idéal pour les développeurs, les projets volumineux, récurrents ou complexes. Puissant, mais demande un peu d’apprentissage.

- Beautiful Soup : Parfait pour les débutants, analystes ou pour extraire rapidement des données de quelques pages. Simple, flexible et top pour prototyper.

- Thunderbit : La solution IA sans code pour tous les autres. Si tu veux éviter le code, le débogage et la maintenance, Thunderbit te permet d’extraire, enrichir et exporter tes données en quelques minutes — direct depuis ton navigateur.

Envie de tester l’extraction sans code ? et essaie-la. Ou jette un œil à notre pour plus de guides, astuces et cas d’usage.

Au final, le meilleur outil, c’est celui qui te donne les données dont tu as besoin — sans transformer ton mardi après-midi en session de débogage Python. Et si tu veux partager tes galères ou victoires d’extraction web, tu sais où me trouver.

FAQ

1. Quel est le plus adapté pour débuter : Scrapy ou Beautiful Soup ?

Beautiful Soup est bien plus accessible pour les débutants. Son installation est simple, sa prise en main rapide, et il est parfait pour les petits besoins. Scrapy est puissant mais demande plus d’apprentissage — il convient mieux aux développeurs sur des projets volumineux ou récurrents.

2. Peut-on utiliser Scrapy ou Beautiful Soup sans coder ?

Non, ces outils nécessitent de connaître Python et un peu de HTML. Si tu ne veux pas écrire de scripts, un outil no-code comme est plus adapté : il permet d’extraire des données en langage naturel, directement dans le navigateur.

3. Faut-il utiliser Scrapy et Beautiful Soup ensemble ?

La plupart du temps, non. Scrapy possède son propre moteur de parsing et fonctionne de façon autonome. Beautiful Soup s’utilise seul pour les petits besoins. Certains utilisateurs avancés les combinent, mais ce n’est pas nécessaire pour des résultats rapides et pratiques.

4. Que faire si le site utilise du JavaScript ou du scroll infini ?

Ni Scrapy ni Beautiful Soup ne gèrent le JavaScript nativement — il faut ajouter des outils comme Selenium. prend en charge de nombreux sites modernes automatiquement, y compris ceux avec scroll infini ou contenu dynamique.

5. Je veux juste transformer une page web en tableur. Dois-je vraiment apprendre Python ?

Non. Si ton objectif est d’obtenir des données structurées rapidement — comme une liste de prix ou un annuaire dans Excel — apprendre Scrapy ou Beautiful Soup est souvent disproportionné. le fait en deux clics, sans écrire une ligne de code.

Envie d’en savoir plus ? Découvre , , ou explore d’autres articles sur le .