Tu t’es déjà retrouvé devant un site web en te demandant comment choper toutes ces données précieuses dans un tableur, sans y passer la nuit à faire du copier-coller ? Rassure-toi, t’es loin d’être le seul ! En 2025, l’extraction de données web, c’est plus réservé aux geeks : c’est devenu un vrai super-pouvoir pour les boîtes. Que tu veuilles te faire une liste de prospects, surveiller les prix des concurrents ou nourrir tes analyses, tout le monde veut accéder vite fait aux infos du web. Bonne nouvelle : avec Python, l’extraction web devient non seulement accessible, mais aussi carrément simple, même si ton dernier souvenir de code, c’est la customisation de ta page MySpace.

Dans ce tuto, je t’emmène étape par étape pour extraire des données avec Python. On va voir les bases, comment gérer les sites statiques et dynamiques, et je te montrerai comment booster ta productivité en mixant Python avec , notre extracteur web IA maison. Que tu sois totalement débutant ou que tu veuilles passer au niveau supérieur, tu trouveras ici des conseils concrets, des exemples de code qui marchent et quelques astuces tirées de mon expérience dans le SaaS et l’automatisation.

C’est quoi l’extraction web et pourquoi miser sur Python ?

On commence par la base. L’extraction web, c’est automatiser la récup’ d’infos sur des sites internet. Imagine : tu apprends à ton ordi à « lire » une page web et à en sortir pile ce qui t’intéresse — prix, titres d’actu, coordonnées — sans te ruiner la santé à tout faire à la main (). Les boîtes s’en servent pour surveiller la concurrence en temps réel, faire de la veille, générer des leads ou entraîner des modèles d’IA ().

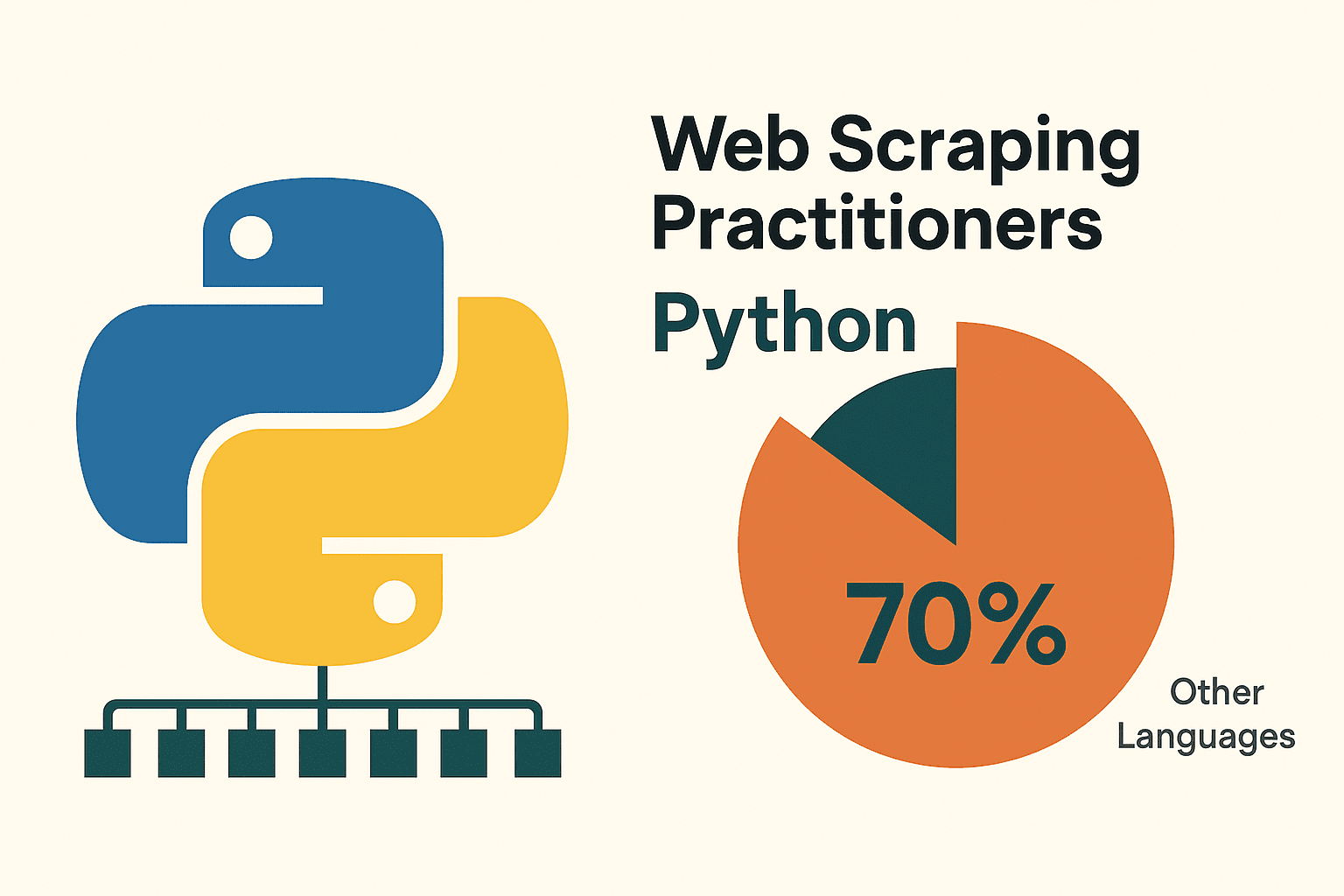

Mais alors, pourquoi Python est LE langage de référence pour l’extraction web ? Déjà, il est super simple à prendre en main : sa syntaxe est claire, presque comme de l’anglais, donc parfait pour débuter. Mais surtout, Python a un écosystème de dingue : des bibliothèques comme requests, BeautifulSoup, Scrapy, Selenium et pandas te permettent de tout faire, de la récup’ de pages à l’analyse des données. Pas étonnant que , loin devant les autres langages.

Pourquoi Python est le top pour l’extraction web ?

J’ai testé pas mal de langages au fil des années, mais Python reste le plus efficace pour l’extraction web — surtout pour commencer. Voilà pourquoi :

- Simplicité et clarté : La syntaxe de Python est clean, ce qui rend l’écriture et le débogage des scripts bien plus faciles ().

- Un max de bibliothèques : Des outils comme requests (pour les requêtes HTTP), BeautifulSoup (pour l’analyse HTML), Scrapy (pour le crawling à grande échelle), Selenium (pour automatiser le navigateur) et pandas (pour l’analyse de données) couvrent tous les besoins ().

- Une grosse communauté : Python, c’est une armée de gens prêts à t’aider. Si tu bloques, la solution existe sûrement déjà sur le web.

Comment Python se compare aux autres solutions ? Petit tableau récap’ :

| Approche | Avantages | Inconvénients |

|---|---|---|

| Python | Facile à apprendre, plein de bibliothèques, top pour l’analyse de données, super polyvalent | Faut écrire un peu de code, demande des outils en plus pour les sites très dynamiques |

| JavaScript/Node | Gère direct le contenu dynamique, adapté à l’asynchrone, même langage que le front-end web | Plus dur à prendre en main, moins de bibliothèques dédiées à l’extraction, plus verbeux pour les débutants |

| R (rvest) | Pratique pour l’extraction rapide en recherche, s’intègre à l’analyse de données R | Écosystème plus limité, moins costaud pour les sites dynamiques |

| Outils no-code | Zéro code à écrire, mise en place rapide, assistants IA/visuels (genre Thunderbit) | Flexibilité limitée pour la logique custom, quotas d’utilisation, moins de contrôle |

(, )

Pour la plupart des pros et des passionnés de data, Python, c’est le meilleur compromis : puissant, flexible et accessible.

Préparer son environnement Python pour l’extraction de données

Avant de te lancer dans l’extraction, il faut installer et configurer ton environnement Python. Pas de panique, c’est plus simple qu’un meuble IKEA, et sans les vis en trop !

1. Installer Python :

Télécharge la dernière version de Python 3 sur . Sous Windows, pense à cocher « Ajouter Python au PATH » pendant l’installation. Sur Mac, passe par Homebrew (brew install python3). Sous Linux, un petit apt install python3 python3-pip et c’est plié ().

2. (Recommandé) Créer un environnement virtuel :

Ça permet d’isoler les bibliothèques de ton projet. Dans ton dossier de travail :

1python -m venv venv

2# Activation :

3# Windows :

4venv\Scripts\activate

5# Mac/Linux :

6source venv/bin/activate3. Installer les bibliothèques de base :

Dans le terminal, tape :

1pip install requests beautifulsoup4 pandas selenium lxmlrequests: pour les requêtes HTTPbeautifulsoup4: pour l’analyse HTMLpandas: pour manipuler/exporter les donnéesselenium: pour les sites dynamiques (optionnel)lxml: analyse rapide HTML/XML

4. Choisir un éditeur de code :

- (avec l’extension Python) : léger, populaire, parfait pour débuter.

- : complet, dédié à Python.

- : interactif, top pour tester et analyser ().

5. (Pour Selenium) Installer un WebDriver :

Selenium a besoin d’un pilote de navigateur (genre ChromeDriver). Le plus simple, c’est d’utiliser webdriver_manager :

1pip install webdriver-managerDans ton script :

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))Astuce : Si pip n’est pas reconnu, vérifie que Python est bien dans ton PATH et que l’environnement virtuel est activé.

Extraire des données de sites statiques avec Python : mode d’emploi

Les sites statiques, c’est les plus simples à extraire. Si tu vois les données dans le « code source » de la page, Python peut les choper.

Prenons l’exemple de , un site d’entraînement bien connu.

Étape 1 : Récupérer la page

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200 = OKÉtape 2 : Analyser le HTML

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")Étape 3 : Extraire les données

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")Étape 4 : Gérer la pagination

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)Et voilà, t’as extrait plusieurs pages et sauvegardé les données dans un CSV. Plutôt cool pour quelques lignes de code, non ? ()

Bonnes pratiques : Pense toujours à checker le fichier robots.txt et les conditions d’utilisation du site avant d’extraire. Reste cool : évite d’envoyer trop de requêtes à la seconde. Un petit time.sleep(1) entre chaque requête, c’est la base.

Extraire des sites dynamiques : utiliser Selenium avec Python

Certains sites sont plus coriaces. Si les données n’apparaissent qu’après du JavaScript (scroll infini, pop-ups, tableaux dynamiques), il te faut un outil qui imite un vrai navigateur. C’est là que Selenium entre en scène.

Étape 1 : Lancer le navigateur

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")Étape 2 : Attendre le chargement du contenu

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)Étape 3 : Scroller ou cliquer pour charger plus de contenu

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightÉtape 4 : Extraire les données

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})Étape 5 : Sauvegarder et nettoyer

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()Astuces :

- Utilise les « waits » explicites (

WebDriverWait) pour éviter les bugs si les éléments ne sont pas encore chargés (). - Pour un mode sans interface graphique, ajoute

options.headless = Truedans tes options Chrome. - Si tu repères une API JSON dans le trafic réseau du site, tu peux souvent zapper Selenium et utiliser

requests— c’est bien plus rapide !

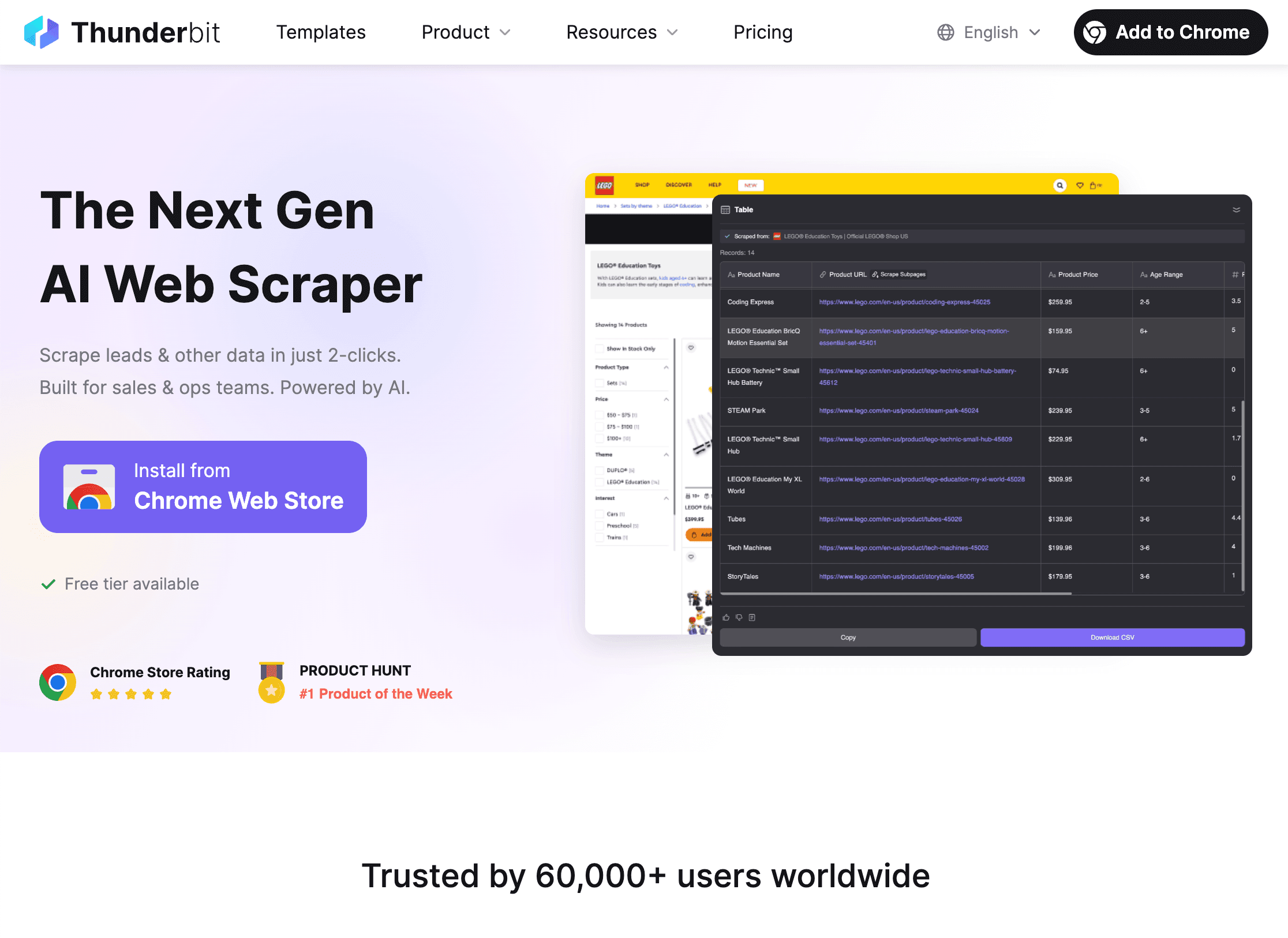

Combiner Thunderbit et Python pour des workflows de folie

C’est là que ça devient vraiment fun. Même avec toutes les bibliothèques Python, extraire des données sur un site complexe peut vite tourner au casse-tête. C’est là que fait la différence.

Thunderbit, c’est une extension Chrome d’extraction web boostée à l’IA, qui te permet de pointer, cliquer et extraire des données de n’importe quel site — sans taper une ligne de code. Parfait pour les pros qui veulent des données vite fait, mais aussi nickel pour bosser main dans la main avec Python pour des traitements avancés.

Comment Thunderbit + Python te font gagner un temps fou :

Comment Thunderbit + Python te font gagner un temps fou :

-

Utilise Thunderbit pour extraire les données :

- Ouvre l’.

- Clique sur « Suggestions IA » pour laisser l’IA de Thunderbit repérer les champs à extraire.

- Gère la pagination, les sous-pages, les images ou les PDF en quelques clics.

- Exporte tes données direct en CSV, Excel, Google Sheets, Notion ou Airtable.

-

Analyse et nettoie les données dans Python :

- Charge le fichier exporté dans Python avec pandas :

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - Tu peux alors filtrer, nettoyer, fusionner, visualiser ou faire des analyses avancées selon tes besoins.

- Charge le fichier exporté dans Python avec pandas :

-

Automatise toute la chaîne :

- Thunderbit permet l’extraction programmée, pour recevoir des données fraîches chaque jour.

- Combine avec des scripts Python pour des rapports automatiques, des alertes ou d’autres traitements.

Pourquoi utiliser les deux ? Thunderbit te fait gagner un temps fou sur les sites galère ou pour des besoins ponctuels. Python te donne la main pour analyser, nettoyer et intégrer ces données dans tes process. C’est comme le beurre de cacahuète et la confiture : chacun est bon seul, mais ensemble c’est encore meilleur ().

Gérer les galères courantes lors de l’extraction web avec Python

L’extraction web, c’est pas toujours un long fleuve tranquille. Voici les galères les plus fréquentes — et comment t’en sortir :

1. Blocages (erreurs 403/429, CAPTCHAs) :

- Change régulièrement ton User-Agent pour simuler différents navigateurs.

- Utilise des proxies pour varier les adresses IP ().

- Ajoute des pauses entre les requêtes (

time.sleep()). - Respecte le robots.txt et les règles de crawl-delay.

- Pour les CAPTCHAs, Selenium permet parfois de les résoudre à la main, ou passe par un service dédié.

2. Contenu dynamique pas chargé :

- Utilise Selenium pour les pages très dynamiques.

- Cherche des appels API internes dans l’onglet réseau du navigateur — tu peux parfois récupérer direct les données en JSON.

3. Problèmes de connexion ou de session :

- Utilise

requests.Session()pour garder les cookies. - Automatise la connexion avec Selenium si besoin.

4. Changements de structure du site :

- Privilégie les sélecteurs robustes (ID plutôt que classes).

- Surveille les changements et adapte tes scripts.

- L’IA de Thunderbit s’adapte toute seule aux changements de mise en page, donc zéro maintenance pour toi.

5. Gros volumes de données :

- Utilise la concurrence (

concurrent.futuresouasyncio) pour accélérer l’extraction. - Écris les données au fur et à mesure sur disque ou en base de données pour éviter de saturer la mémoire.

(, )

Dépannage : déboguer et optimiser tes scripts d’extraction

Quand ça coince (et ça arrivera !), voici une checklist rapide :

- HTTP 404/403/429 : Vérifie l’URL, les headers et la fréquence des requêtes.

- Timeouts/erreurs de connexion : Mets en place des tentatives avec backoff exponentiel.

- AttributeError/NoneType : Ajoute des vérifs avant d’accéder aux éléments ; inspecte le HTML réellement reçu.

- Problèmes d’encodage : Mets

response.encoding = 'utf-8'ou précise l’encodage à la sauvegarde. - Élément Selenium introuvable : Utilise les « waits » explicites ; vérifie tes sélecteurs.

- Erreurs de mémoire : Écris les données par lots, utilise des générateurs ou une base de données pour les très gros volumes.

- Débogage : Utilise des print/logs ou sauvegarde le HTML pour inspection.

Pour les perfs, pense aux requêtes asynchrones (aiohttp), au multithreading ou à un framework comme Scrapy pour les gros projets. Mais ne te prends pas la tête à sur-optimiser pour les petits scripts : la clarté, c’est le plus important quand on apprend.

Bonnes pratiques pour une extraction web éthique et légale

Avec le pouvoir d’extraire vient la responsabilité ! Voici comment rester dans les clous (et dormir tranquille) :

- Respecte le robots.txt et les CGU : Si un site interdit l’extraction, touche pas.

- Évite les données perso ou sensibles : Reste sur les infos publiques ; ne collecte rien que tu ne voudrais pas voir collecté sur toi.

- Sois cool : Limite la fréquence des requêtes, évite les heures de pointe et ne surcharge pas les serveurs.

- Identifie-toi : Utilise un User-Agent custom avec tes coordonnées si besoin.

- Vérifie la législation : Aux US, l’extraction de données publiques est en général OK, mais violer les CGU ou extraire des données privées, c’est risqué ().

- Utilise les API officielles si dispo : C’est plus safe et plus stable.

(, )

Conclusion & points clés à retenir

Savoir extraire des données avec Python, c’est une vraie compétence à l’ère de la data. En résumé :

- Python est le choix numéro un pour l’extraction web grâce à sa simplicité, ses bibliothèques et sa communauté ().

- Commence par les sites statiques avec requests et BeautifulSoup ; passe à Selenium pour le contenu dynamique.

- Thunderbit te fait gagner un temps fou sur les sites complexes ou pour des besoins ponctuels — puis utilise Python pour l’analyse et l’automatisation.

- Gère les galères avec des headers tournants, des proxies, des pauses et une gestion solide des erreurs.

- Sois éthique : Respecte les sites, évite les données sensibles et reste dans la légalité.

Mon conseil ? Commence petit : choisis un site simple, écris ton premier script et vois ce que tu peux en tirer. Une fois à l’aise, combine Thunderbit et Python pour des workflows encore plus puissants. Et rappelle-toi : chaque bug, c’est juste une énigme à résoudre (parfois avec un coup de main de Stack Overflow).

Envie de voir Thunderbit en action ou d’en savoir plus sur l’extraction ? Va faire un tour sur le ou abonne-toi à notre pour des tutos et des astuces.

Bonne extraction — que tes données soient toujours clean, tes scripts sans bug et ton IP jamais bloquée !

FAQ

1. C’est quoi l’extraction web, et c’est légal ?

L’extraction web, c’est automatiser la récup’ de données sur des sites. Extraire des données publiques, c’est en général légal aux US et dans pas mal de pays, mais il faut respecter les conditions d’utilisation, éviter les données sensibles et suivre les lois sur la vie privée ().

2. Pourquoi tout le monde utilise Python pour l’extraction web ?

Python est super accessible pour les débutants, a des bibliothèques puissantes pour chaque étape (requests, BeautifulSoup, Selenium, pandas) et une grosse communauté pour s’entraider ().

3. Quand utiliser Selenium plutôt que requests/BeautifulSoup ?

Utilise Selenium quand les données sont chargées dynamiquement par JavaScript et n’apparaissent pas dans le HTML de base. Selenium automatise un vrai navigateur, donc il « voit » ce que voit l’utilisateur.

4. Comment Thunderbit marche avec Python ?

Thunderbit permet d’extraire des données complexes ou non structurées grâce à l’IA en quelques clics, puis d’exporter en CSV/Excel/Sheets. Tu peux ensuite charger ces données dans Python pour les nettoyer, les analyser ou les automatiser — un vrai gain de temps.

5. Les meilleurs tips pour éviter les blocages lors de l’extraction ?

Change ton User-Agent, utilise des proxies, ajoute des pauses, respecte le robots.txt et évite les données sensibles ou privées. Pour les extractions massives, pense à des outils ou services anti-bot.

Prêt à te lancer ? Télécharge l’ et découvre à quel point c’est simple de combiner IA et Python pour tes projets data. Et si tu bloques, rappelle-toi : chaque grand extracteur a commencé par une seule ligne de code.

Pour aller plus loin