Laissez-moi vous partager la première fois où j’ai voulu extraire des données d’un site web pour ma boîte. J’étais installé à la table de la cuisine, un café à la main, l’autre sur un script Python bancal, en train d’essayer de récupérer les prix des produits d’un concurrent. Je me disais : « Franchement, ça doit être simple ! » Résultat ? Un CSV rempli de cases vides… et un respect tout neuf pour ceux qui disent « il suffit d’automatiser ça avec Python ». Avance rapide jusqu’en 2025 : l’extraction web est devenue un incontournable pour toutes les boîtes qui misent sur la donnée, et alimente les équipes commerciales, e-commerce, marketing et opérations avec des infos en temps réel, impossibles à collecter à la main.

Mais le vrai défi, c’est pas juste d’écrire du code : même si le scraping Python est plus puissant que jamais, le secteur bouge à toute vitesse. Le marché de l’extraction web explose — on parle de . Près de pour prendre de meilleures décisions. Pourtant, le vrai casse-tête, c’est de choisir le bon outil, de passer à l’échelle… et de ne pas devenir fou à force de jongler avec une forêt de scripts. Dans ce guide ultime, je vous présente toutes les grandes bibliothèques Python pour le scraping (avec exemples de code), des cas d’usage concrets, et pourquoi — même si j’adore Python — je pense que les solutions sans code comme sont le meilleur choix pour la majorité des entreprises en 2025.

C’est quoi l’extraction web avec Python ? (Explication simple)

Pour faire court, l’extraction web, c’est automatiser le « copier-coller ». Plutôt que de mobiliser une armée de stagiaires pour collecter des prix, des contacts ou des avis, tu utilises un logiciel qui visite les pages web, extrait les infos voulues et les balance dans un tableur ou une base de données. Le scraping Python, c’est juste faire tout ça avec des scripts Python : on récupère les pages, on analyse le HTML, et on extrait ce qui nous intéresse.

Imagine un assistant numérique qui parcourt les sites à ta place, 24h/24, sans jamais demander de pause café. Les données les plus recherchées par les boîtes ? Prix, fiches produits, contacts, avis, images, articles de presse, annonces immobilières… Certains sites proposent des API, mais la plupart non — ou alors elles sont ultra limitées. C’est là que l’extraction web prend tout son sens : elle permet d’accéder à grande échelle à des données publiques, même sans bouton « télécharger » officiel.

Pourquoi le Web Scraping Python est-il indispensable pour les équipes business ?

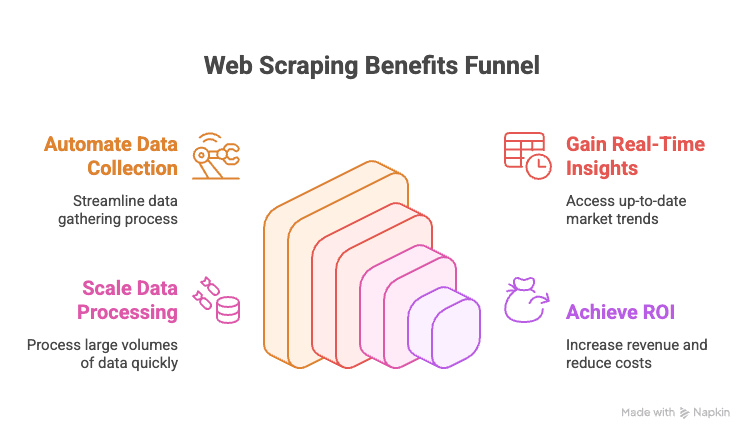

Soyons clairs : en 2025, si ta boîte ne fait pas d’extraction web, tu rates des occasions en or. Voilà pourquoi :

- Automatisation de la collecte de données : Fini le copier-coller interminable depuis les sites concurrents ou les annuaires en ligne.

- Données en temps réel : Accès instantané aux prix, stocks ou tendances du marché.

- Passage à l’échelle : Extraire des milliers de pages aussi vite que tu réchauffes ton plat au micro-ondes.

- ROI mesurable : Les entreprises pilotées par la donnée affichent .

Voici un tableau récapitulatif des usages à fort impact :

| Département | Exemple d’usage | Valeur ajoutée |

|---|---|---|

| Commercial | Extraire des leads depuis des annuaires, enrichir avec des emails | Listes de prospects plus larges et mieux ciblées |

| Marketing | Suivre les prix, promos et avis des concurrents | Campagnes plus pertinentes, réactivité accrue |

| E-commerce | Surveiller prix, stocks et avis produits | Tarification dynamique, alertes de stock |

| Opérations | Agréger les données fournisseurs, automatiser les rapports | Gain de temps, moins d’erreurs manuelles |

| Immobilier | Collecter des annonces sur plusieurs sites | Plus d’offres, réponses clients plus rapides |

En bref : l’extraction web, c’est l’arme secrète pour des décisions plus rapides, plus futées et plus compétitives.

Panorama : Les principales bibliothèques Python pour le Web Scraping (avec exemples)

Comme promis, voici un tour d’horizon complet. L’écosystème Python pour le scraping est immense : il y a une bibliothèque pour chaque besoin, du simple téléchargement de page à l’automatisation complète du navigateur. Voici les incontournables, avec des exemples de code :

urllib et urllib3 : Les bases des requêtes HTTP

Ce sont les outils intégrés de Python pour envoyer des requêtes HTTP. Un peu old school, mais fiables pour les tâches simples.

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # Code HTTP

6print(response.data[:100]) # 100 premiers octets du contenuÀ privilégier si tu veux zéro dépendance ou un contrôle très fin. Mais pour la plupart des usages, requests est plus agréable.

requests : La bibliothèque Python la plus populaire pour le scraping

S’il fallait une mascotte pour le scraping Python, ce serait requests. Simple, puissante, elle gère toute la complexité HTTP.

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # contenu JSON analysé (si la réponse est en JSON)Pourquoi autant de succès ? Elle gère cookies, sessions, redirections… Tu te concentres sur la donnée, pas sur la technique. Attention : requests ne fait que récupérer le HTML. Pour extraire les infos, il faut un parseur comme BeautifulSoup.

BeautifulSoup : Analyse HTML et extraction de données simplifiées

BeautifulSoup est la référence pour analyser le HTML en Python. Tolérante, facile à prendre en main, elle fonctionne parfaitement avec requests.

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"Idéale pour les petits/moyens projets ou pour débuter. Pour des volumes massifs ou des requêtes complexes, lxml est plus adapté.

lxml et XPath : Analyse HTML/XML rapide et puissante

Besoin de vitesse ou d’utiliser XPath (langage de requête pour XML/HTML) ? lxml est ton allié.

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")XPath permet d’extraire les données avec une grande précision. lxml est rapide et efficace, mais demande un peu plus d’apprentissage que BeautifulSoup.

Scrapy : Le framework pour le crawling à grande échelle

Scrapy, c’est le mastodonte pour les gros projets de scraping. Un vrai framework — l’équivalent de Django pour l’extraction web.

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }Scrapy gère les requêtes asynchrones, le suivi des liens, les pipelines et l’export dans de nombreux formats. Un peu trop lourd pour de petits scripts, mais imbattable pour crawler des milliers de pages.

Selenium, Playwright et Pyppeteer : Scraper les sites dynamiques

Quand un site charge ses données en JavaScript, il faut automatiser le navigateur. Selenium et Playwright sont les références.

Exemple Selenium :

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Exemple Playwright :

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")Ces outils peuvent tout faire comme un humain, mais sont plus lents et gourmands que le scraping HTTP pur. À utiliser uniquement si nécessaire.

MechanicalSoup, RoboBrowser, PyQuery, Requests-HTML : Outils complémentaires

-

MechanicalSoup : Automatise les formulaires et la navigation, basé sur Requests et BeautifulSoup.

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser : Similaire à MechanicalSoup, mais moins maintenu.

-

PyQuery : Analyse HTML façon jQuery.

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML : Combine requêtes HTTP, parsing et même rendu JavaScript.

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

À privilégier pour les formulaires, les sélecteurs CSS ou un peu de rendu JS.

Asyncio et Aiohttp : Accélérer le scraping Python

Pour extraire des centaines ou milliers de pages, les requêtes synchrones sont trop lentes. Place à aiohttp et asyncio pour le scraping en mode turbo.

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))Cette méthode permet de récupérer des dizaines de pages en parallèle, et d’accélérer sérieusement tes extractions.

Bibliothèques spécialisées : PRAW (Reddit), PyPDF2, etc.

-

PRAW : Pour extraire des données de Reddit via son API.

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2 : Pour extraire du texte de fichiers PDF.

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

Autres : Il existe des bibliothèques pour Instagram, Twitter, l’OCR (Tesseract), etc. Si ta source de données est atypique, il y a sûrement une bibliothèque Python qui va bien.

Tableau comparatif : Bibliothèques Python pour le scraping

| Outil / Bibliothèque | Facilité d’utilisation | Vitesse & Échelle | Idéal pour |

|---|---|---|---|

| Requests + BeautifulSoup | Facile | Modérée | Débutants, sites statiques, scripts rapides |

| lxml (avec XPath) | Moyenne | Rapide | Gros volumes, parsing complexe |

| Scrapy | Difficile | Très rapide | Entreprise, gros crawls, pipelines |

| Selenium / Playwright | Moyenne | Lente | Sites dynamiques, interactions JS |

| aiohttp + asyncio | Moyenne | Très rapide | Gros volumes, pages statiques |

| MechanicalSoup | Facile | Modérée | Connexion, formulaires, gestion de session |

| PyQuery | Moyenne | Rapide | Fans de sélecteurs CSS, manipulation DOM |

| Requests-HTML | Facile | Variable | Petits jobs, rendu JS léger |

Tutoriel pas à pas : Créer un extracteur web Python (exemple concret)

Prenons un cas concret : extraire des fiches produits d’un site e-commerce fictif, gérer la pagination et exporter en CSV.

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")Explications :

- On parcourt les pages, on récupère le HTML, on extrait les produits, on collecte nom et prix, et on s’arrête quand il n’y a plus rien à gratter.

- On exporte tout en CSV pour une analyse facile.

Tu préfères exporter vers Excel ? Utilise pandas :

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)Gérer les formulaires, connexions et sessions en scraping Python

Beaucoup de sites demandent une connexion ou la soumission d’un formulaire. Voilà comment faire :

Avec requests et une session :

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")Avec MechanicalSoup :

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()Les sessions permettent de garder les cookies et de rester connecté pendant l’extraction de plusieurs pages.

Extraire du contenu dynamique et des pages générées en JavaScript

Si les données ne sont pas dans le HTML (le code source affiche des divs vides), il faut automatiser le navigateur.

Exemple Selenium :

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_sourceOu, si tu trouves l’API appelée par le JavaScript, utilise simplement requests pour récupérer le JSON — c’est bien plus rapide.

Exporter les données extraites : CSV, Excel, bases de données, etc.

-

CSV : Utilise le module

csvde Python (voir plus haut). -

Excel : Utilise pandas ou openpyxl.

-

Google Sheets : Utilise la bibliothèque

gspread.1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

Bases de données : Utilise

sqlite3,pymysql,psycopg2ou SQLAlchemy pour les bases SQL. Pour NoSQL,pymongopour MongoDB.

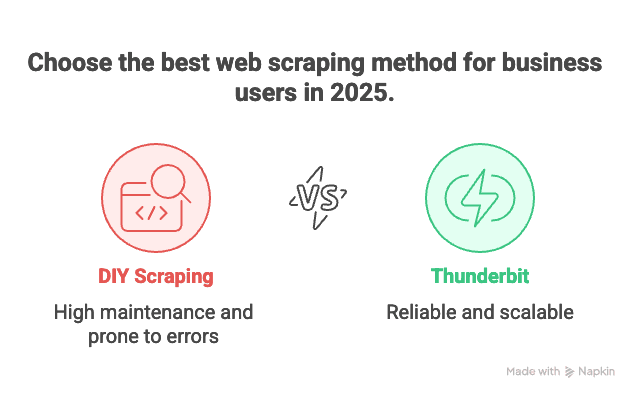

Python vs solutions no-code modernes : Pourquoi Thunderbit est le choix n°1 en 2025

Soyons honnêtes : la maintenance. Coder ses propres extracteurs, c’est top… jusqu’au jour où il faut gérer 100 sites différents, chacun avec ses caprices, et que tout plante la veille d’un rapport crucial. Du vécu !

C’est pour ça que je recommande chaudement . Voilà pourquoi c’est mon outil préféré pour les pros en 2025 :

- Aucune ligne de code à écrire : Thunderbit propose une interface visuelle. Clique sur « Suggérer les champs avec l’IA », ajuste les colonnes, lance l’extraction… et c’est plié. Pas de Python, pas de débogage, pas de nuits blanches sur Stack Overflow.

- Passe à l’échelle sans prise de tête : Besoin d’extraire 10 000 fiches produits ? Le moteur cloud de Thunderbit s’en occupe, sans surveillance.

- Zéro maintenance : Suivre 100 sites concurrents pour une veille e-commerce ? Maintenir 100 scripts Python, c’est l’enfer. Avec Thunderbit, il suffit de choisir ou d’adapter un modèle, et l’IA s’ajuste automatiquement aux changements de mise en page.

- Gestion des sous-pages et de la pagination : Thunderbit suit les liens, gère la pagination et peut même enrichir tes données en visitant chaque fiche produit.

- Modèles prêts à l’emploi : Pour les sites populaires (Amazon, Zillow, LinkedIn…), Thunderbit propose des modèles tout faits. Un clic, et tes données sont prêtes.

- Export gratuit des données : Exporte vers Excel, Google Sheets, Airtable ou Notion — sans frais cachés.

En résumé : si tu veux juste les données, Thunderbit, c’est comme avoir un majordome numérique. Si tu es développeur et que tu aimes bidouiller, Python reste un super terrain de jeu… mais parfois, on veut juste aller droit au but.

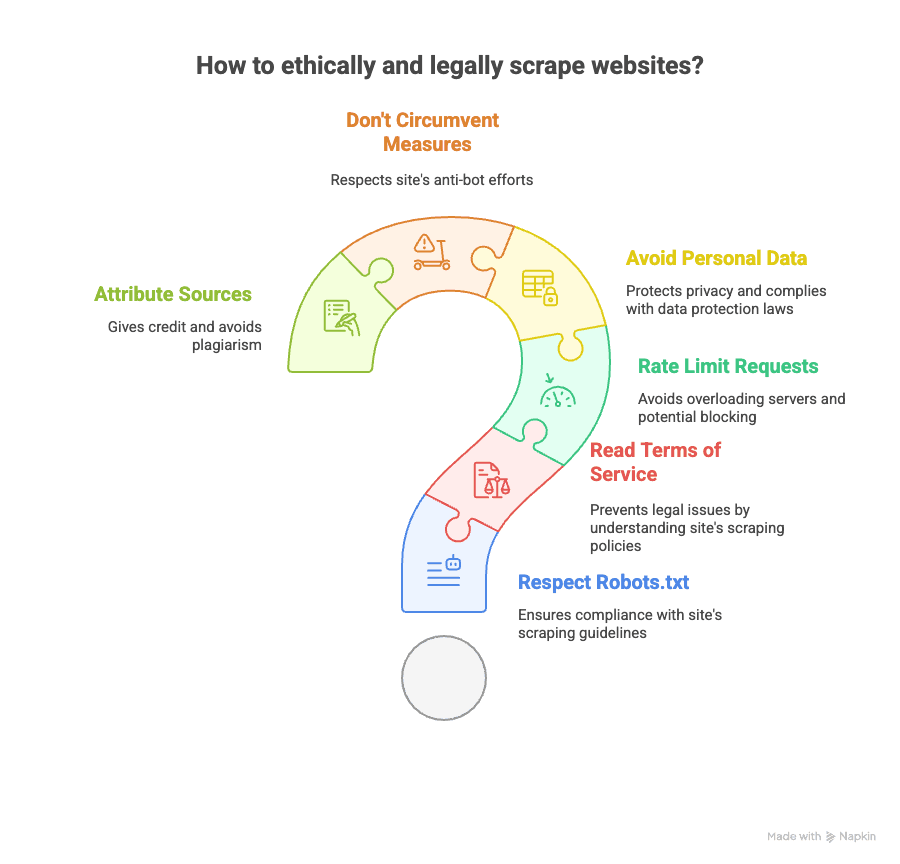

Bonnes pratiques pour un scraping Python éthique et légal

L’extraction web, c’est puissant, mais ça implique des responsabilités. Voici comment rester dans les clous (et dormir tranquille) :

- Vérifie le robots.txt : Respecte les consignes du site sur ce qui peut être extrait.

- Lis les conditions d’utilisation : Certains sites interdisent clairement le scraping. Les ignorer peut te valoir un blocage, voire des soucis juridiques.

- Limite la fréquence : N’inonde pas les serveurs — ajoute des pauses entre les requêtes.

- Évite les données personnelles : Prudence avec les emails, numéros de téléphone ou toute donnée couverte par le RGPD ou le CCPA.

- Ne contourne pas les protections anti-bot : Si un site utilise des CAPTCHAs ou bloque activement, réfléchis à deux fois.

- Cite tes sources : Si tu publies une analyse, crédite l’origine des données.

Pour creuser la question légale, consulte cette et les .

Pour aller plus loin : ressources pour apprendre le Web Scraping Python (cours, docs, communautés)

Envie d’approfondir ? Voici ma sélection de ressources incontournables :

- Docs officielles :

- Livres :

- « Web Scraping with Python » de Ryan Mitchell

- « Automate the Boring Stuff with Python » d’Al Sweigart

- Guides en ligne :

- Vidéos tutorielles :

- La chaîne YouTube de Corey Schafer

- Communautés :

Et bien sûr, pour découvrir le scraping sans code, jette un œil à la ou au .

Conclusion & points clés : Choisir la bonne solution d’extraction web en 2025

- Le scraping Python est ultra puissant et flexible. Si tu aimes coder, que tu veux tout maîtriser et que la maintenance ne te fait pas peur, c’est un excellent choix.

- Il existe une bibliothèque Python pour chaque besoin : pages statiques, contenu dynamique, formulaires, API, PDF, etc.

- Mais pour la plupart des entreprises, maintenir des dizaines de scripts, c’est vite l’enfer. Si ton objectif est d’obtenir rapidement des données, à grande échelle, sans être un crack en informatique, est la solution idéale.

- L’interface sans code, boostée par l’IA de Thunderbit, permet d’extraire n’importe quel site en quelques clics, de gérer sous-pages et pagination, et d’exporter les données où tu veux — sans une ligne de Python.

- L’éthique et la légalité comptent : Vérifie toujours les règles du site, respecte la vie privée et scrape de façon responsable.

Que tu sois un pro de Python ou que tu veuilles juste les données sans prise de tête, les outils n’ont jamais été aussi performants qu’en 2025. Mon conseil ? Teste les deux approches, vois ce qui te convient, et laisse les robots s’occuper des tâches répétitives… à condition qu’ils restent polis !

Et si tu en as marre de courir après des scripts qui plantent, essaie l’. Ton futur toi (et ta réserve de café) te dira merci.

Envie d’aller plus loin ? Découvre ou pour des tutos pratiques et les dernières stratégies d’extraction.