Soyons clairs : personne ne rêve de passer sa journée à copier-coller 500 lignes de prix produits dans un tableur. (Si c’est votre passion, respect pour ta ténacité, mais pense à investir dans une bonne attelle pour le poignet !) Que tu bosses dans la vente, l’opérationnel ou que tu veuilles juste garder une longueur d’avance sur la concurrence, tu as sûrement déjà galéré à récupérer des infos sur des sites web. Aujourd’hui, tout tourne autour de la donnée web, et l’automatisation de l’extraction explose — .

Après plusieurs années à naviguer dans le monde du SaaS et de l’automatisation, j’ai tout vu : des macros Excel de l’extrême aux scripts Python bricolés à la dernière minute. Dans ce guide, je vais te montrer comment utiliser un parseur HTML Python pour extraire des données concrètes (oui, on va choper ensemble les notes de films sur IMDb), et surtout pourquoi, en 2025, il existe une alternative bien plus efficace : des outils boostés à l’IA comme qui te permettent d’obtenir les infos sans écrire une seule ligne de code.

C’est quoi un parseur HTML et pourquoi l’utiliser avec Python ?

On commence par la base : à quoi sert un parseur HTML ? Imagine-le comme le bibliothécaire du web. Il lit le code HTML parfois bien fouillis d’une page et le transforme en une structure claire et organisée. Résultat : tu peux extraire facilement les infos qui t’intéressent — titres, prix, liens — sans te perdre dans la jungle des balises et des divs.

Python, c’est LA référence pour ce genre de mission, et ce n’est pas pour rien. Il est facile à lire, parfait pour les débutants et il existe tout un écosystème de bibliothèques dédiées à l’extraction et au parsing web. D’ailleurs, , grâce à sa simplicité et à sa communauté ultra-active.

Les parseurs HTML incontournables en Python

Voici les outils les plus utilisés pour parser du HTML avec Python :

- BeautifulSoup : Le grand classique, parfait pour débuter.

- lxml : Ultra-rapide et puissant, top pour les requêtes avancées.

- html5lib : Très tolérant avec le HTML mal fichu, comme un navigateur.

- PyQuery : Permet d’utiliser des sélecteurs façon jQuery en Python.

- HTMLParser : Le parseur intégré à Python — toujours dispo, mais assez basique.

Chacun a ses particularités, mais tous transforment le HTML brut en données bien rangées.

Exemples concrets : comment les entreprises profitent des parseurs HTML Python

L’extraction de données web n’est plus réservée aux développeurs ou aux data scientists. C’est devenu un vrai levier stratégique, surtout pour les équipes commerciales et opérationnelles. Quelques exemples concrets :

| Cas d’usage (Secteur) | Données extraites | Bénéfices pour l’entreprise |

|---|---|---|

| Veille tarifaire (Retail) | Prix concurrents, stocks | Tarification dynamique, marges optimisées (source) |

| Analyse concurrentielle | Fiches produits, avis, disponibilité | Identifier des opportunités, générer des leads (source) |

| Prospection commerciale (B2B) | Noms d’entreprises, emails, contacts | Automatiser la prospection, enrichir le pipe (source) |

| Analyse de sentiment (Marketing) | Posts sociaux, avis, notes | Feedback en temps réel, détection de tendances (source) |

| Agrégation immobilière | Annonces, prix, infos agents | Analyse de marché, stratégie de prix (source) |

| Recrutement | Profils candidats, salaires | Sourcing, benchmark des rémunérations (source) |

En clair : continuer à copier-coller à la main, c’est perdre du temps et de l’argent.

Tour d’horizon des parseurs HTML Python : comparatif des bibliothèques phares

Passons à la pratique. Voici un comparatif express des principales bibliothèques Python pour parser du HTML, histoire de choisir celle qui te conviendra le mieux :

| Bibliothèque | Facilité d’utilisation | Vitesse | Flexibilité | Maintenance | Idéal pour |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | Modérée | Débutants, HTML mal formé |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | Modérée | Vitesse, XPath, gros volumes |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | Faible | Parsing façon navigateur, HTML cassé |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | Modérée | Fans de jQuery, sélecteurs CSS |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | Faible | Tâches simples, intégré |

BeautifulSoup : la valeur sûre pour commencer

BeautifulSoup, c’est l’outil parfait pour s’initier au parsing HTML. Sa syntaxe est limpide, la doc est claire, et il gère sans souci le HTML mal structuré (). Son seul défaut ? Il n’est pas le plus rapide, surtout sur de grosses pages, et il ne gère pas nativement les sélecteurs avancés comme XPath.

lxml : pour la vitesse et la puissance

Si tu as besoin de rapidité ou de requêtes XPath, lxml est un excellent choix (). Basé sur des bibliothèques C, il est ultra-performant, mais son installation peut être un peu plus technique et il demande un peu plus d’expérience.

Les autres options : html5lib, PyQuery et HTMLParser

- html5lib : Parse le HTML comme un navigateur — parfait pour les pages mal codées, mais assez lent ().

- PyQuery : Permet d’utiliser des sélecteurs façon jQuery en Python, pratique si tu viens du front-end ().

- HTMLParser : L’option native de Python — rapide et toujours dispo, mais limitée en fonctionnalités.

Étape 1 : Préparer son environnement Python pour parser du HTML

Avant de parser quoi que ce soit, il faut installer et configurer ton environnement Python. Voici comment faire :

-

Installer Python : Télécharge-le sur si ce n’est pas déjà fait.

-

Installer pip : Normalement inclus avec Python 3.4+, sinon vérifie avec

pip --versiondans ton terminal. -

Installer les bibliothèques (on va utiliser BeautifulSoup et requests pour ce tuto) :

1pip install beautifulsoup4 requests lxmlbeautifulsoup4: le parseur HTML.requests: pour récupérer les pages web.lxml: un parseur rapide utilisé par BeautifulSoup.

-

Vérifier l’installation :

1python -c "import bs4, requests, lxml; print('Tout est prêt !')"

Astuces si tu galères :

- Si tu as des erreurs de permission, tente

pip install --user ... - Sur Mac/Linux, il peut falloir utiliser

python3etpip3. - Si tu vois “ModuleNotFoundError”, vérifie l’orthographe et l’environnement Python utilisé.

Étape 2 : Parser ta première page web avec Python

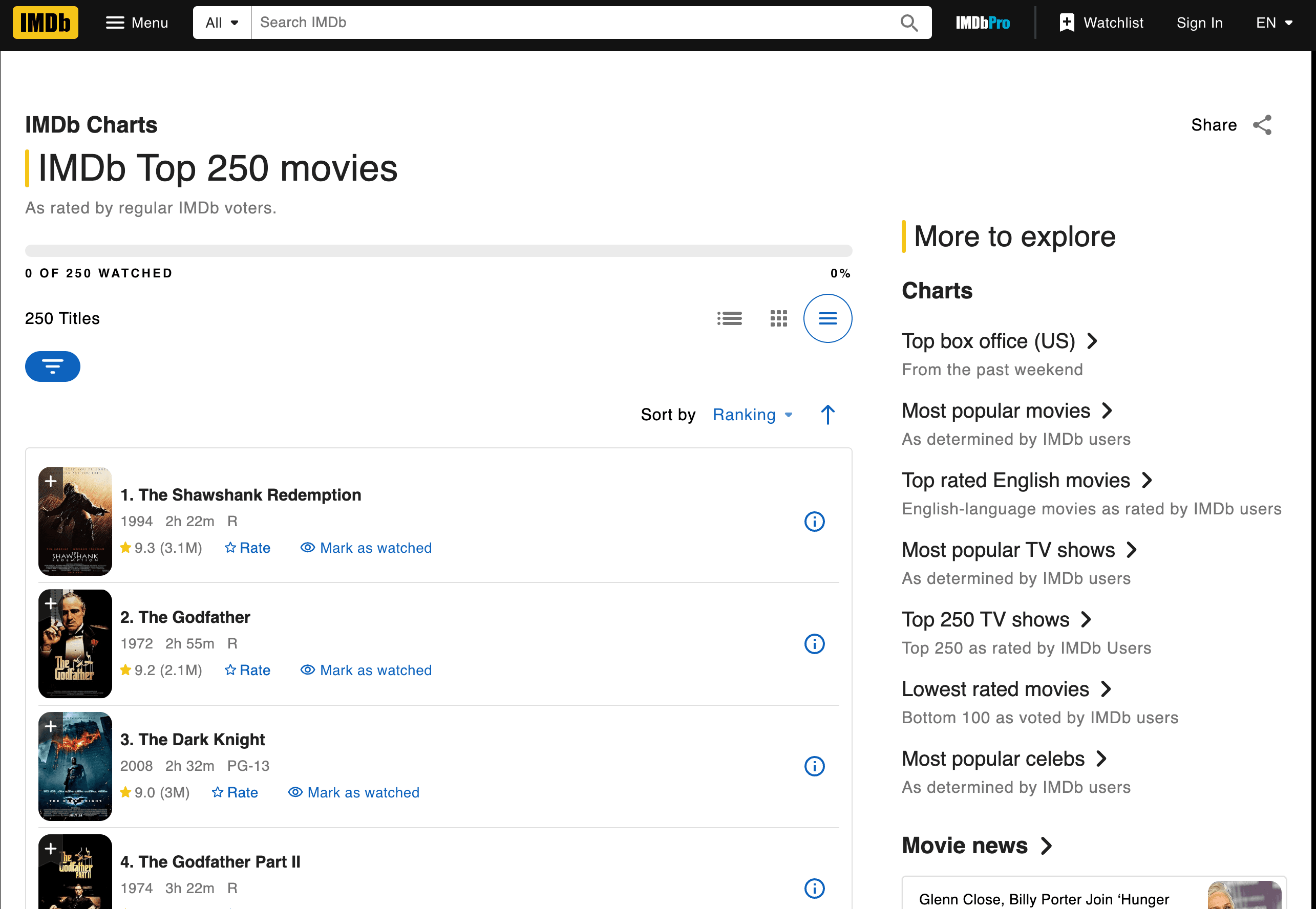

On passe à la pratique : on va extraire les 250 meilleurs films d’IMDb, avec leur titre, année et note.

Récupérer et parser la page

Voici un script étape par étape :

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# Trouver les cellules de titre et de note

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# Parcourir les 3 premiers films en exemple

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Note : {rating}")Explications :

- On utilise

requests.get()pour récupérer la page. BeautifulSoupparse le HTML.- On cible les balises

<td>avec les classes correspondantes. - On extrait le texte pour le titre, l’année et la note.

Ce que tu dois obtenir :

11. The Shawshank Redemption (1994) -- Note : 9.3

22. The Godfather (1972) -- Note : 9.2

33. The Dark Knight (2008) -- Note : 9.0Extraire les données : titres, notes et plus

Comment j’ai trouvé les balises et classes à utiliser ? J’ai inspecté le code HTML de la page IMDb (clic droit > Inspecter l’élément). Repère les motifs : ici, chaque film est dans un <td class="titleColumn"> et la note dans <td class="ratingColumn imdbRating"> ().

Astuce : Pour n’importe quel site, commence toujours par analyser la structure HTML et repérer les classes ou balises uniques.

Sauvegarder et exporter les résultats

Pour enregistrer les données dans un fichier CSV :

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Titre', 'Année', 'Note'])

13 writer.writerows(movies)Conseils pour un fichier propre :

- Utilise

.strip()pour virer les espaces en trop. - Gère les données manquantes avec des conditions

if. - Pour exporter vers Excel, ouvre le CSV dans Excel ou utilise

pandaspour générer un fichier.xlsx.

Étape 3 : Gérer les changements HTML et les galères de maintenance

C’est là que ça se complique. Les sites web changent souvent de structure — parfois juste pour embêter les extracteurs de données ! Si IMDb remplace class="titleColumn" par class="movieTitle", ton script ne renverra plus rien. Du vécu…

Quand les scripts plantent : les galères classiques

Les soucis fréquents :

- Sélecteurs introuvables : la balise ou la classe a changé.

- Résultats vides : la structure de la page a bougé ou le contenu est chargé en JavaScript.

- Erreurs HTTP : le site a mis en place des protections anti-bot.

Comment réagir ?

- Vérifie que le HTML analysé correspond bien à celui affiché dans ton navigateur.

- Mets à jour tes sélecteurs selon la nouvelle structure.

- Si le contenu est dynamique, il faudra peut-être utiliser un outil d’automatisation de navigateur (genre Selenium) ou trouver une API.

Le vrai casse-tête ? Si tu scrapes 10, 50 ou 500 sites différents, tu passeras plus de temps à réparer tes scripts qu’à exploiter les données ().

Étape 4 : Passer à l’échelle — les coûts cachés du parsing HTML manuel en Python

Imaginons que tu veuilles extraire des données non seulement sur IMDb, mais aussi sur Amazon, Zillow, LinkedIn et d’autres. Chaque site demande son propre script. Et à chaque changement de structure, il faut tout recommencer…

Les coûts cachés :

- Maintenance : .

- Infrastructure : Il faut gérer les proxys, les erreurs, la surveillance.

- Performance : Passer à l’échelle, c’est gérer la concurrence, les limites de requêtes, etc.

- Qualité : Plus de scripts = plus de risques de bugs.

Pour les équipes non techniques, ça devient vite ingérable. C’est comme embaucher une armée de stagiaires pour copier-coller toute la journée — sauf que les stagiaires sont des scripts Python qui plantent dès qu’un site change.

Au-delà des parseurs HTML Python : découvre Thunderbit, l’alternative IA

C’est là que ça devient vraiment intéressant. Et si tu pouvais zapper le code, oublier la maintenance, et obtenir tes données, peu importe les changements de site ?

C’est exactement ce que propose . C’est une extension Chrome Extracteur Web IA qui te permet d’extraire des données structurées de n’importe quel site en deux clics. Pas de Python, pas de scripts, pas de prise de tête.

Parseurs HTML Python vs Thunderbit : le match

| Critère | Parseurs HTML Python | Thunderbit (voir les tarifs) |

|---|---|---|

| Temps d’installation | Long (installation, code, débogage) | Court (installer l’extension, cliquer) |

| Facilité d’utilisation | Nécessite de coder | Aucun code — pointer et cliquer |

| Maintenance | Lourde (scripts souvent cassés) | Minime (l’IA s’adapte automatiquement) |

| Passage à l’échelle | Complexe (scripts, proxys, infra) | Intégré (cloud scraping, tâches en lot) |

| Enrichissement des données | Manuel (plus de code) | Intégré (étiquetage, nettoyage, traduction, sous-pages) |

Pourquoi coder quand l’IA peut tout faire à ta place ?

Pourquoi miser sur l’IA pour l’extraction de données web ?

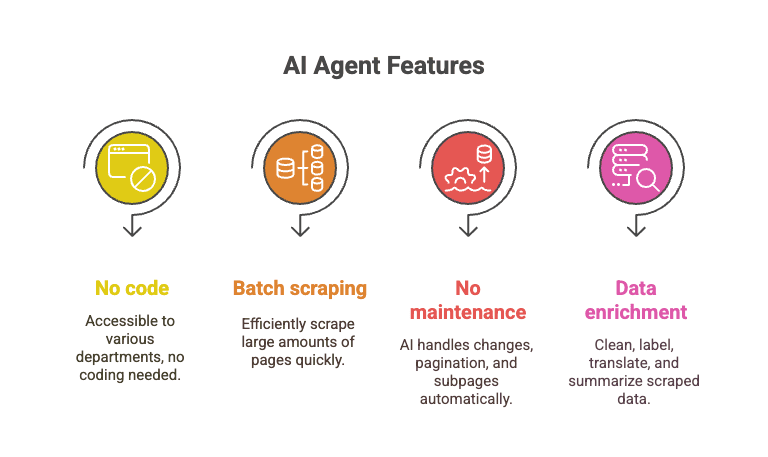

L’agent IA de Thunderbit lit la page, comprend sa structure et s’adapte aux changements. C’est comme avoir un super-stagiaire qui ne dort jamais et ne râle jamais quand les classes changent.

- Aucune compétence technique requise : tout le monde peut l’utiliser — commercial, ops, marketing…

- Extraction en masse : récupère 10 000+ pages en un temps record, là où un script Python galère sur une seule.

- Zéro maintenance : l’IA gère les changements de structure, la pagination, les sous-pages, etc.

- Enrichissement des données : nettoyage, étiquetage, traduction, résumé… tout est possible en direct.

Imagine : tu extrais tout le Top 250 IMDb, plus les pages détaillées de chaque film, plus les avis, en quelques clics — pendant que tes scripts Python bloquent encore sur une erreur “NoneType”.

Tutoriel : extraire les notes de films IMDb avec Thunderbit

Voyons comment Thunderbit gère la même mission sur IMDb :

- Installe l’.

- Va sur la .

- Clique sur l’icône Thunderbit.

- Clique sur “AI Suggest Fields”. Thunderbit analyse la page et propose les colonnes (Titre, Année, Note).

- Ajuste les colonnes si besoin.

- Clique sur “Scrape”. Thunderbit extrait instantanément les 250 lignes.

- Exporte vers Excel, Google Sheets, Notion ou CSV — à toi de choisir.

Et voilà. Pas de code, pas de débogage, pas de “pourquoi la liste est vide ?”.

Tu veux voir le résultat ? File sur la pour des démos, ou jette un œil à notre pour un autre exemple concret.

Conclusion : choisis le bon outil pour tes besoins en données web

Les parseurs HTML Python comme BeautifulSoup et lxml sont puissants, flexibles et gratuits. Ils sont parfaits pour les développeurs qui veulent tout contrôler et n’ont pas peur de mettre les mains dans le cambouis. Mais ils impliquent une courbe d’apprentissage, une maintenance continue et des coûts cachés — surtout si tes besoins d’extraction grossissent.

Pour les équipes business, commerciales ou toute personne qui veut juste la donnée (et pas le code), les outils IA comme changent la donne. Ils permettent d’extraire, nettoyer et enrichir la donnée web à grande échelle, sans coder et sans maintenance.

Mon conseil ? Utilise Python si tu aimes le scripting et que tu veux tout personnaliser. Mais si tu tiens à ton temps (et à ta tranquillité d’esprit), teste Thunderbit. Pourquoi coder et surveiller des scripts quand l’IA peut tout faire à ta place ?

Envie d’en savoir plus sur l’extraction web, la collecte de données et l’automatisation par l’IA ? Plonge dans d’autres tutos sur le , comme ou .