En 2026, le web est devenu un vrai terrain de jeu où la moitié du trafic est générée par des robots, et les extracteurs web open source sont les alliés discrets de la veille tarifaire, de l’entraînement IA et de bien d’autres usages. Après avoir passé des années dans le SaaS et l’automatisation, une chose est claire : choisir le bon crawler web auto-hébergé peut vous éviter bien des galères (et quelques nuits blanches à déboguer). Que vous ayez juste besoin de récupérer quelques pages produits ou de crawler des millions d’URLs pour de la recherche, les alternatives open source à Firecrawl présentées ici sauront répondre à vos besoins, peu importe votre volume, votre stack technique ou votre tolérance à la complexité.

Mais attention, il n’y a pas de solution miracle. Certaines équipes ont besoin de la puissance brute de Scrapy ou de la capacité d’archivage d’Heritrix, alors que d’autres trouveront la maintenance des bibliothèques open source trop lourde. On va donc passer en revue les 9 meilleures alternatives open source à Firecrawl pour 2026, leurs points forts, et comment choisir l’outil qui colle à votre activité—sans perdre de temps en essais-erreurs.

Avant de plonger dans la sélection, parlons un peu stratégie. L’écosystème des extracteurs web open source n’a jamais été aussi riche, et votre choix dépendra de plusieurs critères essentiels :

- Facilité d’utilisation : Vous préférez une interface visuelle ou vous êtes à l’aise avec Python, Go ou JavaScript ?

- Scalabilité : Vous ciblez un seul site ou des millions de pages sur des centaines de domaines ?

- Type de contenu : Vous visez du HTML statique ou des pages dynamiques qui tournent avec JavaScript ?

- Intégration : Vous voulez exporter vers Excel, alimenter une base de données ou brancher à une chaîne d’analyse ?

- Maintenance : Vous avez les ressources pour maintenir du code maison ou vous cherchez un outil qui s’adapte tout seul aux changements de sites ?

Voici un tableau récapitulatif pour vous aider à y voir plus clair :

| Scénario | Meilleur outil(s) |

|---|---|

| No-code, navigation hors ligne | HTTrack |

| Crawl massif, multi-domaines | Scrapy, Apache Nutch, StormCrawler |

| Sites dynamiques/JavaScript | Puppeteer |

| Automatisation de formulaires | MechanicalSoup |

| Téléchargement/archivage statique | Wget, HTTrack, Heritrix |

| Développeur Go, performance | Colly |

On attaque maintenant le top 9 des alternatives open source à Firecrawl pour 2026.

- Scrapy : le choix pour le crawling Python à grande échelle

est la référence incontournable du crawling open source. Développé en Python, c’est le framework préféré des devs qui veulent passer à l’échelle : millions de pages, mises à jour fréquentes, logique complexe.

Pourquoi choisir Scrapy ?

- Scalabilité extrême : Scrapy gère des milliers de requêtes par seconde et est utilisé par des boîtes qui extraient des milliards de pages chaque mois ().

- Modulaire et extensible : Créez vos spiders sur mesure, ajoutez des middlewares pour les proxys, gérez les connexions et exportez en JSON, CSV ou vers une base de données.

- Communauté active : Plein de plugins, une doc bien fournie et beaucoup de réponses sur Stack Overflow.

- Fiabilité éprouvée : Utilisé en prod par des équipes e-commerce, médias et recherche partout dans le monde.

Limites : Courbe d’apprentissage raide pour les non-développeurs, et il faut maintenir vos spiders à chaque changement de site. Mais pour la maîtrise et la perf, Scrapy reste une valeur sûre.

- Apache Nutch : idéal pour les moteurs de recherche d’entreprise

est le pionnier des crawlers open source, pensé pour le crawling à l’échelle d’internet et les besoins des grandes entreprises. Si vous rêvez de créer votre propre moteur de recherche ou de crawler des millions de domaines, Nutch est fait pour vous.

Pourquoi Apache Nutch ?

- Scalabilité Hadoop : Construit sur Hadoop, Nutch peut crawler des milliards de pages sur des clusters de serveurs ( l’utilise pour explorer le web public).

- Crawling par lots : Donnez-lui une liste d’URLs de départ et laissez-le tourner—parfait pour les tâches planifiées à grande échelle.

- Intégration : Fonctionne avec Solr, Elasticsearch et les pipelines big data.

Limites : Mise en place complexe (clusters Hadoop, fichiers de config Java), et plus orienté vers le crawling brut que l’extraction de données structurées. Surdimensionné pour les petits projets, mais imbattable pour le web-scale.

- Heritrix : la référence pour l’archivage web et la conformité

est le crawler développé par Internet Archive, conçu pour l’archivage et la préservation numérique.

Pourquoi Heritrix ?

- Archivage complet : Capture chaque page, ressource et lien—idéal pour la conformité légale ou les instantanés historiques.

- Sortie WARC : Stocke tout dans des fichiers Web ARChive standardisés, prêts à être rejoués ou analysés.

- Interface web : Configurez et surveillez vos crawls via une interface navigateur.

Limites : Gourmand en ressources (disque et mémoire), ne gère pas le JavaScript, et produit des archives brutes plutôt que des tableaux de données structurées. Parfait pour les bibliothèques, archives ou secteurs réglementés.

- Colly : la performance pour les développeurs Go

est le chouchou des devs Go : rapide, léger et très concurrent.

Pourquoi Colly ?

- Ultra-rapide : Grâce à la concurrence de Go, Colly peut extraire des milliers de pages avec très peu de ressources ().

- API simple : Définissez des callbacks sur les éléments HTML, gérez cookies et robots.txt automatiquement.

- Idéal pour le statique : Parfait pour les pages générées côté serveur, les APIs ou l’intégration dans un backend Go.

Limites : Pas de rendu JavaScript intégré (pour les sites dynamiques, il faut l’associer à Chromedp par exemple), et nécessite de connaître Go.

- MechanicalSoup : l’automatisation simple des formulaires

est une bibliothèque Python qui fait le pont entre les requêtes HTTP simples et l’automatisation de navigateur.

Pourquoi MechanicalSoup ?

- Automatisation des formulaires : Connexion, remplissage de formulaires, gestion de session—parfait pour extraire derrière une authentification.

- Léger : S’appuie sur Requests et BeautifulSoup, donc rapide et facile à prendre en main.

- Idéal pour les sites interactifs : Si vous devez soumettre des formulaires de recherche ou extraire après connexion, c’est un excellent choix ().

Limites : Pas d’exécution JavaScript, donc inadapté aux sites dynamiques. Idéal pour les pages statiques ou générées côté serveur avec interactions simples.

- Puppeteer : la solution pour les sites dynamiques et JavaScript

est le couteau suisse pour extraire les sites modernes riches en JavaScript. Cette bibliothèque Node.js vous donne le contrôle total d’un navigateur Chrome sans interface.

Pourquoi Puppeteer ?

- Gère le contenu dynamique : Extraction de SPAs, scroll infini, pages chargées en AJAX ().

- Simulation utilisateur : Cliquez, remplissez des formulaires, faites des captures d’écran, résolvez des CAPTCHAs (avec plugins).

- Automatisation puissante : Idéal pour les tests, la veille ou l’extraction de tout ce qu’un utilisateur peut voir.

Limites : Consommation de ressources importante (lance des instances Chrome), plus lent que les extracteurs HTTP purs, et nécessite une infrastructure solide pour l’échelle.

- Wget : pour les téléchargements rapides en ligne de commande

est l’outil classique en ligne de commande pour télécharger des sites statiques et des fichiers.

Pourquoi Wget ?

- Simplicité : Téléchargez un site ou un dossier complet en une commande—aucun code à écrire.

- Rapidité : Écrit en C, il est rapide et efficace.

- Idéal pour le contenu statique : Parfait pour la documentation, les blogs ou le téléchargement massif de fichiers ().

Limites : Pas d’exécution JavaScript ni de gestion de formulaires, et télécharge des pages brutes (pas de données structurées). À voir comme un aspirateur numérique pour sites statiques.

- HTTrack : la navigation hors ligne sans code

est le cousin convivial de Wget, avec une interface graphique pour cloner des sites web.

Pourquoi HTTrack ?

- Simplicité GUI : Assistant pas à pas accessible à tous, même sans compétences techniques.

- Navigation hors ligne : Modifie les liens pour naviguer localement dans le site copié.

- Idéal pour l’archivage : Parfait pour les chercheurs, marketeurs ou toute personne souhaitant une copie d’un site sans coder ().

Limites : Ne gère pas le contenu dynamique, peut être lent sur les gros sites, et n’est pas conçu pour l’extraction de données structurées.

- StormCrawler : le crawling distribué en temps réel

est le crawler distribué moderne pour les équipes qui ont besoin de données web en continu et à grande échelle.

Pourquoi StormCrawler ?

- Crawling temps réel : Basé sur Apache Storm, il traite les données en flux—idéal pour la veille média ou les moteurs de recherche ().

- Modulaire et évolutif : Ajoutez du parsing, de l’indexation ou des traitements personnalisés selon vos besoins.

- Utilisé par Common Crawl : Alimente le dataset news de l’un des plus grands archives web ouvertes.

Limites : Nécessite des compétences Java et une infrastructure Storm, donc réservé aux équipes expérimentées en systèmes distribués. Surdimensionné pour les petits besoins.

Comparatif des alternatives open source à Firecrawl : quel concurrent gratuit choisir ?

Voici un aperçu comparatif des 9 outils :

| Outil | Cas d’usage idéal | Points forts | Inconvénients | Langage / Installation |

|---|---|---|---|---|

| Scrapy | Crawling massif, fréquent | Puissant, évolutif, grande communauté | Courbe d’apprentissage, Python requis | Framework Python |

| Apache Nutch | Entreprise, web-scale | Scalabilité Hadoop, éprouvé | Installation complexe, batch | Java/Hadoop |

| Heritrix | Archivage, conformité | Capture complète, sortie WARC | Lourd, pas de JS, archives brutes | Application Java, web UI |

| Colly | Dev Go, performance | Rapide, API simple, concurrence | Pas de JS, Go requis | Bibliothèque Go |

| MechanicalSoup | Automatisation de formulaires | Léger, gestion de session | Pas de JS, échelle limitée | Bibliothèque Python |

| Puppeteer | Sites dynamiques/JavaScript | Contrôle total, automatisation | Gourmand, Node.js requis | Bibliothèque Node.js |

| Wget | Téléchargement statique, hors ligne | Simple, rapide, CLI | Pas de JS, pages brutes | Outil en ligne de commande |

| HTTrack | Utilisateurs non-tech, archivage | GUI, navigation hors ligne facile | Pas de JS, lent sur gros sites | Application desktop (GUI) |

| StormCrawler | Crawling distribué, temps réel | Évolutif, modulaire, temps réel | Expertise Java/Storm requise | Cluster Java/Storm |

Faut-il créer son propre crawler ou utiliser une alternative open source à Firecrawl ?

Soyons francs : développer son propre crawler peut sembler tentant… jusqu’à ce que la maintenance, la gestion des proxys et la lutte anti-bot deviennent un vrai casse-tête. Les outils open source ci-dessus concentrent des années d’expérience et de retours de la communauté. Selon les experts du secteur, utiliser une solution existante est le moyen le plus rapide et fiable d’obtenir des résultats sans réinventer la roue ().

- Adoptez l’open source si : Vos besoins correspondent à l’existant, vous voulez gagner du temps de dev et profiter du support communautaire.

- Développez en interne si : Vos exigences sont vraiment uniques, vous avez une grosse expertise et le scraping est au cœur de votre activité.

Attention, l’open source n’est pas « gratuit » si on compte le temps d’ingénierie, la maintenance serveur et les mises à jour pour contrer les protections anti-scraping. Si vous voulez la puissance d’un crawler sans coder, il y a une autre option.

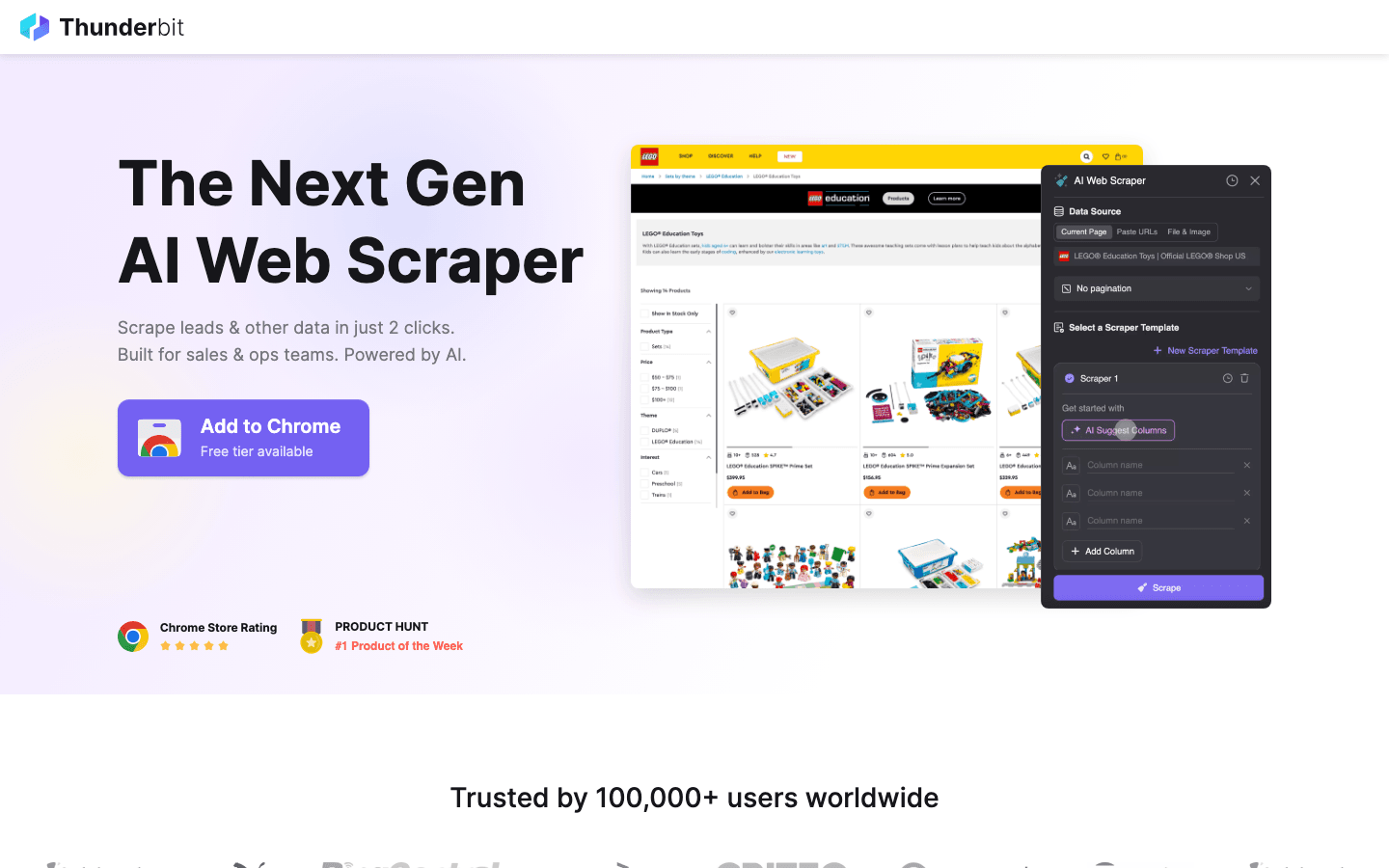

Bonus : si l’open source est trop complexe, essayez Thunderbit

Les outils listés plus haut sont top pour les devs, mais ils ont tous un point commun : il faut coder, ils galèrent face aux protections anti-bot IA, et demandent une maintenance continue.

est ma reco pour ceux qui veulent éviter ces galères. Il combine puissance d’extraction et simplicité d’utilisation.

Pourquoi choisir Thunderbit plutôt qu’un outil open source ?

- Aucune compétence technique requise : Contrairement à Scrapy ou Puppeteer, Thunderbit est une extension Chrome boostée à l’IA. Clique sur « Suggérer les champs IA » et l’extracteur se construit tout seul.

- Gestion des cas complexes : Contenu dynamique, scroll infini, pagination… tout est automatisé par l’IA, sans scripts à écrire.

- Export instantané : Passez du site web à Excel, Google Sheets ou Notion en deux clics.

- Zéro maintenance : Plus besoin de mettre à jour votre code à chaque changement de site—l’IA de Thunderbit s’adapte pour vous.

Que tu sois commercial, marketeur ou chercheur et que tu aies besoin de données tout de suite sans apprendre Python ou Go, Thunderbit complète parfaitement les outils open source de cette liste.

Envie de voir Thunderbit en action ? et teste-la par toi-même.

Conclusion : bien choisir son crawler web auto-hébergé en 2026

Le monde des alternatives open source à Firecrawl n’a jamais été aussi vaste. Que tu aies besoin de la puissance de Scrapy ou Nutch, ou de la précision d’archivage d’Heritrix, il y a une solution pour chaque usage. L’essentiel, c’est d’adapter l’outil à tes besoins : inutile de sortir l’artillerie lourde pour une extraction rapide, mais ne sous-estime pas l’investissement si tu vises l’échelle internet.

Et n’oublie pas : si la voie open source s’avère trop technique ou trop chronophage, des outils IA comme Thunderbit sont là pour prendre le relais.

Prêt à te lancer ? Teste Scrapy pour ton prochain projet data, ou pour une extraction simple et intelligente. Pour plus de conseils, va faire un tour sur le pour des analyses détaillées et des tutos.

FAQ

1. Quel est l’avantage principal des alternatives open source à Firecrawl ? Les solutions open source offrent flexibilité, économies et la possibilité d’auto-héberger et de personnaliser votre crawler. Vous évitez la dépendance à un fournisseur et profitez du support et des mises à jour de la communauté.

2. Quel outil privilégier pour un utilisateur non technique qui veut des résultats rapides ? est un bon choix open source pour la navigation hors ligne. Mais pour extraire des données structurées (comme des tableaux Excel), on recommande l’outil bonus grâce à ses capacités IA.

3. Comment gérer les sites dynamiques riches en JavaScript ? est la meilleure option : il contrôle un vrai navigateur et peut extraire tout ce qu’un utilisateur voit, y compris les SPAs et le contenu chargé en AJAX.

4. Quand utiliser un crawler lourd comme Apache Nutch ou StormCrawler ? Si tu dois parcourir des millions de pages sur plein de domaines, ou si tu as besoin de crawling distribué en temps réel (moteurs de recherche, veille média), ces outils sont faits pour la fiabilité et l’échelle.

5. Vaut-il mieux créer son propre crawler ou utiliser une solution open source existante ? Pour la plupart des équipes, utiliser et personnaliser un outil open source existant est plus rapide, économique et fiable. Ne développe en interne que si tes besoins sont très spécifiques et que tu peux assurer la maintenance sur le long terme.

Bonne extraction—et que tes données soient toujours fraîches, structurées et prêtes à l’emploi.

En savoir plus