Le flux d’actualités en ligne, c’est un vrai marathon sans ligne d’arrivée. Chaque minute, de nouveaux titres débarquent, les avis fusent de partout, et les histoires changent de cap à une vitesse folle – bien plus vite que ce que tu peux suivre en scrollant sur ton navigateur. Après avoir passé des années à bidouiller des outils d’automatisation et d’IA, je peux te dire que tomber sur la bonne info au bon moment, ça peut tout changer : une décision stratégique, une campagne marketing qui cartonne, ou même la réputation d’une boîte. Mais soyons clairs : essayer de suivre ce torrent d’infos à la main, c’est comme vouloir attraper la pluie avec une passoire. C’est là que le scraping de l’actualité – l’automatisation de l’extraction de données structurées depuis les sites d’info – devient ton meilleur allié pour une veille en temps réel.

Mais attention, le scraping de l’actualité, ce n’est pas juste ramasser des titres à la pelle. Il faut être précis, rapide, et surtout rester dans les clous. Si tu t’y prends mal, tu risques de te retrouver avec des données périmées, incomplètes, voire de te mettre dans l’illégalité. Bien fait, tu as un radar d’actualité qui te garde toujours une longueur d’avance. Dans ce guide, je te partage les meilleures pratiques du scraping de l’actualité en 2025, avec mon retour d’expérience chez et les dernières tendances du secteur. Que tu sois analyste, communicant, chercheur ou juste accro à l’info et aux tableurs, tu trouveras ici des conseils concrets, des workflows testés et quelques anecdotes (et même une pointe d’humour – parce que même les scrapers ont besoin de rigoler).

Qu’est-ce que le scraping de l’actualité et pourquoi c’est devenu incontournable ?

Le scraping de l’actualité, c’est l’art d’extraire automatiquement des articles, titres, auteurs, dates et autres infos depuis les sites d’info, pour transformer un flux chaotique en données bien rangées et faciles à exploiter. Contrairement au scraping web classique, souvent centré sur des pages statiques ou des annuaires, ici, c’est la fraîcheur et la mise à jour continue qui comptent – c’est comme te créer ton propre fil d’actualité sur mesure.

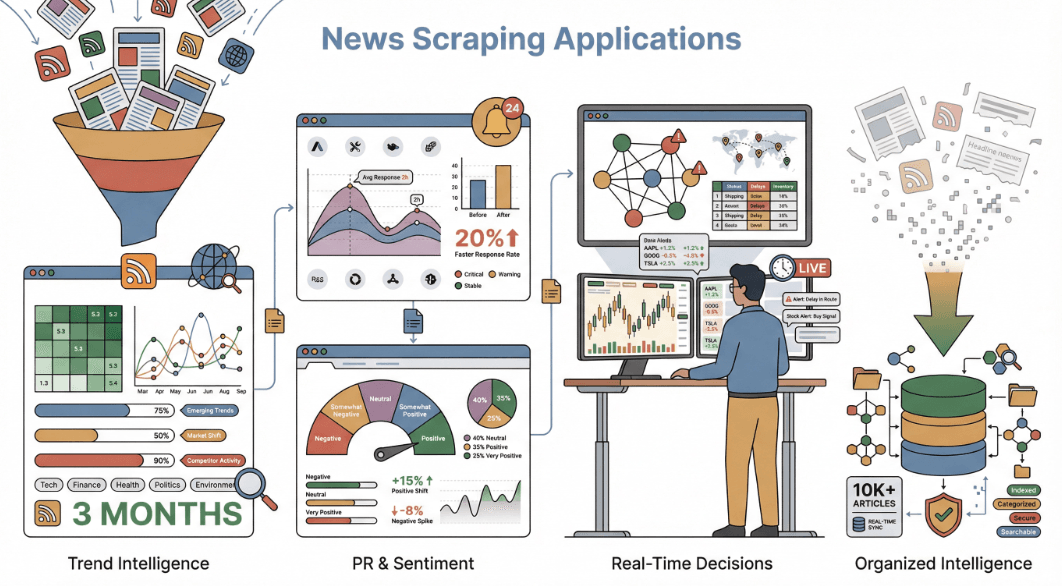

Pourquoi c’est si crucial ? Parce que , et les entreprises voient les flux d’actualités comme une vraie mine d’or stratégique. Que ce soit pour flairer les tendances du marché, garder un œil sur la concurrence, analyser le sentiment ou gérer une crise de réputation, avoir la bonne info au bon moment, c’est un vrai super-pouvoir.

Quelques exemples concrets d’utilisation du scraping de l’actualité :

- Veille marché & tendances : Repère les signaux faibles des mois avant qu’ils n’atterrissent dans les rapports officiels. Les boîtes qui agrègent l’info de plusieurs sources flairent les évolutions du secteur jusqu’à trois mois plus tôt que celles qui restent sur leurs propres datas.

- Surveillance concurrentielle & RP : Suis en temps réel les mentions de ta marque (ou de tes rivaux). Les marques qui surveillent le sentiment dans les médias ont vu leur réactivité grimper de .

- Analyse de sentiment & recherche : Passe au crible des milliers d’articles pour détecter le ton, les biais ou les tendances narratives – comme le utilisé par les économistes.

- Décision en temps réel : Alimente des algos de trading, des alertes supply chain ou des dashboards pour réagir à l’info dès qu’elle tombe.

Bref, le scraping de l’actualité, c’est transformer le tsunami d’infos quotidien en veille structurée – et aujourd’hui, c’est devenu indispensable.

Scraping de l’actualité ou API d’actualités : où est le vrai plus ?

Tu te demandes sûrement : « Pourquoi ne pas juste utiliser une API d’actualités ? » C’est une question qu’on me pose tout le temps.

Les API d’actualités (genre NewsAPI.org ou Google News API) te filent des flux structurés de titres, résumés et métadonnées de plein de sources. C’est top pour une intégration rapide et une couverture large, surtout si tu veux juste les infos de base comme le titre, la date et la source. Mais il y a des limites :

- Champs de données limités : La plupart des API ne donnent que le titre, la source, la date et parfois un mini résumé. Pour le texte complet, la bio de l’auteur, les commentaires ou les liens associés ? Souvent, c’est mort.

- Couverture incomplète : Les API ne couvrent pas tous les sites – surtout les médias locaux, spécialisés ou payants.

- Aucune personnalisation : Tu es coincé avec le format et la fréquence de mise à jour du fournisseur.

- Coût & quotas : Les API de qualité sont souvent limitées ou coûtent un bras.

Le scraping de l’actualité, lui, te donne la main. Tu peux extraire tout ce qui s’affiche sur la page – commentaires, tags, médias, articles liés, etc. Pas de limite de format ou de fréquence imposée par un tiers. Et si tu veux te monter une base de connaissances complète – avec toutes les subtilités qui font la richesse de l’info – le scraping, c’est la solution.

Petit comparatif rapide :

| Champ de données | API d’actualités | Scraping de l’actualité |

|---|---|---|

| Titre | Oui | Oui |

| URL de l’article | Oui | Oui |

| Source | Oui | Oui |

| Date/heure de publication | Oui | Oui |

| Auteur | Parfois | Oui |

| Texte intégral | Parfois (payant) | Oui |

| Image principale | Souvent | Oui |

| Tags/Catégorie | Peut-être | Oui |

| Commentaires | Non | Oui |

| Liens vers articles liés | Non | Oui |

| Engagement social | Non | Oui (si visible) |

| Cohérence des données | Élevée | Variable (à normaliser) |

Le scraping te permet de capter toute la richesse des contenus – parfait pour l’analyse avancée, la modélisation du sentiment ou la création de dashboards sur-mesure.

Pour creuser le sujet, va voir .

Programmer le scraping de l’actualité : éviter les blocages et garder des données fraîches

Parlons d’un point sensible du scraping de l’actualité : à quelle fréquence scraper, et comment éviter de se faire bloquer ?

L’actualité, c’est la réactivité. Si tu scrapes trop lentement, tu rates les scoops. Trop vite, ton IP saute avant même d’avoir vu l’erreur 404. Tout est question de dosage – et c’est là que la planification fait la différence.

Quelques bons réflexes pour programmer ton scraping de l’actualité :

- Colle-toi au rythme du site : Si la source publie toutes les heures, scrape toutes les heures. Pour une newsletter quotidienne, une fois par jour suffit. Pour les sites très actifs (CNN, Reuters, Google News), toutes les 30 minutes, voire plus souvent en journée, c’est parfois nécessaire ().

- Espace tes requêtes : N’inonde pas le serveur. Mets des pauses entre les requêtes et évite de scraper des centaines de pages d’un coup.

- Respecte le robots.txt : Vérifie toujours les consignes de crawl et les zones interdites.

- Surveille les erreurs : Si tu récupères des données vides ou des CAPTCHAs, c’est sûrement que tu vas trop vite.

Chez Thunderbit, on a développé la fonction Extracteur Programmé pile pour ça. Tu choisis ton intervalle (« toutes les 4 heures en semaine »), et Thunderbit gère tout : répartition des requêtes, exécution dans le cloud, collecte de données sans prise de tête ni blocage. En plus, le scraping cloud de Thunderbit peut traiter jusqu’à 50 pages en même temps, en répartissant la charge et en imitant le comportement d’un utilisateur normal.

Pour aller plus loin sur la planification et les stratégies anti-blocage, checke .

Extraire des données de contenus dynamiques : techniques pour des résultats solides

Les sites d’actualité modernes, c’est rarement du gâteau. Entre le scroll infini, les boutons « voir plus », les commentaires chargés en AJAX et des mises en page qui changent plus souvent que je ne change de playlist, le scraping devient… comment dire, « sportif ».

Les galères classiques :

- Scroll infini & pagination : La plupart des flux d’actualités chargent plus d’articles au fil du scroll. Un scraper basique ne verra que 10% du contenu.

- Éléments dynamiques : Les commentaires, images ou liens associés n’apparaissent parfois qu’après une action ou un délai.

- Changements fréquents de structure : Les sites d’actualité modifient souvent leur HTML, ce qui casse les scrapers classiques.

Comment Thunderbit gère tout ça :

- Pagination & scroll infini automatiques : L’IA de Thunderbit détecte et gère la navigation multi-pages et le scroll infini, pour ne rien louper.

- Extraction intelligente des champs : Plutôt que de s’appuyer sur des sélecteurs fragiles, Thunderbit « lit » la page grâce à l’IA et repère les champs clés (titre, auteur, date), même après une refonte du site.

- Scraping de sous-pages : Besoin du texte complet ? Thunderbit visite chaque lien d’article et fusionne les données dans un seul jeu de données.

- Mode navigateur pour contenus dynamiques : Thunderbit peut bosser dans ta session navigateur, exécuter le JavaScript et attendre le chargement complet – parfait pour les sites blindés d’AJAX.

Par exemple, scraper Google News avec Thunderbit permet de récupérer chaque titre, source et date, même quand de nouveaux articles poppent dynamiquement. Et si la structure change, un clic sur « Améliorer les champs par IA » et Thunderbit s’adapte direct.

Pour les détails techniques, va voir .

Rester dans les clous : conformité et sécurité du scraping de l’actualité

Un point sérieux : le scraping de l’actualité, c’est une zone grise côté loi et éthique. Il faut jouer réglo. Voici comment rester du bon côté :

- Respecte le robots.txt et les CGU : Vérifie toujours ce que le site autorise. Si une section est interdite, ne la scrape pas.

- Ne touche pas aux contenus payants ou privés : Reste sur les données publiques. Contourner un paywall, c’est non.

- Usage interne uniquement : Le scraping pour analyse interne ou dashboard, c’est plus safe que de republier des articles entiers.

- N’abîme pas les serveurs : Sois cool. Espace tes requêtes et évite de surcharger le site.

- Gère les données perso avec soin : Si tu collectes des noms d’auteurs ou des commentaires, pense aux lois sur la vie privée (RGPD, etc.).

Thunderbit est pensé pour t’aider à rester dans les clous. Il scrape via ton navigateur (en respectant tes droits d’accès), ne contourne pas la sécurité, et garde tes données sous ton contrôle. Toutes les exports sont gratuits et locaux – c’est toi qui décides où vont tes datas.

Pour plus d’infos sur la légalité, checke .

Les atouts uniques de Thunderbit pour le scraping de l’actualité

Je l’avoue, je ne suis pas objectif – mais Thunderbit a été conçu pour rendre le scraping de l’actualité simple et puissant, même si tu n’es pas un as du code. Voilà ce qui change la donne :

- Détection intelligente des champs par IA : Clique sur « Suggérer les champs par IA » et Thunderbit te propose direct les bonnes colonnes (titre, auteur, date, contenu, image, etc.) – sans code, sans prise de tête.

- Scraping de sous-pages et multi-pages : Suivi auto des liens vers les articles pour extraire le texte complet, les commentaires ou les liens associés.

- Gestion des contenus dynamiques : Scroll infini, AJAX, changements de structure – l’IA de Thunderbit s’adapte, ton extracteur ne casse pas à chaque update.

- Modes cloud & navigateur : Choisis le cloud pour la rapidité et le traitement en parallèle, ou le mode navigateur pour les sites qui demandent une connexion ou du JavaScript.

- Export gratuit et flexible : Exporte vers Excel, Google Sheets, Airtable, Notion ou JSON – sans limite ni surcoût.

- Simplicité sans code : Si tu sais naviguer sur le web, tu sais utiliser Thunderbit. Pas de XPath, pas de scripts, juste pointer, cliquer, c’est parti.

- Tarifs abordables : Un forfait gratuit pour les petits besoins, des offres payantes dès 15€/mois – bien moins cher que la plupart des solutions pro.

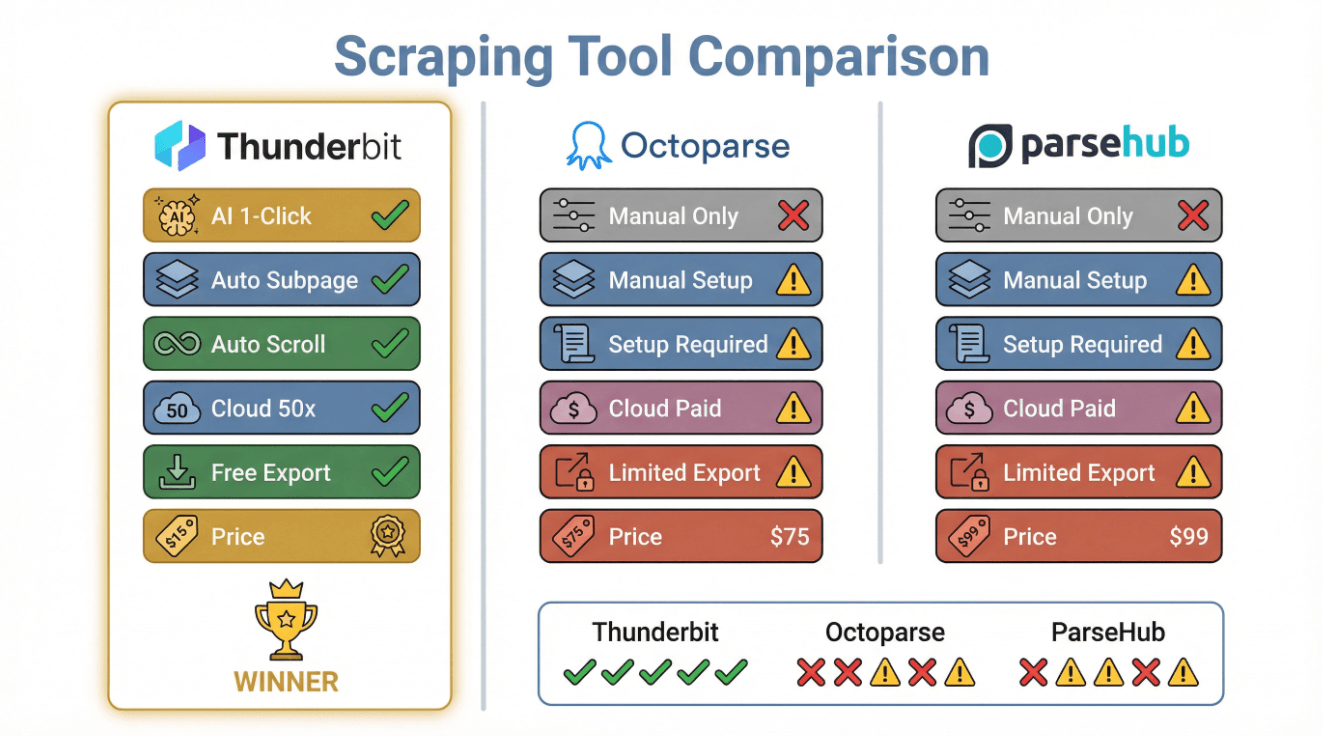

Comparatif express :

| Fonctionnalité | Thunderbit | Octoparse | ParseHub |

|---|---|---|---|

| Détection IA des champs | Oui (1 clic) | Non (manuel) | Non (manuel) |

| Scraping de sous-pages | Oui (auto) | Oui (manuel) | Oui (manuel) |

| Gestion du scroll infini | Oui (auto) | Oui (config req.) | Oui (config req.) |

| Scraping cloud | Oui (50 à la fois) | Oui (payant) | Oui (payant) |

| Export gratuit | Oui (tous plans) | Limité | Limité |

| Configuration sans code | Oui | Oui | Oui |

| Tarifs | Gratuit/15€+/mois | 75€+/mois | 99€+/mois |

Pour en savoir plus, va voir le .

Bonnes pratiques pour un scraping d’actualité fiable et rapide

Voici une checklist à garder sous le coude pour tout projet de scraping de l’actualité :

- Choisis des sources fiables : Prends les sites reconnus et souvent mis à jour (Google News, BBC, CNN, Reuters, TechCrunch).

- Adapte la fréquence de scraping : Calque ton planning sur le rythme de publication – toutes les heures pour l’info chaude, quotidiennement pour les flux plus calmes.

- Gère les contenus dynamiques : Utilise des outils (comme Thunderbit) capables de gérer le scroll infini, l’AJAX et les changements de structure.

- Déduplique et valide les données : Vire les doublons, vérifie les champs manquants et normalise les formats.

- Respecte la législation : Vérifie toujours le robots.txt, les CGU et évite les contenus payants ou privés.

- Surveille et adapte : Mets en place des alertes en cas d’échec, et vérifie régulièrement la qualité des données.

- Automatise l’intégration : Exporte vers tes outils préférés (Sheets, Notion, Airtable) et crée des dashboards ou alertes.

Tableau récap’ :

| Étape | Bonne pratique |

|---|---|

| Choix des sources | Fiables, pertinentes, diversifiées |

| Programmation | Adapter à la fréquence, espacer les requêtes |

| Gestion dynamique | IA/automatisation pour scroll, pagination, AJAX |

| Qualité des données | Dédupliquer, valider, normaliser |

| Conformité | robots.txt, CGU, lois sur la vie privée |

| Suivi | Alertes, vérifications, adaptation aux changements |

| Export & usage | Automatiser vers Sheets, Notion, dashboards, alertes |

Construire un workflow solide de scraping de l’actualité : mode d’emploi

Passons à la pratique. Voilà comment je mettrais en place un workflow de scraping de l’actualité avec – sans code, sans prise de tête.

Étape 1 : Identifier les sources d’actualité à cibler

- Sélectionne tes sites : Commence par les grands médias (BBC, CNN, Reuters), les sites spécialisés (TechCrunch, Medical News Today) et les agrégateurs (Google News).

- Vérifie l’accessibilité : Assure-toi que le contenu est public (pas de paywall).

- Pense langue/région : Thunderbit gère 34 langues, profites-en pour élargir ta veille.

- Fais ta liste d’URLs : Pages d’accueil, rubriques ou résultats de recherche (ex : Google News sur « régulation IA »).

Étape 2 : Configurer Thunderbit pour le scraping de l’actualité

- Installe l’.

- Ouvre la page cible dans Chrome.

- Clique sur « Suggérer les champs par IA » : Thunderbit te propose direct les colonnes (Titre, URL, Source, Date, Auteur, Image, etc.).

- Ajuste si besoin : Ajoute ou renomme des champs (ex : « Catégorie » pour suivre les rubriques).

- Enregistre comme modèle : Pour réutiliser la config sur d’autres pages similaires.

Étape 3 : Programmer et surveiller les tâches de scraping

- Planifie tes extractions : Utilise le planificateur Thunderbit (« chaque jour à 7h » ou « chaque heure en journée »).

- Teste en manuel : Vérifie que les données collectées sont bien ce que tu attends.

- Surveille les erreurs : Contrôle régulièrement les résultats ; si tu vois des données manquantes, relance « Suggérer les champs par IA » ou ajuste la planification.

- Gère les sous-pages : Pour le texte complet, active le scraping de sous-pages pour extraire les champs en plus.

Étape 4 : Exporter et exploiter les données d’actualité

- Exporte vers ton outil favori : Google Sheets, Airtable, Notion, Excel ou JSON.

- Automatise tes dashboards : Connecte ton tableur à Google Data Studio, Tableau ou Power BI pour une veille en temps réel.

- Mets en place des alertes : Utilise Zapier ou IFTTT pour recevoir des notifs sur de nouveaux titres ou mots-clés.

- Fais évoluer ton workflow : Ajuste tes champs, sources ou planning selon tes besoins – Thunderbit s’adapte sans souci.

Pour aller plus loin, checke .

Conclusion : les points clés pour un scraping d’actualité efficace

En résumé : dans un monde où l’info va à la vitesse de la lumière sur les réseaux, le scraping automatisé de l’actualité, c’est la clé pour rester informé, réactif et compétitif. Les bonnes pratiques sont simples mais cruciales : choisis les bonnes sources, planifie intelligemment, gère le contenu dynamique, respecte la loi et surveille tes résultats.

Thunderbit rend tout ça accessible à tous – sans code, sans prise de tête, avec des données d’actualité fiables et prêtes à être analysées, intégrées dans un dashboard ou utilisées pour des alertes. Que tu sois analyste, communicant, chercheur ou juste passionné d’info, tu peux te créer ton propre radar d’actualité en quelques minutes.

Marre de courir après les titres à la main ? Passe à Thunderbit. Ton futur toi (et ta boîte mail) te remerciera.

Envie d’aller plus loin ? Parcours le pour des tutos, des analyses et toute l’actu du scraping web boosté à l’IA.

FAQ

1. Pourquoi scraper l’actualité plutôt qu’utiliser une API ?

Le scraping permet de collecter des données plus riches et personnalisées – y compris les commentaires, bios d’auteurs, liens associés et texte intégral – que la plupart des API ne fournissent pas. C’est idéal pour bâtir des bases de données complètes, des modèles de sentiment ou des graphes de connaissances.

2. Comment éviter le blocage IP lors du scraping de sites d’actualité ?

Utilise des outils de planification (comme l’Extracteur Programmé de Thunderbit) pour espacer les requêtes, adapter la fréquence au site et respecter le robots.txt. Évite les extractions trop rapides et surveille les erreurs ou CAPTCHAs.

3. Quelle est la meilleure façon de gérer les sites d’actualité dynamiques avec scroll infini ou contenu AJAX ?

Opte pour un extracteur (comme Thunderbit) qui gère la pagination automatique, le scroll infini et l’extraction intelligente des champs. Tu récupéreras ainsi tous les articles, même ceux chargés dynamiquement.

4. Le scraping de l’actualité est-il légal ?

Extraire des données publiques à des fins d’analyse interne est généralement autorisé, mais vérifie toujours le robots.txt et les conditions d’utilisation du site. Ne scrape jamais de contenu payant ou privé, et respecte les droits d’auteur et la vie privée.

5. Qu’est-ce qui rend Thunderbit particulièrement adapté au scraping de l’actualité ?

Thunderbit combine détection intelligente des champs, scraping de sous-pages, gestion du contenu dynamique et export gratuit vers Excel, Sheets, Airtable et Notion – le tout sans code et avec une interface intuitive. C’est pensé pour les pros qui veulent des données fiables, sans prise de tête technique.

Prêt à te lancer dans ton propre pipeline d’actualité ? et découvre la simplicité du scraping d’actualité.

Pour aller plus loin