En 2025, les données issues du web ne sont plus juste un bonus : elles sont carrément le carburant de la stratégie des boîtes. Que tu bosses dans un mastodonte du e-commerce qui scrute les prix des concurrents en temps réel, ou dans une équipe commerciale qui veut booster sa base de prospects, les données publiques du web sont devenues un vrai trésor numérique. Les stats sont claires : près de , et plus de . Même si Python fait beaucoup de bruit, , surtout là où la fiabilité et l’intégration sont non négociables.

Après plusieurs années à bosser dans le SaaS et l’automatisation, j’ai vu à quel point le web scraping en Java peut changer la donne pour une entreprise. Mais j’ai aussi croisé des équipes qui galéraient avec le code bas niveau ou les sites blindés de protections anti-bot. C’est pour ça que je te propose un guide concret et progressif pour dompter le web scraping en Java en 2025, en misant sur la synergie entre le code et les outils modernes boostés à l’IA comme . Que tu sois dev, manager ou utilisateur métier qui veut des données sans prise de tête, ce guide est fait pour toi.

C’est quoi le Web Scraping en Java ? Explication Rapide

On va faire simple : le web scraping en Java, c’est utiliser du code Java pour aller chercher automatiquement des infos sur des sites web. Imagine un assistant virtuel ultra-rapide qui peut parcourir des milliers de pages et te ramener les données dont tu as besoin dans un tableau — sans jamais se fatiguer, sans faute, et à la vitesse de ta connexion.

Le principe, c’est ça :

- Envoyer une requête à un site web (comme si tu ouvrais la page dans ton navigateur).

- Télécharger le HTML (le code source de la page).

- Analyser ce HTML pour le transformer en une structure que ton programme comprend.

- Extraire les infos qui t’intéressent (noms de produits, prix, emails, etc.).

- Enregistrer les résultats dans un format pratique : CSV, Excel, base de données, ou même Google Sheets.

Pas besoin d’être un crack en dev pour piger les bases. Avec les bons outils et un peu de méthode, même les métiers peuvent automatiser la collecte de données et transformer des pages web en or exploitable.

Pourquoi le Web Scraping en Java est Incontournable pour les Entreprises en 2025 ?

Le web scraping, c’est plus réservé aux geeks : c’est devenu un vrai levier business. Voyons comment les boîtes utilisent le web scraping en Java pour prendre l’avantage, et pourquoi le ROI est bien réel.

| Cas d’usage du Web Scraping | Bénéfices pour l’entreprise (ROI) | Secteurs concernés |

|---|---|---|

| Veille tarifaire concurrentielle | Intelligence prix en temps réel ; hausse des ventes de 20 % et plus grâce à une réactivité accrue | E-commerce, Distribution |

| Génération de leads & prospection | Listes de prospects automatisées et à jour ; 70 % de temps gagné sur la recherche manuelle | B2B, Marketing, Recrutement |

| Études de marché & analyse de tendances | Détection précoce des tendances ; 5 à 15 % de CA supplémentaire et 10 à 20 % de ROI marketing en plus | Produits grand public, Agences marketing |

| Données financières & investissement | Données alternatives pour le trading ; marché de plus de 5 milliards $ pour les “alt-data” issues du web | Finance, Hedge Funds, Fintech |

| Automatisation & monitoring | Collecte de données routinière automatisée ; 73 % d’économies et 85 % de déploiement plus rapide | Immobilier, Supply Chain, Secteur public |

()

Pourquoi Java ? Parce qu’il est taillé pour l’échelle, la fiabilité et l’intégration. Beaucoup de pipelines de données en entreprise tournent déjà sur Java, donc ajouter un extracteur web, c’est naturel. Et côté multithreading et gestion des erreurs, Java est top pour les gros volumes — imagine extraire des milliers de pages par jour, pas juste quelques-unes.

Comment Fonctionne le Web Scraping en Java ? Les Bases et les Atouts

Décortiquons comment marche un extracteur web Java classique :

- Requêtes HTTP : Java utilise des libs comme JSoup ou Apache HttpClient pour choper les pages web. Tu peux bidouiller les en-têtes, utiliser des proxies et simuler un vrai navigateur pour éviter de te faire bloquer.

- Analyse HTML : Des outils comme JSoup transforment le HTML en “DOM” (arbre de données), ce qui rend la recherche d’infos super simple avec des sélecteurs CSS.

- Extraction des données : Tu poses tes règles (genre “récupère tous les

<span class='price'>”) pour choper ce qui t’intéresse. - Stockage des données : Les résultats peuvent finir en CSV, Excel, JSON ou dans une base de données.

Pourquoi Java sort du lot pour le Web Scraping ?

- Multithreading : Java gère plein de pages en même temps, ce qui booste grave les extractions massives. Là où Python galère avec le GIL, Java fait tourner le multitâche à fond.

- Performance : Grâce à la compilation, Java encaisse sans broncher les tâches lourdes et gourmandes en mémoire.

- Intégration en entreprise : Les extracteurs Java s’intègrent easy avec les systèmes existants (CRM, ERP, bases de données) sans prise de tête.

- Gestion des erreurs : Le typage strict et la gestion des exceptions rendent les extracteurs plus costauds et faciles à maintenir sur la durée.

Si tu pilotes un pipeline de données critique, la stabilité et la scalabilité de Java, c’est du solide.

Les Meilleures Bibliothèques et Frameworks pour le Web Scraping en Java

L’écosystème Java est blindé de bibliothèques pour le scraping, mais trois sortent vraiment du lot pour les pros : JSoup, HtmlUnit et Selenium. Voici comment les départager :

| Bibliothèque | Gère JavaScript ? | Facilité d’utilisation | Performance | Idéal pour |

|---|---|---|---|---|

| JSoup | ❌ (Non) | Très simple | Excellente | Pages statiques, tâches rapides, jobs légers |

| HtmlUnit | ⚠️ Partiel | Moyenne | Moyenne | JS simple, formulaires, scraping sans interface graphique |

| Selenium | ✅ Oui (Complet) | Moyenne/Difficile | Moins rapide (par page) | Sites riches en JS, pages interactives/dynamiques |

()

JSoup : L’Indispensable pour l’Analyse HTML Simple

est mon go-to pour la plupart des extractions. Léger, super simple à prendre en main, il est parfait pour les pages statiques où les données sont direct dans le HTML.

Exemple :

1Document doc = Jsoup.connect("https://www.scrapingcourse.com/ecommerce/").get();

2String bannerTitle = doc.select("div.site-title").text();

3System.out.println("Banner: " + bannerTitle);C’est vraiment aussi simple. Pour extraire des articles de blog, des listes de produits ou des annuaires sans JavaScript, JSoup fait le taf.

HtmlUnit : Simuler un Navigateur pour les Tâches Plus Corsées

est un navigateur sans interface graphique écrit en Java. Il gère un peu de JavaScript, peut remplir des formulaires et cliquer sur des boutons — tout ça sans ouvrir de fenêtre.

Quand l’utiliser : Si tu dois te connecter à un site ou gérer du contenu dynamique basique, sans la lourdeur de Selenium.

Exemple :

1WebClient webClient = new WebClient();

2HtmlPage page = webClient.getPage("https://example.com/login");

3// ... remplir le formulaire et valider ...Selenium : Pour les Sites Blindés de JavaScript et Interactifs

est la solution la plus puissante. Il contrôle un vrai navigateur (Chrome, Firefox…), donc il gère n’importe quel site, même ceux full JavaScript.

Quand l’utiliser : Pour extraire des données d’applis web modernes, de sites à scroll infini ou qui demandent des interactions utilisateur.

Exemple :

1WebDriver driver = new ChromeDriver();

2driver.get("https://www.scrapingcourse.com/ecommerce/");

3List<WebElement> products = driver.findElements(By.cssSelector("li.product"));

4// ... extraction des données ...

5driver.quit();Booster le Web Scraping Java avec Thunderbit : L’Automatisation Visuelle qui Change Tout

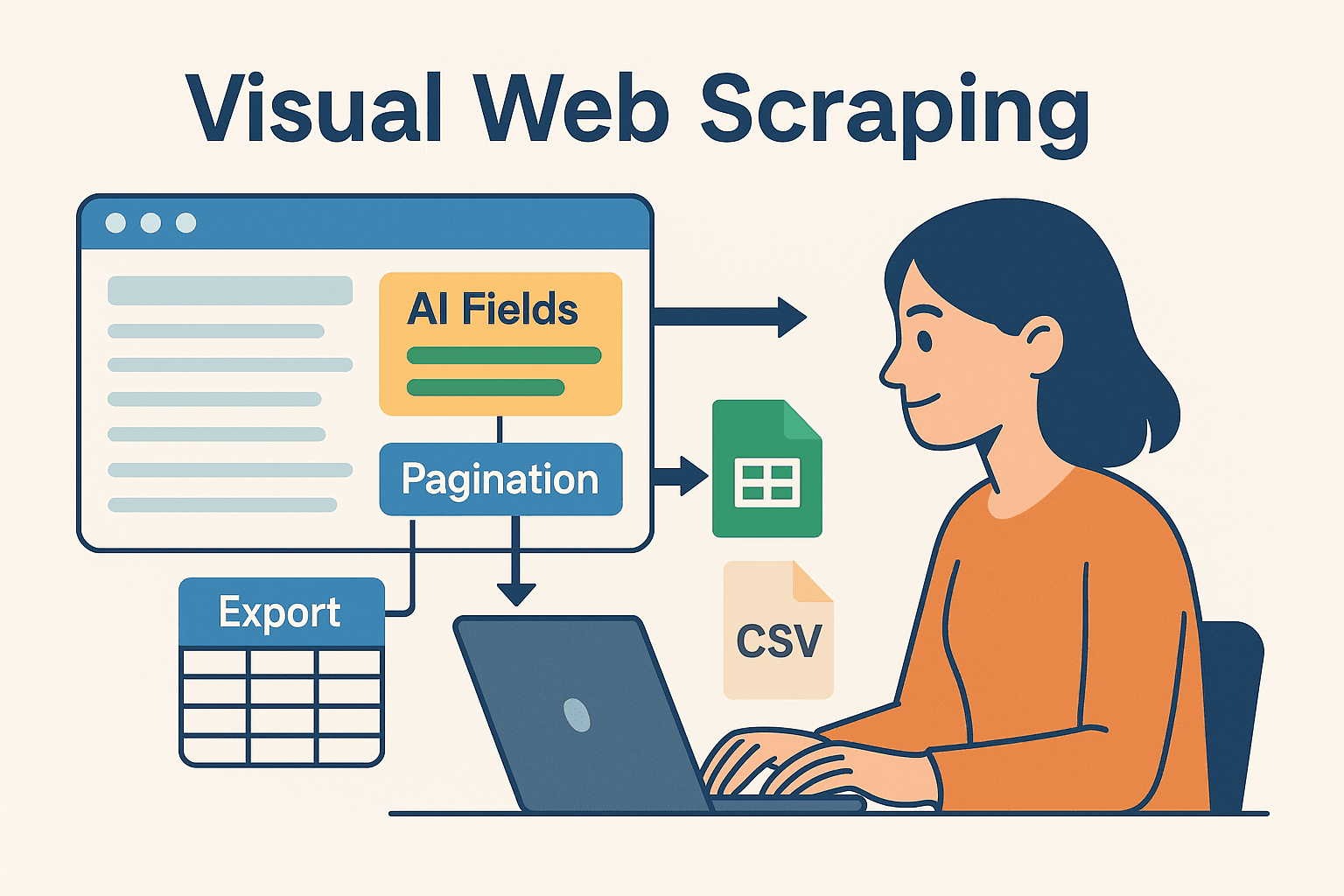

C’est là que ça devient vraiment cool — surtout pour les équipes qui veulent pas passer leur vie dans le code. est un extracteur web IA, sans code, qui te permet de configurer visuellement tes extractions (directement dans le navigateur), puis d’exporter les données vers Excel, Google Sheets, Airtable ou Notion.

Pourquoi Mixer Thunderbit et Java ?

- Champs suggérés par l’IA : La fonction “Suggérer des champs” de Thunderbit lit la page et te propose direct les données à extraire — plus besoin de fouiller dans le HTML ou d’écrire des sélecteurs.

- Extraction de sous-pages : Besoin de détails en plus ? Thunderbit peut aller sur chaque sous-page (genre fiches produits) et enrichir ton dataset.

- Modèles instantanés : Pour les sites connus (Amazon, Zillow, LinkedIn), Thunderbit a des modèles prêts à l’emploi — zéro config.

- Export facile : Une fois l’extraction finie, exporte tes données en quelques secondes — prêtes à être traitées par ton code Java.

Thunderbit fait gagner un temps fou pour prototyper, gérer les sites galères ou permettre aux non-devs d’avoir les données qu’ils veulent. Pour les devs, c’est aussi un super moyen d’automatiser les tâches répétitives ou fragiles, et de se concentrer sur la logique métier.

Associer Thunderbit et Java pour des Projets Costauds

Voici un workflow que j’adore :

- Prototyper avec Thunderbit : Utilise l’extension Chrome pour configurer visuellement ton extraction. Laisse l’IA suggérer les champs, gérer la pagination et exporter les données vers Google Sheets ou CSV.

- Traiter en Java : Code en Java pour lire les données exportées (depuis Sheets, CSV ou Airtable), puis fais tes traitements, analyses ou intégrations avec tes systèmes d’entreprise.

- Automatiser & planifier : Utilise le planificateur intégré de Thunderbit pour garder tes données à jour, et fais en sorte que ton pipeline Java récupère automatiquement les dernières extractions.

Cette approche hybride te donne le meilleur des deux mondes : la rapidité et la flexibilité du scraping sans code boosté à l’IA, et la puissance de Java pour le traitement derrière.

Tutoriel : Crée ton Premier Extracteur Web Java Pas à Pas

On passe à la pratique. Voici comment monter un extracteur web Java simple, étape par étape.

Préparer ton environnement Java

- Installer Java (JDK) : Prends Java 17 ou 21 pour être tranquille.

- Configurer Maven : Il gère les dépendances pour toi.

- Choisir un IDE : IntelliJ IDEA, Eclipse ou VSCode, à toi de voir.

- Ajouter JSoup à ton

pom.xml:1<dependency> 2 <groupId>org.jsoup</groupId> 3 <artifactId>jsoup</artifactId> 4 <version>1.16.1</version> 5</dependency>

Écrire et lancer ton extracteur

Exemple : extraire les noms et prix de produits d’un site e-commerce de démo.

1import org.jsoup.Jsoup;

2import org.jsoup.nodes.Document;

3import org.jsoup.select.Elements;

4import org.jsoup.nodes.Element;

5public class ProductScraper {

6 public static void main(String[] args) {

7 String url = "https://www.scrapingcourse.com/ecommerce/";

8 try {

9 Document doc = Jsoup.connect(url)

10 .userAgent("Mozilla/5.0")

11 .get();

12 Elements productElements = doc.select("li.product");

13 for (Element productEl : productElements) {

14 String name = productEl.selectFirst("h2").text();

15 String price = productEl.selectFirst("span.price").text();

16 System.out.println(name + " -> " + price);

17 }

18 } catch (Exception e) {

19 e.printStackTrace();

20 }

21 }

22}Astuce : Mets un user-agent pour faire croire que tu es un vrai navigateur. Certains sites bloquent l’user-agent Java par défaut.

Exporter et utiliser tes données

- Export CSV : Utilise

FileWriterou une lib comme OpenCSV pour écrire les résultats dans un fichier CSV. - Export Excel : Utilise Apache POI pour les fichiers .xls/.xlsx.

- Intégration base de données : Utilise JDBC pour insérer les données direct dans ta base.

- Google Sheets : Exporte depuis Thunderbit et lis avec l’API Google Sheets de Java.

Gérer les Galères du Web Scraping en Java

Le scraping, c’est pas toujours du gâteau. Voici les soucis les plus fréquents — et comment les esquiver :

- Blocage IP & limitations de fréquence : Ralentis tes requêtes (

Thread.sleep()), utilise des proxies et varie les délais. Pour les gros volumes, passe par des services de proxy. - CAPTCHAs & détection de bots : Utilise Selenium pour simuler un humain, ou des API anti-bot. Parfois, le scraping cloud de Thunderbit passe à travers.

- Contenu dynamique : Si JSoup ne trouve rien, c’est que les données sont chargées en JavaScript. Passe à Selenium ou HtmlUnit, ou cherche l’API utilisée par le site.

- Changements de structure de site : Code de façon flexible avec des sélecteurs adaptatifs. Surveille tes extracteurs et sois prêt à les mettre à jour. L’IA de Thunderbit s’adapte vite aux changements de page — relance juste “Suggérer des champs”.

- Gestion de session : Pour les sites avec login, gère bien cookies et sessions. Selenium et Thunderbit (quand tu es connecté à Chrome) gèrent les pages authentifiées.

Conseils de Pro pour Optimiser le Web Scraping en Java

Prêt à passer à la vitesse supérieure ? Voici quelques tips de pro :

- Multithreading : Utilise

ExecutorServicepour extraire plusieurs pages en même temps. Mais vas-y mollo pour pas te faire bloquer ! - Planification : Utilise Quartz Scheduler en Java, ou laisse Thunderbit gérer la planif dans le cloud en langage naturel (“tous les lundis à 9h”).

- Scalabilité cloud : Pour les très gros volumes, fais tourner des navigateurs headless dans le cloud ou répartis les tâches sur plusieurs machines.

- Workflows hybrides : Utilise Thunderbit pour les sites galères et ton code Java pour le reste. Fusionne les résultats dans ton data warehouse.

- Monitoring & logs : Appuie-toi sur les frameworks de logs Java pour surveiller la santé de tes extracteurs, détecter les bugs et déclencher des alertes si besoin.

Conclusion & Points Clés à Garder en Tête

La donnée web, c’est le nouvel or, et Java reste l’un des meilleurs outils pour l’exploiter — surtout si tu veux de la fiabilité, de l’échelle et de l’intégration. Le workflow de base est simple : récupérer, analyser, extraire, exporter. Avec JSoup, HtmlUnit et Selenium, tu peux tout gérer, des annuaires classiques aux sites les plus dynamiques.

Mais pas besoin de tout faire à la main. Des outils comme amènent l’IA et l’automatisation visuelle, pour prototyper, adapter et faire évoluer tes projets de scraping plus vite que jamais. Mon conseil ? N’hésite pas à mixer code et no-code. Utilise Thunderbit pour la config rapide et la maintenance, puis laisse ton pipeline Java gérer le traitement lourd.

Envie de voir comment Thunderbit peut booster tes workflows ? et teste l’extraction de ton premier site en quelques minutes. Pour aller plus loin, checke le pour des tutos, des analyses et toute l’actu de l’automatisation du web scraping.

Bon scraping — que tes données soient toujours clean, fraîches et prêtes à l’emploi !

FAQ

1. Java est-il toujours pertinent pour le web scraping en 2025 ?

Carrément. Si Python cartonne pour les scripts rapides, Java reste la référence pour les projets d’extraction costauds, fiables et durables — surtout quand l’intégration et le multithreading sont clés.

2. Quand utiliser JSoup, HtmlUnit ou Selenium ?

JSoup pour les pages statiques, HtmlUnit pour le contenu dynamique simple ou les formulaires, Selenium pour les sites blindés de JavaScript ou interactifs. Prends l’outil qui colle à la complexité du site.

3. Comment éviter d’être bloqué lors du scraping ?

Espace tes requêtes, utilise des proxies rotatifs, mets des user-agents crédibles et simule un comportement humain. Pour les sites coriaces, pense au scraping cloud de Thunderbit ou aux API anti-bot.

4. Peut-on combiner Thunderbit et Java ?

Bien sûr. Utilise Thunderbit pour configurer et planifier visuellement tes extractions, exporte les données, puis traite-les ou intègre-les avec ton code Java. C’est une combinaison puissante pour les métiers comme pour les devs.

5. Quelle est la façon la plus rapide de débuter le web scraping en Java ?

Installe Java et Maven, ajoute JSoup et teste l’extraction d’un site simple. Pour les tâches plus complexes ou le prototypage rapide, installe et laisse l’IA faire le gros du boulot — puis intègre les résultats dans ton workflow Java.

Envie de plus d’astuces, d’exemples de code ou de conseils d’automatisation ? Parcours le ou abonne-toi à notre pour des tutos pratiques et toute l’actu du web scraping. En savoir plus