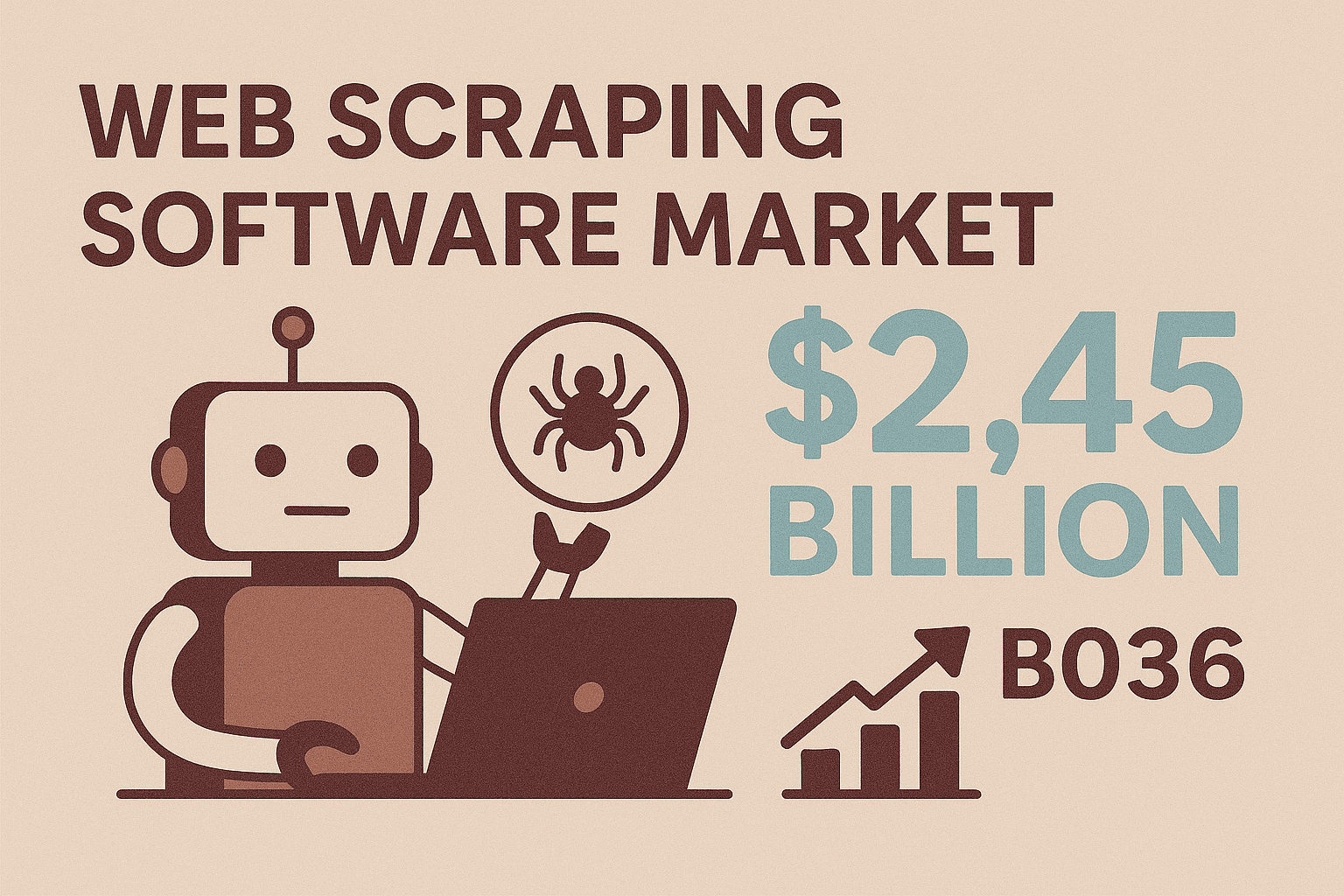

Il y a un vrai plaisir à regarder un script tourner sur un site web et ramasser des données pendant que tu bois ton café. Fini l’époque où le « screen scraping » rimait avec copier-coller à la main ou demandes répétées au service IT pour obtenir un export. Aujourd’hui, le screen scraping Java sert aussi bien à la génération de leads qu’à la veille tarifaire en temps réel, et ce n’est plus réservé aux développeurs experts. D’ailleurs, avec un marché des logiciels d’extraction de données web qui devrait atteindre , il est clair que les entreprises cherchent des solutions automatisées et flexibles pour transformer le web en données prêtes à l’emploi.

Que tu sois business developer, commercial ou dev qui veut extraire des données structurées de sites web — surtout ceux sans API — le screen scraping Java est une compétence à avoir dans sa poche. Dans ce guide, je t’explique les bases, les bibliothèques Java à connaître, les galères fréquentes et comment des outils no-code comme peuvent booster tes projets. Que tu veuilles coder ton propre extracteur ou laisser l’IA bosser à ta place, tu trouveras ici des astuces concrètes pour extraire des données plus vite, sans te prendre la tête.

Que tu sois business developer, commercial ou dev qui veut extraire des données structurées de sites web — surtout ceux sans API — le screen scraping Java est une compétence à avoir dans sa poche. Dans ce guide, je t’explique les bases, les bibliothèques Java à connaître, les galères fréquentes et comment des outils no-code comme peuvent booster tes projets. Que tu veuilles coder ton propre extracteur ou laisser l’IA bosser à ta place, tu trouveras ici des astuces concrètes pour extraire des données plus vite, sans te prendre la tête.

Les bases du Screen Scraping Java : Définition et Intérêt

On commence par l’essentiel. Le screen scraping Java, c’est utiliser du code Java pour aller chercher automatiquement des infos sur des sites web — en gros, automatiser la lecture d’une page et l’extraction des données qui t’intéressent. Contrairement aux API, qui donnent des données déjà bien rangées (quand elles existent), le screen scraping va directement interagir avec la page, comme si tu surfais sur Chrome ou Firefox.

Pourquoi c’est important ? Parce que la plupart des sites — surtout dans l’e-commerce, l’immobilier ou les annuaires B2B — n’ont ni API publique ni export massif. Le screen scraping permet donc d’accéder à ces données « enfermées ». Avec Java, tu as une boîte à outils super flexible : tu peux écrire des règles sur-mesure, gérer les connexions, cliquer sur des boutons, et même extraire du contenu dynamique. C’est la solution parfaite quand les outils classiques ne suffisent pas ou que tu dois adapter l’extraction à un besoin métier bien précis.

Et la demande explose. Les boîtes qui adoptent des outils modernes d’extraction (surtout ceux boostés à l’IA) gagnent sur la collecte de données, avec des taux de précision qui montent à 99 %. De quoi libérer un temps fou autrefois perdu à chercher à la main.

Applications métiers clés du Screen Scraping Java

Dans quels cas le screen scraping Java fait vraiment la différence ? Voici quelques exemples qui parlent à tout le monde :

| Application | Valeur métier | Exemple d'utilisation |

|---|---|---|

| Génération de leads | Automatiser la collecte de prospects, élargir le pipe commercial, gagner du temps | Extraire des contacts sur LinkedIn ou des annuaires en ligne (noms, emails, téléphones) |

| Veille tarifaire | Suivre les prix concurrents en temps réel, ajuster ses tarifs, libérer les analystes | Parcourir les sites e-commerce pour des mises à jour quotidiennes des prix et stocks |

| Extraction de fiches produit | Agréger des catalogues multi-sources, garder les listings à jour | Récupérer noms, caractéristiques, images, avis depuis des sites fournisseurs ou concurrents |

| Études de marché | Collecter des jeux de données massifs et à jour pour l’analyse | Extraire des centaines d’avis produits ou d’annonces immobilières pour détecter des tendances |

| Analyse concurrentielle | Repérer les tendances, surveiller les nouveautés, analyser la perception client | Agréger les pages produits, avis clients ou mentions presse des concurrents |

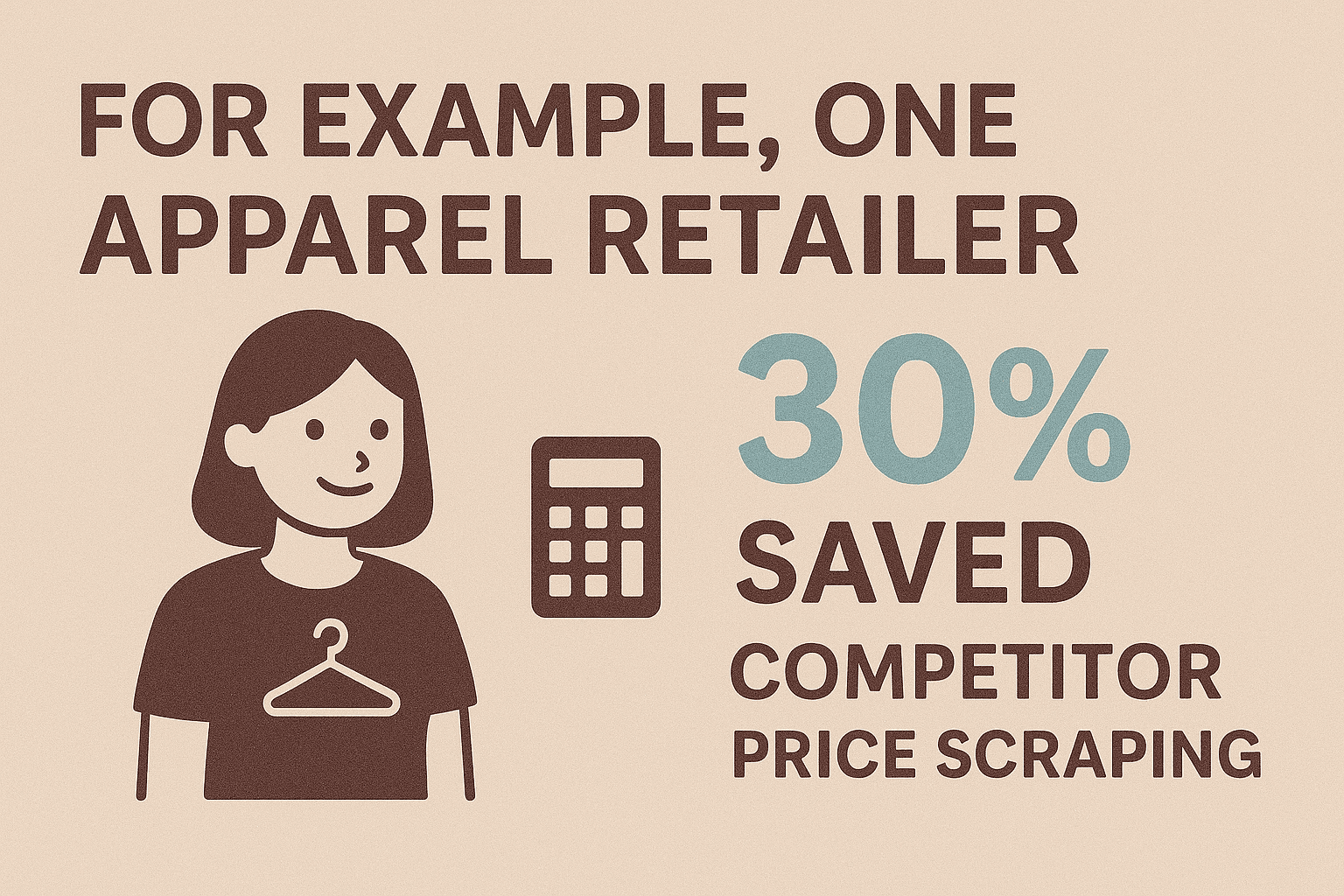

Par exemple, un distributeur textile qui a automatisé la veille tarifaire de ses concurrents a tout en ayant des infos en temps réel. Les commerciaux utilisent le scraping pour monter des listes de prospects qui prendraient des semaines à faire à la main. Et avec plus de , les e-commerçants s’appuient sur l’extraction pour rester dans la course.

En clair : si tu as besoin de données web et qu’il n’y a pas d’API, le screen scraping est souvent la seule solution efficace.

En clair : si tu as besoin de données web et qu’il n’y a pas d’API, le screen scraping est souvent la seule solution efficace.

Bien démarrer : Outils et bibliothèques Java pour le Screen Scraping

L’écosystème Java regorge de bibliothèques qui rendent le screen scraping accessible, même si tu n’es pas dev à temps plein. Voici les plus connues :

1. Selenium WebDriver

- Fonction : Automatise un vrai navigateur (Chrome, Firefox) pour interagir avec des sites dynamiques bourrés de JavaScript.

- Idéal pour : Extraire des sites qui demandent une connexion, des clics ou des interactions utilisateur.

- Points forts : Gère tout ce qu’un humain peut voir ; parfait pour les workflows complexes.

- Limites : Plus lent et gourmand en ressources ; il faut installer les drivers de navigateur.

Exemple de code :

1WebDriver driver = new ChromeDriver();

2driver.get("https://example.com/page");

3String title = driver.getTitle();

4System.out.println("Page title: " + title);

5driver.close();2. Jsoup

- Fonction : Récupère et analyse le HTML statique via une API simple, façon jQuery.

- Idéal pour : Scraping rapide de pages statiques, blogs, actus ou listes produits.

- Points forts : Léger, rapide, facile à prendre en main, tolère le HTML mal fichu.

- Limites : Ne gère pas le JavaScript ni les contenus chargés en AJAX.

Exemple de code :

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements names = doc.select(".product-name");

3for (Element name : names) {

4 System.out.println(name.text());

5}3. HtmlUnit

- Fonction : Simule un navigateur sans interface graphique en Java, exécute certains scripts JavaScript.

- Idéal pour : Sites moyennement dynamiques où tu veux un comportement proche d’un navigateur sans la lourdeur de Selenium.

- Points forts : Pas besoin de navigateur externe ; gère les requêtes HTTP, cookies et scripts simples.

- Limites : Moins costaud que Selenium pour les frameworks JS modernes.

Exemple de code :

1WebClient webClient = new WebClient(BrowserVersion.CHROME);

2HtmlPage page = webClient.getPage("https://example.com");

3DomElement button = page.getElementById("next-btn");

4page = button.click();

5String content = page.asText();4. Autres solutions à connaître

- WebMagic, Gecco : Frameworks haut niveau pour crawler et extraire à grande échelle.

- Htmleasy : Ultra simple, mise tout sur la facilité d’utilisation — parfait pour des prototypes rapides.

Comparatif des bibliothèques Java pour le Screen Scraping

| Bibliothèque | Support du contenu dynamique | Facilité d’utilisation | Cas d’usage idéal |

|---|---|---|---|

| Selenium | Oui | Moyenne | Sites riches en JS, connexions, workflows interactifs |

| Jsoup | Non | Facile | Pages statiques, prototypage rapide |

| HtmlUnit | Partiel | Moyenne | Scraping léger sans interface, JS simple |

| Htmleasy | Non | Très facile | Sites simples et statiques, extractions rapides |

| WebMagic/Gecco | Non (JS) | Moyenne | Crawling massif, extraction multi-pages |

Checklist pour bien démarrer :

- Choisis ta bibliothèque (Selenium pour le dynamique, Jsoup pour le statique).

- Configure ton projet Java (ajoute les dépendances via Maven/Gradle).

- Analyse le HTML du site cible avec les outils de dev du navigateur.

- Écris un premier script pour extraire un élément simple.

- Développe ta logique d’extraction et gère la pagination.

- Exporte tes données (CSV, JSON ou direct en base de données).

Tutoriel : Créer ton premier Screen Scraper Java pas à pas

Prenons un cas concret : extraire les noms et prix de produits d’une page e-commerce de démo avec Jsoup.

Étape 1 : Préparer le projet

Ajoute Jsoup à ton pom.xml Maven :

1<dependency>

2 <groupId>org.jsoup</groupId>

3 <artifactId>jsoup</artifactId>

4 <version>1.16.1</version>

5</dependency>Étape 2 : Récupérer la page web

1String url = "https://www.scrapingcourse.com/ecommerce/";

2Document doc = Jsoup.connect(url).get();Étape 3 : Analyser et extraire les données

1Elements productElements = doc.select("li.product");

2for (Element productEl : productElements) {

3 String name = productEl.selectFirst(".woocommerce-loop-product__title").text();

4 String price = productEl.selectFirst(".price").text();

5 System.out.println(name + " -> " + price);

6}Étape 4 : Gérer la pagination

1Element nextLink = doc.selectFirst("a.next");

2while (nextLink != null) {

3 String nextUrl = nextLink.absUrl("href");

4 doc = Jsoup.connect(nextUrl).get();

5 // Répéter la logique d’extraction

6 nextLink = doc.selectFirst("a.next");

7}Étape 5 : Exporter les données (exemple CSV)

1FileWriter csvWriter = new FileWriter("products.csv");

2csvWriter.append("Product Name,Price\n");

3for (Element productEl : productElements) {

4 String name = ...;

5 String price = ...;

6 csvWriter.append("\"" + name + "\",\"" + price + "\"\n");

7}

8csvWriter.flush();

9csvWriter.close();Ou, pour du JSON :

1List<Product> products = new ArrayList<>();

2// remplir la liste dans la boucle

3Gson gson = new Gson();

4String jsonOutput = gson.toJson(products);

5Files.write(Paths.get("products.json"), jsonOutput.getBytes());Formats de sortie : JSON, CSV et plus

- CSV : Parfait pour l’analyse rapide, les tableurs ou le partage avec des collègues non techniques.

- JSON : Idéal pour intégrer dans des applis, des API ou pour des données imbriquées.

- Excel : Utilise Apache POI pour générer des fichiers

.xlsxnatifs. - Base de données : Insère direct via JDBC pour un stockage durable.

Choisis le format qui colle le mieux à ton workflow. Pour la plupart des utilisateurs, CSV ou Excel, c’est le top.

Dépasser les obstacles : Problèmes courants et solutions en Screen Scraping Java

Le screen scraping, ce n’est pas toujours du gâteau. Voici les galères les plus fréquentes et comment t’en sortir :

1. Contenu dynamique (JavaScript/AJAX)

- Problème : Les données arrivent après le chargement de la page ; Jsoup ne les voit pas.

- Solution : Utilise Selenium WebDriver pour piloter un vrai navigateur, ou repère les requêtes AJAX à reproduire en Java.

2. Anti-bot et limitations

- Problème : Les sites bloquent ou limitent les requêtes automatiques.

- Solution : Respecte les délais entre requêtes, varie les user agents, fais tourner les IP et simule un comportement humain. Pour les gros volumes, pense aux proxys ou aux plugins furtifs pour Selenium.

3. Changements de structure du site

- Problème : Un changement de HTML casse tes sélecteurs.

- Solution : Centralise les sélecteurs dans ton code, privilégie les classes CSS solides ou les attributs data, et logge les erreurs pour réagir vite. Sois prêt à adapter ton scraper.

4. Qualité et nettoyage des données

- Problème : Formats incohérents, valeurs manquantes ou texte bruité.

- Solution : Utilise les fonctions de traitement de chaînes et les regex de Java pour nettoyer à la volée. Normalise les formats (téléphones, prix) et gère les valeurs nulles intelligemment.

5. Performance et passage à l’échelle

- Problème : Scraper des milliers de pages prend du temps.

- Solution : Utilise la concurrence en Java (ExecutorService, pools de threads) pour paralléliser, sans saturer les sites cibles. Écris les résultats au fil de l’eau pour éviter les soucis de mémoire.

Pour plus de tips, va voir le .

Pourquoi Thunderbit est le partenaire idéal du Screen Scraping Java

Parlons franchement : la maintenance, c’est le nerf de la guerre. Écrire et maintenir des scrapers Java peut vite devenir un casse-tête, surtout quand les sites changent ou renforcent leurs protections anti-bot. C’est là que fait la différence.

Thunderbit, c’est une extension Chrome d’extracteur web IA, sans code, pensée pour les pros du business, les commerciaux, les marketeurs, et tous ceux qui veulent automatiser la collecte de données web — sans taper une ligne de code. Voilà pourquoi c’est un vrai plus pour les devs Java comme pour les non-techs :

- Détection intelligente des champs : Clique sur « Suggérer les champs IA » et l’IA de Thunderbit analyse la page pour te proposer direct les colonnes utiles (noms de produits, prix, emails, etc.).

- Scraping en 2 clics : Un clic pour que l’IA repère les données, un autre pour les extraire. Plus besoin de bidouiller des sélecteurs ou d’écrire des scripts.

- Extraction sur sous-pages : Thunderbit peut suivre les liens (ex : pages produit) et enrichir ton tableau avec des infos en plus — sans codage manuel.

- Modèles instantanés : Pour les sites connus (Amazon, Zillow, Shopify), Thunderbit propose des modèles prêts à l’emploi pour un scraping structuré immédiat.

- Reconnaissance des types de données : Détecte emails, numéros de téléphone, dates, images, etc. — et exporte des données propres, prêtes à l’emploi.

- Accessibilité no-code : Tout le monde dans l’équipe peut l’utiliser, ce qui libère les devs pour des tâches à plus forte valeur ajoutée.

- Zéro maintenance : Si le site change, reclique sur « Suggérer les champs IA » — l’IA de Thunderbit s’adapte toute seule.

Thunderbit, c’est parfait pour les projets urgents, les prototypes ou pour compléter ton workflow Java quand tu as besoin de données vite, sans passer des heures à coder ou déboguer.

Intégrer Thunderbit à Java : Construire un pipeline de données complet

Le vrai game changer, c’est quand tu combines la simplicité de Thunderbit avec la puissance de Java. Voici comment monter un pipeline de données efficace de A à Z :

- Extraction avec Thunderbit : Utilise Thunderbit pour collecter les données du site cible. Programme des extractions récurrentes ou utilise les modèles instantanés pour les sites classiques.

- Export des données : Exporte tes résultats en CSV, Excel, , Airtable ou Notion — des formats que Java gère facilement.

- Traitement avec Java : Développe une appli Java pour lire les données exportées (via l’API Google Sheets ou en lisant le CSV), les nettoyer ou enrichir, puis les intégrer à tes systèmes internes (CRM, base de données, analytics).

- Automatisation du workflow : Planifie Thunderbit pour tourner à intervalles réguliers et déclenche ton script Java après chaque extraction. Ton pipeline de données tourne tout seul.

Exemple : Ton équipe commerciale veut une liste de prospects fraîche chaque lundi depuis un annuaire en ligne. Thunderbit extrait les données et les exporte vers Google Sheets. Ton appli Java lit la feuille, déduplique les contacts et les intègre dans le CRM. Si la structure du site change, il suffit d’ajuster la config Thunderbit — pas besoin de toucher au code Java.

Cette approche hybride te donne le meilleur des deux mondes : Thunderbit gère la complexité et la variabilité du web, Java orchestre la logique métier et l’intégration.

Conseils avancés : Passer à l’échelle et automatiser le Screen Scraping Java

Si tes besoins d’extraction grossissent, voici comment passer à la vitesse supérieure :

- Parallélisation : Utilise les pools de threads Java pour extraire plusieurs pages en même temps, mais limite la concurrence pour ne pas te faire bloquer.

- Planification : Automatise les extractions avec la librairie Quartz de Java ou le planificateur intégré de Thunderbit (tu décris juste la fréquence en langage naturel).

- Gestion des erreurs : Prévoyez des relances, des timeouts et des alertes (email ou Slack) en cas de souci.

- Scraping cloud : Le mode cloud de Thunderbit permet d’extraire 50 pages d’un coup — parfait pour les gros volumes sans saturer ton ordi.

- Maintenance : Documente tes scrapers, centralise les sélecteurs et logge les anomalies pour un dépannage rapide. Avec Thunderbit, la plupart des mises à jour se font en un clic sur « Suggérer les champs IA ».

Pour des volumes énormes (millions de pages), pense à des frameworks distribués comme Apache Nutch ou des API cloud spécialisées — mais pour la majorité des besoins business, le combo Thunderbit + Java suffit largement, sans la prise de tête.

Conclusion & Points clés à retenir

Le screen scraping Java, c’est un super levier pour exploiter les données du web — que ce soit pour générer des leads, surveiller la concurrence ou nourrir tes analyses. À retenir :

- Java offre flexibilité et contrôle pour les extractions sur-mesure, complexes ou qui demandent des logins, du contenu dynamique ou une logique métier spécifique.

- Thunderbit apporte la simplicité no-code et l’intelligence artificielle au scraping web, rendant l’extraction accessible à tous et réduisant le temps de mise en place de plusieurs heures à quelques minutes.

- Combiner les deux approches permet de bâtir des pipelines de données rapides et robustes : extraction avec Thunderbit, traitement et intégration avec Java.

- Automatise et passe à l’échelle grâce à la parallélisation, la planification et le cloud scraping — sans crouler sous la maintenance.

- L’avenir est hybride : Avec la montée des outils IA comme Thunderbit, les meilleurs extracteurs mixeront code et no-code pour une efficacité maximale.

Prêt à passer à la vitesse supérieure dans l’extraction de données ? , lance ton premier scraper Java et découvre combien de temps (et d’énergie) tu peux gagner. Pour plus d’astuces et de guides, va faire un tour sur le .

FAQ

1. Qu’est-ce que le screen scraping Java et en quoi est-ce différent du web scraping classique ?

Le screen scraping Java, c’est utiliser du code Java pour extraire des données directement depuis l’interface d’un site (la page affichée), surtout quand il n’y a pas d’API. C’est une forme de web scraping, mais le terme « screen scraping » insiste sur l’extraction telle qu’un utilisateur la verrait, pas depuis des sources structurées côté serveur.

2. Quand privilégier Java pour le screen scraping plutôt qu’un outil no-code ?

Utilise Java quand tu as besoin de logique personnalisée, de gérer des connexions complexes, d’interagir avec du contenu dynamique ou d’intégrer l’extraction à tes systèmes métiers. Les outils no-code comme Thunderbit sont parfaits pour les tâches rapides, les prototypes ou pour rendre les utilisateurs non techniques autonomes.

3. Quels sont les principaux défis du screen scraping Java et comment les résoudre ?

Les galères classiques : contenu dynamique (à gérer avec Selenium), protections anti-bot (utilise des délais, des proxys, des headers réalistes), changements de structure (centralise les sélecteurs) et nettoyage des données (exploite les outils de chaînes et regex de Java). Pour les gros volumes, mise sur la concurrence et une gestion solide des erreurs.

4. Comment Thunderbit complète-t-il le screen scraping Java ?

L’extension Chrome IA de Thunderbit facilite l’extraction de données sur n’importe quel site — sans code. Idéale pour les tâches rapides, les prototypes ou pour compléter ton workflow Java et gagner du temps tout en évitant la maintenance. Tu peux exporter les données dans des formats exploitables par Java, pour un pipeline fluide.

5. Peut-on automatiser un pipeline complet avec Thunderbit et Java ?

Carrément ! Programme des extractions récurrentes avec Thunderbit, exporte les résultats vers Google Sheets ou CSV, puis utilise une appli Java pour lire, traiter et intégrer les données. Cette approche hybride allie la rapidité et l’adaptabilité de Thunderbit à la puissance et la flexibilité de Java.