En 2025, le web ressemble à une vraie jungle numérique : plus de la moitié du trafic ne vient même pas de vraies personnes. Les bots et crawlers, eux, génèrent plus de 50 % de l’activité en ligne (), et parmi eux, seuls certains sont vraiment utiles : moteurs de recherche, robots d’aperçu pour les réseaux sociaux, outils d’analyse. Les autres ? On ne va pas se mentir, ils ne sont pas toujours là pour te faciliter la vie. Après des années à bosser sur des outils d’automatisation et d’IA chez , j’ai vu à quel point un crawler (bon ou mauvais) peut chambouler ton SEO, fausser tes stats, bouffer ta bande passante, voire causer de vrais soucis de sécurité.

Que tu sois responsable d’un site, d’une boîte ou que tu veuilles juste garder la main sur ton espace numérique, il n’a jamais été aussi important de savoir qui tape à la porte de ton serveur. Voilà pourquoi j’ai préparé ce guide 2025 des crawlers incontournables : leur utilité, comment les repérer, et comment laisser passer les bons tout en gardant les indésirables à distance.

C’est quoi un crawler « connu » ? User-Agent, IPs et vérification

On commence par la base : c’est quoi un crawler « connu » ? En gros, c’est un bot qui s’identifie avec un user-agent clair (genre Googlebot/2.1 ou bingbot/2.0) et, idéalement, qui bosse depuis des plages d’IP ou des blocs ASN officiels et vérifiables (). Les géants comme Google, Microsoft, Baidu, Yandex, DuckDuckGo publient la doc de leurs bots et souvent des outils ou fichiers JSON avec leurs IPs officielles (, , ).

Mais attention : se fier juste au user-agent, c’est risqué. Beaucoup de bots malveillants se font passer pour Googlebot ou Bingbot pour gruger tes protections (). La meilleure méthode, c’est donc la double vérification : checker à la fois le user-agent et l’IP (ou ASN), via reverse DNS ou listes officielles. Avec un outil comme , tu peux automatiser tout ça : extraction des logs, matching des user-agents, croisement des IPs pour obtenir une liste fiable et à jour des bots qui visitent ton site.

Comment utiliser cette liste des crawlers ?

Concrètement, à quoi sert une liste des crawlers connus ? Voilà comment t’en servir au mieux :

- Mise en liste blanche (allowlisting) : Assure-toi que les bots utiles (moteurs de recherche, robots d’aperçu social) ne soient jamais bloqués par ton pare-feu, CDN ou WAF. Utilise leurs IPs et user-agents officiels pour une gestion précise.

- Filtrage analytique : Exclue le trafic des bots de tes stats pour avoir des chiffres qui reflètent tes vrais visiteurs humains — pas juste les passages répétés de Googlebot ou AhrefsBot ().

- Gestion des bots : Mets en place des règles de crawl-delay ou de limitation pour les outils SEO trop gourmands, et bloque ou challenge les bots inconnus ou suspects.

- Analyse automatisée des logs : Utilise des outils d’IA (comme Thunderbit) pour extraire, classifier et taguer l’activité des crawlers dans tes logs, histoire de repérer les tendances, démasquer les imposteurs et garder tes règles à jour.

Mettre à jour sa liste des crawlers, ce n’est pas un truc à faire une fois pour toutes. De nouveaux bots débarquent, d’autres changent de comportement, et les attaquants sont de plus en plus malins chaque année. Automatiser la veille — en scrappant la doc officielle ou les dépôts GitHub avec Thunderbit — te fera gagner un temps fou.

1. Thunderbit : Identification des crawlers et gestion des données par l’IA

n’est pas juste un Extracteur Web IA : c’est l’assistant data des équipes qui veulent vraiment comprendre et maîtriser le trafic des crawlers. Ce qui fait la différence avec Thunderbit :

- Prétraitement sémantique : Avant d’extraire les données, Thunderbit transforme les pages web et logs en contenu structuré façon Markdown. Ce prétraitement « sémantique » permet à l’IA de piger le contexte, les champs et la logique de ce qu’elle lit. C’est super utile sur les pages complexes, dynamiques ou blindées de JavaScript (genre Facebook Marketplace ou de longs fils de commentaires) où les extracteurs classiques galèrent.

- Double vérification : Thunderbit récupère vite la doc officielle des IPs et ASNs des crawlers, puis les compare à tes logs serveurs. Résultat : une « liste blanche de confiance » sur laquelle tu peux vraiment compter — fini les vérifs manuelles interminables.

- Extraction automatisée des logs : Balance tes logs bruts à Thunderbit, il te sort des tableaux structurés (Excel, Sheets, Airtable), en taguant les visiteurs fréquents, les chemins suspects et les bots connus. Tu peux ensuite brancher ces résultats à ton WAF ou CDN pour automatiser le blocage, la limitation ou les challenges CAPTCHA.

- Conformité et audit : L’extraction sémantique de Thunderbit garde une trace claire des accès — qui, quand, comment, et quelles actions ont été prises. Un vrai plus pour le RGPD, le CCPA et autres obligations légales.

J’ai vu des équipes diviser par cinq leur charge de gestion des crawlers grâce à Thunderbit — et enfin faire la différence entre bots utiles, nuisibles ou juste imposteurs.

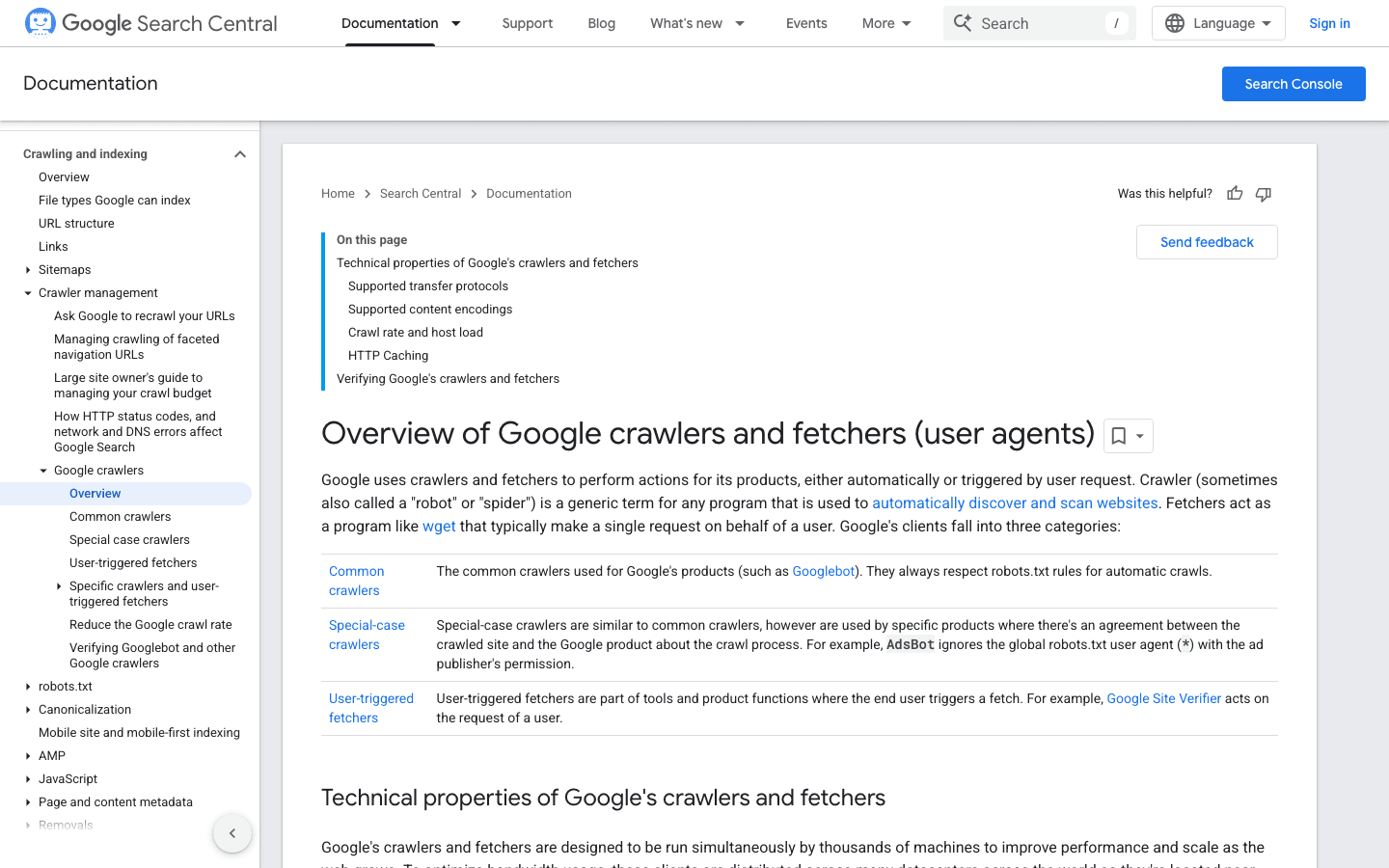

2. Googlebot : La référence des moteurs de recherche

reste la star des crawlers. Il indexe ton site pour Google Search — le bloquer, c’est comme mettre un rideau de fer sur ta vitrine digitale.

- User-Agent :

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) - Vérification : Utilise la ou la .

- Conseils de gestion : Toujours autoriser Googlebot. Utilise robots.txt pour guider (pas bloquer) son crawl, et ajuste la fréquence dans Google Search Console si besoin.

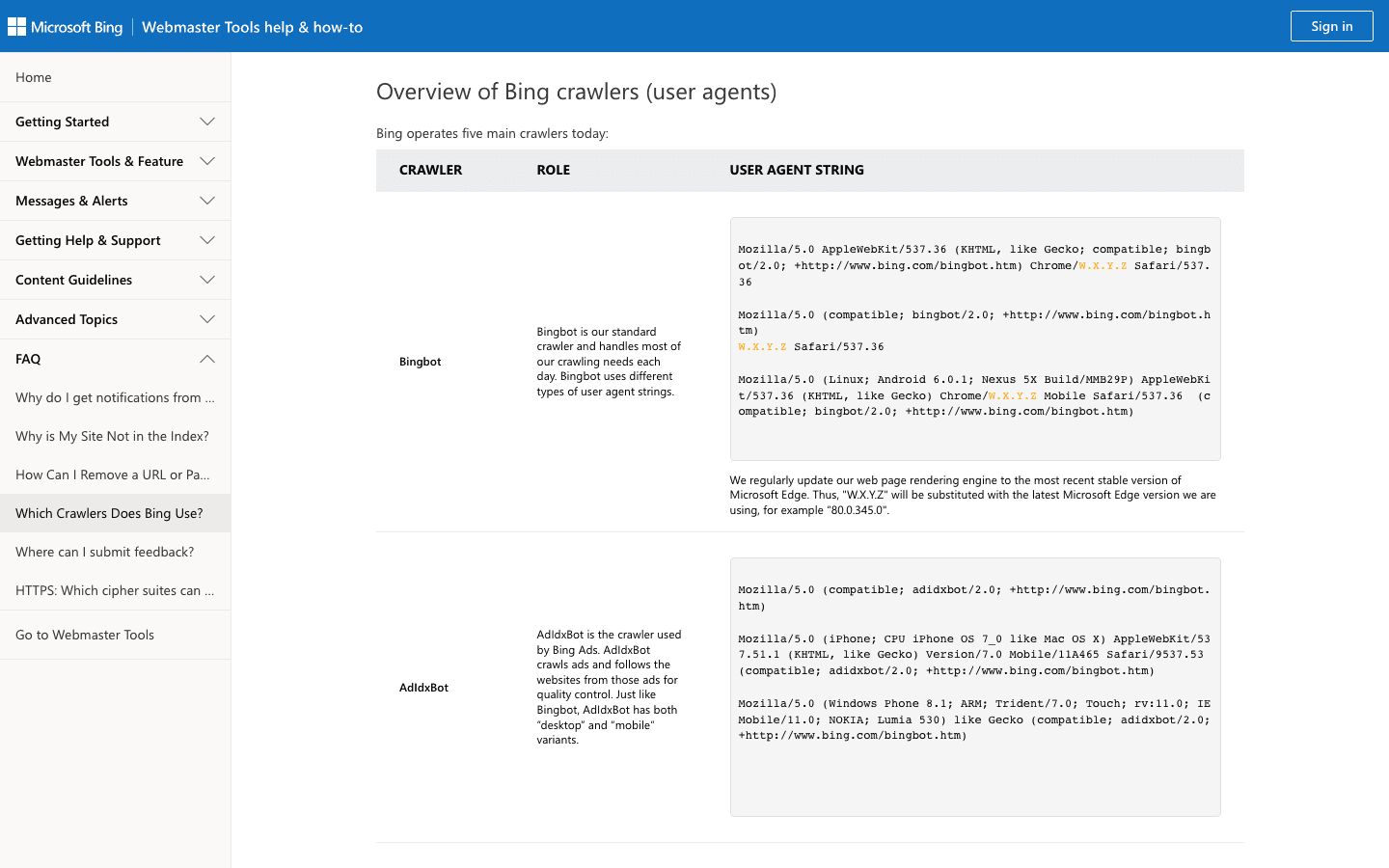

3. Bingbot : L’explorateur web de Microsoft

alimente Bing et Yahoo. C’est le deuxième crawler le plus important pour la plupart des sites.

- User-Agent :

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) - Vérification : Utilise l’ et la .

- Conseils de gestion : Autorise Bingbot, règle la fréquence de crawl dans Bing Webmaster Tools, et ajuste avec robots.txt.

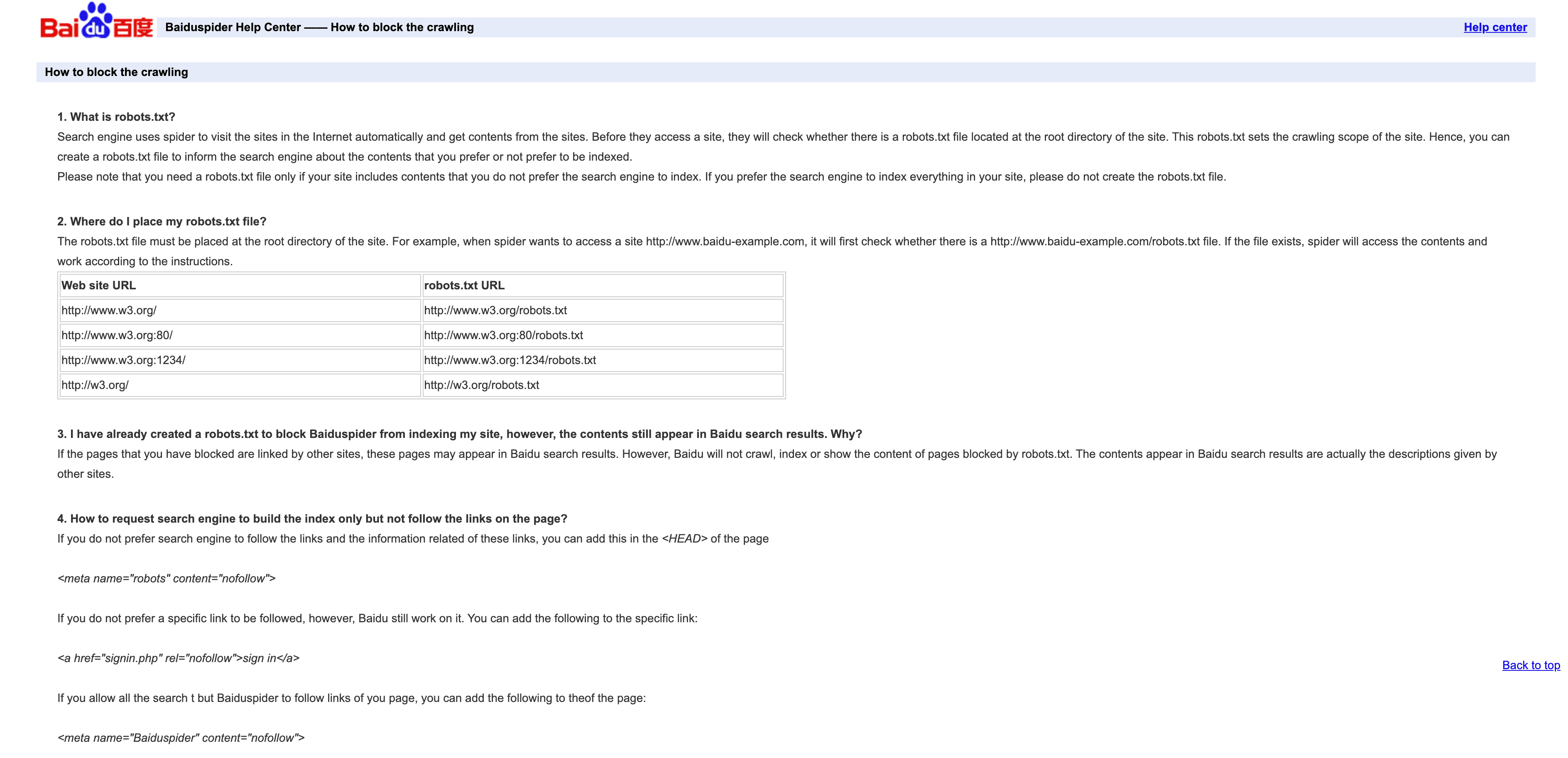

4. Baiduspider : Le crawler leader en Chine

est la clé pour toucher le public chinois.

- User-Agent :

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) - Vérification : Pas de liste IP officielle ; vérifie la présence de

.baidu.comen DNS inversé, mais attention, ce n’est pas infaillible. - Conseils de gestion : Autorise si tu vises la Chine. Utilise robots.txt pour fixer les règles, mais Baiduspider ne les respecte pas toujours. Si le SEO chinois ne t’intéresse pas, limite ou bloque pour économiser la bande passante.

5. YandexBot : Le crawler du moteur russe

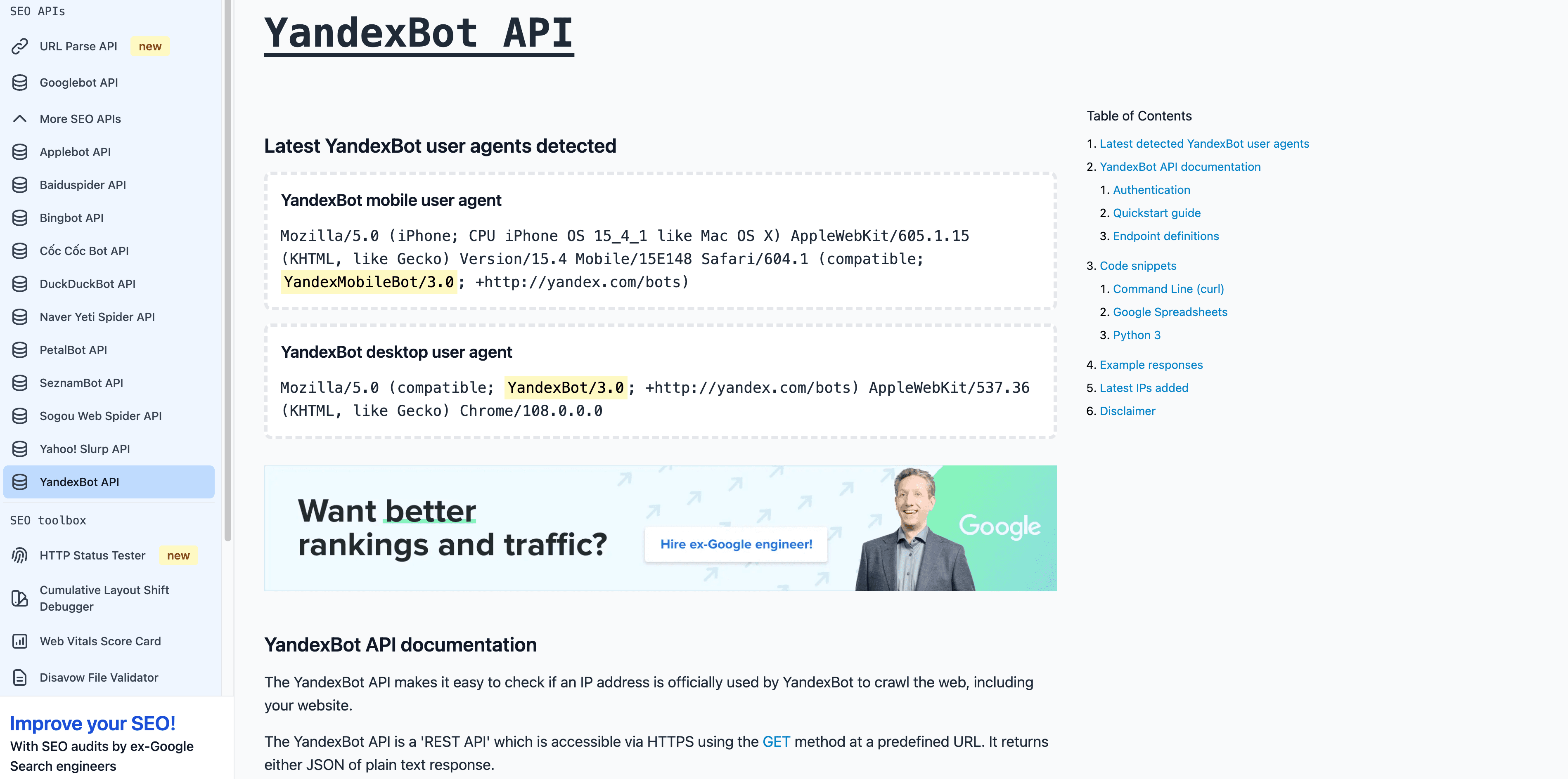

est incontournable pour la Russie et la CEI.

- User-Agent :

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots) - Vérification : Le DNS inversé doit finir par

.yandex.ru,.yandex.netou.yandex.com. - Conseils de gestion : Autorise si tu cibles les russophones. Utilise Yandex Webmaster pour gérer le crawl.

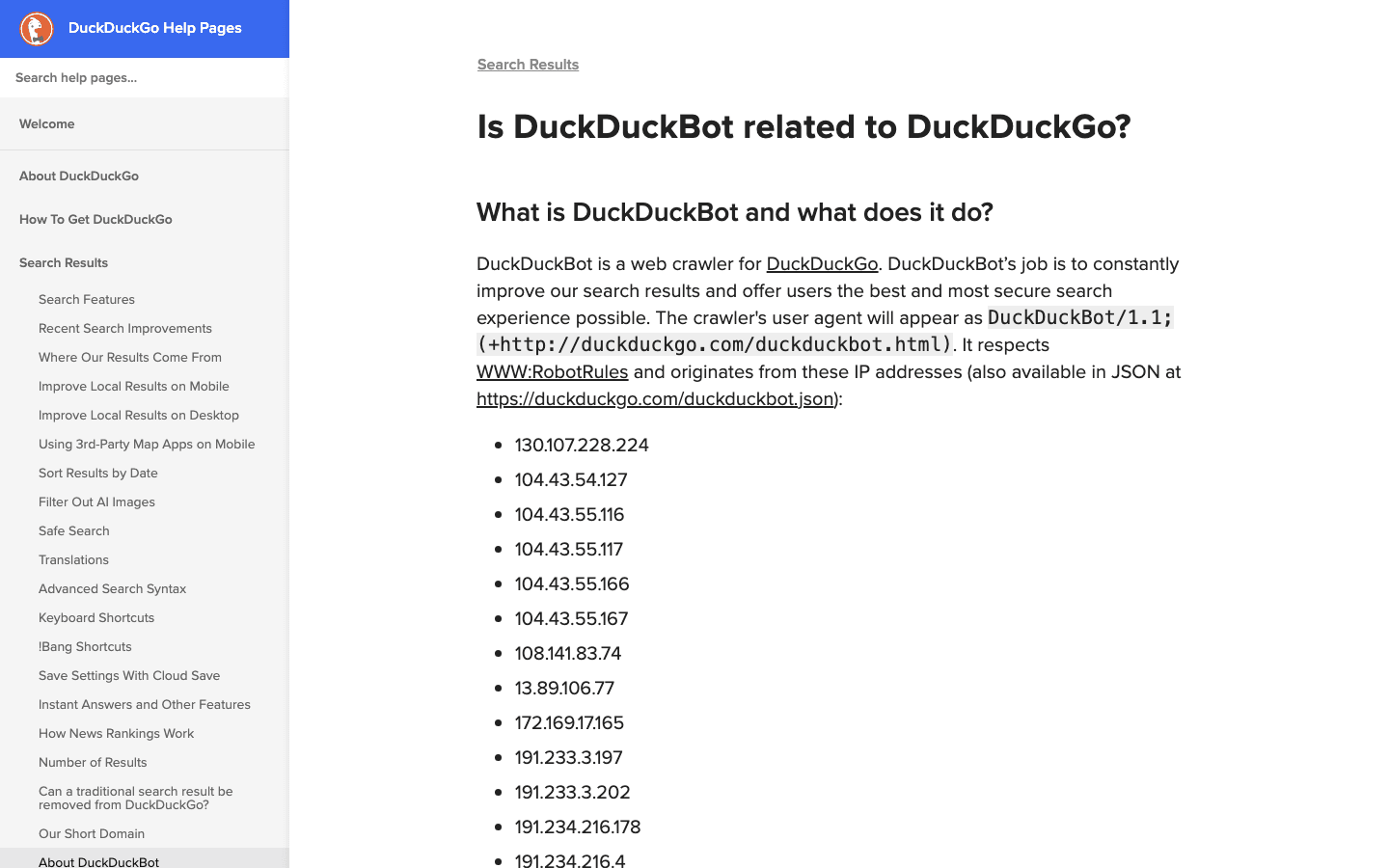

6. DuckDuckBot : Le crawler axé sur la confidentialité

alimente le moteur DuckDuckGo, qui mise tout sur la vie privée.

- User-Agent :

DuckDuckBot/1.1; (+http://duckduckgo.com/duckduckbot.html) - Vérification : .

- Conseils de gestion : Autorise sauf si ce public ne t’intéresse pas. Faible charge de crawl, facile à gérer.

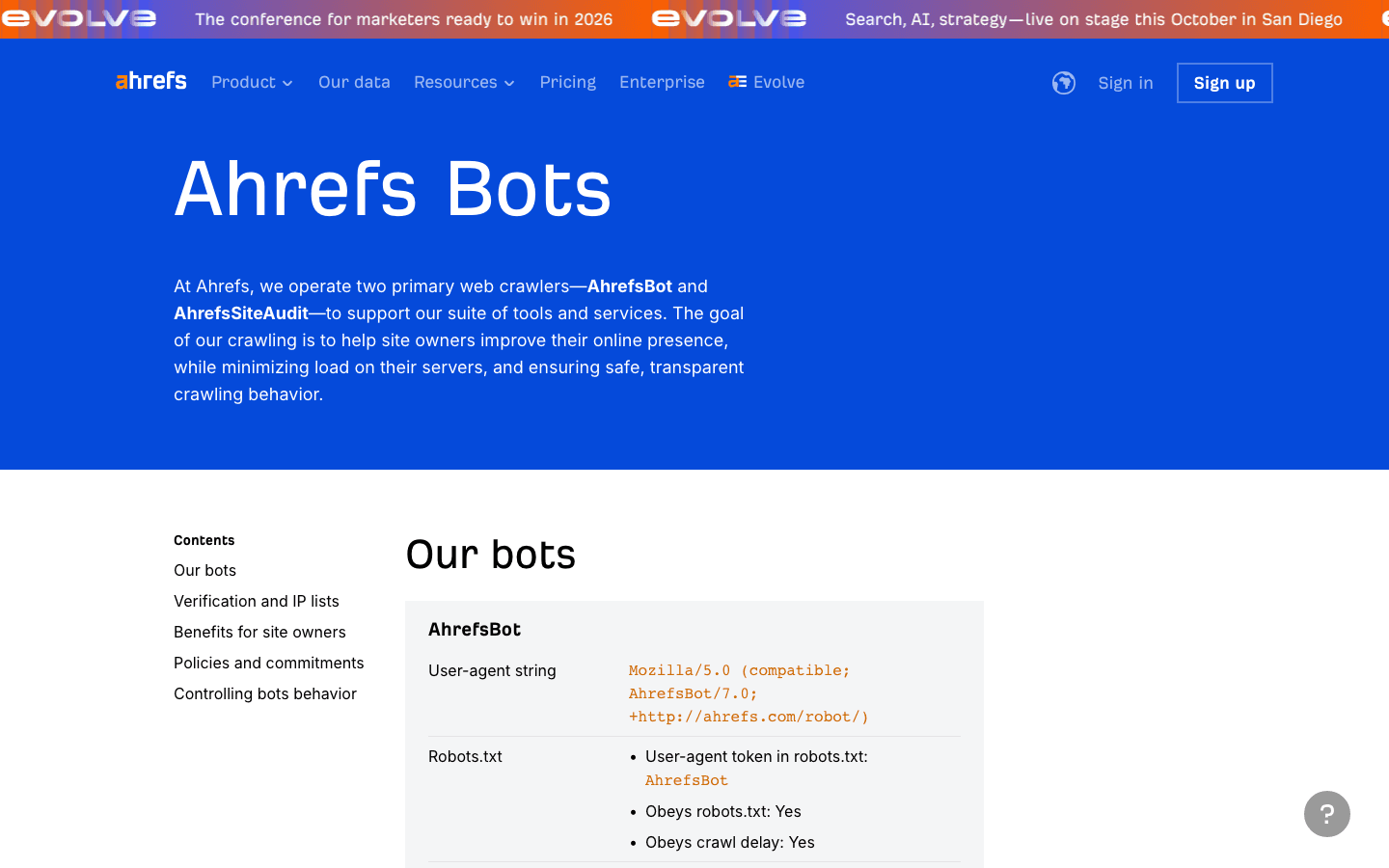

7. AhrefsBot : Analyse SEO et backlinks

est un crawler SEO très utilisé — parfait pour l’analyse de backlinks, mais parfois un peu trop gourmand en bande passante.

- User-Agent :

Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/) - Vérification : Pas de liste IP publique ; vérifie par UA et DNS inversé.

- Conseils de gestion : Autorise si tu utilises Ahrefs. Utilise robots.txt pour limiter ou bloquer. Tu peux aussi .

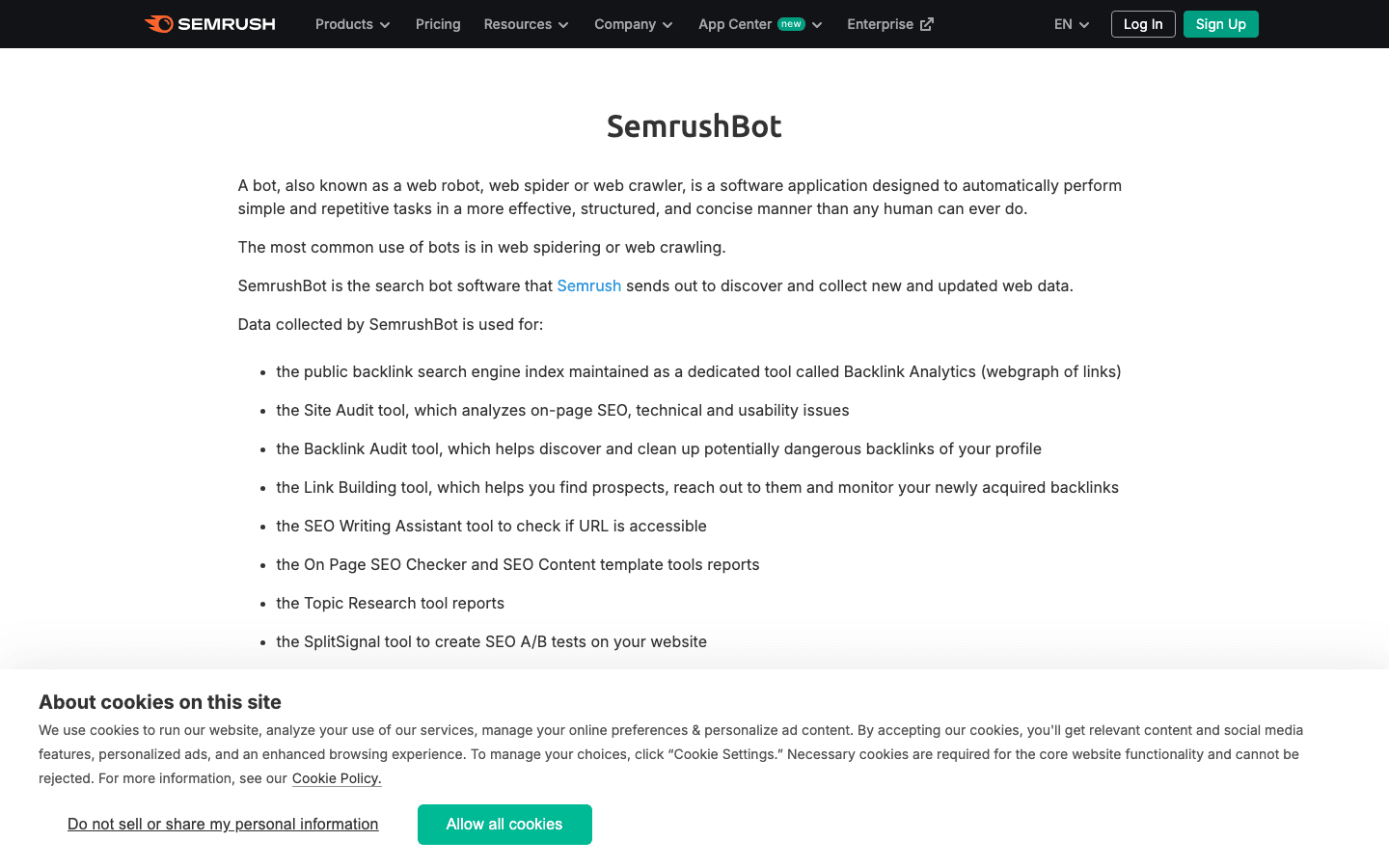

8. SemrushBot : Analyse SEO concurrentielle

est un autre poids lourd du SEO.

- User-Agent :

Mozilla/5.0 (compatible; SemrushBot/1.0; +http://www.semrush.com/bot.html)(et variantes commeSemrushBot-BA,SemrushBot-SI, etc.) - Vérification : Par user-agent ; pas de liste IP publique.

- Conseils de gestion : Autorise si tu utilises Semrush, sinon limite ou bloque via robots.txt ou des règles serveur.

9. FacebookExternalHit : Bot d’aperçu pour les réseaux sociaux

va chercher les données Open Graph pour les aperçus de liens sur Facebook et Instagram.

- User-Agent :

facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php) - Vérification : Par user-agent ; IPs appartenant à l’ASN de Facebook.

- Conseils de gestion : Autorise pour des aperçus enrichis. Le blocage empêche l’affichage des miniatures ou résumés sur Facebook/Instagram.

10. Twitterbot : Crawler d’aperçu de liens pour X (Twitter)

va chercher les données Twitter Card pour X (Twitter).

- User-Agent :

Twitterbot/1.0 - Vérification : Par user-agent ; ASN Twitter (AS13414).

- Conseils de gestion : Autorise pour les aperçus Twitter. Utilise les balises meta Twitter Card pour un rendu optimal.

Tableau comparatif : Les principaux crawlers en un clin d’œil

| Crawler | Objectif | Exemple User-Agent | Méthode de vérification | Impact business | Conseils de gestion |

|---|---|---|---|---|---|

| Thunderbit | Analyse IA des logs/crawlers | N/A (outil, pas un bot) | N/A | Gestion des données, classification des bots | Utilisez pour l’extraction de logs, création de listes blanches |

| Googlebot | Indexation Google Search | Googlebot/2.1 | DNS & liste IP | Essentiel pour le SEO | Toujours autoriser, gérer via Search Console |

| Bingbot | Recherche Bing/Yahoo | bingbot/2.0 | DNS & liste IP | Important pour le SEO Bing/Yahoo | Autoriser, gérer via Bing Webmaster Tools |

| Baiduspider | Recherche Baidu (Chine) | Baiduspider/2.0 | DNS inversé, UA string | Clé pour le SEO en Chine | Autoriser si cible Chine, surveiller la bande passante |

| YandexBot | Recherche Yandex (Russie) | YandexBot/3.0 | DNS inversé vers .yandex.ru | Clé pour Russie/Europe de l’Est | Autoriser si cible RU/CEI, utiliser outils Yandex |

| DuckDuckBot | Recherche DuckDuckGo | DuckDuckBot/1.1 | Liste IP officielle | Audience axée confidentialité | Autoriser, faible impact |

| AhrefsBot | Analyse SEO/backlinks | AhrefsBot/7.0 | UA string, DNS inversé | Outil SEO, peut être gourmand | Autoriser/limiter/bloquer via robots.txt |

| SemrushBot | Analyse SEO/concurrentielle | SemrushBot/1.0 (et variantes) | UA string | Outil SEO, parfois agressif | Autoriser/limiter/bloquer via robots.txt |

| FacebookExternalHit | Aperçus de liens sociaux | facebookexternalhit/1.1 | UA string, ASN Facebook | Engagement réseaux sociaux | Autoriser pour aperçus, utiliser balises OG |

| Twitterbot | Aperçus de liens Twitter | Twitterbot/1.0 | UA string, ASN Twitter | Engagement Twitter | Autoriser pour aperçus, utiliser balises Twitter Card |

Gérer sa liste des crawlers : les bons réflexes pour 2025

- Mets à jour régulièrement : Le monde des crawlers bouge vite. Prends l’habitude de faire des revues tous les trimestres et utilise des outils comme Thunderbit pour scrapper et comparer les listes officielles ().

- Vérifie, ne fais pas confiance à l’aveugle : Contrôle toujours le user-agent ET l’IP/ASN. Ne laisse pas les imposteurs fausser tes stats ou pomper tes données ().

- Liste blanche pour les bons bots : Assure-toi que les crawlers de recherche et sociaux ne soient jamais bloqués par tes règles anti-bot ou pare-feu.

- Limite ou bloque les bots trop gourmands : Utilise robots.txt, crawl-delay ou des règles serveur pour calmer les outils SEO trop insistants.

- Automatise l’analyse des logs : Utilise des outils IA (comme Thunderbit) pour extraire, classifier et taguer l’activité des crawlers — tu gagneras du temps et tu verras des tendances que tu aurais ratées autrement.

- Trouve le bon équilibre entre SEO, analytics et sécurité : Ne bloque pas les bots qui font tourner ton business, mais ne laisse pas les mauvais faire la loi.

Conclusion : Une liste des crawlers à jour, c’est vital

En 2025, gérer sa liste des crawlers, ce n’est plus juste un job d’admin — c’est un enjeu business qui touche au SEO, à l’analytics, à la sécurité et à la conformité. Avec les bots qui dominent le trafic web, il faut savoir qui visite ton site, pourquoi, et comment réagir. Garde ta liste à jour, automatise dès que tu peux, et appuie-toi sur des outils comme pour garder une longueur d’avance. Le web ne va pas ralentir — une stratégie intelligente et active sur les crawlers, c’est ta meilleure défense (et attaque) dans ce monde piloté par les bots.

FAQ

1. Pourquoi c’est important de garder une liste des crawlers à jour ?

Parce que les bots font maintenant plus de la moitié du trafic web, et seuls quelques-uns sont vraiment utiles. Une liste à jour te permet d’autoriser les bons bots (pour le SEO et les aperçus sociaux) et de bloquer ou limiter les mauvais, protégeant ainsi tes stats, ta bande passante et la sécurité de tes données.

2. Comment différencier un vrai crawler d’un faux ?

Ne te fie jamais juste au user-agent : vérifie toujours l’adresse IP ou l’ASN via les listes officielles ou le DNS inversé. Des outils comme Thunderbit automatisent ce process en croisant tes logs avec les IPs et user-agents publiés des bots.

3. Que faire si un bot inconnu visite mon site ?

Analyse le user-agent et l’IP. S’il n’est pas sur ta liste blanche et ne correspond pas à un bot connu, limite, challenge ou bloque-le. Utilise des outils IA pour classifier et surveiller l’apparition de nouveaux crawlers.

4. Comment Thunderbit aide à gérer les crawlers ?

Thunderbit utilise l’IA pour extraire, structurer et classifier l’activité des crawlers à partir des logs, ce qui facilite la création de listes blanches, la détection des imposteurs et l’automatisation des politiques. Son prétraitement sémantique est particulièrement efficace sur les sites complexes ou dynamiques.

5. Quels sont les risques à bloquer un crawler majeur comme Googlebot ou Bingbot ?

Bloquer les crawlers des moteurs de recherche peut faire disparaître ton site des résultats, tuant ton trafic organique. Vérifie toujours tes pare-feux, robots.txt et règles anti-bot pour ne pas exclure accidentellement les bots essentiels.

Pour aller plus loin :