Imagine un peu la scène : c’est lundi matin, tu bois ton café tranquille et, déjà, ta boîte mail explose d’alertes. Un nouvel outil boosté à l’IA fait la une pour avoir laissé filer des données sensibles. Ton PDG veut des explications, le service juridique est en mode panique, et tes clients ? Ils réclament des réponses nettes sur ce que deviennent leurs infos avec tous ces systèmes « intelligents » qu’on a déployés. Bienvenue en 2026, où la confidentialité des données IA n’est plus juste un souci technique, mais un vrai sujet stratégique qui peut jouer sur la réputation de ta boîte… et parfois sur ta propre carrière.

La vérité, c’est que l’IA s’est incrustée partout, que ce soit dans la vente, l’immobilier ou le e-commerce. Mais plus on s’appuie sur l’IA, plus les risques s’accumulent. Rien que l’an dernier, les incidents de confidentialité des données IA ont explosé de 56 %, et seulement 47 % des gens dans le monde font confiance aux entreprises IA pour protéger leurs données perso — un chiffre qui s’effondre (, ). Pour avoir bossé sur des plateformes SaaS et d’automatisation (et aujourd’hui cofondé ), je peux te le dire : piger les dernières statistiques confidentialité données IA, ce n’est pas juste pour cocher la case conformité, c’est ce qui va faire la différence entre cartonner et juste survivre dans le digital d’aujourd’hui.

Confidentialité des données IA en 2026 : les chiffres à connaître

On va droit au but. Voici les stats à sortir lors de ton prochain comité de direction ou face à un client :

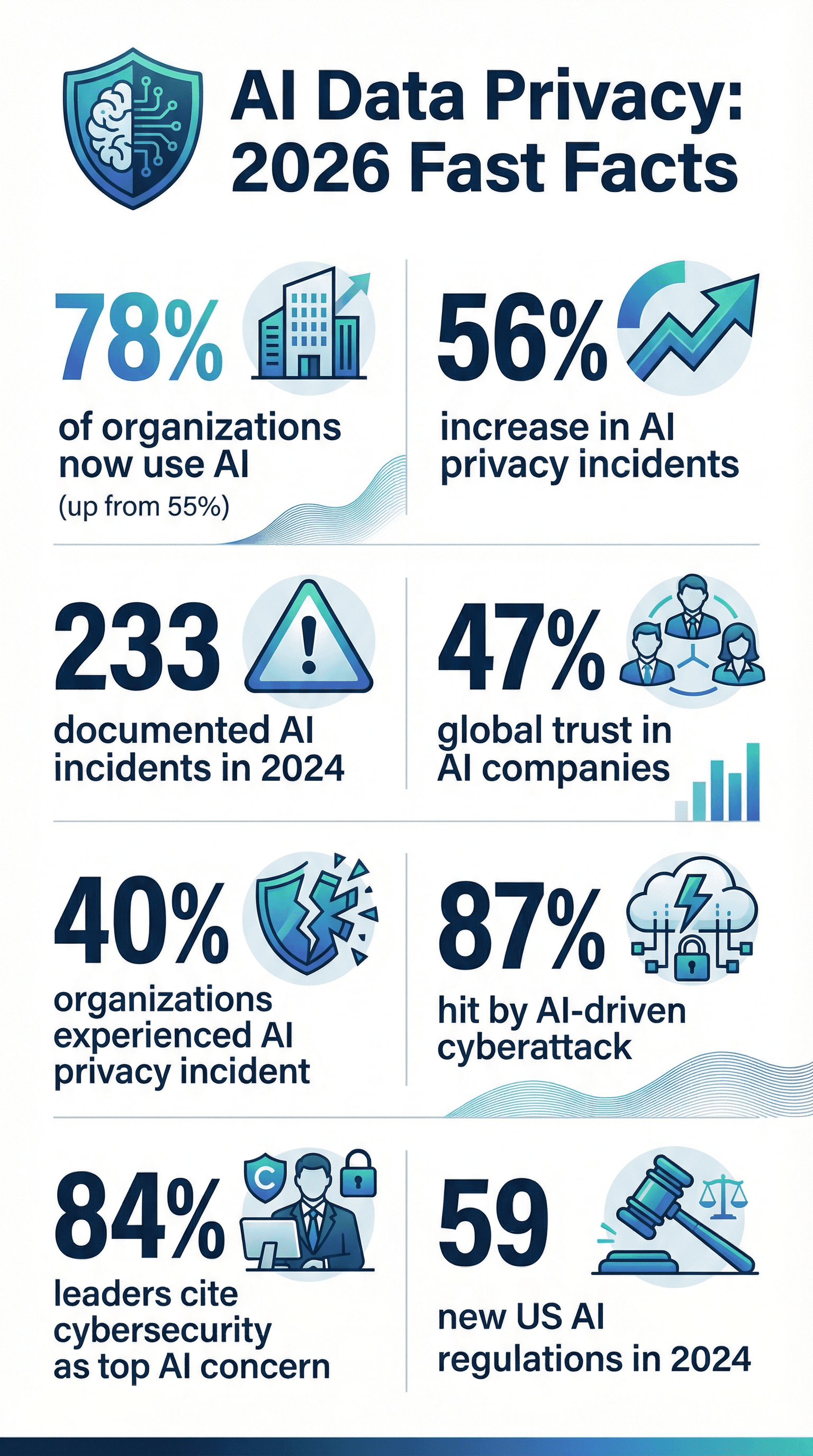

- L’IA est partout : 78 % des boîtes utilisaient l’IA en 2024, contre 55 % l’année d’avant ().

- Les incidents explosent : Les problèmes de sécurité et de confidentialité IA ont grimpé de 56 % en un an, avec 233 cas recensés en 2024 ().

- Les fuites sont courantes : 40 % des boîtes ont déjà eu un souci de confidentialité IA (), et 21 % ont subi une cyberattaque l’an dernier ().

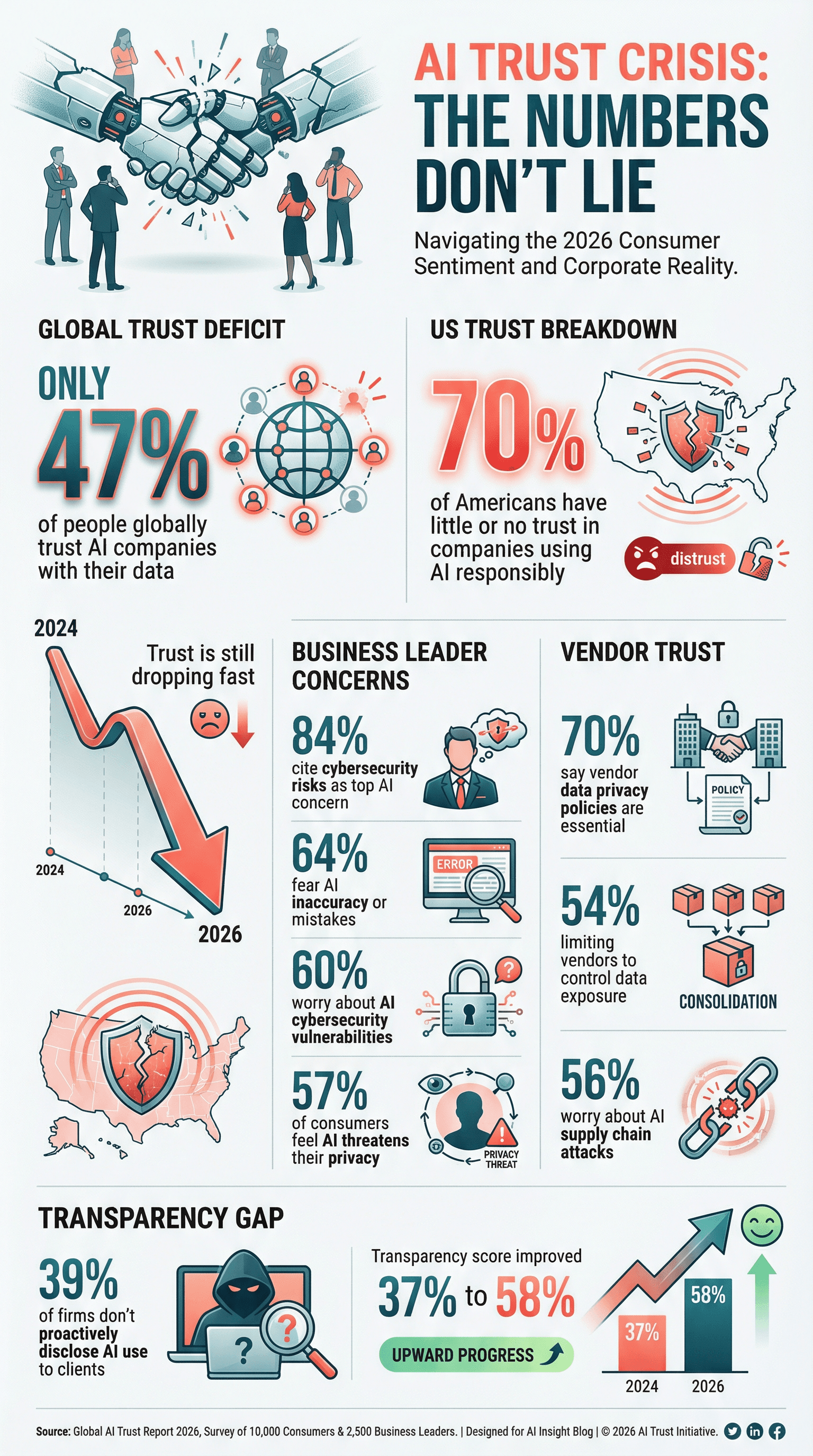

- La confiance s’effrite : Seuls 47 % des gens font confiance aux entreprises IA pour leurs données, et aux US, 70 % n’ont que peu ou pas confiance dans l’usage responsable de l’IA ().

- La confidentialité devient prioritaire : 61 % des boîtes placent la cybersécurité — dont la protection des données IA — dans leur top 3 des priorités stratégiques ().

- Les fournisseurs sous surveillance : 70 % des boîtes jugent la politique de confidentialité des fournisseurs essentielle pour choisir leurs partenaires IA/tech ().

- Les dirigeants flippent : 84 % des décideurs citent les risques cybersécurité comme leur plus grosse crainte liée à l’IA ().

- La régulation s’accélère : Les agences fédérales US ont sorti 59 nouvelles règles IA en 2024, soit plus du double de 2023 ().

- Les politiques formelles manquent : Seules 43 % des boîtes ont une vraie politique de gouvernance IA, même si 77 % bossent dessus (, ).

- Les cyberattaques IA deviennent la norme : 87 % des boîtes ont subi une cyberattaque boostée à l’IA l’an dernier ().

Ces chiffres, c’est pas juste pour la déco : ils doivent faire réagir tous ceux qui gèrent des données, la conformité ou la transformation digitale.

Pourquoi la confidentialité des données IA est devenue ultra-critique

L’IA, ce n’est pas juste une évolution logicielle : elle chamboule la façon dont les boîtes collectent, traitent et exploitent les données. Contrairement aux logiciels classiques, les systèmes IA apprennent sur des montagnes de données, souvent en vrac, qui peuvent contenir des emails clients ou des dossiers médicaux. Et le plus fou ? Les modèles IA peuvent « retenir » et ressortir des infos de façon inattendue, exposant parfois des données confidentielles censées rester secrètes ().

L’ampleur du truc est dingue. Un seul modèle IA peut traiter des millions de lignes ou extraire des données du web — parfois sans consentement clair. Résultat : protéger ces données devient vital. Et comme l’IA prend des décisions en quelques secondes (crédit, recrutement…), la moindre erreur ou biais peut être amplifiée à grande échelle, avec des violations de vie privée, voire des soucis de droits civiques.

Tu penses que ta politique de confidentialité suffit ? Détrompe-toi. L’IA amène de nouveaux risques — empoisonnement de données, inversion de modèle, attaques adversariales — que les contrôles classiques ne couvrent pas. Et si tu rates la confidentialité IA ? Les conséquences sont lourdes : perte de clients, amendes, réputation abîmée pour longtemps. En 2026, la confidentialité des données IA, c’est plus juste une case à cocher, c’est une question de survie.

Statistiques confidentialité données IA : adoption, inquiétudes et conformité

L’IA, c’est devenu la norme

Soyons clairs : l’IA, ce n’est plus une nouveauté, c’est la base. En 2024, 78 % des boîtes utilisaient l’IA, contre 55 % l’année d’avant (). Dans des secteurs comme le juridique ou la finance, c’est encore plus fort — 42 % des cabinets d’avocats utilisaient des outils IA en 2025, presque le double de l’année précédente (). Plus d’IA, c’est plus de données collectées, analysées… et parfois exposées.

Les inquiétudes sur la vie privée montent en flèche

Plus de puissance, plus de responsabilités… et plus d’angoisse. 57 % des consommateurs dans le monde voient l’IA comme une vraie menace pour leur vie privée (). Aux US, 70 % des gens qui connaissent l’IA n’ont que peu ou pas confiance dans l’usage de leurs données (). Même les boss s’inquiètent : 64 % craignent les erreurs de l’IA, et 60 % pointent les failles cybersécurité IA comme un gros risque ().

Plus de puissance, plus de responsabilités… et plus d’angoisse. 57 % des consommateurs dans le monde voient l’IA comme une vraie menace pour leur vie privée (). Aux US, 70 % des gens qui connaissent l’IA n’ont que peu ou pas confiance dans l’usage de leurs données (). Même les boss s’inquiètent : 64 % craignent les erreurs de l’IA, et 60 % pointent les failles cybersécurité IA comme un gros risque ().

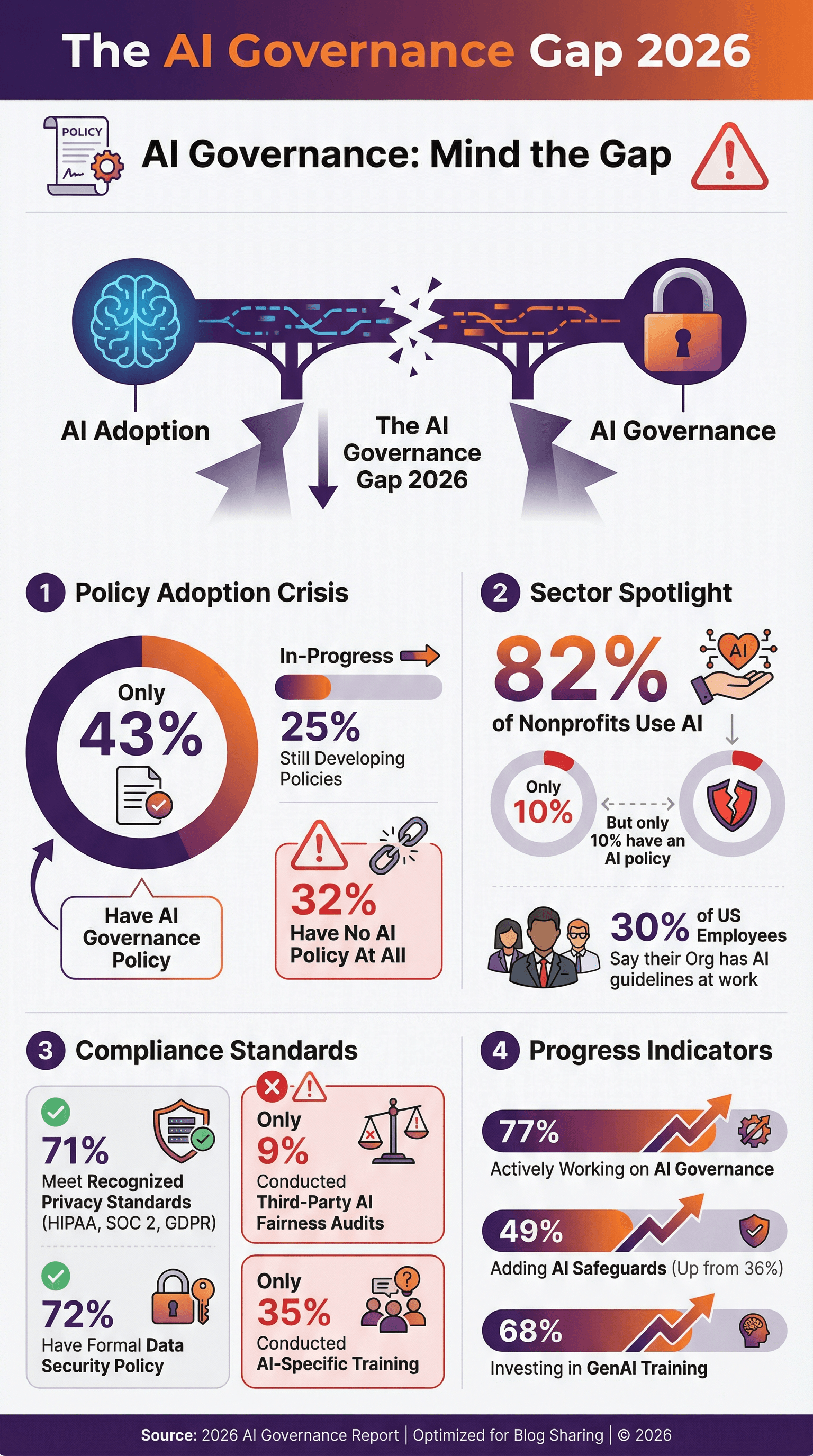

Conformité : un objectif qui bouge tout le temps

Les boîtes essaient de suivre le rythme des lois comme RGPD, CCPA, HIPAA ou SOC 2 — mais l’IA complique tout. 71 % des boîtes disent respecter les standards de confidentialité (), et 72 % ont une politique formelle de sécurité des données. Mais attention : moins de la moitié ont une politique dédiée à la gouvernance ou à l’éthique IA. Seules 43 % des boîtes l’ont fait, et 25 % sont en train de la mettre en place (, ). Les autres avancent à l’aveugle.

Adoption des politiques de confidentialité IA

Les politiques IA, c’est plus un « nice to have », c’est devenu indispensable. Mais les chiffres montrent qu’on est encore à la traîne :

- Seules 43 % des boîtes ont une politique de gouvernance IA, 25 % sont en train de la rédiger ().

- Aux US, seulement 30 % des salariés disent que leur boîte a des règles sur l’usage de l’IA au boulot ().

- Dans le monde associatif, 82 % des ONG utilisent l’IA, mais seulement 10 % ont une politique dédiée ().

- Bonne nouvelle : 77 % des boîtes bossent activement sur la gouvernance IA, et ça monte à 90 % chez les gros utilisateurs ().

Les pionniers mettent à jour leurs politiques pour interdire certains usages IA, imposer une revue humaine, et s’engager sur l’équité et la transparence. Si ta boîte n’a pas encore bougé, c’est le moment — avant qu’un incident ou une nouvelle loi ne t’y oblige.

Audits et certifications en confidentialité IA

Avoir une politique, c’est bien, mais les audits et certifications, c’est la preuve que tu fais vraiment le job.

- 71 % des boîtes disent être conformes à des standards comme HIPAA, SOC 2 ou RGPD ().

- 51 % exigent la conformité HIPAA de leurs fournisseurs pour les données santé, et 45 % demandent un chiffrement de bout en bout ().

- Seules 9 % des boîtes ont fait un audit externe sur l’équité ou les biais IA — mais ça va grimper avec la nouvelle réglementation ().

Des certifications comme SOC 2, ISO 27001 ou HITRUST deviennent de vrais arguments pour se démarquer. Si tu es fournisseur, prépare-toi à devoir prouver ta conformité. Si tu es client, exige ces preuves de tes partenaires.

Cybersécurité IA : menaces, incidents et riposte

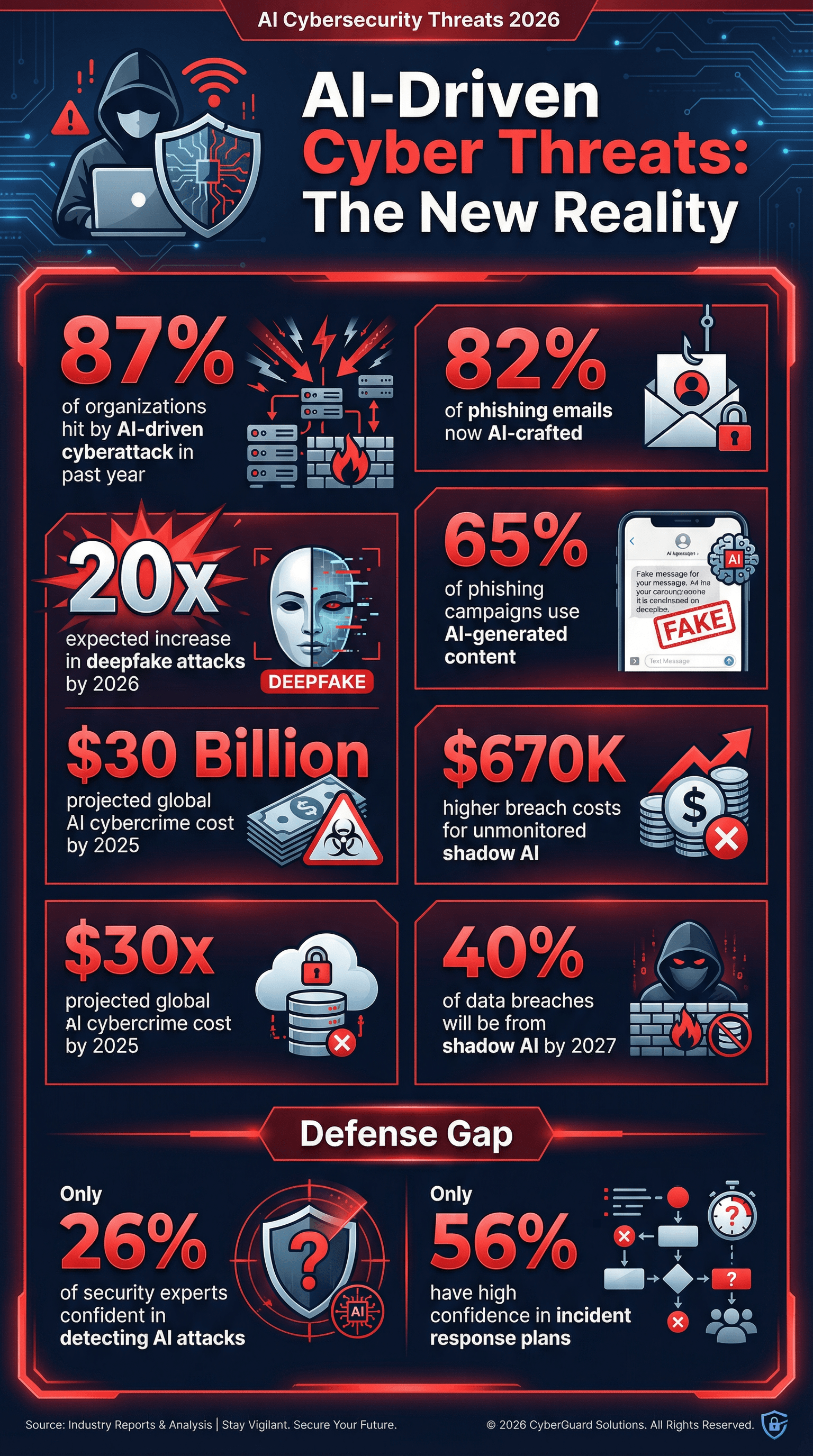

On va pas se mentir : l’IA, c’est pas juste une cible, c’est aussi une arme pour les cybercriminels. Et les chiffres font froid dans le dos.

- 87 % des boîtes ont subi une cyberattaque boostée à l’IA l’an dernier ().

- 65 % des campagnes de phishing utilisent maintenant des contenus générés par l’IA pour imiter des messages crédibles ().

- 82 % des emails de phishing seraient rédigés avec l’aide de l’IA ().

- Les attaques deepfake devraient être multipliées par 20 d’ici 2026 ().

- Shadow AI (usage non autorisé de l’IA par les employés) est un risque qui monte — Gartner prévoit que 40 % des fuites de données viendront d’une mauvaise utilisation de l’IA ou du shadow AI d’ici 2027 ().

Et voilà une stat qui empêche les responsables sécurité de dormir : seuls 26 % des pros de la sécu se disent très confiants pour détecter les attaques pilotées par l’IA (). Autant chercher une aiguille dans une botte de foin…

Cyberattaques IA : ce que disent les chiffres

- 87 % des boîtes ont été attaquées par l’IA en 12 mois ().

- Le phishing devient plus malin : fin 2025, plus de 82 % des emails de phishing étaient générés par l’IA ().

- Les deepfakes explosent : Les attaques audio/vidéo deepfake devraient être multipliées par 20 d’ici 2026.

- Le Shadow AI, c’est risqué : D’ici 2027, 40 % des fuites de données viendront d’une mauvaise utilisation de l’IA ou du shadow AI ().

- Le coût des fuites grimpe : Les boîtes qui laissent filer de l’IA non surveillée ou du shadow AI paient en moyenne 670 000 $ de plus par incident ().

- Coût mondial : La cybercriminalité boostée à l’IA pourrait coûter 30 milliards de dollars d’ici 2025 ().

Si tu ne testes pas tes défenses contre les emails de phishing IA ou les deepfakes, tu joues avec le feu.

Les boîtes misent sur la cybersécurité IA

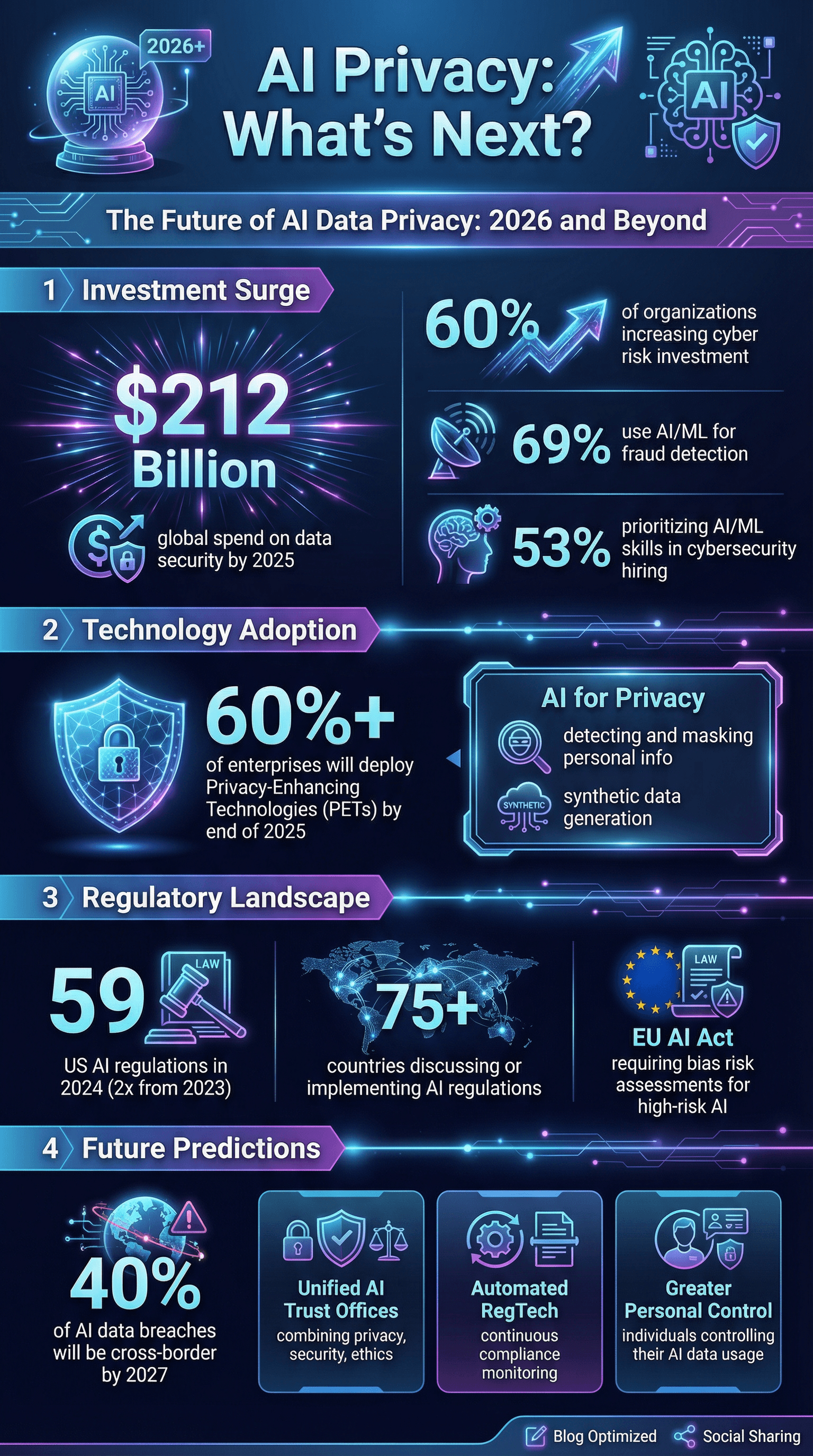

Bonne nouvelle : les entreprises investissent à fond dans la cybersécurité IA :

- 60 % des boîtes augmentent leurs budgets pour réduire les risques cyber, l’IA étant un facteur clé ().

- 69 % utilisent l’IA ou le machine learning pour détecter et prévenir la fraude ().

- 53 % privilégient les compétences IA et ML dans le recrutement cybersécurité ().

- Les dépenses mondiales en sécurité des données devraient atteindre 212 milliards de dollars d’ici 2025 ().

Mais il y a encore des trous dans la raquette : seules 56 % des boîtes se disent très confiantes dans leur plan de réponse aux incidents, et encore moins pour les scénarios IA.

Gouvernance des données IA : formation, supervision et lutte contre les biais

La tech, c’est bien, mais sans équipes formées et process adaptés, le risque reste là.

- Seules 35 % des boîtes ont formé leurs équipes sur la confidentialité, la sécurité ou l’éthique IA ().

- 68 % des boîtes investissent dans la formation IA générative pour leurs employés ().

- 30 % misent sur la supervision humaine pour contrôler l’IA ().

- Seules 9 % font appel à des audits indépendants pour l’équité IA ().

- 49 % sont en train d’ajouter des mesures de gouvernance IA, contre 36 % l’année d’avant.

Le biais algorithmique, c’est aussi un souci de confidentialité. Les IA qui traitent différemment selon le genre, l’origine, etc., peuvent causer des discriminations et des procès. 46 % des dirigeants placent l’IA responsable — dont l’équité — dans leurs priorités d’investissement (). Mais mesurer et corriger les biais, c’est encore galère pour beaucoup.

Biais et équité IA : impact sur la confidentialité

- Les incidents IA liés aux biais ou à la sécurité grimpent chaque année ().

- 25 % de réduction des écarts de genre dans les recommandations de candidats après correction.

- La pression réglementaire monte : RGPD et futur AI Act européen imposeront des évaluations de risques de biais pour les IA « à haut risque ».

Si tu ne testes pas tes IA pour les biais, tu risques non seulement une mauvaise image, mais aussi des procès et la fuite de clients.

Risques liés aux fournisseurs et à l’écosystème : consolidation et exposition tierce

Aucune boîte n’est toute seule. La plupart bossent avec un réseau de fournisseurs, clouds et partenaires — autant de portes d’entrée pour les risques de confidentialité.

- 54 % des boîtes réduisent le nombre de fournisseurs pour limiter les coûts et l’exposition des données ().

- 70 % jugent la politique de confidentialité essentielle pour choisir leurs partenaires tech.

- 56 % craignent les attaques sur la chaîne d’approvisionnement boostées à l’IA ().

La tendance : moins de partenaires, des contrôles de confidentialité plus costauds, et considérer tes fournisseurs comme une extension de ta propre sécu.

Pressions réglementaires et clients : transparence et divulgation en IA

Régulateurs et clients mettent la pression. En 2024, les US ont eu 59 actions réglementaires IA, plus du double de l’année d’avant. Dans le monde, au moins 75 pays ont bossé sur des lois IA ().

- La transparence devient la règle : Les clients veulent savoir comment tu utilises l’IA, mais 39 % des boîtes avouent ne pas informer proactivement leurs clients ().

- Être prêt pour l’audit : Prépare-toi à prouver ta conformité — HIPAA, SOC 2, listes d’outils IA, contrôles de gestion des données.

- Les scores de transparence des gros développeurs IA sont passés de 37 % à 58 % en six mois ().

Si tu n’es pas prêt pour un audit ou un questionnaire client costaud, tu n’es pas prêt pour 2026.

L’avenir de la confidentialité des données IA : tendances et perspectives

Voilà ce qui se profile pour les prochaines années (et ce que les experts prédisent) :

- La confidentialité comme avantage concurrentiel : Les boîtes capables de prouver la sécurité, l’éthique et la confidentialité de leur IA gagneront la confiance des clients ().

- Gouvernance unifiée : On va voir apparaître des « bureaux de confiance IA » qui rassemblent confidentialité, sécurité et éthique.

- Technos de renforcement de la confidentialité (PETs) : Plus de 60 % des boîtes comptent déployer des PETs d’ici fin 2025 ().

- Conformité automatisée : Les outils RegTech pour l’IA vont devenir incontournables, avec une surveillance continue.

- Défis transfrontaliers : D’ici 2027, 40 % des fuites de données IA viendront d’une mauvaise gestion internationale ().

- Plus de contrôle pour chacun : Des outils permettront aux utilisateurs de gérer l’usage de leurs données par l’IA.

- L’IA au service de la confidentialité : L’IA va servir à détecter et masquer les infos perso, générer des données synthétiques, etc.

- Réponse aux incidents et résilience : Les boîtes vont passer de la simple prévention à la résilience, avec assurance contre les incidents IA et exercices de récupération après empoisonnement ou corruption de modèles.

En tant que passionné d’automatisation et d’IA (et, oui, un peu parano sur la confidentialité), je parie que les gagnants de la prochaine décennie seront ceux qui feront de la sécurité et de la confidentialité des piliers, pas des options.

À retenir : ce que veulent dire les stats 2026 sur la confidentialité IA pour ta boîte

Pour finir, quelques actions concrètes pour éviter de finir dans la rubrique des mauvais exemples :

- Mets la confidentialité IA au centre de ta stratégie. Pas en bonus, mais dès le début.

- Fais des analyses de risques IA sérieuses. Cartographie tes systèmes, flux de données et failles potentielles.

- Investis dans la formation et la gouvernance IA. Ne laisse pas ton équipe être le maillon faible.

- Renforce tes défenses techniques en pensant IA. Utilise l’IA pour contrer l’IA : déploie des outils de détection et de surveillance avancés.

- Sois exigeant avec tes fournisseurs. Rationalise, vérifie et exige des preuves de conformité.

- Joue la carte de la transparence. Informe clients et utilisateurs sur l’usage de l’IA — avant que d’autres ne le fassent à ta place.

- Déploie des technos de renforcement de la confidentialité. Anonymise, chiffre et limite les données au max.

- Prépare-toi au pire. Mets en place un plan de réponse aux incidents IA et teste-le régulièrement.

- Reste à jour sur les lois et standards. Le cadre réglementaire bouge vite — ne te fais pas surprendre.

- Fais de la confiance ta boussole. En 2026 et après, la confiance, c’est ton meilleur atout.

Sources et lectures pour aller plus loin

Tu veux creuser ou choper des chiffres pour tes slides ? Voici quelques-unes des meilleures ressources utilisées pour cet article :

- )

Pour plus d’analyses sur l’IA, l’automatisation et la confidentialité, va voir le ou explore nos guides sur et .